【经典算法】深入剖析LSM-Tree算法:原理与实战

本文介绍了LSM-Tree(日志结构合并树)算法的核心原理、实现方法及应用场景。该算法通过分层存储和批量合并操作,将随机写转化为顺序写,显著提升写入性能,适用于大数据存储和分布式系统。文章详细解析了LSM-Tree的写入流程、读取流程和合并操作,并提供了Python实现的关键代码示例。同时,结合LevelDB、RocksDB等实际案例,分析了其在时序数据库、分布式系统等场景的优势,也指出了读取性能

目录

一、引言

在大数据处理与分布式存储等前沿领域,数据犹如汹涌澎湃的浪潮,持续不断地奔涌而来。据统计,全球每天产生的数据量高达数 ZB(1ZB = 1024EB,1EB = 1024PB,1PB = 1024TB ) ,这些数据涵盖了从互联网日志、社交媒体互动信息,到金融交易记录、科学研究数据等各个方面。面对如此海量的数据,传统的数据存储和处理方式显得力不从心,而 LSM - Tree(Log - Structured Merge - Tree,日志结构合并树)算法却在这一挑战中脱颖而出,成为了众多大数据存储系统和分布式数据库的关键技术支撑。

以分布式文件系统 Hadoop 分布式文件系统(HDFS)为例,它需要高效地存储和管理海量的文件数据,LSM - Tree 算法的应用使得数据写入操作能够快速响应,即使面对大规模的数据写入请求,也能保持稳定的性能。在 NoSQL 数据库领域,像 Cassandra、LevelDB、RocksDB 等知名数据库,均采用 LSM - Tree 作为数据存储引擎。Cassandra 作为一种高可扩展性的分布式数据库,借助 LSM - Tree 结构,能够轻松应对高并发的读写操作,为众多互联网企业提供了强大的数据存储和处理能力;LevelDB 由 Google 开发,以其快速的键值存储能力著称,LSM - Tree 是其实现高性能的核心所在;RocksDB 则在 Facebook 的各种应用场景中发挥着重要作用,通过 LSM - Tree 实现了对大规模数据的高效管理。

二、LSM-Tree 算法是什么

(一)核心概念

LSM - Tree,即日志结构合并树,是一种独特的数据存储结构与算法。它的核心在于将数据按层级组织,跨越内存和磁盘组件 ,通过批量合并操作将内存中的新数据逐步刷写到磁盘,以此来降低随机写磁盘的开销。简单来说,它就像是一个有条不紊的文件整理系统,把频繁变动的数据先放在易于操作的 “临时文件夹”(内存)中,等积累到一定程度后,再统一、有序地整理到 “永久文件夹”(磁盘)里。

(二)设计理念

LSM - Tree 的设计理念极具创新性,它巧妙地牺牲了部分读取性能,来换取写入吞吐量的大幅提升。在传统的数据存储方式中,随机写操作就像是在图书馆里随机地把书籍放回书架,工作人员需要花费大量时间寻找合适的位置,效率低下。而顺序写则如同按照书籍编号依次放回书架,简单高效。磁盘 I/O 操作中,顺序写的速度远远高于随机写。据测试,在普通机械硬盘上,顺序写的速度可以达到随机写的数十倍甚至上百倍。LSM - Tree 正是利用了这一特性,将数据先在内存中进行快速的写入操作,积累到一定程度后,再以顺序写的方式将数据批量写入磁盘,大大提高了写入效率 。这种设计理念使得 LSM - Tree 在面对海量数据的写入场景时,能够轻松应对,展现出卓越的性能优势。

三、LSM-Tree 的工作原理

(一)写入流程

- 预写日志(WAL):在 LSM - Tree 的写入流程中,预写日志(Write - Ahead Log,WAL)是至关重要的第一步。当有新的写操作到来时,系统首先会将这些操作记录到 WAL 中 。这就像是给数据操作留下了一份 “备份记录”,其目的是为了保障数据的持久性和一致性。在系统发生故障,如突然断电、程序崩溃等意外情况时,WAL 中的记录可以用于恢复未完成的事务,确保数据不会丢失。以 MySQL 的 Binlog 为例,Binlog 同样是一种预写日志,它记录了所有对数据库的写操作,包括数据的插入、更新和删除等。在 MySQL 的主从复制架构中,Binlog 起着关键作用,主库将 Binlog 发送给从库,从库通过重放 Binlog 中的操作,实现与主库的数据同步,保证了数据的一致性 。在 LSM - Tree 中,WAL 的作用与之类似,为数据的安全和一致性提供了坚实的保障。

- MemTable:完成 WAL 的写入后,数据会被写入内存中的 MemTable。MemTable 通常采用跳表(Skip List)、红黑树等有序的数据结构来存储数据 。以跳表为例,它是一种随机化的数据结构,通过多层链表来实现高效的插入、删除和查找操作。跳表的每一层都是一个有序的链表,高层链表中的元素是底层链表元素的子集,这样在查找时可以通过高层链表快速定位到大致范围,然后再在底层链表中精确查找,大大提高了查找效率。在 LSM - Tree 中,MemTable 利用这些数据结构的特性,实现了快速的插入和删除操作。当有新的数据写入时,MemTable 能够迅速将其插入到合适的位置,并且在需要删除数据时,也能高效地完成操作,为系统提供了快速响应写入请求的能力。

- 触发 Compaction:MemTable 的大小是有限的,当其中的数据量达到一定阈值时,就会触发 Compaction 操作 。此时,MemTable 会被转换为 Immutable MemTable(不可变的 MemTable),同时系统会创建一个新的 MemTable 来接收新的写请求。Immutable MemTable 中的数据会被刷入磁盘,生成 SSTable(Sorted String Table)文件。SSTable 是一种有序的、不可变的磁盘文件,其中的数据按照键值对的顺序排列,这使得后续的读取操作可以利用二分查找等算法快速定位数据,提高读取效率。在这个过程中,数据从内存转移到了磁盘,完成了一次数据的持久化存储,同时也为新的写入操作腾出了内存空间。

(二)读取流程

- MemTable 优先查找:在 LSM - Tree 进行读取操作时,由于 MemTable 存储的是最新写入的数据,并且是按升序排列的,所以查找操作首先会在 MemTable 中进行。以跳表实现的 MemTable 为例,跳表的有序性使得查找过程可以从跳表的高层链表开始,快速定位到目标键值对可能所在的范围,然后逐步向下层链表进行精确查找。这种查找方式效率较高,能够快速确定目标数据是否存在于 MemTable 中,如果存在,则可以直接返回数据,大大提高了读取的速度。

- Block Cache 查找:如果在 MemTable 中未找到目标数据,接下来会在 Block Cache 中进行查找 。Block Cache 是一种缓存机制,它存储了预先加载到内存中的 SSTable 块。当需要读取 SSTable 中的数据时,系统会首先检查 Block Cache 中是否已经缓存了相应的数据块。如果存在缓存,则可以直接从缓存中读取数据,避免了磁盘 I/O 操作,大大提高了读取性能。这就像是在图书馆中查找书籍,先查看是否已经有这本书的电子版(缓存)存在于电脑中,如果有,就无需去书架(磁盘)上寻找,节省了时间和精力。

- SSTable 查找:若 Block Cache 中也未找到数据,那么就需要从磁盘上的 SSTable 文件中查找 。LSM - Tree 通常会维护多个层级的 SSTable 文件,数据会从最低层 L0 开始逐层向上查找。由于 SSTable 文件中的数据是有序的,所以可以使用二分查找等算法来快速定位目标数据。在查找过程中,系统会依次检查每个层级的 SSTable 文件,直到找到目标数据或者遍历完所有层级的文件。如果最终没有找到目标数据,则返回未找到的结果。

(三)合并操作(Merge)

随着写入操作的不断进行,磁盘上会产生越来越多的 SSTable 文件 。当多个 SSTable 文件达到一定数量时,就会触发合并操作(Merge)。合并操作的主要目的是将这些小的 SSTable 文件合并为一个更大的 SSTable 文件,从而减少文件数量,提高读取性能。在合并过程中,系统会读取多个 SSTable 文件中的数据,并按照键值对的顺序进行排序和合并。在合并时,还会清理冗余数据,如已删除的数据和过期的数据。例如,当某个键值对被标记为删除时,在合并过程中会将其从数据集中移除,不再保留在新的 SSTable 文件中。这样不仅减少了文件数量,还优化了数据存储结构,提高了存储空间的利用率,使得系统在读取数据时能够更快地定位到目标数据,提升了整体的性能表现。

四、代码实现步骤

(一)环境准备

为了实现 LSM - Tree 算法,我们选择使用 Python 语言,它具有简洁易读的语法和丰富的库,能够帮助我们快速实现算法的核心功能。Python 在数据处理和算法实现领域应用广泛,许多开源的数据处理框架和库都提供了 Python 接口,使得它成为实现 LSM - Tree 算法的理想选择。在开发环境方面,我们可以使用 PyCharm 作为集成开发环境(IDE),它提供了强大的代码编辑、调试和项目管理功能。

安装 Python 非常简单,你可以从 Python 官方网站(https://www.python.org/downloads/ )下载最新版本的 Python 安装包,然后按照安装向导的提示进行安装。安装完成后,打开命令行终端,输入 “python --version”,如果显示 Python 的版本号,说明安装成功。

接下来安装 PyCharm,你可以从 JetBrains 官方网站(https://www.jetbrains.com/pycharm/download/ )下载社区版或专业版的 PyCharm 安装包,安装过程同样按照向导提示进行。安装完成后,打开 PyCharm,创建一个新的 Python 项目,即可开始编写代码。

(二)关键数据结构实现

- MemTable 实现:我们以跳表(Skip List)为例来实现 MemTable。跳表是一种随机化的数据结构,它通过在不同层次上维护链表,使得插入、删除和查询操作的时间复杂度平均为 O (log n)。在 Python 中,我们可以使用类来实现跳表。以下是实现跳表的关键代码片段及注释:

import random

class SkipListNode:

def __init__(self, key, value, level):

self.key = key

self.value = value

self.forward = [None] * (level + 1)

class SkipList:

def __init__(self, max_level, p):

self.max_level = max_level

self.p = p

self.header = SkipListNode(-1, -1, max_level)

self.level = 0

def random_level(self):

level = 0

while random.random() < self.p and level < self.max_level:

level += 1

return level

def insert(self, key, value):

update = [None] * (self.max_level + 1)

current = self.header

for i in range(self.level, -1, -1):

while current.forward[i] and current.forward[i].key < key:

current = current.forward[i]

update[i] = current

current = current.forward[0]

if not current or current.key != key:

new_level = self.random_level()

if new_level > self.level:

for i in range(self.level + 1, new_level + 1):

update[i] = self.header

self.level = new_level

new_node = SkipListNode(key, value, new_level)

for i in range(new_level + 1):

new_node.forward[i] = update[i].forward[i]

update[i].forward[i] = new_node

print(f"Insert key: {key}, value: {value}")

def search(self, key):

current = self.header

for i in range(self.level, -1, -1):

while current.forward[i] and current.forward[i].key < key:

current = current.forward[i]

current = current.forward[0]

if current and current.key == key:

return current.value

else:

return None

def delete(self, key):

update = [None] * (self.max_level + 1)

current = self.header

for i in range(self.level, -1, -1):

while current.forward[i] and current.forward[i].key < key:

current = current.forward[i]

update[i] = current

current = current.forward[0]

if current and current.key == key:

for i in range(self.level + 1):

if update[i].forward[i] != current:

break

update[i].forward[i] = current.forward[i]

while self.level > 0 and self.header.forward[self.level] is None:

self.level -= 1

print(f"Delete key: {key}")

# 使用示例

skip_list = SkipList(max_level = 16, p = 0.5)

skip_list.insert(1, "value1")

skip_list.insert(2, "value2")

print(skip_list.search(1))

skip_list.delete(2)在上述代码中,SkipListNode类表示跳表中的节点,每个节点包含键(key)、值(value)以及一个指向下一个节点的数组(forward)。SkipList类则实现了跳表的基本操作,包括插入(insert)、查找(search)和删除(delete)。random_level方法用于随机生成新节点的层数,以保持跳表的平衡性。

- SSTable 实现:SSTable 是一种有序的、不可变的磁盘文件,用于存储从 MemTable 中刷入的数据。我们需要设计 SSTable 的文件格式,并实现数据的写入和读取功能。以下是一个简单的 SSTable 实现示例:

import struct

class SSTable:

def __init__(self, file_name):

self.file_name = file_name

self.file = open(file_name, 'wb')

def write(self, key, value):

key_size = len(key)

value_size = len(value)

self.file.write(struct.pack('!I', key_size))

self.file.write(key.encode())

self.file.write(struct.pack('!I', value_size))

self.file.write(value.encode())

def close(self):

self.file.close()

class SSTableReader:

def __init__(self, file_name):

self.file_name = file_name

self.file = open(file_name, 'rb')

def read(self):

while True:

try:

key_size = struct.unpack('!I', self.file.read(4))[0]

key = self.file.read(key_size).decode()

value_size = struct.unpack('!I', self.file.read(4))[0]

value = self.file.read(value_size).decode()

yield key, value

except struct.error:

break

def close(self):

self.file.close()

# 使用示例

sst = SSTable('test.sst')

sst.write('key1', 'value1')

sst.write('key2', 'value2')

sst.close()

reader = SSTableReader('test.sst')

for key, value in reader.read():

print(f"Read key: {key}, value: {value}")

reader.close()在上述代码中,SSTable类负责将键值对写入文件,它使用struct模块将数据按照指定格式打包写入文件。SSTableReader类则用于从文件中读取数据,按照相同的格式解析数据并返回。

(三)读写操作实现

- 写入操作代码:结合预写日志(WAL)和 MemTable 的写入操作代码如下:

import os

class WAL:

def __init__(self, file_name):

self.file_name = file_name

self.file = open(file_name, 'ab')

def write(self, key, value):

key_size = len(key)

value_size = len(value)

self.file.write(struct.pack('!I', key_size))

self.file.write(key.encode())

self.file.write(struct.pack('!I', value_size))

self.file.write(value.encode())

def close(self):

self.file.close()

class LSM:

def __init__(self, wal_file, memtable_max_size):

self.wal = WAL(wal_file)

self.memtable = SkipList(max_level = 16, p = 0.5)

self.memtable_max_size = memtable_max_size

self.sstables = []

def put(self, key, value):

self.wal.write(key, value)

self.memtable.insert(key, value)

if self.memtable_size() > self.memtable_max_size:

self.flush_memtable()

def memtable_size(self):

# 这里简单假设每个节点占用固定大小,实际需要根据节点结构精确计算

return len(self.memtable.header.forward[0]) * 100

def flush_memtable(self):

sst_file = f"sst_{len(self.sstables)}.sst"

sst = SSTable(sst_file)

current = self.memtable.header.forward[0]

while current:

sst.write(current.key, current.value)

current = current.forward[0]

sst.close()

self.sstables.append(sst_file)

self.memtable = SkipList(max_level = 16, p = 0.5)

# 使用示例

lsm = LSM('wal.log', memtable_max_size = 1000)

lsm.put('key1', 'value1')

lsm.put('key2', 'value2')在上述代码中,WAL类负责将写入操作记录到预写日志中。LSM类则管理整个 LSM - Tree 结构,put方法首先将数据写入 WAL,然后插入 MemTable。当 MemTable 的大小超过阈值时,调用flush_memtable方法将 MemTable 中的数据刷入 SSTable 文件,并重置 MemTable。

- 读取操作代码:从 MemTable、Block Cache(这里简单假设未实现复杂的 Block Cache,直接从 SSTable 读取)到 SSTable 查找数据的代码如下:

class LSM:

# 省略其他方法...

def get(self, key):

value = self.memtable.search(key)

if value:

return value

for sst_file in self.sstables:

reader = SSTableReader(sst_file)

for k, v in reader.read():

if k == key:

reader.close()

return v

reader.close()

return None

# 使用示例

lsm = LSM('wal.log', memtable_max_size = 1000)

# 假设已经进行了一些写入操作

print(lsm.get('key1'))在上述代码中,get方法首先在 MemTable 中查找数据,如果未找到,则依次在各个 SSTable 文件中查找。

(四)合并操作实现

合并多个 SSTable 文件的代码如下:

import heapq

class SSTableMerger:

def __init__(self, sstable_files):

self.sstable_files = sstable_files

self.readers = [SSTableReader(file) for file in sstable_files]

self.heap = []

for i, reader in enumerate(self.readers):

try:

key, value = next(reader.read())

heapq.heappush(self.heap, (key, i, value))

except StopIteration:

pass

def merge(self, output_file):

sst = SSTable(output_file)

while self.heap:

key, reader_index, value = heapq.heappop(self.heap)

sst.write(key, value)

try:

key, value = next(self.readers[reader_index].read())

heapq.heappush(self.heap, (key, reader_index, value))

except StopIteration:

pass

sst.close()

for reader in self.readers:

reader.close()

# 使用示例

sstable_files = ['sst_0.sst','sst_1.sst']

merger = SSTableMerger(sstable_files)

merger.merge('merged.sst')在上述代码中,SSTableMerger类使用堆(heapq)来合并多个 SSTable 文件。它首先将每个 SSTable 文件的第一条记录放入堆中,然后不断从堆中取出最小键值对写入新的 SSTable 文件,并将对应 SSTable 文件的下一条记录放入堆中,直到所有 SSTable 文件的记录都被处理完。

五、案例与应用场景

(一)实际案例分析

以 LevelDB 为例,它是一个由 Google 开发的基于 LSM - Tree 的高效键值存储库 。在一些嵌入式系统和对读写性能有特定要求的应用场景中,LevelDB 展现出了卓越的性能表现。在某物联网项目中,需要对大量传感器产生的数据进行实时存储和查询。LevelDB 利用 LSM - Tree 结构,将传感器数据快速写入 MemTable,再通过顺序写的方式将数据刷入磁盘的 SSTable 文件。在这个过程中,LevelDB 的写入性能优势得到了充分体现,能够轻松应对传感器每秒产生的数千条数据写入请求,并且在数据查询时,通过 MemTable 和 SSTable 的协同查找机制,也能快速返回查询结果,满足了项目对数据读写的实时性要求 。

RocksDB 是 Facebook 开源的存储引擎,同样基于 LSM - Tree 实现 。在大规模分布式系统中,RocksDB 被广泛应用于缓存、存储等多个环节。以 Facebook 的消息存储系统为例,每天需要处理数十亿条消息的存储和读取。RocksDB 通过 LSM - Tree 结构,高效地处理了海量消息的写入操作,即使在高并发的情况下,也能保持稳定的写入性能。在读取方面,RocksDB 通过优化的缓存机制和 SSTable 查找算法,能够快速定位和读取用户的消息,为 Facebook 的用户提供了流畅的消息收发体验 。通过这些实际案例可以看出,基于 LSM - Tree 的数据库在处理海量数据和高并发读写操作时,具有明显的性能优势和应用价值。

(二)适用场景总结

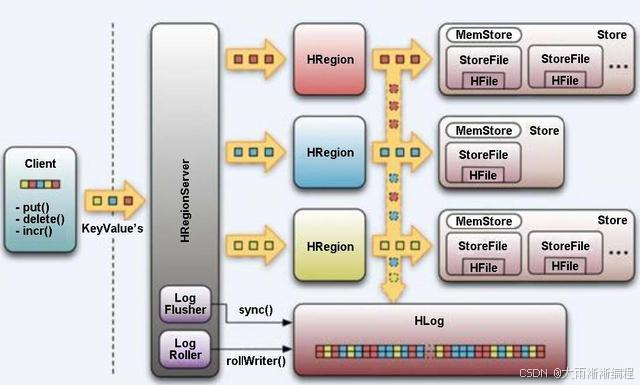

LSM - Tree 适用于多种场景,尤其是写多读少的场景 。在时序数据库中,如 InfluxDB,大量的时间序列数据不断写入,而读取操作相对较少。LSM - Tree 的高效写入性能使得它能够快速处理这些写入请求,同时通过合并操作优化数据存储结构,为后续的查询提供支持。在海量数据存储场景中,LSM - Tree 也表现出色 。随着数据量的不断增长,传统的数据存储方式可能会面临性能瓶颈,而 LSM - Tree 通过将数据分层存储在内存和磁盘中,利用顺序写的优势,能够有效地管理和存储海量数据。在分布式系统中,像 HBase 这样的分布式数据库,基于 LSM - Tree 实现了数据的分布式存储和读写 。它通过将数据分散存储在多个节点上,利用 LSM - Tree 的特性实现了高效的写入和查询操作,同时通过分布式的架构保证了系统的高可用性和可扩展性。LSM - Tree 在大数据、分布式系统等领域有着广泛的应用前景,能够为各种复杂的应用场景提供强大的数据存储和处理能力。

六、总结与展望

(一)LSM-Tree 算法优势与不足

LSM - Tree 算法凭借其独特的设计理念和数据结构,在数据存储和处理领域展现出显著的优势 。其最大的亮点在于写入性能的大幅提升,通过将随机写转化为顺序写,LSM - Tree 在面对海量数据的写入请求时,能够保持高效稳定的表现。在一些物联网项目中,传感器产生的数据如潮水般涌来,LSM - Tree 结构的数据库能够轻松应对每秒数千条甚至数万条数据的写入,为数据的实时采集和存储提供了有力支持。在分布式系统中,LSM - Tree 也能很好地适应高并发的写入场景,保证系统的性能和稳定性 。

然而,LSM - Tree 并非完美无缺 。在读取性能方面,由于数据可能分散存储在多个层级的 SSTable 文件中,查找操作需要遍历多个文件,这使得读取操作的时间复杂度相对较高,尤其在数据量庞大且层级较多的情况下,读取延迟会较为明显。磁盘空间占用也是 LSM - Tree 面临的一个问题 。在合并操作过程中,为了保证数据的有序性和一致性,可能会产生一些临时文件和冗余数据,导致磁盘空间的利用率降低。随着时间的推移,大量的 SSTable 文件也会占用较多的磁盘空间,需要定期进行优化和清理 。

(二)未来发展趋势

随着技术的不断进步,LSM - Tree 算法也在持续演进和优化 。在硬件层面,随着固态硬盘(SSD)的广泛应用,LSM - Tree 可以更好地利用 SSD 的并行读写特性,进一步提升读写性能。一些研究正在探索如何优化 LSM - Tree 的结构和算法,以充分发挥 SSD 的优势,减少读写放大问题,提高存储效率 。在软件层面,未来的 LSM - Tree 可能会与其他先进的技术相结合,如人工智能和机器学习 。通过机器学习算法对数据的访问模式和负载情况进行分析和预测,LSM - Tree 可以动态地调整自身的参数和结构,实现更加智能化的管理和优化。可以根据数据的读写频率和热度,自动调整 SSTable 的层级和合并策略,提高系统的整体性能 。

在应用拓展方面,LSM - Tree 有望在更多领域得到应用 。在区块链技术中,LSM - Tree 可以用于存储和管理区块链的交易数据,利用其高效的写入性能和数据一致性保证,为区块链的高效运行提供支持。在边缘计算领域,设备产生的数据需要在本地进行快速处理和存储,LSM - Tree 的特性使其能够满足边缘计算对数据处理的实时性和高效性要求 。随着大数据、人工智能等技术的不断发展,LSM - Tree 作为一种关键的数据存储和处理技术,将在未来的数字化世界中发挥更加重要的作用,为各个领域的创新和发展提供强大的技术支撑 。

七、互动环节

关于 LSM - Tree 算法,大家如果还有任何疑问,或者在代码实现过程中遇到了困难,欢迎在评论区留言提问。同时,也非常期待有实践经验的小伙伴分享自己在项目中应用 LSM - Tree 的宝贵经验和心得,大家相互交流,共同进步。

如果你觉得这篇文章对你有所帮助,别忘了点赞、收藏。还没有关注我的小伙伴,赶紧点击关注,后续我会分享更多精彩的技术内容,包括分布式系统、大数据处理等前沿领域的知识和实践经验,千万不要错过!

更多推荐

已为社区贡献27条内容

已为社区贡献27条内容

所有评论(0)