macbook pro 内存32G,显卡AMD Radeon Pro 5500M 4 GBIntel UHD Graphics 630 1536 MB, 能运行Llama 3-8B 量化级别Q4 吗

首选方案:直接使用Ollama。它最省心,自动化程度最高,并且通过命令行运行最稳定。备用方案:使用LM Studio。适合喜欢图形化界面、不想操作命令行的用户。您的体验:您完全可以正常使用Llama 3-8B进行文档摘要、创意写作、编程辅助、信息问答等任务。它的理解和生成质量会很高,只是生成速度不会“秒出”,需要稍等几秒到十几秒,但这完全在可接受范围内。恭喜您,您的MacBook Pro是一台非常

·

当然可以!您的 MacBook Pro 配置完全能够运行 Q4 量化版本的 Llama 3-8B,并且能获得相当可用的体验。

硬件分析

- 内存 (RAM: 32GB): 完全足够,是您的最大优势。Q4量化模型约占用 4.8GB,macOS系统本身需要几个GB,剩下的大量内存可以用于缓存和保证系统流畅。这是运行模型的保障。

- AMD 显卡 (VRAM: 4GB): 显存不足以单独容纳整个模型。macOS 的 AI 框架(MLX, llama.cpp)会主要利用系统内存,但可以将计算任务分配给 AMD 显卡,从而获得比纯CPU更快的速度。

- Intel UHD 显卡: 在本次部署中基本不参与计算,可以忽略。

结论:您的设备会以 “内存为主、AMD GPU加速” 的模式运行模型。效果会远好于纯CPU的旧电脑,但速度会慢于拥有足够显存的NVIDIA显卡。生成速度预计在 5-15 token/秒,属于完全正常可用的范围。

详细部署步骤 (最佳方案:使用 Ollama)

这是最简单、最无需折腾的方法,Ollama 会自动为您处理所有底层优化(包括利用AMD显卡)。

第一步:安装 Ollama

- 访问 Ollama 官网:Ollama

- 点击 Download,选择 macOS (Apple Silicon/Intel) 版本进行下载。

- 下载完成后,打开

.dmg文件,将 Ollama 图标拖拽到 Applications 文件夹中完成安装。 - 首次启动:在“应用程序”中找到 Ollama 并运行它。屏幕上可能不会出现任何窗口,但它会在菜单栏显示一个小图标,表示服务已在后台运行。

第二步:通过终端运行模型

- 打开您的终端(Terminal)应用程序(在“启动台”->“其他”里可以找到)。

- 在终端中,输入以下命令并回车:

ollama run llama3:8b-

llama3:8b这个标签默认就包含了最流行的 Q4 量化版本。

- 等待下载:Ollama 会自动开始下载模型文件(约 4.8GB)。请保持网络通畅,并耐心等待。下载完成后会自动加载并进入对话界面。

- 开始对话:当终端出现

>>>提示符时,表示模型已加载成功。您可以直接输入问题开始对话。

>>> 请用鲁迅的文风写一段关于秋天的短文。第三步(可选):使用图形化聊天界面

Ollama 本身是命令行工具,但您可以搭配一个图形界面来使用。

- 开源方案:Open WebUI (原名 Ollama WebUI)

-

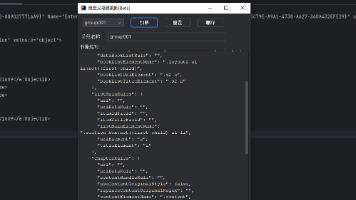

- 在终端运行以下命令,通过 Docker 来安装(需先安装 Docker Desktop):

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main-

- 安装并启动Docker后,在浏览器中访问

http://localhost:3000 - 首次使用需要创建一个账号,然后在设置中将 Ollama 的API地址设置为

http://host.docker.internal:11434。

- 安装并启动Docker后,在浏览器中访问

- 简单方案:聊天机器人

-

- 在Mac App Store中搜索 “MacGPT” 或 “ChatBot for Ollama” 等客户端,它们可以直接连接您本地的Ollama服务,提供更美观的聊天窗口。

备选方案:使用 LM Studio

如果您更喜欢图形化的一站式解决方案,LM Studio 是另一个绝佳选择。

- 下载安装:

-

- 访问 LM Studio 官网。

- 下载 macOS 版本并安装。

- 搜索下载模型:

-

- 打开 LM Studio,在首页的搜索框中搜索

Llama 3 8B。 - 您会看到很多版本,选择任何一个标明 “Q4”、“4-bit”、“GGUF” 格式的模型文件(例如由

TheBloke提供的版本,他是量化领域的权威)。 - 点击下载,LM Studio 会自动处理。

- 打开 LM Studio,在首页的搜索框中搜索

- 加载与聊天:

-

- 下载完成后,切换到 Chat 标签页。

- 在右上角的模型选择下拉框中,选中您刚刚下载的模型。

- 点击 Load 按钮加载模型。

- 加载完成后,直接在底部输入框开始聊天。

总结与建议

- 首选方案:直接使用 Ollama。它最省心,自动化程度最高,并且通过命令行运行最稳定。

- 备用方案:使用 LM Studio。适合喜欢图形化界面、不想操作命令行的用户。

- 您的体验:您完全可以正常使用Llama 3-8B进行文档摘要、创意写作、编程辅助、信息问答等任务。它的理解和生成质量会很高,只是生成速度不会“秒出”,需要稍等几秒到十几秒,但这完全在可接受范围内。

恭喜您,您的MacBook Pro是一台非常好的本地AI实验设备,尽情享受吧!

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)