【Coze工作流实战】学习笔记(2)

模型定位:DeepSeek 是一款轻量化大模型,具备较好的自然语言处理能力,同时对硬件资源要求相对较低,适合个人或中小企业在本地环境部署,满足离线使用、数据隐私保护等需求。核心优势轻量化:模型体积较小,可在普通 PC 或服务器上运行,无需高端 GPU 集群。兼容性:支持与主流智能体开发平台(如 Coze)集成,适配多种工作流场景。隐私性:本地部署可避免数据上传至云端,适合处理敏感信息(如企业内部数

·

《03 DeepSeek 本地部署》视频内容整理

一、DeepSeek 模型核心概述

- 模型定位:DeepSeek 是一款轻量化大模型,具备较好的自然语言处理能力,同时对硬件资源要求相对较低,适合个人或中小企业在本地环境部署,满足离线使用、数据隐私保护等需求。

- 核心优势:

- 轻量化:模型体积较小,可在普通 PC 或服务器上运行,无需高端 GPU 集群。

- 兼容性:支持与主流智能体开发平台(如 Coze)集成,适配多种工作流场景。

- 隐私性:本地部署可避免数据上传至云端,适合处理敏感信息(如企业内部数据、个人隐私数据)。

二、DeepSeek 本地部署前期准备

-

硬件与环境要求

- 硬件配置:推荐 CPU 至少 8 核以上,内存 16GB+(若启用 GPU 加速,需 NVIDIA 显卡支持 CUDA,显存 8GB+)。

- 操作系统:支持 Windows 10/11、Linux(如 Ubuntu 20.04+)、macOS(Intel 芯片或 M 系列芯片)。

- 依赖工具:需安装 Python 3.8+、Git(用于拉取模型代码)、包管理工具 pip 或 conda。

-

模型资源获取

- 官方渠道:从 DeepSeek 官网或开源社区(如 GitHub、Hugging Face)下载模型权重文件(如 DeepSeek-7B、DeepSeek-13B 等不同参数规模版本)。

- 版本选择:根据硬件性能选择模型版本(参数越小,对硬件要求越低,适合入门部署)。

三、DeepSeek 本地部署详细步骤

-

环境配置

- 创建虚拟环境:使用 conda 或 venv 创建独立的 Python 环境,避免依赖冲突。

bash

conda create -n deepseek-env python=3.10 conda activate deepseek-env - 安装依赖库:安装模型运行所需的库(如 transformers、accelerate、torch 等)。

bash

pip install transformers accelerate torch sentencepiece

- 创建虚拟环境:使用 conda 或 venv 创建独立的 Python 环境,避免依赖冲突。

-

模型部署与启动

- 解压模型文件:将下载的模型权重文件解压至本地目录(如

./deepseek-model)。 - 编写启动脚本:使用 Python 调用 transformers 库加载模型,启动本地 API 服务(支持 HTTP 接口调用)。

python

运行

from transformers import AutoTokenizer, AutoModelForCausalLM import uvicorn from fastapi import FastAPI app = FastAPI() tokenizer = AutoTokenizer.from_pretrained("./deepseek-model") model = AutoModelForCausalLM.from_pretrained("./deepseek-model") @app.post("/generate") def generate(text: str): inputs = tokenizer(text, return_tensors="pt") outputs = model.generate(**inputs, max_new_tokens=100) return tokenizer.decode(outputs[0], skip_special_tokens=True) if __name__ == "__main__": uvicorn.run(app, host="0.0.0.0", port=8000) - 启动服务:运行脚本,验证模型是否成功加载(若出现 “Started server process” 提示,说明部署成功)。

- 解压模型文件:将下载的模型权重文件解压至本地目录(如

-

本地测试

- 接口调用:通过 curl 或 Postman 发送请求,测试模型生成能力。

bash

curl -X POST http://localhost:8000/generate -H "Content-Type: application/json" -d '{"text": "什么是RAG技术?"}' - 结果验证:检查返回结果是否符合预期,若出现卡顿或错误,需排查硬件资源是否充足、依赖是否安装正确。

- 接口调用:通过 curl 或 Postman 发送请求,测试模型生成能力。

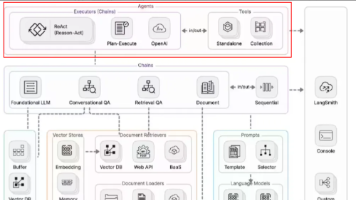

四、DeepSeek 与 Coze 平台的集成方法

1.** 配置 Coze 外部模型 **- 打开 Coze 平台,进入 “模型管理” 模块,选择 “添加外部模型”。

- 填写本地 DeepSeek 服务的 API 地址(如

http://localhost:8000/generate),设置调用密钥(可选,用于权限控制)。

2.** 工作流中调用本地模型 **- 在 Coze 工作流设计器中,添加 “生成节点”,选择已配置的 DeepSeek 本地模型作为生成引擎。

- 测试集成效果:构建简单工作流(如用户提问→调用 DeepSeek 生成回答),验证本地模型是否能正常响应 Coze 的调用请求。

3.** 集成注意事项 **- 网络互通:确保 Coze 运行环境(如云端或本地客户端)能访问 DeepSeek 本地服务的 IP 和端口。

- 性能适配:若工作流并发量较高,需优化本地模型的部署配置(如启用 GPU 加速、调整最大生成 tokens 限制)。

五、常见问题与优化方案

-** 部署失败 **:

- 若提示 “内存不足”,可尝试使用更小参数的模型版本,或关闭其他占用资源的程序。

- 若依赖安装报错,检查 Python 版本是否兼容,或使用官方推荐的依赖版本清单。

-** 生成速度慢 **: - 启用 GPU 加速:确保已安装对应版本的 CUDA 和 cuDNN,模型加载时指定

device_map="auto"。 - 优化生成参数:减少

max_new_tokens值,或使用量化模型(如 4-bit、8-bit 量化)。

-** 集成异常 **: - 检查 API 接口格式是否与 Coze 要求一致(如请求 / 响应的 JSON 结构)。

- 关闭本地防火墙或添加端口例外,确保 Coze 能正常访问本地服务。

更多推荐

已为社区贡献48条内容

已为社区贡献48条内容

所有评论(0)