(IJCAI2025)傅里叶变换结合注意力机制,涨点起飞!

最近注意力机制又双叒叕火出圈了,和傅里叶变换的组合直接杀穿顶会!比如IJCAI25上的SRConvNet,在图像超分辨率任务里直接干出 SOTA 性能!为什么这种跨界操作如此之香?因为傅里叶变换能把数据拆成不同频率的“积木块”,而注意力机制能锁定最关键的部分,这对很多领域(尤其是信号处理)都是不可或缺!不过这方向目前还存在些老问题,比如计算量爆炸、泛化能力拉胯...但想想这不都是创新突破口?

最近注意力机制又双叒叕火出圈了,和傅里叶变换的组合直接杀穿顶会!比如IJCAI25上的SRConvNet,在图像超分辨率任务里直接干出 SOTA 性能!

为什么这种跨界操作如此之香?因为傅里叶变换能把数据拆成不同频率的“积木块”,而注意力机制能锁定最关键的部分,这对很多领域(尤其是信号处理)都是不可或缺!

不过这方向目前还存在些老问题,比如计算量爆炸、泛化能力拉胯...但想想这不都是创新突破口?就还拿SRConvNet举例,这模型通过频域门控和轻量卷积把FLOPs砍半,思路是不是能直接套到小目标检测等场景里?

所以如果有兴趣,就快上车,我已经整理好了12篇傅里叶变换+注意力机制的最新论文,方便大家作参考,想冲高分的同学必看,说不定下一个顶会就是你的!

扫描下方二维码,免费获取全部论文合集及项目代码

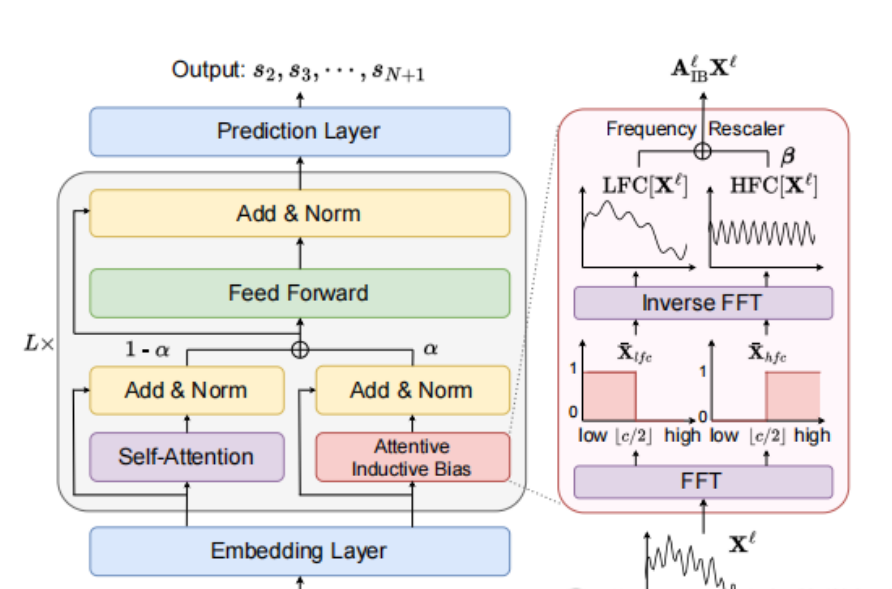

1:论文:An Attentive Inductive Bias for Sequential Recommendation beyond the Self-Attention

内容

该论文提出了一种名为BSARec的新型序列推荐模型,旨在解决Transformer在序列推荐(SR)中因自注意力机制导致的过平滑(oversmoothing)问题,通过傅里叶变换引入归纳偏差(inductive bias),结合低频和高频信息来缓解过平滑问题。

2:论文:FGA: Fourier-Guided Attention Network for Crowd Count Estimation

内容

该论文提出了一种名为FGA的新型注意力机制模块,用于人群计数任务。FGA通过结合快速傅里叶变换(FFT)和空间注意力机制,能够高效地捕获多尺度信息,包括全局模式、半全局模式和局部特征。该模块采用双路径架构:一条路径通过FFT处理全局特征,另一条路径通过传统卷积和通道注意力处理半全局及局部特征。

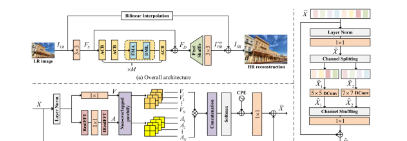

3:论文:SRConvNet: A Transformer-Style ConvNet for Lightweight Image Super-Resolution

内容

该论文介绍了一种名为SRConvNet的轻量级单图像超分辨率(SISR)模型,旨在结合卷积神经网络和视觉变换器的优点,以实现高效的超分辨率重建,FMA通过区域频率-空间调制和聚合来模拟Transformer中的多头自注意力机制,同时降低计算复杂度,DML则利用混合尺度深度动态卷积和通道分割与混洗来增强模型的局部性和适应性。

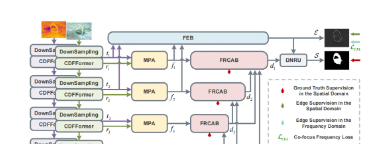

4:论文:Deep Fourier-embedded Network for RGB and Thermal Salient Object Detection

内容

该论文提出了一种基于快速傅里叶变换(FFT)的深度网络DFENet,用于RGB和热成像(RGB-T)图像中的显著目标检测。DFENet通过三个关键模块——模态协调感知注意力(MPA)、频率分解边缘感知块(FEB)和傅里叶残差通道注意力块(FRCAB)——有效地融合了RGB和热成像模态,并在解码阶段生成高分辨率的显著图。

扫描下方二维码,免费获取全部论文合集及项目代码

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)