2025年完整指南:字节跳动 Seed-OSS-36B 开源大模型深度解析

Seed-OSS 是字节跳动 Seed 团队发布的开源大语言模型系列,专为长上下文、推理、智能体和通用能力而设计。

·

🎯 核心要点 (TL;DR)

- 突破性发布:字节跳动发布 Seed-OSS 系列开源大模型,采用 Apache-2.0 许可证

- 技术亮点:36B 参数,原生 512K 上下文,可控思维预算,仅用 12T tokens 训练

- 性能卓越:在多项基准测试中达到开源 SOTA,特别在推理、代码和智能体任务表现突出

- 实用价值:提供基础模型和指令微调版本,支持研究和商业应用

目录

什么是 Seed-OSS 模型 {#what-is-seed-oss}

Seed-OSS 是字节跳动 Seed 团队发布的开源大语言模型系列,专为长上下文、推理、智能体和通用能力而设计。该模型系列包含三个版本:

- Seed-OSS-36B-Base:基础模型(包含合成指令数据预训练版本)

- Seed-OSS-36B-Base-woSyn:纯净版基础模型(无合成指令数据)

- Seed-OSS-36B-Instruct:指令微调模型(适用于各种下游任务)

💡 专业提示

Seed-OSS 主要针对国际化(i18n)用例进行优化,在多语言支持方面表现出色。

核心技术特性 {#key-features}

🎯 可控思维预算

- 用户可灵活调整推理长度

- 支持动态控制思维预算,提升推理效率

- 建议使用 512 的整数倍(512、1K、2K、4K、8K、16K)

🧠 增强推理能力

- 专门针对推理任务优化

- 保持平衡且出色的通用能力

- 在 AIME24 达到 91.7 分,AIME25 达到 84.7 分

🤖 智能体能力

- 在工具使用和问题解决等智能体任务中表现卓越

- TAU1-Retail 达到 70.4 分(开源 SOTA)

- SWE-Bench Verified 达到 56 分(开源 SOTA)

🔬 研究友好

- 提供包含和不包含合成指令数据的预训练模型

- 为研究社区提供更多样化的选择

📚 原生长上下文

- 支持高达 512K 的原生长上下文

- RULER (128K) 基准测试达到 94.6 分

模型架构详解 {#architecture}

| 参数 | 规格 |

|---|---|

| 参数量 | 36B |

| 注意力机制 | GQA (Grouped Query Attention) |

| 激活函数 | SwiGLU |

| 层数 | 64 |

| QKV 头数 | 80 / 8 / 8 |

| 头维度 | 128 |

| 隐藏层维度 | 5120 |

| 词汇表大小 | 155K |

| 上下文长度 | 512K |

| RoPE 基频 | 1e7 |

⚠️ 注意

36B 参数的模型在 Q4 量化下大约需要 20GB+ 显存,建议使用支持部分卸载的推理框架。

性能基准测试 {#benchmarks}

基础模型性能对比

| 基准测试 | Qwen3-30B-A3B-Base | Qwen2.5-32B-Base | Seed-OSS-36B-Base | Seed-OSS-36B-Base-woSyn |

|---|---|---|---|---|

| MMLU-Pro | 59.8 | 58.5 | 65.1 | 60.4 |

| MMLU | 82.7 | 84.0 | 84.9 | 84.8 |

| BBH | 81.4 | 79.1 | 87.7 | 87.2 |

| GSM8K | 87.0 | 87.5 | 90.8 | 90.3 |

| MATH | 61.1 | 63.5 | 81.7 | 61.3 |

| HumanEval | 70.7 | 47.6 | 76.8 | 75.6 |

指令微调模型表现

| 任务类别 | 基准测试 | Qwen3-30B-A3B-Thinking | Qwen3-32B | Seed-OSS-36B-Instruct |

|---|---|---|---|---|

| 数学推理 | AIME24 | 87.7 | 82.7 | 91.7 |

| 数学推理 | AIME25 | 81.3 | 73.3 | 84.7 |

| 代码能力 | LiveCodeBench v6 | 60.3 | 53.4 | 67.4 |

| 智能体 | TAU1-Retail | 58.7 | 40.9 | 70.4 |

| 智能体 | SWE-Bench Verified | 31.0 | 23.4 | 56.0 |

| 长上下文 | RULER (128K) | 94.5 | 77.5 | 94.6 |

✅ 最佳实践

推荐使用 temperature=1.1 和 top_p=0.95 进行采样以获得最佳性能。

可控思维预算机制 {#thinking-budget}

工作原理

Seed-OSS 的独特之处在于其可控思维预算机制,用户可以灵活指定模型的思考预算:

<seed:think>

让我逐步解决这个问题...

<seed:cot_budget_reflect>我已使用 129 个 tokens,还剩 383 个 tokens 可用。</seed:cot_budget_reflect>

使用幂规则...

<seed:cot_budget_reflect>我已使用 258 个 tokens,还剩 254 个 tokens 可用。</seed:cot_budget_reflect>

或者,记住...

<seed:cot_budget_reflect>我已耗尽 token 预算,现在开始回答问题。</seed:cot_budget_reflect>

</seed:think>

预算设置指南

| 预算值 | 适用场景 | 性能表现 |

|---|---|---|

| 0 | 需要直接回答 | 快速响应,无思考过程 |

| 512 | 简单问题 | 基础推理,适中性能 |

| 1K-2K | 中等复杂度 | 平衡效率与质量 |

| 4K-8K | 复杂推理 | 深度思考,高质量输出 |

| 16K+ | 极复杂任务 | 最大推理能力 |

| 默认(-1) | 无限制 | 自动调节思考长度 |

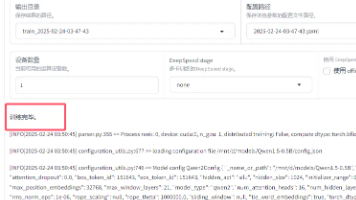

快速开始指南 {#quick-start}

环境准备

pip3 install -r requirements.txt

pip install git+ssh://git@github.com/Fazziekey/transformers.git@seed-oss

基础使用

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name_or_path = "ByteDance-Seed/Seed-OSS-36B-Instruct"

tokenizer = AutoTokenizer.from_pretrained(model_name_or_path)

model = AutoModelForCausalLM.from_pretrained(

model_name_or_path,

device_map="auto"

)

messages = [

{"role": "user", "content": "如何制作意大利面?"},

]

tokenized_chat = tokenizer.apply_chat_template(

messages,

tokenize=True,

add_generation_prompt=True,

return_tensors="pt",

thinking_budget=512 # 控制思维预算

)

outputs = model.generate(

tokenized_chat.to(model.device),

max_new_tokens=2048

)

output_text = tokenizer.decode(outputs[0])

vLLM 部署

# 安装支持 Seed-OSS 的 vLLM 版本

VLLM_USE_PRECOMPILED=1 VLLM_TEST_USE_PRECOMPILED_NIGHTLY_WHEEL=1 \

pip install git+ssh://git@github.com/FoolPlayer/vllm.git@seed-oss

# 启动 API 服务器

python3 -m vllm.entrypoints.openai.api_server \

--host localhost \

--port 4321 \

--model ./Seed-OSS-36B-Instruct \

--tensor-parallel-size 8 \

--dtype bfloat16

与竞品对比分析 {#comparison}

训练效率对比

| 模型 | 参数量 | 训练 Tokens | 上下文长度 | 特殊能力 |

|---|---|---|---|---|

| Seed-OSS-36B | 36B | 12T | 512K | 可控思维预算 |

| Qwen3-30B-A3B | 30B | 32T | 1M (RoPE) | 推理优化 |

| Qwen2.5-32B | 32B | 18T | 128K | 通用能力 |

| Gemma3-27B | 27B | 未公开 | 8K | Google 生态 |

💡 专业提示

Seed-OSS 仅用 12T tokens 就达到了优异性能,展现了高效的训练策略和数据质量。

应用场景适配

🤔 常见问题解答 {#faq}

Q: Seed-OSS 与 GPT-OSS 有什么关系?

A: Seed-OSS 是字节跳动独立开发的模型,与 OpenAI 的 GPT-OSS 没有直接关系。两者都采用了可控思维预算的设计理念,但在架构和训练方法上有所不同。

Q: 36B 参数的模型需要多少显存?

A:

- FP16: 约 72GB

- INT8: 约 36GB

- INT4: 约 18-20GB

- 建议使用支持部分卸载的推理框架,如 vLLM 或 llama.cpp

Q: 如何选择合适的思维预算?

A: 根据任务复杂度选择:

- 简单 QA:512 tokens

- 数学推理:2K-4K tokens

- 复杂编程:4K-8K tokens

- 研究分析:8K+ tokens

Q: Base 版本和 woSyn 版本有什么区别?

A:

- Base 版本:包含合成指令数据的预训练,性能更好

- woSyn 版本:纯净的基础模型,适合研究和自定义微调

Q: 模型支持哪些语言?

A: Seed-OSS 主要针对国际化用例优化,支持多种语言,在 MMMLU 多语言基准上达到 78.4 分。

Q: 商业使用是否有限制?

A: 采用 Apache-2.0 许可证,允许商业使用,但建议详细阅读许可证条款。

总结与建议

Seed-OSS-36B 代表了开源大模型领域的重要进展,其独特的可控思维预算机制和优异的性能表现使其成为研究和应用的理想选择。

🎯 推荐使用场景

- 研究机构:利用 woSyn 版本进行基础研究

- 企业应用:部署 Instruct 版本构建智能应用

- 开发者:使用可控思维预算优化推理效率

- 教育领域:作为教学和学习的优质开源资源

📈 未来展望

- 期待更大规模版本的发布(如传闻中的 200B MoE 模型)

- 持续关注社区反馈和性能优化

- 探索更多创新的推理控制机制

✅ 立即行动

访问 Hugging Face 下载模型,或查看 GitHub 仓库 获取最新文档和示例代码。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)