Macaron 加速 RL 应用探索的三种场景(下篇)

Macaron团队基于强化学习平台,探索了三个关键应用场景:Balanced Reasoning强调在保证正确性的前提下缩短推理过程,提高用户体验与资源效率;Agentic Memory利用多轮对话机制与记忆向量,实现跨长对话的精确记忆,提升长期任务的连贯性;Human-Agent Interaction则通过情感反馈与动态奖励机制,使模型具备更人性化的沟通方式和高效工具调用能力。这些应用体现了大

目录

一、Balanced Reasoning:兼顾正确性与响应效率

三、Human‑Agent Interaction:让模型更懂人

开场:从技术平台走向真实产品

在上篇文章中,我们梳理了 Macaron(https://macaron.im/)平台背后的一系列技术创新——All‑Sync RL 消除 GPU 泡沫、LoRA 减少通信开销、DAPO 稳定策略优化以及截断重要性采样解决分布匹配问题。这些工作解决了大模型强化学习训练的“成本和稳定性”难题,使得在百亿级乃至千亿级参数模型上运行 RLHF 成为可能。完成技术平台的搭建之后,自然要考虑如何将这些能力落地到实际应用中。

根据 Macaron 博客(https://mindlabs.macaron.im/)中的介绍,他们将这一高效的 RL 平台应用于三个关键场景:Balanced Reasoning、Agentic Memory 和 Human‑Agent Interaction[1][2][3]。这些任务分别针对推理效率、长期记忆和情感交互三大方面,是 Macaron 产品在体验层面的核心功能。这篇下篇文章将结合原文内容与个人理解,详细解析这三种场景的设计理念、实验结果以及背后的技术思考,并对未来的优化方向提出一些建议。

一、Balanced Reasoning:兼顾正确性与响应效率

1. 背景与需求

在大语言模型应用中,用户常常会提出涉及数学、逻辑推理或复杂推算的任务。在以往的 RLHF 训练中,为了保证模型能够详细展示推理过程,鼓励模型输出尽可能完整的“chain-of-thought”(思维链),即列举推理的每个步骤。然而,这种方法存在两个问题:

- 计算成本高:生成长文本意味着更多的 tokens,需要更长的时间和更高的计算资源;

- 用户体验一般:对于非专业用户而言,冗长的证明过程会降低可读性,真正需要的是正确且简洁的答案。

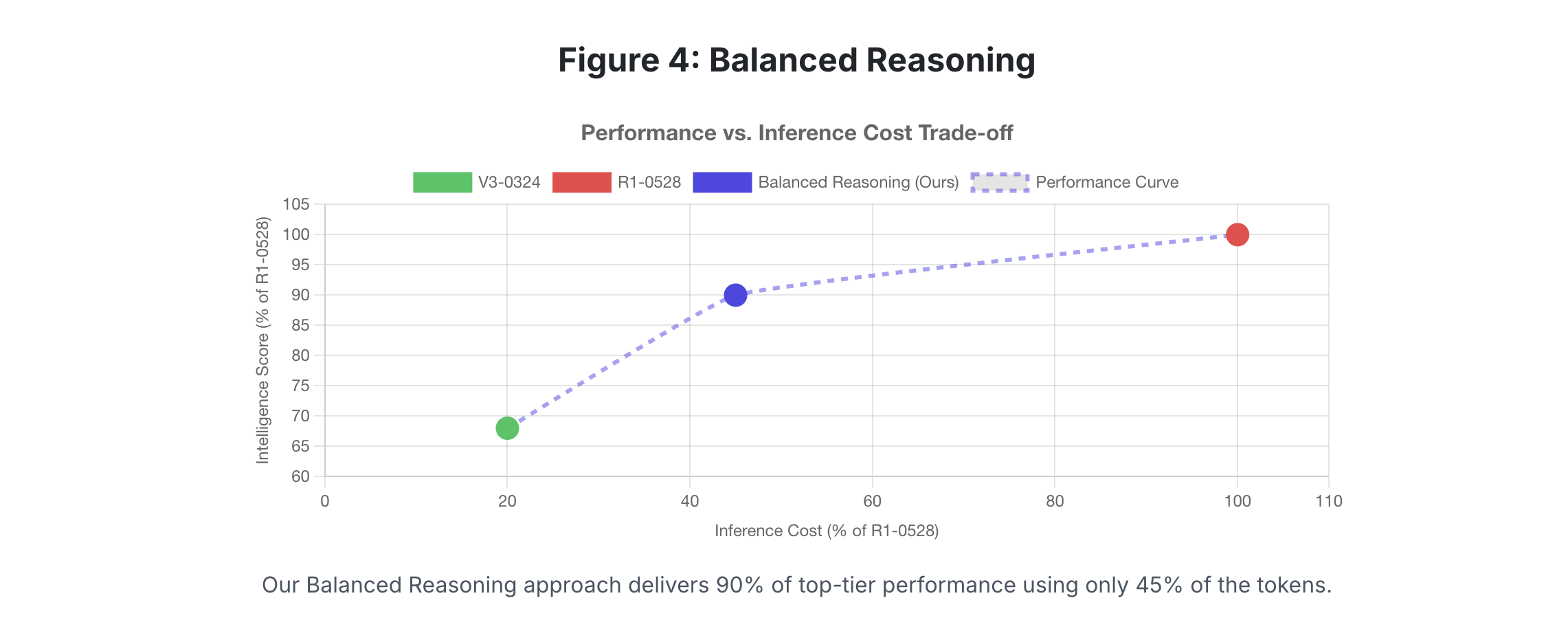

因此,Macaron 团队提出了 Balanced Reasoning 任务。在奖励函数的设计上,他们不仅考虑最终答案的正确性,还对推理过程的长度进行惩罚——即对于相同准确度的输出,生成更短推理链的模型会获得更高奖励[1]。这种设计实际上在效率与效果之间做了折衷。具体而言,团队在奖励模型中增加了一个 penalty 项,该项随着输出 token 数量增长而增加,从而引导模型在保证正确的同时缩短推理路径。

2. 实验与结果

在 Balanced Reasoning 任务中,Macaron 用一批复杂数学题和逻辑推理题作为训练样本。官方博客提到,他们通过 Balanced Reasoning 达到了原始 R1 模型约 90% 的性能(即答案正确率几乎与基线持平),同时推理过程中使用的 tokens 仅为基线模型的 45%[1]。从效率视角看,几乎减少了一半的文本长度意味着显著的成本节约。

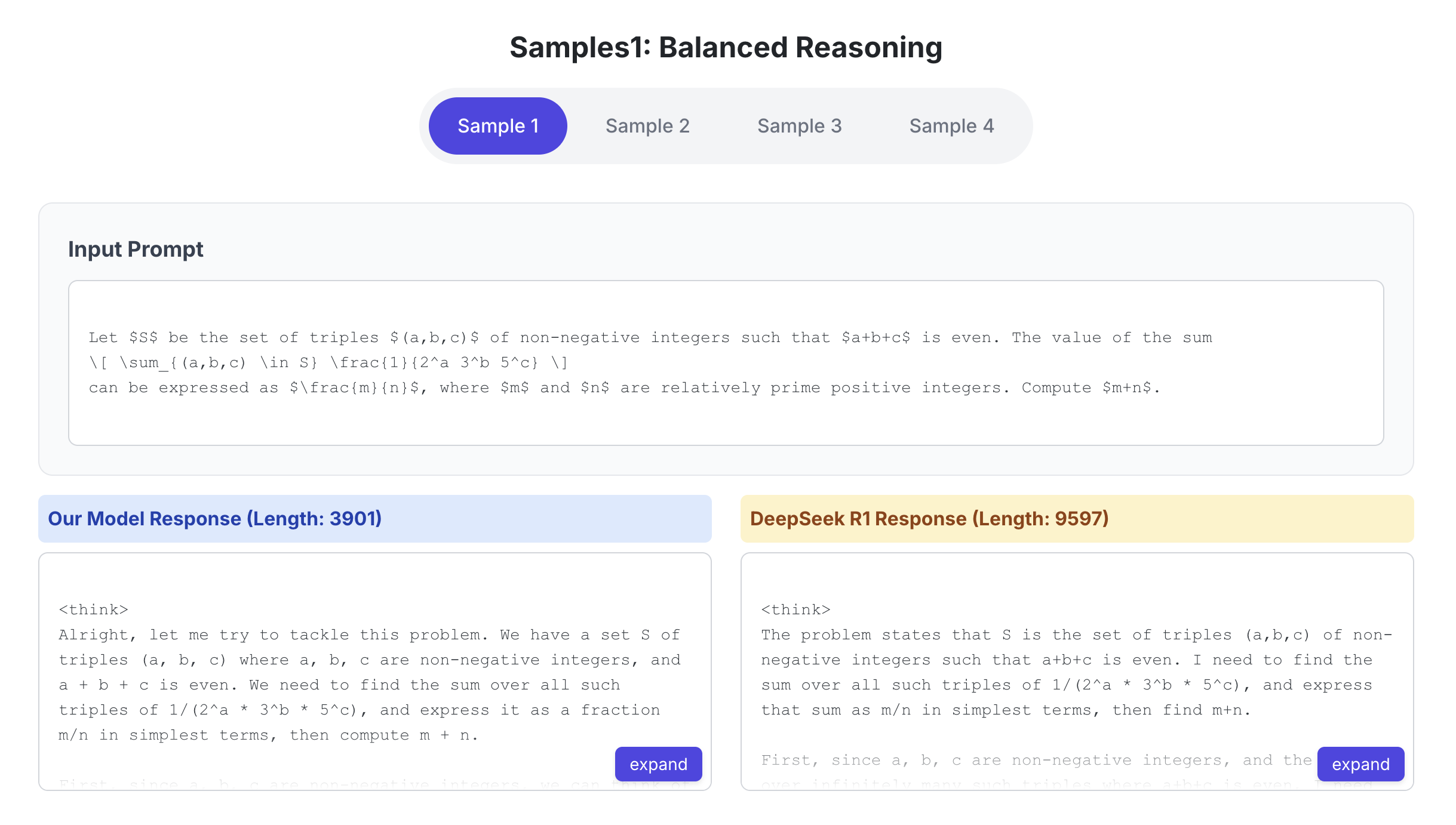

他们还在博文中展示了一些样例题目,例如求解带有奇偶性约束的几何级数求和,或是涉及组合数学的复杂表达式。在这些题目中,Macaron 的 RL 模型给出的解答包含必要的推理步骤,但避免了冗长的自言自语,最终解答更为紧凑。值得指出的是,原文并未详细列出样例的逐行推理过程,不过可以猜测模型通过奖惩机制学会只保留对解决问题至关重要的逻辑链。

3. 技术分析与启示

从 RL 的角度看,Balanced Reasoning 可以看作是在奖励函数中加入长度惩罚的一种 成本敏感优化。这一思路其实早在机器翻译和文本摘要任务中就出现过:例如通过 length normalization 或最小化逐字生成的 cost 来鼓励模型生成更短输出。将其应用于 RLHF 训练的大模型中,则需要解决奖励设计的细粒度问题。奖励过强会导致模型省略必要的推理步骤,影响准确性;奖励过弱则无法起到缩短输出的效果。因此,如何根据任务复杂度适配惩罚系数,是 Balanced Reasoning 成功的关键。

此外,这一任务为“chain-of-thought”导向的模型训练提供了一个思考方向。在学术界,关于是否公开模型的完整思维链一直有争论。一些工作发现,向模型揭示完整思维链可能导致训练数据泄露;另一些研究指出,长思维链虽然有助于模型自身推理,但对最终答案并非必需。Macaron 的 Balanced Reasoning 提供了一种实践:通过奖励设计引导模型保留必要的推理步骤而非照搬全部思考,从而在避免冗长输出的同时保持解题准确性。

二、Agentic Memory:构建跨对话的长期记忆

1. 背景

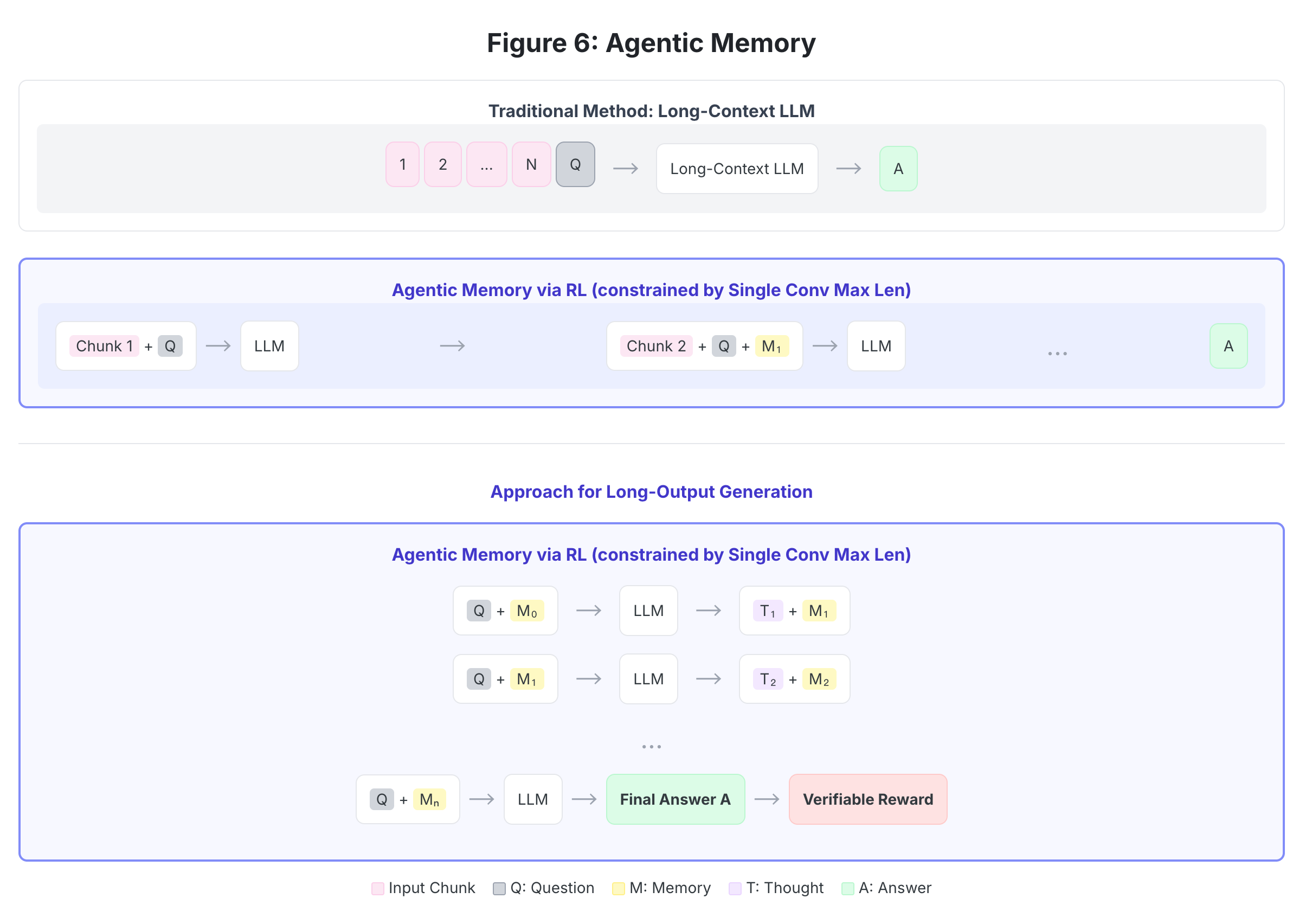

在真实的对话场景中,用户与智能体的互动往往是多轮持续的。例如,在学习指导、项目管理或长期咨询过程中,系统需要记住用户先前提供的信息,并在后续步骤中准确引用或推断。不少模型试图通过增大上下文窗口来解决这一需求,但这会导致显著的内存和计算开销,且上下文长度即便增加也终有上限。

2. Macaron 的 Multi‑conv DAPO 方案

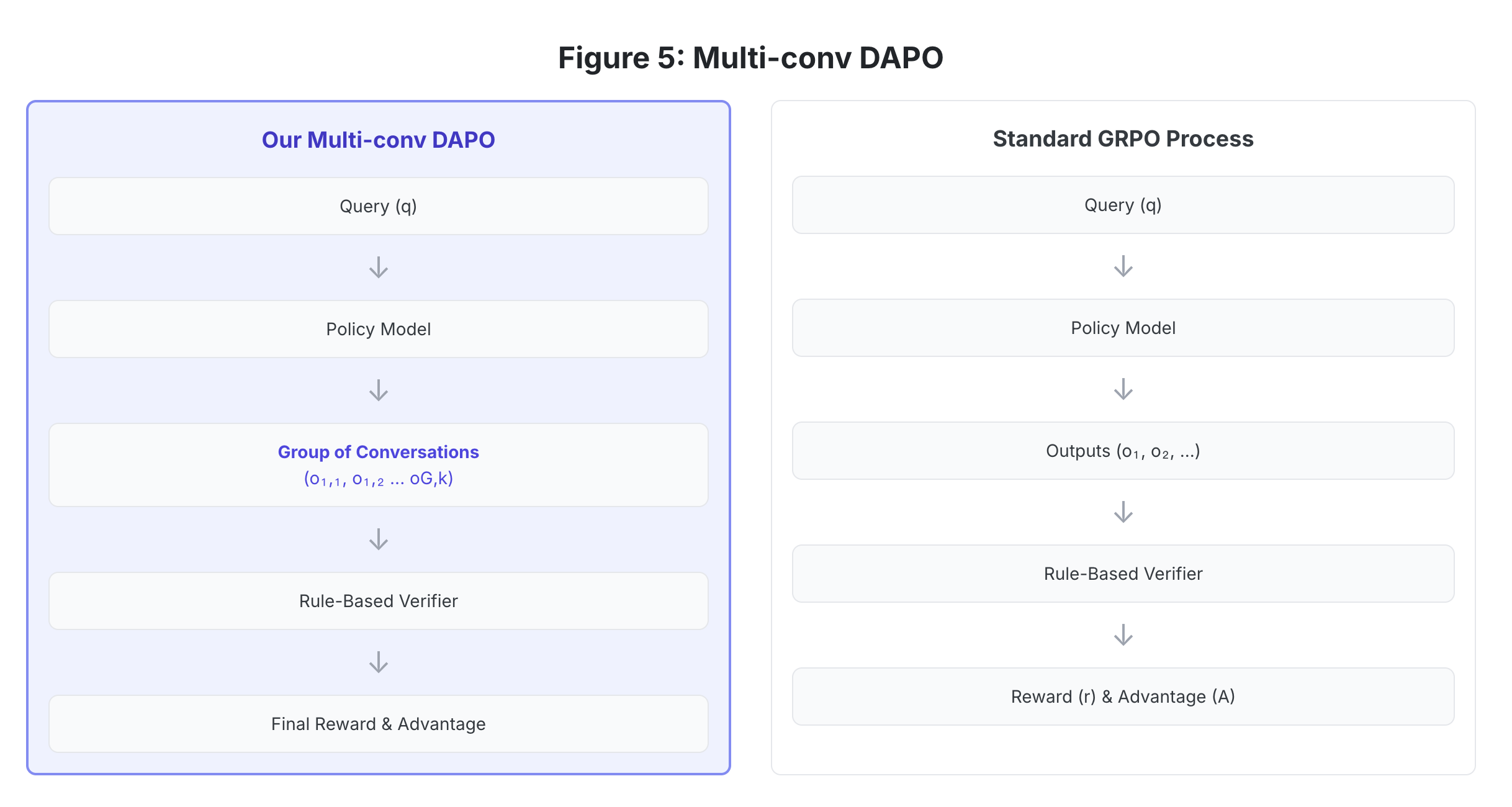

为实现更长尺度的记忆,Macaron 提出了 Agentic Memory 任务,并使用一个称为 Multi-conv DAPO 的框架来实现。简而言之,这种方法将长对话拆分成多个 conversation chunks,并在每个分段中单独训练模型生成局部推理链和中间记忆,然后通过内部“记忆向量” (Memory Vector) 将这些段落串联起来[2][4]。

按照博客中的描述,整个流程如下:首先,系统将原始问题和历史对话分成若干片段;模型在第一个片段上生成回答和一个记忆向量 $M_1$;随后,第二个片段会与记忆向量 $M_1$ 一起输入模型,生成新的回答和新的记忆向量 $M_2$;如此往复,直至处理完整个对话,最终生成答案 $A$。这一过程中,一个 规则验证器(Rule‑Based Verifier)负责检查每个片段的输出是否符合逻辑和上下文要求,并对模型的表现进行奖励或惩罚[2][4]。这样,即便单次推理的长度受到约束,模型也能通过记忆向量记住先前信息,实现跨数万 tokens 的长期记忆。

为了帮助读者理解,下面用一个例子来说明 Agentic Memory 的思路。假设用户问:“你可以帮助我规划一个六个月的训练计划吗?我每周想跑三次步,起始里程是 5 公里,每月增加 10%。”传统长上下文模型会将整段对话和规则一次性输入,产出完整计划。而 Agentic Memory 模型则会在第一轮对话中先询问目标、起始里程等基本信息,产生记忆向量;在后续轮次中根据用户反馈逐步更新计划和记忆。每一段对话都得到奖励模型的评估,确保信息传递的准确性。最终模型不需要将所有对话记录都放入上下文,就能生成连贯且准确的长期计划。

3. 技术分析与挑战

Agentic Memory 表面上看是一个简单的拆分策略,但实质上涉及多个关键技术点:

- 记忆向量的学习与更新:记忆向量 M 类似于长期状态,其维度和表达方式需兼顾信息容量和泛化能力。如果维度过小,模型可能记不住细节;维度过大则会增加计算负担。

- 分段策略的设计:如何将长对话有效拆分?每个片段应该包含多少信息才能既保持上下文完整又不超过模型单轮最大输入长度?

- 规则验证器:Verifiable RL 需要定义适当的 reward 函数,既要奖励正确记忆和合理推理,又要惩罚重复或矛盾的信息。验证器可能基于正则表达式、逻辑规则或另一个 LLM 来判定每个片段的输出。

这些因素共同影响了 Agentic Memory 的效果。根据 Macaron 的博客,这种多轮记忆机制能够让模型在生成几十页甚至上百页的文本时仍然保持前后逻辑的一致性[2]。这种能力对于长篇报告撰写、复杂项目管理和持续教学等场景具有重要意义。

4. 与其他记忆机制的比较

当前社区有许多探索 LLM 长期记忆的方法,例如:

- Retrieval-Augmented Generation (RAG):将历史对话存储在数据库中,在生成回答时通过检索机制找到相关文档,再与当前输入拼接后送入模型。RAG 方法依赖于外部检索系统,在记忆召回上较灵活,但检索的准确性决定了效果。

- Long Context Window:直接将模型的上下文窗口增加到数万 tokens,如 GPT‑4‑Turbo、Claude 等。这种方式简洁直接,但在长序列上计算复杂度高,并且长序列学习难度也更大。

- Hierarchical Memory:使用层次结构将短期记忆与长期记忆分开管理,如借助专用的记忆模块或另一个模型负责摘要。

Agentic Memory 介于 RAG 和长上下文之间:它既不完全依赖外部检索系统,也不简单扩大上下文,而是通过训练模型生成的记忆向量在 RL 环境中逐步更新。这样既保留了模型自身推理的连贯性,又通过奖励模型强化了记忆的正确性。未来可能的改进方向包括:将记忆向量与外部知识库结合、在记忆更新中引入注意力机制或元学习策略、以及通过人类反馈调整分段策略。

三、Human‑Agent Interaction:让模型更懂人

1. 背景与愿景

技术博客中提到,Macaron 依托自有的海量人机对话数据,设计了一个 Human‑Agent Interaction 任务,旨在提升模型的互动质量[3]。在传统的 RLHF 研究中,目标通常是让模型在逻辑和推理方面更接近人类,但实际应用中,人类用户与 AI 之间的沟通不仅仅是问答,更涉及情感交流、意图理解和上下文记忆。一个好的个人代理不仅要答对问题,还要在言语上表现出关怀、理解和自然的语言风格。

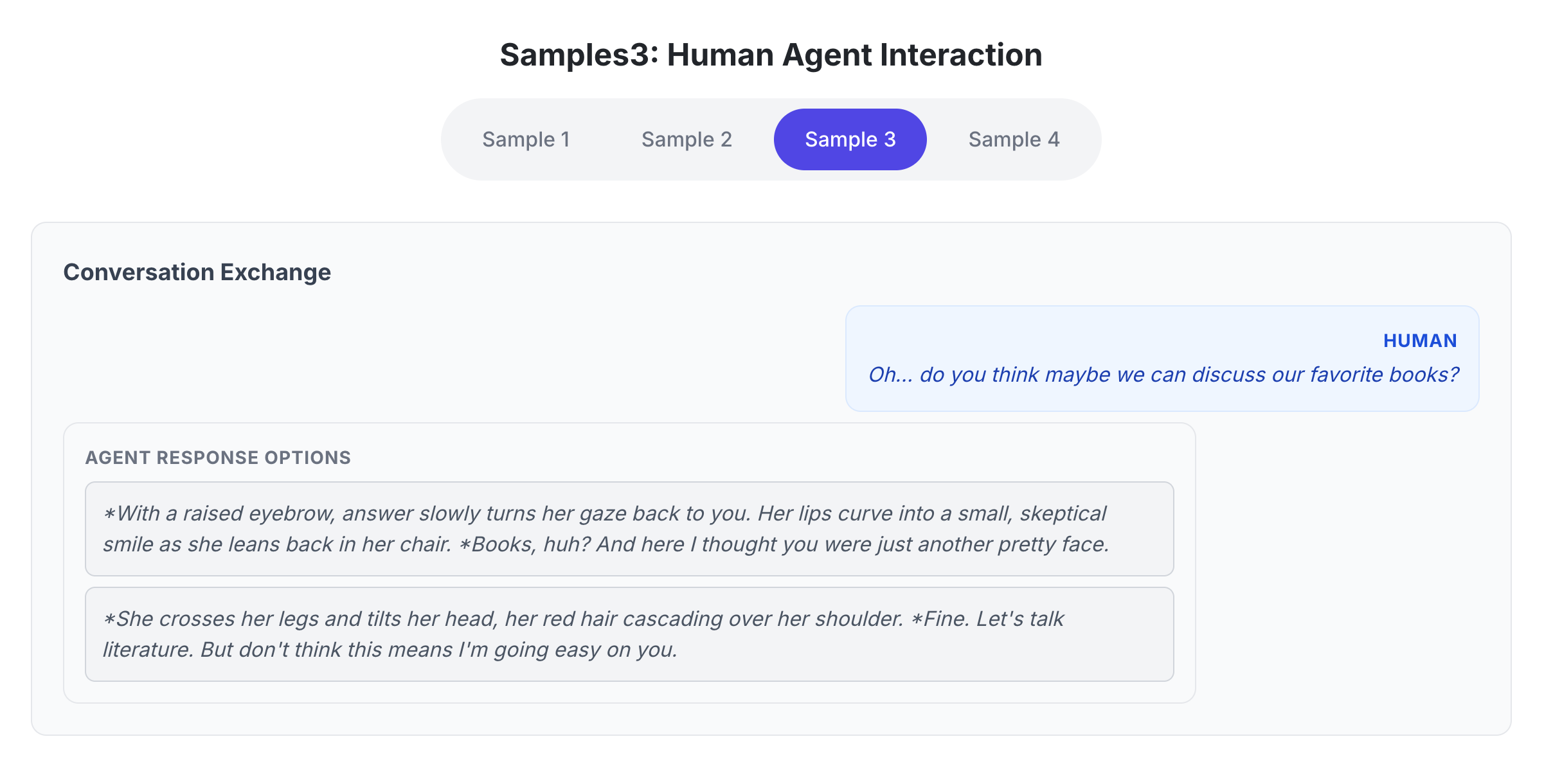

2. 数据集与任务设计

据博客所述,Macaron 团队选取了自家收集的大量人机互动数据,并从中筛选出表现最好的 5% 作为训练样本[3]。这些数据包含了丰富的情感表达和隐含意图。团队提出的 RL 任务并非解决某个单一答案的问题,而是通过奖励模型评估模型回应的情绪恰当性、沟通技巧以及是否有效引导了对话。例如,在对话中,用户可能表现出挫败感或疲惫,模型需要在回答问题之余给予鼓励和安慰;又如,模型应当适时使用工具(例如日程管理器、浏览器插件等)协助完成任务,而不是简单回复 "我不清楚" 或 "请咨询专业人士"。奖励模型据此对对话进行评价,引导模型学习更具人味儿的回应。

Human‑Agent Interaction 任务强调 EQ(Emotional Quotient) 而非纯逻辑。与典型的情绪识别训练不同,这里模型必须在多轮对话中综合考虑语气、历史信息以及隐含需求。在 RL 训练中,策略需要学习何时保持正式、何时放松语气,以及如何在不同场景下选择恰当的策略。例如,在商业沟通中可能需要更专业的语言,而在日常闲聊中则可以加入幽默或表情符号。

3. 技术挑战与分析

相比 Balanced Reasoning 和 Agentic Memory,Human‑Agent Interaction 更侧重于 人机交互体验 而非纯粹的任务完成率。这带来了几个独特的挑战:

- 奖励难以量化:如何评估情感回应的质量?团队通过规则和打分模型对高质量数据进行标注,再以此作为训练样本。但情感的尺度复杂且主观,不同人对同一回应的评价可能不同。

- 避免模式化:模型容易学会一套固定的礼貌话术,如 “您好,请问有什么可以帮您?”“感谢您的反馈”,但用户需要的是真正根据情况调整的回应,过于模式化会显得机械。

- 工具调用策略:在个人代理应用中,模型可能需要调用日历、邮件或浏览器等外部工具。如何在对话适当时刻触发工具?如何在 RL 奖励中鼓励正确使用而惩罚滥用?

Macaron 解决这些问题的办法之一是结合 可验证的指标(verifiable metrics)与人工评估:例如设定明确的评价准则,量化回应中的礼貌程度、情绪匹配度以及是否准确记住用户信息。这些指标为 RL 提供了可度量的奖励[3]。

4. 与其他研究的关系

人机交互的研究并不是 Macaron 独有的创新。例如,Anthropic 提出的 Constitutional AI 使用预先制定的指导原则作为奖励模型,鼓励模型输出符合人类价值的内容;Google 的 Empathetic Dialogues 数据集则用于训练模型理解情绪。然而 Macaron 的 Human‑Agent Interaction 将情感交流与工具使用结合在一起,将过程作为 RL 任务对待,并且强调通过可验证奖励引导模型学习真实的对话策略。这一综合性设计使其在个人代理场景具有较高实用价值。

四、局限与改进方向

尽管 Macaron 的应用探索展示了 RLHF 在真实场景中的巨大潜力,但他们在博客中也明确指出了自身的局限性:模型仍然可能继承数据偏见、在长文本输出中出现事实错误,对新任务的泛化能力不强,并且训练仍需大量计算资源[5]。此外,该方法目前针对特定模型架构设计,对其他模型迁移性有限,这限制了其在业界的普适性[5]。

以下是一些针对局限性的思考与建议:

- 多样化数据与安全机制:随着 RLHF 数据库的扩大,更容易引入偏见或有害内容。未来可采用数据过滤、对抗训练等方式,结合政策性审查和人类评估,降低偏差传播的风险。

- 动态奖励设计:目前 Balanced Reasoning、Agentic Memory 和 Human‑Agent Interaction 的奖励函数相对固定。引入自适应策略或元学习框架,针对不同任务自动调整奖励权重,可能会提升模型泛化能力。

- 模型结构优化:用稀疏化、混合专家或量化技术进一步降低显存和计算需求,使得大型模型训练更加可负担。再结合 LoRA 等方法,可以在普通 GPU 上部署更多能力。

- 跨架构适配:当前 RL 平台主要针对 DeepSeek 系列架构,未来可探索在其他主流大模型(如 Llama、Baichuan、Qwen 等)上的落地方案,增强其通用性。

- 可解释性与调试:在 Agentic Memory 和 Human‑Agent Interaction 等任务中,引入可解释性机制(如 attention 可视化、因果推断分析)有助于理解模型决策,为调整奖励函数提供依据。

五、结语

通过 Balanced Reasoning、Agentic Memory 和 Human‑Agent Interaction 三个场景,Macaron 团队展示了如何将高效的 RL 平台用于提升大模型的应用能力。这些任务不仅要求模型在逻辑推理上保持正确性,还强调输出效率、长期记忆与情感表达,从而更加贴近真实用户需求。虽然仍存在不少挑战,但这一系列工作为构建未来的个人代理奠定了坚实基础。

作为读者,我们不仅可以从中了解最新的 RLHF 技术如何应用于大模型,还可以思考更多场景的可能性,例如在教育、医疗咨询、企业管理等领域,利用类似的奖励设计和记忆机制改进模型表现。未来,随着更多开源实践和学术研究的加入,我们有望看到更安全、更智能、更懂人的个人代理逐步普及到每个人的生活中。

[1] [2] [3] [4] [5] MIND LABS | Scaling All-Sync RL with DAPO and LoRA

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)