AI硬件产品怎么做?——AI智能锁

AI智能锁

目录

简介

虽然小智AI的热点已经过去,但是影响还在扩散,越来越多的产品开始引入AI这套体系,比较成功的方式是<现有产品+AI>。

应用最多的就是一些玩具,引入了语音对话、AI智能体的概念。

虽然整体体验很难让人满意,但趋势还是很明显,至少开始脱离AI智障的魔咒,开始走向AI智能。

今天这篇内容就来谈谈,智能锁+AI的实现逻辑。

现有的智能锁多数还是轻AI的方式,比如AI指纹、AI掌纹......

本质上还是增加了AI的营销词汇,侧重宣传,并不能称之为真AI。

当然也有一些企业开始尝鲜,比如最近看到的萤石的AI智能锁,就增加了AI智能体和AI语音对话的功能。

注:来自萤石官方宣传图

算是一个不错的尝试。

那具体是怎么实现呢?

下面仅从框架层面给大家大体展示一下AI方案,仅供参考。

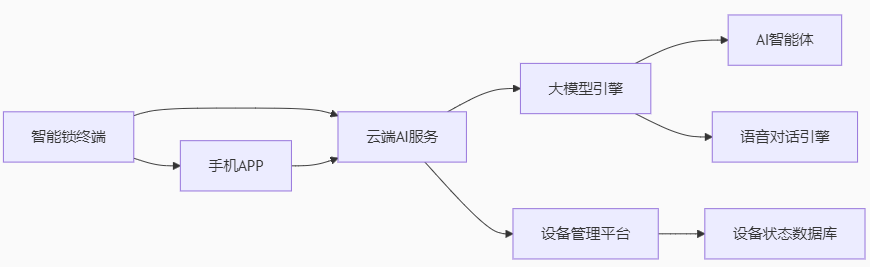

系统架构设计:端云协同AI交互

终端层(智能锁)

多模态传感器:

-

麦克风阵列(支持降噪与远场拾音)。

-

毫米波雷达(24GHz)检测人体靠近与逗留;

-

三摄系统(室外400万+200万像素,室内200万像素)实现全景看护;

AI芯片:搭载4 TOPS算力边缘芯片,支持本地语音唤醒、人脸检测、加密通信;

通信模块:WiFi 6 + 蓝牙5.2双模,保障低延时数据传输。

云端层

AI中台:

-

AI智能体系统:支持自定义角色(萤石/萤喵喵等),提供个性化交互与事件摘要(如“妈妈拿快递回家”)

-

大模型引擎(如DeepSeek):解析用户意图,生成控制指令或对话响应;

-

语音识别(ASR):实时转译语音为文本;

设备管理:动态注册设备能力描述(Descriptor),映射为LLM可调用函数。

应用层(APP)

语音助手:发起对话、查看AI事件标签、录像语义搜索(如“今早谁收了快递?”)

设备联动:触发智能场景(如开门自动亮灯)。

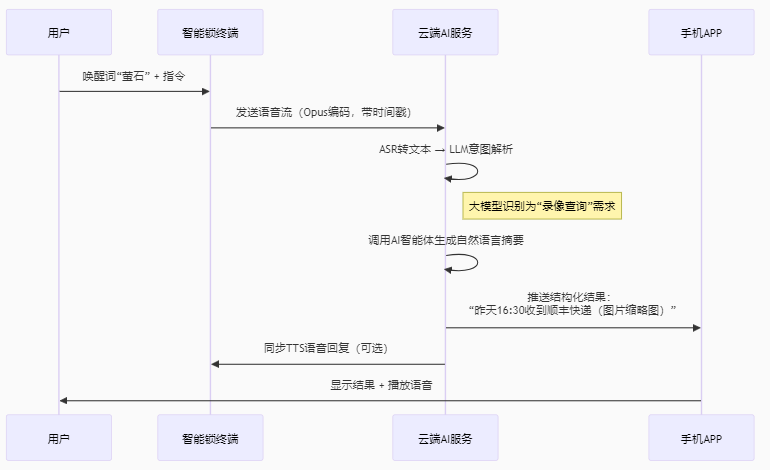

核心交互流程与时序图

场景:用户语音指令“萤石,查看昨天的快递记录”。

语音唤醒与传输:

终端采用双唤醒词引擎(本地芯片处理“萤石”唤醒,云端处理复杂指令)。

语音流经Opus编码(20ms/帧),通过WebSocket二进制协议传输。

意图解析与函数调用:

LLM根据设备上报的Descriptor动态生成函数:

json

{

"name": "search_video_record",

"description": "搜索门锁录像记录",

"parameters": {

"date": {"type": "string", "description": "日期,例如'昨天'、'2025-08-18'"},

"object": {"type": "string", "description": "检索对象,如'快递'、'陌生人'"}

}

}

大模型输出结构化指令:{"function": "search_video_record", "parameters": {"date": "昨天", "object": "快递"}}。

AI智能体交互:

智能体基于事件标签生成自然语言摘要(如结合包裹检测算法+时间戳生成“顺丰快递下午送达”)。

支持多角色响应(如切换“萤喵喵”童声播报儿童出门事件)。

安全与性能优化

隐私保护:

端到端加密:语音流与视频数据使用AES-256-GCM加密。

本地脱敏:人脸特征码在终端计算,仅摘要事件上云。

低功耗设计:

分级唤醒:毫米波雷达检测人体 → 启动摄像头 → 语音唤醒AI芯片。

双供电系统:5000mAh锂电池(主) + 干电池(备),续航4-6个月。

实时性保障:

端侧预处理:语音唤醒延迟 < 300ms。

-

若本文对你有所启发,就请转发传递

作者简介

卫朋,《硬件产品经理》作者,人人都是产品经理受邀专栏作家,CSDN认证博客专家、嵌入式领域优质创作者,阿里云开发者社区专家博主

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)