如何快速部署一个鉴黄服务?【图文详解】免费开源的Open NSFW模型解决方案?本地部署离线识别?

本文介绍了两种识别不良图片的解决方案:1)使用Python脚本,通过opennsfw2库自动下载预训练模型,对指定文件夹内的图片进行扫描并评分,超过阈值即判定为敏感图片;2)推荐使用极智C盘清理软件,该工具提供AI智能隐私清理功能,支持多平台聊天记录清理和敏感图片检测等。两种方法均可快速部署鉴黄服务,用户可根据实际需求选择适合的技术方案。

一、问题背景

在网络环境中,图片、视频等内容的传播十分广泛,其中可能夹杂着色情、低俗等不良信息。这些不良信息不仅会影响网络环境的健康,还可能对青少年的成长造成负面影响。

对于很多小伙伴来说,可能需要一种简单、快速且有效的方式来对平台上的内容进行鉴黄处理。

故在此简单介绍两种简单的扫描识别不良图片文件的解决方案。

二、解决方案

方法一:Python脚本实现

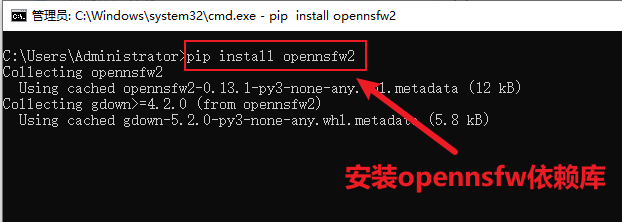

(1)安装 opennsfw2 依赖库:

pip install opennsfw2

(2)编写简单的扫描并识别某个文件夹内所有图片等Python测试代码:

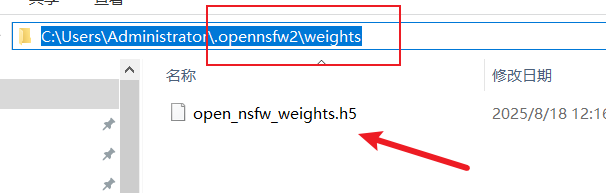

首次使用opennsfw2的相关识别接口时,会触发预训练模型文件下载。其会自动下载预训练模型 open_nsfw_weights.h5 文件到 C:\Users\Administrator\.opennsfw2\weights 的目录下:

import os

from PIL import Image

import opennsfw2 as n2

def scan_images(folder_path):

# 遍历文件夹里的所有文件

for filename in os.listdir(folder_path):

# 获取文件的完整路径

file_path = os.path.join(folder_path, filename)

# 判断是否是文件

if os.path.isfile(file_path):

# 判断文件是否是图片

if filename.lower().endswith(('.png', '.jpg', '.jpeg')):

try:

# 打开图片

with Image.open(file_path) as img:

# 将图片转换为模型需要的格式

img = img.convert('RGB')

# 进行鉴黄识别,获取分数(分数越高,越可能是敏感图片)

score = n2.predict_image(img)

# 打印结果

print(f"文件: {filename},敏感分数: {score:.2f}")

# 可以根据分数设置阈值,比如大于0.7就认为是敏感图片

if score > 0.7:

print(f"警告:{filename} 可能是敏感图片!")

except Exception as e:

print(f"处理 {filename} 时出错:{e}")

if __name__ == "__main__":

folder_to_scan = "D:/images_to_scan" # 替换成你的文件夹路径

scan_images(folder_to_scan)

方法二:安装软件实现

若寻求更为方便且快捷的智能方法,可以使用极智C盘清理自带的AI智能隐私清理功能,其智能引擎功能比较强大:

(1)支持微信、QQ、飞书、钉钉等聊天记录清理保护;

(2)成人敏感图片文件检出、文件夹加密、办公文件隐藏加密等多项智能功能,防止隐私泄露。

前往隐私清理专家的官网免费下载使用:![]() https://www.cpanx.com/product/cleaner.html

https://www.cpanx.com/product/cleaner.html

三、总结

使用python调用opennsfw模型或者第三方工具等,都可以自行快速部署一个鉴黄服务。小伙伴可根据不同需求进行操作。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)