第二阶段_技术栈过渡-Day 5: 大模型开发环境

本文介绍了大模型开发环境的组成与特点,对比了传统Java开发环境差异。重点讲解了Conda环境管理的安装、配置与常见问题解决,以及Jupyter Notebook的安装、基本使用和在大模型开发中的应用场景。内容包括环境隔离、依赖管理、远程访问配置等实用技巧,为开发者提供了构建高效大模型开发环境的全面指导。

Day 5: 大模型开发环境

学习目标

- 理解大模型开发环境的组成和重要性

- 掌握Conda环境管理和Jupyter Notebook的使用方法

- 学习GPU加速和分布式训练的基础知识

- 了解主流云平台的大模型开发服务

- 对比JAVA和Python的开发环境差异

1. 大模型开发环境概述

1.1 大模型开发环境的组成

大模型开发环境是一套用于开发、训练和部署大型语言模型的软硬件工具和平台的集合。

核心组件:

- 硬件基础设施:GPU/TPU服务器、高性能存储、网络设备

- 系统软件:操作系统、驱动程序、容器化工具

- 开发工具:编程语言、IDE、版本控制系统

- 机器学习框架:PyTorch、TensorFlow等

- 环境管理工具:Conda、Docker等

- 实验管理工具:Jupyter Notebook、MLflow等

- 分布式训练框架:Horovod、DeepSpeed、Megatron-LM等

- 云平台服务:AWS、Azure、Google Cloud等

1.2 大模型开发环境的特点

计算密集型:

- 需要强大的GPU/TPU集群

- 训练时间可能长达数周或数月

- 高内存需求(模型参数和中间状态)

数据密集型:

- 处理TB或PB级别的训练数据

- 高速存储和数据传输需求

- 数据预处理和缓存策略

协作开发:

- 多人团队协作

- 实验跟踪和版本控制

- 资源调度和分配

可扩展性:

- 从单GPU到数千GPU的扩展

- 模型并行和数据并行

- 分布式训练优化

1.3 与传统JAVA开发环境的对比

| 特性 | JAVA开发环境 | 大模型开发环境 |

|---|---|---|

| 硬件需求 | 中等(CPU、内存) | 高(GPU/TPU集群) |

| 开发工具 | IDE(IntelliJ、Eclipse) | Jupyter、VSCode、PyCharm |

| 依赖管理 | Maven、Gradle | Conda、pip、Poetry |

| 运行环境 | JVM | Python解释器、CUDA |

| 部署方式 | JAR包、WAR包、容器 | 模型文件、推理服务、API |

| 资源消耗 | 中等 | 极高 |

| 开发周期 | 相对短 | 相对长(实验迭代) |

| 调试难度 | 中等 | 高(模型行为不透明) |

2. Conda环境管理

2.1 Conda简介

Conda是一个开源的包管理和环境管理系统,用于安装多个版本的软件包及其依赖,并在它们之间轻松切换。

Conda的优势:

- 跨平台(Windows、macOS、Linux)

- 语言无关(支持Python、R、Ruby、Lua、Scala等)

- 环境隔离(避免依赖冲突)

- 二进制包分发(避免编译问题)

- 集成了pip功能

Anaconda vs Miniconda:

- Anaconda:完整发行版,包含常用科学计算和数据科学包

- Miniconda:最小安装,只包含conda、Python和少量必要包

2.2 Conda安装

# 下载Miniconda安装脚本

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

# 或者对于macOS

# wget https://repo.anaconda.com/miniconda/Miniconda3-latest-MacOSX-x86_64.sh

# 执行安装脚本

bash Miniconda3-latest-Linux-x86_64.sh

# 验证安装

conda --version

2.3 环境管理

# 创建新环境

conda create -n llm_env python=3.10

# 激活环境

conda activate llm_env

# 查看当前环境

conda info --envs

# 安装包

conda install numpy pandas matplotlib

# 安装PyTorch(带CUDA支持)

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia

# 查看已安装的包

conda list

# 导出环境

conda env export > environment.yml

# 从文件创建环境

conda env create -f environment.yml

# 删除环境

conda deactivate # 先退出环境

conda env remove -n llm_env

2.4 常见问题和解决方案

依赖冲突:

# 使用--no-deps选项避免依赖冲突

conda install --no-deps package_name

# 或者使用严格的依赖解析器

conda install --strict-channel-priority package_name

环境损坏:

# 重建环境

conda deactivate

conda env remove -n damaged_env

conda env create -f environment.yml

包安装失败:

# 尝试不同的通道

conda install -c conda-forge package_name

# 如果conda安装失败,尝试pip

pip install package_name

环境迁移:

# 在源机器上导出环境

conda env export --no-builds > environment.yml

# 在目标机器上创建环境

conda env create -f environment.yml

3. Jupyter Notebook

3.1 Jupyter简介

Jupyter Notebook是一个开源的交互式计算环境,允许用户创建和共享包含代码、可视化和文本的文档。

Jupyter的优势:

- 交互式执行代码

- 富文本编辑(Markdown、LaTeX)

- 内联数据可视化

- 代码和文档的结合

- 易于共享和协作

Jupyter生态系统:

- Jupyter Notebook:原始的基于Web的交互式环境

- JupyterLab:下一代用户界面,提供更完整的IDE体验

- Jupyter Hub:多用户服务器

- Voilà:将Notebook转换为独立应用

- nbconvert:转换Notebook为其他格式(HTML、PDF等)

3.2 安装和启动

# 在conda环境中安装Jupyter

conda activate llm_env

conda install jupyter jupyterlab

# 启动Jupyter Notebook

jupyter notebook

# 启动JupyterLab

jupyter lab

3.3 基本使用

创建和管理笔记本:

- 创建新笔记本:点击"New" > “Python 3”

- 重命名笔记本:点击标题并编辑

- 保存笔记本:Ctrl+S或点击保存图标

- 导出笔记本:File > Download as

单元格类型:

- Code:执行Python代码

- Markdown:格式化文本、公式、图表

- Raw:不处理的原始文本

快捷键:

- Shift+Enter:执行当前单元格并移动到下一个

- Ctrl+Enter:执行当前单元格但不移动

- Alt+Enter:执行当前单元格并在下方插入新单元格

- A:在当前单元格上方插入新单元格

- B:在当前单元格下方插入新单元格

- DD:删除当前单元格

- M:将单元格转换为Markdown

- Y:将单元格转换为代码

3.4 高级功能

魔术命令:

# 行魔术命令

%matplotlib inline # 内联显示matplotlib图表

%timeit func() # 测量函数执行时间

# 单元格魔术命令

%%time # 测量整个单元格执行时间

%%bash # 执行bash命令

%%html # 渲染HTML

扩展:

# 安装扩展管理器

pip install jupyter_contrib_nbextensions

jupyter contrib nbextension install --user

# 常用扩展

# - Table of Contents:自动生成目录

# - Collapsible Headings:可折叠标题

# - ExecuteTime:显示单元格执行时间

# - Variable Inspector:变量查看器

远程访问:

# 配置远程访问

jupyter notebook --generate-config

# 编辑配置文件

# ~/.jupyter/jupyter_notebook_config.py

# 设置密码

jupyter notebook password

# 启动服务器

jupyter notebook --no-browser --port=8888 --ip=0.0.0.0

3.5 在大模型开发中的应用

数据探索和预处理:

import pandas as pd

import matplotlib.pyplot as plt

# 加载数据

df = pd.read_csv('training_data.csv')

# 数据探索

df.head()

df.info()

df.describe()

# 数据可视化

plt.figure(figsize=(10, 6))

df['column'].hist()

plt.title('Distribution')

plt.show()

模型原型开发:

import torch

import torch.nn as nn

# 定义模型

class SimpleModel(nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.fc = nn.Linear(10, 1)

def forward(self, x):

return self.fc(x)

# 创建模型实例

model = SimpleModel()

print(model)

实验跟踪:

# 记录实验参数和结果

experiment_results = []

for learning_rate in [0.001, 0.01, 0.1]:

for batch_size in [32, 64, 128]:

# 训练模型

# ...

# 记录结果

experiment_results.append({

'learning_rate': learning_rate,

'batch_size': batch_size,

'accuracy': accuracy,

'loss': loss

})

# 分析结果

results_df = pd.DataFrame(experiment_results)

results_df.sort_values('accuracy', ascending=False)

可视化模型行为:

# 可视化注意力权重

import seaborn as sns

attention_weights = model.get_attention_weights(input_text)

plt.figure(figsize=(10, 8))

sns.heatmap(attention_weights, annot=True, cmap='viridis')

plt.title('Attention Weights')

plt.show()

4. GPU加速和分布式训练

4.1 GPU加速基础

GPU vs CPU:

- CPU:少量强大的核心,适合串行任务

- GPU:大量简单的核心,适合并行任务

CUDA简介:

- NVIDIA开发的并行计算平台和API

- 允许使用GPU进行通用计算(GPGPU)

- 为深度学习框架提供底层支持

PyTorch中的GPU使用:

import torch

# 检查GPU可用性

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

print(f"Using device: {device}")

# 创建GPU张量

tensor_gpu = torch.tensor([1, 2, 3], device=device)

# 或

tensor_gpu = torch.tensor([1, 2, 3]).to(device)

# 将模型移动到GPU

model = MyModel()

model.to(device)

# 训练时使用GPU

for inputs, targets in dataloader:

inputs = inputs.to(device)

targets = targets.to(device)

outputs = model(inputs)

# ...

4.2 多GPU训练

数据并行(Data Parallelism):

- 将数据分割到多个GPU上

- 每个GPU有完整的模型副本

- 梯度在反向传播后同步

# PyTorch DataParallel

model = MyModel()

if torch.cuda.device_count() > 1:

print(f"Using {torch.cuda.device_count()} GPUs")

model = nn.DataParallel(model)

model.to(device)

分布式数据并行(Distributed Data Parallelism):

- 更高效的多GPU训练方法

- 支持多节点训练

- 使用环形通信减少通信开销

# PyTorch DistributedDataParallel

import torch.distributed as dist

import torch.multiprocessing as mp

from torch.nn.parallel import DistributedDataParallel as DDP

def setup(rank, world_size):

os.environ['MASTER_ADDR'] = 'localhost'

os.environ['MASTER_PORT'] = '12355'

dist.init_process_group("nccl", rank=rank, world_size=world_size)

def train(rank, world_size):

setup(rank, world_size)

model = MyModel().to(rank)

ddp_model = DDP(model, device_ids=[rank])

# 训练代码...

# 启动多进程

world_size = torch.cuda.device_count()

mp.spawn(train, args=(world_size,), nprocs=world_size, join=True)

4.3 模型并行(Model Parallelism)

模型并行是将模型的不同部分放在不同的GPU上,适用于模型太大无法放入单个GPU内存的情况。

# 简单的模型并行示例

class ModelParallelModel(nn.Module):

def __init__(self):

super(ModelParallelModel, self).__init__()

self.part1 = nn.Sequential(

nn.Linear(10, 20),

nn.ReLU()

).to('cuda:0')

self.part2 = nn.Sequential(

nn.Linear(20, 30),

nn.ReLU()

).to('cuda:1')

self.part3 = nn.Linear(30, 1).to('cuda:1')

def forward(self, x):

x = x.to('cuda:0')

x = self.part1(x)

x = x.to('cuda:1')

x = self.part2(x)

x = self.part3(x)

return x

4.4 大模型训练框架

DeepSpeed:

- 微软开发的深度学习优化库

- 实现了ZeRO(Zero Redundancy Optimizer)

- 支持模型并行、流水线并行和数据并行

- 内存优化和混合精度训练

# DeepSpeed基本使用

import deepspeed

# 定义模型配置

ds_config = {

"train_batch_size": 32,

"fp16": {

"enabled": True

},

"zero_optimization": {

"stage": 2

}

}

# 初始化DeepSpeed模型

model_engine, optimizer, _, _ = deepspeed.initialize(

model=model,

model_parameters=model.parameters(),

config=ds_config

)

# 训练循环

for inputs, labels in dataloader:

outputs = model_engine(inputs)

loss = criterion(outputs, labels)

model_engine.backward(loss)

model_engine.step()

Megatron-LM:

- NVIDIA开发的大型Transformer模型训练框架

- 专注于模型并行和流水线并行

- 针对Transformer架构优化

Accelerate:

- Hugging Face开发的简化分布式训练的库

- 提供统一的API,支持多种训练配置

- 与Transformers库无缝集成

# Accelerate基本使用

from accelerate import Accelerator

accelerator = Accelerator()

model, optimizer, train_dataloader = accelerator.prepare(

model, optimizer, train_dataloader

)

for epoch in range(num_epochs):

for batch in train_dataloader:

outputs = model(batch["input_ids"])

loss = outputs.loss

accelerator.backward(loss)

optimizer.step()

optimizer.zero_grad()

5. 云平台与大模型开发

5.1 主流云平台对比

| 特性 | AWS | Azure | Google Cloud | 阿里云 |

|---|---|---|---|---|

| GPU实例 | EC2 P3/P4/G4 | NC/ND系列 | A2/T4/V100 | GPU云服务器 |

| 托管ML服务 | SageMaker | Azure ML | Vertex AI | PAI |

| 大模型服务 | Bedrock | Azure OpenAI | Vertex AI | 通义千问 |

| 存储服务 | S3 | Blob Storage | Cloud Storage | OSS |

| 容器服务 | ECS/EKS | AKS | GKE | ACK |

| 特色功能 | 生态完整 | OpenAI集成 | TPU支持 | 本地化服务 |

5.2 AWS SageMaker

主要特点:

- 端到端机器学习平台

- 内置算法和预训练模型

- 分布式训练支持

- 模型部署和监控

- Jupyter笔记本集成

基本使用流程:

- 准备数据并上传到S3

- 创建SageMaker笔记本实例

- 开发和训练模型

- 部署模型为端点

- 监控和管理模型

# SageMaker示例代码

import sagemaker

from sagemaker.pytorch import PyTorch

# 初始化SageMaker会话

sagemaker_session = sagemaker.Session()

role = sagemaker.get_execution_role()

# 定义PyTorch估算器

estimator = PyTorch(

entry_point='train.py',

role=role,

framework_version='1.12.0',

py_version='py38',

instance_count=1,

instance_type='ml.p3.2xlarge',

hyperparameters={

'epochs': 10,

'batch-size': 64,

'learning-rate': 0.001

}

)

# 开始训练

estimator.fit({'training': 's3://bucket/training-data'})

# 部署模型

predictor = estimator.deploy(

initial_instance_count=1,

instance_type='ml.m5.xlarge'

)

5.3 Google Cloud Vertex AI

主要特点:

- 统一的ML平台

- AutoML和自定义训练

- TPU支持

- 端到端MLOps

- 预训练API(视觉、语言等)

基本使用流程:

- 创建数据集并上传到Cloud Storage

- 配置训练作业

- 训练模型

- 部署模型

- 监控和管理

# Vertex AI示例代码

from google.cloud import aiplatform

# 初始化Vertex AI

aiplatform.init(project='your-project-id')

# 创建自定义训练作业

job = aiplatform.CustomTrainingJob(

display_name='pytorch-training',

script_path='train.py',

container_uri='gcr.io/cloud-aiplatform/training/pytorch-gpu.1-12:latest',

requirements=['torch==1.12.0'],

model_serving_container_image_uri='gcr.io/cloud-aiplatform/prediction/pytorch-gpu.1-12:latest'

)

# 开始训练

model = job.run(

dataset=dataset,

model_display_name='my-model',

machine_type='n1-standard-8',

accelerator_type='NVIDIA_TESLA_V100',

accelerator_count=1

)

# 部署模型

endpoint = model.deploy(

machine_type='n1-standard-4',

accelerator_type='NVIDIA_TESLA_T4',

accelerator_count=1

)

5.4 自建GPU集群

对于需要更多控制或成本敏感的场景,自建GPU集群是一个选择。

硬件考量:

- GPU型号(NVIDIA A100、V100、RTX等)

- CPU和内存配置

- 网络互连(NVLink、InfiniBand)

- 存储系统(高速SSD、分布式文件系统)

软件栈:

- 操作系统(Ubuntu Server)

- CUDA和cuDNN

- 容器化(Docker、Singularity)

- 资源管理(Slurm、Kubernetes)

- 分布式训练框架

基本搭建步骤:

- 硬件安装和网络配置

- 操作系统安装和基础配置

- NVIDIA驱动和CUDA安装

- Docker和NVIDIA Container Toolkit安装

- Kubernetes或Slurm集群配置

- 存储系统配置

- 监控系统部署

6. 从JAVA开发者视角理解大模型开发环境

6.1 开发环境对比

JAVA开发环境:

- IDE:IntelliJ IDEA、Eclipse、NetBeans

- 构建工具:Maven、Gradle、Ant

- 依赖管理:Maven Central、JCenter

- 容器化:Docker、Kubernetes

- CI/CD:Jenkins、GitHub Actions

- 测试框架:JUnit、TestNG、Mockito

Python大模型开发环境:

- IDE:Jupyter、VSCode、PyCharm

- 环境管理:Conda、virtualenv

- 依赖管理:pip、Poetry、Conda

- 实验跟踪:MLflow、Weights & Biases

- 分布式训练:DeepSpeed、Megatron-LM

- 模型版本控制:Hugging Face Hub、DVC

6.2 工作流对比

JAVA应用开发工作流:

- 需求分析和设计

- 编码实现

- 单元测试和集成测试

- 构建和打包

- 部署和监控

- 维护和更新

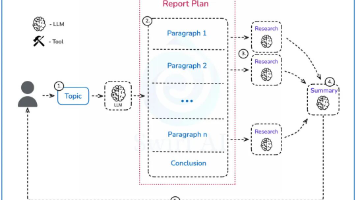

大模型开发工作流:

- 数据收集和预处理

- 模型设计和实现

- 实验和超参数调优

- 模型训练和评估

- 模型部署和服务化

- 监控和持续改进

6.3 技能迁移

可迁移的技能:

- 软件工程原则(模块化、可测试性、可维护性)

- 版本控制和协作

- 系统设计和架构

- 性能优化和调试

- 部署和运维

需要学习的新技能:

- Python生态系统

- 机器学习基础

- GPU编程和优化

- 分布式训练

- 实验管理和跟踪

- 模型评估和解释

6.4 实践建议

循序渐进:

- 先掌握Python基础和科学计算库

- 学习单机环境下的模型训练

- 熟悉Jupyter和实验跟踪

- 尝试小规模GPU训练

- 逐步扩展到分布式训练

- 探索云平台服务

环境配置建议:

- 从Miniconda开始,按需安装包

- 使用虚拟环境隔离不同项目

- 记录环境配置(environment.yml)

- 使用Docker容器确保环境一致性

- 熟悉基本的Linux和CUDA命令

资源管理:

- 了解GPU内存管理

- 学习批处理和梯度累积

- 掌握混合精度训练

- 合理设置批量大小和学习率

- 实现检查点保存和恢复

7. 实践练习

练习1:Conda环境管理

- 安装Miniconda

- 创建一个名为"llm_dev"的环境,Python版本为3.10

- 在环境中安装PyTorch(带CUDA支持)、Jupyter和Matplotlib

- 导出环境配置文件

- 删除环境并从配置文件重新创建

练习2:Jupyter Notebook

- 启动Jupyter Notebook服务器

- 创建一个新的笔记本

- 编写一个包含Markdown说明和代码的笔记本,展示PyTorch张量操作

- 使用魔术命令测量代码执行时间

- 导出笔记本为HTML和Python脚本

练习3:GPU加速

- 编写代码检测可用的GPU

- 创建一个简单的神经网络模型

- 实现CPU和GPU版本的训练循环

- 比较两者的训练速度

- 使用CUDA事件精确测量GPU操作时间

8. 总结与反思

- 大模型开发环境是一套复杂的软硬件工具和平台的集合,包括硬件基础设施、系统软件、开发工具、机器学习框架等

- Conda是一个强大的环境管理工具,可以创建隔离的环境并管理依赖,对于大模型开发至关重要

- Jupyter Notebook提供了交互式的开发环境,特别适合数据探索、可视化和实验原型开发

- GPU加速是大模型训练的关键,包括单GPU加速、多GPU数据并行和模型并行等技术

- 云平台提供了强大的大模型开发和训练服务,包括托管的GPU实例、机器学习平台和预训练模型服务

- 相比JAVA开发环境,大模型开发环境更加注重实验管理、资源优化和分布式训练

- JAVA开发者可以利用已有的软件工程技能,同时学习Python生态系统和机器学习特定工具

9. 预习与延伸阅读

预习内容

- Hugging Face Transformers库的基本概念和使用方法

- 预训练模型的加载和使用

- 模型微调的基本流程

- 大模型推理优化技术

延伸阅读

- Eli Stevens等,《Deep Learning with PyTorch》(第10章:部署和生产)

- Aurélien Géron,《Hands-On Machine Learning with Scikit-Learn, Keras, and TensorFlow》(第19章:大规模训练和部署)

- Chip Huyen,《Designing Machine Learning Systems》

- AWS SageMaker文档:https://docs.aws.amazon.com/sagemaker/

- NVIDIA Deep Learning文档:https://docs.nvidia.com/deeplearning/

10. 明日预告

明天我们将开始第三阶段的学习,重点关注大模型应用开发。我们将首先学习Hugging Face Transformers库,这是一个用于处理预训练模型的强大库,提供了加载、微调和部署大型语言模型的工具和接口。我们将探讨如何使用预训练模型进行推理,以及如何针对特定任务进行微调。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)