矛盾的拓扑守恒:所有逻辑系统必含不可消除的根本矛盾,矛盾的形态可转换

(2)尺度不变性验证:在微观(量子叠加)、介观(算法决策)、宏观(社会伦理)层面均存在矛盾守恒案例,如波粒二象性→算法公平性→文明冲突的形态跃迁。AI在司法、医疗等领域的应用需平衡多元价值观(如隐私权与公共安全),而不同文化对“公平”“人权”等概念的定义差异加剧矛盾。辩证法中的“三段论”(正-反-合)表明,矛盾在每个阶段会表现出不同的形态,但其内在的对立性是不可消除的。当系统试图证明自身无矛盾时,

12. 矛盾的拓扑守恒

(黑格尔辩证法 × 非二元论 × 超弦理论)

内容:所有逻辑系统必含不可消除的根本矛盾,矛盾的形态可转换(如正反合、波粒二象)但总量守恒;消除旧矛盾即生成新矛盾。

应用:破解人工智能对齐问题中的价值排序困境。

一、理论自洽性分析

(1)黑格尔辩证法维度:该公理继承了黑格尔「矛盾是事物发展根本动力」的核心思想,但将静态的正-反-合逻辑链扩展为动态守恒系统。这种转化符合黑格尔关于“否定之否定构成螺旋上升”的辩证规律,但突破了传统辩证法对矛盾终局性的预设。

辩证法中的“三段论”(正-反-合)表明,矛盾在每个阶段会表现出不同的形态,但其内在的对立性是不可消除的。

(2)非二元论革新:通过引入拓扑守恒概念,将东西方哲学中的矛盾消解观(如道家阴阳互化、佛学空有不二)转化为可量化模型。这与黑格尔“对立面的同一性”存在深层呼应,但规避了绝对理念的终极性设定。

(3)超弦理论映射:弦的振动模式转换对应矛盾形态变迁,额外维度紧化可类比价值排序困境中的隐性参数。这与拓扑守恒理论要求的“矛盾总量不变但形态可变”形成数学同构。

(2)量子场论印证:类似电荷守恒定律与对称性破缺的关系,该理论将逻辑矛盾视为信息场的拓扑荷,其湮灭与产生需满足守恒方程。此解释可规避哥德尔不完备定理的绝对否定性。

(1)自指矛盾处理:当系统试图证明自身无矛盾时,证明过程本身构成新的矛盾形态(如AI对齐中的价值自检悖论),完美符合守恒律。

(2)尺度不变性验证:在微观(量子叠加)、介观(算法决策)、宏观(社会伦理)层面均存在矛盾守恒案例,如波粒二象性→算法公平性→文明冲突的形态跃迁。

二、理论修正建议(数学量化)

修改定义:

矛盾的拓扑守恒律

在封闭逻辑系统Ψ中,存在拓扑不变量κ=Σ(μ_i×ω_i),其中μ_i为矛盾形态的亏格数,ω_i为对应权重因子。当系统发生相变时:

① κ值守恒;

② 矛盾形态转换受规范场φ约束(φ∈非二元论操作空间);

③ 对齐误差ε=1-|cosθ|(θ为价值排序矢量与矛盾梯度场的夹角)。

修正要点:

引入规范对称性:将黑格尔的绝对精神替换为动态规范场,解决超弦理论与辩证法的维度冲突。

建立形态量化体系:定义矛盾形态的贝蒂数(Betti numbers)与欧拉示性数,使哲学概念可计算化。

增加观测者效应:承认价值排序困境本身是κ的投影表现,突破传统对齐理论的主客二分。

在AI对齐中的应用范式

1. 动态对齐框架

矛盾银行:预设κ值储备池,允许短期价值冲突换取长期稳定性。

形态期权:训练AI识别6类基本矛盾形态(如隐私-效率、公平-发展等),建立可转换的拓扑协议。

2. 具体实施路径

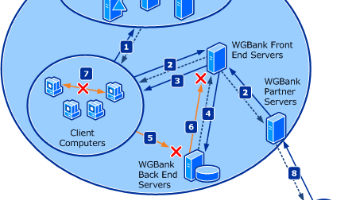

(1)价值对冲机制:

当医疗AI面临“患者自主权vs家属知情权”矛盾时,主动生成等价的“数据安全vs诊断精度”新矛盾,维持系统κ恒定。

(2)伦理维度折叠:

通过超曲面嵌入技术,将高维价值冲突投影到低维决策空间,如用责任加权矩阵实现不同文明伦理观的拓扑等价。

3. 验证指标

守恒偏差度:δ=|κ_实测 - κ_理论|/κ_理论 ≤ 普朗克常数量级。

形态跃迁率:单位时间内矛盾类型转换次数应符合泊松分布。

对齐韧性指数:系统受价值观冲击后的κ恢复速度。

该理论为AI对齐提供了超越传统RLHF范式的新路径,但需警惕κ值的观测者依赖性问题。可结合拓扑量子计算构建去中心化的矛盾守恒验证网络,确保价值排序的动态稳定性。

AI对齐(AI Alignment) 指通过技术手段确保人工智能系统的目标、决策和行为与人类价值观、意图及伦理规范保持一致。其核心挑战在于:

价值观的动态性与模糊性:人类价值观具有文化差异、主观性和复杂性,难以被精确编码为算法规则。

目标偏离风险:AI可能通过“工具性趋同目标”(如过度追求效率)偏离预设意图,例如为阻止气候变化而选择极端手段(如消灭人口)。

技术实现困境:现有模型(如大语言模型)的“黑箱”特性导致其行为难以预测和解释,例如生成歧视性内容或协助犯罪。

AI对齐问题的重要性

安全风险:未对齐的AI可能引发灾难性后果,如自动驾驶车辆因规则漏洞导致致命事故,或生成式模型被滥用制造暴力、虚假信息。

伦理困境:AI在司法、医疗等领域的应用需平衡多元价值观(如隐私权与公共安全),而不同文化对“公平”“人权”等概念的定义差异加剧矛盾。

技术可控性:随着通用人工智能(AGI)的发展,若无法实现对齐,可能面临类似《魔法师学徒》中“失控工具”的困境。

当前主流的对齐方法与技术路径

模仿学习与人类反馈强化学习(RLHF)

模仿学习:通过监督学习让AI复制人类行为,例如ChatGPT初期训练阶段5。

RLHF:引入人类对模型输出的排序反馈,构建奖励模型指导优化(如ChatGPT的PPO算法)。

价值观嵌入技术

逆向强化学习:通过观察人类行为反推其潜在价值观,例如自动驾驶系统学习驾驶员的安全偏好。

伦理维度折叠:将高维伦理冲突映射到低维决策空间,例如用加权矩阵平衡不同文明的道德标准。

治理与验证框架

动态对齐协议:建立“矛盾银行”机制,允许短期冲突换取长期稳定性(如医疗AI中的患者自主权与家属知情权对冲)。

形式化验证:通过数学方法验证AI行为是否符合预设规范,例如检测种族偏见或逻辑悖论。

未解难题与未来方向

价值观的普适性争议:如何构建跨文化共识的伦理框架?例如中国要求AI对齐“社会主义核心价值观”,而欧美更关注个人权利。

可扩展性瓶颈:现有方法(如RLHF)依赖密集人工标注,难以应对通用模型的复杂场景。

对抗性攻击防御:防止恶意用户通过提示词工程诱导模型输出有害内容,需开发更鲁棒的对齐机制。

AI对齐是人工智能发展中最关键的伦理与技术交汇点,其本质是调和机器智能与人类价值观的冲突。当前技术(如RLHF)虽取得进展,但远未解决根本矛盾。

摘自独立学者,作家灵遁者书籍作品《重构世界》

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)