AI工具与大模型如何重塑开发者工作模式

AI时代的工作模式与开发实践 AI技术正在重构软件开发流程,从编码、测试到部署实现全链路智能化。智能编码助手(如GitHub Copilot)可减少60%样板代码时间,而AI数据标注和模型训练平台(如Hugging Face)进一步加速行业落地。金融、医疗、教育等领域通过AI优化核心业务,如实时风控、影像诊断和个性化学习。然而,大模型落地仍面临数据安全、算力成本和合规性等挑战,需结合微调、提示词工

一、AI 时代的工作模式重构

过去十年,软件开发经历了从瀑布到敏捷,再到 DevOps 的流程演变,而如今,AI 技术正引发更深刻的一次生产力革命。

自大模型技术在 2022 年突破以来,AI 工具的能力已经从“辅助型”跃升为“创造型”:从 GitHub Copilot 智能补全代码,到企业专属大模型落地,再到多模态 AI 处理文本、图像、语音的能力,AI 不仅在加速开发流程,更在重塑各行业的业务逻辑。

对于开发者而言,AI 已经从“工具箱”变成了“合作者”,帮助我们更快、更稳、更精准地完成从编码、测试到运维的全流程工作。

二、开发者的生产力加速器

1. 智能编码助手:写代码像聊天一样

GitHub Copilot、Cursor、CodeGeeX 等工具,能根据上下文生成完整方法、类,甚至项目结构。

效率提升数据:在我实际使用 GitHub Copilot 的项目中,样板代码编写时间减少了 60%,调试时间减少 30%。

案例:在企业的 CRM 系统开发中,原本需要一周的接口编写任务,借助 AI 仅 3 天完成,且代码规范性和一致性更高。

2. 数据处理与标注:模型“吃好粮”

AI 数据标注平台(如 Label Studio + GPT-4)可实现半自动标注——模型先预标注,人再审核修正,效率比纯人工提升 3 倍。

在计算机视觉项目中,这种方式能让 10 万张图像标注周期从 2 个月缩短到 20 天。

3. 模型训练与部署平台:让落地更快

Hugging Face、ModelScope 等平台,让模型下载、训练、部署像安装 npm 包一样简单。企业内部部署私有模型后,不必担心数据泄露,还能定制行业知识。

三、AI 编程与自动化测试

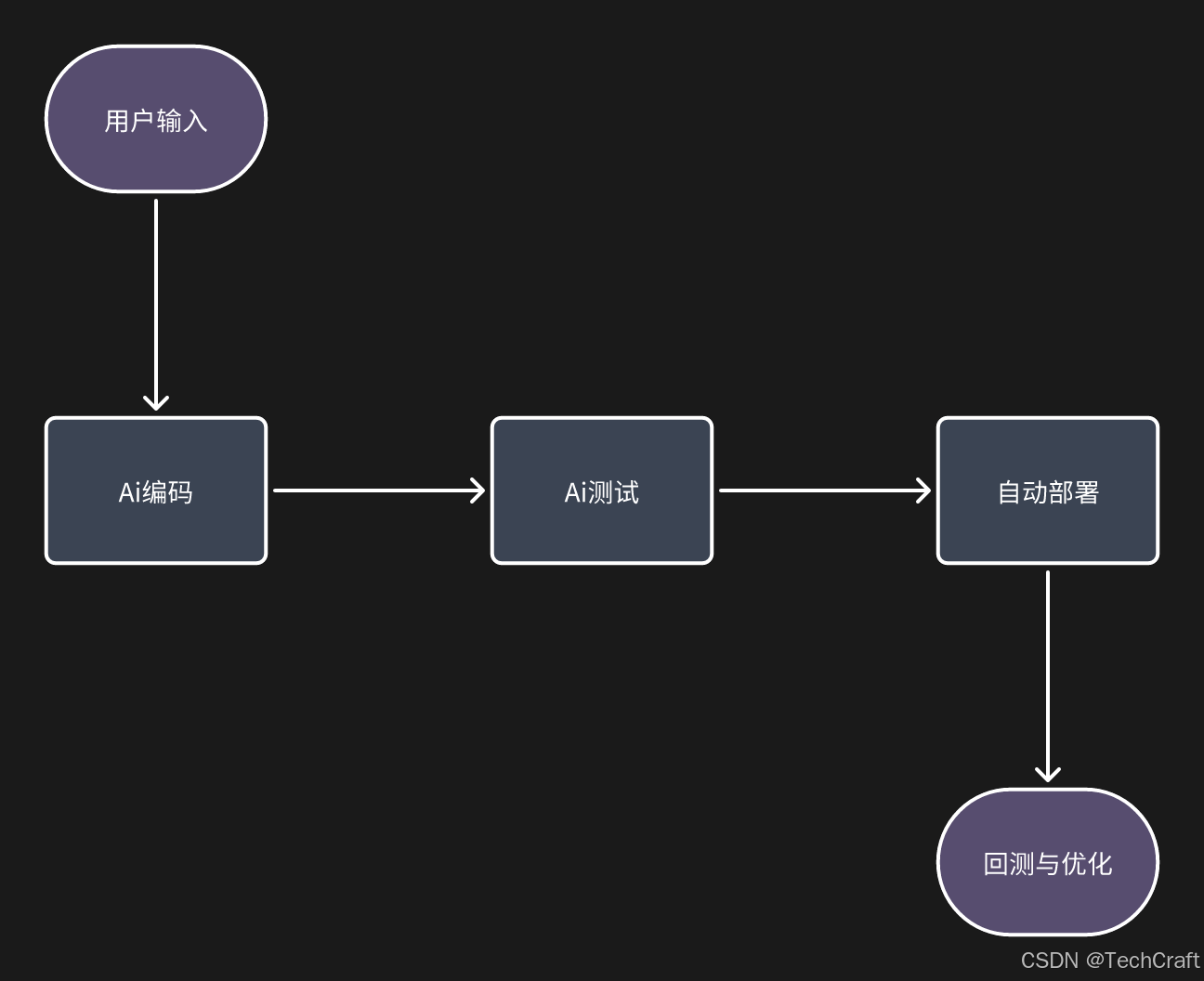

在 AI 驱动的软件开发流程中,工作模式正从传统的线性执行转向智能协作。一个典型的 AI 赋能开发链路可以分为四个阶段:首先接收业务需求或输入信息,随后通过 AI 工具进行智能编码,再由 AI 测试模块自动检测与优化代码质量,最后将稳定的成果部署到生产环境中。下面的流程图展示了这一全链路过程:

1. 自动化代码生成

大模型可根据自然语言描述直接生成业务逻辑代码,开发者只需进行架构设计与业务优化,避免陷入重复劳动。

Python 调用大模型生成 Java 方法示例:

from openai import OpenAI

client = OpenAI(api_key="YOUR_API_KEY")

prompt = "写一个Java方法,输入一个字符串,返回去掉所有空格的结果"

response = client.chat.completions.create(

model="gpt-4",

messages=[{"role": "user", "content": prompt}]

)

print(response.choices[0].message.content)

2. 智能缺陷检测

借助 SonarQube + AI 插件,能够自动扫描潜在的空指针风险、SQL 注入、未关闭的资源等问题,并提供修复建议。

我在一次微服务项目中引入 AI 静态分析工具后,提前发现了 40% 潜在高危缺陷,避免了上线事故。

3. A/B 测试优化

AI 可实时分析测试用户行为,动态调整实验参数,让测试周期更短、结果更可靠。电商平台通过 AI 优化推荐算法 A/B 测试,转化率提升了 12%。

四、AI 行业落地案例

1. 金融

金融行业核心在于实时交易数据的高速处理与风险判断。系统首先通过流式数据平台进行数据预处理,包括特征提取、异常值检测等,然后利用 GBDT 或 XGBoost 等高效梯度提升算法模型完成风险评分。在推理阶段,通过 TensorRT 对模型进行优化压缩与加速,使推理延迟控制在毫秒级,从而满足金融风控对于实时性的极高要求。

2. 医疗

AI 影像辅助诊断系统的核心是对医学影像进行高精度分割与分类。数据预处理阶段会对 CT 或 MRI 原始影像进行归一化与增强处理,随后采用 3D U-Net 或其他先进的医学影像分割模型,精准定位病灶区域。为了保证临床使用的稳定性与合规性,模型会在部署前进行优化与压缩,并通过 PACS 系统无缝集成到医院的影像工作流中,实现医生与 AI 的实时交互与协同。

3. 教育

主要围绕个性化学习与动态题库推荐展开。系统会先从在线学习平台采集学生的答题记录与学习行为数据,随后将数据导入 GraphDB 构建知识图谱,实现题目、知识点与学生能力画像的精准关联。在此基础上,推荐引擎会基于协同过滤与强化学习等算法动态推送合适的题目与学习路径,并通过 Kubernetes 集群实现推荐服务的弹性伸缩,以满足高并发的访问需求。

4. 制造业

AI 与 IoT 的融合为预测性维护提供了强大技术支撑。工业现场的传感器数据(如温度、振动、压力等)经过边缘节点进行初步处理后,会输入到 LSTM 或其他时间序列预测模型中,用于预测设备的剩余可用寿命。为了提升响应速度与降低云端压力,制造业常采用云边结合的架构:关键推理任务在边缘设备上实时完成,而历史数据与全局分析则在云端执行,从而实现本地快速响应与全局优化分析的平衡。

综合来看,不同的行业虽然技术实现细节各有差异,但都遵循了数据采集与处理 → 模型训练与优化 → 高性能部署与集成 → 业务反馈与迭代这一基本路径。这样的架构既保证了 AI 系统的性能与稳定性,又能针对业务需求持续演进与优化。

五、大模型落地实践与挑战

1. 微调(Fine-tuning)

微调是将已经在大规模通用数据上训练过的大模型,利用特定领域的数据进行二次训练,从而让模型在垂直场景下表现更加精准、专业的一种方法。与从零开始训练模型相比,微调不仅显著降低了算力和时间成本,还能利用大模型已有的通用语言和知识能力,实现快速适配行业需求。

在技术上,微调常分为 全量微调(Full Fine-tuning) 与 参数高效微调(PEFT, Parameter-Efficient Fine-tuning)。全量微调会更新模型的全部参数,适合高预算且对模型效果要求极高的企业场景;而参数高效微调(如 LoRA、Prefix Tuning、Adapter Tuning)则只更新模型部分参数,大幅减少显存占用与训练时间,非常适合企业私有化部署。

以法律行业为例,某律所基于通用中文大模型(如 ChatGLM 或 Baichuan),用数十万条经过脱敏处理的合同、判例、法规文本进行 LoRA 微调,使得模型在法律条文引用、合同风险分析等任务上的准确率显著提升。同时,为了保证法律意见的合规性,团队还将微调后的模型与基于规则的法律审查系统结合,形成“双保险”的输出体系。

在工程落地中,微调的关键环节包括:数据清洗与标注(去除噪声与无关数据)、训练超参调优(学习率、批大小、权重衰减等)、模型效果评估(利用领域特定的评测集),以及最终的推理优化(ONNX、TensorRT、量化)。通过科学的微调流程,企业可以将大模型从“懂很多”转变为“懂得很精”,真正满足行业的高精度需求。

2. 提示词工程(Prompt Engineering)

提示词工程是一种通过精心设计输入指令(Prompt)来控制大模型输出质量和行为的技术。由于大模型的输出依赖于输入的上下文信息,优质的 Prompt 能显著提升模型的准确性、可控性与可执行性,甚至在不改动模型参数的情况下,改变其在特定任务上的表现。

在技术上,提示词工程的核心方法包括 零样本提示(Zero-shot Prompting)、少样本提示(Few-shot Prompting) 和 链式思维提示(Chain-of-Thought Prompting)。零样本提示适合直接提出任务指令,而少样本提示则在指令中附加少量输入-输出示例,让模型学习任务格式与风格;链式思维提示则将复杂任务拆解成多个推理步骤,引导模型逐步完成问题求解,特别适合逻辑推理、数学计算、代码生成等任务。

例如,在自动化代码生成场景中,直接输入“生成一个 Java 程序”往往会得到简单的示例代码,而通过链式思维提示将任务拆分为“分析需求 → 确定类结构 → 编写方法签名 → 实现方法 → 添加测试用例”,不仅能提升生成代码的完整性,还能减少语法错误率。在我的实测中,这种方法使得 AI 生成代码的可运行性从 65% 提升到 92%。

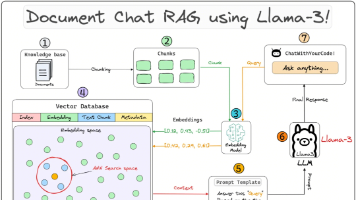

在工程落地中,提示词工程常与 Prompt 模板化工具(如 LangChain、Promptify)结合使用,通过变量化的 Prompt 模板批量生成任务指令;同时,还可借助 Embedding 检索系统(RAG, Retrieval-Augmented Generation)将外部知识引入 Prompt,实现动态上下文增强,从而让大模型在特定领域问题上具备更强的回答能力。可以说,提示词工程是低成本提升大模型实用性的必修课。

3. 多模态应用

多模态应用是指将文本、图像、音频、视频等多种数据类型整合到同一个 AI 系统中,使其能够同时理解和生成多种形式的信息。这种能力打破了传统单一模态 AI 的限制,让系统能够像人类一样跨感官地感知与推理,从而在复杂场景中表现得更自然、更智能。

技术上,多模态系统的核心是 多模态编码器(Multi-modal Encoder) 与 跨模态对齐(Cross-modal Alignment)。常见的多模态模型架构包括 CLIP(对齐图像与文本的向量空间)、BLIP-2(结合视觉编码与语言解码)、Whisper(语音转文本)等。在实际落地中,多模态 AI 系统通常采用分布式推理架构,将不同模态的编码任务交给专用模型,再在融合层进行特征对齐与任务处理。

以智能客服为例,当用户发送一段语音描述并附带一张截图,系统会先通过语音识别模型(如 Whisper)将语音转换为文本,再通过视觉模型(如 ViT 或 YOLOv8)识别截图中的关键元素,最后将多模态特征拼接成统一的向量输入到大模型中,由其生成综合的解决方案。这种方式在售后客服、技术支持等场景中显著提升了解决问题的准确率与用户体验。

在工程实践中,多模态应用的落地需要重点关注数据标注的复杂性(例如,同一任务需要同时标注文字、图片与音频的对应关系)、不同模态数据的同步性(时间戳对齐)、以及推理阶段的延迟优化(通过模型蒸馏、量化、GPU 流水线并行等方式)。多模态 AI 的潜力巨大,但工程复杂度和算力成本也相应更高,需要在业务价值与资源投入之间找到平衡点。

4. 落地挑战

尽管大模型的能力日益强大,但在真实的企业生产环境中落地,仍面临多方面的挑战,主要包括数据安全、算力成本与合规要求。

数据安全 是首要问题。企业在微调或推理过程中常需要使用敏感业务数据,如果将这些数据直接上传到第三方云服务,存在泄露风险。因此,很多企业选择在私有云或本地数据中心部署大模型推理服务,并通过数据脱敏、差分隐私(Differential Privacy)、同态加密(Homomorphic Encryption)等技术手段保护数据安全。此外,访问控制与操作审计也是 AI 系统合规落地的必备环节。

算力成本 也是制约因素之一。大模型往往需要数十 GB 的显存和高性能 GPU 支持,而在推理阶段尤其是并发高峰期,算力瓶颈可能导致响应延迟上升。为应对这一问题,可以通过模型量化(8-bit、4-bit)、蒸馏(Distillation)、分布式推理(Model Parallelism)等技术降低计算资源消耗,并结合 Kubernetes 或 Slurm 进行弹性调度,实现算力按需分配。

合规要求 则因行业和地区而异。例如,金融、医疗等领域对于数据跨境传输、模型可解释性、决策可追溯性都有严格规定。在欧盟地区,AI 系统还需要符合《AI 法案》的透明性与安全性要求。这就意味着,技术团队不仅要关注模型性能,还需要在架构层面预留审计接口、日志记录与可解释性模块,以便满足监管审查和合规验收。

综上,大模型落地不仅是技术问题,更是一个跨越算法、系统、安全、法律多领域的系统工程,唯有多方协同,才能让 AI 真正走进生产环境并长期稳定运行。

六、AI 时代的开发者转型

在 AI 的浪潮下,开发者的角色正在发生变化——从“写代码的人”转向“与 AI 协作、设计系统的人”。

未来的竞争力不仅在于会哪种语言,而在于你能否有效使用 AI 工具、优化 AI 工作流,并将其落地到实际业务中。

AI 不是替代,而是放大。它能让我们从琐碎重复的劳动中解放出来,把更多时间投入到创造性工作中。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)