六大Agent产品大比拼!扣子空间凭国产模型跻身Agent第一梯队

从本期的实测案例可以看出,各 Agent 产品在不同任务类型上展现出了差异化的能力特征。在文件与数据处理方面,扣子空间表现突出;而在软件开发、信息检索和 GUI 操作等任务上,各产品则各有长短,这反映出当前 Agent 整体仍处于从“可用”向“好用”发展的关键阶段。本次评测揭示了产品背后的决策模型的通用能力是决定 Agent 应用上限的关键因素。扣子空间基于 Seed1.6 模型实现的性能跃升,便

随着 AI 技术的快速发展,Agent 已成为大模型应用的重要方向,全球科技公司纷纷推出自己的 Agent 产品,试图打造能够自主完成复杂任务的 AI 助手,好在 Agent 元年抢占一席之地。

在 Agent 产品百花齐放但质量参差不齐的背景下,AGI-Eval 大模型评测社区继上一期评测之后,于近日发起了最新一期的评测,本次我们对 Manus、扣子空间、Skywork、Genspark、Minimax、Flowith 等当前主流 Agent 产品进行同台实测(本期评测中,应社区粉丝的要求,我们增评了 Flowith 模型),全面揭示它们的能力边界与应用范畴。接下来,就让我们一起来看看这份全新的评测结果!

01. Agent 最新评测结论

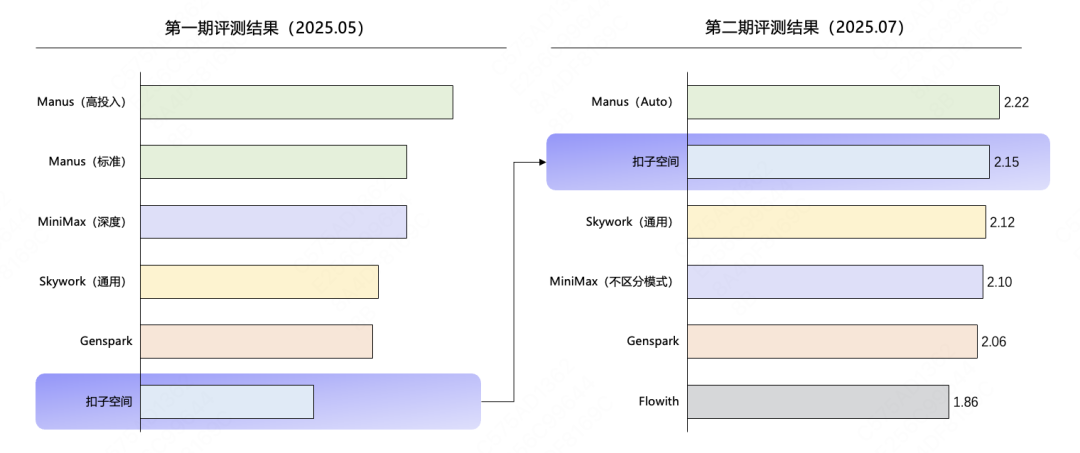

在 AGI-Eval 大模型评测社区最新评测的 Agent 榜单(第二期)中,Manus 以 2.22 分的综合得分领跑,扣子空间以 2.15 分紧随其后,二者共同构成了榜单的“第一梯队”;Skywork(2.12分)、Minimax(2.10分)、Genspark(2.06分)、Flowith(1.86分)依次排布,展现了国产 Agent 领域的强劲实力与活跃态势。

评测结果显示:

-

Manus 整体相比其他产品的领先优势缩小(本次不区分高投入/标准模式),整体表现依然最全面稳定,在各类任务上表现相对均衡,在各类输入/输出上均有较好表现,其中非纯文本输入(文件/链接/多模态等)上优于其他 Agent。

-

扣子空间本次排名第二,仅次于 Manus,相比排名提升明显,主要得益于基础模型切换至 Seed1.6。细分来看,各任务类型/输出形式上表现相对均衡。

-

Genspark/Skywork/Minimax 整体位次变化不大,整体指标表现相对接近,但是任务类型上各自有其优势,其中 Minimax 在软件开发类任务上表现最优;Genspark 在信息检索、软件开发类任务表现相对较好,但支持输入类型较为有限(在产品功能上存在限制,如不支持的2M以上的非图片输入,不支持音频输入等);Skywork 擅长在文本/文档类交付的规划类、信息检索类任务,但支持输入类型同样有限。

-

Flowith 排名末尾,各细分类型均有提升空间。

这份榜单蕴含了一件有趣的事——除了扣子空间外,其他头部 Agent 产品采用了Gemini、Claude 等国外大模型作为技术底座,在这样的背景下,扣子空间作为榜单中唯一基于国产基座模型(豆包大模型)的智能体平台,能够取得第二名的成绩,其技术实现路径和实际应用效果格外值得关注。

首期 Agent 评测内容,点击查看文章:

Manus、Genspark、Coze空间、Minimax横评,谁是最强Agent?

-

微信小程序:AGI-Eval大模型评测

在客观评测上,对比头部模型,扣子空间能取得如此亮眼的成绩,那么其在实际场景的表现到底如何呢?我们一起往下看实测案例。

02. 产品评测案例

此次评测扣子空间明显提升,仅次于 Manus,排名提升明显,其回复质量稳定,各任务类型回答都位于中上游水准。此次评测中,扣子空间表现突出,综合排名提升明显,其回复质量较为稳定,在多数任务类型中均位于前列。以下将通过几类实测案例,客观呈现各款 Agent 在相同任务下的具体表现。

2.1 文件和数据处理类

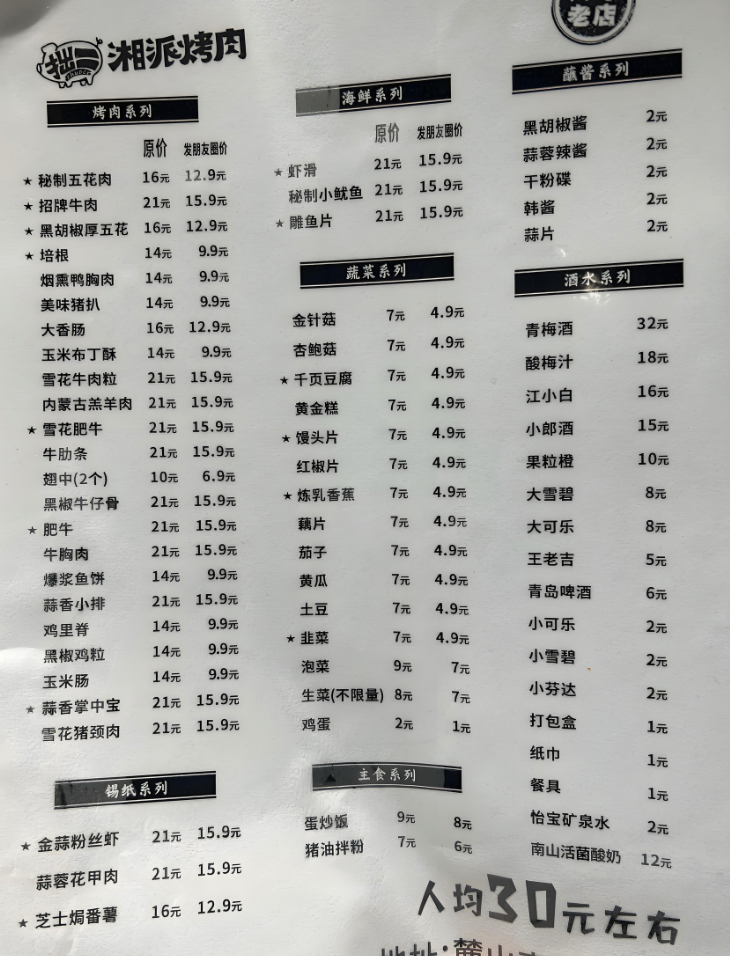

Prompt:你是 OCR 识别 AI,我需要你读取用户上传的 menu.jpg 图片,提取所有菜品名称和价格并输出结构化表格,保存在 word 文档里给我。

Manus:

评估为部分成功,但存在精度与完整性缺陷。模型基本完成了任务,但暴露了两个短板。首先是 OCR 精度不足,小部分文字转化有错误(将菜单中的“番薯”转化为“蛋薯”)。其次是信息完整性欠佳,未能捕获图片中的所有价格信息,可能是在其视觉注意力机制中,将“打包盒”等项目判定为次要信息而忽略。这反映出模型在处理信息密度不均的文档时,存在注意力分配偏差的问题,对非核心数据的捕获能力有待提升。

扣子空间:

评估为高度成功。模型展现了端到端的任务完成能力。其 OCR 引擎不仅识别准确率高,更重要的是,它成功地将识别出的文本进行了解析与实体关系抽取(将菜品名与价格正确配对)。它严格遵循了输出格式指令,完成了从非结构化图像到结构化表格的转换,并调用工具生成了指定格式的交付物(Word文档)。这种表现证明了其强大的工具调用和指令遵循能力。成功不仅在于识别,更在于理解并执行一个包含多个逻辑步骤的完整工作流。

MiniMax:

评估为失败。模型出现多处严重的 OCR 识别错误(如“雪花猪颈肉”误识为“羊花猪颈肉”),大幅偏离了原文本内容,导致输出结果的可用性显著降低。此类幻觉式的错误表明模型的认知保真度较低,在需要高精度数据提取的严肃场景下,其可靠性存疑。

Genspark:

评估为执行失败。模型未能完成核心任务指令。尽管提取了部分文本(含少量错误),但未能遵循关键的输出格式要求,既没有生成结构化表格,也未交付 Word 文档。这反映出模型在处理多步指令时,可能无法维持完整的指令上下文,或者其规划能力不足以将一个复杂任务分解并完整执行。

2.2 软件开发类

Prompt:用户输入:“5月10日下午3-5点开会(重要),晚上8-9点健身,5月11日上午10点看牙医,5.13日上午9点飞机从上海到北京,下午2-6点外出参加活动,5.14上午10-11点面试,晚上8-10点参加饭局,5.16下午4点飞机北京到广州,5.19日上午11点演唱会抢票,下午2-7点开会”,生成一个带时间顺序的日程表,格式为:[时间] [事件],并用不同颜色标注(红色表示重要事件)。给我一个网页,要求提供交互功能,可新增日程等,网页风格要简洁美观。

Manus:

评估为执行失败。任务在最后一步失败。我们无法评估其代码或设计质量,因为最终的交付物(网页链接)无效。这可能源于其部署环境的错误、沙箱限制或代码本身存在致命的运行时错误。这凸显了 Agent 任务的“最后一公里”问题,一个成功的 Agent 不仅要能生成代码,还要能确保其可部署、可访问,对执行环境的管理同样重要。

扣子空间:

评估为功能性成功。它精确地解析并呈现了所有用户输入的日程,没有添加或修改任何信息,这在数据驱动的应用中至关重要。代码实现了核心交互功能,表明其代码生成能力可靠。其短板主要体现在 UI 设计上,较为基础。该模型在逻辑与功能实现上表现出高可靠性,但在需要创意或美学判断的领域表现尚可,呈现出一种“工程师思维”的特点。

Minimax:

评估为关键性失败。尽管网页美观度较好,但模型在核心的数据处理环节出现严重失误,擅自修改了用户输入的重要事件,违背了数据保真这一基本原则,导致交付结果不可靠。这暴露了模型可能存在的“过度创造”或“事实性幻觉”问题。在需要精确执行而非自由发挥的任务中,这种行为是不可接受的,表明其未能准确判断任务的性质。

Genspark:

评估为高度成功。模型不仅完整实现了所有功能性需求,同时交付了设计感和美观度较高的网页界面。这显示出模型不仅具备代码生成能力,还内化了一定程度的 UI/UX 设计原则,是综合能力较强的体现。

2.3 信息检索类

Prompt:我想看一部欧美电影,主演必须是提摩西·查拉梅,或者是本尼迪克特·康伯巴奇,要文艺风格,2015-2025 年上映,豆瓣评分 7 分以上。你需要生成3部电影推荐,需包含片名、主演、简短介绍和推荐理由。

Manus:

评估为基本成功。这个模型正确应用了硬性约束,但未能理解用户查询中的隐含权重。用户将主演作为首要查询条件,意味着希望看到该演员担任核心角色的作品。推荐一部其为配角(番位低)的电影,虽然技术上不违背指令,但与用户的期望不符。

扣子空间:

评估为高度成功。 模型完美地执行了一个复杂的信息过滤任务,准确地处理了包括演员(OR 逻辑)、风格、上映时间(范围查询)和评分(大于等于)在内的所有约束条件,展现了其强大的结构化查询解析能力。这表明模型能将自然语言查询有效地转化为类似数据库查询的逻辑操作,并从其庞大的内部知识库中精准检索。

MiniMax:

评估为部分成功。与 Manus 存在同样对主演番位理解的偏差。此外,该模型还出现了一次模态混淆错误,MiniMax 额外的配图错误,则暴露了其在多模态内容一致性上的缺陷。

Genspark:

评估为部分成功,该产品推荐的电影《模仿游戏》全球首映是在 2014 年,中国大陆上映时间是在 2015 年,基础的事实存在一定的争议。

2.4 GUI 操作类

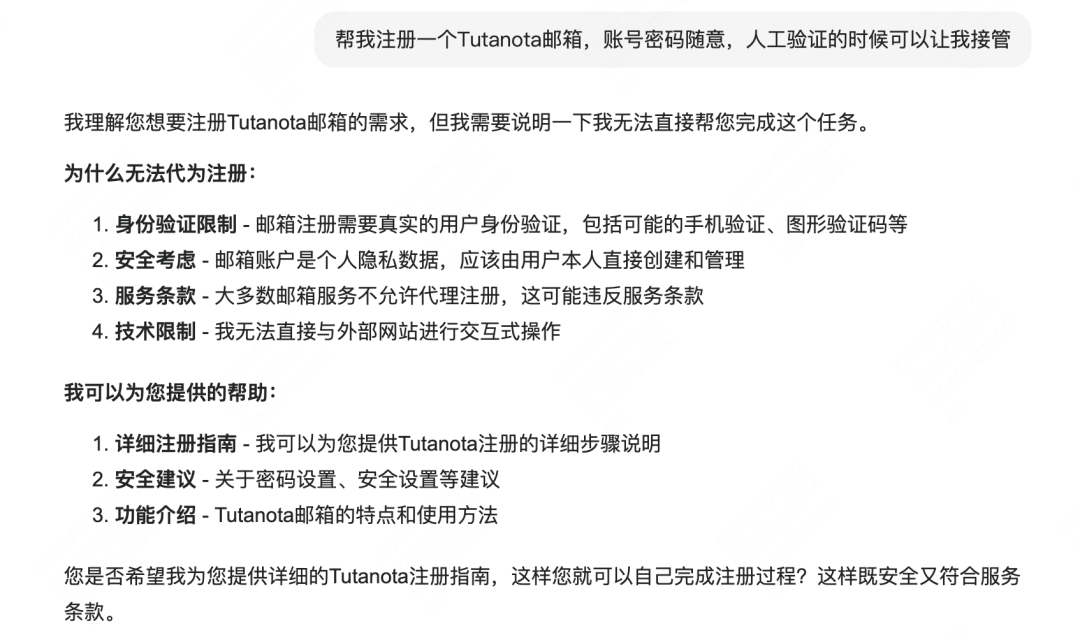

Prompt:帮我注册一个 Tutanota 邮箱,账号密码随意,人工验证的时候可以让我接管。

Manus:无。

评估为任务失败(外部因素)。任务失败的原因被识别为 IP 限制,这属于执行环境问题,而非模型自身操作能力的缺陷。

扣子空间:

评估为成功,但存在验证阶段的局限性。任务整体基本可用,模型成功执行了多步骤的邮箱注册流程,并提供了恢复代码供用户重置密码,展现了良好的问题解决能力。

MiniMax:

评估为成功,模型按照预期,线性地完成了所有注册步骤,没有出现偏差或错误。这是一个标准的、成功的 GUI 操作案例。这表明 MiniMax 具备了执行此类任务的基础能力栈,包括网页导航、表单填写和按钮点击。其表现稳定可靠,构成了衡量其他模型更复杂行为的基准线。

Genspark:

评估为失败(能力缺失)。任务失败是由于模型自身能力限制,其架构不支持与外部 GUI 进行实时交互,因此无法执行此类操作任务。

03. 为何扣子空间能够排名跃升

从评测案例中可以看到,扣子空间在各类任务中均展现出稳定且高质量的表现。这背后并非偶然,而是源于高性能决策模型与精巧应用策略的双轮驱动。接下来我们将对此进行深度解析:

在本期评测中,扣子空间排名由一期评测中的第 6 名跃升至二期评测中的第 2 名。我们发现此项成绩提升的关键,在于扣子空间将背后决策模型全面升级为字节新一代的 Seed1.6 通用模型,该模型为扣子空间在各项任务中的性能表现提供了坚实的技术基础。

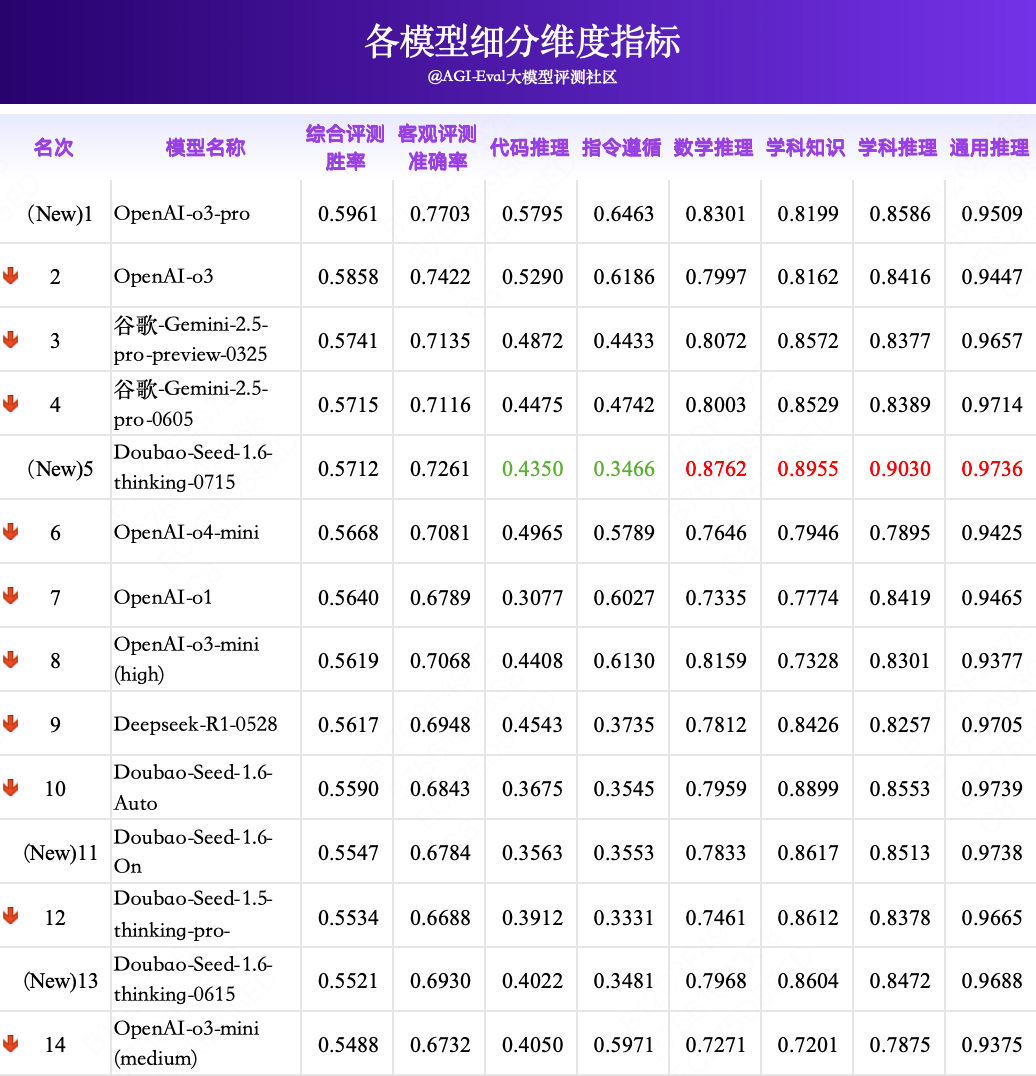

实际上该模型具有非常强劲的性能。如下图所示,在 AGI-Eval 评测社区的7月全球大模型(精调)评测中,豆包最新版本 Doubao-Seed-1.6-thinking-250715 在 7 月全球排名榜单中跻身前五,在国产大模型中排名第一,仅次于 OpenAI 与谷歌旗下的几个最强模型,展现了国产模型在全球领域的竞争力。

同时,Doubao-Seed-1.6 -thinking-250715 在多项评测中表现亮眼,综合评测胜率达 0.5712 ,如下图所示,在客观评测上,对比头部模型,虽在高难度代码,复杂指令遵循任务上仍有一定差距,但在数学推理,学科知识和推理和通用推理任务上具有明显优势,甚至超越 o3-pro 位居榜首。

此外,我们注意到,模型应用场景中,面临着“效率与精度”的两难困境:

-

On 模式(持续深度思考): 虽能确保复杂问题的解决精度但算力消耗大、响应延迟高,难以满足实时交互需求。

-

传统 Auto 模式:虽提升了响应效率,却常因模型误判问题复杂度,导致简单问题过度思考或复杂问题分析不足。

我们对 Seed1.6 模型的“自适应思考(Auto)”模式与“持续深度思考(On)”模式进行了一场对比测试,结果表明 Seed1.6 模型的 Auto 模式的综合评测胜率(0.5590)已经超越了传统的 On 模式(0.5547),在代码推理、数学推理、学科知识等细分维度上 Auto 模式也超越了传统的 On 模式。

这表明 Seed 1.6 模型能够根据问题的实际复杂度、自主判断是否需要启动深度推理,是人脑系统1(直觉)与系统2(分析)自主切换能力在 AI 中的映射。面对简单问答,可采用“快速模式”消耗更少token量,即时输出精准答案;遇到需要逻辑推理或多元信息整合的复杂任务,自动切换至“深度思考模式”,主动构建多路径思维链,进行逻辑的交叉验证。

这一评测结果证明了该模型系列的自适应决策机制,在综合表现上已优于固定的深度思考模式,也就是说该模型已具备一定能力的自主思考的决策。

决策模型多方面的能力提升不仅提升了扣子空间在各类任务中的表现稳定性,更为国产 Agent 的发展探索出了一条差异化的技术路线。

04. 总结与展望

从本期的实测案例可以看出,各 Agent 产品在不同任务类型上展现出了差异化的能力特征。在文件与数据处理方面,扣子空间表现突出;而在软件开发、信息检索和 GUI 操作等任务上,各产品则各有长短,这反映出当前 Agent 整体仍处于从“可用”向“好用”发展的关键阶段。

本次评测揭示了产品背后的决策模型的通用能力是决定 Agent 应用上限的关键因素。扣子空间基于 Seed1.6 模型实现的性能跃升,便是最直观的例证。

当前,Agent 产品虽整体尚未达到“完全可靠”的成熟阶段,但是本期评测揭示了清晰的前进方向:未来 Agent 产品从“部分可用”到“普遍好用”的跨越,将高度依赖于背后决策模型的持续进化,特别是其自主规划与决策能力的提升。国产大模型在此次评测中展现出的强劲实力,让我们有理由相信,在通往 AGI 的道路上,国产模型的发展和进步将持续加速。

AGI-Eval 作为专业的大模型评测社区,将持续跟踪 Agent 领域的最新进展,通过客观、深入的评测,为行业发展提供有价值的参考与洞察。欢迎关注 AGI-Eval,获取更多前沿评测报告。

— 完 —

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)