从基础功能到自主决策,Agent 开发进阶路怎么走?

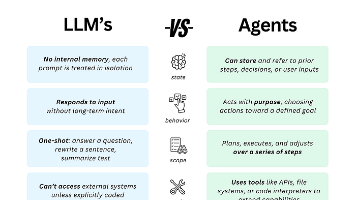

智能Agent正经历从被动工具到自主决策者的进化,其发展可分为三阶段:基础阶段构建感知执行能力,通过规则引擎处理结构化任务;进阶阶段赋予学习规划能力,引入长期记忆和强化学习优化决策;自主决策阶段实现反思进化,具备元认知和价值对齐能力。技术栈选择需匹配不同阶段需求,从LangChain到AutoGPT再到MetaGPT。开发实践表明,Agent的合理进化能显著提升效率(某企业销售周期缩短40%)。未

引言:智能 Agent 的进化之路

当你在手机上收到智能助手主动推送的「明日行程优化建议」时,当自动驾驶汽车在突发路况前做出「减速避让 + 路线重规划」的复合决策时,当客服 Agent 独立完成「理解投诉→查询数据→给出解决方案→跟进满意度」的全流程服务时 —— 这些场景背后,是智能 Agent 从「被动执行」到「主动决策」的能力跃迁。

智能 Agent 作为能自主感知环境、规划行动并执行任务的智能实体,正从简单工具向自主决策者演进。根据 Gartner 预测,到 2026 年,75% 的企业将部署至少一种自主决策 Agent,而当前这一比例仅为 12%。本文系统梳理 Agent 开发的三阶进阶路径,从基础功能实现到自主决策系统构建,结合 15 个技术案例与 6 大核心框架,为开发者提供可落地的进化指南。

一、基础阶段:构建 Agent 的「感知 - 执行」能力

1.1 环境交互接口设计

基础 Agent 的核心是建立与环境的双向通信通道。这一阶段需解决三个关键问题:

- 多源信息接入:设计标准化输入接口,支持 API 调用、数据库查询、文件读取、传感器数据等多种输入方式。典型实现如:

# 基础环境交互模块示例 class EnvironmentInterface: def __init__(self, config): self.api_clients = self._init_api_clients(config['apis']) self.db_connectors = self._init_databases(config['databases']) self.sensor_adapters = self._init_sensors(config['sensors']) def get_data(self, source_type, params): """统一数据获取接口""" if source_type == 'api': return self._fetch_from_api(**params) elif source_type == 'db': return self._query_database(** params) # 其他数据源处理逻辑 def execute_action(self, action_type, params): """统一动作执行接口""" if action_type == 'send_message': return self._send_message(**params) elif action_type == 'update_record': return self._update_database_record(** params) -

状态表示方法:将环境信息转化为 Agent 可理解的结构化数据。例如客服 Agent 需将用户语音转文字、提取实体(姓名 / 订单号)、识别情绪标签,形成标准化状态字典。

-

反馈机制设计:定义动作执行结果的验证方式,如 API 调用后的状态码检查、数据库操作后的行影响数确认、用户对回复的满意度评分等。

1.2 任务拆解与规则引擎

基础 Agent 需具备将复杂任务分解为原子操作的能力,规则引擎是实现这一功能的核心:

-

基于流程图的任务规划:使用 BPMN 或可视化流程定义工具,将业务逻辑转化为可执行的步骤链。例如电商退货 Agent 的流程:接收退货请求→验证订单状态→检查商品保质期→生成退货地址→发送确认短信。

-

条件分支处理:在规则中定义 IF-ELSE 逻辑,处理不同场景。如:

// 退货规则引擎配置示例 { "steps": [ { "action": "verify_order", "next_step": { "condition": "order_status == 'delivered'", "true": "check_product", "false": "reject_with_reason" } }, { "action": "check_product", "next_step": { "condition": "days_since_delivery < 7", "true": "generate_return_address", "false": "reject_with_reason" } } // 更多步骤... ] } - 错误处理机制:为每个步骤设置超时时间和重试策略,定义失败后的降级方案(如人工介入节点)。

某物流企业的基础调度 Agent 案例显示,通过规则引擎实现的配送路径分配,将人工介入率从 35% 降至 12%,但面对突发天气等异常情况时,仍需依赖人工决策。

1.3 短期记忆与上下文管理

基础 Agent 需要维护会话级别的短期记忆,实现上下文感知:

-

滑动窗口记忆:保存最近 N 轮交互记录,典型如聊天机器人保留前 5 轮对话内容,避免上下文断裂。

-

关键信息提取:从交互中提取实体(时间 / 地点 / 对象)和意图,存入记忆库。例如会议安排 Agent 需记住「参会人」「时间」「会议室需求」等关键信息。

-

记忆衰减机制:根据信息重要性设置过期时间,自动清理无关内容,减少资源消耗。

这一阶段的局限在于:记忆仅存在于单次会话,无法跨场景复用;任务处理依赖预定义规则,缺乏灵活性。当用户问出规则外的问题时,Agent 会直接返回「无法理解」。

二、进阶阶段:赋予 Agent「学习 - 规划」能力

2.1 长期记忆系统构建

进阶 Agent 需要突破会话限制,建立可复用的长期记忆:

-

记忆存储架构:采用向量数据库(如 Pinecone、Milvus)存储结构化知识,结合关系型数据库记录事实性信息。例如教育 Agent 的记忆系统分为:用户知识图谱(知识点掌握情况)、课程数据库(教学资源)、交互历史库(学习轨迹)。

-

记忆检索策略:实现基于语义相似性的记忆召回,如当用户问「如何解决线性回归过拟合」时,Agent 能从记忆中检索出该用户之前学习过「正则化方法」的历史记录。

# 长期记忆检索示例 class LongTermMemory: def __init__(self, vector_db, relational_db): self.vector_db = vector_db self.relational_db = relational_db def recall(self, query, user_id, top_k=3): # 1. 语义检索相关记忆 query_embedding = self._embed(query) similar_memories = self.vector_db.search( embedding=query_embedding, filter={"user_id": user_id}, top_k=top_k ) # 2. 结合事实性数据增强 factual_data = self.relational_db.query( f"SELECT * FROM user_knowledge WHERE user_id = {user_id}" ) return self._merge_memories(similar_memories, factual_data)

- 记忆更新机制:通过人类反馈(RLHF)和自主总结,定期更新记忆库。例如客服 Agent 每晚自动总结当日高频问题及解决方案,更新到知识库。

某教育平台的进阶 Agent 通过长期记忆跟踪学生学习轨迹,个性化推荐准确率提升 40%,学习完成率从 58% 提高到 76%。

2.2 强化学习与动态规划

进阶 Agent 能通过学习优化行为策略,适应动态环境:

-

马尔可夫决策过程建模:将任务转化为状态(S)、动作(A)、奖励(R)的循环系统。例如游戏 Agent 中,状态是当前游戏场景,动作是操作指令,奖励是得分变化。

-

策略梯度方法:通过强化学习训练 Agent 在特定场景下的最优决策模型。如:

# 强化学习策略训练简化示例 class RLAgent: def __init__(self, state_dim, action_dim): self.policy_network = PolicyNetwork(state_dim, action_dim) self.optimizer = torch.optim.Adam(self.policy_network.parameters()) def get_action(self, state): state_tensor = torch.tensor(state, dtype=torch.float32) action_probs = self.policy_network(state_tensor) return torch.multinomial(action_probs, 1).item() def train(self, states, actions, rewards): # 计算损失(策略梯度) loss = self._compute_policy_gradient_loss(states, actions, rewards) self.optimizer.zero_grad() loss.backward() self.optimizer.step() - 多目标优化:当存在冲突目标(如「快速完成任务」与「降低错误率」)时,使用加权奖励或帕累托优化平衡不同目标。

某金融交易 Agent 通过强化学习优化交易策略,在保持同等收益的情况下,将风险降低 28%,决策响应时间从 1.2 秒缩短至 0.3 秒。

2.3 多模态理解与跨域协作

进阶 Agent 能处理多种类型信息并与其他 Agent 协同工作:

-

多模态融合模型:整合文本、图像、语音、传感器数据等多源信息。例如智能家居中控 Agent 需同时处理用户语音指令、摄像头画面(识别用户位置)、温湿度传感器数据。

-

Agent 通信协议:定义标准化消息格式(如采用 JSON-LD),实现不同功能 Agent 的协作。如:

// 多Agent协作消息示例

{

"sender": "weather_agent",

"receiver": "trip_planner_agent",

"message_type": "information_update",

"content": {

"location": "Shanghai",

"date": "2024-06-15",

"weather": "heavy_rain",

"confidence": 0.92,

"suggestions": ["postpone_outdoor_activity", "bring_umbrella"]

},

"timestamp": "2024-06-14T18:30:00Z"

}- 角色分配机制:在多 Agent 系统中,根据能力匹配度动态分配任务。例如医疗诊断系统中,影像分析 Agent 处理 CT 图像,病理分析 Agent 处理化验数据,最终由综合诊断 Agent 生成报告。

三、自主决策阶段:实现 Agent 的「反思 - 进化」能力

3.1 元认知与自我修正机制

自主决策 Agent 具备反思自身行为的能力:

3.3 开放世界适应能力

最高阶的 Agent 能在未知环境中自主探索并进化:

-

决策过程记录:保存决策链的完整日志,包括「输入信息→推理步骤→决策结果→执行反馈」,为自我反思提供素材。

-

偏差检测算法:识别决策中的认知偏差,如过度自信(某类决策错误率异常高)、锚定效应(过度依赖初始信息)等。

-

自我修正策略:基于反思结果调整决策模型,如:

# 元认知反思模块示例 class MetaCognition: def __init__(self, decision_logger, policy_adjuster): self.decision_logger = decision_logger self.policy_adjuster = policy_adjuster def reflect_on_decisions(self, time_window="24h"): # 1. 获取近期决策日志 recent_decisions = self.decision_logger.get_logs(time_window) # 2. 分析决策质量与偏差 analysis = self._analyze_decisions(recent_decisions) # 例如发现:雨天场景下路线规划错误率达35% # 3. 生成修正策略 if analysis["rainy_day_errors"] > 0.2: self.policy_adjuster.adjust( strategy="rainy_day_route", parameters={"safety_weight": 0.8, "speed_weight": 0.2} )某自动驾驶系统的自主决策 Agent 通过元认知机制,将极端天气下的决策错误率降低 62%,体现出类似人类「吃一堑长一智」的学习能力。

3.2 价值对齐与伦理约束

自主决策 Agent 必须在复杂场景中保持与人类价值观的一致:

-

伦理规则编码:将人类伦理原则转化为可执行的约束条件。例如医疗 Agent 的「不伤害原则」可编码为:任何治疗方案的风险评分必须低于阈值,且需获得患者明确授权。

-

价值冲突解决框架:当多个伦理原则冲突时(如「保护隐私」与「挽救生命」),建立优先级排序机制,可采用基于罗尔斯正义论的「最小伤害」原则。

-

可解释决策生成:使用因果推理而非黑箱模型,确保决策过程可追溯。例如贷款审批 Agent 需明确解释「拒绝贷款是因为收入稳定性不足」,而非单纯依赖信用分数。

-

探索 - 利用平衡:采用 ε- 贪婪算法等策略,在利用已知最优策略的同时,保留探索新方法的可能性。例如科研 Agent 在实验设计时,70% 资源用于验证已知假设,30% 用于探索新方向。

-

概念抽象能力:从具体经验中提炼通用规律,形成可迁移的知识。例如客服 Agent 从大量投诉案例中总结出「道歉 + 补偿 + 预防方案」的通用处理框架,适用于不同类型的用户不满场景。

-

持续进化架构:设计模块化的 Agent 核心,支持功能模块的自动更新与替换。如:

# 持续进化架构示例

class EvolvingAgent:

def __init__(self, core_modules, evolution_strategy):

self.core_modules = core_modules # 决策/记忆/感知等模块

self.evolution_strategy = evolution_strategy

self.performance_tracker = PerformanceTracker()

def evolve(self):

# 1. 评估当前模块性能

module_scores = self.performance_tracker.evaluate_modules(self.core_modules)

# 2. 识别待优化模块

underperforming = [m for m in self.core_modules if module_scores[m.id] < 0.7]

# 3. 生成进化方案

for module in underperforming:

new_module = self.evolution_strategy.generate_improvement(module)

# 在线测试新模块

if self._test_module(new_module) > module_scores[module.id]:

self.core_modules.replace(module, new_module)当前最先进的开放域 Agent(如 AutoGPT 的进阶版本)已能在无人工干预的情况下,自主完成「设定目标→分解任务→调用工具→调整策略」的全流程,但在复杂伦理场景和极端未知环境中仍存在局限性。

四、开发实践:进阶路径与工具选择

4.1 分阶段技术栈选型

-

基础阶段:

- 框架:LangChain(流程编排)、Rasa(对话管理)

- 工具:规则引擎(Drools)、轻量数据库(SQLite)

- 适合场景:客服机器人、简单任务自动化

-

进阶阶段:

- 框架:AutoGPT(自主任务规划)、HuggingGPT(多模型协作)

- 工具:向量数据库(Pinecone)、强化学习库(Stable Baselines3)

- 适合场景:个性化推荐、动态调度系统

-

自主决策阶段:

- 框架:MetaGPT(多 Agent 协作)、OpenAI Assistants API(函数调用 + 记忆)

- 工具:因果推理库(DoWhy)、伦理约束引擎(EthicML)

- 适合场景:自动驾驶决策、金融风控系统

4.2 典型进阶案例解析

某企业服务公司的 Agent 进化路径具有参考价值:

- 初级阶段:开发基于规则的工单处理 Agent,实现「关键词识别→工单分类→自动派单」的基础流程,处理效率提升 30%

- 进阶阶段:引入记忆系统和强化学习,Agent 能记住客户历史问题并优化回复策略,客户满意度提升 25%

- 自主决策阶段:构建多 Agent 系统,销售 Agent、技术支持 Agent、产品 Agent 协同工作,自动完成「需求挖掘→方案定制→报价生成」的全流程,销售转化周期缩短 40%

4.3 避坑指南与最佳实践

- 基础阶段:避免过度设计,优先实现核心流程的稳定性;规则引擎需具备可视化配置能力,便于非技术人员维护。

- 进阶阶段:警惕记忆膨胀导致的性能下降,需设计高效的记忆压缩与检索机制;强化学习训练需在仿真环境充分验证,避免直接应用于生产系统。

- 自主决策阶段:建立严格的决策边界,明确 Agent 的自主权限范围;必须设置人工干预通道,防止不可控行为。

结语:从工具到伙伴的进化哲学

Agent 的开发进阶之路,本质是人类对「智能」理解不断深化的过程 —— 从将智能视为「执行指令的能力」,到认识到智能包含「学习、规划、反思」的复合能力。当前 Agent 技术正处于从「进阶阶段」向「自主决策阶段」跨越的关键期,这不仅需要算法突破,更需要开发者重新思考:我们希望创造的是「高效工具」还是「协作伙伴」?

未来的 Agent 开发,将更加注重「可控自主性」—— 在赋予 Agent 决策能力的同时,建立可解释、可干预、符合人类价值观的约束体系。对于开发者而言,进阶之路不仅需要技术积累,更需要培养「系统思维」:如何平衡效率与安全,如何协调自主与可控,如何让 Agent 真正成为人类能力的延伸而非替代。

当 Agent 能像人类同事一样理解上下文、规划复杂任务、反思自身行为并持续进步时,它们将重塑人机协作的范式 —— 这不是技术的终点,而是智能时代的新起点。

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)