LLM在产品和项目中如何落地

任何应用开发的起点都是明确 “解决什么问题”,LLM 应用也不例外。核心场景:是客服、知识库、代码生成、工作流,还是多模态交互?用户需求:是否私有数据?是否需要调用三方API?是否需要多轮对话记忆?约束条件:成本预算、数据安全、合规要求(如隐私、法规)。无论是在产品中还是在项目中落地LLM,本质都是软件工程,都需要遵循软件工程的实践思路。Dify 是一个大模型应用开发的平台。它提供了一系列工具和服

结论:基于 LLM 的应用开发,核心是围绕 “收集需求/场景→确定模型能力→封装模型功能→提供业务调用” 的流程展开。

在AI浪潮席卷的今天,大型语言模型(LLM)已成为技术创新的新引擎。但如何将这股强大的力量真正“落地”,转化为解决实际业务问题的应用?本文将为你拆解一套清晰、可操作的LLM应用开发流程。

需求分析与场景定义

任何应用开发的起点都是明确 “解决什么问题”,LLM 应用也不例外。这一步需要清晰回答:

- 核心场景:是客服、知识库、代码生成、工作流,还是多模态交互?

- 用户需求:是否私有数据?是否需要调用三方API?是否需要多轮对话记忆?

- 约束条件:成本预算、数据安全、合规要求(如隐私、法规)。

无论是在产品中还是在项目中落地LLM,本质都是软件工程,都需要遵循软件工程的实践思路。

模型选型与方案设计

根据需求选择合适的 LLM,并确定技术方案(自己部署还是调用 API),这是后续开发的基础。

模型选型核心依据

- 能力匹配:通用对话选 Llama 3、Qwen 3;代码场景选 CodeLlama、StarCoder;专业领域(如医疗)选 Med-PaLM、BioLlama。

- 部署成本:开源模型(如 7B/13B 参数)可本地部署(低成本),大模型(如 70B+)需高性能 GPU(成本高);第三方 API(如 GPT-4、文心一言)按调用量收费,无需硬件投入。

- 数据安全:私有数据场景优先选开源模型自部署(如 Llama 3 8B);公开场景可直接调用 API(如 GPT-3.5 Turbo)。

技术方案选择

| 方案 | 适用场景 | 部署方式 |

|---|---|---|

| 自己部署开源模型 | 数据在私域,成本低,可定制化强 | 部署工具:ollama(轻量)、vllm(高性能推理)、TGI(Hugging Face 官方工具);硬件:GPU(如 A10、3090)或 CPU(仅小模型) |

| 直接调用云厂商API | 快速验证、无硬件资源、通用场景 | / |

Ollama:本地模型的管家

Ollama 是一个旨在简化大型语言模型(LLMs)本地部署和运行的工具或框架,官网地址:https://ollama.com/

-

简化部署流程:提供了一个简化的界面和命令行工具,使得下载、安装和运行大模型变得非常容易

-

支持多种模型:可以方便的同时管理多个模型

-

优化性能:Ollama 设计时考虑到了性能优化,即使是在资源受限的环境中也能提供良好的用户体验。例如,可以帮助在没有 GPU 的情况下,在 CPU 上运行较大的模型。

-

易于使用的接口:提供了简单的命令行接口(CLI),让用户可以方便地管理模型,如下载、更新、删除等操作。对于开发者而言,也提供了API接口以便于集成到自己的应用中。

-

社区和支持:作为一款开源或开放使用的工具,Ollama 拥有一个活跃的社区,用户可以在其中分享经验、解决问题以及获取最新的信息和技术支持。

Ollama常用命令:

| 命令 | 说明 |

|---|---|

| ollama server | 启动 Ollama 服务 |

| ollama version | 查询版本 |

| ollama run | 运行大模型 |

| ollama list | 显示模型列表 |

| ollama show | 显示模型信息 |

| ollama pull | 拉取模型 |

| ollama push | 推送模型到仓库。官方模型库: https://ollama.com/library |

| ollama cp | 拷贝模型 |

| ollama rm | 删除模型 |

| ollama stop | 停止正在运行的模型实例 |

| ollama ps | 查询正在运行的模型进程 |

Dify:LLM应用低代码开发平台

简介

Dify 是一个大模型应用开发的平台。它提供了一系列工具和服务,帮助开发者更轻松地创建、部署和维护基于AI的应用程序。官网地址:https://dify.ai/

-

低代码集成:提供直观的用户界面,开发者无需编写大量代码即可集成AI功能到应用中。

-

自定义工作流:允许用户设计复杂的对话逻辑和交互流程,工作流中集成AI能力。

-

模型微调与优化:提供了对预训练模型进行微调的能力,让开发者可以根据特定任务的需求定制模型性能,提高准确性和适用性。

-

数据管理:包括数据标注、清洗等功能,有助于准备高质量的数据集用于训练或测试AI模型。

-

实时监控与分析:内置了对AI应用性能的实时监控工具,以及数据分析能力,帮助开发者快速定位并解决问题,持续改进服务质量。

-

安全与隐私保护:注重用户数据的安全性和隐私保护,确保符合相关法律法规的要求。

-

多环境部署支持:无论是云端还是本地服务器都可以。

-

社区与资源:拥有活跃的开发者社区,可以获取最新的资讯、教程和技术支持,促进知识共享和技术交流。

简单来说,Dify是一个让AI触手可及的工具,

竞品功能对比

dify 和竞品的功能对比:

如何构建AI能力

Dify中默认提供了5中能力类型:

-

聊天助手:基于 LLM 构建对话式交互的助手

-

文本生成应用:面向文本生成类任务的助手,例如撰写故事、文本分类、翻译等

-

Agent:能够分解任务、推理思考、调用工具的对话式智能助手

-

对话流:适用于定义等复杂流程的多轮对话场景,具有记忆功能的应用编排方式

-

工作流:适用于自动化、批处理等单轮生成类任务的场景的应用编排方式

以聊天助手举例,如何在dify中搭建一个基于LLM的应用:

1:创建应用

在Dify的web界面中创建一个聊天助手应用,选取其依赖的大模型,关联知识库(可选),编写提示词(prompt)

2:调试应用

就是和助手聊天,根据需求和它反馈的答案,确认是否需要改进提示词

3:发布应用

点击发布按钮后,将生成一个聊天助手的应用,它基于LLM,拥有一个独立的页面和公开的URL可供使用,也提供API可以让业务系统调用。

Ollama和Dify的关系

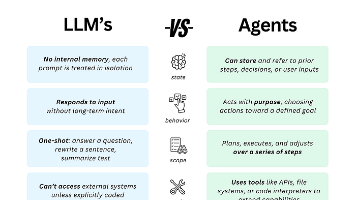

ollama注重大模型的管理,强项是下载大模型文件并部署及接口化封装,可以概括为ollama是大模型的运行时。

dify注重基于大模型开发应用,它在 Ollama 之上提供了更贴近业务的抽象层。例如:

-

可视化的 prompt 工程与模板管理

-

对话流程编排(多轮对话、上下文管理)

-

集成 RAG(检索增强生成)能力,可以轻松的打造类似知识库和文档问答的AI应用

-

提供更简单的应用级 API(如直接调用一个 “客服对话应用” 的接口,而非底层模型接口)

dify本身不具备根据模型源文件安装和部署大模型的功能,

其核心能力是对接已部署好的模型服务(无论是云端 API 还是本地部署的模型服务)。

dify可以直接通过大模型本身提供的http接口和大模型交互,也可以间接的通过ollama这种工具和大模型交互,具体而言dify请求ollama的接口发起对大模型的调用,ollama转发给实际的大模型处理,并将处理结果返回给dify,整个过程ollama充当了一个代理的角色。

业务集成

调用大模型本身

业务系统直接调用LLM原生接口,无需额外中间层。适用于调用闭源模型,或者原生提供 API 的开源模型(如部分模型通过 FastAPI 自行封装的接口)。

调用管理工具

业务系统调用中间工具的接口,由工具负责与 LLM 交互,这类工具又可细分为两种角色:

-

模型管理工具(如 Ollama):核心是 “让本地模型具备可调用能力”,业务系统调用它们的接口(如 Ollama 的/api/chat),工具内部负责加载模型、执行推理、返回结果。

-

应用开发平台(如 Dify、LangChain):核心是 “简化 LLM 应用开发”,业务系统调用平台封装的接口(如 Dify 的对话 API),平台内部负责选择模型(可能是云端 API 或本地 Ollama 等)、处理 prompt、管理对话流程等。

总结

基于 LLM 的应用开发,本质是将模型能力与业务需求精准匹配。从明确场景、选型模型,到用 Ollama 部署模型、Dify 快速开发应用,再到集成到业务系统,每一步都需围绕 “解决实际问题” 展开。

掌握这套流程,你将能高效落地 LLM 应用,让 AI 技术真正为业务赋能。

引用

- LLM核心概念:https://mp.weixin.qq.com/s/6m8pYskMmrERtFCztMdNNQ

- Ollama:https://ollama.com

- Dify:https://dify.ai

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)