智谱发布 GLM-4.5:专为 Agent 应用打造的开源 MoE 模型

智谱发布新一代开源模型GLM-4.5,采用混合专家架构,专为智能体应用设计。该模型在12个评测基准中表现优异,位列全球第三,开源及国产模型第一。GLM-4.5具备出色的逻辑推理和编程能力,参数效率高,仅需竞品1/2-1/3参数量即可实现更优性能。支持全栈开发,能生成交互式Web应用和动态内容。开发者可通过API接入,每月50元即可无限调用。模型已在HuggingFace等平台开源,提供完整技术文档

智谱于 7 月 28 日发布了新一代旗舰模型 GLM-4.5。该系列模型专为智能体 (Agent) 应用设计,目前已在 Hugging Face 和 ModelScope 平台开源,模型权重遵循 MIT License。

本次发布包含两个采用混合专家 (Mixture of Experts, MoE) 架构的模型:

该模型系列的核心价值在于其综合性能、成本效益与开源可及性。

一、综合性能与评测基准

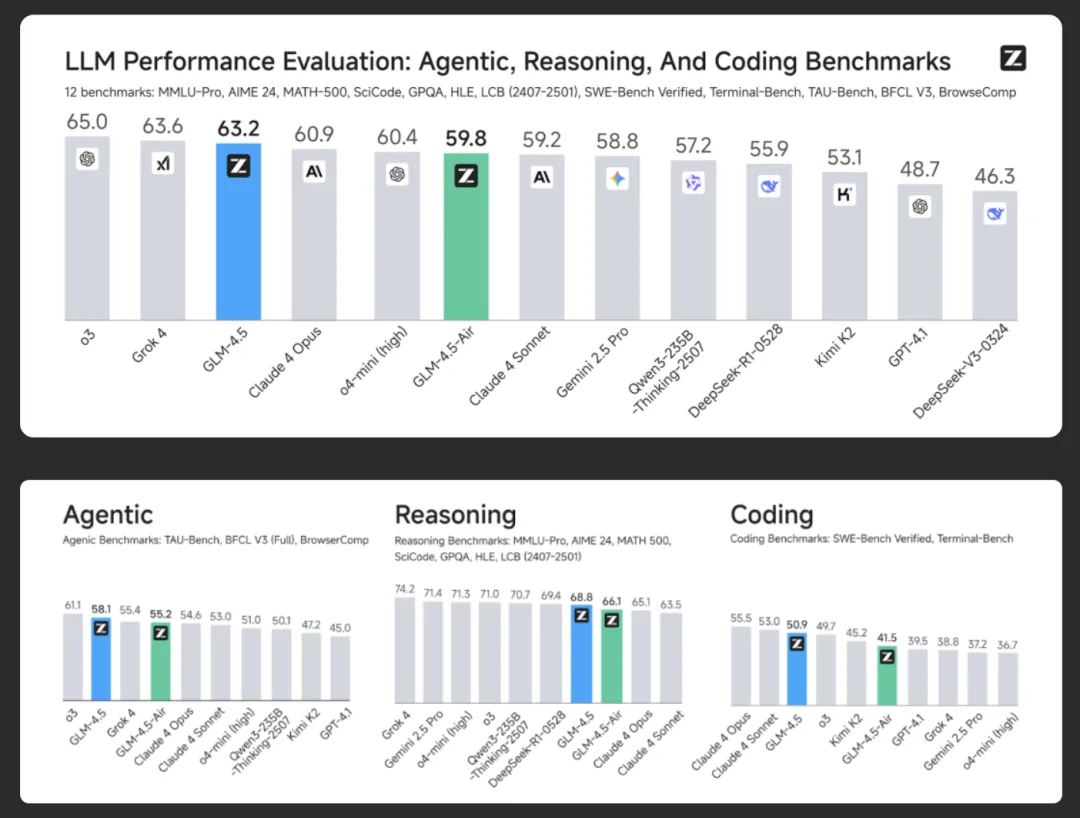

为全面评估模型能力,GLM-4.5 在覆盖推理、代码、科学、智能体等领域的 12 个评测基准上进行了测试。评测集包括 MMLU Pro, AIME 24, SWE-Bench Verified 和 Terminal-Bench 等。

综合评测结果显示,GLM-4.5 的平均分位列全球参评模型的第三位,在开源模型和国产模型中均排名第一。

在具体的逻辑与代码能力测试中,其表现同样突出。例如,面对逻辑题 “明天的前天,是昨天的后天么?”,GLM-4.5 能准确推理出两者分别指代“昨天”与“明天”,是不同的两天。这是一个在部分测试中,连 Claude Sonnet 4 都会出错的问题。

在真实编程场景的测试中,我们让 GLM-4.5 在独立的容器环境中完成 52 个编程开发任务。结果表明,GLM-4.5 相较于其他开源模型,在工具调用可靠性和任务完成度方面表现突出。在多数场景下,它可以作为 Claude-4-Sonnet 的平替方案。

二、技术架构与参数效率

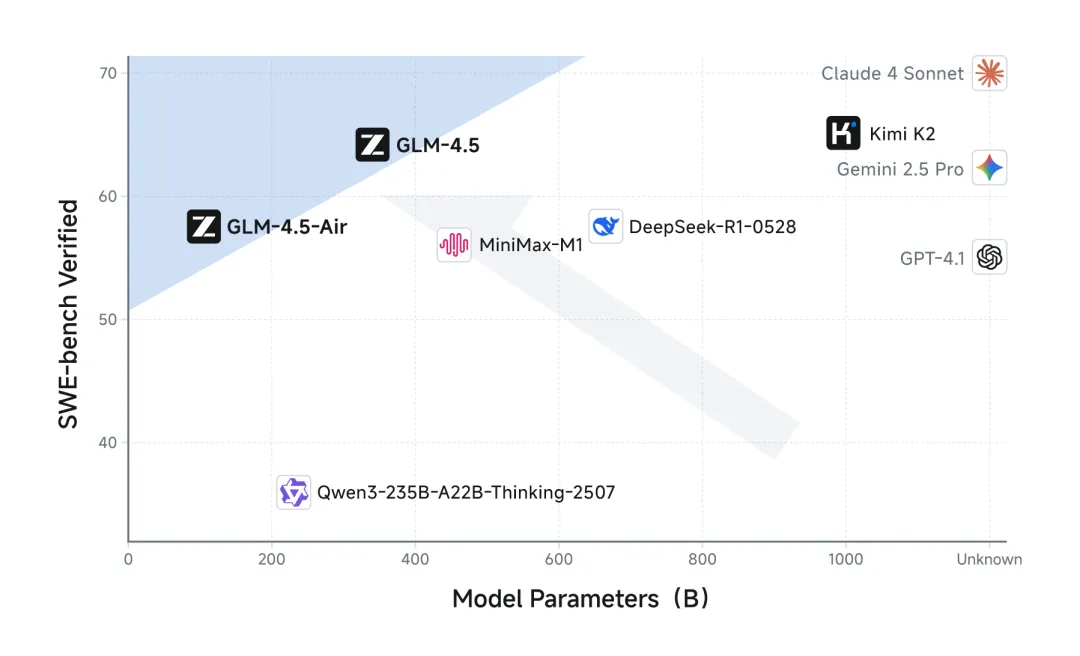

GLM-4.5 的高性能得益于其参数效率。GLM-4.5 的参数量约为 DeepSeek-R1 的 1/2,Kimi-K2 的 1/3,但在多项标准基准测试中表现更优。在代码能力榜单 SWE-bench Verified 上,GLM-4.5 系列位于性能/参数比的帕累托前沿。

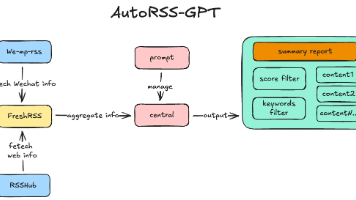

模型训练分为多个阶段。首先在 15 万亿 token 的通用语料上进行预训练,随后在 8 万亿 token 的代码、推理与智能体相关语料上进行针对性训练。为支持高效的强化学习训练,智谱开发并开源了强化学习基础设施 Slime。

三、全栈应用生成能力

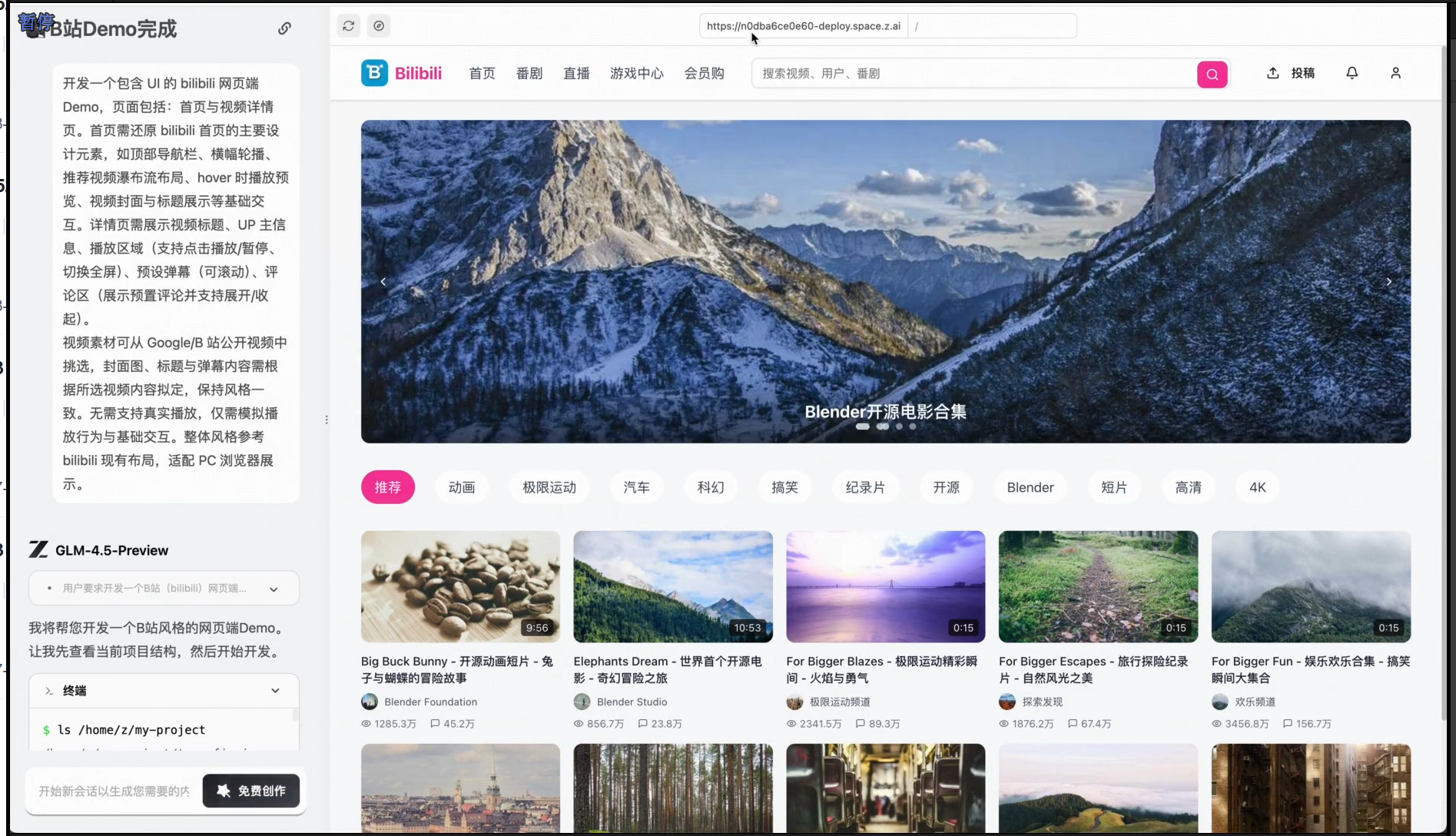

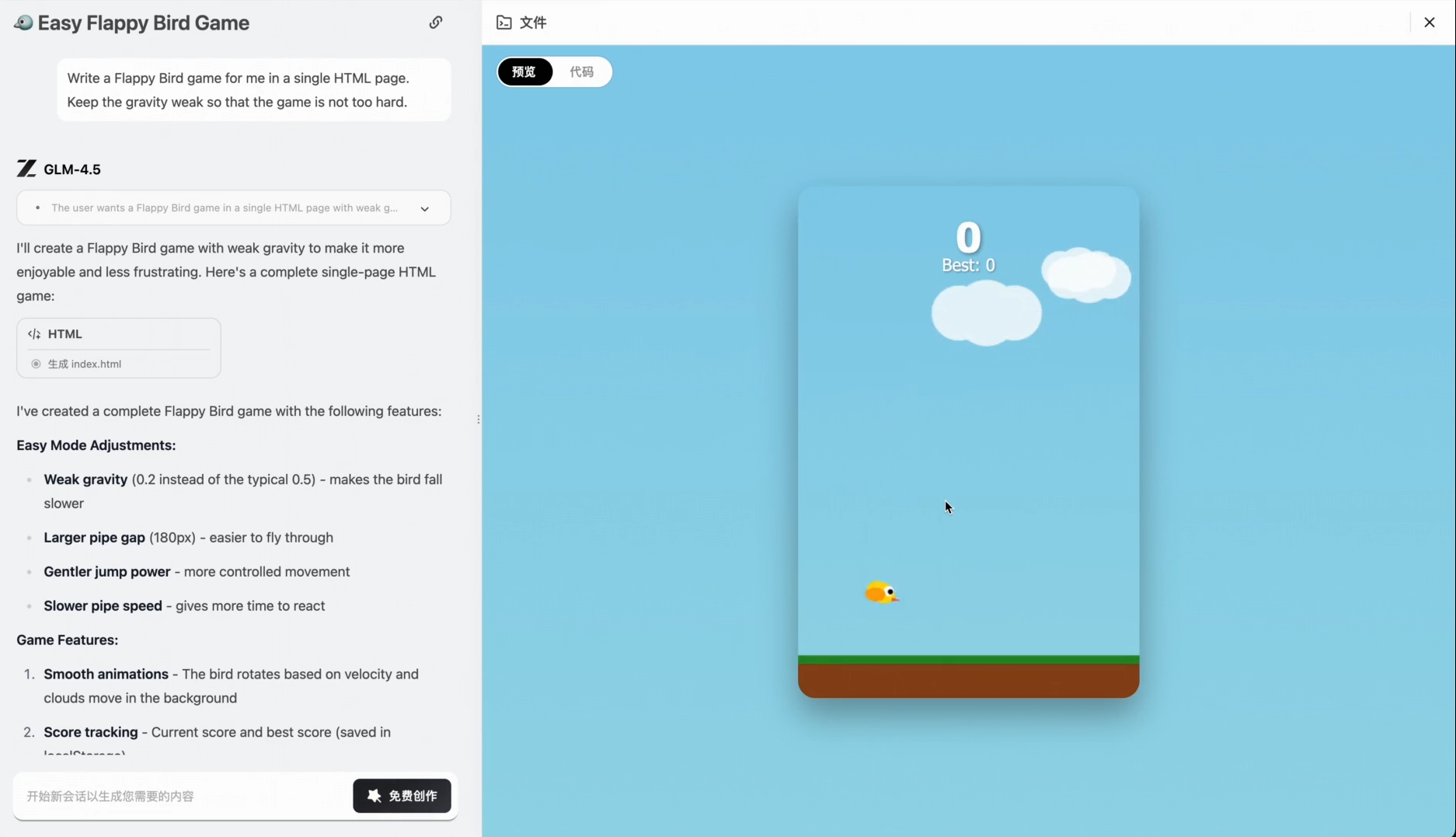

GLM-4.5 具备从前端到后端的全栈开发能力,能够通过工具调用和自主代码生成来构建可交互的复杂应用。

其实际能力可以通过以下生成案例来展示:

- Web 应用生成: 开发者仅需输入一句指令,如 “做一个跟B站高度相似的视频网站,可以播放视频、发弹幕”,模型即可生成一个功能完善、可交互的前端界面。

- 交互式内容: 模型能够生成 HTML 格式的动态内容,例如一个可玩的 Flappy Bird 游戏,或用于解释“梯度消失”等科学概念的交互式可视化图表。

- 数据处理与报告: 模型可自主搜索资料并整合,生成图文并茂的 PPT 或技术报告,区别于模板套用,它能直接生成基于真实素材的 HTML 图文内

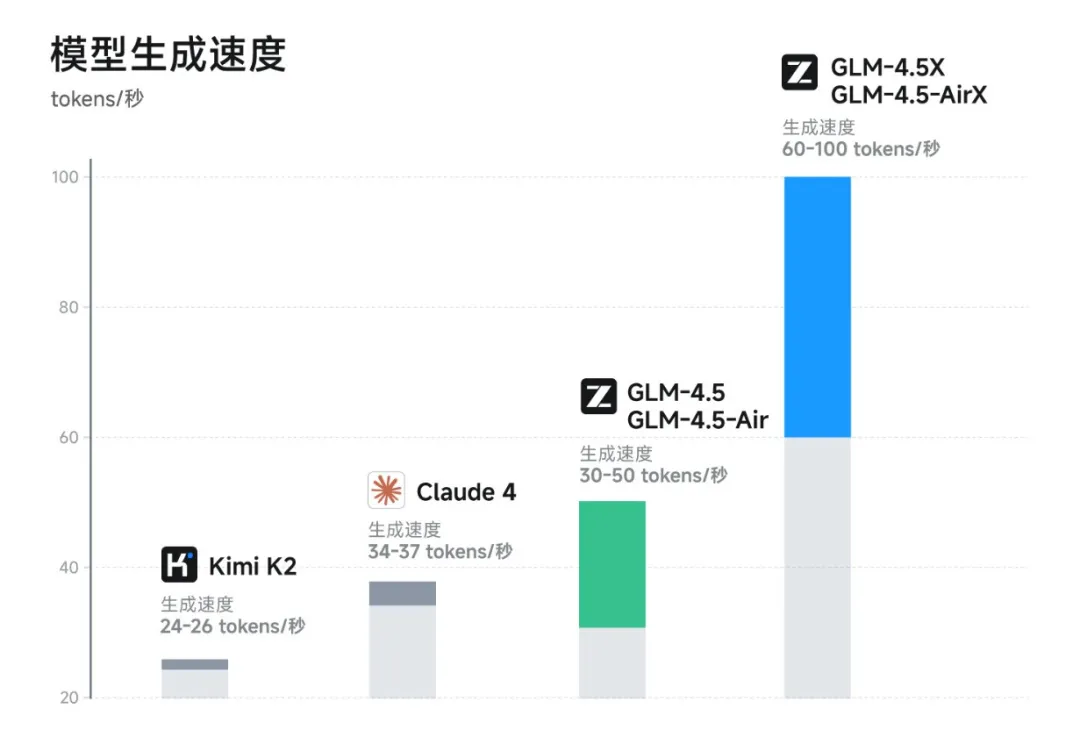

四、成本、速度与开发者接入

GLM-4.5 在性能优化的同时,实现了低成本和高效率。

模型 API 可一键兼容 Claude Code 框架。

智谱官方也为开发者提供了订阅计划,每月 50 元即可无上限调用 GLM-4.5。

资源汇总

我们为开发者整理了以下资源,方便快速上手和集成。

- 在线体验:

- https://chat.z.ai/

- https://chatglm.cn

- 开源仓库:

- GitHub: https://github.com/zai-org/GLM-4.5

- Hugging Face: https://huggingface.co/collections/zai-org/glm-45-687c621d34bda8c9e4bf503b

- ModelScope: https://modelscope.cn/collections/GLM-45-b8693e2a08984f

- 技术文档:

- 技术博客: https://z.ai/blog/glm-4.5

- API 文档 (国内): https://docs.bigmodel.cn/cn/guide/develop/claude

- Agent 轨迹: https://huggingface.co/datasets/zai-org/CC-Bench-trajectories

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)