优化算法之批量大小(batch_size)

批量大小的选择在小批量梯度下降法中,批量大小(Batch Size)对网络优化的影响也非常大.一般而言,批量大小不影响随机梯度的期望,但是会影响随机梯度的方差.批量大小越大,随机梯度的方差越小,引入的噪声也越小,训练也越稳定,因此可以设置较大的学习率.而批量大小较小时,需要设置较小的学习率,否则模型会不收敛.学习率通常要随着批量大小的增大而相应地增大.一个简单有效的方法是线性缩放规则(Linear

批量大小的选择

在小批量梯度下降法中,批量大小(Batch Size)对网络优化的影响也非常大.一般而言,批量大小不影响随机梯度的期望,但是会影响随机梯度的方差.批量大小越大,随机梯度的方差越小,引入的噪声也越小,训练也越稳定,因此可以设置较大的学习率.而批量大小较小时,需要设置较小的学习率,否则模型会不收敛.学习率通常要随着批量大小的增大而相应地增大.一个简单有效的方法是线性缩放规则(Linear Scaling Rule): 当批量大小增加𝑚倍时,学习率也增加𝑚倍.参见习题7-1.线性缩放规则往往在批量大小比较小时适用,当批量大小非常大时,线性缩放会使得训练不稳定.

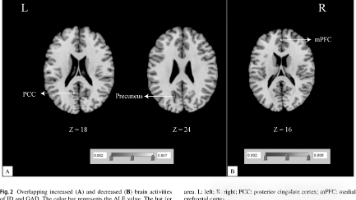

图7.3给出了从回合(Epoch)和迭代(Iteration)的角度,批量大小对损失下降的影响.每一次小批量更新为一次迭代,所有训练集的样本更新一遍为一个回合,两者的关系为

从图7.3a可以看出,批量大小越大,下降效果越明显,并且下降曲线越平滑.但从图7.3b可以看出,如果按整个数据集上的回合(Epoch)数来看,则是批量样本数越小,适当小的批量大小会导致更快的收敛.此外,批量大小和模型的泛化能力也有一定的关系.[Keskar et al.,2016]通过实验发现:批量越大,越有可能收敛到尖锐最小值;批量越小,越有可能收敛到平坦最小值

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)