层归一化 LayerNorm

层归一化 LayerNorm

·

层归一化(Layer Normalization)是深度学习中用于归一化神经网络各层输入的技术

1. 归一化的作用

在神经网络训练中,各层输入数据分布会随训练变化,即“内部协变量偏移”,这会导致训练变慢、模型难以收敛,还可能使梯度消失或爆炸,影响模型性能。归一化可解决这些问题,加速训练收敛,提高模型稳定性和泛化能力。

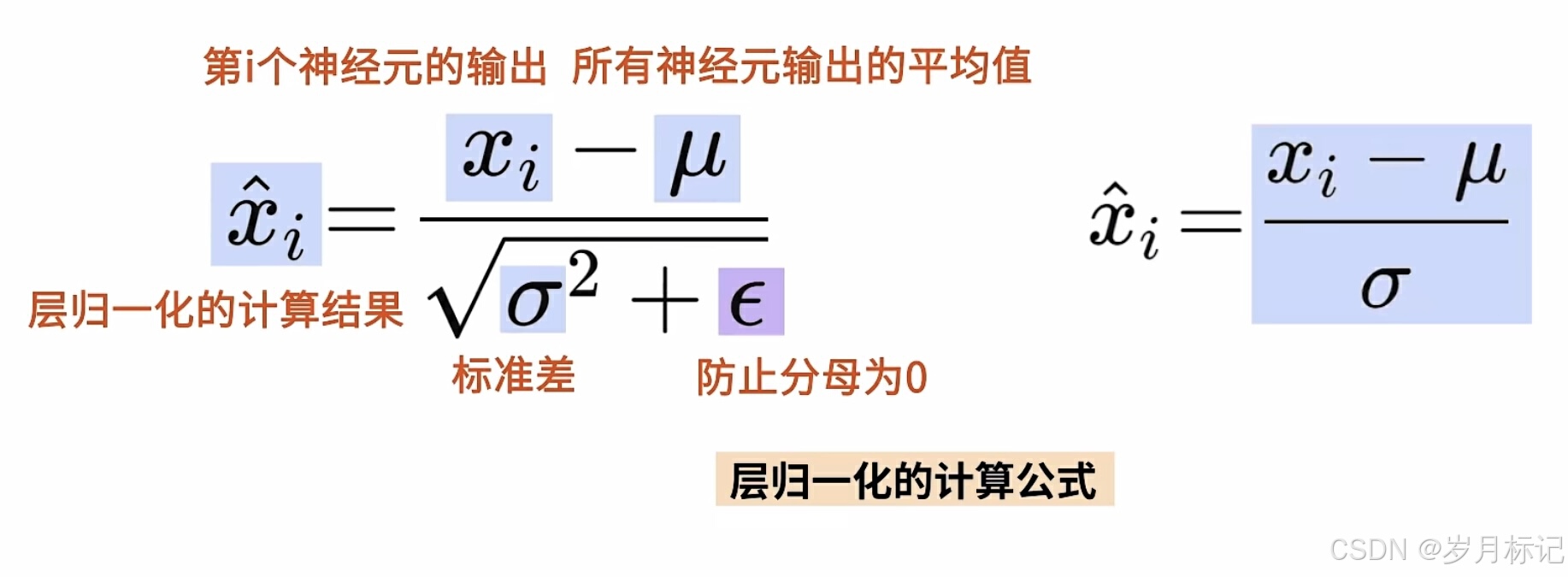

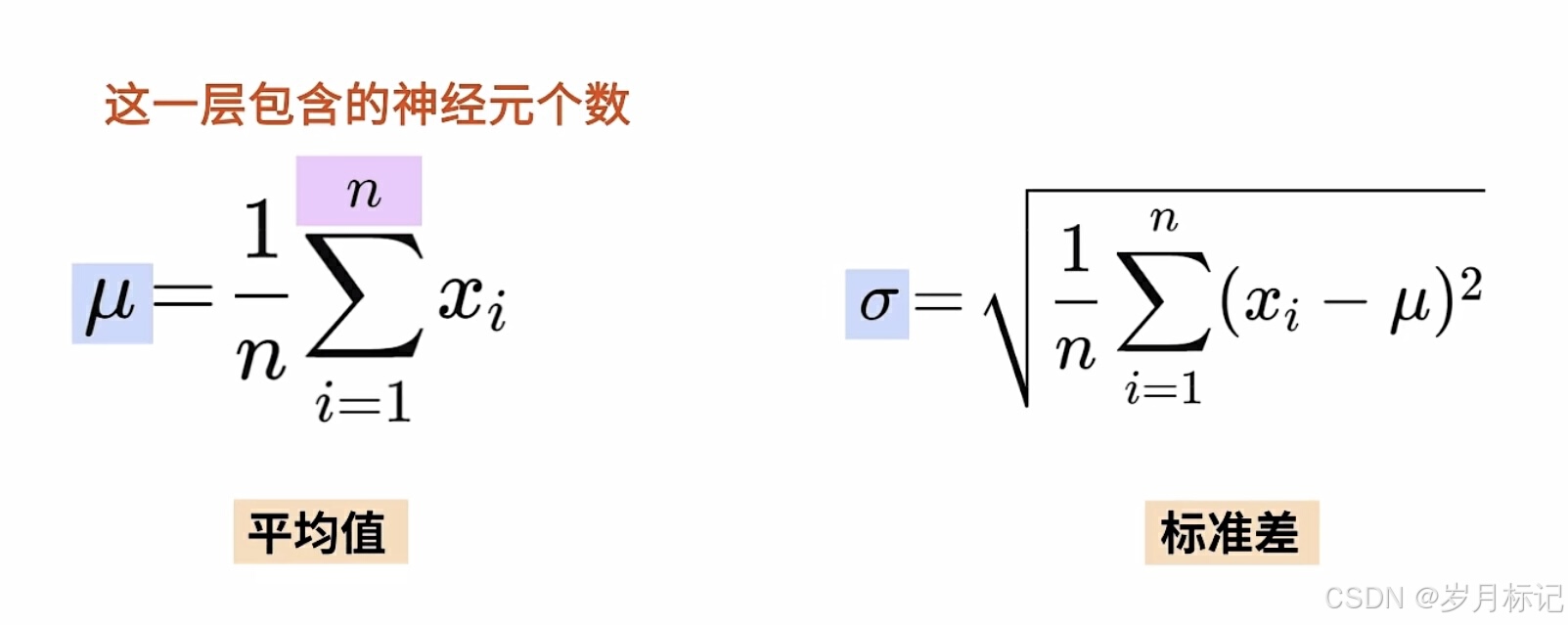

2. 层归一化的计算过程

3. 层归一化与其他归一化方法的区别

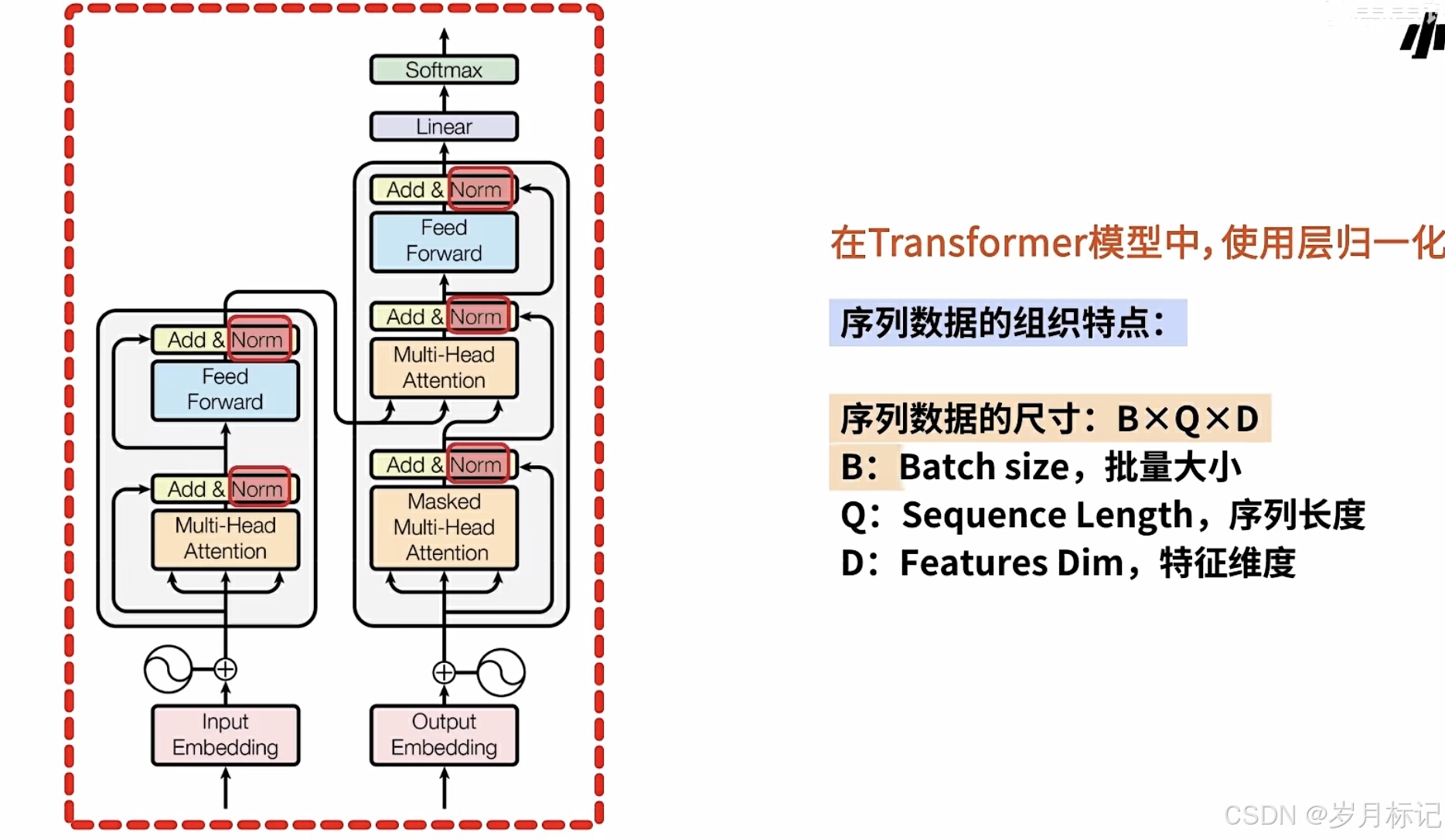

- 归一化维度:与批量归一化(Batch Normalization)对一批数据的同一维度特征归一化不同,层归一化对每个样本的所有维度特征归一化,更适合处理序列数据等。

- 适用场景:层归一化在自然语言处理的循环神经网络(RNN)、长短时记忆网络(LSTM)、Transformer等模型中应用广泛,能有效处理序列中各时间步的输入变化,提高模型对不同长度序列的适应性。

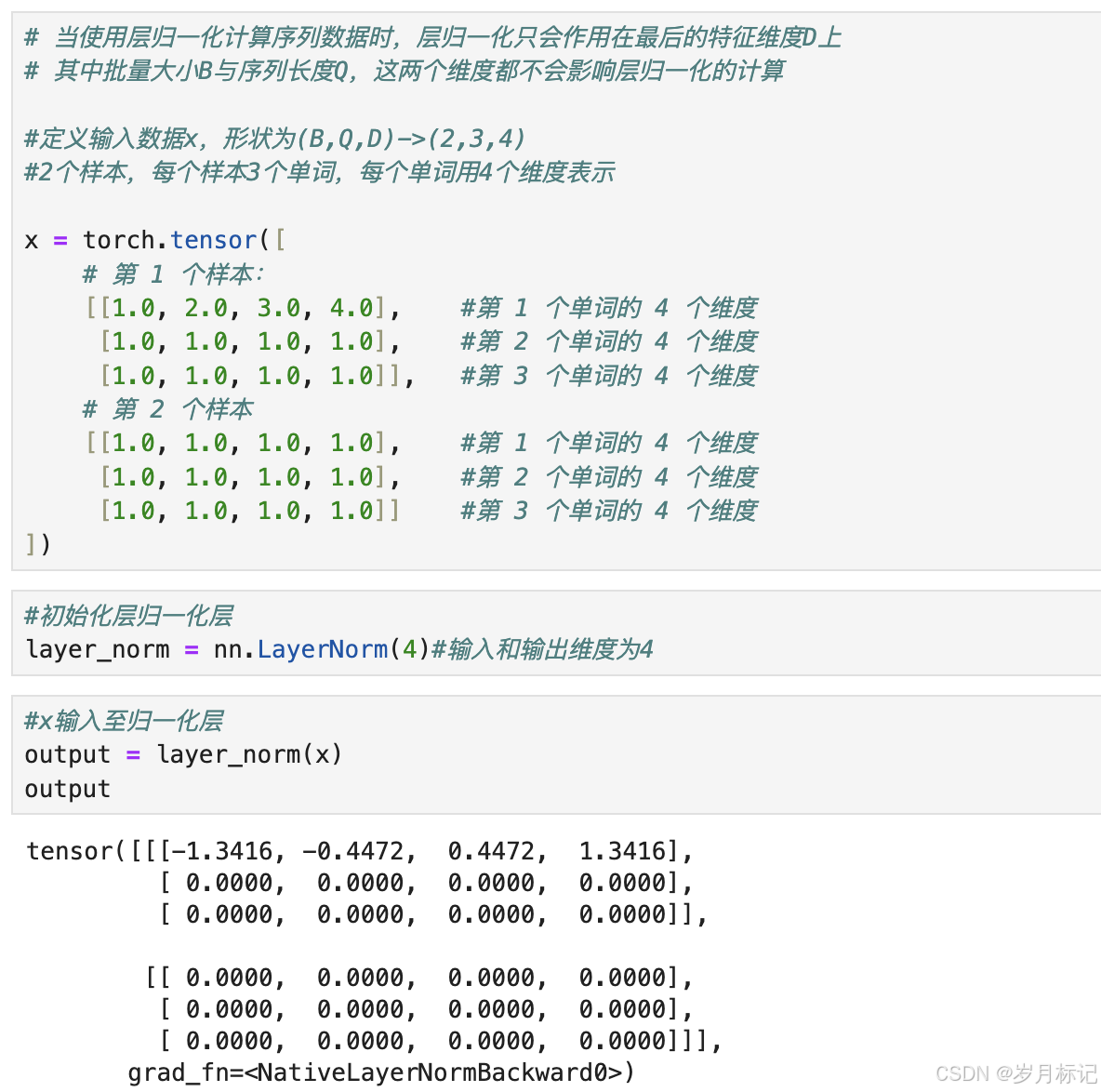

4. 计算举例

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)