【2025最新】大模型入门学习教程(超详细),从零基础入门到精通,看这一篇就够了!

大模型入门学习教程(非常详细)看这一篇就够了!

目录

一、LLM Fundamentals 基础

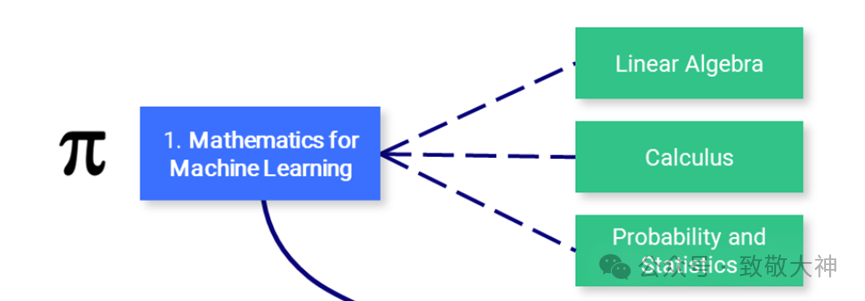

1. 机器学习的数学基础

在掌握机器学习之前,理解支撑这些算法的基本数学概念非常重要。

-

线性代数:这是理解许多算法(特别是深度学习算法)的关键。主要概念包括向量、矩阵、行列式、特征值和特征向量、向量空间以及线性变换。

-

微积分:许多机器学习算法涉及到连续函数的优化,这需要理解导数、积分、极限和级数。多变量微积分以及梯度的概念也很重要。

-

概率论与统计学:这些知识对于理解模型如何从数据中学习并进行预测至关重要。主要概念包括概率理论、随机变量、概率分布、期望、方差、协方差、相关性、假设检验、置信区间、最大似然估计和贝叶斯推断。

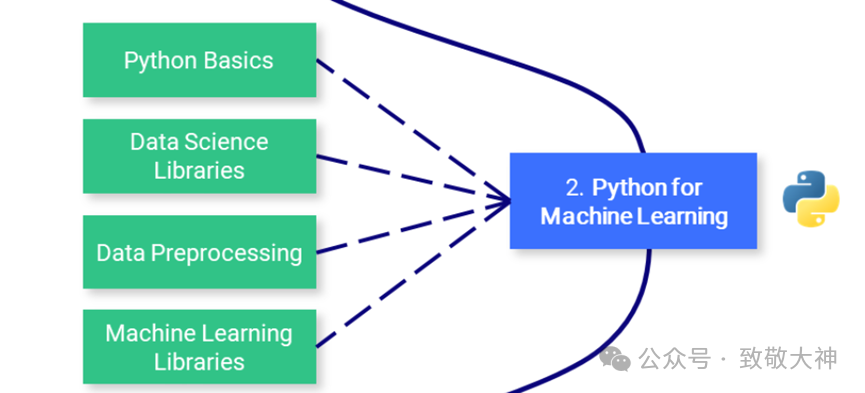

2. 机器学习的 Python

Python 是一种强大且灵活的编程语言,因其可读性、一致性和强大的数据科学库生态系统而特别适合机器学习。

-

Python 基础:掌握 Python 编程需要理解基本语法、数据类型、错误处理和面向对象编程。

-

数据科学库:包括熟悉 NumPy 用于数值计算,Pandas 用于数据操作和分析,以及 Matplotlib 和 Seaborn 用于数据可视化。

-

数据预处理:这包括特征缩放和标准化、处理缺失数据、异常值检测、分类数据编码,以及将数据划分为训练集、验证集和测试集。

-

机器学习库:熟练使用 Scikit-learn 是至关重要的,这个库提供了广泛的有监督和无监督学习算法。理解如何实现线性回归、逻辑回归、决策树、随机森林、K 最近邻(K-NN)和 K-means 聚类等算法也很重要。主成分分析(PCA)和 t-SNE 等降维技术对可视化高维数据也非常有帮助。

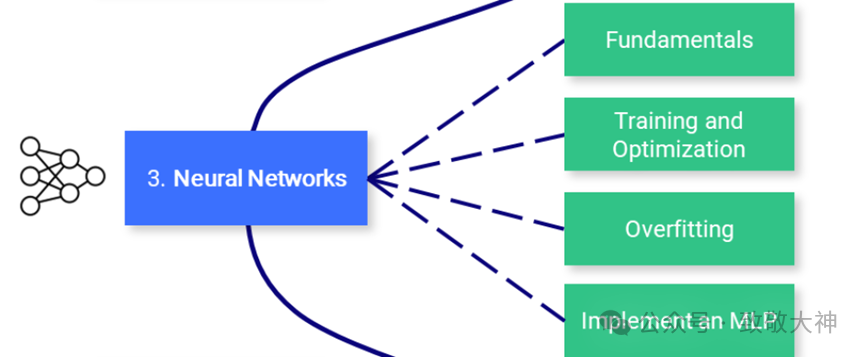

3. 神经网络

神经网络是许多机器学习模型的基础,特别是在深度学习领域。要有效利用神经网络,需要全面理解其设计和机制。

-

基础知识:包括理解神经网络的结构,如层、权重、偏置以及激活函数(如 sigmoid、tanh、ReLU 等)。

-

训练和优化:熟悉反向传播算法以及不同类型的损失函数,如均方误差(MSE)和交叉熵。理解各种优化算法,如梯度下降、随机梯度下降、RMSprop 和 Adam。

-

过拟合:了解过拟合的概念(即模型在训练数据上表现良好但在未见过的数据上表现较差),各种正则化技术(如 dropout、L1/L2 正则化、提前停止、数据增强)以防止过拟合。

-

实现多层感知机(MLP):构建一个多层感知机,也称为全连接网络。

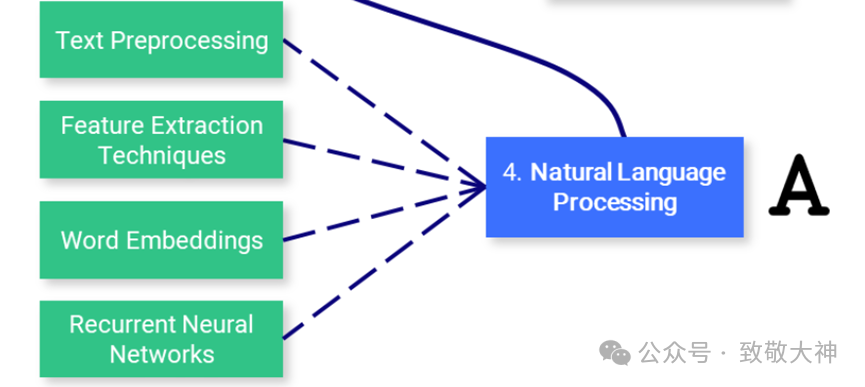

4. 自然语言处理(NLP)

自然语言处理(NLP)是人工智能的一个迷人领域,它弥合了人类语言与机器理解之间的差距。从简单的文本处理到理解语言细微差别,NLP 在翻译、情感分析、聊天机器人等许多应用中扮演了关键角色。

-

文本预处理:学习各种文本预处理步骤,如分词(将文本拆分为单词或句子)、词干提取(将单词还原为其根形)、词形还原(类似于词干提取,但考虑上下文)、停用词去除等。

-

特征提取技术:熟悉将文本数据转换为机器学习算法可以理解的格式的方法。关键方法包括词袋模型(BoW)、词频-逆文档频率(TF-IDF)和 n-grams。

-

词嵌入:词嵌入是一种词语表示方法,它允许具有相似含义的词具有相似的表示。关键方法包括 Word2Vec、GloVe 和 FastText。

-

递归神经网络(RNNs):理解 RNNs 的工作原理,这是一种设计用于处理序列数据的神经网络。探索 LSTM 和 GRU,这两种 RNN 变体能够学习长期依赖关系。

二、LLM Scientist 科学家

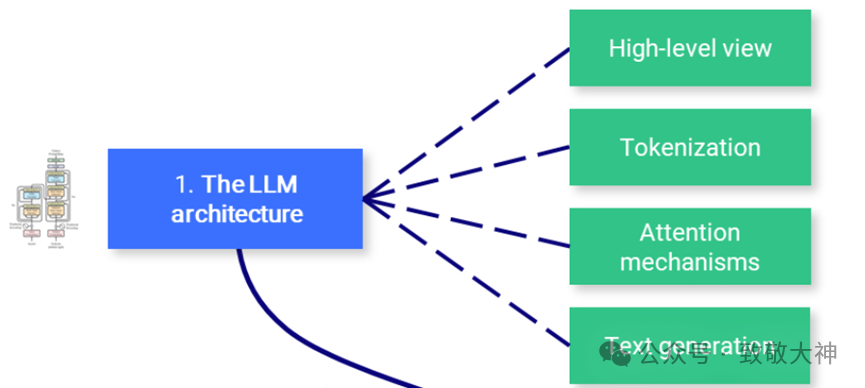

1. 大型语言模型(LLM)架构

虽然对 Transformer 架构的深入理解不是必须的,但了解其输入(tokens)和输出(logits)是非常重要的。原始的注意力机制是另一个关键组件,因为后续版本中引入了改进的版本。

-

高层次视角:重新审视编码器-解码器 Transformer 架构,特别是仅解码器的 GPT 架构,这在现代大型语言模型中广泛使用。

-

分词:理解如何将原始文本数据转换为模型可以理解的格式,这涉及将文本拆分为 tokens(通常是单词或子词)。

-

注意力机制:掌握注意力机制的理论,包括自注意力和缩放点积注意力,这使得模型在生成输出时能够关注输入的不同部分。

-

文本生成:了解模型生成输出序列的不同方式。常见的策略包括贪婪解码、束搜索(beam search)、top-k 采样和核采样(nucleus sampling)。

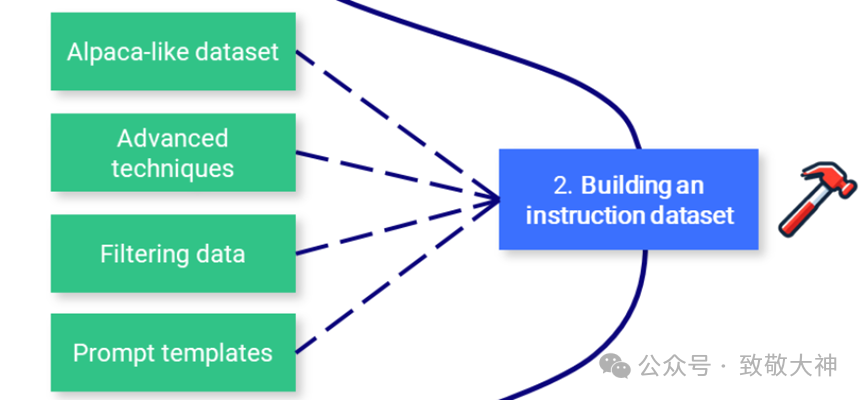

2. 构建指令数据集

虽然从维基百科和其他网站获取原始数据很容易,但在自然环境中收集指令和答案的配对却很困难。正如在传统机器学习中一样,数据集的质量将直接影响模型的质量,因此它可能是微调过程中最重要的组成部分。

-

Alpaca-类似数据集:使用 OpenAI API(GPT)从零生成合成数据。您可以指定种子和系统提示,以创建多样化的数据集。

-

高级技术:学习如何使用 Evol-Instruct 改进现有数据集,如何生成高质量的合成数据,如在 Orca 和 phi-1 论文中所述。

-

数据过滤:传统技术包括正则表达式(regex)、删除近似重复项、关注具有较高 token 数量的答案等。

-

提示模板:没有真正标准的指令和答案格式,因此了解不同的聊天模板(如 ChatML、Alpaca 等)是重要的。

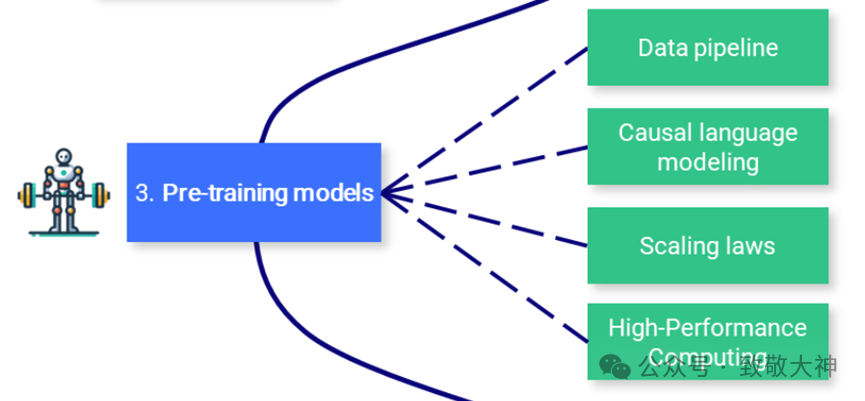

3. 预训练模型

预训练是一个非常漫长且昂贵的过程。了解预训练过程中发生的事情是有益的,但不需要实际操作经验。

-

数据管道:预训练需要巨大的数据集(例如,Llama 2 在 2 万亿 tokens 上进行了训练),这些数据需要经过过滤、分词,并与预定义的词汇表进行整理。

-

因果语言建模:了解因果语言建模与掩码语言建模的区别,以及在这种情况下使用的损失函数。为了高效的预训练,深入了解 Megatron-LM 或 gpt-neox。

-

规模定律:规模定律 描述了模型性能如何随着模型大小、数据集大小和训练所用计算量的变化而变化。

-

高性能计算:此处不涉及,但如果您计划从头开始创建自己的大型语言模型,了解 HPC(硬件、分布式工作负载等)是基础知识。

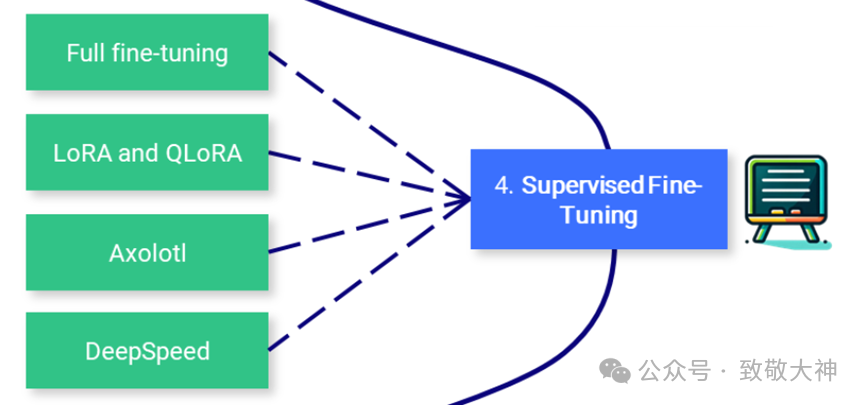

4. 监督微调

预训练模型仅在下一个 token 预测任务上进行训练,这使得它们在处理指令时并不是特别有用。监督微调(SFT)可以调整它们以响应指令。此外,它还允许您在任何数据上(如私有数据或未见过的数据)对模型进行微调,并在不需要支付如 OpenAI API 的费用的情况下使用它。

-

全面微调:全面微调指的是训练模型中的所有参数。这是一种效率较低的技术,但能够产生略好的结果。

-

LoRA:一种基于低秩适配器的参数高效技术(PEFT)。它不是训练所有参数,而是仅训练这些适配器。

-

QLoRA:另一种基于 LoRA 的 PEFT 技术,它将模型的权重量化为 4 位,并引入分页优化器以管理内存峰值。结合 Unsloth 使用,可以在免费的 Colab 笔记本上高效运行。

-

Axolotl:一个用户友好且功能强大的微调工具,被许多最先进的开源模型使用。

-

DeepSpeed:针对多 GPU 和多节点设置的高效预训练和微调工具(在 Axolotl 中实现)。

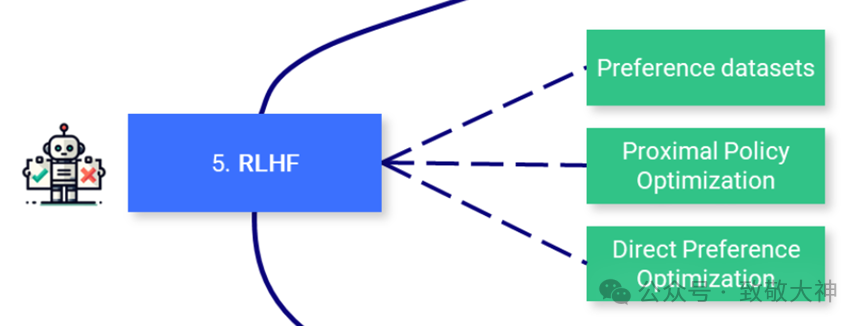

5. 偏好对齐

在监督微调之后,强化学习从人类反馈(RLHF)是用于将大型语言模型(LLM)的回答与人类期望对齐的步骤。其核心思想是通过从人类(或人工)反馈中学习偏好,以减少偏见、审查模型或使其更有用。这比 SFT 更复杂,通常被视为可选步骤。

-

偏好数据集:这些数据集通常包含若干个带有某种排序的答案,因此比指令数据集更难生成。

-

近端策略优化(PPO):该算法利用一个奖励模型来预测给定文本是否被人类高度评价。然后,使用这个预测来优化 SFT 模型,并根据 KL 散度施加惩罚。

-

直接偏好优化(DPO):DPO 通过将问题重新表述为分类问题来简化过程。它使用参考模型而不是奖励模型(无需训练),并且只需要一个超参数,使其更加稳定和高效。

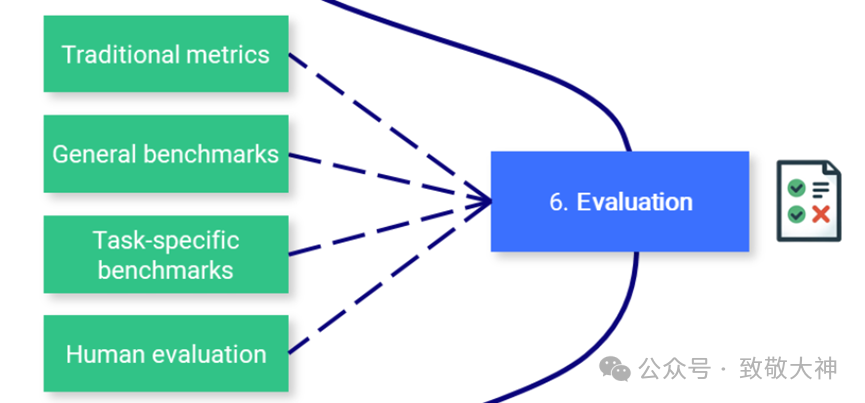

6. 评估

评估大型语言模型(LLM)是管道中一个被低估的部分,这一过程既耗时又具有一定的可靠性。您的下游任务应决定您需要评估的内容,但始终记住 Goodhart 定律:“当一个度量成为目标时,它不再是一个好的度量。”

-

传统指标:像困惑度(Perplexity)和 BLEU 分数这样的指标现在不如以前流行,因为它们在大多数情况下存在缺陷。尽管如此,理解这些指标以及它们的适用场景仍然很重要。

-

通用基准:基于 语言模型评估工具包(Language Model Evaluation Harness),Open LLM Leaderboard 是通用 LLM(如 ChatGPT)的主要基准。还有其他流行的基准,如 BigBench、MT-Bench 等。

-

任务特定基准:诸如摘要生成、翻译和问答等任务具有专门的基准、指标,甚至子领域(如医学、金融等),例如用于生物医学问答的 PubMedQA。

-

人工评估:最可靠的评估是用户的接受率或人类的比较。除了聊天记录之外,记录用户反馈(例如使用 LangSmith)有助于识别潜在的改进领域。

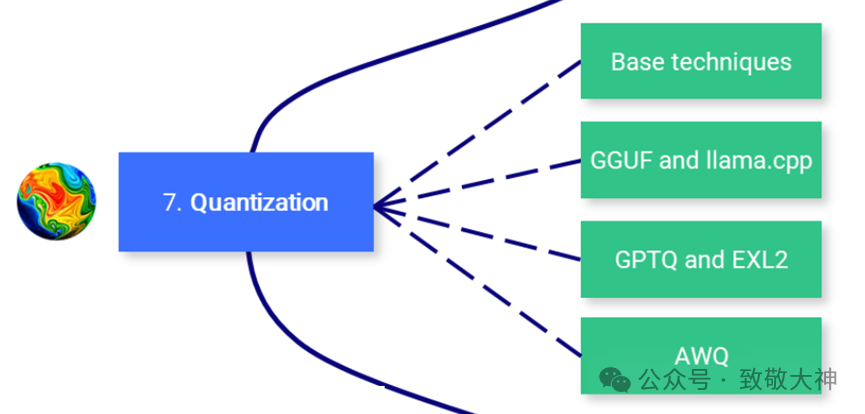

7. 量化

量化是将模型的权重(和激活值)转换为更低精度的过程。例如,将使用 16 位存储的权重转换为 4 位表示。这个技术在减少大型语言模型(LLM)的计算和内存成本方面变得越来越重要。

-

基础技术:学习不同的精度级别(如 FP32、FP16、INT8 等)以及如何使用 absmax 和零点技术进行简单的量化。

-

GGUF 和 llama.cpp:最初设计用于在 CPU 上运行,llama.cpp 和 GGUF 格式已成为在消费级硬件上运行 LLM 的最受欢迎的工具。

-

GPTQ 和 EXL2:GPTQ 和更具体的 EXL2 格式提供了极快的速度,但只能在 GPU 上运行。模型的量化过程也需要较长时间。

-

AWQ:这种新格式比 GPTQ 更准确(困惑度更低),但使用了更多的 VRAM,且不一定更快。

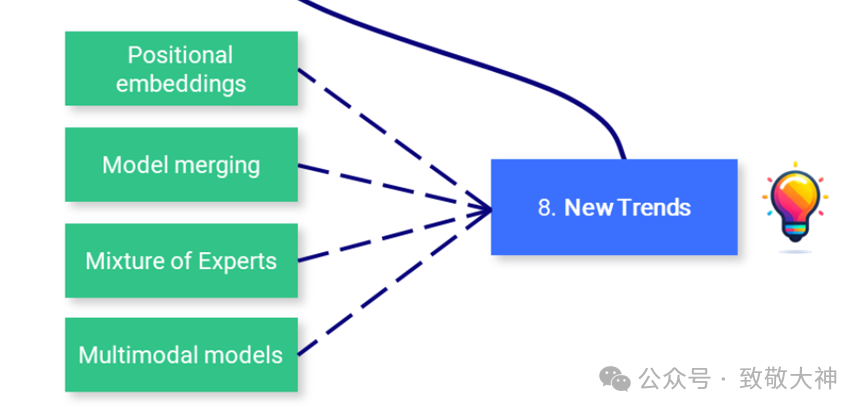

8. 新趋势

一些新的发展趋势。

-

位置嵌入:了解大型语言模型(LLM)如何编码位置,特别是像 RoPE 这样的相对位置编码方案。实现 YaRN(将注意力矩阵乘以温度因子)或 ALiBi(基于 token 距离的注意力惩罚)来扩展上下文长度。

-

模型合并:合并训练好的模型已成为创建高性能模型的一种流行方法,无需进行微调。流行的 mergekit 库实现了最受欢迎的合并方法,如 SLERP、DARE 和 TIES。

-

专家混合:由于其优异的性能,Mixtral 使 MoE 架构重新流行。与此同时,OSS 社区中出现了一种 frankenMoE 类型,通过合并模型如 Phixtral 提供了更便宜且性能良好的选择。

-

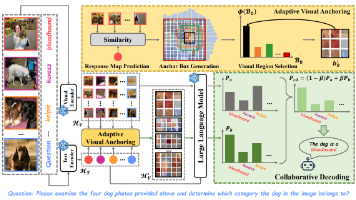

多模态模型:这些模型(如 CLIP、Stable Diffusion 或 LLaVA)可以处理多种类型的输入(文本、图像、音频等),并使用统一的嵌入空间,这解锁了如文本到图像等强大的应用。

三、LLM Engineer 工程师

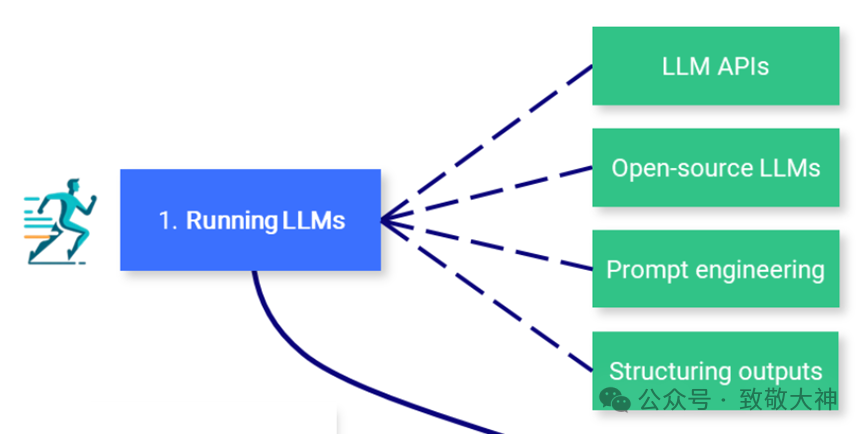

1. 运行大型语言模型(LLMs)

由于硬件要求高,运行大型语言模型可能会很困难。根据您的使用案例,您可能希望通过 API(如 GPT-4)来简单地使用模型,或在本地运行它。在任何情况下,提示和指导技术可以改善和约束您的应用输出。

-

LLM API:API 是部署 LLM 的一种方便方式。这个领域分为私人 LLM(如 OpenAI、Google、Anthropic、Cohere 等)和开源 LLM(如 OpenRouter、Hugging Face、Together AI 等)。

-

开源 LLM:可以在 Hugging Face Hub 上找到 LLM。您可以直接在 Hugging Face Spaces 中运行其中一些,或通过像 LM Studio 这样的应用程序本地下载并运行,或通过 CLI 使用 llama.cpp 或 Ollama。

-

提示工程:常见的技术包括零样本提示、少样本提示、思维链和 ReAct。这些技术在更大的模型中效果更好,但也可以调整用于较小的模型。

-

结构化输出:许多任务需要结构化输出,如严格的模板或 JSON 格式。可以使用像 LMQL、Outlines、Guidance 等库来指导生成并遵循给定的结构。

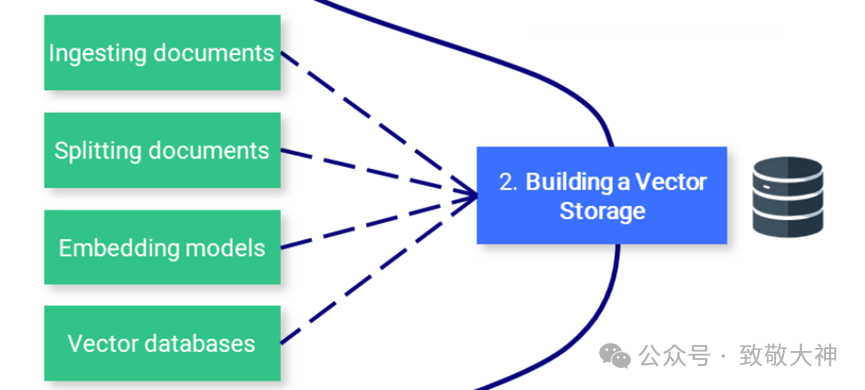

2. 构建向量存储

创建向量存储是构建检索增强生成(RAG)管道的第一步。文档被加载、拆分,并且相关的块被用来生成向量表示(嵌入),这些向量会被存储以便在推理过程中使用。

-

文档导入:文档加载器是处理多种格式的便利工具,包括 PDF、JSON、HTML、Markdown 等。它们还可以直接从一些数据库和 API(如 GitHub、Reddit、Google Drive 等)中检索数据。

-

拆分文档:文本拆分器将文档分解为较小且语义上有意义的块。与其在 n 个字符后拆分文本,不如按标题拆分或递归拆分,并附加一些额外的元数据。

-

嵌入模型:嵌入模型将文本转换为向量表示。这允许对语言进行更深层次和更细致的理解,这是执行语义搜索所必需的。

-

向量数据库:向量数据库(如 Chroma、Pinecone、Milvus、FAISS、Annoy 等)专门用于存储嵌入向量。它们可以根据向量相似性高效地检索与查询“最相似”的数据。

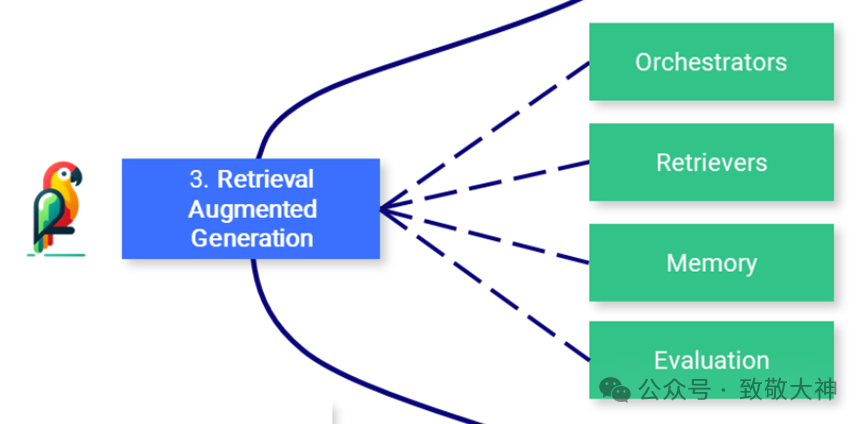

3. 检索增强生成(RAG)

通过 RAG,大型语言模型(LLM)从数据库中检索上下文文档,以提高答案的准确性。RAG 是增强模型知识的一种流行方法,无需进行微调。

-

协调器:协调器(如 LangChain、LlamaIndex、FastRAG 等)是将 LLM 连接到工具、数据库、记忆等的流行框架,并增强其能力。Zlai也是属于这里。

-

检索器:用户指令通常没有针对检索进行优化。可以应用不同的技术(例如,多查询检索器、HyDE 等)来重新措辞/扩展它们,并提高性能。

-

记忆:为了记住先前的指令和回答,LLM 和像 ChatGPT 这样的聊天机器人将这些历史信息添加到上下文窗口中。可以通过总结(例如,使用较小的 LLM)、向量存储 + RAG 等方法来改进这个缓冲区。

-

评估:我们需要评估文档检索(上下文精确度和召回率)和生成阶段(答案的准确性和相关性)。可以使用 Ragas 和 DeepEval 等工具简化评估过程。

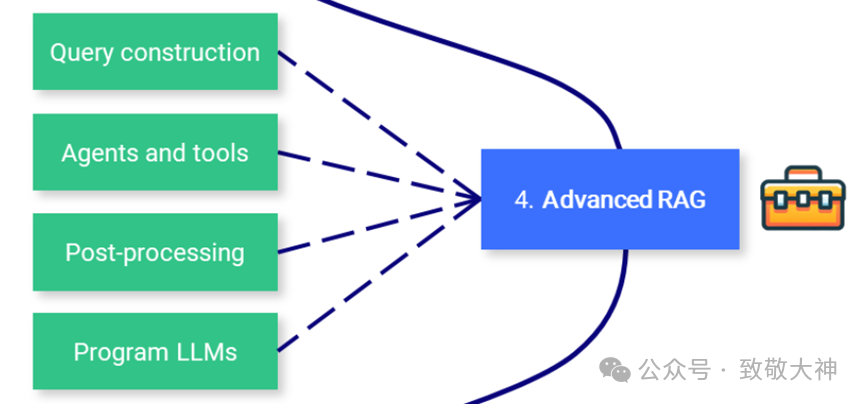

4. 高级 RAG

现实应用可能需要复杂的管道,包括 SQL 或图数据库,以及自动选择相关工具和 API。这些高级技术可以改进基础解决方案并提供额外功能。

-

查询构造:存储在传统数据库中的结构化数据需要特定的查询语言,如 SQL、Cypher、元数据等。我们可以直接将用户指令转换为查询,以通过查询构造访问数据。

-

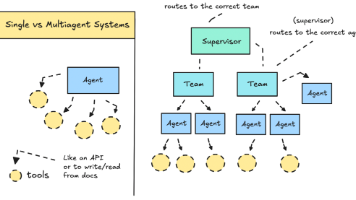

代理和工具:代理通过自动选择最相关的工具来增强 LLM。这些工具可以像使用 Google 或 Wikipedia 这样简单,也可以像 Python 解释器或 Jira 这样复杂。

-

后处理:最后一步处理输入的数据,这些数据被送入 LLM。通过重新排序、RAG-fusion 和分类等方法,增强检索文档的相关性和多样性。

-

编程 LLM:像 DSPy 这样的框架允许您基于自动评估以编程方式优化提示和权重。

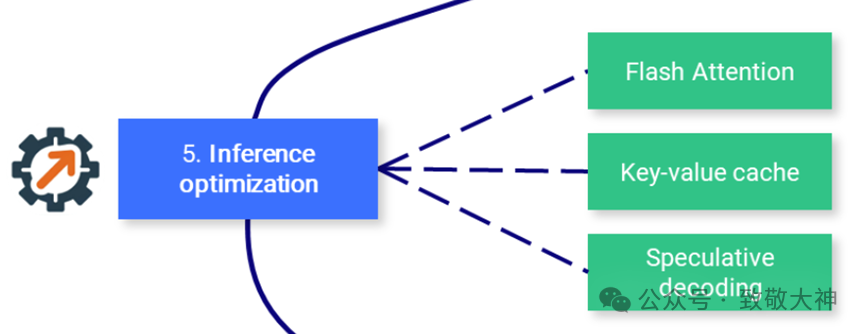

5. 推理优化

文本生成是一个成本高昂的过程,需要昂贵的硬件。除了量化之外,还有各种技术被提出,以最大化吞吐量并降低推理成本。

-

闪电注意力(Flash Attention):优化注意力机制,将其复杂度从平方级别降低到线性级别,从而加快训练和推理速度。

-

键值缓存(Key-value cache):了解键值缓存以及 多查询注意力(Multi-Query Attention,MQA) 和 分组查询注意力(Grouped-Query Attention,GQA) 中引入的改进。

-

推测解码(Speculative decoding):使用一个小模型生成草稿,然后由更大的模型进行审查,以加速文本生成。

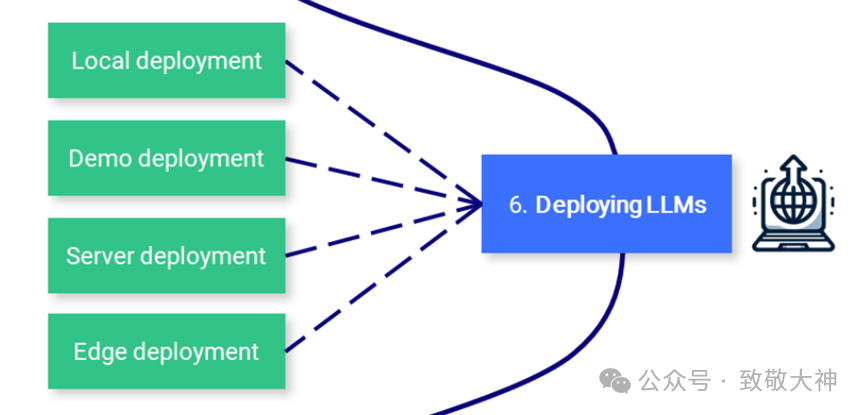

6. 部署 LLM

在大规模部署 LLM 是一项工程壮举,可能需要多个 GPU 集群。在其他场景下,演示和本地应用可以用更低的复杂度实现。

-

本地部署:隐私是开源 LLM 相较于私有 LLM 的一个重要优势。本地 LLM 服务器(如 LM Studio、Ollama、oobabooga、kobold.cpp 等)利用这一优势为本地应用提供支持。

-

演示部署:像 Gradio 和 Streamlit 这样的框架有助于原型设计和分享演示。你也可以轻松地在线托管这些应用,例如使用 Hugging Face Spaces。

-

服务器部署:大规模部署 LLM 需要云服务(参见 SkyPilot)或本地基础设施,通常利用优化的文本生成框架,如 TGI、vLLM 等。

-

边缘部署:在受限环境中,像 MLC LLM 和 mnn-llm 这样的高性能框架可以将 LLM 部署在网页浏览器、Android 和 iOS 上。

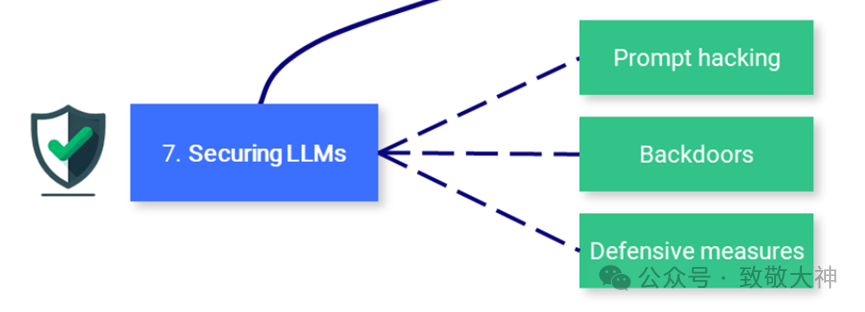

7. 安全性 LLM

除了传统的软件安全问题外,LLM 由于其训练和提示方式,还存在独特的弱点。

-

提示攻击:与提示工程相关的不同技术,包括提示注入(附加指令以劫持模型的回答)、数据/提示泄露(检索其原始数据/提示)和越狱(构造提示以绕过安全功能)。

-

后门:攻击向量可以针对训练数据本身,例如通过毒化训练数据(例如,添加虚假信息)或创建后门(秘密触发器,以在推理过程中改变模型的行为)。

-

防御措施:保护 LLM 应用的最佳方法是针对这些漏洞进行测试(例如,使用红队和检查工具如 garak),并在生产环境中监控它们(使用像 langfuse 这样的框架)。

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

大模型学习资料:CSDN大礼包:《大模型入门&进阶学习资源包》免费分享

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

大模型学习资料:CSDN大礼包:《大模型入门&进阶学习资源包》免费分享

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

大模型学习资料:CSDN大礼包:《大模型入门&进阶学习资源包》免费分享

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

大模型学习资料:CSDN大礼包:《大模型入门&进阶学习资源包》免费分享

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)