2025年Pytorch-gpu版本安装(各种情况适用自己的安装需求,亲测绝对有效,示例安装torch2.6.0,过程详细面向小白)

2025年最新的Pytorch-gpu版本安装,满足各种安装需求同时对torch2.6.0版本进行安装,完全面向小白,过程详细。

我在上一篇博客中分析了一些安装Tensorflow-gpu版本的各种问题与心得,大家可以参考Tensorflow-gpu安装问题与心得,最终得出了结论,将代码重构成Pytorch-gpu可以有效的解决环境配置的各种问题,Pytorch的安装非常简单,只需要命令行就可以实现,不需要手动安装cuda与cudnn包,可以真正的实现用conda创建隔离的虚拟环境,因此,我写了一期关于如何安装Pytorch-gpu版本的安装教程。

目录

二.实例安装torch2.6.0+cuda11.8+python3.10

0.安装前引言

大家在开始安装Pytorch-gpu前,建议安装Anaconda与pycharm,具体的安装过程我会在后续的文章中做出教程,这一篇文章默认大家已经有了一些基础,只需要按照pytorch-gpu来调用显卡加速训练。

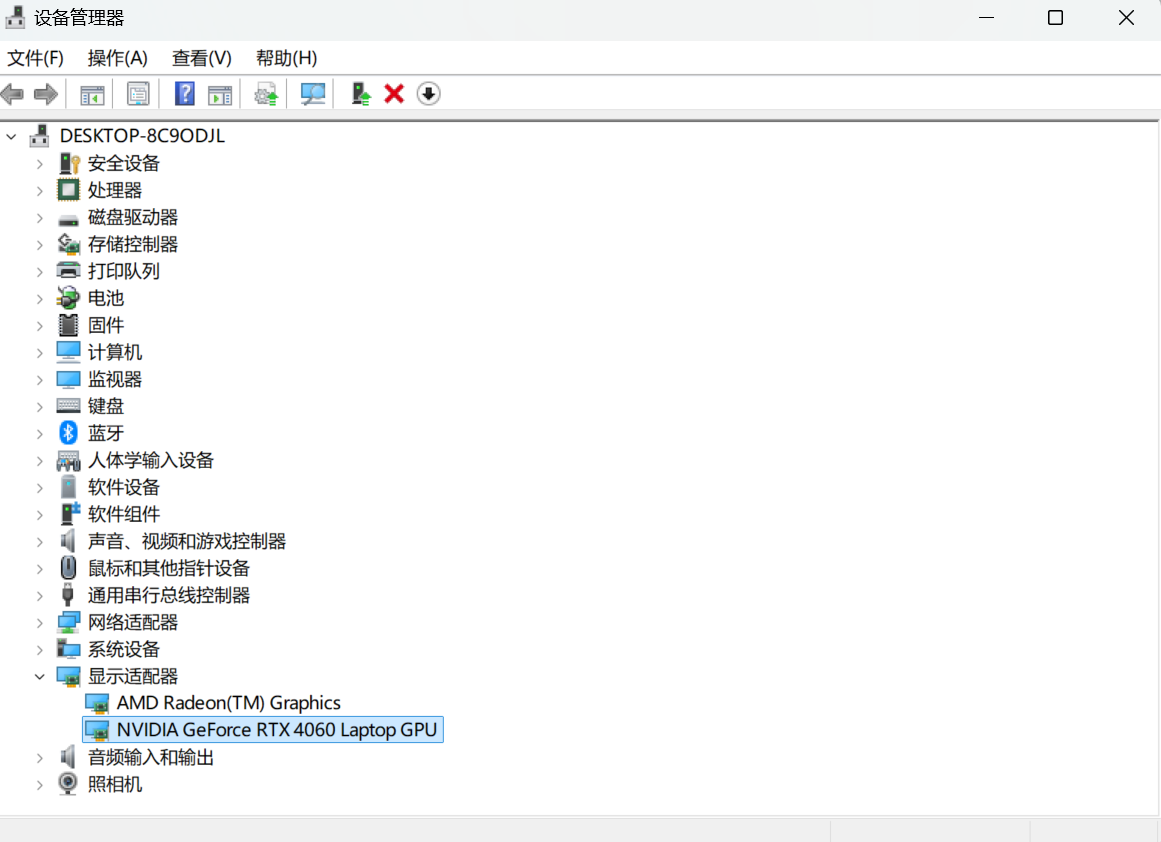

(1)查看显卡支持

首先,打开设备管理器来查看自己的显卡是不是NVIDIA英伟达显卡,对于大部分用户来说应该都是满足的,如果不是那就使用cpu版本的pytorch。

(2)查看显卡驱动最高支持版本

其次,查看电脑的显卡驱动版本,安装Windows系统时一般都会自动安装的,如果很低可以直接到NVIDIA官网下载更新一下。

同时按住win+R打开命令窗口,输入cmd,在终端输入一下命令来查看显卡驱动版本。

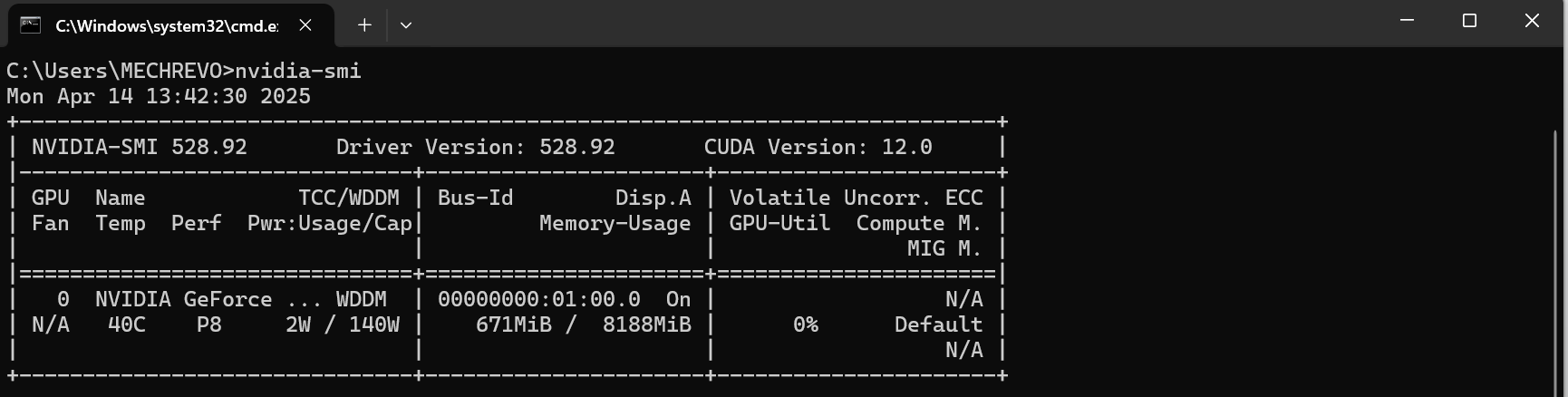

nvidia-smi

可以看到CUDA Version是12.0,说明我可以下载的CUDA版本要低于12.0即可,CUDA和CUDNN就是调用GPU需要用到的工具,安装Pytorch-gpu版本时直接用命令行就可以一起安装,无需手动安装。

一.安装合适的Pytorch-gpu版本

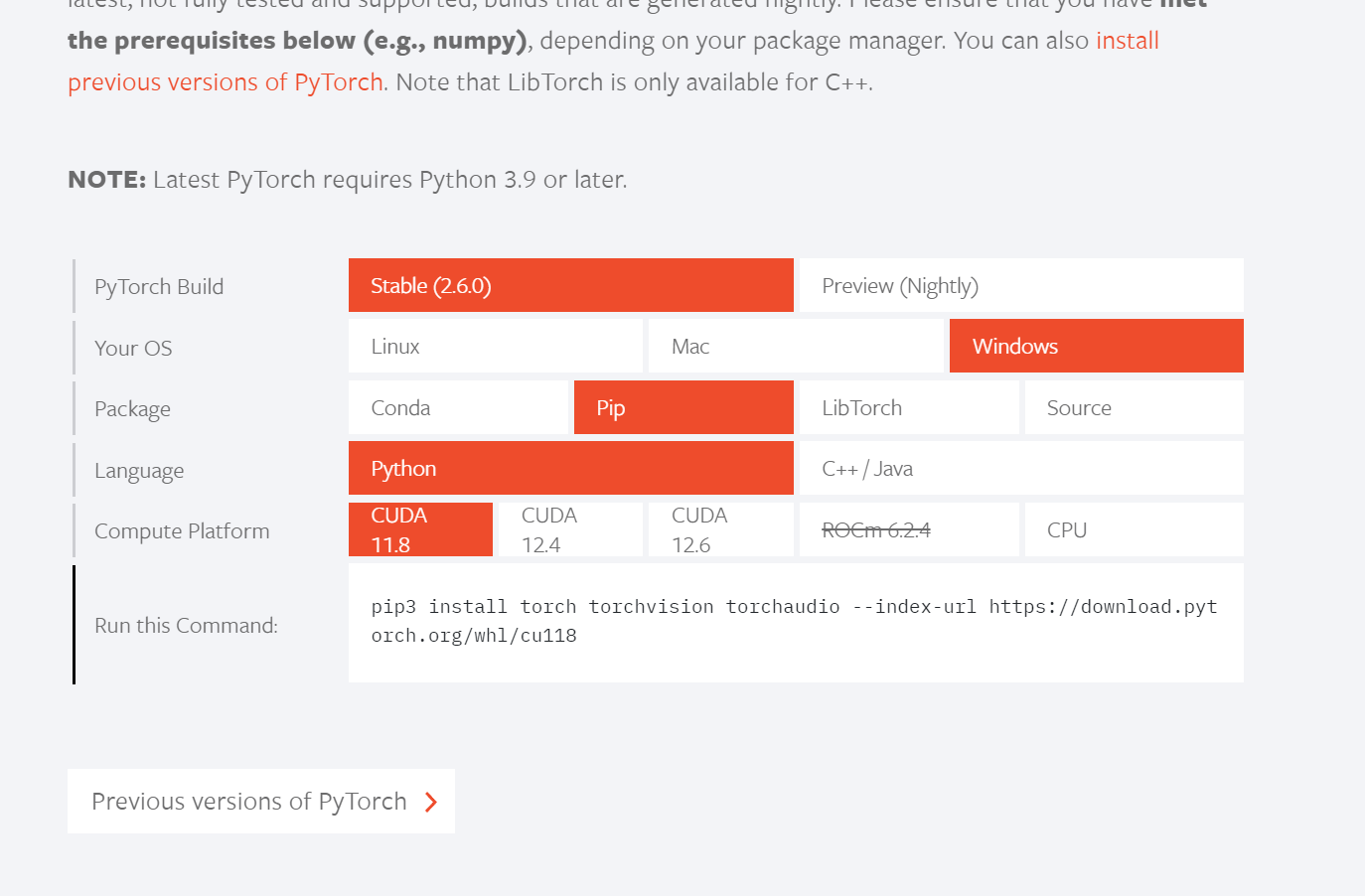

不论是安装gpu版本还是cpu版本,都可以进入官网pytroch官网,下拉可以看到安装的需求与命令。

这里一定要注意,这是最新版的pytroch,可以看到Pytroch Build有稳定版和先测版,稳定版是2.6.0且NOTE是需要至少3.9的python版本的,下面的分别对应着操作系统、编程语言、CUDA版本,如果只需要cpu版本只需要将Compute Platform换成CPU即可用命令行下载,大家根据自己的代码来选择版本,如果需要安装之前的pytorch版本,可以进入下面的Previous versions of PyTorch。

可以一直往下寻找自己适配的版本,不论是CUDA还是cpu版本都有对应的命令来直接下载(建议安装conda,直接创建虚拟环境来下载)。

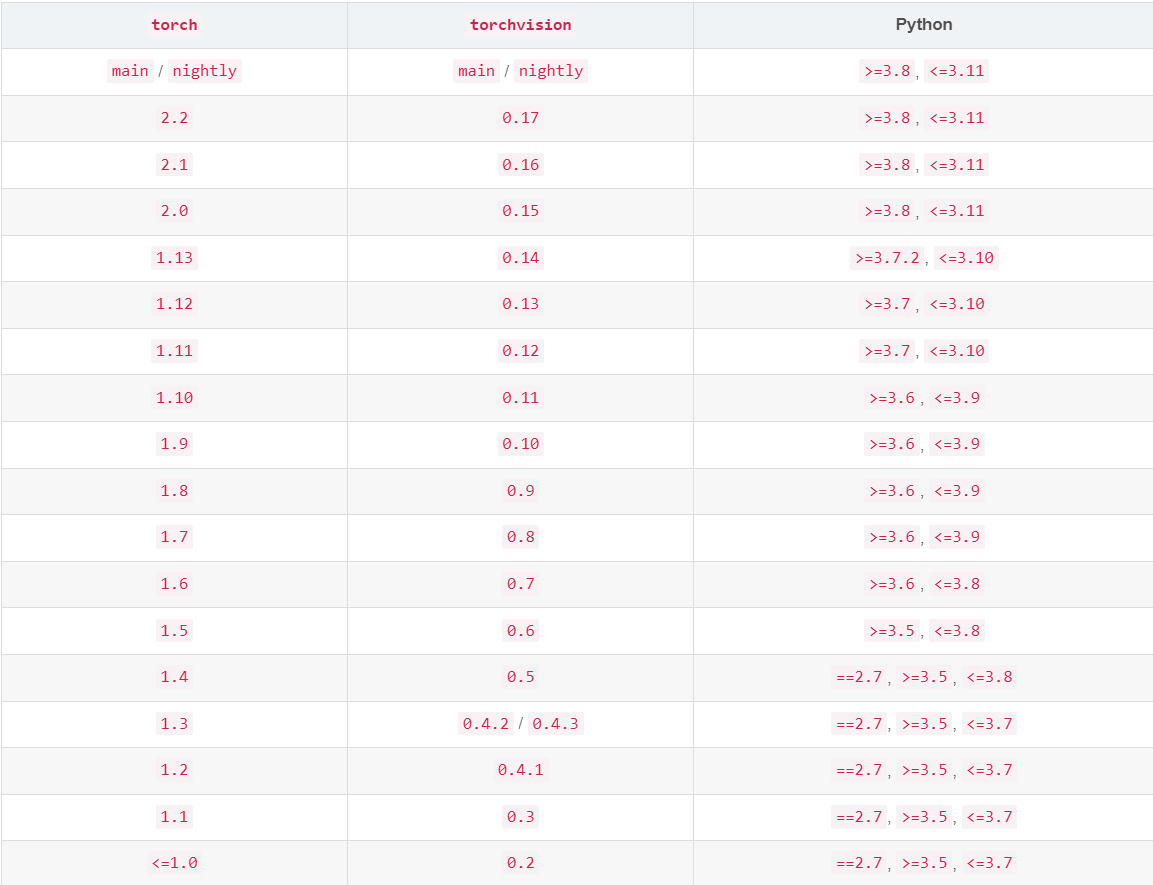

在下载前,如果是使用conda虚拟环境,需要先创建虚拟环境,那么要按照的pytorch与python版本对应就需要先确认一下(要先创建虚拟python环境,激活后在按照pytorch,当然直接在本机python环境安装也要对应一下python版本)。

下表来自Pytorch在Github官方版本表,需要对应torch与python环境的兼容。

在确认了需要安装的python版本与torch时,就可以创建虚拟环境了,大家可以参考我第一篇的文章conda创建虚拟环境,激活虚拟环境后,就可以在终端直接输入官方复制的命令来下载torch了。如果直接在本机环境安装torch直接在cmd中输入命令即可。

二.实例安装torch2.6.0+cuda11.8+python3.10

在明白了整个的安装过程后,我们可以争对自己需要安装的torc版本来搭建环境了,我在这里举例了我的安装步骤,即torch2.6.0+cuda11.8+python3.10的环境。

首先,查看对应表确保torch与python环境是兼容的,其次创建conda虚拟环境。

conda create -n t26 python==3.10激活环境后来安装torch。

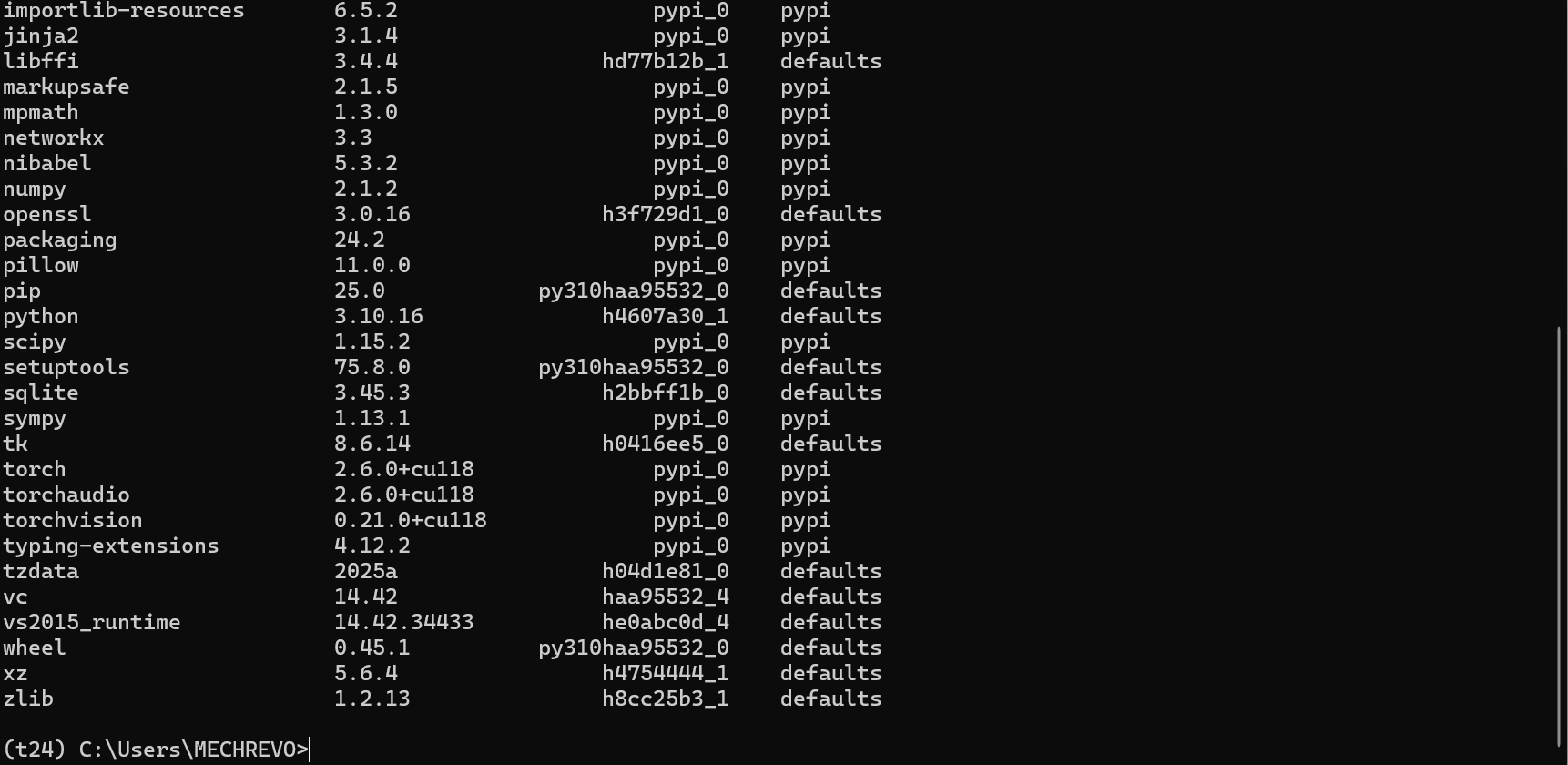

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118在些许等待后就安装完成了,输入以下命令来查看已安装的包。

conda list

可以看到已经安装成功了,接下来需要测试GPU是否可用了。

三.验证GPU是非可用

大家可以在pycharm中导入环境来验证,也可以在激活环境下输入python来直接输入代码来验证,这种方法都是一样的,这里建议用pycharm导入环境来验证(早晚要导入的,有问题了删除再次创建虚拟环境即可)。

import torch

import time

from torch import autograd

#GPU加速

print(torch.__version__)

print(torch.cuda.is_available())

a=torch.randn(10000,1000)

b=torch.randn(1000,10000)

print(a)

print(b)

t0=time.time()

c=torch.matmul(a,b)

t1=time.time()

print(a.device,t1-t0,c.norm(2))

device=torch.device('cuda')

print(device)

a=a.to(device)

b=b.to(device)

t0=time.time()

c=torch.matmul(a,b)

t2=time.time()

print(a.device,t2-t0,c.norm(2))

t0=time.time()

c=torch.matmul(a,b)

t2=time.time()

print(a.device,t2-t0,c.norm(2))

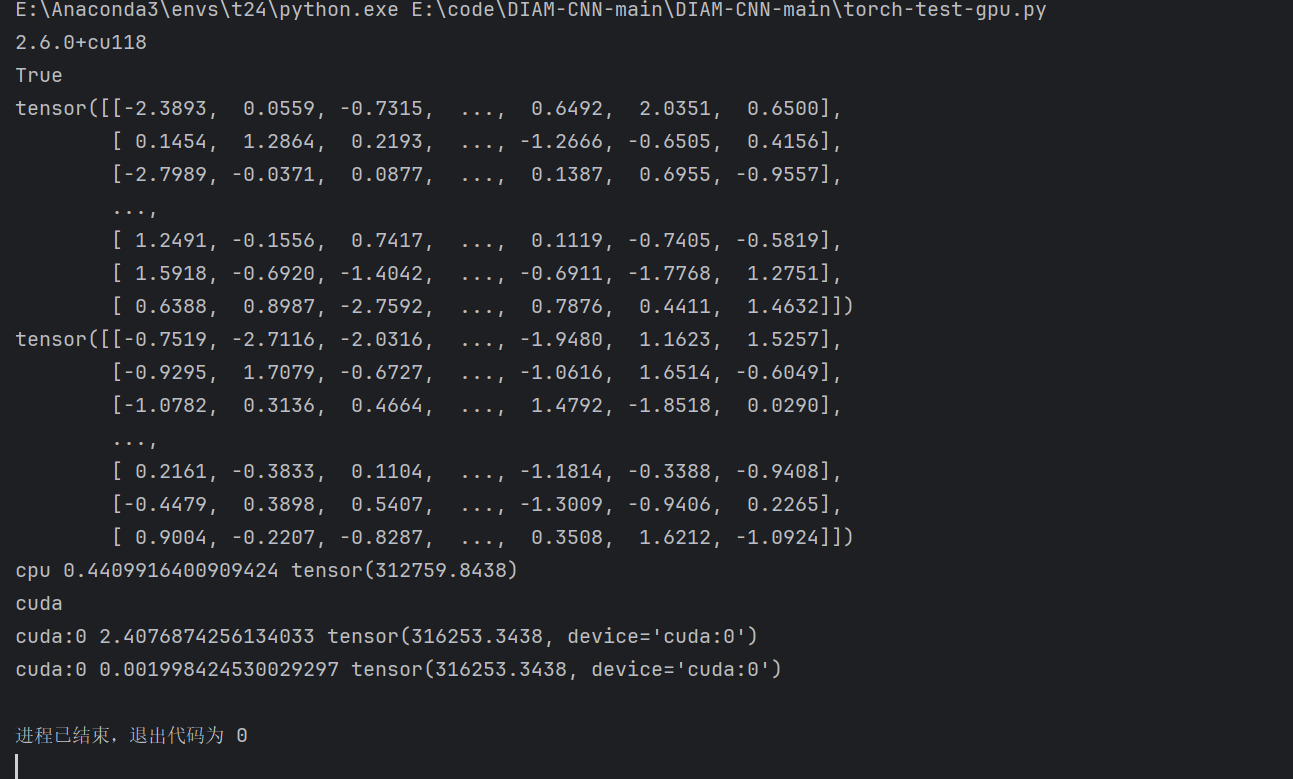

运行以上的测试代码,可以返回torch版本与gpu是否可用,同时做了cpu与gpu运算时间的对比,我的测试结果如下。

代码首先输出了torch版本与GPU可用的信息(True),然后对两个随机矩阵分别用cpu和gpu运算,输出了一次cpu运算时间和两次的gpu运算时间。

至此,torch-gpu的安装已经全部完成,希望可以帮助到大家。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)