首个医学世界模型:斯坦福、普林斯顿联手重塑未来外科手术

AI进化为能在手术台中感知组织张力并引导机械臂操作的数字医生了!在医学界,抽象临床推理与物理干预长期分离。斯坦福大学与普林斯顿大学的研究团队携手推出了通用医疗具身世界模型MedOS(医学操作系统)。该平台模仿人类大脑的双系统认知机制,既能在医学考试和临床科研中展现出顶尖的推理能力,又能将这种智能延伸到物理世界。S 全屏播放 full_screen_mv系统通过理解手术视频中的物理力学规律来预测风险

AI进化为能在手术台中感知组织张力并引导机械臂操作的数字医生了!

在医学界,抽象临床推理与物理干预长期分离。斯坦福大学与普林斯顿大学的研究团队携手推出了通用医疗具身世界模型MedOS(医学操作系统)。

该平台模仿人类大脑的双系统认知机制,既能在医学考试和临床科研中展现出顶尖的推理能力,又能将这种智能延伸到物理世界。

系统通过理解手术视频中的物理力学规律来预测风险,并借助XR(扩展现实)和机器人技术与人类医生实时协作,让资历较浅的医护人员也能爆发出顶尖专家的实力。

填平医学理论与物理操作的鸿沟

长久以来,AI在医学领域存在着明显的分野。

一边是极其擅长处理病历和诊断数据的智能系统,另一边是手术室里极其精准却对解剖结构毫无概念的机械臂。

当下的医疗AI大多被困在数字世界里,只能对着静态影像或电子健康记录执行计算任务。

它们无法感知真实手术过程中的动态变化,更无法在充满不确定性的物理环境中采取行动。

精密的外科手术机器人虽然能够执行外科医生的指令,但它们严重缺乏对人体解剖环境的理解。

解决这个脱节问题需要一个前所未有的协作智能平台。

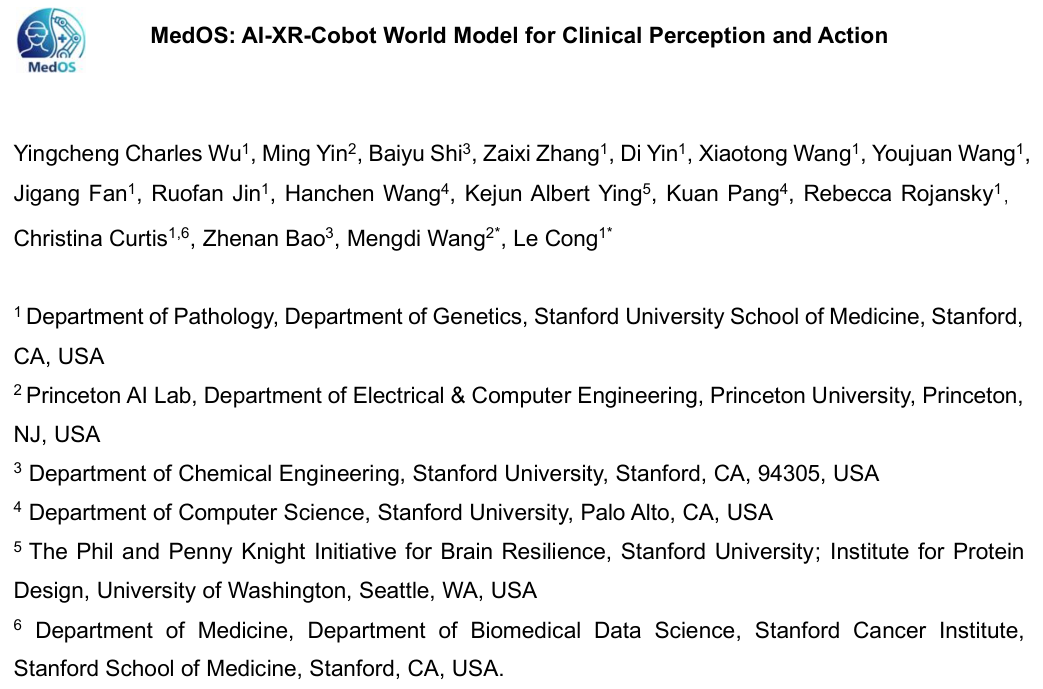

研究团队将MedOS系统设计成一个具身世界模型,让临床环境变得既能被机器感知,又能被机器操作。

你可以把系统想象成一个拥有两套大脑回路的资深外科医生。

在日常临床实践中,人类医生必须在制定宏观策略与执行精准微操之间无缝切换。

系统完美复制了这种认知机制,构建了一个横跨数字与物理尺度的统一架构。

在数字世界里系统启动慢思考模式。

它会像老专家一样仔细梳理患者的终身病历数据,识别出肝硬化或门静脉高压等潜在疾病风险。

接着它会分析近期的临床事件,制定出周密的手术计划以最大限度地减少组织损伤并确保严格止血。

当视线转移到物理世界的手术台上,系统就会瞬间激活快思考模式。

它通过高带宽的扩展现实流媒体和机器人控制接口,实时建立包含第一人称视角和深度信息的立体状态空间。

一旦发现组织存在纤维化粘连,快思考模块会立刻察觉到牵拉可能带来的撕裂风险,瞬间指挥机械臂改用吸引器进行分离以避开常规抓钳。

赋予机器深层医学逻辑

支撑这一切的是一个极其复杂的智能体网络。

协调器智能体就像是医院的医疗主管,负责将复杂的查询任务拆解并分发给电子病历、指南、放射影像和病理学等专用智能体。

核心的推理智能体则遵循基于证据合成和因果推断的思考模板开展严密的工作。

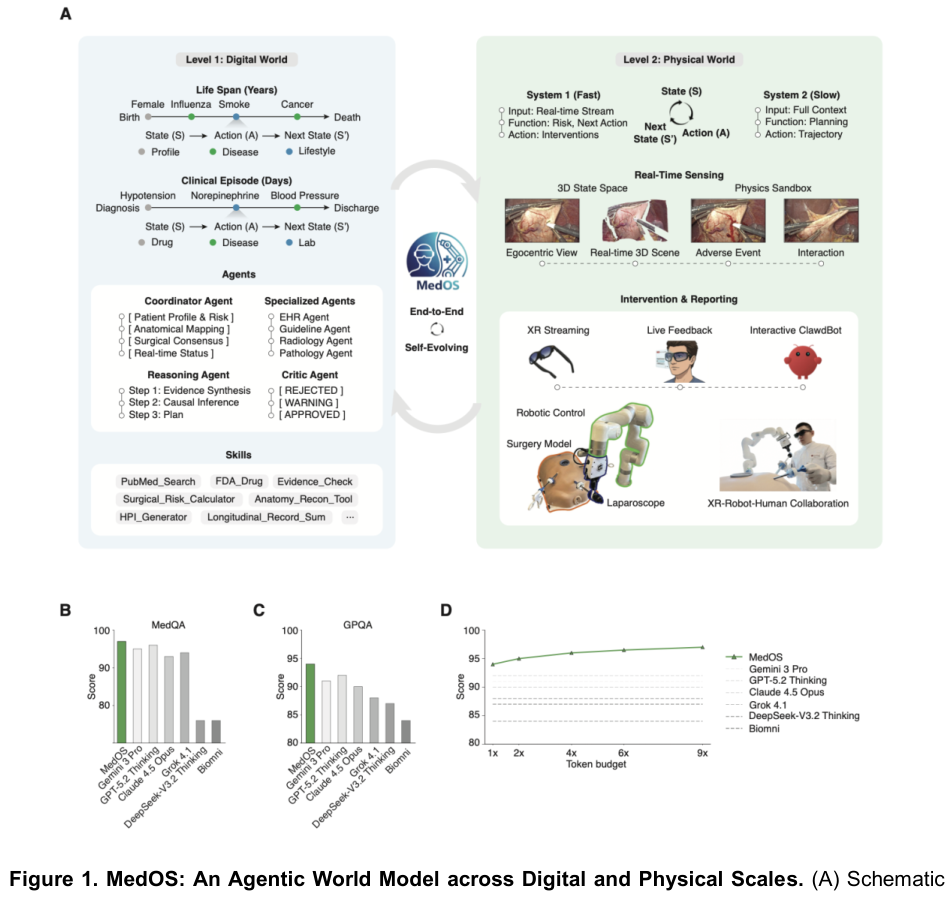

研究团队在多个极具挑战性的生物医学基准测试中检验了这套大脑。

在测试医学执照考试水平的MedQA(医学问答基准)数据集中,系统斩获了约97%的准确率。

系统在测验专家级推理能力的GPQA(研究生水平通用问答基准)测试上同样拿下了约94%的高分,将Gemini 3 Pro和GPT-5.2 Thinking等前沿模型远远甩在身后。

该系统还展现出了极其罕见的推理期扩展特性。

给系统分配用于慢思考的算力词元预算越多,它给出的策略就越完善。

这种设计让它成为一个能够应对复杂临床场景并自我进化的强悍临床智库。

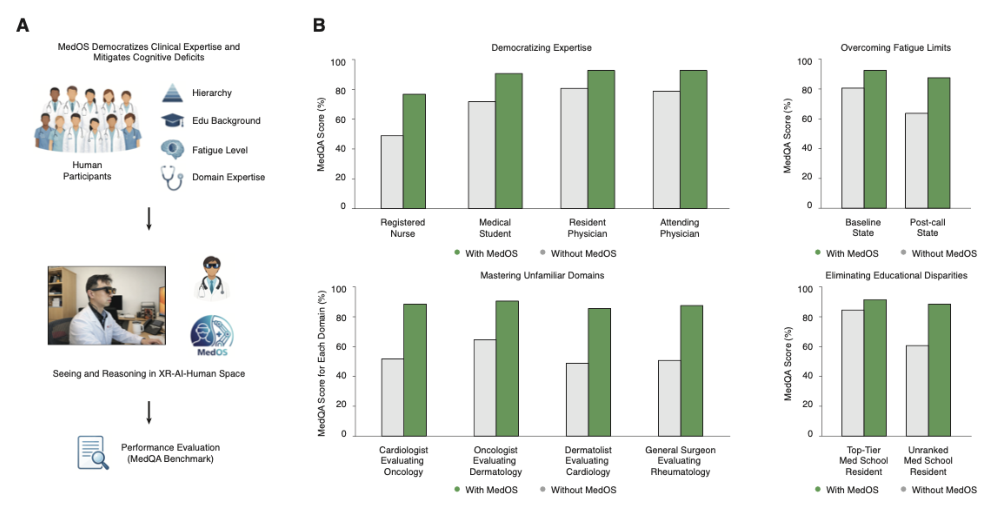

强大的智力,直接大幅抹平了人类医疗工作者之间的经验壁垒。

研究人员邀请了各种不同层级、不同教育背景甚至处于不同疲劳状态的24名医生和护士进行人机协作测试。

在系统的辅助下,注册护士的诊断准确率从49%飙升至77%,医学生的成绩也跃升至91%。

那些缺乏临床经验的年轻群体在系统的加持下,直接匹敌甚至超越了主治医师79%的独立表现得分。

即便是那些刚值完夜班导致睡眠严重不足的医生,原本直线下降的判断力也在系统的帮助下完全恢复并超越了其精力充沛时的基础水平。

系统还能让心脏病专家精准评估肿瘤学病例,让医生们轻松跨越自身专业领域的学科边界。

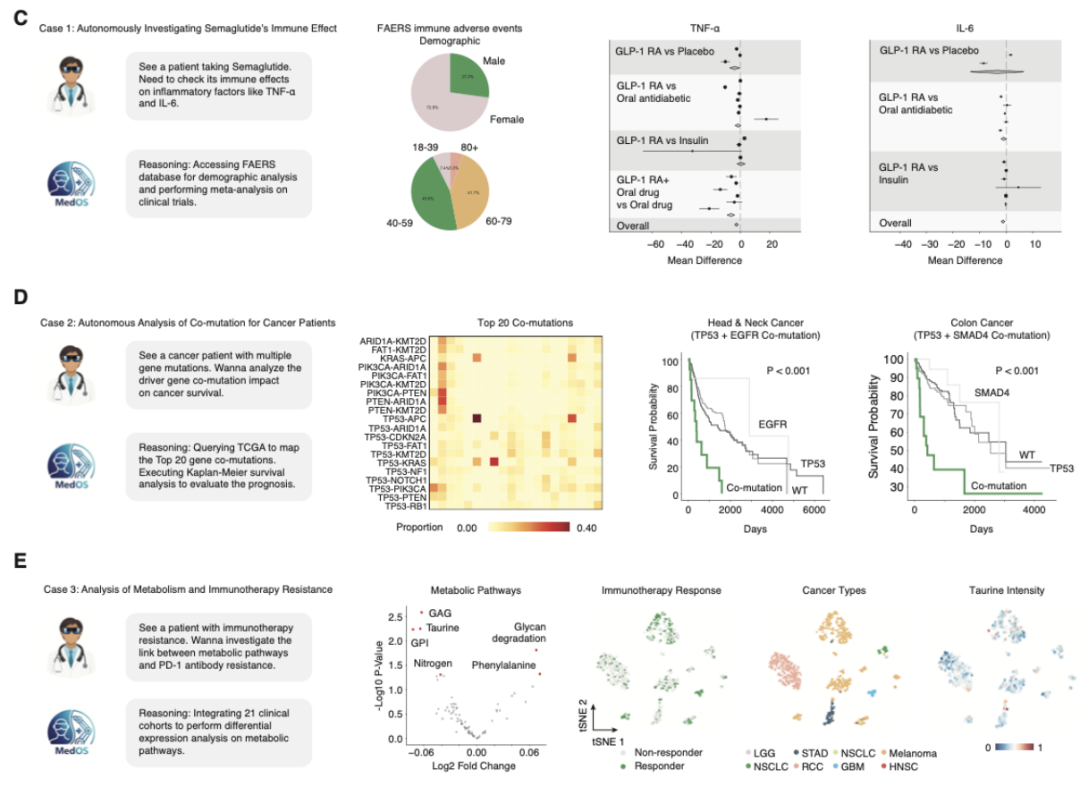

不仅是回答问题,该系统还能自主推进极其复杂的临床科研工作。

只需人类抛出一个关于药物免疫副作用的疑问,它就能自动访问FAERS(美国食品药品监督管理局不良事件报告系统)进行不良事件的人口统计分析。

提取数据后它会自主执行荟萃分析,直接生成森林图来揭示炎症因子水平在不同用药对照组中的显著变化。

在处理复杂的基因组肿瘤学任务时,它能迅速调取TCGA(癌症基因组图谱)数据,绘制出前20个多基因突变的相互作用热图。

它能独立完成生存分析并生成卡普兰梅耶生存曲线,准确找出特定基因共突变对头颈癌或结肠癌患者生存概率的致命影响。

在探索免疫治疗耐药性机制时,它更是通过差异表达分析将牛磺酸代谢等途径与抗体疗效联系起来,自主生成直观的单细胞聚类图谱。

具备空间物理直觉的极速视觉引擎

要让机器真正在手术室里发挥作用,仅仅看懂静态图片远远不够。

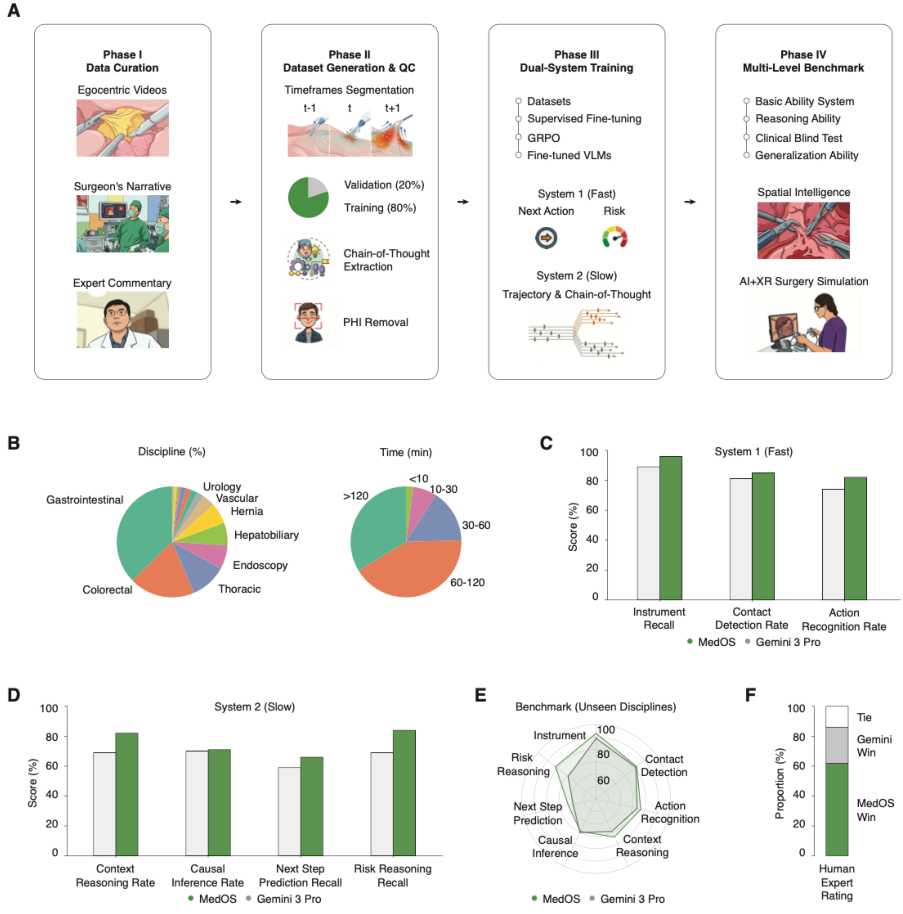

研究团队耗费巨大精力构建了一个名为MedSuperVision(医学超级视觉)的庞大手术视频数据集。

这个数据集包含了长达85398分钟的真实手术第一人称视频,涵盖了肝胆、胃肠和泌尿等多个高难度外科领域。

这里面的每一段视频都被注入了外科专家的灵魂。

将近两千名临床专家为这些手术视频录制了旁白,详细解释每一步操作的内在意图。

研究人员将这些原始素材切片并提取出专家的思维链条,剔除患者隐私信息后打造出一个用来训练机器物理直觉的超级知识库。

利用这个数据集,团队采用组相对策略优化算法对视觉语言模型进行了针对性极强的微调训练。

他们专门剥离出了负责识别风险动作的快系统和负责轨迹与逻辑规划的慢系统。

经过这种严苛训练的视觉引擎,在仪器召回、接触检测和动作识别等毫秒级高频任务上全面碾压了通用的基础大模型。这赋予了机器一种极其稀缺的空间物理智能。

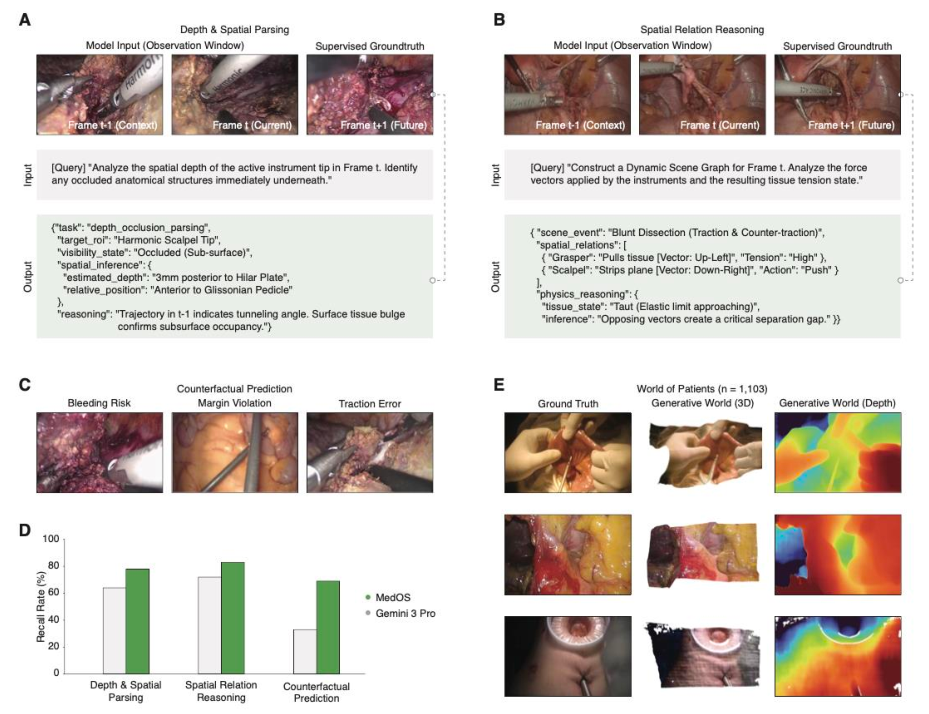

它摒弃了将手术画面视作平面像素点的局限思维,直接在脑海中还原出操作视野的立体结构。

当一把超声刀在组织后方移动时,系统能够通过分析表面组织的隆起变形程度和刀具的行进角度,精准判断出刀尖深处隐藏的格利森血管蒂。

令人拍案叫绝的是它对物理力学的深刻理解。

在一场包含牵引和反牵引的钝性分离操作中,系统能像物理学家一样拆解出精确的受力向量动态场景图。

它清楚知道抓钳在向上拉扯组织,手术刀在向下剥离筋膜,并能实时推断出相对的力矩正在制造出完美的临界分离间隙。

它甚至学会了通过反事实预测来预知危险。

通过输入时间观察窗口的序列数据,系统可以在悲剧发生前预见到血管破裂、切缘违规或是牵引力过大等医疗事故。

在一场包含上百个测试场景的盲测实验中,五位拥有执照的医生一致认为该系统生成的指导意见远比其他通用大模型要可靠和精准。

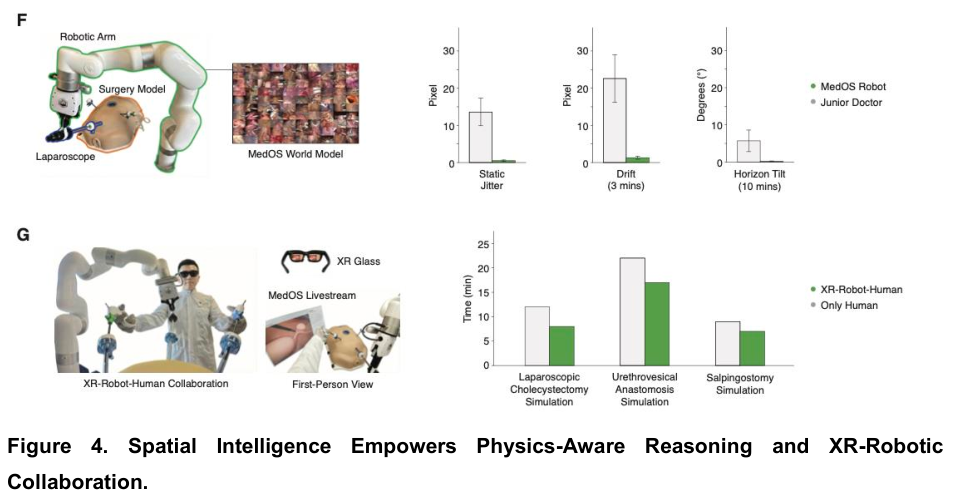

图中展示了MedSuperVision视频数据集的构建流程与双系统物理感知训练效果。

混合现实与协作机器人重塑手术台

拥有了强大的大脑和锐利的眼睛,接下来就是为系统装上灵活的双手。

研究人员让该系统接管了真实的微创手术机械臂,并将其稳定度与一位资历尚浅的初级医生进行了同台持械比拼。

人类医生常常因为生理性震颤而在精细操作中出现轻微的抖动与长期的地平线倾斜。

受AI控制的机器手却展现出了令人惊叹的绝对稳定性。

无论是在静态的像素级抖动测试还是长达三分钟的仪器漂移测量中,系统都将其控制在了一个极低的误差范围内,彻底过滤掉了人类肉体的生理局限。

为了让这种智能真正服务于人类,团队创造了一个令人兴奋的混合现实协作环境。

外科医生戴上扩展现实眼镜,眼前不仅有真实的手术区域,还叠加了一层由系统实时计算出来的增强视觉数据流。

医生依然握着机器人的控制杆,但认知的重担被彻底卸下了。

在一系列模拟的腹腔镜胆囊切除、输尿管吻合和输卵管造口手术中,这套协作系统的威力展露无遗。

有了AI在视网膜上提供实时导航和物理力学预警,医生们完成任务的速度大幅提升。

医生只需全神贯注于眼前的刀尖执行操作,那些关于方向感、空间深度和潜在风险的繁杂计算全交由数字助手代劳。

这套系统还能利用它见过的海量真实手术画面,反向生成高保真的三维数字孪生世界。

它为1103名患者重建了极其逼真的子宫或血管床等复杂地形与密集深度图。

未来的年轻医生和机器智能体可以在完全不危及真人生命的情况下,在这个虚拟的生成式手术室里进行无数次的演练与学习。

医学技术的演进,此刻正式从单纯的诊疗辅助大步跨入实体干预的新纪元。

参考资料:

https://medos-ai.github.io/

https://medos-ai.github.io/assets/logos/MedOS-paper.pdf

更多推荐

已为社区贡献254条内容

已为社区贡献254条内容

所有评论(0)