ollama v0.16.3 发布:新增Cline集成、支持Gemma 3 / Llama 3 / Qwen 3架构、全新Zstd压缩支持与TUI交互升级详解

修复 MLX 参数显示错误与层工厂缺失问题。优化在 MLX 环境下的参数计数显示。模型调度器增强任务分配逻辑(better mlx model scheduling)。修复 macOS 下载链接指向错误。恢复到版本0.5.0的兼容性。CLI 中增设环境变量:OPENAI_BASE_URL用于 Codex 集成与代理请求重定向。更新 go.mod 依赖,新增。代码地址:github.com/olla

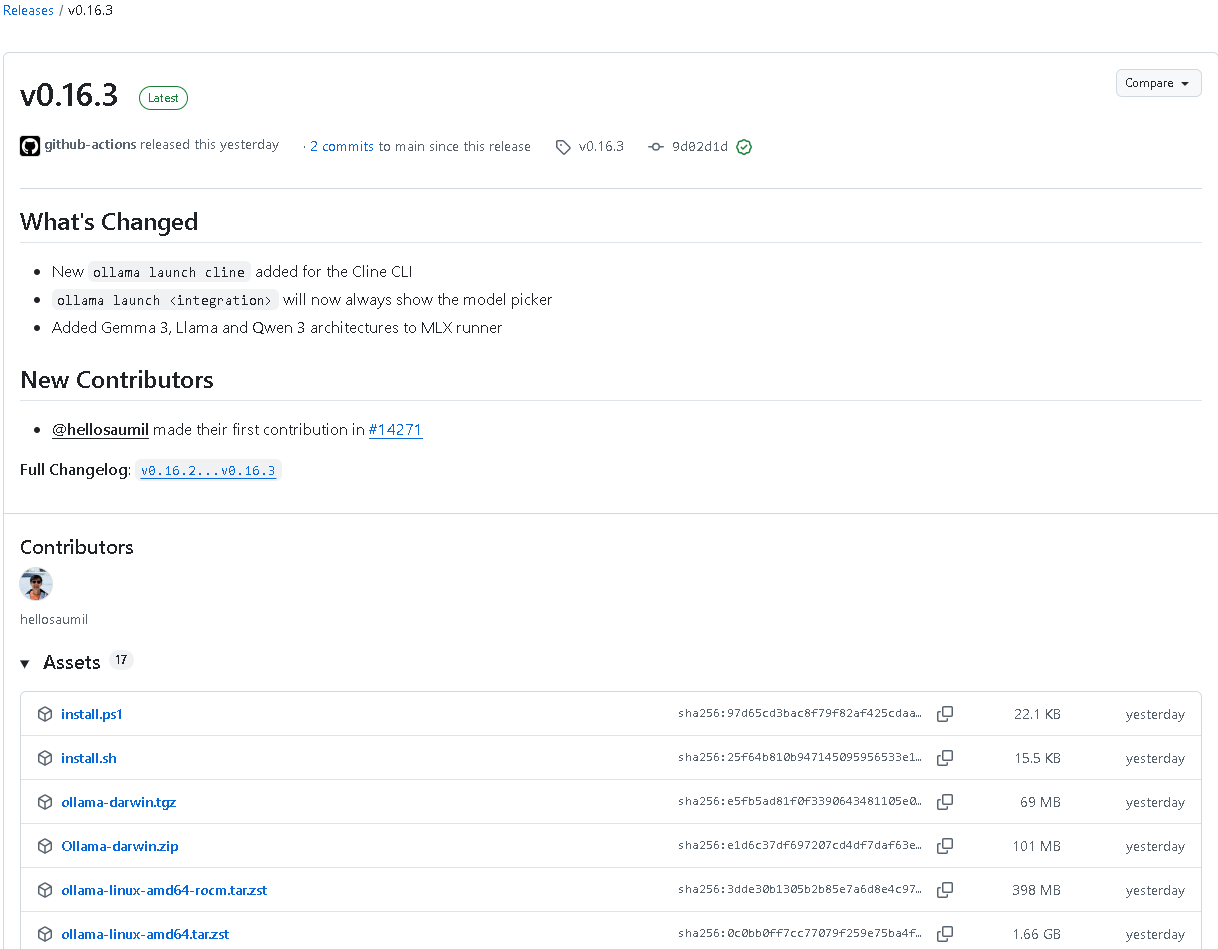

一、版本信息概览

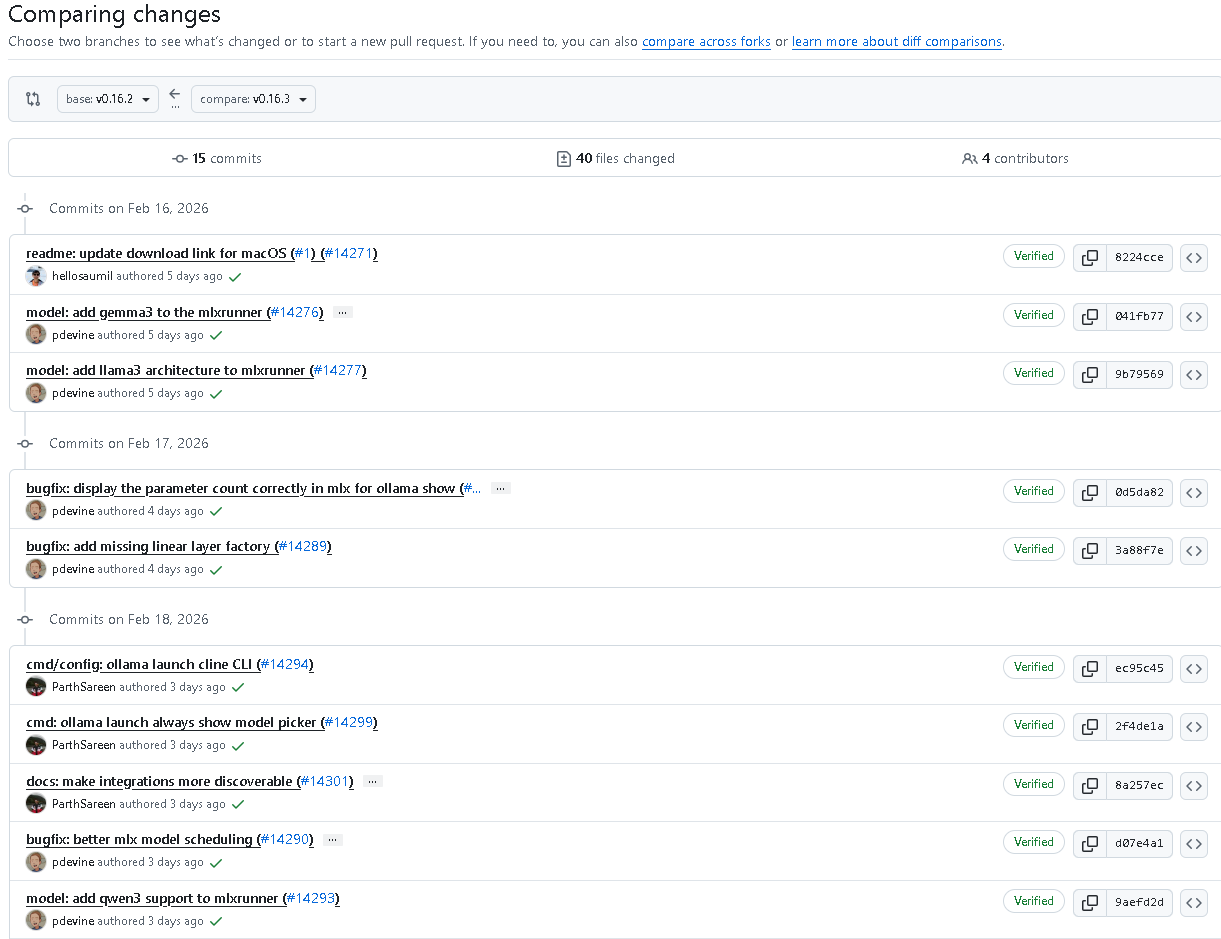

2026年2月21日,ollama 团队正式发布 v0.16.3 最新版本。这一版本是继上次更新后的又一次重要功能升级与性能优化版本,不仅集成了全新的 Cline CLI 启动支持,还在多项关键功能上进行了拓展与修复,包括:

- 新增 Cline CLI 集成支持:

ollama launch cline - 新增 MLX Runner 对 Gemma 3、Llama3 和 Qwen3 三种架构的支持

- 改进命令行交互,

ollama launch现在始终显示模型选择器 - 引入 Zstd 压缩解码支持以提升请求处理性能

- 优化 TUI 单选与多选交互体验

- 新增 Pi 集成文档与更加完善的 CLI 配置能力

- 修复多项 MLX 参数显示、调度和层工厂创建的错误

这一版本的改动范围广泛,涉及命令行接口 (CLI)、模型调度(MLX runner)、服务器中间件、解析器系统、安装脚本、文档系统等七大板块。

下面我们将详细拆解 ollama v0.16.3 的新版特性与底层改动。

二、全新集成:Cline CLI 集成正式加入

ollama v0.16.3 的最大亮点之一,是新增了对 Cline 集成的完整支持。Cline 是一个自适应的自主编码代理系统(Autonomous Coding Agent),具有多线程、并行执行等特性。通过 ollama launch cline 命令,用户可以直接与 Cline 进行连接与模型调度。

新版实现了完整的 cmd/config/cline.go 文件与对应的单元测试 cline_test.go,其中关键能力包括:

1. 新的命令行入口

ollama launch cline

该命令将自动检测本地是否安装了 Cline CLI (npm install -g cline),并在检测到未安装时提示进行安装。

2. Cline 配置文件路径自动检测

路径默认为:

~/.cline/data/globalState.json

系统会根据此路径调用配置文件,并在首次运行时自动生成。

3. 一键写入 Ollama 集成配置

安装后,系统会向 globalState.json 文件添加:

{

"ollamaBaseUrl": "http://localhost:11434",

"actModeApiProvider": "ollama",

"planModeApiProvider": "ollama",

"actModeOllamaModelId": "kimi-k2.5:cloud",

"planModeOllamaModelId": "kimi-k2.5:cloud"

}

这意味着 Cline 的 “执行模式 (act)” 与 “规划模式 (plan)” 都将以 Ollama 为后端,全面接管语言模型调用。

4. 模型同步与无缝切换

Cline.Models() 方法会读取并返回当前配置模型,如:

["kimi-k2.5:cloud"]

Cline 会将该模型作为主力执行模型,支持在 Ollama 侧继续进行 pull / switch / run 操作,从而实现一体化模型调用体验。

5. 测试覆盖

单元测试验证了以下场景:

- 创建配置文件

- 覆盖旧配置但保留自定义字段

- 多次修改模型时的自动更新

- 无模型输入时的无操作行为

- 路径检测与文件不存在时的返回处理

此功能的加入使得 Ollama 在自动化编程与智能代理方向的扩展更加稳固。

三、架构扩展:MLX Runner 新增多款主流模型支持

在模型层面,v0.16.3 引入了 Gemma 3、Llama 3 和 Qwen 3 架构。在 model: add gemma3 / llama3 / qwen3 三条提交中,分别增加了对这三类架构的 MLX Runner 兼容。

新的解析函数在 model/parsers/parsers.go 中定义:

case "qwen3":

p = &Qwen3Parser{hasThinkingSupport: false, defaultThinking: false}

case "qwen3-thinking":

p = &Qwen3Parser{hasThinkingSupport: true, defaultThinking: true}

case "qwen3-coder":

p = &Qwen3CoderParser{}

新增的 Qwen3Parser 系列支持模型多阶段输出解析,包括:

<think>思考阶段结构化提取<tool_call>工具调用自动识别- 输出内容的分块拼接与连续流式精确还原

新解析器设计了完整的状态机,包括:

CollectingThinking → CollectingContent → CollectingToolContent → Done

能够准确区分模型自我思考(Thinking Block)与用户输出(Content Block)。

此外,通过精确的 JSON 提取逻辑实现了对工具调用结构的复原:

{"name": "get_weather", "arguments": {"location": "San Francisco"}}

在单元测试中验证了思考标签、工具调用、拆分流式输入等多种边界情形。

四、命令行与交互体验升级

1. ollama launch 模型选择交互优化

命令行行为调整为:无论是否存在默认模型,都将强制显示选择器,防止命令误触导致错误模型执行。新增的代码修改点为:

cmd: ollama launch always show model picker (#14299)

2. 新增交互逻辑支持:

- 接口函数

DefaultSingleSelector添加第三个参数current,支持高亮当前默认模型 selectIntegration()改为按优先级(自定义排序 + 字母顺序)展示- 新增排序规则

integrationOrder = []string{"opencode", "droid", "pi", "cline"},保证重点项目优先展示

3. CLI 集成列表更新

支持的集成列表中新增:

cline Cline

pi Pi

并在帮助信息中更新:

Supported integrations:

claude Claude Code

cline Cline

codex Codex

droid Droid

opencode OpenCode

openclaw OpenClaw

pi Pi

五、TUI(文本交互界面)系统全面重构

TUI 交互在 v0.16.3 作出了近百行改动,实现更智能、更流畅的多选操作体验。

1. 新增单选 / 多选模式切换

- 默认使用 单选模式(

multi=false),使用 Tab 键 可切换至多选 - 多选返回逻辑调整为 “最后选中的项为默认模型”

- “单选模式” 支持快速添加模型到现有模型集

2. 全新帮助指令界面

- 单选模式:

"↑/↓ navigate • enter select • tab add multiple • esc cancel" - 多选模式:

"↑/↓ navigate • space toggle • tab select single • enter confirm • esc cancel"

3. 光标定位增强

函数 cursorForCurrent() 支持模糊匹配当前选中项,并在存在相似名称 (e.g. qwen3 vs qwen3:8b) 时智能跳转对应位置,避免浏览冗余。

4. UI优化

- 默认项以

(default)标签标注 - 检查框

[x] / [ ]动态渲染 - 滚动与分页逻辑同步更新

此改进显著提升了交互式模型挑选体验,使得管理多模型集成更直观。

六、服务器增强:Zstd 压缩全面支持

在 middleware/openai.go 中,ollama 增加了对 zstd 压缩格式的自动识别与解压能力:

if c.GetHeader("Content-Encoding") == "zstd" {

reader, err := zstd.NewReader(c.Request.Body, zstd.WithDecoderMaxMemory(8<<20))

...

}

特点:

- 最大解压内存限制 8MB,用于防止 DoS 攻击

- 自动将请求头

Content-Encoding: zstd删除,继续 JSON 解析 - 出错后安全返回

400 Bad Request

单元测试全面覆盖三类情况:

- 普通 JSON 请求

- Zstd 压缩请求

- 超出最大限制的压缩请求

验证了解压、模型字段读取、对话体内容提取的正确性。

七、安装脚本改进:防止部分下载的执行风险

在 scripts/install.sh 中,v0.16.3 为安装脚本添加了安全包装:

# Wrap script in main function so that a truncated partial download doesn't end

# up executing half a script.

main() {

...

}

main

此举避免了用户脚本部分下载时执行未完整逻辑的风险。

八、文档系统更新

1. 新增 Pi 集成说明

路径:docs/integrations/pi.mdx

完整说明了如何通过 npm 安装 @mariozechner/pi-coding-agent,并配置到 Ollama:

ollama launch pi

或手动设置 ~/.pi/agent/models.json 文件。

2. 集成目录更新

在 docs/integrations/index.mdx 中新增:

并完善分类结构,将 “Assistants” 和 “Coding” 集合区分更加清晰。

九、其他修复与优化总结

- 修复 MLX 参数显示错误与层工厂缺失问题。

- 优化

ollama show在 MLX 环境下的参数计数显示。 - 模型调度器增强任务分配逻辑(better mlx model scheduling)。

- 修复 macOS 下载链接指向错误。

- 恢复

mlx-c bindings到版本0.5.0的兼容性。 - CLI 中增设环境变量:

用于 Codex 集成与代理请求重定向。OPENAI_BASE_URL OPENAI_API_KEY - 更新 go.mod 依赖,新增

github.com/klauspost/compress v1.18.3。

十、总结与展望

代码地址:github.com/ollama/ollama

通过 ollama v0.16.3,我们看到这一版本不仅仅是增量更新,而是一次 全栈强化:

- 在集成层面:引入 Cline、Pi,将 ollama 扩展为 AI 工具生态的核心接口层。

- 在模型层面:增加对新一代语言架构(Llama3 / Qwen3 / Gemma3)的支持,紧跟业界前沿。

- 在交互层面:重新设计 CLI 与 TUI,使多模型管理、自动代理配置更加简洁。

- 在安全层面:Zstd 保护、防部分下载机制均提升稳定性。

- 在开发层面:完善单元测试覆盖率,确保大规模框架集成稳定运行。

这一版本代表着 ollama 自研生态进入了“多核代理时代”,它不再只是模型运行器,而开始成为智能代理系统的统一底座。

结语:

ollama v0.16.3 不仅带来了更多模型和更强的交互性,更在底层架构和安全机制上迈出了关键的一步。借助这次更新,开发者能够更高效地集成多模型、多代理系统,运行本地的智能开发助手、AI编码代理与自主系统。

未来版本极有可能继续扩展更多编码代理和模型运行架构,而 v0.16.3 作为承上启下的重要节点,为 Ollama 走向 AI 工具生态中心打下了坚实基础。

更多推荐

已为社区贡献51条内容

已为社区贡献51条内容

所有评论(0)