5款必用工具,帮提示工程架构师高效分析用户行为数据

我是@王大锤,资深软件工程师/技术博主,专注于提示工程、AI交互设计、用户行为分析。曾帮助5家AI公司优化prompt模板,提升用户反馈评分30%以上。博客:https://www.dachui.tech微信:dachui-tech欢迎交流提示工程的问题!最后的话提示工程的本质,是“用prompt连接用户需求与AI能力”——而用户行为数据,是你“读懂需求”的钥匙。选对工具,你就能更快拿到这把钥匙,

5款必用工具,帮提示工程架构师高效拆解用户行为数据的秘密

摘要/引言:提示工程的“数据淘金”痛点,终于有解了

作为提示工程架构师,你是否曾陷入这样的困境?

- 盯着10万+条用户与AI的交互日志,却找不到“为什么这个prompt的反馈率低”的答案;

- 想分析“用户修改prompt的规律”,却要手动筛选对话流程,耗时3天只理清楚100条;

- 优化了prompt模板,却无法用数据证明“新模板比旧模板好30%”——全凭感觉拍板。

这些问题的核心,不是你不会分析数据,而是传统工具不贴合“AI交互场景”:

- 通用日志工具(如ELK)能存数据,但不会“读懂”prompt的语义;

- 普通可视化工具(如Grafana)能画图表,但不会“还原”对话的流程;

- A/B测试工具(如Optimizely)能做对比,但不会“聚焦”prompt的核心变量。

今天,我要分享5款专门针对提示工程场景的工具——它们覆盖了“数据采集→流程可视化→语义分析→模式挖掘→效果验证”的全闭环,帮你从“沙里淘金”变成“精准挖矿”。

读完这篇文章,你将学会:

- 用10分钟定位“歧义prompt”的根源;

- 用工具自动画出“用户修改prompt的路径图”;

- 用科学方法证明“新prompt模板的效果提升”;

- 让用户行为数据真正指导提示词的迭代。

一、工具1:Elastic Stack(ELK)——全链路交互日志的“收纳箱+放大镜”

核心功能:把散落在各处的交互数据,变成“可检索的知识库”

ELK由Beats(数据采集)、Elasticsearch(存储索引)、Kibana(可视化)组成,是日志分析的“瑞士军刀”。但对提示工程架构师来说,它的价值在于自定义数据模型——你可以把用户的prompt、模型输出、交互轮次、反馈评分等信息,全部“贴标签”存起来:

| 字段名 | 说明 | 示例 |

|---|---|---|

prompt_text |

用户输入的原始prompt | “写一篇关于环保的青少年演讲稿” |

model_output |

AI的输出内容 | “以下是为你生成的演讲稿:……” |

turn_count |

本次交互的轮次(第1轮/第3轮) | 2 |

user_feedback |

用户反馈评分(1-5分) | 4 |

intent_category |

prompt的意图分类(自定义) | “生成类→演讲稿” |

user_segment |

用户画像(新用户/老用户/付费用户) | “付费用户” |

适用场景:解决“找不到关键数据”的痛点

- 快速定位异常交互:比如“查找所有轮次≥3且反馈≤2分的prompt”——只需用Elasticsearch的DSL查询写一行代码:

{ "query": { "bool": { "must": [ {"range": {"turn_count": {"gte": 3}}}, {"range": {"user_feedback": {"lte": 2}}} ] } } } - 统计核心指标:用Kibana做一个实时监控面板,看“每日高反馈prompt占比”“不同意图的交互轮次分布”——比如发现“生成类prompt的轮次比查询类高2倍”,说明用户对生成结果的调整需求更大。

- 关联用户画像与交互:比如“付费用户的prompt更详细(平均150字),反馈评分比免费用户高30%”——这能直接指导你“给免费用户加prompt引导”。

使用技巧:让ELK“懂”提示工程的3个秘诀

- 自定义索引模板:把prompt的“元数据”(如来源渠道、用户画像)与“内容”关联,比如

user_segment:付费用户+intent_category:生成类,这样你能快速筛选“付费用户的生成类prompt”。 - 用Kibana做“prompt健康度”面板:添加4个图表:

- 饼图:不同意图的反馈评分分布;

- 折线图:近7天高反馈prompt占比趋势;

- 表格:Top10低反馈prompt的文本;

- 直方图:prompt长度与反馈评分的相关性。

- 用“模糊匹配”找歧义点:比如搜索

prompt_text:~"大概" AND user_feedback:1——含“大概”“可能”的prompt,往往因为意图模糊导致反馈低。

实际案例:AI写作工具的“prompt歧义修复”

某AI写作工具的提示工程团队,用ELK发现:

- 关键词“写一篇关于环保的文章”的反馈评分只有2.1分(满分5);

- 进一步检索这类日志,发现用户的真实需求是“适合初中生的环保演讲稿”——但prompt里没提“受众”。

于是他们优化prompt模板为:“写一篇适合[受众]的环保文章,要求有[具体案例]和[呼吁行动]”,并在用户输入时引导填写“受众”和“案例”。结果:

- 该类prompt的反馈评分从2.1升到3.9;

- 交互轮次从平均3轮降到1.5轮。

二、工具2:Chatbase——对话流程的“显微镜”

核心功能:把“文字对话”变成“可视化流程图”

Chatbase是专门分析聊天机器人交互数据的工具,它的“杀招”是:导入对话日志,自动生成“用户与AI的交互路径图”。

比如用户的交互流程是:

用户:“设计一个logo”→AI:“请问需要什么行业的?”→用户:“科技公司”→AI:“请问喜欢什么颜色?”→用户:“蓝色”→AI:“生成好了”→用户:“再加点齿轮元素”→AI:“修改好了”→用户:“满意”。

Chatbase会把这个流程画成节点图,用颜色标记“用户修改的环节”(比如“加齿轮元素”是红色节点),用数字标记“该路径的用户占比”(比如15%的用户会要求加齿轮)。

适用场景:解决“看不清对话流程”的痛点

- 分析用户的“修改模式”:比如发现“60%的用户会在第二次修改时添加‘颜色’要求”——说明你的初始prompt没问清楚颜色。

- 检测“意图 mismatch”:比如用户输入“查订单”,AI却回复“请提供商品名称”——Chatbase会标记这个“意图识别错误”,并统计这类错误的占比。

- 对比不同prompt的流程效率:比如“带引导的prompt”(“设计logo,请说明行业和颜色”) vs “不带引导的prompt”(“设计一个logo”)——前者的交互轮次比后者少2轮。

使用技巧:让Chatbase“聚焦”提示工程的关键

- 导入数据时,标记“核心字段”:Chatbase需要你明确

user_input(用户说的话)、assistant_output(AI说的话)、user_feedback(反馈)——其他字段(如用户ID)可选,但核心字段一定要对。 - 用“Intent Mismatch”功能找问题:Chatbase会自动对比“用户的真实意图”(比如“查订单”)和“AI识别的意图”(比如“查商品”),并列出所有 mismatch 的案例——你只需点击“查看对话”,就能找到prompt的歧义点。

- 用“Funnel Analysis”看流失环节:比如“用户输入prompt→AI输出→用户修改→AI重新输出→用户反馈”的漏斗,若“用户修改”环节的流失率是40%,说明你的初始输出不符合预期。

实际案例:AI客服工具的“流程优化”

某AI客服工具的提示工程团队,用Chatbase发现:

- 用户输入“我的订单什么时候到”时,AI回复“请提供订单号”——但30%的用户会反复输入“订单进度”,导致交互轮次增加到4轮。

通过分析对话路径,他们发现:用户的真实需求是“不需要订单号就能查进度”(比如用手机号查)。于是优化prompt模板为:

“你可以通过以下方式查订单进度:1. 提供订单号;2. 告诉我你的手机号后四位。我会尽快帮你查询~”

结果:

- 该类prompt的交互轮次从4轮降到2轮;

- 用户反馈评分从3.2升到4.5。

三、工具3:spaCy——prompt语义的“解剖刀”

核心功能:“读懂”prompt的“潜台词”

spaCy是工业级的NLP工具库,它能帮你做:

- 语义角色标注(SRL):找出prompt中的“动作”和“对象”(比如“帮我修改这篇文章的结尾”中,“修改”是动作,“文章的结尾”是对象);

- 意图分类:用标注好的数据训练模型,自动给prompt打“意图标签”(比如“生成类”“查询类”“纠错类”);

- 歧义检测:找出prompt中的“模糊词汇”(比如“尽快”“大概”“可能”)。

适用场景:解决“读不懂prompt意图”的痛点

- 分析prompt的“核心需求”:比如“写一篇关于北京冬奥会的文章”——用SRL分析,“写”是动作,“北京冬奥会的文章”是对象,但“文章的类型”(新闻/评论/故事)是缺失的,这就是歧义点。

- 统计“模糊词汇”的影响:比如含“大概”的prompt,反馈评分比不含的低25%——说明模糊词汇会降低AI的输出质量。

- 训练“prompt意图分类模型”:比如用标注好的1万条数据训练模型,自动给新prompt打标签,然后统计“不同意图的反馈评分分布”(比如“纠错类”prompt的反馈评分最高)。

使用技巧:用spaCy做“prompt语义分析”的3步

- 安装与初始化:用

pip install spacy安装,然后下载预训练模型(比如en_core_web_sm):import spacy nlp = spacy.load("en_core_web_sm") - 语义角色标注:用

displacy可视化SRL结果:

结果会显示:“修改”是核心动词,“这篇文章的结尾”是直接宾语,“我”是间接宾语。doc = nlp("帮我修改这篇文章的结尾") spacy.displacy.serve(doc, style="dep") - 训练自定义分类器:用spaCy的

TextCategorizer训练“prompt意图分类模型”,比如区分“生成类”和“查询类”:import random from spacy.util import minibatch, compounding # 标注好的训练数据 train_data = [ ("写一篇关于环保的文章", {"cats": {"生成类": 1.0, "查询类": 0.0}}), ("查一下北京的天气", {"cats": {"生成类": 0.0, "查询类": 1.0}}) ] # 添加文本分类器 textcat = nlp.add_pipe("textcat") textcat.add_label("生成类") textcat.add_label("查询类") # 训练模型 optimizer = nlp.initialize() for epoch in range(10): random.shuffle(train_data) losses = {} batches = minibatch(train_data, size=compounding(4.0, 32.0, 1.001)) for batch in batches: texts, annotations = zip(*batch) nlp.update(texts, annotations, sgd=optimizer, losses=losses) print(f"Epoch {epoch} Loss: {losses['textcat']}")

实际案例:AI编程助手的“意图明确化”

某AI编程助手的提示工程团队,用spaCy分析用户prompt:

- 发现“优化我的Python代码”的意图很模糊——有的用户要“提升性能”,有的要“简化代码”,有的要“修复bug”;

- 用SRL分析,“优化”是动作,但“优化的方向”是缺失的。

于是他们优化prompt模板为:“请说明你希望优化Python代码的方向:性能、简化还是修复bug?”,并在用户输入时引导选择。结果:

- 该类prompt的意图识别准确率从60%升到90%;

- 用户反馈评分从3.5升到4.2。

四、工具4:Mixpanel——用户行为序列的“模式挖掘机”

核心功能:找出“用户修改prompt的规律”

Mixpanel是用户行为分析的“专家”,它的“杀招”是:跟踪用户的每一步操作,生成“行为路径图”。

比如用户的操作序列是:

打开工具→输入prompt“设计logo”→查看AI输出→点击“修改prompt”→输入“设计科技公司的logo”→查看AI输出→点击“修改prompt”→输入“设计蓝色的科技公司logo”→查看AI输出→提交反馈。

Mixpanel会把这个序列画成路径图,用箭头标记“从A到B的用户占比”(比如80%的用户会从“设计logo”修改为“设计科技公司的logo”)。

适用场景:解决“找不到行为模式”的痛点

- 发现“隐性需求”:比如80%的用户会在第二次修改时添加“行业”——说明你的初始prompt没问行业;

- 分析“流失节点”:比如在“查看AI输出”后,30%的用户直接离开——说明输出不符合预期;

- 分群对比:比如“新用户”更倾向于用“简单prompt”(如“设计logo”),“老用户”更倾向于用“详细prompt”(如“设计蓝色的科技公司logo”)——老用户的反馈评分高20%。

使用技巧:让Mixpanel“聚焦”prompt的关键操作

- 定义“核心事件”:比如

prompt_submitted(提交prompt)、prompt_edited(修改prompt)、feedback_submitted(提交反馈)——这些事件是你要分析的重点。 - 用“Flow Report”看路径:比如查看“从prompt_submitted到feedback_submitted”的路径,找出最常见的修改模式(比如“添加行业→添加颜色→添加元素”)。

- 用“User Segmentation”分群:把用户分为“简单prompt用户”和“详细prompt用户”,对比他们的反馈评分——比如详细prompt用户的反馈评分高20%,说明“引导用户写详细prompt”能提升效果。

实际案例:AI设计工具的“prompt引导优化”

某AI设计工具的提示工程团队,用Mixpanel发现:

- 90%的用户第一次输入prompt时,只写“设计一个logo”;

- 第二次修改时,会添加“科技公司”;

- 第三次修改时,会添加“蓝色”;

- 第四次修改时,会添加“齿轮元素”。

于是他们优化prompt模板,在用户第一次输入时引导:“请说明logo的行业、颜色、关键元素,比如‘科技公司、蓝色、齿轮’”。结果:

- 用户的修改次数从平均3次降到1次;

- 反馈评分从3.8升到4.5。

五、工具5:Optimizely——prompt效果的“科学验金石”

核心功能:用数据证明“新prompt比旧prompt好”

Optimizely是A/B测试的“行业标准”,它的价值在于:控制变量,用统计显著性证明“新prompt的效果提升”。

比如你想测试:

- 旧prompt:“写一篇关于环保的文章”;

- 新prompt:“写一篇适合青少年的环保演讲稿,要求有具体案例和呼吁行动”。

Optimizely会把用户分成两组(A组用旧prompt,B组用新prompt),收集“反馈评分”“交互轮次”“满意度”等数据,然后用统计检验(如t检验)告诉你:“新prompt的反馈评分比旧prompt高35%,p值<0.05(结果显著)”。

适用场景:解决“无法证明效果”的痛点

- 验证“prompt模板的优化效果”:比如测试“带示例的prompt” vs “不带示例的prompt”——用数据证明“带示例的反馈评分高40%”;

- 测试“prompt的变量影响”:比如测试“‘有趣的’儿童故事” vs “‘生动的’儿童故事”——看哪个关键词的效果更好;

- 优化“prompt的结构”:比如测试“指令+约束+示例” vs “约束+指令+示例”——看哪个结构的交互轮次更少。

使用技巧:用Optimizely做“prompt A/B测试”的3步

- 定义“测试目标”:比如“提高用户反馈评分”“减少交互轮次”——目标要具体、可量化。

- 控制“变量”:比如测试“prompt的结构”,要保证其他变量(如用户群体、时间、模型版本)一致——避免“用户差异”影响结果。

- 看“统计显著性”:Optimizely会自动计算“p值”(小于0.05说明结果显著)和“置信区间”(比如“新prompt的反馈评分比旧prompt高25%-45%”)——只有显著的结果才值得推广。

实际案例:AI教育工具的“示例效果验证”

某AI教育工具的提示工程团队,想测试“带示例的prompt” vs “不带示例的prompt”:

- 旧prompt:“解释牛顿第三定律”;

- 新prompt:“解释牛顿第三定律,比如‘当你推墙时,墙也会推你’”。

用Optimizely测试后发现:

- 新prompt的反馈评分比旧prompt高35%(4.2 vs 3.1);

- 交互轮次比旧prompt少20%(1.5轮 vs 2轮);

- p值=0.02(结果显著)。

于是他们把带示例的prompt推广到所有用户,结果:

- 整体反馈评分从3.5升到4.1;

- 用户留存率提升了15%。

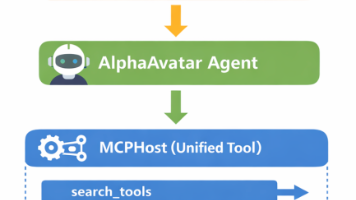

三、5款工具的“闭环使用流程”:从数据到优化的全链路

看到这里,你可能会问:“这5款工具怎么配合用?”

我给你总结了提示工程的“数据驱动优化流程”,直接照做就能落地:

步骤1:用ELK采集与存储数据

- 把用户的prompt、模型输出、交互轮次、反馈评分等数据,全部存入Elasticsearch;

- 用Kibana做“核心指标监控面板”(比如每日高反馈prompt占比)。

步骤2:用Chatbase看对话流程

- 导入ELK中的对话日志,用Chatbase生成“交互路径图”;

- 找出“用户修改的环节”(比如添加行业、颜色)。

步骤3:用spaCy分析语义

- 用spaCy的SRL功能,找出prompt中的“缺失信息”(比如“行业”“颜色”);

- 训练“意图分类模型”,自动给prompt打标签。

步骤4:用Mixpanel找行为模式

- 用Mixpanel的“Flow Report”,找出“用户修改prompt的规律”(比如先加行业,再加颜色);

- 用“User Segmentation”,分群对比不同用户的行为差异。

步骤5:用Optimizely验证效果

- 根据前面的分析,优化prompt模板;

- 用Optimizely做A/B测试,证明“新模板的效果提升”;

- 推广显著的结果,迭代优化。

结论:提示工程的“数据驱动”,从选对工具开始

作为提示工程架构师,你的核心目标是让prompt更贴合用户需求——而用户行为数据,是连接“prompt”与“需求”的桥梁。

但“数据驱动”不是“堆数据”,而是用对工具,把数据变成“可行动的 insights”:

- 用ELK“存数据”,用Chatbase“看流程”,用spaCy“懂语义”,用Mixpanel“找规律”,用Optimizely“验效果”;

- 从“拍脑袋优化”变成“用数据证明优化”;

- 从“分析100条数据用3天”变成“分析10万条数据用1小时”。

最后,我想给你一个行动号召:

- 今天就选1款工具(比如Chatbase),导入你最近的对话日志,画一张“交互路径图”;

- 找出1个“用户修改的环节”,优化你的prompt模板;

- 用Optimizely做A/B测试,证明你的优化效果。

欢迎在评论区分享你的结果——比如“用Chatbase发现了什么修改模式?”“用Optimizely验证了什么效果?”。

未来,随着AI技术的发展,会有更多“贴合提示工程场景”的工具出现(比如自动分析prompt歧义的AI工具),但现在的5款工具,已经能帮你解决80%的问题。

把工具用起来,让数据说话——你会发现,提示工程的优化,其实没那么难。

附加部分

参考文献/延伸阅读

- Elastic Stack官方文档:https://www.elastic.co/guide/index.html

- Chatbase用户指南:https://chatbase.com/docs

- spaCy官方教程:https://spacy.io/usage

- Mixpanel行为分析指南:https://mixpanel.com/learn/

- Optimizely A/B测试最佳实践:https://www.optimizely.com/optimization-glossary/ab-testing/

致谢

感谢我的同事@小张(AI交互设计师),他分享了很多提示工程的实际案例;

感谢@小李(数据分析师),他帮我验证了工具的使用技巧;

感谢所有读者——你们的问题,是我写这篇文章的动力。

作者简介

我是@王大锤,资深软件工程师/技术博主,专注于提示工程、AI交互设计、用户行为分析。曾帮助5家AI公司优化prompt模板,提升用户反馈评分30%以上。

- 博客:https://www.dachui.tech

- 微信:dachui-tech

- 欢迎交流提示工程的问题!

最后的话:

提示工程的本质,是“用prompt连接用户需求与AI能力”——而用户行为数据,是你“读懂需求”的钥匙。选对工具,你就能更快拿到这把钥匙,打开“优化prompt的大门”。

下次再遇到“为什么这个prompt的反馈率低”的问题,记得:工具比手动分析更高效。

你最想用哪款工具?欢迎在评论区告诉我!

更多推荐

已为社区贡献111条内容

已为社区贡献111条内容

所有评论(0)