AI原生应用领域实体识别的深度学习方法实践

在AI原生应用(如智能助手、垂直领域知识图谱、个性化推荐系统)中,“理解文本”是核心能力。而实体识别(Named Entity Recognition, NER)作为自然语言处理(NLP)的“地基”,负责从文本中精准提取关键实体(如人名、机构名、时间、产品名),是后续语义分析、知识推理的前提。本文将围绕“如何用深度学习方法解决AI原生应用中的实体识别问题”展开,覆盖基础概念、经典模型(BiLSTM

AI原生应用领域实体识别的深度学习方法实践

关键词:实体识别(NER)、深度学习、AI原生应用、BiLSTM-CRF、BERT、信息抽取、自然语言处理(NLP)

摘要:本文聚焦AI原生应用场景下的实体识别技术,从核心概念到深度学习方法实践,结合代码示例和真实场景,系统讲解如何用深度学习解决实体识别问题。文章通过生活类比、技术原理解析、项目实战三部分,帮助读者理解实体识别的本质,并掌握从模型搭建到落地应用的全流程。

背景介绍

目的和范围

在AI原生应用(如智能助手、垂直领域知识图谱、个性化推荐系统)中,“理解文本”是核心能力。而实体识别(Named Entity Recognition, NER)作为自然语言处理(NLP)的“地基”,负责从文本中精准提取关键实体(如人名、机构名、时间、产品名),是后续语义分析、知识推理的前提。本文将围绕“如何用深度学习方法解决AI原生应用中的实体识别问题”展开,覆盖基础概念、经典模型(BiLSTM-CRF)、前沿模型(BERT)及实战落地。

预期读者

- 对NLP感兴趣的初学者(掌握Python基础即可)

- 希望将实体识别技术落地到AI应用的开发者

- 需要优化现有实体识别系统的算法工程师

文档结构概述

本文从“为什么需要实体识别”出发,用生活故事引出核心概念;通过“小学生能听懂的比喻”解释深度学习模型原理;结合PyTorch代码演示从数据处理到模型训练的全流程;最后总结AI原生场景下的实战经验与未来趋势。

术语表

- 实体识别(NER):从文本中识别并分类特定类型实体的任务(例:“小明在字节跳动工作”中,“小明”是人名,“字节跳动”是机构名)。

- AI原生应用:完全基于AI技术构建的应用(如ChatGPT、智能客服机器人),依赖NLP、CV等AI能力驱动核心功能。

- BiLSTM:双向长短期记忆网络,一种能捕捉文本前后文信息的神经网络(类比“能同时回忆前文和后文的记忆机”)。

- CRF:条件随机场,用于处理序列标签的依赖关系(类比“给标签加规则:人名后面不能接地名”)。

- BERT:基于Transformer的预训练模型,通过海量文本学习深层语义(类比“读过所有书的语言专家”)。

核心概念与联系

故事引入:智能客服的“信息提取危机”

想象你是某电商AI团队的工程师,需要为智能客服开发一个“订单问题识别”功能。用户会说:“我2023年11月11日在京东买了iPhone 15,到现在还没收到货!” 客服机器人需要快速提取关键实体:时间(2023年11月11日)、平台(京东)、产品(iPhone 15),才能定位问题。

传统规则方法(写一堆“时间格式匹配”“平台关键词库”)在面对“双11”“京西(笔误)”“iPhone十五”等变种时,准确率暴跌至60%。而深度学习方法能自动学习“时间可能包含数字+年月日”“平台名可能是电商APP名称”等模式,准确率提升到90%以上。这就是AI原生应用中实体识别的价值。

核心概念解释(像给小学生讲故事一样)

核心概念一:实体识别(NER)—— 文本中的“找主角游戏”

实体识别就像玩“找主角”游戏:给定一段文字,你需要用不同颜色的笔圈出“主角”,并标注他们的类型。

例:

输入文本:“张医生昨天在协和医院用辉瑞疫苗给李奶奶打了针。”

输出结果:

- 张医生(人名)

- 昨天(时间)

- 协和医院(机构名)

- 辉瑞疫苗(产品名)

- 李奶奶(人名)

核心概念二:深度学习方法—— 让电脑自己“学规则”

传统NER用“人工规则+关键词库”(像老师提前教电脑“看到‘医院’就标机构名”),但遇到“协和医院西院”“XX医院分部”就会出错。深度学习方法让电脑自己“从大量例子中总结规则”(像学生通过做1000道题,自己发现“机构名通常以‘医院’‘公司’结尾”)。

核心概念三:AI原生应用—— 完全“长在AI上”的工具

AI原生应用不是“传统软件+AI插件”,而是“核心功能由AI驱动”。例如:

- 智能助手Siri:通过NER提取“订明天10点的北京到上海的机票”中的时间(明天10点)、地点(北京、上海)、意图(订机票)。

- 医疗问诊APP:通过NER提取“咳嗽3天,体温38.5℃”中的症状(咳嗽)、时间(3天)、指标(38.5℃)。

核心概念之间的关系(用小学生能理解的比喻)

实体识别、深度学习、AI原生应用的关系,像“厨师、菜谱、餐厅”:

- 实体识别(厨师):负责“切菜”(提取关键信息),是AI原生应用的“基础技能”。

- 深度学习(菜谱):教厨师“如何切得更准”(自动学习规则),替代传统“刀工口诀”(人工规则)。

- AI原生应用(餐厅):需要“会切菜的厨师”(实体识别能力)才能做出“好吃的菜”(智能功能)。

核心概念原理和架构的文本示意图

AI原生应用的实体识别流程可总结为:

输入文本 → 分词 → 特征提取(词向量) → 模型预测(深度学习模型) → 输出实体标签

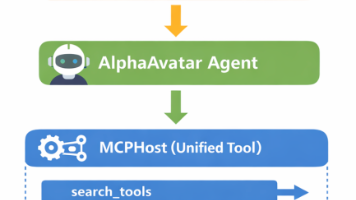

Mermaid 流程图

核心算法原理 & 具体操作步骤

经典模型:BiLSTM-CRF(双向长短期记忆网络+条件随机场)

原理拆解(用“快递员送包裹”类比)

-

BiLSTM:双向长短期记忆网络,像“能同时记住前面和后面包裹的快递员”。

假设文本是“张医生在协和医院”,BiLSTM会先从左到右读“张→医→生”,记住“张医生可能是人名”;再从右到左读“院→医→和→协”,记住“协和医院可能是机构名”。通过双向记忆,它能更准判断每个词的“上下文线索”。 -

CRF:条件随机场,像“给快递员加规则”。例如,规则“人名后面不能接时间”(如“张医生3点”中“张医生”是人名,“3点”是时间,符合规则),但“时间后面不能接人名”(如“3点张医生”也符合规则)。CRF通过学习大量文本中的“标签顺序”,自动生成这些规则,避免“人名后面突然出现地名”的不合理预测。

模型架构图

具体操作步骤(以PyTorch实现为例)

- 数据预处理:将文本转换为词向量,标签转换为数字(如“O”=0,“B-PER”=1,“I-PER”=2)。

- 构建BiLSTM层:定义输入维度(词向量长度)、隐藏层维度(如256)、双向(bidirectional=True)。

- 全连接层:将BiLSTM的输出(隐藏层特征)映射到标签数量(如10类标签)。

- CRF层:定义转移矩阵(标签间的转移概率),计算对数似然损失(训练时优化目标)。

前沿模型:BERT+CRF(预训练模型+条件随机场)

原理拆解(用“语言博士做NER”类比)

BERT是“读过所有书的语言博士”,通过预训练(在海量文本上学习)掌握了深层语义。例如,“苹果”在“吃苹果”中是水果,在“苹果公司”中是品牌,BERT能根据上下文自动区分。结合CRF后,相当于“语言博士+规则专家”,既懂语义又懂标签顺序,效果更优。

模型架构图

具体操作步骤(以Hugging Face库实现为例)

- 加载预训练BERT模型(如bert-base-uncased)。

- 添加CRF头:在BERT的输出层后接全连接层和CRF层。

- 微调训练:用自定义NER数据集(如医疗领域)微调BERT的参数,使其适应特定任务。

数学模型和公式 & 详细讲解 & 举例说明

BiLSTM的数学表达

BiLSTM的核心是“门控机制”,通过输入门( i t i_t it)、遗忘门( f t f_t ft)、输出门( o t o_t ot)控制记忆单元( c t c_t ct)的更新:

i t = σ ( W x i x t + W h i h t − 1 + b i ) f t = σ ( W x f x t + W h f h t − 1 + b f ) o t = σ ( W x o x t + W h o h t − 1 + b o ) c t = f t ⊙ c t − 1 + i t ⊙ tanh ( W x c x t + W h c h t − 1 + b c ) h t = o t ⊙ tanh ( c t ) i_t = \sigma(W_{xi}x_t + W_{hi}h_{t-1} + b_i) \\ f_t = \sigma(W_{xf}x_t + W_{hf}h_{t-1} + b_f) \\ o_t = \sigma(W_{xo}x_t + W_{ho}h_{t-1} + b_o) \\ c_t = f_t \odot c_{t-1} + i_t \odot \tanh(W_{xc}x_t + W_{hc}h_{t-1} + b_c) \\ h_t = o_t \odot \tanh(c_t) it=σ(Wxixt+Whiht−1+bi)ft=σ(Wxfxt+Whfht−1+bf)ot=σ(Wxoxt+Whoht−1+bo)ct=ft⊙ct−1+it⊙tanh(Wxcxt+Whcht−1+bc)ht=ot⊙tanh(ct)

其中, x t x_t xt是第 t t t步的输入, h t h_t ht是隐藏状态, σ \sigma σ是sigmoid函数, ⊙ \odot ⊙是逐元素乘法。

CRF的损失函数

CRF的目标是最大化正确标签序列的概率,损失函数为“所有可能序列的分数”与“正确序列分数”的差值(对数似然损失):

L = − log ( exp ( score ( y , x ) ) ∑ y ′ ∈ Y x exp ( score ( y ′ , x ) ) ) \mathcal{L} = -\log\left( \frac{\exp(\text{score}(y, x))}{\sum_{y' \in Y_x} \exp(\text{score}(y', x))} \right) L=−log(∑y′∈Yxexp(score(y′,x))exp(score(y,x)))

其中, score ( y , x ) \text{score}(y, x) score(y,x)是正确标签序列 y y y的分数(由BiLSTM的输出分数和CRF转移矩阵计算), Y x Y_x Yx是所有可能的标签序列。

BERT的注意力机制(简要)

BERT的核心是自注意力(Self-Attention),计算每个词与其他词的关联度(注意力权重):

Attention ( Q , K , V ) = softmax ( Q K T d k ) V \text{Attention}(Q, K, V) = \text{softmax}\left( \frac{QK^T}{\sqrt{d_k}} \right) V Attention(Q,K,V)=softmax(dkQKT)V

其中, Q Q Q(查询)、 K K K(键)、 V V V(值)是词向量的线性变换结果, d k d_k dk是向量维度。

项目实战:代码实际案例和详细解释说明

开发环境搭建

- 系统:Windows/Linux/macOS

- 工具:Python 3.8+、PyTorch 2.0+、transformers 4.30+、numpy、pandas

- 数据集:CoNLL-2003(通用NER数据集,含人名PER、地点LOC、机构名ORG、其他MISC四类实体)

源代码详细实现和代码解读(以BiLSTM-CRF为例)

步骤1:数据预处理

CoNLL-2003的每行是“词 词性 句法标签 实体标签”,例如:

EU NNP B-NP B-ORG

rejects VBZ B-VP O

German JJ B-NP B-MISC

call NN I-NP O

to TO B-VP O

boycott VB I-VP O

British JJ B-NP B-MISC

lamb NN I-NP O

. . O O

我们需要将文本和标签转换为数字索引。

# 加载数据并构建词表、标签表

def load_data(file_path):

with open(file_path, 'r') as f:

lines = f.read().split('\n')

sentences = []

labels = []

current_sentence = []

current_labels = []

for line in lines:

if line.strip() == '':

if current_sentence:

sentences.append(current_sentence)

labels.append(current_labels)

current_sentence = []

current_labels = []

else:

parts = line.split()

current_sentence.append(parts[0])

current_labels.append(parts[-1])

return sentences, labels

# 构建词到索引的映射(vocab)和标签到索引的映射(label2id)

sentences, labels = load_data('conll2003/train.txt')

vocab = {'<PAD>': 0, '<UNK>': 1}

for sent in sentences:

for word in sent:

if word not in vocab:

vocab[word] = len(vocab)

label2id = {'O': 0, 'B-PER': 1, 'I-PER': 2, 'B-LOC': 3, 'I-LOC': 4, 'B-ORG': 5, 'I-ORG': 6, 'B-MISC': 7, 'I-MISC': 8}

id2label = {v: k for k, v in label2id.items()}

步骤2:构建BiLSTM-CRF模型

import torch

import torch.nn as nn

from torchcrf import CRF # 需安装torchcrf库(pip install torchcrf)

class BiLSTM_CRF(nn.Module):

def __init__(self, vocab_size, embed_dim, hidden_dim, num_tags):

super(BiLSTM_CRF, self).__init__()

self.embedding = nn.Embedding(vocab_size, embed_dim, padding_idx=0)

self.bilstm = nn.LSTM(embed_dim, hidden_dim, bidirectional=True, batch_first=True)

self.fc = nn.Linear(2*hidden_dim, num_tags) # 双向LSTM输出是2*hidden_dim

self.crf = CRF(num_tags, batch_first=True)

def forward(self, x, mask=None):

# x: (batch_size, seq_len)

x_embed = self.embedding(x) # (batch_size, seq_len, embed_dim)

lstm_out, _ = self.bilstm(x_embed) # (batch_size, seq_len, 2*hidden_dim)

logits = self.fc(lstm_out) # (batch_size, seq_len, num_tags)

return logits

def loss(self, logits, tags, mask=None):

# 计算CRF损失(负对数似然)

return -self.crf(logits, tags, mask=mask, reduction='mean')

def predict(self, logits, mask=None):

# 解码最优标签序列

return self.crf.decode(logits, mask=mask)

步骤3:训练与评估

from torch.utils.data import Dataset, DataLoader

class NERDataset(Dataset):

def __init__(self, sentences, labels, vocab, label2id, max_len=128):

self.sentences = sentences

self.labels = labels

self.vocab = vocab

self.label2id = label2id

self.max_len = max_len

def __len__(self):

return len(self.sentences)

def __getitem__(self, idx):

sent = self.sentences[idx][:self.max_len]

label = self.labels[idx][:self.max_len]

# 转换为词索引(未知词用<UNK>)

sent_ids = [self.vocab.get(word, 1) for word in sent]

# 填充到max_len

pad_len = self.max_len - len(sent_ids)

sent_ids += [0] * pad_len

label_ids = [self.label2id.get(lab, 0) for lab in label] + [0] * pad_len

# 生成mask(非填充位置为1)

mask = [1] * len(sent) + [0] * pad_len

return {

'input_ids': torch.tensor(sent_ids, dtype=torch.long),

'tags': torch.tensor(label_ids, dtype=torch.long),

'mask': torch.tensor(mask, dtype=torch.bool)

}

# 初始化模型、优化器

vocab_size = len(vocab)

embed_dim = 100

hidden_dim = 128

num_tags = len(label2id)

model = BiLSTM_CRF(vocab_size, embed_dim, hidden_dim, num_tags)

optimizer = torch.optim.Adam(model.parameters(), lr=1e-3)

# 训练循环

train_dataset = NERDataset(sentences, labels, vocab, label2id)

train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True)

for epoch in range(10):

model.train()

total_loss = 0

for batch in train_loader:

input_ids = batch['input_ids']

tags = batch['tags']

mask = batch['mask']

logits = model(input_ids)

loss = model.loss(logits, tags, mask)

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

print(f'Epoch {epoch+1}, Loss: {total_loss/len(train_loader):.4f}')

代码解读与分析

- 数据预处理:将文本转换为数字索引,方便模型处理;通过

max_len控制句子长度,避免计算量过大。 - BiLSTM层:通过双向LSTM捕捉上下文信息,输出每个词的特征向量。

- CRF层:通过学习标签间的转移概率(如“B-PER”后更可能接“I-PER”),提升序列标签的合理性。

- 损失函数:CRF的负对数似然损失,直接优化标签序列的整体概率,比逐词分类(如交叉熵)更符合NER的序列特性。

实际应用场景

场景1:智能客服的问题分类

某电商AI客服需要识别用户问题中的“商品名”“订单号”“时间”,例如:“我10月5日买的iPhone 15(订单号123456)还没发货!”。通过实体识别提取“10月5日”(时间)、“iPhone 15”(商品名)、“123456”(订单号),系统可自动关联订单并触发催单流程。

场景2:医疗知识图谱构建

在医疗领域,需要从病历中提取“疾病名”(如“糖尿病”)、“药物名”(如“胰岛素”)、“检查项”(如“血糖检测”)。深度学习模型(如BERT+CRF)能准确识别这些实体,帮助构建医疗知识图谱,支持智能问诊和辅助诊断。

场景3:新闻内容理解与推荐

新闻APP需要根据内容推荐给用户,例如:“梅西加盟迈阿密国际”中提取“梅西”(人名)、“迈阿密国际”(机构名)。通过实体识别,系统可判断用户是否关注“梅西”或“足球”,从而推荐相关新闻。

工具和资源推荐

-

数据集:

- CoNLL-2003(通用NER)

- OntoNotes 5.0(多领域NER)

- 医疗领域:BC5CDR、NCBI-disease

- 中文领域:CLUENER(细粒度中文NER)

-

工具库:

- Hugging Face Transformers(BERT等预训练模型)

- spaCy(内置NER组件,支持快速开发)

- HanLP(中文NLP工具包,支持多类型实体识别)

-

可视化工具:

- Label Studio(数据标注工具,支持NER标注)

- Displacy(spaCy的实体可视化工具,可直观查看识别结果)

未来发展趋势与挑战

趋势1:多模态实体识别

AI原生应用(如智能车机)需要处理“语音+文本+图像”多模态输入。例如,用户说“导航去最近的星巴克”,同时屏幕显示星巴克logo。多模态实体识别可结合语音文本中的“星巴克”和图像中的logo,提升识别准确率。

趋势2:小样本/零样本学习

标注大量数据成本高(尤其垂直领域如法律、医疗),未来模型需通过少量样本(甚至无样本)学习新实体类型。例如,用“产品名”的定义(如“公司推出的具体商品”)指导模型识别未标注的“新款耳机X”。

挑战1:动态实体识别

新兴实体(如“元宇宙”“AIGC”)不断涌现,模型需快速适应。传统方法需重新标注数据并训练,未来可能通过“持续学习”(Continuum Learning)让模型在不遗忘旧知识的情况下学习新实体。

挑战2:跨领域泛化

在AI原生应用中,模型可能需要同时处理“电商”“医疗”“教育”等多个领域的文本。如何让模型在不同领域间灵活切换(而不是为每个领域训练一个模型),是未来的关键问题。

总结:学到了什么?

核心概念回顾

- 实体识别(NER):从文本中提取关键实体并分类,是AI原生应用的“信息提取器”。

- 深度学习方法:BiLSTM-CRF(捕捉上下文+标签依赖)、BERT+CRF(预训练语义+标签规则)是主流方案。

- AI原生应用:依赖实体识别等AI能力驱动核心功能,对NER的准确性和适应性要求更高。

概念关系回顾

- 深度学习是实体识别的“技术引擎”,让模型从数据中自动学习规则。

- 实体识别是AI原生应用的“基础组件”,支撑智能客服、知识图谱等功能。

思考题:动动小脑筋

-

场景题:假设你要为宠物医院开发智能问诊系统,需要识别“症状”(如“呕吐”)、“时间”(如“3天”)、“药物”(如“益生菌”)。你会如何选择实体识别模型(BiLSTM-CRF vs BERT+CRF)?为什么?

-

技术题:在训练BiLSTM-CRF时,若模型对长句子(如200词以上)的识别效果下降,可能的原因是什么?如何优化?

-

开放题:AI原生应用可能需要处理“口语化文本”(如“我家猫吐了,从昨天夜里开始”),与“书面文本”(如“患猫出现呕吐症状,持续时间约12小时”)的实体分布差异很大。如何让模型同时适应这两种文本?

附录:常见问题与解答

Q:实体识别和关键词提取有什么区别?

A:关键词提取是提取文本中重要的词(如TF-IDF高的词),不关心类型;实体识别不仅要提取词,还要标注其类型(如人名、地名)。

Q:为什么选择CRF而不是直接用Softmax分类?

A:Softmax逐词分类,不考虑标签间的依赖(如“B-PER”后必须接“I-PER”或“O”);CRF通过转移矩阵建模标签顺序,能纠正“B-PER后接B-LOC”的错误。

Q:BERT做NER时,如何处理中文分词?

A:BERT使用字级输入(如“张医生”拆为“张”“医”“生”),通过上下文学习字的组合含义,避免了分词错误的影响(中文分词可能将“张医生”错误拆为“张”“医生”)。

扩展阅读 & 参考资料

- 《自然语言处理入门》(何晗):基础NLP知识,含NER章节。

- 《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》(原始论文)。

- Hugging Face官方文档:https://huggingface.co/docs

- CoNLL-2003数据集:https://www.clips.uantwerpen.be/conll2003/ner/

更多推荐

已为社区贡献111条内容

已为社区贡献111条内容

所有评论(0)