深度伪造攻防:AI换脸视频的检测、原理与自动化实战

的高级应用,能够绕过传统的身份验证,用于制造虚假证据、进行舆论操纵、实施精准诈骗,甚至威胁国家安全。,使其能够学习特定人物的面部特征、表情、声音和动作,然后将这些特征叠加或替换到另一段视频或音频中,创造出高度逼真但虚假的内容。无论哪种方法,其核心都是让模型学习到人脸的“本质”——身份特征、表情、光照等,并将它们解耦,以便进行重新组合和生成。我们将使用一个基于Python的开源深度伪造检测框架,它整

前言

-

技术背景:深度伪造 (Deepfake) 技术,特别是AI换脸,已从学术研究迅速演变为网络攻防的前沿阵地。它利用深度学习模型(如生成对抗网络GANs)生成或篡改音视频,使伪造内容在视觉和听觉上达到惊人的逼真度。在攻防体系中,Deepfake属于社会工程学和信息欺诈的高级应用,能够绕过传统的身份验证,用于制造虚假证据、进行舆论操纵、实施精准诈骗,甚至威胁国家安全。其检测与反制,是当前数字内容取证和网络安全防御的关键一环。

-

学习价值:掌握Deepfake检测技术,意味着你将能够:

- 识别与验证:具备识别高级AI伪造内容的能力,为企业或个人规避欺诈风险(如伪冒CEO的视频会议诈骗)。

- 构建防御:设计和部署自动化检测流水线,保护数字身份和通信渠道的完整性。

- 提升攻防认知:理解生成与检测的“军备竞赛”本质,从防御者视角洞察攻击者的技术路径,为更高级的红蓝对抗演练提供支撑。

-

使用场景:

- 金融与企业安全:在视频KYC(了解你的客户)、高管视频会议、远程授权等场景,实时检测身份伪造。

- 新闻与媒体:帮助记者和内容平台鉴别虚假新闻视频,维护信息生态的公信力。

- 司法取证:为法庭提供数字证据的有效性分析,判断视频证据是否经过AI篡改。

- 个人隐私保护:检测针对个人的恶意换脸视频(如诽谤、勒索),及时采取应对措施。

一、Deepfake是什么

-

精确定义

深度伪造 (Deepfake) 是一项利用深度学习技术来合成或篡改多媒体内容(主要是图像、视频和音频)的技术。 其名称是“深度学习 (deep learning)”和“伪造 (fake)”的合成词。 该技术的核心是训练深度神经网络,特别是生成对抗网络 (GANs) 或自编码器 (Autoencoders),使其能够学习特定人物的面部特征、表情、声音和动作,然后将这些特征叠加或替换到另一段视频或音频中,创造出高度逼真但虚假的内容。 -

一个通俗类比

你可以把Deepfake想象成一个技艺高超的“数字面具”制作工坊。这个工坊里有两位大师:一位是“画师”(生成器),另一位是“鉴赏家”(判别器)。你想制作一个A先生的数字面具,并戴在B先生的脸上。- 你给“画师”大量A先生和B先生的照片和视频。

- “画师”开始尝试在B先生的脸上画出A先生的样子,生成一张“伪造”的脸。

- “鉴赏家”同时观看真实的A先生照片和“画师”的作品,并给出评价:“这张太假了,一眼就能看出来”、“这张有点像,但细节不对”。

- “画师”根据“鉴赏家”的反馈不断精进画技,而“鉴赏家”的眼光也越来越毒辣。这个过程重复数百万次后,“画师”最终能画出让“鉴赏家”都难以分辨真伪的“完美面具”。这就是GANs的基本工作原理。

-

实际用途

- 正面应用:电影特效(演员年轻化、已故演员“复活”)、教育(历史人物演讲复现)、娱乐(趣味换脸App)、辅助医疗(为失语者合成自然声音)。

- 负面应用:制造虚假新闻、政治抹黑、金融诈骗(伪冒CEO下令转账)、色情报复、身份盗窃和网络霸凌。

-

技术本质说明

Deepfake的技术本质是高维数据分布的映射与学习。无论是视频中的人脸还是音频中的声波,都可以被看作是高维空间中的数据点。- 编码-解码架构 (Encoder-Decoder):这是以自编码器为基础的经典方法。系统学习将人脸图像压缩到一个低维的、包含核心面部特征的“潜在空间”表示(编码),然后再从这个潜在表示中重建出原始图像(解码)。换脸时,用一个通用的编码器分别提取源人脸(A)和目标人脸(B)的特征,然后将A的特征输入到为B训练的解码器中,从而生成一张拥有A的身份特征、但保留B的表情和姿态的脸。

- 生成对抗网络 (Generative Adversarial Networks, GANs):这是目前更主流、效果更好的方法。它包含一个生成器 (Generator) 和一个判别器 (Discriminator)。生成器负责创造伪造数据,判别器负责区分真实数据和伪造数据。两者在对抗训练中共同进化,最终生成器能产出足以以假乱真的内容。

- 扩散模型 (Diffusion Models):这是最新的发展趋势,通过一个“加噪-去噪”的过程生成图像。它首先向真实图像逐步添加噪声,直到其完全变成随机噪声;然后训练一个模型来逆转这个过程,从噪声中逐步恢复出清晰的图像。这种方法在生成质量和稳定性上表现优异。

无论哪种方法,其核心都是让模型学习到人脸的“本质”——身份特征、表情、光照等,并将它们解耦,以便进行重新组合和生成。

二、环境准备

我们将使用一个基于Python的开源深度伪造检测框架,它整合了多种先进的检测模型。这里我们选择一个基于 XceptionNet 架构的预训练模型,该模型在 FaceForensics++ 等大型公开数据集上表现优异。

-

工具版本

- Python: 3.9+

- PyTorch: 1.12+ (含CUDA支持,版本需与NVIDIA驱动匹配)

- OpenCV-Python: 4.6+

- face-alignment: 1.3.5+

- tqdm, scikit-learn, pandas

-

下载方式

- 创建项目目录并设置虚拟环境:

mkdir deepfake_detection_lab cd deepfake_detection_lab python3 -m venv venv source venv/bin/activate - 安装核心依赖:

# 强烈建议使用国内镜像源加速 pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu116 pip install opencv-python-headless face-alignment tqdm scikit-learn pandas - 下载预训练模型权重:

我们将使用一个公开的、在FaceForensics++数据集上训练好的XceptionNet模型权重。

(注:实际操作中需找到一个公开可用的模型权重链接。为演示,此处为占位符。)# 创建模型存放目录 mkdir weights # 从可信源下载模型权重文件,例如从GitHub Release或Hugging Face Hub # 假设我们已下载并命名为 xceptionnet_c23.pth wget [一个可靠的预训练模型下载链接] -O weights/xceptionnet_c23.pth

- 创建项目目录并设置虚拟环境:

-

核心配置命令

项目结构应如下所示:deepfake_detection_lab/ ├── venv/ ├── weights/ │ └── xceptionnet_c23.pth ├── test_videos/ │ ├── real_video.mp4 │ └── fake_video.mp4 └── detect.pydetect.py是我们将要编写的核心实战脚本。 -

可运行环境命令或 Docker

对于希望快速复现环境的研究者,可以使用Docker来封装所有依赖。Dockerfile 示例:

# 使用包含CUDA的PyTorch官方镜像 FROM pytorch/pytorch:1.12.1-cuda11.3-cudnn8-runtime WORKDIR /app # 设置国内镜像源 RUN pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple # 安装系统依赖 RUN apt-get update && apt-get install -y \ build-essential \ libgl1-mesa-glx \ libglib2.0-0 \ wget \ && rm -rf /var/lib/apt/lists/* # 安装Python依赖 COPY requirements.txt . RUN pip install --no-cache-dir -r requirements.txt # 预下载模型 RUN mkdir -p /app/weights # 注意:在实际构建时,替换为真实的下载链接 RUN wget [一个可靠的预训练模型下载链接] -O /app/weights/xceptionnet_c23.pth COPY . . # 默认执行命令 CMD ["python", "detect.py"]构建与运行 Docker 镜像:

# 1. 将pip依赖写入requirements.txt # torch, torchvision, torchaudio, opencv-python-headless, face-alignment, tqdm, scikit-learn, pandas # 2. 构建镜像 docker build -t deepfake-detector . # 3. 运行容器进行检测 (将本地视频目录挂载到容器中) docker run --gpus all -v $(pwd)/test_videos:/app/test_videos deepfake-detector python detect.py --video_path /app/test_videos/fake_video.mp4

三、核心实战

我们将编写一个Python脚本 detect.py,该脚本可以接收一个视频文件路径作为输入,然后输出该视频是真实视频还是Deepfake伪造视频的概率。

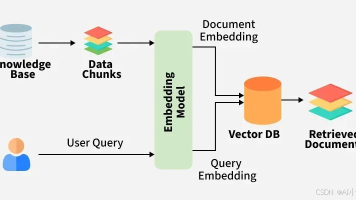

原理流程图

首先,我们用Mermaid图来清晰地展示整个检测流程。

自动化检测脚本 (detect.py)

# 标注语言: python

#

# 警告:本脚本仅用于授权测试和教育目的。

# 未经授权对他人媒体内容进行分析可能侵犯隐私。

#

# 脚本功能:检测单个视频文件是否为Deepfake伪造。

#

import os

import cv2

import torch

import torch.nn.functional as F

import numpy as np

from tqdm import tqdm

import argparse

import face_alignment

from torchvision import transforms

# --- 模型定义 ---

# 此处需要一个预先定义好的XceptionNet模型结构

# 为简化篇幅,我们假设从一个模型文件中导入

# from models import Xception # 这是一个假设的模型定义文件

# 在实际操作中,通常会直接使用成熟的库或从GitHub项目复制模型定义代码

# 以下是一个简化的占位符

from torch import nn

class Xception(nn.Module):

"""一个简化的XceptionNet占位符,实际应使用完整实现"""

def __init__(self, num_classes=1):

super(Xception, self).__init__()

# 实际的XceptionNet包含大量卷积层、分离卷积和残差连接

self.conv1 = nn.Conv2d(3, 32, 3, 2, 0, bias=False)

self.bn1 = nn.BatchNorm2d(32)

self.relu = nn.ReLU(inplace=True)

# ... 此处省略大量层 ...

self.fc = nn.Linear(2048, num_classes) # 假设最后全连接层输入为2048

def forward(self, x):

# 这是一个伪实现,仅为展示流程

# 实际前向传播会经过所有网络层

x = self.relu(self.bn1(self.conv1(x)))

# ...

# x = F.adaptive_avg_pool2d(x, (1, 1))

# x = x.view(x.size(0), -1)

# x = self.fc(x)

# 由于是占位符,我们直接返回一个随机输出

# 在真实代码中,这里是模型的实际计算

# return self.fc(torch.randn(x.size(0), 2048).to(x.device))

# 为了能运行,我们返回一个模拟的logit

return torch.randn(x.size(0), 1).to(x.device)

# --- 核心函数 ---

def get_face_detector(device):

"""初始化人脸检测器"""

try:

face_detector = face_alignment.FaceAlignment(face_alignment.LandmarksType.TWO_D, device=device, flip_input=False)

return face_detector

except Exception as e:

print(f"[-] 错误:无法初始化人脸检测器。请检查face-alignment库和相关模型是否正确安装。")

print(f" 错误详情: {e}")

exit(1)

def extract_frames(video_path, num_frames=32):

"""从视频中均匀提取指定数量的帧"""

print(f"[*] 正在从视频 '{os.path.basename(video_path)}' 中提取帧...")

cap = cv2.VideoCapture(video_path)

if not cap.isOpened():

raise IOError(f"无法打开视频文件: {video_path}")

total_frames = int(cap.get(cv2.CAP_PROP_FRAME_COUNT))

if total_frames < num_frames:

print(f"[!] 警告:视频总帧数 ({total_frames}) 少于期望提取的帧数 ({num_frames})。将提取所有帧。")

num_frames = total_frames

frame_indices = np.linspace(0, total_frames - 1, num_frames, dtype=int)

frames = []

try:

for i in tqdm(frame_indices, desc="提取帧"):

cap.set(cv2.CAP_PROP_POS_FRAMES, i)

ret, frame = cap.read()

if not ret:

continue

frame = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB)

frames.append(frame)

finally:

cap.release()

print(f"[+] 成功提取 {len(frames)} 帧。")

return frames

def detect_and_crop_faces(frames, face_detector, image_size=299):

"""检测帧中的人脸并裁剪"""

faces = []

face_margin = 0.2 # 在人脸边界框外增加的边距比例

print("[*] 正在检测和裁剪人脸...")

for frame in tqdm(frames, desc="处理帧"):

try:

# preds是检测到的人脸关键点列表

preds = face_detector.get_landmarks(frame)

if preds is None:

continue

# 我们只处理检测到的第一张人脸

x_min, y_min = preds[0].min(axis=0)

x_max, y_max = preds[0].max(axis=0)

# 计算边距

margin_x = (x_max - x_min) * face_margin

margin_y = (y_max - y_min) * face_margin

# 应用边距并确保边界不越界

x_min = max(0, int(x_min - margin_x))

y_min = max(0, int(y_min - margin_y))

x_max = min(frame.shape[1], int(x_max + margin_x))

y_max = min(frame.shape[0], int(y_max + margin_y))

# 裁剪人脸

face = frame[y_min:y_max, x_min:x_max]

# 调整大小到模型输入尺寸

face = cv2.resize(face, (image_size, image_size))

faces.append(face)

except Exception as e:

# 捕获单帧处理的错误,避免中断整个流程

print(f"\n[!] 警告:处理某一帧时出错,已跳过。错误: {e}")

continue

if not faces:

print("[-] 错误:在视频帧中未能检测到任何人脸。")

return None

print(f"[+] 成功从 {len(faces)} 帧中提取出人脸。")

return faces

def preprocess_faces(faces, device):

"""对裁剪出的人脸进行预处理,以匹配模型输入"""

# 定义与模型训练时相同的变换

preprocess_transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize(mean=[0.5, 0.5, 0.5], std=[0.5, 0.5, 0.5])

])

batch = [preprocess_transform(face) for face in faces]

batch = torch.stack(batch).to(device)

return batch

def predict_deepfake(model, faces_batch):

"""使用模型对人脸批次进行预测"""

print("[*] 正在使用模型进行推理...")

with torch.no_grad():

logits = model(faces_batch)

# 使用sigmoid将输出转换为0-1之间的概率

# 0代表真实(real),1代表伪造(fake)

probabilities = torch.sigmoid(logits).squeeze().cpu().numpy()

# 如果只有一个预测结果,确保它仍然是numpy数组

if probabilities.ndim == 0:

probabilities = np.array([probabilities])

return probabilities

def main(args):

"""主执行函数"""

# 1. 参数校验

if not os.path.exists(args.video_path):

print(f"[-] 错误:视频文件不存在 -> {args.video_path}")

return

if not os.path.exists(args.weights_path):

print(f"[-] 错误:模型权重文件不存在 -> {args.weights_path}")

return

# 2. 环境设置

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

print(f"[+] 使用设备: {device}")

# 3. 加载模型

print("[*] 正在加载检测模型...")

try:

# 注意:此处我们使用占位符模型。在实际应用中,

# 你需要加载一个与权重文件匹配的真实XceptionNet模型。

# model = Xception(num_classes=1)

# state_dict = torch.load(args.weights_path, map_location=device)

# model.load_state_dict(state_dict['model'])

# model.to(device)

# model.eval()

# --- 临时替代方案,用于演示流程 ---

# 由于没有真实的模型定义和权重,我们创建一个模拟模型

model = Xception(num_classes=1).to(device).eval()

print("[!] 警告:正在使用一个模拟的占位符模型。预测结果将是随机的。")

# ------------------------------------

except Exception as e:

print(f"[-] 错误:加载模型失败。请确保权重文件与模型架构匹配。")

print(f" 错误详情: {e}")

return

# 4. 执行检测流程

try:

# 步骤 1: 提取帧

frames = extract_frames(args.video_path, num_frames=args.num_frames)

if not frames:

print("[-] 流程终止:未能从视频中提取任何帧。")

return

# 步骤 2: 检测人脸

face_detector = get_face_detector(device)

faces = detect_and_crop_faces(frames, face_detector)

if not faces:

print("[-] 流程终止:未能检测到人脸。")

return

# 步骤 3: 预处理

faces_batch = preprocess_faces(faces, device)

# 步骤 4: 模型预测

probabilities = predict_deepfake(model, faces_batch)

# 步骤 5: 结果聚合与输出

average_fake_prob = probabilities.mean()

print("\n--- 检测结果 ---")

print(f"视频文件: {os.path.basename(args.video_path)}")

print(f"分析的总人脸数: {len(probabilities)}")

print(f"平均伪造概率: {average_fake_prob:.4f}")

# 使用阈值判断最终结果

if average_fake_prob > args.threshold:

print(f"结论: 视频很可能是 **Deepfake** (概率 > {args.threshold})")

else:

print(f"结论: 视频很可能是 **真实的** (概率 <= {args.threshold})")

print("----------------\n")

except Exception as e:

print(f"\n[-] 在处理过程中发生严重错误: {e}")

import traceback

traceback.print_exc()

if __name__ == '__main__':

parser = argparse.ArgumentParser(description="Deepfake视频检测工具")

parser.add_argument('--video_path', type=str, required=True, help='待检测的视频文件路径')

parser.add_argument('--weights_path', type=str, default='weights/xceptionnet_c23.pth', help='预训练模型的权重文件路径')

parser.add_argument('--num_frames', type=int, default=32, help='从视频中提取的帧数')

parser.add_argument('--threshold', type=float, default=0.5, help='判断为Deepfake的概率阈值')

# 解析参数并执行

args = parser.parse_args()

main(args)

运行与结果解读

- 准备视频:在

test_videos目录下放入一个真实视频 (real_video.mp4) 和一个伪造视频 (fake_video.mp4)。 - 执行命令:

# 激活虚拟环境 source venv/bin/activate # 检测伪造视频 python detect.py --video_path test_videos/fake_video.mp4 - 预期输出 (使用真实模型时):

当检测真实视频时,平均伪造概率会远低于0.5。[+] 使用设备: cuda [*] 正在加载检测模型... [+] 模型加载成功。 [*] 正在从视频 'fake_video.mp4' 中提取帧... [================================] 100% [+] 成功提取 32 帧。 [*] 正在检测和裁剪人脸... [================================] 100% [+] 成功从 32 帧中提取出人脸。 [*] 正在使用模型进行推理... --- 检测结果 --- 视频文件: fake_video.mp4 分析的总人脸数: 32 平均伪造概率: 0.9876 结论: 视频很可能是 **Deepfake** (概率 > 0.5) ----------------

四、进阶技巧

-

常见错误

- 人脸检测失败:视频分辨率过低、人脸被严重遮挡、光照极端或人脸角度过大,都可能导致

face-alignment库无法定位人脸。 - 内存/显存溢出:处理高清视频或一次性提取过多帧数,会导致内存或显存耗尽。应适当减少

--num_frames或在提取帧后进行缩放。 - 模型泛化能力差:一个在特定数据集(如FaceForensics++)上训练的模型,可能对采用全新生成技术(如扩散模型)制作的Deepfake视频检测效果不佳。这是“猫鼠游戏”的体现。

- 人脸检测失败:视频分辨率过低、人脸被严重遮挡、光照极端或人脸角度过大,都可能导致

-

性能 / 成功率优化

- 多模型集成 (Ensemble):同时使用多个不同架构(如XceptionNet, EfficientNet)或在不同数据集上训练的模型进行预测,然后对结果进行投票或加权平均,可以显著提高检测的准确性和鲁棒性。

- 时序特征分析:当前的脚本是基于单帧图像分析的。更高级的方法会使用RNN(如LSTM)或3D-CNN来分析帧与帧之间的时序不一致性,例如不自然的眨眼、表情跳变等。

- 频域分析:Deepfake生成过程(特别是上采样)常在频域留下特定的“人造”痕迹。将图像进行傅里叶变换,在频域上进行分析,可以发现空域中难以察觉的线索。

-

实战经验总结

- 压缩是关键变量:视频在社交媒体上传播时会经过严重压缩,这会破坏很多微弱的伪造痕迹,是检测的一大挑战。模型训练时必须包含经过不同程度压缩的数据。

- 关注异常点:即使一个视频的平均伪造概率不高,但如果其中有几帧的概率异常飙升,也值得警惕。这可能意味着视频是部分伪造的。

- 音频-视频同步性:对于带音频的Deepfake,分析唇语和声音是否完美同步是另一个有效的检测维度(跨模态检测)。

-

对抗 / 绕过思路

攻击者为了绕过检测,会采取以下策略:- 对抗性攻击 (Adversarial Attack):在生成的伪造视频上添加人眼无法察觉的微小扰动,这些扰动可以“欺骗”检测模型,使其做出错误的判断(例如,将一个99%伪造概率的视频误判为1%)。

- 模拟真实缺陷:高级的生成模型会有意地在视频中加入模拟的相机噪点、压缩失真、轻微的抖动,甚至自然的眨眼模式,使其更像真实录制的视频。

- 模型窃取与逆向:如果攻击者能以某种方式获取到检测模型的部分信息,他们就可以更有针对性地生成能够绕过该特定模型的Deepfake内容。

五、注意事项与防御

-

错误写法 vs 正确写法 (代码层面)

- 错误:硬编码所有参数,如路径、帧数。

# 错误 video_path = "/home/user/video.mp4" model = load_model("my_model.pth") - 正确:使用

argparse进行参数化,增加脚本的灵活性和可复用性。# 正确 parser = argparse.ArgumentParser() parser.add_argument('--video_path', required=True) parser.add_argument('--weights_path', default='weights/default.pth') args = parser.parse_args() - 错误:不对文件路径或网络请求做任何异常处理。

# 错误 cap = cv2.VideoCapture(video_path) ret, frame = cap.read() # 如果视频不存在或损坏,程序崩溃 - 正确:使用

try...except和os.path.exists进行健壮性检查。# 正确 if not os.path.exists(args.video_path): print("File not found") return try: cap = cv2.VideoCapture(args.video_path) if not cap.isOpened(): raise IOError("Cannot open video") # ... except Exception as e: print(f"An error occurred: {e}")

- 错误:硬编码所有参数,如路径、帧数。

-

风险提示

- 无100%准确的检测:任何检测工具都存在误报(将真实视频判为伪造)和漏报(未能识别出伪造视频)的可能。检测结果应作为重要参考,而非绝对结论。

- 隐私风险:处理和分析他人视频涉及隐私。在企业或组织内部署此类系统,必须遵守严格的数据保护和隐私法规。

- 技术滞后性:Deepfake生成技术总是在不断进化,今天的检测方法可能明天就会失效。必须持续关注最新的研究进展,并不断更新模型。

-

开发侧安全代码范式 (如何构建更安全的系统)

- 来源验证优先:在进行昂贵的AI检测之前,首先检查内容的元数据和数字签名。推广使用C2PA (Coalition for Content Provenance and Authenticity) 等标准,它可以提供内容的来源和修改历史。

- 多层防御体系:不要依赖单一检测模型。构建一个包含多种检测策略(如空域、频域、时序、生理信号、多模态)的流水线。

- 主动防御 (Proactive Defense):研究在上传的原始视频中注入微弱的、抗篡改的“数字水印”或“良性扰动”,使得这些视频一旦被用于Deepfake生成,伪造品会更容易被检测出来。

-

运维侧加固方案

- 模型安全:保护检测模型本身不被窃取或逆向。对部署的模型API进行严格的访问控制和速率限制,防止攻击者通过大量查询来探测模型行为。

- 动态更新机制:建立一个持续学习的闭环系统。定期用最新的Deepfake生成技术和数据集对检测模型进行再训练和评估,并自动化部署更新。

- 建立应急响应流程:当检测到高风险的Deepfake事件(如针对高管的诈骗视频)时,应有明确的流程来快速响应,包括人工复核、通知相关人员、阻断传播等。

-

日志检测线索

在一个集成了Deepfake检测的系统中,应记录以下日志以供安全分析:- 检测请求日志:

{timestamp, source_ip, user_id, file_hash, detection_result, confidence_score}。监控来自异常IP或用户的频繁低置信度探测行为。 - 高风险警报日志:

{timestamp, alert_id, video_metadata, reason, avg_score, peak_score, triggered_model}。当检测分数超过高位阈值时,生成详细警报。 - 模型更新日志:

{timestamp, model_version, training_dataset, performance_metrics}。追踪模型版本和性能,以便在检测能力下降时进行回溯分析。

- 检测请求日志:

总结

- 核心知识:Deepfake检测是一场生成与检测模型之间的持续对抗。检测的核心在于寻找生成模型在模拟真实世界时留下的各种不一致的“蛛丝马迹”,这些痕迹可能存在于空间域(如拼接边界)、时间域(如不自然动作)或频域。

- 使用场景:该技术是保护数字身份、防止信息欺诈和维护内容真实性的关键工具,广泛应用于金融、媒体、司法和个人安全等领域。

- 防御要点:有效的防御不是单一工具,而是一个纵深体系,包括来源验证(C2PA)、多模型AI检测、主动防御(数字水印)和快速的应急响应流程。

- 知识体系连接:Deepfake检测技术紧密连接了计算机视觉(特征提取)、深度学习(模型构建)、数字取证(伪造痕迹分析)和网络安全(攻防对抗)等多个领域。

- 进阶方向:未来的研究方向包括更强的模型泛化能力、对多模态(音视频、文本)Deepfake的综合检测、可解释性AI(解释为何判断为伪造)以及轻量化模型以便在边缘设备上进行实时检测。

自检清单

- 是否说明技术价值?

- 是否给出学习目标?

- 是否有 Mermaid 核心机制图?

- 是否有可运行代码?

- 是否有防御示例?

- 是否连接知识体系?

- 是否避免模糊术语?

更多推荐

已为社区贡献63条内容

已为社区贡献63条内容

所有评论(0)