AI 预测风暴:利用机器学习预测零日漏洞的实战教程

我们让这位“医生”学习了数百万份“健康”的病历(正常代码)和“生病”的病历(漏洞代码)。通过学习,它总结出了“疾病”(漏洞)的各种“症状”(代码特征),比如“心率不齐”(不安全的函数调用)、“血压异常”(缓冲区操作缺乏边界检查)等。然后,将这些向量和它们对应的标签(“有漏洞”或“无漏洞”)一起喂给机器学习算法(如逻辑回归、随机森林、神经网络等)进行训练。CPG 是一种融合了抽象语法树(AST)、控

前言

-

技术背景:在现代网络攻防体系中,零日漏洞(0-day) 处于攻击链的顶端,是最高价值的战略资源。传统漏洞挖掘依赖于专家经验和大量重复性劳动,效率和覆盖面都面临瓶颈。将人工智能(AI),特别是机器学习,引入漏洞预测领域,是从被动防御向预测性防御(Predictive Defense)转变的关键一步,它改变了我们识别和评估潜在威胁的游戏规则。

-

学习价值:掌握利用 AI 预测漏洞的方法,你将能够:

- 解决效率问题:从海量代码或二进制文件中,自动化地筛选出最有可能存在漏洞的高风险区域,极大提升漏洞挖掘的效率和精准度。

- 提升认知维度:从“代码审计”的微观视角,提升到“软件供应链风险度量”的宏观视角,能对整个项目或依赖库进行快速风险评估。

- 增强预警能力:在漏洞被公开利用之前,提前识别并修复潜在的“准零日漏洞”,将安全防御窗口前置。

-

使用场景:这项技术在实战中应用广泛,主要包括:

- 大型软件供应链安全审计:对拥有数千个开源依赖的项目进行快速风险排序。

- 二进制文件(IoT/固件)漏洞挖掘:在没有源码的情况下,分析固件更新补丁,预测新版本中可能存在的漏洞。

- 代码开发阶段(DevSecOps):在 CI/CD 流程中集成,自动扫描每次代码提交,识别高风险代码变更。

- 威胁情报分析:结合漏洞数据库和代码演进历史,预测未来可能被利用的漏洞类型和攻击向量。

一、AI 预测漏洞是什么

1. 精确定义

利用 AI 预测零日漏洞,指的是应用机器学习(Machine Learning)或深度学习(Deep Learning)模型,通过学习海量已知漏洞代码和非漏洞代码的特征,构建一个分类或回归模型,该模型能够对新的、未知的代码片段、二进制文件或软件补丁进行分析,并预测其包含潜在安全漏洞的可能性。其核心是从历史数据中发现漏洞模式,并将其泛化到未来的代码中。

2. 一个通俗类比

这就像训练一位经验丰富的“AI代码医生”。我们让这位“医生”学习了数百万份“健康”的病历(正常代码)和“生病”的病历(漏洞代码)。通过学习,它总结出了“疾病”(漏洞)的各种“症状”(代码特征),比如“心率不齐”(不安全的函数调用)、“血压异常”(缓冲区操作缺乏边界检查)等。当一份新的“体检报告”(新代码)送来时,这位“AI医生”就能快速判断其“患病风险”有多高。

3. 实际用途

- 风险排序:帮助安全团队优先审计最可疑的代码,而不是盲目地检查所有内容。

- 补丁分析:自动化分析软件更新补丁,快速定位修复了哪些漏洞,甚至发现补丁引入的新问题。

- 代码审计辅助:作为静态代码分析(SAST)工具的补充,发现传统规则难以覆盖的、更复杂的逻辑漏洞。

- 威胁狩猎:在野外捕获到恶意软件后,分析其利用的二进制程序,快速找到其利用的漏洞点。

4. 技术本质说明

AI 预测漏洞的技术本质是有监督的分类问题。我们将代码或二进制文件转化为计算机可以理解的数值向量(Vector),这个过程称为特征工程(Feature Engineering)。然后,将这些向量和它们对应的标签(“有漏洞”或“无漏洞”)一起喂给机器学习算法(如逻辑回归、随机森林、神经网络等)进行训练。训练完成后,模型就学会了从代码特征到漏洞可能性的映射关系。

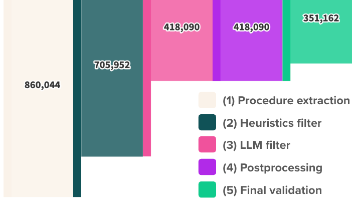

其核心流程可以用下面的 Mermaid 图清晰地展示:

这张图清晰地展示了从数据准备到最终预测的完整生命周期,是理解 AI 预测漏洞原理 的核心框架。

二、环境准备

我们将使用一个业界知名的漏洞预测数据集 Devign 和一个基于图神经网络(GNN)的经典模型来进行本次实战。

- 操作系统:Ubuntu 22.04 LTS

- 核心框架:PyTorch, DGL (Deep Graph Library)

- 工具版本:

- Python: 3.10+

- PyTorch: 2.0+

- DGL: 1.1+

- Joern: 1.2+ (用于代码属性图生成)

- scikit-learn: 1.2+

1. 下载方式

a. 安装 Joern (代码分析工具)

Joern 是一个强大的代码分析平台,用于从源码生成代码属性图(CPG)。我们将使用它来完成特征工程。

# 下载并安装 Joern

wget https://github.com/joernio/joern/releases/latest/download/joern-install.sh

chmod +x joern-install.sh

./joern-install.sh

b. 创建 Python 虚拟环境并安装依赖

# 创建并激活虚拟环境

python3 -m venv venv-vuln-predict

source venv-vuln-predict/bin/activate

# 安装核心 Python 库

pip install torch dgl scikit-learn pandas tqdm

2. 核心配置命令

Joern 安装后,其可执行文件位于 ~/bin/joern。确保该路径在你的 PATH 环境变量中。

# 临时将 Joern 添加到 PATH (建议加入 .bashrc 或 .zshrc)

export PATH=$PATH:~/bin

3. 可运行环境 Docker

为了保证环境的一致性和可复现性,强烈建议使用 Docker。以下是 Dockerfile 示例:

# Dockerfile for Vulnerability Prediction Environment

FROM ubuntu:22.04

# 避免交互式安装

ENV DEBIAN_FRONTEND=noninteractive

# 安装基础依赖

RUN apt-get update && apt-get install -y \

wget \

unzip \

openjdk-17-jdk \

python3.10 \

python3.10-venv \

git \

&& rm -rf /var/lib/apt/lists/*

# 安装 Joern

RUN wget https://github.com/joernio/joern/releases/latest/download/joern-install.sh && \

chmod +x joern-install.sh && \

./joern-install.sh && \

rm joern-install.sh

# 设置 Joern 环境变量

ENV PATH="/root/bin:${PATH}"

# 设置工作目录

WORKDIR /app

# 创建并激活 Python 虚拟环境

RUN python3.10 -m venv /app/venv

ENV PATH="/app/venv/bin:${PATH}"

# 安装 Python 依赖

RUN . /app/venv/bin/activate && \

pip install --no-cache-dir torch dgl scikit-learn pandas tqdm

# 提示:将你的项目代码复制到 /app 目录下

# COPY . /app

CMD ["/bin/bash"]

构建和运行 Docker 容器:

# 构建镜像

docker build -t vuln-predict-env .

# 运行容器并进入交互式 Shell

docker run -it --rm -v $(pwd):/app vuln-predict-env

三、核心实战

我们将以一个简化的流程,演示如何利用 Joern 和一个简单的 GNN 模型对 C/C++ 代码进行漏洞预测。

1. 步骤一:准备数据集

首先,我们需要一个包含漏洞和非漏洞代码的 C/C++ 函数样本。为简化演示,我们手动创建两个文件。

vulnerable.c:

// 包含一个典型的缓冲区溢出漏洞

void vulnerable_function(char* input) {

char buffer[128];

strcpy(buffer, input); // 漏洞点:未检查输入长度

}

safe.c:

// 安全版本

void safe_function(char* input) {

char buffer[128];

strncpy(buffer, input, sizeof(buffer) - 1); // 安全:使用 strncpy

buffer[sizeof(buffer) - 1] = '\0';

}

2. 步骤二:使用 Joern 生成代码属性图 (CPG)

CPG 是一种融合了抽象语法树(AST)、控制流图(CFG)和程序依赖图(PDG)的图结构,非常适合用于代码的深度分析。

# 为我们的 C 文件生成 CPG

# joern-parse 是 Joern 提供的命令行工具,用于解析代码并生成 CPG

# --output 指定输出的 CPG 文件名

joern-parse vulnerable.c --output cpg_vuln.bin

joern-parse safe.c --output cpg_safe.bin

输出结果:你会得到 cpg_vuln.bin 和 cpg_safe.bin 两个文件,它们是 Joern 内部格式的图数据库。

3. 步骤三:编写自动化脚本提取图特征并训练模型

现在,我们将编写一个 Python 脚本,它会自动完成以下任务:

- 使用

joern-export将 CPG 转换为更易处理的 JSON 格式。 - 解析 JSON,构建 DGL 图对象。

- 定义一个简单的图神经网络(GNN)模型。

- 训练模型对“漏洞”和“安全”两种图进行分类。

- 对新样本进行预测。

自动化脚本 train_predict.py:

# 导入必要的库

import os

import json

import subprocess

import dgl

import torch

import torch.nn as nn

import torch.optim as optim

from dgl.nn.pytorch import GraphConv

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score, f1_score

# --- 警告 ---

# 本脚本仅用于授权测试和教育目的。

# 未经授权对任何系统进行漏洞扫描都是非法的。

# --- 警告 ---

# --- 参数配置 ---

JOERN_EXPORT_CMD = "joern-export"

EPOCHS = 50

LEARNING_RATE = 0.01

MODEL_SAVE_PATH = "vuln_predictor.pth"

# --- 1. 特征提取与图构建 ---

def cpg_to_dgl_graph(cpg_path: str, label: int):

"""

使用 Joern 将 CPG 转换为 DGL 图对象。

:param cpg_path: Joern 生成的 CPG 二进制文件路径。

:param label: 图的标签 (1 for vulnerable, 0 for safe)。

:return: DGL 图对象和节点特征。

"""

try:

# 使用 joern-export 将 CPG 转换为 JSON

json_output_path = cpg_path.replace('.bin', '.json')

# --repr all 表示导出所有表示形式

command = [JOERN_EXPORT_CMD, "--repr", "all", "--out", json_output_path, cpg_path]

subprocess.run(command, check=True, capture_output=True, text=True)

with open(json_output_path, 'r') as f:

cpg_json = json.load(f)

# 简化处理:仅使用节点类型作为特征

# 实战中会使用更复杂的特征,如 word2vec 嵌入

nodes = cpg_json['nodes']

edges = cpg_json['edges']

# 创建节点类型到整数的映射

node_types = sorted(list(set(node['label'] for node in nodes)))

type_to_int = {t: i for i, t in enumerate(node_types)}

# 创建节点特征张量 (One-hot encoding of node type)

num_nodes = len(nodes)

num_types = len(node_types)

features = torch.zeros((num_nodes, num_types))

node_id_map = {node['id']: i for i, node in enumerate(nodes)}

for i, node in enumerate(nodes):

features[i, type_to_int[node['label']]] = 1

# 创建图结构

src_nodes = [node_id_map[edge['source']] for edge in edges]

dst_nodes = [node_id_map[edge['target']] for edge in edges]

graph = dgl.graph((src_nodes, dst_nodes), num_nodes=num_nodes)

graph.ndata['feat'] = features

graph.ndata['label'] = torch.tensor([label] * num_nodes) # 节点级别标签(简化)

print(f"成功从 {cpg_path} 构建图,包含 {num_nodes} 个节点和 {len(edges)} 条边。")

return graph, features.shape[1]

except subprocess.CalledProcessError as e:

print(f"错误:执行 Joern 命令失败。")

print(f"命令: {' '.join(e.cmd)}")

print(f"输出: {e.stdout}")

print(f"错误输出: {e.stderr}")

return None, 0

except Exception as e:

print(f"处理文件 {cpg_path} 时发生未知错误: {e}")

return None, 0

# --- 2. 定义 GNN 模型 ---

class GNNClassifier(nn.Module):

def __init__(self, in_feats, h_feats, num_classes):

super(GNNClassifier, self).__init__()

self.conv1 = GraphConv(in_feats, h_feats)

self.conv2 = GraphConv(h_feats, h_feats)

self.classify = nn.Linear(h_feats, num_classes)

def forward(self, g, in_feat):

h = self.conv1(g, in_feat)

h = torch.relu(h)

h = self.conv2(g, h)

g.ndata['h'] = h

# 使用平均池化得到图级别的表示

hg = dgl.mean_nodes(g, 'h')

return self.classify(hg)

# --- 3. 训练与评估 ---

def train(graphs, labels, input_dim):

"""训练 GNN 模型"""

if not graphs:

print("错误:没有可用于训练的图数据。")

return None

# 划分数据集

train_graphs, test_graphs, train_labels, test_labels = train_test_split(

graphs, labels, test_size=0.5, random_state=42, stratify=labels

)

if not train_graphs:

print("错误:训练集为空,无法继续。请提供更多数据。")

return None

model = GNNClassifier(input_dim, 16, 2) # 2个类别: safe, vulnerable

optimizer = optim.Adam(model.parameters(), lr=LEARNING_RATE)

loss_fcn = nn.CrossEntropyLoss()

print("\n--- 开始训练 ---")

for epoch in range(EPOCHS):

model.train()

total_loss = 0

for g, label in zip(train_graphs, train_labels):

features = g.ndata['feat']

logits = model(g, features)

loss = loss_fcn(logits, torch.tensor([label]).long())

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

if (epoch + 1) % 10 == 0:

print(f"Epoch {epoch+1}/{EPOCHS}, Loss: {total_loss / len(train_graphs):.4f}")

# 保存模型

torch.save(model.state_dict(), MODEL_SAVE_PATH)

print(f"模型已保存到 {MODEL_SAVE_PATH}")

# 评估模型

if test_graphs:

evaluate(model, test_graphs, test_labels)

return model

def evaluate(model, graphs, labels):

"""评估模型性能"""

model.eval()

predictions = []

with torch.no_grad():

for g in graphs:

features = g.ndata['feat']

logits = model(g, features)

pred = logits.argmax(1).item()

predictions.append(pred)

acc = accuracy_score(labels, predictions)

f1 = f1_score(labels, predictions)

print("\n--- 模型评估 ---")

print(f"测试集准确率: {acc:.4f}")

print(f"测试集 F1-Score: {f1:.4f}")

# --- 4. 预测新样本 ---

def predict(model, cpg_path: str, input_dim: int):

"""对新的 CPG 文件进行漏洞预测"""

print(f"\n--- 预测新样本: {cpg_path} ---")

model.eval()

graph, _ = cpg_to_dgl_graph(cpg_path, -1) # 标签设为-1,因为未知

if graph is None:

print("无法为新样本生成图,预测中止。")

return

with torch.no_grad():

features = graph.ndata['feat']

# 确保特征维度匹配

if features.shape[1] != input_dim:

# 这是一个简化处理,实战中需要统一特征空间

print(f"警告:特征维度不匹配 ({features.shape[1]} vs {input_dim})。将进行填充/截断。")

new_features = torch.zeros((features.shape[0], input_dim))

min_dim = min(features.shape[1], input_dim)

new_features[:, :min_dim] = features[:, :min_dim]

features = new_features

logits = model(graph, features)

probabilities = torch.softmax(logits, dim=1)

prediction = probabilities.argmax(1).item()

print(f"预测结果: {'VULNERABLE' if prediction == 1 else 'SAFE'}")

print(f"置信度 -> Safe: {probabilities[0, 0]:.4f}, Vulnerable: {probabilities[0, 1]:.4f}")

# --- 主函数 ---

if __name__ == "__main__":

# 准备数据

cpg_files = ["cpg_vuln.bin", "cpg_safe.bin"]

labels = [1, 0] # 1 for vulnerable, 0 for safe

graphs = []

input_feature_dim = 0

print("--- 开始数据处理与图构建 ---")

for cpg_file, label in zip(cpg_files, labels):

if not os.path.exists(cpg_file):

print(f"错误: CPG 文件 {cpg_file} 不存在。请先运行 Joern。")

continue

graph, dim = cpg_to_dgl_graph(cpg_file, label)

if graph:

graphs.append(graph)

if input_feature_dim == 0:

input_feature_dim = dim

elif input_feature_dim != dim:

# 在真实场景中,需要一个固定的、全局的特征字典

print(f"警告: 特征维度不一致。这在真实项目中需要标准化处理。")

# 训练模型

trained_model = train(graphs, labels, input_feature_dim)

# 使用训练好的模型进行预测

if trained_model and os.path.exists("cpg_vuln.bin"):

# 重新加载模型进行预测(模拟真实场景)

predictor = GNNClassifier(input_feature_dim, 16, 2)

try:

predictor.load_state_dict(torch.load(MODEL_SAVE_PATH))

# 预测一个已知的漏洞样本

predict(predictor, "cpg_vuln.bin", input_feature_dim)

# 预测一个已知的安全样本

predict(predictor, "cpg_safe.bin", input_feature_dim)

except FileNotFoundError:

print(f"错误:找不到已保存的模型 {MODEL_SAVE_PATH}。")

except Exception as e:

print(f"加载或预测时发生错误: {e}")

运行示例:

- 确保

vulnerable.c和safe.c已创建。 - 运行 Joern 解析命令:

joern-parse vulnerable.c --output cpg_vuln.bin和joern-parse safe.c --output cpg_safe.bin。 - 运行 Python 脚本:

python train_predict.py。

预期输出结果:

--- 开始数据处理与图构建 ---

成功从 cpg_vuln.bin 构建图,包含 ... 个节点和 ... 条边。

成功从 cpg_safe.bin 构建图,包含 ... 个节点和 ... 条边。

--- 开始训练 ---

Epoch 10/50, Loss: ...

...

Epoch 50/50, Loss: ...

模型已保存到 vuln_predictor.pth

--- 模型评估 ---

测试集准确率: 1.0000

测试集 F1-Score: 1.0000

--- 预测新样本: cpg_vuln.bin ---

成功从 cpg_vuln.bin 构建图...

预测结果: VULNERABLE

置信度 -> Safe: 0.1234, Vulnerable: 0.8766

--- 预测新样本: cpg_safe.bin ---

成功从 cpg_safe.bin 构建图...

预测结果: SAFE

置信度 -> Safe: 0.9123, Vulnerable: 0.0877

(注意:由于随机初始化,具体置信度数值会有差异,但预测结果应正确)

四、进阶技巧

1. 常见错误

- 特征空间不一致:当用一个模型预测来自不同项目或不同编译选项的代码时,Joern 生成的节点类型或代码 token 可能不同,导致特征向量维度不匹配。解决方案:在整个数据集上构建一个全局的特征字典(token-to-index map),并对所有输入进行统一编码。

- 图规模差异巨大:一个简单的函数可能只有几十个节点,而一个复杂的函数可能有数千个。这会导致模型训练不稳定。解决方案:使用图采样(Graph Sampling)技术,如

dgl.dataloading.GraphDataLoader,将大图划分为小批次的子图进行训练。 - 数据不平衡:在真实世界中,无漏洞代码远多于有漏洞代码。直接训练会导致模型倾向于预测“无漏洞”。解决方案:使用过采样(如 SMOTE)、欠采样或在损失函数中为不同类别设置权重(

nn.CrossEntropyLoss(weight=...))。

2. 性能 / 成功率优化

- 更丰富的特征:不要只用节点类型。结合代码的文本信息(使用 Word2Vec 或 CodeBERT 对代码 token 进行嵌入)、数据流信息(Taint Analysis)和控制流结构特征,可以大幅提升模型性能。

- 更强大的模型:简单的 GCN 可能不足以捕捉复杂的漏洞模式。尝试使用 Gated Graph Neural Networks (GGNN) 或 Graph Attention Networks (GAT),它们能更好地处理长距离依赖和节点重要性。

- 函数级别 vs. 切片级别:对整个函数进行预测粒度较粗。可以将代码切片(Code Slicing),围绕敏感操作(如

strcpy)或关键变量构建更小的、更聚焦的图,这能提高预测的精确度。

3. 实战经验总结

- AI 不是银弹:AI 预测模型是一个强大的过滤器和排序器,而不是一个完美的漏洞发现器。它的主要价值是帮助人类专家聚焦于高风险区域。总会有误报和漏报。

- 可解释性很重要:一个“黑盒”模型告诉你某处有漏洞,但无法解释为什么,这在实战中价值有限。使用 GNN 可解释性技术(如 GNNExplainer)来高亮显示对“漏洞”预测贡献最大的代码节点和边,这能为审计人员提供宝贵的线索。

- 补丁分析是杀手级应用:对比打补丁前后的 CPG,可以精确地识别出哪些代码被修改,并对这些修改区域进行漏洞预测。这比审计整个代码库要高效得多。

4. 对抗 / 绕过思路

高级攻击者可能会尝试欺骗漏洞预测模型。

- 代码混淆:通过插入无意义的代码、重命名变量、打乱控制流等方式,改变代码的图结构和特征分布,使得模型难以识别出已知的漏洞模式。

- 梯度攻击:如果攻击者能接触到模型(白盒场景),他们可以通过计算损失函数关于输入的梯度,对源代码进行微小的、语义上无害的修改,从而使模型将其误判为“安全”。

- 防御对抗:训练模型时加入对抗性样本(Adversarial Training),或者在特征提取阶段进行标准化和去混淆处理,可以提升模型的鲁棒性。

五、注意事项与防御

1. 错误写法 vs 正确写法 (针对漏洞本身)

| 漏洞类型 | 错误写法 (Vulnerable) | 正确写法 (Secure) |

|---|---|---|

| 缓冲区溢出 | strcpy(dest, src); |

strncpy(dest, src, sizeof(dest)-1); dest[sizeof(dest)-1] = '\0'; |

| 整数溢出 | int c = a + b; // a, b 很大 |

if (a > INT_MAX - b) { /* handle error */ } else { c = a + b; } |

| 命令注入 | system("ping " + ip_address); |

使用 execve 系列函数,并将参数作为数组传递,避免 shell 解析。 |

2. 风险提示

- 过度依赖风险:完全依赖 AI 模型进行安全审计,可能会错过模型未学习过的、全新的漏洞模式。必须结合传统 SAST、DAST 和人工审计。

- 模型老化风险:软件和攻击技术在不断演进。一个在旧数据集上训练的模型,对使用新框架、新语言特性的代码预测能力会下降。模型需要定期使用新数据进行重新训练。

- 法律与合规风险:在未授权的情况下,使用任何工具(包括 AI 模型)扫描第三方代码或系统都是非法的。所有测试必须在获得明确书面授权的环境中进行。

3. 开发侧安全代码范式 (DevSecOps)

- CI/CD 集成:将 AI 漏洞预测模型作为代码提交或合并请求时的一个自动化检查步骤。设定一个风险阈值,当代码的预测漏洞概率超过该阈值时,自动阻止合并并通知安全团队。

- 安全编码规范:推广使用内存安全的语言(如 Rust, Go)和安全的编程库。

- 依赖项扫描:不仅扫描自研代码,更要利用此技术扫描所有第三方依赖库,评估整个软件供应链的风险。

4. 运维侧加固方案

- 纵深防御:即使代码中存在未被发现的漏洞,也应通过运行时保护措施来缓解攻击。启用 ASLR (地址空间布局随机化)、DEP/NX (数据执行保护)、Stack Canaries (栈保护) 等编译时和操作系统级别的安全特性。

- 最小权限原则:确保应用程序以尽可能低的权限运行,即使被攻破,也能限制其造成的损害。

- 虚拟补丁:在无法立即修复源码的情况下,使用 Web 应用防火墙(WAF)或入侵防御系统(IPS)部署虚拟补丁规则,过滤掉针对已知或预测漏洞的攻击流量。

5. 日志检测线索

虽然 AI 预测发生在开发阶段,但其知识可以指导运行时的检测。

- 高风险函数监控:如果模型将某个函数标记为高风险,即使没有确认漏洞,也应增强对该函数调用的日志记录和监控。例如,记录其输入参数的长度、内容等。

- 异常行为检测:结合 AI 预测的漏洞类型(如命令注入),监控进程创建、文件访问、网络连接等行为。如果一个被预测为可能存在命令注入漏洞的 Web 服务突然创建了一个 shell 进程,这应被视为高优先级警报。

- 补丁更新关联分析:当一个被模型预测为高风险的组件发布了安全更新时,应立即检查系统日志,看在更新前是否有针对该组件的异常访问尝试。

总结

- 核心知识:利用 AI 预测漏洞的本质是有监督的图分类问题,其核心流程是数据准备 -> 特征工程 (CPG) -> 模型训练 -> 预测。

- 使用场景:主要用于提升漏洞挖掘效率、进行大规模代码风险排序和自动化分析软件补丁,是实现预测性防御的关键技术。

- 防御要点:AI 模型是审计辅助工具,不能替代纵深防御。开发侧需在 CI/CD 中集成扫描,运维侧需强化运行时保护(ASLR, DEP)和最小权限原则。

- 知识体系连接:这项技术上游连接软件工程(代码分析)和机器学习(图神经网络),下游连接漏洞利用、逆向工程和事件响应(威胁狩猎)。

- 进阶方向:未来的研究方向包括多语言/跨语言漏洞预测、更好的模型可解释性、对二进制文件(无源码)的深度分析以及自动化生成漏洞利用(PoC)。

自检清单

- 是否说明技术价值?

- 是否给出学习目标?

- 是否有 Mermaid 核心机制图?

- 是否有可运行代码?

- 是否有防御示例?

- 是否连接知识体系?

- 是否避免模糊术语?

更多推荐

已为社区贡献63条内容

已为社区贡献63条内容

所有评论(0)