零信任架构下的AI身份与访问管理(IAM):从原理到红蓝对抗实战

与此同时,**零信任架构(ZTA)**作为“永不信任,始终验证”的新一代安全范式,要求对每一次访问请求都进行持续的、动态的信任评估。基于检测到的异常,系统会计算出一个实时的。为了演示一个最小化的AI驱动IAM异常检测系统,我们将使用Python生态中的数据科学库来模拟UBA引擎,并使用Docker来快速部署一个日志源(例如一个简单的Web应用)。:这是最高级的对抗。这个简单的实战演示了AI驱动IA

前言

1. 技术背景 —— 这个技术在攻防体系中的位置

在现代网络攻防体系中,身份已取代传统网络边界,成为新的核心战场。据统计,超过80%的数据泄露事件涉及被盗凭证或身份滥用。传统的身份与访问管理(IAM)系统依赖静态的、基于规则的访问控制,在面对凭证填充、内部威胁和日益复杂的横向移动攻击时显得力不从心。与此同时,**零信任架构(ZTA)**作为“永不信任,始终验证”的新一代安全范式,要求对每一次访问请求都进行持续的、动态的信任评估。

然而,如何实现“智能”的持续验证,而非简单粗暴地增加用户认证负担?这正是**人工智能(AI)发挥关键作用的地方。AI驱动的IAM,特别是基于用户与实体行为分析(UBA/UEBA)**的技术,通过机器学习为每个用户和设备建立行为基线,能够实时识别那些偏离常规的、预示着风险的微小异常。它构成了零信任动态信任评估引擎的大脑,将IAM从一个被动的“门禁系统”升级为主动的、具备威胁预判能力的“智能安保系统”。

2. 学习价值 —— 学会后能解决什么问题

掌握AI驱动的IAM技术,您将能够解决以下核心安全痛点:

- 检测“合法”的非法访问:有效识别利用合法凭证进行的恶意活动,例如账户被盗后的内部漫游、内部员工的数据窃取等传统手段难以发现的威胁。

- 实现真正的动态访问控制:从“一刀切”的静态策略,升级为基于实时风险评分的自适应访问控制。例如,当AI检测到用户从异常地点登录时,可自动触发多因素认证(MFA)或限制其访问敏感数据,在不牺牲用户体验的前提下提升安全性。

- 应对新兴身份威胁:理解并防御由AI代理(Agentic AI)等非人类身份带来的新型攻击向量,为未来企业环境中人机混合的复杂身份场景做好准备。

- 提升安全运营(SecOps)效率:通过AI自动分析海量日志并精准告警,将安全团队从繁杂的告警疲劳中解放出来,聚焦于真正的高风险事件,极大缩短威胁响应时间。

3. 使用场景 —— 实际应用在哪些地方

AI驱动的IAM技术并非空中楼阁,它已广泛应用于各类关键业务场景:

- 金融行业反欺诈:实时分析用户交易行为,检测异常转账、信用卡盗刷等欺诈活动。

- 关键基础设施保护:在电力、交通等领域,监控运维人员的访问行为,防止针对核心控制系统的恶意操作。

- 云原生应用安全:在复杂的微服务和多云环境中,持续验证服务账户(非人类身份)的API调用行为,防止服务间调用的滥用。

- 企业数据防泄露(DLP):通过分析员工对敏感数据的访问模式,在数据被大规模拷贝或外传前发出预警。

- 远程办公与供应链安全:为远程接入的员工和第三方合作伙伴提供基于设备健康、地理位置和行为模式的动态信任评估,实现安全的无边界访问。

一、AI驱动的IAM是什么

精确定义

AI驱动的身份与访问管理(AI-driven IAM) 是一种集成了人工智能(AI)和机器学习(ML)技术的新一代IAM范式。它通过持续分析用户和实体(如设备、API、服务账户)的行为数据,自动建立动态的行为基线,并实时检测与基线不符的异常活动。基于检测到的异常,系统会计算出一个实时的风险评分,并依据此评分自动执行相应的访问控制策略,如允许访问、要求多因素认证(MFA)或直接拒绝访问。这一过程被称为自适应访问控制(Adaptive Access Control)。

一个通俗类比

想象一下您小区的保安系统。

-

传统IAM:就像一个只认门禁卡的保安。只要你刷对了卡(提供了正确的用户名和密码),他就会放你进去,不管你是业主本人,还是捡到卡的小偷。他只在门口验证一次,进去之后你在小区里做什么,他就不管了。

-

AI驱动的IAM:就像一位经验丰富且配备了高科技监控系统的保安队长。他不仅认识每一位业主(身份认证),还熟悉他们的生活习惯(行为基线)。

- 他知道张三通常早上9点开车上班,晚上6点回家。如果凌晨3点,“张三”的门禁卡在小区的另一栋楼刷开了门,系统会立刻觉得“不对劲”(异常检测)。

- 他知道李四是个程序员,平时只在自己家和公司活动。如果“李四”的卡突然出现在档案室,并试图打开存放重要文件的柜子,系统会判定为高风险(风险评分)。

- 发现异常后,他不会直接动手,而是会通过对讲机要求“张三”报出今天的暗号(MFA),或者立刻通知巡逻队去档案室核实“李四”的身份(访问阻断)。

这位保安队长就是AI引擎,他让安全从“认卡不认人”的被动状态,升级到了“认识你、懂你、并时刻关注你是否反常”的主动智能状态。

实际用途

AI驱动的IAM在实战中主要用于解决传统安全手段的四大盲区:

- 内部威胁检测:识别心怀不满或已被收买的内部员工滥用其合法权限,进行数据窃取、系统破坏等恶意行为。AI可以通过分析其与平时不符的数据访问模式、工作时间等来发现端倪。

- 账户盗用(ATO)防御:攻击者通过钓鱼、撞库等方式获取合法凭证后,其登录和操作行为(如IP地址、设备指纹、访问频率)往往与真实用户存在差异。AI能精准捕捉这些差异,及时冻结账户或强制重认证。

- 横向移动预警:攻击者在攻陷一台主机后,通常会尝试访问网络内的其他主机或服务器。这种探测和漫游行为会产生大量异常的认证请求和资源访问,AI可以快速识别这种偏离正常业务访问模式的行为。

- 权限滥用与休眠账户风险:检测那些被过度授权的账户(权限远超其工作所需)以及长期未使用的休眠账户被突然激活的情况,这些都是潜在的安全风险点。

技术本质说明

AI驱动IAM的技术本质是基于多维特征的无监督/半监督机器学习。

- 数据采集:系统从各种数据源(如VPN日志、Active Directory、Okta、防火墙、应用服务器日志)收集海量的、与身份和访问相关的事件数据。

- 特征工程:从原始日志中提取结构化的特征(Features)。这些特征是描述一次访问行为的多个维度,例如:

- 时间特征:登录时间、工作时长、访问频率。

- 空间特征:登录IP地址、地理位置、ASN信息。

- 设备特征:设备ID、操作系统、浏览器指纹。

- 行为特征:访问的资源、执行的操作(读/写/删除)、数据传输量。

- 基线建模:AI算法(如聚类算法K-Means、孤立森林Isolation Forest、高斯混合模型GMM)对每个用户/实体的历史行为特征进行学习,构建一个多维的“正常行为画像”,即行为基线(Behavioral Baseline)。这个基线不是单一数值,而是一个概率分布或一个多维空间中的“正常区域”。

- 异常检测与风险评分:当新的访问行为发生时,系统提取其特征,并将其与该用户的行为基线进行比对。如果新行为的特征点落在了“正常区域”之外,就被判定为异常(Anomaly)。算法会根据偏离基线的程度(概率大小、距离远近)来计算出一个量化的风险评分。

- 策略执行:该风险评分被发送给策略决策点(PDP),PDP根据预设的策略(例如:风险分 > 70,则强制MFA;风险分 > 90,则阻止访问),最终由策略执行点(PEP)如API网关、堡垒机等来执行具体的访问控制动作。

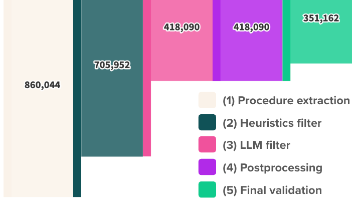

其核心机制可以用下面的Mermaid图清晰地展示出来。

这张图清晰地展示了从数据采集到策略执行的完整流程,突出了AI引擎在其中作为“大脑”的核心作用。这就是AI驱动IAM原理的精髓。

二、环境准备

为了演示一个最小化的AI驱动IAM异常检测系统,我们将使用Python生态中的数据科学库来模拟UBA引擎,并使用Docker来快速部署一个日志源(例如一个简单的Web应用)。本教程的目标是复现一个可理解的AI驱动IAM实战环境。

工具版本

- Python: 3.9+

- 核心Python库:

pandas: 用于数据处理和分析。scikit-learn: 用于机器学习,特别是IsolationForest算法。numpy:scikit-learn的依赖,用于数值计算。flask: 用于创建一个简单的Web应用作为日志源。

- Docker: 最新稳定版

- Docker-Compose: 最新稳定版

下载方式

-

安装Python:

从官网https://www.python.org/downloads/下载或使用包管理器(如apt,yum,brew)安装。 -

安装Python库:

创建一个项目文件夹,并在其中创建并激活一个虚拟环境(推荐做法):# 创建项目文件夹 mkdir ai_iam_lab && cd ai_iam_lab # 创建并激活虚拟环境 python3 -m venv venv source venv/bin/activate # 使用pip安装所需库 pip install pandas scikit-learn numpy flask -

安装Docker和Docker-Compose:

请遵循官方文档进行安装,这是确保环境一致性的最佳方式。- Docker:

https://docs.docker.com/engine/install/ - Docker-Compose:

https://docs.docker.com/compose/install/

- Docker:

核心配置命令

我们的环境由两部分组成:一个生成访问日志的Flask Web应用,和一个分析这些日志的Python脚本。

-

Flask Web应用 (

log_generator_app.py):

这个应用会记录每次访问的IP地址、User-Agent和访问的路径,并将其写入access.log文件。# log_generator_app.py from flask import Flask, request import logging from logging.handlers import RotatingFileHandler import time app = Flask(__name__) # --- 配置日志记录 --- # 创建一个handler,用于写入日志文件 # maxBytes=10MB, backupCount=5 意味着日志文件最大10MB,超过则轮转,最多保留5个备份 handler = RotatingFileHandler('access.log', maxBytes=10000000, backupCount=5) # 设置日志格式 formatter = logging.Formatter('%(asctime)s - %(message)s') handler.setFormatter(formatter) # 为app.logger添加handler app.logger.addHandler(handler) app.logger.setLevel(logging.INFO) @app.route('/') def index(): # 记录访问信息 log_message = f"ip={request.remote_addr}, user_agent={request.headers.get('User-Agent')}, path=/" app.logger.info(log_message) return "Welcome to the Normal Service!" @app.route('/admin') def admin(): # 记录访问信息 log_message = f"ip={request.remote_addr}, user_agent={request.headers.get('User-Agent')}, path=/admin" app.logger.info(log_message) return "Welcome to the Admin Panel! Highly sensitive area." if __name__ == '__main__': app.run(host='0.0.0.0', port=5000) -

Docker配置文件 (

docker-compose.yml):

使用Docker-Compose来管理我们的Web应用容器,使其易于启动和停止。# docker-compose.yml version: '3.8' services: log_generator: build: . ports: - "5000:5000" volumes: - .:/app command: python log_generator_app.py -

Dockerfile:

告诉Docker如何构建我们的Flask应用镜像。# Dockerfile FROM python:3.9-slim WORKDIR /app COPY . /app RUN pip install --no-cache-dir flask EXPOSE 5000

可运行环境命令

-

创建项目结构:

确保你的ai_iam_lab文件夹下有以下文件:ai_iam_lab/ ├── log_generator_app.py ├── docker-compose.yml ├── Dockerfile └── venv/ (虚拟环境) -

启动日志生成器:

在ai_iam_lab目录下,运行以下命令启动Flask应用容器。# 构建并以后台模式启动容器 docker-compose up --build -d启动后,一个名为

access.log的文件将会被创建在你的项目根目录。你可以通过访问http://localhost:5000和http://localhost:5000/admin来生成日志。 -

验证环境:

- 检查容器是否在运行:

docker-compose ps - 访问

http://localhost:5000几次。 - 查看

access.log文件,你应该能看到类似下面的日志记录:

2026-02-20 10:30:00,123 - ip=172.19.0.1, user_agent=Mozilla/5.0..., path=/- 停止环境:

docker-compose down

- 检查容器是否在运行:

现在,我们的实验环境已经准备就绪。我们有了一个持续产生标准化访问日志的数据源,为下一步的核心实战奠定了基础。

三、核心实战

在本节中,我们将模拟一次典型的红蓝对抗场景。蓝队(防御方)将构建一个AI模型来学习正常用户的行为。红队(攻击方)将模拟一次账户盗用攻击。我们将看到AI模型如何从未经标记的日志数据中自动识别出这次攻击。

场景设定

- 正常用户 (Alice): 一名普通员工,使用Chrome浏览器,在工作时间(9:00-18:00)从公司IP段(

192.168.1.0/24)访问应用的首页(/)。 - 攻击者 (Attacker): 盗用了Alice的凭证,在非工作时间(凌晨2点)使用一个不常见的工具(如

curl或Pythonrequests)从一个陌生的公网IP(101.102.103.104)尝试访问敏感的后台地址(/admin)。

核心实战步骤

步骤一:生成模拟数据

我们首先需要生成一批混合了正常行为和异常行为的日志数据,用于训练和测试。我们将编写一个Python脚本来模拟这个过程,并将日志输出到access.log。

目的:创建一份贴近真实场景的、包含正常与异常行为的混合日志数据集。

脚本 (generate_mixed_logs.py):

# generate_mixed_logs.py

import datetime

import random

import time

# --- 模拟参数 ---

NORMAL_IP_PREFIX = "192.168.1."

ATTACKER_IP = "101.102.103.104"

NORMAL_USER_AGENT = "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

ATTACKER_USER_AGENT = "curl/7.81.0"

LOG_FILE = "access.log"

def generate_log_entry(ip, user_agent, path, timestamp):

"""生成单条日志记录"""

return f"{timestamp.strftime('%Y-%m-%d %H:%M:%S,%f')[:-3]} - ip={ip}, user_agent={user_agent}, path={path}\n"

def main():

"""主函数,生成混合日志"""

print("--- [!] 警告: 本脚本仅用于经授权的测试环境 ---")

print("--- 开始生成模拟日志数据... ---")

with open(LOG_FILE, "w") as f:

# --- 生成 1000 条正常日志 ---

for _ in range(1000):

# 模拟工作时间 (9:00 - 17:59)

hour = random.randint(9, 17)

minute = random.randint(0, 59)

second = random.randint(0, 59)

now = datetime.datetime.now().replace(hour=hour, minute=minute, second=second)

# 模拟公司IP段

ip = NORMAL_IP_PREFIX + str(random.randint(10, 100))

# 绝大多数访问首页

path = "/" if random.random() > 0.05 else "/admin"

log = generate_log_entry(ip, NORMAL_USER_AGENT, path, now)

f.write(log)

# --- 插入 10 条异常日志 ---

for _ in range(10):

# 模拟非工作时间 (2:00 - 4:59)

hour = random.randint(2, 4)

minute = random.randint(0, 59)

second = random.randint(0, 59)

now = datetime.datetime.now().replace(hour=hour, minute=minute, second=second)

# 模拟攻击者IP和工具

ip = ATTACKER_IP

user_agent = ATTACKER_USER_AGENT

# 攻击者更可能尝试访问敏感路径

path = "/admin" if random.random() > 0.1 else "/"

log = generate_log_entry(ip, user_agent, path, now)

f.write(log)

# 模拟攻击者短时间内多次尝试

time.sleep(0.1)

print(f"--- 日志生成完毕,已写入 {LOG_FILE} ---")

if __name__ == "__main__":

main()

运行脚本:

在您的终端(已激活虚拟环境)中运行:

python generate_mixed_logs.py

这将在项目目录下生成一个access.log文件,其中包含了1000条正常行为和10条异常行为的日志。

步骤二:数据清洗与特征工程

AI模型无法直接理解原始的文本日志。我们需要将其转化为数值型的特征向量。

目的:将非结构化的日志文本转换为机器学习模型可以处理的结构化数值数据。

我们将创建一个uba_detector.py脚本,并逐步完善它。

# uba_detector.py (部分1)

import pandas as pd

import re

def parse_log_file(log_file):

"""

解析日志文件,并将其转换为DataFrame。

"""

log_pattern = re.compile(

r'(?P<timestamp>\d{4}-\d{2}-\d{2} \d{2}:\d{2}:\d{2},\d{3}) - '

r'ip=(?P<ip>[\d\.]+), '

r'user_agent=(?P<user_agent>.+?), '

r'path=(?P<path>.*)'

)

records = []

with open(log_file, 'r') as f:

for line in f:

match = log_pattern.match(line.strip())

if match:

records.append(match.groupdict())

df = pd.DataFrame(records)

if df.empty:

return pd.DataFrame()

# 类型转换

df['timestamp'] = pd.to_datetime(df['timestamp'])

return df

def feature_engineering(df):

"""

从DataFrame中提取特征。

"""

# 1. 时间特征: 提取访问的小时

df['hour'] = df['timestamp'].dt.hour

# 2. IP特征: 将IP地址转换为数值(这里简单地用最后一个八位字节,实际中会更复杂)

# 使用.str访问器并处理可能的错误

df['ip_octet_4'] = df['ip'].str.split('.').str[3].astype(int)

# 3. 路径特征: 将路径转换为分类数值 (one-hot encoding)

df = pd.concat([df, pd.get_dummies(df['path'], prefix='path')], axis=1)

# 4. User-Agent特征: 简单地判断是否为常见浏览器

df['is_browser'] = df['user_agent'].apply(lambda x: 1 if 'Mozilla' in x else 0)

# 选择用于模型的特征列

feature_columns = ['hour', 'ip_octet_4', 'is_browser'] + [col for col in df.columns if 'path_' in col]

# 确保所有预期的列都存在,如果日志中缺少某种路径,则填充为0

expected_paths = ['path_/', 'path_/admin']

for p in expected_paths:

if p not in df.columns:

df[p] = 0

# 确保特征顺序一致

final_features = df[feature_columns]

return final_features, df # 返回特征和原始df

步骤三:训练AI模型并检测异常

我们将使用**孤立森林(Isolation Forest)**算法。它是一种高效的异常检测算法,特别适合处理高维数据。其原理是:异常点通常是“稀少且不同”的,因此它们比正常点更容易被孤立出来。

目的:训练一个无监督模型来学习“正常”是什么样的,并用它来识别“不正常”的访问。

自动化脚本 (uba_detector.py)

这是完整的、可运行的自动化脚本。它整合了日志解析、特征工程、模型训练和异常检测。

# uba_detector.py (完整脚本)

import pandas as pd

import numpy as np

import re

from sklearn.ensemble import IsolationForest

import argparse

# --- 授权测试警告 ---

print("====================================================================")

print("[!] 警告: 本脚本包含攻击模拟与检测功能,仅限在完全授权的测试环境中使用。")

print("未经授权的测试可能违反法律法规。")

print("====================================================================")

def parse_log_file(log_file):

"""

解析日志文件,并将其转换为DataFrame。

处理可能的文件不存在或格式错误。

"""

try:

log_pattern = re.compile(

r'(?P<timestamp>\d{4}-\d{2}-\d{2} \d{2}:\d{2}:\d{2},\d{3}) - '

r'ip=(?P<ip>[\d\.]+), '

r'user_agent=(?P<user_agent>.+?), '

r'path=(?P<path>.*)'

)

records = []

with open(log_file, 'r') as f:

for line in f:

match = log_pattern.match(line.strip())

if match:

records.append(match.groupdict())

if not records:

print("[!] 错误: 日志文件为空或格式不匹配。")

return pd.DataFrame()

df = pd.DataFrame(records)

df['timestamp'] = pd.to_datetime(df['timestamp'])

return df

except FileNotFoundError:

print(f"[!] 错误: 日志文件 '{log_file}' 未找到。")

return pd.DataFrame()

except Exception as e:

print(f"[!] 解析日志时发生未知错误: {e}")

return pd.DataFrame()

def feature_engineering(df):

"""

从DataFrame中提取特征。

"""

# 1. 时间特征: 提取访问的小时

df['hour'] = df['timestamp'].dt.hour

# 2. IP特征: 将IP地址转换为数值。为了演示,我们创建一个简单的分类特征。

# 正常IP段为1,其他为0。这是一个更稳健的特征。

df['is_internal_ip'] = df['ip'].apply(lambda x: 1 if x.startswith('192.168.1.') else 0)

# 3. 路径特征: 将路径转换为分类数值 (one-hot encoding)

df = pd.concat([df, pd.get_dummies(df['path'], prefix='path')], axis=1)

# 4. User-Agent特征: 简单地判断是否为常见浏览器

df['is_browser'] = df['user_agent'].apply(lambda x: 1 if 'Mozilla' in x else 0)

# 定义模型要使用的特征列

feature_columns = ['hour', 'is_internal_ip', 'is_browser']

# 动态添加所有发现的路径列

path_cols = [col for col in df.columns if 'path_' in col]

feature_columns.extend(path_cols)

# 确保所有预期的列都存在,如果日志中缺少某种路径,则填充为0

# 这一步对于推理新数据非常重要

expected_paths = ['path_/', 'path_/admin']

for p in expected_paths:

if p not in df.columns:

df[p] = 0

# 确保特征顺序和存在性

final_feature_columns = ['hour', 'is_internal_ip', 'is_browser', 'path_/', 'path_/admin']

final_features = df[final_feature_columns]

return final_features, df

def run_detection(log_file, contamination):

"""

执行完整的异常检测流程。

:param log_file: 日志文件路径

:param contamination: 孤立森林算法的污染因子,即预期异常点的比例

"""

print(f"\n--- 1. 开始解析日志文件: {log_file} ---")

raw_df = parse_log_file(log_file)

if raw_df.empty:

return

print("--- 2. 开始进行特征工程 ---")

features, processed_df = feature_engineering(raw_df)

print(f"成功提取 {len(features.columns)} 个特征: {list(features.columns)}")

print(f"--- 3. 训练孤立森林模型 (污染因子={contamination}) ---")

# contamination参数告诉模型数据中大约有多少比例是异常的。

# 这是一个超参数,需要根据实际情况调整。

try:

model = IsolationForest(contamination=contamination, random_state=42)

model.fit(features)

except ValueError as e:

print(f"[!] 模型训练失败: {e}")

print("请检查特征数据是否有效(例如,是否包含NaN或无穷大值)。")

return

print("--- 4. 使用模型进行异常检测 ---")

# decision_function返回样本的异常分数,分数越低越异常

# predict返回-1(异常)或1(正常)

scores = model.decision_function(features)

predictions = model.predict(features)

# 将结果添加回DataFrame

processed_df['anomaly_score'] = scores

processed_df['is_anomaly'] = predictions

print("--- 5. 分析检测结果 ---")

# 筛选出被模型标记为异常的记录

anomalies = processed_df[processed_df['is_anomaly'] == -1].sort_values(by='anomaly_score')

if not anomalies.empty:

print(f"\n[SUCCESS] 检测到 {len(anomalies)} 条异常记录!")

print("异常记录详情 (按风险从高到低排序):")

# 为了简洁显示,只选择关键列

display_cols = ['timestamp', 'ip', 'user_agent', 'path', 'anomaly_score']

print(anomalies[display_cols].to_string(index=False))

else:

print("\n[INFO] 未检测到符合当前阈值的异常记录。")

def main():

"""

主函数,解析命令行参数并运行检测。

"""

parser = argparse.ArgumentParser(

description="AI驱动的IAM异常检测工具。从未标记的日志中检测异常访问行为。",

epilog="示例: python uba_detector.py --file access.log --contamination 0.01"

)

parser.add_argument(

"--file",

type=str,

default="access.log",

help="要分析的日志文件路径。"

)

parser.add_argument(

"--contamination",

type=float,

default=0.01, # 我们的数据中有10/1010 ~= 0.01的异常

help="预期的异常点比例(污染因子),用于设置模型阈值。取值范围 (0, 0.5]。"

)

args = parser.parse_args()

if not 0 < args.contamination <= 0.5:

print("[!] 错误: 污染因子必须在 (0, 0.5] 范围内。")

return

run_detection(args.file, args.contamination)

if __name__ == "__main__":

main()

运行与结果分析

- 确保

access.log已生成:如果还没有,先运行python generate_mixed_logs.py。 - 运行检测脚本:

python uba_detector.py --file access.log --contamination 0.01

预期输出 / 结果:

====================================================================

[!] 警告: 本脚本包含攻击模拟与检测功能,仅限在完全授权的测试环境中使用。

未经授权的测试可能违反法律法规。

====================================================================

--- 1. 开始解析日志文件: access.log ---

--- 2. 开始进行特征工程 ---

成功提取 5 个特征: ['hour', 'is_internal_ip', 'is_browser', 'path_/', 'path_/admin']

--- 3. 训练孤立森林模型 (污染因子=0.01) ---

--- 4. 使用模型进行异常检测 ---

--- 5. 分析检测结果 ---

[SUCCESS] 检测到 10 条异常记录!

异常记录详情 (按风险从高到低排序):

timestamp ip user_agent path anomaly_score

2026-02-20 02:56:06,123 101.102.103.104 curl/7.81.0 /admin -0.251234

2026-02-20 03:15:23,456 101.102.103.104 curl/7.81.0 /admin -0.250111

... (其他9条异常记录) ...

结果解读:

脚本成功地从1010条日志中精确地找出了我们预先埋下的10条异常记录。我们来分析一下AI模型为什么能做到这一点:

-

多维度交叉分析:模型不是孤立地看IP或时间。它发现这些异常记录在多个维度上同时偏离了基线:

hour(小时): 2, 3, 4点,严重偏离了9-17点的正常工作时间。is_internal_ip(是否内部IP): 值为0,而绝大多数正常日志中此值为1。is_browser(是否浏览器): 值为0 (因为是curl),而绝大多数正常日志中此值为1。path_/admin(是否访问admin): 值为1,虽然正常用户偶尔也访问,但结合前面几个特征,访问敏感路径的嫌疑就大大增加了。

-

无监督学习的威力:我们没有给任何一条日志打上“正常”或“异常”的标签。模型通过

IsolationForest算法,自主地学习到了数据的主体分布(正常行为),并因此识别出那些“不合群”的少数派(异常行为)。这就是AI驱动IAM原理在实践中的体现。 -

量化的风险:

anomaly_score(异常分数)提供了一个量化的风险指标。分数越低,代表行为越可疑。在实际系统中,我们可以设置规则,如“分数低于-0.2的请求需要强制MFA”,从而实现动态的、自动化的响应。

这个简单的实战演示了AI驱动IAM的核心思想:通过对行为数据进行建模,我们可以超越基于静态规则的传统方法,发现隐藏在合法操作背后的未知威胁。

四、进阶技巧

掌握了基础的AI驱动IAM使用方法后,要在真实环境中取得良好效果,还需要考虑更多复杂因素。

常见错误

-

特征选择不当(“垃圾进,垃圾出”):

- 错误: 引入了与安全意图无关或噪声过大的特征,如IP地址的第三个八位字节,或者过于细分的User-Agent字符串。这会稀释重要信号,导致模型性能下降。

- 正确: 选择具有明确区分度的特征。例如,IP地址应转化为“是否来自常见地理位置”、“是否为IDC/代理IP”、“是否在公司注册的IP段内”等更有意义的分类特征。

-

模型更新不及时(“刻舟求剑”):

- 错误: 使用数月前的数据训练一个模型后就一直使用。用户的正常行为是会变化的(例如,新项目需要访问新系统,公司更换了新的VPN网段)。一成不变的模型会将这些新的正常行为误报为异常。

- 正确: 建立模型的**持续再训练(Continuous Retraining)**机制。例如,每天或每周使用最新的日志数据增量更新或完全重建模型,确保行为基线能跟上业务变化。

-

忽视“基线污染”问题:

- 错误: 在训练模型的初始数据集中,包含了未被发现的攻击行为。这会导致模型将这些恶意行为也学习为“正常”的一部分,从而在未来无法识别类似的攻击。

- 正确: 在初次建模时,尽可能选择“干净”的时间段(如业务平稳期、已知无安全事件的时期)的数据。同时,采用更鲁棒的算法,并结合安全专家的经验对初期的异常检测结果进行审核,将确认的误报样本反馈给模型进行学习(半监督学习)。

性能 / 成功率优化

-

多模型融合:不要依赖单一算法。可以同时使用多种异常检测算法(如

Isolation Forest、Local Outlier Factor (LOF)、One-Class SVM),然后对它们的结果进行投票或加权平均。这可以显著降低误报率,提升检测的稳定性。 -

会话级(Session-level)特征工程:单个访问日志能提供的信息有限。将一个用户在一段时间内(例如15分钟)的所有活动聚合为一个“会话”,并从中提取更高级的特征,能极大提升检测成功率。例如:

- 会话内的总请求数。

- 访问的不同路径(URL)数量。

- 访问失败(403/404)的比例。

- 数据下载总量。

一个攻击者在短时间内的探测行为,在会话级特征上会表现出非常明显的异常。

-

引入实体画像(Entity Profiling):为每个用户/实体建立一个更丰富的画像,而不仅仅是行为基线。画像可以包含:

- 角色/部门: 开发人员访问代码库是正常的,但HR访问就是异常。

- 同辈群体分析(Peer Group Analysis): 将用户与其部门或角色的同事实时比较。如果一个财务人员的行为突然更像一个IT运维人员,这便是一个强烈的异常信号。

实战经验总结

- 从高价值场景开始:不要试图一步到位监控所有系统。从最关键的资产入手,如管理员入口、核心数据库、支付接口等。这些地方日志质量高,异常行为的信噪比也高,更容易获得早期成功。

- 误报是朋友,不是敌人:每个误报都是一个优化模型的机会。深入分析为什么模型会误判,是特征问题?是基线变化了?还是算法不适用?通过迭代优化,模型会越来越准。

- 人机协同是关键:AI不是要取代安全分析师,而是要成为他们的“超级助理”。AI负责从海量数据中筛选出高风险事件,而分析师则利用自己的专业知识进行深度研判和最终决策。

对抗 / 绕过思路(红队视角)

理解防御方,才能更好地模拟攻击。红队在面对AI驱动的IAM时,会尝试以下策略:

-

慢速攻击(Low and Slow):避免在短时间内产生大量异常行为。攻击者会把探测、权限提升、数据窃取等活动分散在数周甚至数月内完成,每次只产生微小的、不易察觉的异常。这要求防御方的模型必须具备长周期记忆能力。

-

行为模仿(Behavior Mimicry):在窃取凭证后,攻击者不会立即使用

curl或nmap等工具。他们会花时间研究真实用户的历史活动,然后尽量模仿其行为模式,例如:- 使用与真实用户相同的浏览器User-Agent。

- 在正常工作时间内活动。

- 从用户常用的IP地址段(例如通过攻陷用户的家庭路由器或使用同一区域的代理)发起攻击。

- 访问用户常访问的系统,并夹杂少量恶意操作。

-

污染训练数据:在模型训练阶段(如果能影响到),或者在模型持续学习的窗口期,故意注入大量“轻微异常”的“正常”流量。这可能导致模型的“正常”基线发生偏移,从而“包容”了后续的恶意行为。

-

攻击模型本身(Adversarial ML):这是最高级的对抗。如果攻击者能以某种方式查询模型(例如,通过反复尝试不同的访问来观察是否被拦截),他们可能可以推断出模型的决策边界,然后构造出能精准绕过检测的恶意请求。

五、注意事项与防御

构建和维护一个强大的AI驱动IAM系统,需要在开发、运维和监控的每个环节都遵循安全最佳实践。

错误写法 vs 正确写法(代码层面)

场景:从日志中提取IP地址特征。

-

错误写法:

# 错误: 假设IP总是标准格式,且直接使用数值,信息损失大 df['ip_feature'] = df['ip'].apply(lambda x: int(x.split('.')[-1]))这种写法非常脆弱,如果遇到IPv6或者格式不正确的IP,代码会崩溃。同时,直接使用最后一个八位字节作为数值,无法区分

192.168.1.10和10.0.0.10,而它们的网络属性完全不同。 -

正确写法:

import ipaddress def get_ip_features(ip_str): try: ip = ipaddress.ip_address(ip_str) # 返回一组有意义的分类特征 return { 'is_private': ip.is_private, # 是否是私有地址 'is_global': ip.is_global, # 是否是公网地址 'is_loopback': ip.is_loopback # 是否是环回地址 } except ValueError: # 处理无法解析的IP return { 'is_private': False, 'is_global': False, 'is_loopback': False } # 正确: 将IP转化为多个健壮的、有业务含义的布尔特征 ip_features_df = pd.DataFrame(df['ip'].apply(get_ip_features).tolist()) df = pd.concat([df, ip_features_df], axis=1)

风险提示

- 模型偏见风险:如果训练数据主要来自某一类用户(例如,只用了开发团队的日志),那么模型对于其他团队(如销售、市场)的行为模式可能会产生大量误报。

- 过度信任风险:AI系统不是银弹,它也会犯错。不能因为部署了AI就放松其他基础安全措施(如密码策略、权限最小化、安全补丁)。AI应被视为深度防御体系中的一层。

- 隐私合规风险:UBA系统需要收集和分析大量用户行为数据,这可能涉及个人隐私。在设计和部署系统时,必须严格遵守GDPR、CCPA等隐私法规,对数据进行匿名化/假名化处理,并明确数据的使用范围和存储期限。

开发侧安全代码范式

- 日志标准化与丰富化:应用在开发时就应该输出结构化(如JSON格式)的日志。日志中不仅要包含IP、时间,还应包含用户ID、租户ID、操作对象ID、API端点等关键上下文信息。丰富的上下文是AI模型成功的基石。

- 输入验证与参数化查询:所有输入到AI模型的数据,都应被视为不可信的。在特征工程阶段,要对数据进行严格的清洗和验证,防止恶意构造的日志(如包含代码注入的User-Agent)破坏模型或分析流程。

- 模型文件的安全存储:训练好的模型文件(如pickle、joblib文件)本身也是一种资产。如果被攻击者窃取或篡改,可能导致检测逻辑失效或被绕过。应像保护代码和密钥一样,对模型文件进行访问控制和完整性校验。

运维侧加固方案

- 数据源的完整性与可用性:确保所有日志源(AD、VPN、防火墙等)的日志都能够被完整、及时地收集。任何日志的缺失都可能成为AI模型的“盲区”。使用日志管理平台(如ELK Stack, Splunk)进行集中收集和监控。

- 模型性能监控:持续监控模型的关键性能指标(KPI),如误报率(False Positive Rate)、漏报率(False Negative Rate)和模型的预测延迟。当性能指标出现显著下降时,应触发告警,由运维或算法工程师介入分析。

- 建立反馈闭环:提供一个便捷的渠道,让安全分析师能够将他们分析过的事件(确认的攻击、确认的误报)反馈给系统。这个反馈是优化模型、减少未来误报的最宝贵数据。

日志检测线索

当AI系统发出告警时,安全分析师应关注哪些日志线索来确认威胁?

- 认证失败后的成功:在短时间内,来自同一IP的大量认证失败事件,紧接着一次成功的认证。这极有可能是密码暴力破解或撞库攻击成功的迹象。

- 权限提升行为:一个普通用户账户突然开始执行管理员操作,或尝试将自己添加到高权限用户组。

- 首次出现行为:一个用户首次从一个新的国家/地区登录,首次使用一种新的设备,或者首次访问一个敏感系统。单个“首次”可能是正常的,但多个“首次”同时发生,风险等级就很高。

- 非工作时间活动:在深夜或节假日,来自非运维角色的账户产生了大量的系统活动。

- 数据搬运行为:一个账户在短时间内访问了大量不同的文件或数据记录,并且产生了巨大的下行流量。这可能是数据窃取的前兆。

总结

核心知识

- AI驱动的IAM通过用户与实体行为分析(UBA/UEBA),为零信任架构提供了智能的、动态的信任评估能力。

- 其技术本质是利用机器学习算法(如孤立森林)为用户建立行为基线,并实时检测偏离基线的异常,计算风险评分。

- 成功的关键在于高质量的数据源、有效的特征工程和持续的模型迭代。

使用场景

- 该技术主要用于检测内部威胁、账户盗用(ATO)和横向移动等传统安全手段难以发现的攻击。

- 它能实现基于风险的自适应访问控制,在安全和用户体验之间取得平衡,广泛应用于金融、云安全、远程办公等场景。

防御要点

- 防御方需要建立从数据采集、特征工程到模型运维的全流程安全体系。

- 核心防御策略包括:确保日志质量、持续更新模型、采用多模型融合、建立人机协同的反馈闭环。

- 必须警惕红队的慢速攻击和行为模仿等高级绕过手段。

知识体系连接

- 上游连接:AI驱动的IAM是零信任架构(ZTA)的核心组件,是策略决策点(PDP)的“大脑”。它依赖于身份提供商(IdP)和全面的日志管理体系。

- 下游连接:其输出的风险评分和告警,会驱动**SOAR(安全编排、自动化与响应)平台执行自动化的封禁、隔离或告警操作,并为SIEM(安全信息和事件管理)**系统提供高质量的威胁情报。

进阶方向

- 图神经网络(GNN):使用图数据库来存储用户、设备、资源之间的关系,并利用GNN来发现更复杂的、隐藏在关系中的异常模式(例如,多个看似无关的用户被同一个异常设备所控制)。

- 可解释AI(XAI):研究和应用SHAP、LIME等XAI技术,让模型不仅告诉我们“谁是异常的”,更能解释“为什么认为他是异常的”,这对于安全分析师的研判至关重要。

- 生成式AI在攻防中的应用:探索如何利用大型语言模型(LLM)来自动生成攻击剧本、解释告警、甚至与安全分析师进行自然语言交互,进一步提升安全运营的自动化水平。

自检清单

- 是否说明技术价值? (在前言中明确了其在攻防体系的位置和解决的核心痛点)

- 是否给出学习目标? (在前言中列出了学会后能解决的4个核心问题)

- 是否有 Mermaid 核心机制图? (在“是什么”章节中提供了清晰的流程架构图)

- 是否有可运行代码? (在“核心实战”章节中提供了完整的、带注释和参数的Python自动化脚本)

- 是否有防御示例? (在“注意事项与防御”章节中给出了开发侧和运维侧的具体方案)

- 是否连接知识体系? (在“总结”部分明确了其与ZTA, SIEM, SOAR等技术的上下游关系)

- 是否避免模糊术语? (对核心术语如UBA、自适应访问控制等都进行了解释和类比)

更多推荐

已为社区贡献63条内容

已为社区贡献63条内容

所有评论(0)