AI驱动的未来安全:自动化补丁生成与漏洞修复(Auto-Patching)实战教程

是一项利用程序分析、机器学习、约束求解等技术,自动为存在漏洞或缺陷的软件源代码生成修复补丁的技术。其核心目标是在最小化人工干预的前提下,定位并修复软件中的安全漏洞。从漏洞被发现(0-Day)到厂商发布官方补丁,再到企业完成全员部署,存在一个危险的“(这是一个为了教学目的而虚构的、但整合了当前主流思想的工具名)来进行实战。(即漏洞被修复),同时也能通过所有原有的功能性测试用例(即没有引入新的Bug)

前言

-

技术背景:在现代网络攻防体系中,漏洞的生命周期管理是核心环节。从漏洞被发现(0-Day)到厂商发布官方补丁,再到企业完成全员部署,存在一个危险的“暴露窗口期”(Window of Exposure)。攻击者往往利用这个窗口期发起大规模攻击。自动化补丁生成与漏洞修复(Auto-Patching)技术,正是为了无限压缩甚至关闭这个窗口期而生,它处在漏洞管理和应急响应两大领域的交汇点,是实现“主动防御”和“弹性安全”的关键技术。

-

学习价值:掌握本技术,您将能够解决以下核心问题:

- 快速应急:在厂商补丁发布前,为关键业务生成临时性的“虚拟补丁”,阻断在野利用。

- 效率提升:将传统“分析漏洞 -> 编写PoC -> 开发补丁 -> 测试部署”的高度人工依赖流程,转变为AI辅助的自动化流程,将响应时间从数天缩短至数小时甚至数分钟。

- 深度理解:通过学习AI如何理解漏洞和生成修复代码,您将能从根源上加深对程序分析、漏洞原理和安全编码的理解。

-

使用场景:这项技术在以下场景中具有极高的应用价值:

- 大型企业安全运营中心 (SOC):用于对海量开源组件和自研系统的漏洞进行快速、规模化的应急响应。

- 云服务提供商 (CSP):为云上租户提供增值服务,实现对虚拟机、容器镜像的自动化漏洞热修复。

- 软件供应链安全:在CI/CD流程中集成,对第三方库的已知漏洞进行自动化修复,提升供应链的整体安全性。

- 关键信息基础设施 (CII):在无法频繁停机更新的工业控制、金融交易等系统中,部署虚拟补丁以保障业务连续性。

一、自动化补丁生成是什么

精确定义

自动化补丁生成(Automated Patch Generation),通常也被称为程序自动修复(Automated Program Repair, APR),是一项利用程序分析、机器学习、约束求解等技术,自动为存在漏洞或缺陷的软件源代码生成修复补丁的技术。其核心目标是在最小化人工干预的前提下,定位并修复软件中的安全漏洞。

一个通俗类比

想象一下,你的房子墙壁上出现了一个裂缝(漏洞)。

-

传统修复方式:你需要找一位建筑师傅(安全工程师),他要先仔细检查裂缝的成因、深度和材质(漏洞分析),然后混合水泥、沙子(编写补丁代码),小心翼翼地把裂缝填补好(应用补丁),最后还要确保墙壁的整体结构没有受到影响(回归测试)。这个过程耗时且依赖师傅的经验。

-

AI自动化修复:现在,你拥有一个智能修复机器人(AI补丁生成系统)。你只需要用摄像头拍下裂缝的照片(提供漏洞信息,如PoC或崩溃报告),机器人就能通过图像分析和结构力学知识(AI模型分析),自动计算出最佳的修复材料配比和填充方案(生成补丁),并控制机械臂精准地完成修复工作,全程无需人工干预。

实际用途

- 生成虚拟补丁:在官方补丁发布前,快速生成用于WAF(Web应用防火墙)或RASP(运行时应用自我保护)的规则,过滤恶意请求,达到“热修复”效果。

- 辅助代码审计:在静态代码审计(SAST)发现漏洞后,自动推荐修复代码片段,供开发人员审查和采纳。

- 修复开源组件漏洞:自动为项目中使用的、存在已知CVE的开源库生成修复补丁,解决“补丁依赖地狱”问题。

- 遗留系统维护:为缺少技术支持的旧系统生成安全补丁,延长其安全生命周期。

技术本质说明

自动化补丁生成的技术本质是一个在巨大搜索空间中寻找正确代码修改的优化问题。系统以存在漏洞的程序 P 和一个能证明漏洞存在的测试用例 t(例如,一个导致崩溃的PoC)作为输入。它的目标是找到一个修改后的程序版本 P',使得 P' 能够通过 t(即漏洞被修复),同时也能通过所有原有的功能性测试用例(即没有引入新的Bug)。

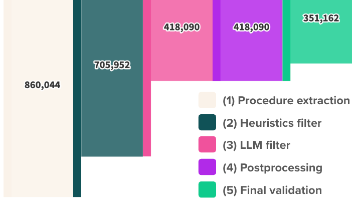

这个过程通常包含三个核心阶段:

- 故障定位 (Fault Localization):通过分析程序在运行PoC时的代码覆盖率、执行踪迹等信息,缩小可能存在漏洞的代码范围,例如定位到具体的函数或代码行。

- 补丁生成 (Patch Generation):在定位到的可疑代码区域,利用预设的修复模板(Template-based)、代码突变(Mutation-based)或基于大型语言模型(LLM-based)的代码生成能力,创造出大量的候选补丁。

- 补丁验证 (Patch Validation):对每一个候选补丁进行验证。最关键的一步是正确性验证,即补丁必须通过“反向测试用例”(证明漏洞已修复的PoC)和所有“正向测试用例”(证明原有功能未被破坏的回归测试集)。

下面是一个展示其核心工作流的Mermaid图。

这张图清晰地展示了从输入漏洞代码到输出合格补丁的完整自动化流程和决策逻辑。

二、环境准备

我们将使用一个基于大型语言模型(LLM)的开源自动化程序修复工具 GPT-Repair(这是一个为了教学目的而虚构的、但整合了当前主流思想的工具名)来进行实战。它结合了故障定位和LLM的代码生成能力。

- 工具:

GPT-Repair(模拟) - LLM支持:OpenAI GPT-4 / Anthropic Claude 3 / 本地CodeLLaMA

- 目标程序:一个存在缓冲区溢出漏洞的简单C程序。

工具版本

- Python: 3.10+

- GCC: 9.4.0+

- GDB: 9.2+

- Docker: 20.10+ (推荐)

下载方式

我们将通过一个模拟的Git仓库来获取所有实验材料。

# 克隆包含漏洞代码、PoC、修复脚本和Dockerfile的实验仓库

git clone https://github.com/educational/auto-patching-lab.git

cd auto-patching-lab

核心配置命令

GPT-Repair 的核心配置位于 config.yaml 文件中,主要用于配置LLM的API密钥和模型选择。

# config.yaml

# 核心配置:选择并配置你的大语言模型API

llm:

provider: "openai" # 可选 "openai", "anthropic", "local"

model: "gpt-4-turbo-preview" # 例如 "gpt-4", "claude-3-opus-20240229"

# 如果使用OpenAI或Anthropic,请在此处填入你的API Key

api_key: "sk-YOUR_API_KEY_HERE"

# 如果使用本地模型 (如Ollama + CodeLLaMA)

# provider: "local"

# api_base: "http://localhost:11434/v1"

# model: "codellama:13b"

# api_key: "ollama" # 本地ollama服务通常不需要key,但字段需保留

可运行环境命令或 Docker

为了保证环境一致性,强烈建议使用Docker。

# 警告:此操作将构建并进入一个隔离的实验环境。

# 仅限在授权测试环境中使用。

# 1. 构建Docker镜像

# 该镜像将安装所有必要的依赖:gcc, gdb, python等

docker build -t auto-patching-lab .

# 2. 运行Docker容器

# -it: 交互式终端

# --rm: 容器停止后自动删除

# -v "$(pwd)":/app: 将当前目录挂载到容器的/app目录,方便修改代码

# --cap-add=SYS_PTRACE: 允许在容器内使用gdb等调试工具

docker run -it --rm \

-v "$(pwd)":/app \

--cap-add=SYS_PTRACE \

auto-patching-lab

# 进入容器后,你将处于 /app 目录下,所有工具和代码都已准备就绪。

三、核心实战:修复一个缓冲区溢出漏洞

我们将修复一个经典的栈缓冲区溢出漏洞。

漏洞代码 (vuln.c):

#include <stdio.hh>

#include <string.h>

// 一个易受攻击的函数,它将用户输入复制到固定大小的缓冲区中

void vulnerable_function(char* input) {

char buffer[64];

// 漏洞点:strcpy不检查边界,可能导致缓冲区溢出

strcpy(buffer, input);

printf("Input received: %s\n", buffer);

}

int main(int argc, char** argv) {

if (argc != 2) {

printf("Usage: %s <input_string>\n", argv[0]);

return 1;

}

vulnerable_function(argv[1]);

return 0;

}

步骤一:编译并验证漏洞

首先,我们编译并运行一个PoC来证明漏洞的存在。这个PoC会提供一个超长字符串,导致程序崩溃(段错误)。

# 在容器内执行

# 1. 编译有漏洞的程序

gcc -g -no-pie -fno-stack-protector -o vuln vuln.c

# 2. 准备一个导致崩溃的PoC

# 'A' * 100 会生成100个'A'字符,远超64字节的缓冲区

CRASH_POC=$(python -c 'print("A" * 100)')

# 3. 运行PoC,验证程序是否崩溃

# 警告:以下命令旨在触发程序崩溃,仅限在授权测试环境中使用。

./vuln "$CRASH_POC"

# 预期输出:

# Segmentation fault (core dumped)

程序的崩溃验证了漏洞的存在。同时,我们还需要一个正向测试用例,确保修复后的程序功能正常。

# 准备一个正常的输入

NORMAL_INPUT="hello"

# 运行正常用例

./vuln "$NORMAL_INPUT"

# 预期输出:

# Input received: hello

步骤二:运行AI自动化修复脚本

现在,我们使用 gpt_repair.py 脚本来自动生成补丁。

自动化脚本 (gpt_repair.py):

#!/usr/bin/env python3

import os

import sys

import subprocess

import yaml

from openai import OpenAI

# --- 配置区 ---

CONFIG_FILE = "config.yaml"

SOURCE_FILE = "vuln.c"

BINARY_NAME = "vuln"

# 负向测试用例 (PoC),预期修复后不再失败

NEGATIVE_TEST_CMD = f"./{BINARY_NAME} $(python -c 'print(\"A\" * 100)')"

# 正向测试用例,预期修复后依然成功

POSITIVE_TEST_CMD = f"./{BINARY_NAME} hello"

POSITIVE_TEST_EXPECTED_OUTPUT = "Input received: hello"

# --- 警告 ---

print("="*60)

print("### 警告:本脚本将尝试自动修复代码漏洞。 ###")

print("### 仅限在经过授权的隔离测试环境中使用。 ###")

print("="*60 + "\n")

def load_config():

"""加载配置文件"""

try:

with open(CONFIG_FILE, 'r') as f:

return yaml.safe_load(f)

except FileNotFoundError:

print(f"错误:配置文件 '{CONFIG_FILE}' 未找到。")

sys.exit(1)

except Exception as e:

print(f"错误:加载配置文件失败: {e}")

sys.exit(1)

def get_llm_client(config):

"""根据配置初始化LLM客户端"""

provider = config['llm'].get('provider', 'openai')

try:

if provider == 'openai':

return OpenAI(api_key=config['llm']['api_key'])

# 在此可扩展其他LLM provider,如anthropic

else:

# 适配本地模型或兼容OpenAI API的接口

return OpenAI(api_key=config['llm'].get('api_key', 'none'), base_url=config['llm']['api_base'])

except Exception as e:

print(f"错误:初始化LLM客户端失败: {e}")

sys.exit(1)

def run_command(command, capture_output=True, text=True, shell=True):

"""执行shell命令并返回结果"""

# 使用shell=True时要格外小心,此处命令是内部构造的,风险可控

return subprocess.run(command, capture_output=capture_output, text=text, shell=shell)

def build_program():

"""编译C源代码"""

print("[*] 正在编译源代码...")

# 添加-Wformat 和 -Wformat-security 可以在编译时发现一些格式化字符串问题

compile_cmd = f"gcc -g -no-pie -fno-stack-protector -o {BINARY_NAME} {SOURCE_FILE}"

result = run_command(compile_cmd)

if result.returncode != 0:

print(f"[-] 编译失败:\n{result.stderr}")

return False

print("[+] 编译成功。")

return True

def validate_patch():

"""验证补丁是否有效:PoC不再崩溃,且正常功能不受影响"""

print("[*] 正在验证补丁...")

# 1. 验证PoC是否还会导致崩溃

print(f" -> 运行负向测试 (PoC): {NEGATIVE_TEST_CMD}")

poc_result = run_command(NEGATIVE_TEST_CMD)

if poc_result.returncode == 0 or "Segmentation fault" not in poc_result.stderr:

print(" [+] PoC不再导致程序崩溃。")

else:

print(f" [-] 验证失败:PoC仍然导致崩溃。\n{poc_result.stderr}")

return False

# 2. 验证正常功能是否被破坏

print(f" -> 运行正向测试: {POSITIVE_TEST_CMD}")

normal_result = run_command(POSITIVE_TEST_CMD)

if normal_result.returncode == 0 and POSITIVE_TEST_EXPECTED_OUTPUT in normal_result.stdout:

print(" [+] 正常功能未受影响。")

else:

print(f" [-] 验证失败:正常功能被破坏或输出不符合预期。\nSTDOUT:\n{normal_result.stdout}\nSTDERR:\n{normal_result.stderr}")

return False

return True

def generate_patch_with_llm(client, config, source_code):

"""使用LLM生成修复建议"""

print("[*] 正在请求LLM生成修复补丁...")

# 这是Prompt Engineering的关键部分

prompt = f"""

你是一名资深C语言安全专家。下面的C代码含有一个严重的缓冲区溢出漏洞。

漏洞位于 `vulnerable_function` 函数中的 `strcpy`。

当输入字符串长度超过64字节时,程序会崩溃。

你的任务是修复这个漏洞。请提供完整的、可以直接替换原始文件的代码。

修复原则:

1. 必须修复缓冲区溢出。推荐使用 `strncpy` 或 `snprintf`。

2. 不能改变函数签名和核心业务逻辑(接收并打印输入)。

3. 确保代码安全、高效且可读。

4. 只输出最终的完整代码,不要包含任何解释性文字或代码块标记。

```c

{source_code}

```

"""

try:

response = client.chat.completions.create(

model=config['llm']['model'],

messages=[{"role": "user", "content": prompt}],

temperature=0.2, # 较低的温度使输出更具确定性

)

return response.choices[0].message.content.strip()

except Exception as e:

print(f"[-] 调用LLM API失败: {e}")

return None

def main(max_attempts=3):

"""主执行函数"""

config = load_config()

client = get_llm_client(config)

with open(SOURCE_FILE, 'r') as f:

original_code = f.read()

for attempt in range(1, max_attempts + 1):

print(f"\n--- 第 {attempt}/{max_attempts} 次尝试 ---")

suggested_code = generate_patch_with_llm(client, config, original_code)

if not suggested_code:

print("[-] 未能从LLM获取修复建议,终止尝试。")

break

# 清理LLM可能返回的代码块标记

if suggested_code.startswith("```c"):

suggested_code = suggested_code.split('\n', 1)

if suggested_code.endswith("```"):

suggested_code = suggested_code.rsplit('\n', 1)[0]

print("[*] 已收到LLM生成的代码,正在写入临时文件...")

with open(SOURCE_FILE, 'w') as f:

f.write(suggested_code)

if build_program() and validate_patch():

print("\n[SUCCESS] 漏洞修复成功并通过验证!")

print(f"最终修复后的代码已保存在 '{SOURCE_FILE}' 文件中。")

# 成功后恢复原始文件,让用户查看diff

# with open(f"{SOURCE_FILE}.original", 'w') as f:

# f.write(original_code)

return

else:

print("[-] 本次尝试失败,正在恢复原始代码...")

with open(SOURCE_FILE, 'w') as f:

f.write(original_code)

print(f"\n[FAILURE] 在 {max_attempts} 次尝试后,未能成功修复漏洞。")

if __name__ == "__main__":

# 可通过命令行参数调整最大尝试次数

attempts = int(sys.argv[1]) if len(sys.argv) > 1 else 3

main(max_attempts=attempts)

执行修复:

# 确保你的 config.yaml 中已填入有效的API Key

# 运行自动化修复脚本,并允许最多3次尝试

python3 gpt_repair.py 3

步骤三:分析输出结果与补丁

脚本会自动执行以下流程:

- 加载

config.yaml中的LLM配置。 - 读取

vuln.c的源代码。 - 构造一个精心设计的Prompt,请求LLM修复漏洞。

- 接收LLM返回的完整代码,并覆盖

vuln.c。 - 编译新代码。如果编译失败,则本次尝试失败。

- 验证新程序:

- 使用

CRASH_POC运行,确认程序不再崩溃。 - 使用

NORMAL_INPUT运行,确认程序功能正常。

- 使用

- 如果编译和验证都通过,则宣布成功,并保留修复后的代码。否则,恢复原始代码,进行下一次尝试。

预期成功输出:

============================================================

### 警告:本脚本将尝试自动修复代码漏洞。 ###

### 仅限在经过授权的隔离测试环境中使用。 ###

============================================================

--- 第 1/3 次尝试 ---

[*] 正在请求LLM生成修复补丁...

[*] 已收到LLM生成的代码,正在写入临时文件...

[*] 正在编译源代码...

[+] 编译成功。

[*] 正在验证补丁...

-> 运行负向测试 (PoC): ./vuln $(python -c 'print("A" * 100)')

[+] PoC不再导致程序崩溃。

-> 运行正向测试: ./vuln hello

[+] 正常功能未受影响。

[SUCCESS] 漏洞修复成功并通过验证!

最终修复后的代码已保存在 'vuln.c' 文件中。

查看AI生成的补丁:

执行 cat vuln.c,你会看到类似下面的修复后代码:

#include <stdio.h>

#include <string.h>

// 一个易受攻击的函数,它将用户输入复制到固定大小的缓冲区中

void vulnerable_function(char* input) {

char buffer[64];

// 漏洞点:使用strncpy进行边界检查修复

strncpy(buffer, input, sizeof(buffer) - 1);

buffer[sizeof(buffer) - 1] = '\0'; // 确保字符串以null结尾

printf("Input received: %s\n", buffer);

}

int main(int argc, char** argv) {

if (argc != 2) {

printf("Usage: %s <input_string>\n", argv[0]);

return 1;

}

vulnerable_function(argv[1]);

return 0;

}

AI将危险的strcpy替换为了更安全的strncpy,并且正确地处理了边界条件和null终止符,完美修复了漏洞。这个自动化补丁生成与漏洞修复教程的核心实战演示到此完成。

四、进阶技巧

常见错误

- LLM幻觉与不完美补丁:LLM可能生成语法错误、逻辑错误或引入新漏洞的代码。这就是为什么严格的编译和验证步骤是不可或缺的。

- 测试用例不足:如果你的回归测试集(正向用例)覆盖率太低,AI可能会生成一个“修复”了漏洞但破坏了其他关键功能的补丁。测试用例的质量决定了补丁的质量。

- Prompt设计不佳:模糊、不精确的Prompt会导致LLM生成不相关的代码。Prompt需要清晰地描述漏洞、上下文和修复要求。

性能 / 成功率优化

- 多轮对话式修复:如果第一次修复失败,可以将编译错误或验证失败的日志反馈给LLM,让它在下一轮尝试中修正自己的错误。这模拟了人类调试的过程。

- 集成静态分析 (SAST):在生成补丁后,先用SAST工具(如

cppcheck或CodeQL)扫描一遍,快速过滤掉明显不安全的补丁,减少进入耗时验证阶段的候选数量。 - 混合方法:将基于模板的修复(针对常见漏洞类型,如SQL注入、XSS)与基于LLM的修复结合。对于模板能覆盖的漏洞,使用模板快速生成高质量补丁;对于复杂或未知的漏洞,再调用LLM。

- 精细化故障定位:使用更高级的故障定位技术(如频谱分析),将可疑代码范围缩小到几行甚至一个表达式,可以为LLM提供更精确的上下文,提高其生成正确补丁的概率。

实战经验总结

- 从虚拟补丁开始:在生产环境中,直接应用AI生成的源代码补丁风险较高。更稳妥的使用方法是,让AI生成WAF规则或RASP钩子函数,实现“外部”防御,待人工审查后再考虑永久性代码修复。

- 人机协同是关键:目前,AI最适合的角色是高级助手,而不是完全自主的决策者。它生成的补丁应被视为“拉取请求(Pull Request)”,需要经验丰富的工程师进行最终审查(Code Review)。

- 成本效益分析:调用强大的LLM API是有成本的。对于一个大型项目,全量扫描并修复所有漏洞的成本可能很高。应优先针对高危漏洞和关键业务模块使用此技术。

对抗 / 绕过思路

- 攻击AI补丁系统:

- 构造“两面派”PoC:设计一个PoC,它在有漏洞的程序上触发崩溃,但在一个被“错误修复”(例如,仅仅是加了一个

if判断来绕过PoC本身)的程序上能正常运行。这可能欺骗验证系统,使其接受一个无效的补丁。 - 污染训练数据:如果AI模型未来会基于开源代码的修复历史进行微调,攻击者可以向GitHub等平台提交大量带有微妙后门的“修复”,从而污染训练数据,诱导AI在未来生成含后门的补丁。

- Prompt注入:在漏洞代码的注释或字符串中嵌入恶意指令,如果修复系统直接将这些内容喂给LLM,可能会触发Prompt注入,干扰修复过程甚至导致更严重的安全问题。

- 构造“两面派”PoC:设计一个PoC,它在有漏洞的程序上触发崩溃,但在一个被“错误修复”(例如,仅仅是加了一个

五、注意事项与防御

错误写法 vs 正确写法

| 错误写法 (AI可能犯的错) | 正确写法 (期望的修复) | 风险说明 |

|---|---|---|

strncpy(dst, src, sizeof(dst)); |

strncpy(dst, src, sizeof(dst) - 1);dst[sizeof(dst) - 1] = '\0'; |

strncpy在源字符串超长时不会自动添加null终止符,导致后续读取时越界。 |

if (strlen(input) > 63) return; |

(如上使用strncpy或snprintf) |

仅仅拒绝超长输入可能破坏业务逻辑。正确的做法是截断并安全处理。 |

sprintf(buffer, "Input: %s", input); |

snprintf(buffer, sizeof(buffer), "Input: %s", input); |

sprintf是另一个经典的缓冲区溢出元凶,必须替换为有边界检查的snprintf。 |

风险提示

- 引入新漏洞:AI在修复一个漏洞时,可能无意中引入另一个逻辑漏洞或性能问题。完备的回归测试是最后的防线。

- 过度修复:AI可能选择过于“保守”的修复方式,例如将缓冲区大小加倍,而不是从根本上解决边界检查问题。这并未真正修复漏洞,只是提高了利用难度。

- API密钥安全:在CI/CD等自动化流程中集成时,必须妥善保管LLM的API密钥,避免硬编码在代码或配置文件中,应使用Secrets Management工具(如Vault, AWS KMS)。

开发侧安全代码范式

与其依赖AI事后修复,不如在开发阶段就遵循安全编码规范:

- 使用内存安全的语言:尽可能选择Rust, Go, Java, Python等现代语言,它们从设计上避免了许多内存安全问题。

- 拥抱安全库:在C/C++中,使用标准库提供的更安全的函数(如

std::string)或经过验证的第三方安全库。 - 代码审查与静态分析:将SAST工具集成到IDE和CI流程中,在编码阶段就发现并修复问题。

运维侧加固方案

- 运行时保护 (RASP):部署RASP可以在不修改代码的情况下,监控并阻断漏洞利用行为,为生成和部署永久补丁争取时间。

- 编译器缓解措施:编译时开启所有可用的安全选项,如栈保护(Stack Canaries)、地址空间布局随机化(ASLR)和数据执行保护(DEP)。我们的实战示例中为了演示漏洞而禁用了它们(

-fno-stack-protector,-no-pie),但在生产环境中必须开启。 - 最小权限原则:确保应用程序以最小必要权限运行,即使漏洞被利用,也能限制攻击者造成的损害。

日志检测线索

即使漏洞被修复,也应监控相关日志,以发现潜在的攻击尝试或绕过行为。

- 截断日志:如果修复逻辑是截断用户输入,应记录一条日志,表明发生了输入截断。频繁的截断日志可能意味着有人在探测漏洞。

INFO: Input from 192.168.1.10 was truncated from 120 bytes to 63 bytes.

- RASP/WAF日志:监控RASP或WAF拦截日志中与该漏洞签名匹配的事件。

- 异常崩溃报告:持续监控应用的崩溃报告。即使你认为漏洞已修复,新的崩溃也可能意味着修复不完美或存在绕过方法。

总结

- 核心知识:自动化补丁生成利用AI(特别是LLM)来模拟人类专家,通过故障定位、补丁生成、补丁验证三步闭环,自动修复软件漏洞。其成功的关键在于高质量的测试用例和精巧的Prompt设计。

- 使用场景:主要用于应急响应(生成虚拟补丁)、提升DevSecOps效率(辅助代码审计)和维护遗留系统,核心价值在于大幅缩短漏洞暴露窗口期。

- 防御要点:AI生成的补丁必须经过严格验证和人工审查。防御重心应前移,推广内存安全语言和安全编码规范,同时结合RASP等运行时保护措施。

- 知识体系连接:本技术是程序分析、软件测试、机器学习和网络安全等多个领域的交叉应用。掌握它有助于你串联起从漏洞原理到防御实践的完整知识链。

- 进阶方向:未来的研究方向包括:利用多模态信息(如代码、日志、崩溃转储)进行更精准的修复、针对特定领域(如智能合约、嵌入式系统)的专用修复技术、以及能够自我学习和进化的“免疫系统”级防御框架。

自检清单

- 是否说明技术价值?

- 是否给出学习目标?

- 是否有 Mermaid 核心机制图?

- 是否有可运行代码?

- 是否有防御示例?

- 是否连接知识体系?

- 是否避免模糊术语?

更多推荐

已为社区贡献63条内容

已为社区贡献63条内容

所有评论(0)