基于 LangChain4j 的 Java AI应用开发:从“Hello AI World“开始

Java开发者也能轻松玩转AI!本文介绍如何用LangChain4j框架快速搭建本地AI应用,无需高端硬件即可运行开源大模型。通过Ollama工具在本地部署Qwen等轻量模型,结合简单的Java代码实现对话功能。文章对比了LangChain4j与Spring AI的适用场景,并展示了10行代码调用本地模型的示例。更重要的是,该框架支持模块化组合AI流程,为后续实现基于私有数据的智能问答(RAG)打

视频教程

嘿,大家好!。今天咱们不聊别的,就干一件特别酷的事——用你熟悉的 Java,亲手搭一个AI 应用!

我知道,很多同学一听到“大模型”、“AI应用”,脑子里立马蹦出几个词:GPU、显卡、Python、TensorFlow……然后心里就打退堂鼓了:“哎呀,这跟我这个只会写 Spring Boot 的 Java 程序员有啥关系?”

停!打住!

我要告诉你一个好消息:现在,用 Java 也能轻松玩转大模型了! 而且,成本低到你不敢信——一张普通的消费级显卡,甚至都不用显卡,就能跑起来!

为什么这事突然变得这么简单?因为有了像 LangChain4j 这样的“神器”。

🧩 第一步:先搞清楚,咱们到底要解决什么问题?

想象一下,你是一家公司的技术负责人。老板说:“咱们公司有成千上万份内部文档、产品手册、客服记录,能不能做个‘智能知识库’?员工问一句‘怎么重置密码?’,系统就能自动从文档里找出答案。”

听起来很高级对吧?但如果你自己从零开始对接大模型,那可太痛苦了:

- 你要手动拼 JSON 请求;

- 要处理 HTTP 连接、超时、重试;

- 要把用户的问题和你的私有数据“喂”给模型;

- 还要考虑怎么存、怎么查这些知识……

这哪是开发 AI 应用?这是在造轮子!

所以,我们需要一个“AI 应用的乐高积木套装”——这就是 LangChain4j!

💡 LangChain4j 是什么?

它是 LangChain 在 Java 生态的官方实现,专门帮 Java 开发者快速搭建 AI 应用。它把那些繁琐的底层通信、数据处理、记忆管理、工具调用都封装好了,你只需要“拼积木”就行!

🔍 那 LangChain4j 和 Spring AI 有啥区别?我该选谁?

好问题!这就像你去吃饭,一个是“快餐店”(Spring AI),一个是“自助厨房”(LangChain4j)。

- Spring AI:如果你已经在用 Spring Boot,而且只打算接入 一个 大模型(比如 OpenAI),那它集成超快,几行配置就搞定。但它“绑定”了 Spring 生态,灵活性稍弱。

- LangChain4j:它 不依赖任何框架!只要你是 Java 项目,管你是 Spring、Quarkus 还是纯 Java SE,都能用。更重要的是——它天生支持多模型动态切换!

举个例子:

你想做一个“大模型调度平台”,今天用 Qwen,明天切 Ollama,后天试试 DeepSeek……

这种场景,LangChain4j 就是为你量身定做的!

🛠️ 动手时间!咱们先跑通第一个“Hello AI World”

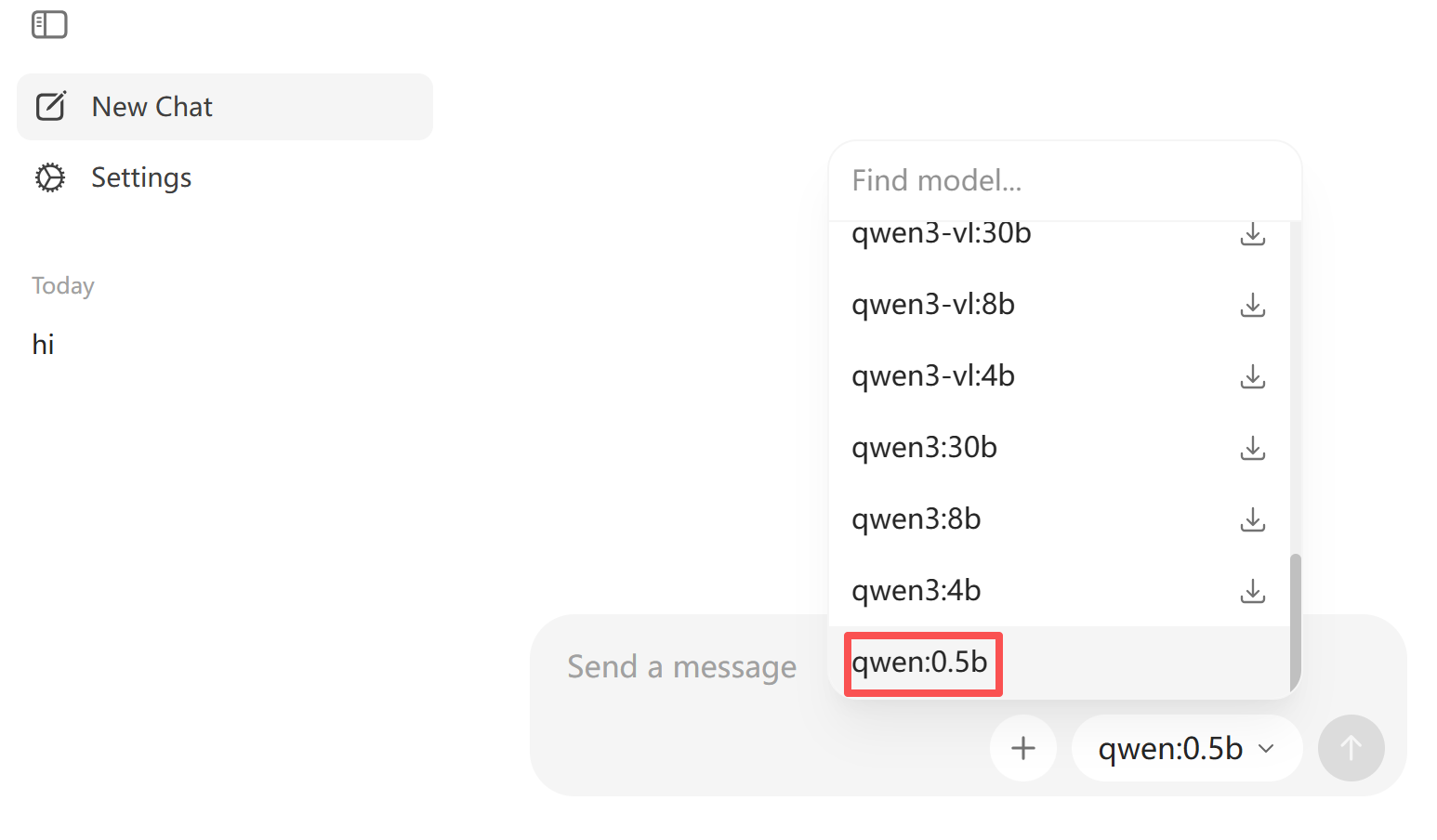

别担心,咱们不用立刻买显卡。先用 Ollama 在本地跑一个开源小模型,比如 qwen:0.5b 或 llama3:8b(根据你电脑性能选)。

第一步:装 Ollama(1分钟搞定)

打开终端,执行:

# Mac / Linux

curl -fsSL https://ollama.com/install.sh | sh

# Windows:去官网 https://ollama.com 下载安装包

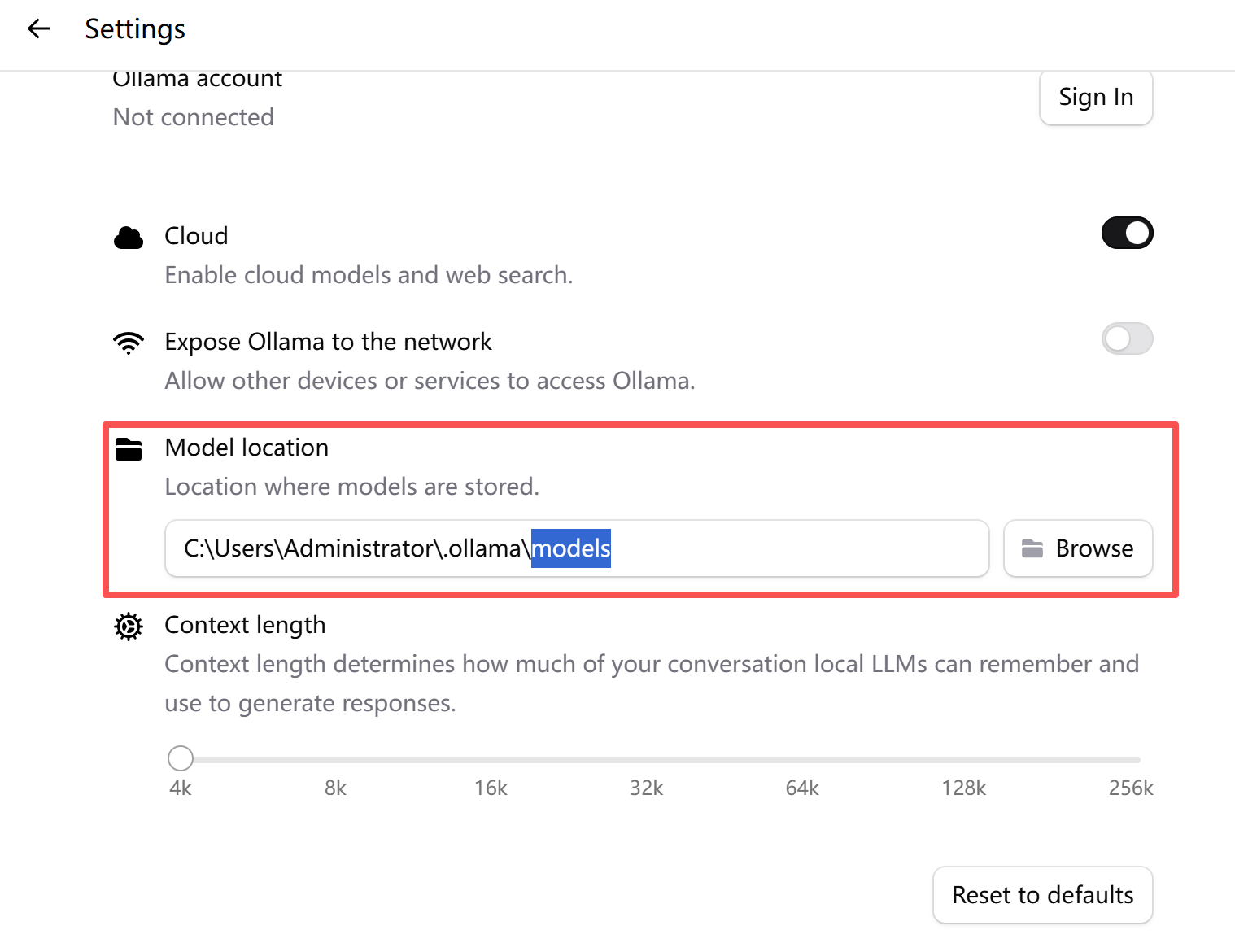

🔔提示:由于Ollama的exe安装软件双击安装的时候默认是在C盘,以及后续的模型数据下载也在C盘,导致会占用C盘空间。

可自定义安装路径:

H:\xiaobian-soft\安装包>OllamaSetup.exe /DIR=H:\xiaobian-soft\ollama自定义模型存储路径:

装好后,拉一个模型下来(以 Qwen 为例):

ollama pull qwen:0.5b

C:\Users\code-say>ollama pull qwen:0.5b

pulling manifest

pulling fad2a06e4cc7: 100% ▕██████████████████████████████████████████████████████████▏ 394 MB

pulling 41c2cf8c272f: 100% ▕██████████████████████████████████████████████████████████▏ 7.3 KB

pulling 1da0581fd4ce: 100% ▕██████████████████████████████████████████████████████████▏ 130 B

pulling f02dd72bb242: 100% ▕██████████████████████████████████████████████████████████▏ 59 B

pulling ea0a531a015b: 100% ▕██████████████████████████████████████████████████████████▏ 485 B

verifying sha256 digest

writing manifest

success

然后启动服务:

- Windows/Mac:安装后一般会自动后台运行。

- Linux:运行

ollama serve

ollama serve

✅ 默认监听

http://localhost:11434

成功拉取qwen:0.5b模型后,选择模型下拉框就会有这个模型:

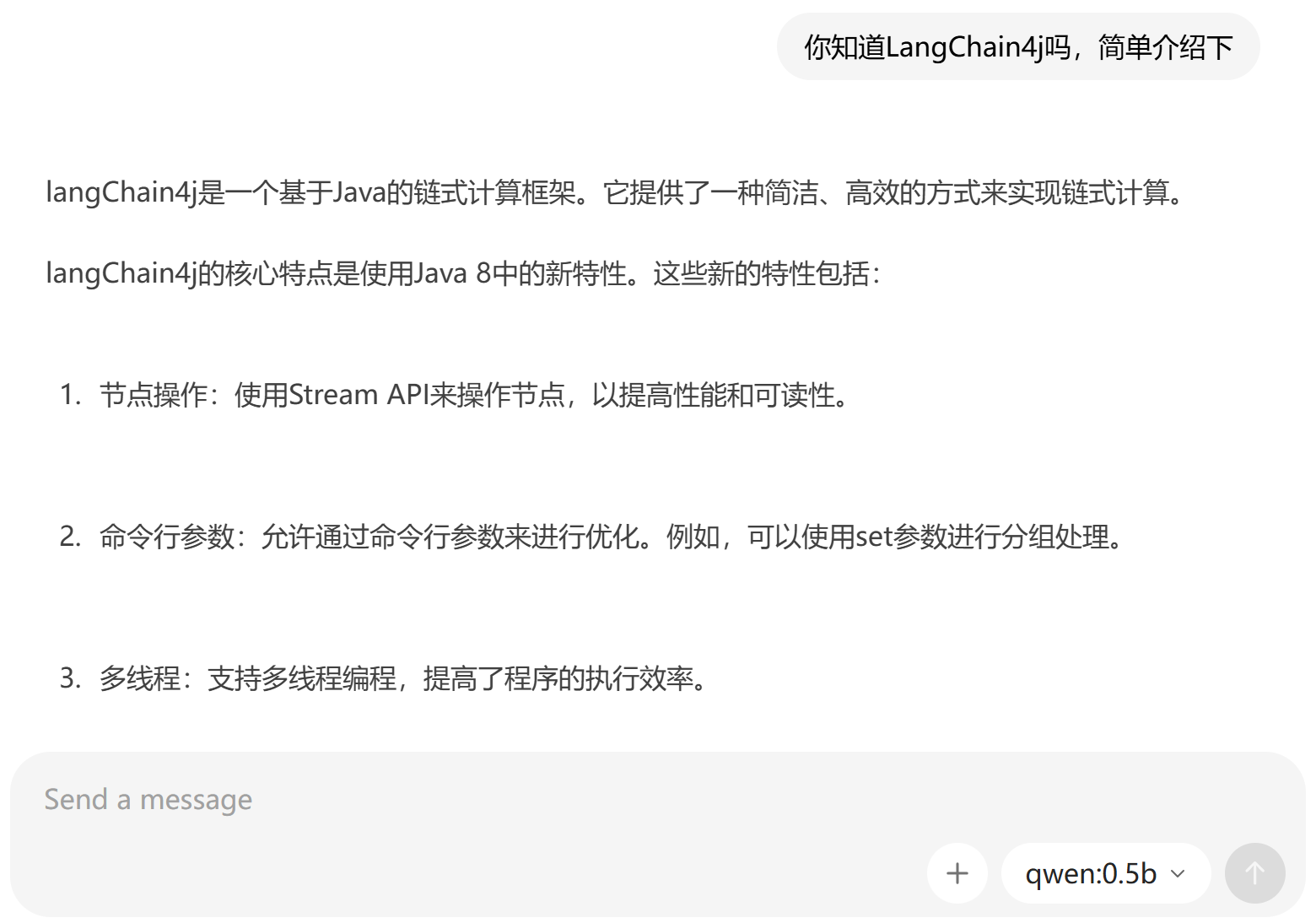

可以直接在这里和大模型对话,即使在没有联网的情况下:

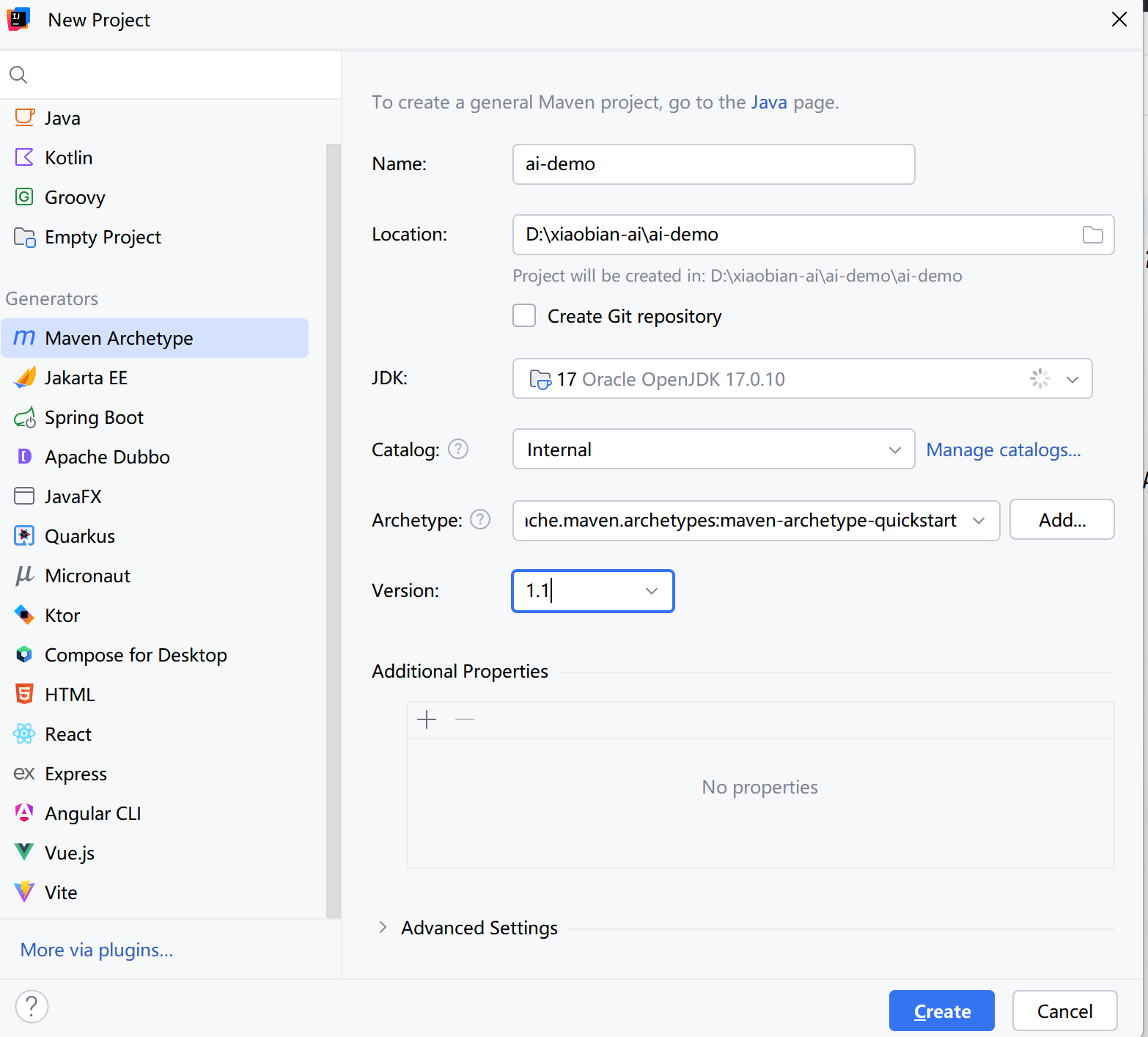

第二步:创建 Java 项目,引入 LangChain4j

用 Spring Initializr 或 Maven 创建一个新项目,加两个依赖(以 Maven 为例):

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j</artifactId>

<version>1.11.0</version> <!-- 请用最新版 -->

</dependency>

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j-ollama</artifactId>

<version>1.11.0</version>

</dependency>

可来这里查看版本:https://github.com/langchain4j/langchain4j/

第三步:写代码!让 Java 和本地大模型对话

来,看这段代码——你只需要 10 行,就能让 Java 调用本地 AI!

import dev.langchain4j.model.chat.ChatModel;

import dev.langchain4j.model.ollama.OllamaChatModel;

/**

* @author 代码悦读

* @version 1.0

* @data 2026/2/10 9:15

*/

public class HelloAIDemo {

public static void main(String[] args) {

// 创建 Ollama 模型(返回的是 ChatModel 类型)

ChatModel model = OllamaChatModel.builder()

.baseUrl("http://localhost:11434") // Ollama 默认地址

.modelName("qwen:0.5b") // 你 pull 的模型名

.build();

// 调用 AI

String answer = model.chat("你好!你是谁?");

System.out.println("🤖 AI 说:" + answer);

}

}

运行一下!你会看到控制台输出类似:

🤖 AI 说:我是来自阿里云的大规模语言模型,我叫通义千问。

🎉 恭喜!你刚刚完成了人生第一个 Java + 本地大模型的程序!

🤔 但是……这跟直接 curl 有啥区别?

好问题!你现在可能想:“这不就是封装了个 HTTP 请求吗?我自己用 OkHttp 也能干!”

没错!但 LangChain4j 的威力,才刚刚开始!

它真正的价值在于——帮你把“AI 应用”拆解成可组合的模块。比如:

用户输入 → [提示词模板] → [检索私有知识] → [调用大模型] → [结构化输出] → 返回结果

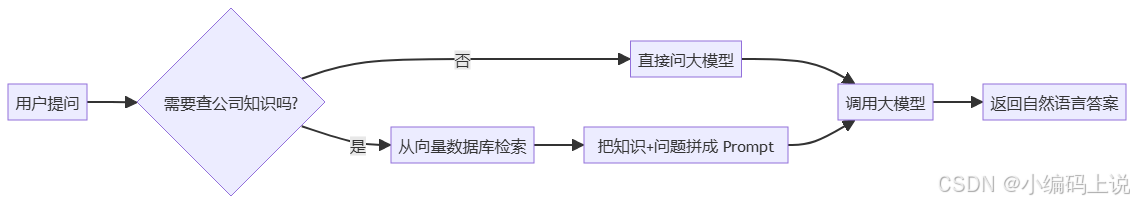

我们可以用 Mermaid 画个简单流程图:

而 LangChain4j 里,每个方框都是一个“组件”:

Retriever:负责查知识PromptTemplate:负责拼提示词ChatModel:负责调模型OutputParser:负责把回答转成 Java 对象

你可以像搭积木一样,自由组合!

📚 下一步:让 AI 学会“读”你的公司文档

光会聊天没用,我们要让它基于你的私有数据回答问题。这就需要“RAG”(检索增强生成)。

LangChain4j 内置支持多种向量数据库,比如:

- Redis

- Elasticsearch

- Milvus

- PGVector(PostgreSQL)

- 甚至内存版(适合测试)

🎯 本节课收获总结

- ✅ AI 应用开发不再是 Python 的专利,Java 也能轻松上手!

- ✅ LangChain4j = Java 开发者的 AI 乐高套装,模块化、可组合、跨框架。

- ✅ 本地大模型成本极低,Ollama + 消费级显卡即可运行。

- ✅ 我们已经跑通了第一个 Java + 本地大模型程序,下一步就是接入私有知识!

最后送大家一句话:

“不要怕 AI 取代程序员,要怕自己不会用 AI 的程序员。”

掌握 LangChain4j,你就站在了“AI 原生 Java 工程师”的起跑线上。简历上写一句:“基于 LangChain4j 构建企业级本地知识库系统,支持高并发问答”,绝对碾压 90% 的传统 CRUD 开发者!

有问题?评论区见!代码和资料我也放好了,记得点赞、收藏!咱们下期见!

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)