AI音效生成与自动剪辑工具完全指南

AI音效生成和自动剪辑技术正在快速成熟,从2024年到2025年,我们已经看到从"玩具级"向"生产级"的质变。音画一体化:即梦3.5 Pro等工具实现了生成阶段的音画同步,而非后期叠加开源生态繁荣:腾讯混元、Stable Audio Open等开源模型降低了专业门槛工作流整合:剪映、InVideo等工具将分散的AI能力串联成闭环文本驱动:Descript等工具让视频编辑像编辑文档一样直观。

AI音效生成与自动剪辑工具完全指南

第一部分:AI音效生成工具详解

一、文本生成音效(Text-to-SFX)工具

1. ElevenLabs Sound Effects

工具概述

ElevenLabs是业界领先的AI音频技术公司,其音效生成器支持通过文本描述生成任何想象得到的声音效果,从乐器音轨到复杂的环境音效均可实现。

核心功能

- 文本驱动的音效生成

- 支持自定义音效时长

- 高质量音频输出

- 与ElevenLabs语音合成生态整合

详细使用教程

步骤1:访问与登录

访问ElevenLabs音效生成页面,登录您的账户(音效生成功能需付费订阅)。

步骤2:输入描述

在文本框中详细描述所需音效。例如:

- “electric guitar distortion with reverb”(带混响的电吉他失真效果)

- “heavy rain on metal roof, distant thunder”(铁皮屋顶上的暴雨,远处雷声)

- “sci-fi laser gun charging and firing”(科幻激光枪充能及发射声)

步骤3:参数调整

- 选择音效时长(系统可自动决定或手动设置)

- 调整生成强度(控制与描述的匹配程度)

步骤4:生成与导出

点击"Generate Sound Effects"按钮,等待生成完成后预览,满意即可下载。

适用场景

- 影视后期制作中的特定音效需求

- 游戏开发中的UI音效和技能音效

- 播客和有声书的环境音铺底

- 广告视频的定制化音效

定价模式

音效生成功能为付费版本,需订阅ElevenLabs的付费计划。

2. Stable Audio Open(Stability AI)

工具概述

由Stability AI开发的开源文本到音频生成模型,专为音乐制作和声音设计领域打造,可生成长达47秒的高质量音频样本和音效。

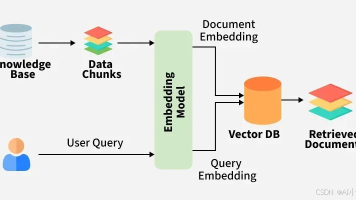

技术架构

基于潜在扩散模型(Latent Diffusion Model),包含三个核心组件:

- 自编码器:将波形压缩为可管理序列长度

- T5文本嵌入:实现文本条件控制

- 基于Transformer的扩散模型(DiT):在潜在空间运行

本地部署教程

环境准备

# 克隆仓库

git clone https://github.com/Stability-AI/stable-audio-tools

cd stable-audio-tools

# 安装依赖

pip install -r requirements.txt

# 下载模型权重(从Hugging Face)

huggingface-cli download stabilityai/stable-audio-open-1.0 --local-dir ./models

生成音效

- 打开Web界面或命令行工具

- 填写提示词(Prompt):

- “Drumbeat”(鼓点)

- “The chirping of birds”(鸟鸣)

- “The sound of rain”(雨声)

- “Synthwave bass drop”(合成器波贝斯掉落)

- 填写负面提示词(Negative Prompt):建议填写"noise"以避免生成噪音

- 调整生成时长(最长47秒)

- 点击生成,结果位于界面右侧,可试听和下载

硬件要求

- 20系及以上NVIDIA显卡(支持半精度运算)

- 16GB以上显存推荐

- CUDA 11.8或更高版本

适用场景

- 音乐制作中的采样生成

- 影视配乐创作

- 游戏音效设计

- 独立音乐人的创作辅助

3. 腾讯混元 HunyuanVideo-Foley

工具概述

腾讯混元团队推出的端到端视频音效生成框架,直接"看懂"视频内容,自动生成精准匹配的动作音效和环境氛围音,实现"所见即所听"。

技术突破

- 分层注意力融合架构(HAFA):将视觉特征与声音语义向量对齐

- 场景记忆单元(Scene Memory Unit):记录视频整体上下文,保持音效连贯性

- 基于扩散模型的声学生成器:从零生成波形,非简单拼接

- 毫秒级同步精度:音效触发延迟控制在±5ms内

部署与使用教程

方式一:Gradio图形界面(推荐新手)

# 1. 克隆仓库

git clone https://gitcode.com/tencent_hunyuan/HunyuanVideo-Foley.git

cd HunyuanVideo-Foley

# 2. 安装依赖

pip install -r requirements.txt

# 3. 下载模型权重

# 从ModelScope或Hugging Face下载hunyuanvideo_foley.pth

# 4. 启动Web界面

streamlit run web_ui.py

# 或

python gradio_app.py

使用流程:

- 上传视频文件(MP4/MOV格式)

- 输入简要描述(如"夜晚丛林行走,伴有蛙鸣")

- 选择风格模板(悬疑片/卡通趣味/写实等)

- 点击生成,实时预览结果

方式二:Python SDK(开发者)

from hunyuan_foley import FoleyEngine

# 初始化引擎

engine = FoleyEngine(model="large", device="cuda")

# 生成音效

result = engine.generate(

video_path="input.mp4",

prompt="夜晚丛林中的脚步声,伴有蛙鸣和风吹树叶",

style="cinematic_realistic",

output_format="wav_48k_24bit"

)

result.export("output.wav")

方式三:命令行批量处理

python inference.py \

--model_path PRETRAINED_MODEL_PATH_DIR \

--config_path ./configs/hunyuanvideo-foley-xxl.yaml \

--single_video video_path \

--single_prompt "audio description" \

--output_dir OUTPUT_DIR

高级参数控制

duration:指定音效时长intensity:音效强度(0.0-1.0)audio_style: cinematic/realistic/cartoonguidance_scale:控制与提示词的匹配程度

适用场景

- 短视频后期自动配音

- 影视预演(Pre-vis)快速音效原型

- 游戏过场动画音效生成

- 独立电影的声音设计

4. AudioLDM-S(轻量级音效生成)

工具概述

AudioLDM的轻量级版本,专为低配显卡优化,可在GTX 1650等入门级GPU上流畅运行,生成专业级环境音效。

核心优势

- 极低硬件门槛:支持4GB显存显卡

- 快速生成:RTX 3050生成5秒音效仅需2.3秒

- 高质量输出:44.1kHz立体声,自然混响

- Docker一键部署:无需手动配置环境

部署教程(Docker方式)

# 1. 拉取镜像(国内加速)

docker pull registry.cn-hangzhou.aliyuncs.com/csdn_ai/audioldm-s:latest

# 2. 创建工作目录

mkdir -p ~/audioldm-s && cd ~/audioldm-s

# 3. 启动容器

docker run -it --gpus all -p 7860:7860 \

-v $(pwd):/workspace/output \

registry.cn-hangzhou.aliyuncs.com/csdn_ai/audioldm-s:latest

使用指南

- 浏览器访问

http://localhost:7860 - 在Prompt框输入英文描述(必须英文):

birds singing in a rain forest, water flowing(雨林鸟鸣,流水声)arctic wind howling across frozen tundra(极地寒风呼啸)soft chime with gentle reverb, like glass bell(柔和钟声,如玻璃铃铛)

- 调整参数:

- Duration:2.5-10秒(建议5-7秒)

- Steps:10-50步(40步为质量与速度平衡点)

- 点击Generate,生成后可直接下载WAV文件

提示词进阶技巧

- 否定提示:在描述后添加

, [negative: 干扰项]排除不需要的声音 - 量化描述:用具体数量词替代模糊词,如"three sparrows chirping"替代"some birds"

- 声学细节:加入

close-mic recording(近距离录音)、distant thunder(远处雷声)等空间描述

5. MyEdit AI音效生成器

工具概述

MyEdit提供用户友好的界面,专注于音效生成与编辑的简单性和效率,适合初学者和专业人士快速生成音效。

使用流程

- 访问MyEdit AI音效生成页面

- 点击’generate’按钮

- 输入音效描述文本

- 点击’Generate Sound Effects’生成

- 预览并下载

6. OptimizerAI

工具概述

OptimizerAI专注于为不同平台和格式优化音效,提供高级工具进行音频质量微调,确保兼容性。

使用步骤

- 访问Optimizer AI音效生成器

- 点击首页"Make a Sound"按钮

- 输入文本描述

- 点击’Generate’生成音效

二、AI音乐与背景音乐生成工具

1. Mubert

工具概述

专注于为视频、播客和直播生成免版税背景音乐的AI平台,拥有50万样本数据库和AI拼接技术,支持长达25分钟的音频生成。

核心功能模块

- Mubert Render:为内容创作者快速生成背景音乐

- Mubert Studio:艺术家可上传样本并创作

- Mubert API:开发者集成到应用

- Mubert Play:个人用户场景音乐生成

使用教程

步骤1:注册与选择模块

访问mubert.com注册账号,选择"Mubert Render"进入创作界面。

步骤2:生成音乐

- 在"Generate Track"栏目输入英文提示词(如"relaxing"、“cyberpunk”、“upbeat electronic”)

- 或上传图片作为灵感来源

- 选择音乐形式:

- Track:完整曲目

- Loop:循环片段

- Mix:混音版本

- Jingle:短促标识音

- 设定时长(5秒至25分钟)

- 点击"Generate Track"

步骤3:下载与应用

生成的音乐显示在下方,试听满意后点击下载(MP3格式)。根据许可条款用于视频、播客、应用等项目。

实用技巧

- 详细文字描述:不要只选预设风格,用文字详细描述场景,如"深夜城市街道,霓虹灯闪烁,赛博朋克氛围,带点忧郁"

- 多生成几次:AI有随机性,同一参数多次尝试以获得最佳结果

- 配合视频节奏:先粗剪视频确定音乐时长和节奏点,再精确生成

- 建立音乐库:遇到满意的音乐及时下载保存,分类复用

定价

- Creator年付$140.28(相当于$11.69/月)

- 比月付节省$2.31/月

2. AIVA(AI Virtual Artist)

工具概述

全球首个获得音乐版权协会认证的AI作曲引擎,专注于生成高质量、结构化的器乐音乐,适用于电影配乐、游戏原声和广告背景音乐。

核心功能

- 文字变音乐:输入"激昂的战斗BGM"或"治愈系钢琴曲",30秒内生成完整编曲

- 风格定制:上传参考曲目,AI学习并复刻特定风格

- 曲谱编辑:内置简易DAW界面,可修改音符、增减乐器轨道

- 多格式导出:支持分轨STEM文件(适配Cubase/Logic Pro)、MIDI、乐谱

使用教程

步骤1:注册与创建项目

访问aiva.ai注册账号,进入个人工作室界面,点击"新建项目"。

步骤2:选择创作方向

- 选择风格:古典、爵士、电影、氛围、电子等

- 设定情绪:激昂、忧郁、神秘、轻松等

- 选择乐器配置:钢琴弦乐、全管弦乐、电子合成等

步骤3:生成与编辑

- AI生成初稿后,在时间线界面调整:

- 修改单个音符

- 增减乐器轨道

- 调整动态和速度

- 使用"Augment"功能生成变奏版本

步骤4:导出

- 导出格式选择:

- MP3/WAV:成品音频

- MIDI:后续在DAW中编辑

- 乐谱:供乐手演奏

- STEM分轨:专业混音

版权与定价

- Pro版$39/月,获得全球通用音乐版权证书

- 所有生成内容经区块链存证

- 支持190个国家商业使用

适用场景

- 电影/游戏配乐(独立游戏《星尘》使用AIVA制作全部BGM)

- YouTube视频背景音乐

- 广告和商业项目

- 音乐教育(学生拆解AI作品学习作曲)

3. Soundraw

工具概述

AI音乐生成平台,支持逐秒调整旋律、节奏、乐器音量,并提供人声分离功能,适合需要精细控制的音乐制作。

使用流程

步骤1:注册与生成

访问soundraw.io注册账号,选择音乐风格、情绪和使用场景,点击"Generate",AI在10秒左右生成3-5首候选曲目。

步骤2:编辑与调整

进入编辑器后:

- 逐秒调整旋律、节奏、乐器音量

- 点击"人声分离"按钮,分离人声和伴奏

- 调整和弦进程、声像、调性

步骤3:导出与版权

- 选择MP3或WAV格式导出

- 付费订阅后自动获得商用版权

定价

- 免费版:每天生成5个文件,最长1分钟,128kbps,不可商用

- 付费版:无限生成、320kbps、商用权限

4. Beatoven.ai

工具概述

采用Diffusion模型与CLAP模型的AI音乐生成器,结合ChatGPT API实现音乐生成与语义理解的深度融合,支持视频上传自动匹配音乐。

核心特色

- 多模态提示:文本+视频双重输入

- 情绪分段处理:根据内容情绪变化自动调整音乐

- 多格式导出:MP3、WAV、FLAC

- 视频同步:上传视频后AI自动分析画面情绪生成匹配音乐

使用教程

步骤1:确定创作方向

上传视频/播客素材,或从现有音轨开始,从8种音乐风格中选择。

步骤2:情绪分段

在时间轴上标记情绪变化点(如从紧张转为温馨),为每段选择16种情绪类型之一。

步骤3:智能创作

点击创作按钮,AI自动生成音乐。使用"Add a Cut"功能在关键时间点切换情绪或风格。

步骤4:精细调整

- 调整音乐时长、风格、情绪

- 控制乐器配置(如钢琴+萨克斯)

- 使用"Augment"功能生成混音版本

步骤5:导出

选择MP3或WAV格式,导出时自动附加版权声明

定价

- 免费版:每月5次生成、1次视频上传、1次音频上传

- 基础套餐:$9.99/月,无限生成与下载

- 企业套餐:定制化API与优先支持

5. Suno AI

工具概述

目前最热门的AI音乐生成工具之一,支持人声演唱和完整歌曲结构(主歌、副歌、桥段),适合快速创作带歌词的流行歌曲。

与Udio对比

| 特性 | Suno | Udio |

|---|---|---|

| 声音质量 | 尚可,有轻微"嗡嗡声" | 卓越,音质清晰 |

| 使用便捷度 | 非常用户友好 | 需要更多时间精力 |

| 创作能力 | 快速、引人注目的成果 | 详细、复杂的作品 |

| 歌曲长度 | 支持更长片段 | 限制在30秒片段 |

| 语言支持 | 更好地支持非英语 | 难以处理非英语歌词 |

| 适用场景 | 快速、梗歌和休闲使用 | 高质量、严肃音乐制作 |

使用建议

- 适合快速创意生成和社交媒体内容

- 商业用途需谨慎,版权存在争议

三、AI音效生成工具综合对比表

| 工具名称 | 生成类型 | 最大时长 | 是否开源 | 硬件要求 | 商业授权 | 最佳适用场景 |

|---|---|---|---|---|---|---|

| ElevenLabs SFX | 文本到音效 | 自定义 | 否 | 云端 | 付费 | 影视后期、游戏音效 |

| Stable Audio Open | 文本到音频 | 47秒 | 是 | 中高端GPU | 需遵守许可 | 音乐制作、采样设计 |

| HunyuanVideo-Foley | 视频到音效 | 同步视频 | 是 | 高端GPU | 开源协议 | 影视配音、自动拟音 |

| AudioLDM-S | 文本到音效 | 10秒 | 是 | 入门级GPU | 开源 | 独立游戏、播客制作 |

| MyEdit | 文本到音效 | 自定义 | 否 | 云端 | 免费/付费 | 快速音效获取 |

| OptimizerAI | 文本到音效 | 自定义 | 否 | 云端 | 免费/付费 | 多平台优化 |

第二部分:AI自动剪辑与视频素材组合工具

一、音画一体生成工具(生成时自动同步音效)

1. 即梦AI 视频3.5 Pro(Seedance 1.5 Pro)

工具概述

即梦AI于2024年12月16日上线的新一代视频生成模型,最大突破在于音画同步生成——在生成视频画面的同时,自动完成环境音效、人声对白和音乐配乐,直接输出可直接使用的成片。

核心能力

- 自动匹配环境音效:风声、雨声、人群声、街道背景音,支持多音源混合和远近变化

- 人声对白生成:原生生成、口型同步、情绪可控

- 背景音乐:贴合画面情绪的智能配乐

- 音画同步:模型原生支持,非后期叠加

与传统工作流对比

| 对比维度 | 专业剪辑软件(PR/FCP) | AI生视频平台(Runway/Pika) | 即梦3.5 Pro |

|---|---|---|---|

| 是否一步成片 | ❌ | ❌ | ✅ |

| 音画同步 | 人工对齐 | 不稳定 | 模型原生 |

| 人声对白 | 手动录制 | 外接或不准 | 原生生成、可控 |

| 环境音效 | 手动找素材 | 常缺失 | 自动匹配 |

| 背景音乐 | 手动选 | 模板化 | 贴合情绪 |

| 修改成本 | 很高 | 中 | 低 |

| 适合人群 | 专业团队 | 视觉向创作者 | 商用/内容创作者 |

使用流程

- 输入文本描述或上传参考图

- 选择生成参数(时长、比例、风格)

- 开启"音画同步"选项

- AI同时生成视频画面+音效+配乐

- 直接导出成片或进入精修模式

适用场景

- 电商带货视频(产品展示+环境音+口播)

- 品牌广告片(氛围音效+情绪配乐)

- 短剧制作(对白+环境音+BGM)

- 自媒体素材(一键成片)

二、AI自动剪辑工具(基于现有素材智能剪辑)

1. 剪映(CapCut)AI功能套件

工具概述

字节跳动旗下剪映推出的"All in AI,All in One"创作平台,将脚本、成片、后期精修串联成无缝创作闭环。

核心AI功能

(1)图文成片

- 输入200-800字文案,AI自动完成:

- 智能配音(50+音色,支持方言/外语)

- 画面匹配(自动搜索素材库匹配关键帧)

- 字幕生成(准确率98%,支持12种方言)

- 背景音乐(智能推荐情绪匹配音乐)

- 剪辑节奏(根据文案逻辑自动分镜)

使用教程:

- 打开剪映App,点击首页"图文成片"

- 粘贴文案(200-800字,避免特殊符号)

- 选择AI音色与画面风格,开启关键词匹配

- AI生成初稿(约10-30秒)

- 微调字幕时长、替换画面

- 选择分辨率(1080×1920竖版或1920×1080横版)导出

(2)智能剪辑引擎

- 智能筛选:自动删除模糊片段、抖动画面

- 智能剪辑:按叙事逻辑自动拼接高光片段(如10分钟旅行素材自动剪出3个高光片段)

- 自动踩点:导入音乐后自动生成鼓点标记,画面切换与音乐完美同步

(3)AI一镜到底

- 上传多段素材,AI智能选取切入切出角度

- 自动生成电影级运镜过渡

- 将不同景观拼成视觉长卷

(4)AI数字人

- 24种形象+23种音色

- 输入文案自动生成口播视频

- 无需真人拍摄

2. Runway Gen-2 + 自动剪辑工作流

工具概述

业界领先的AI视频生成平台,支持文本到视频、图像到视频、视频风格迁移,通过API和Webhook实现自动化剪辑流程。

自动化剪辑架构

[原始视频]

↓

[视觉预处理模块] → [动作检测 & 场景识别]

↓

[多模态融合引擎] ← [音效知识库]

↓

[音效生成器(扩散模型)]

↓

[音频后处理] → [混音 / 均衡 / 空间化]

↓

[带音效视频输出]

本地化部署与自动剪辑教程

步骤1:环境搭建

# 安装Runway SDK

pip install runwayml

# 设置API密钥

export RUNWAY_API_KEY="your_api_key_here"

步骤2:批量生成与自动下载

import os

import requests

import time

def generate_and_download(prompt, duration, output_path):

headers = {"Authorization": f"Bearer {os.getenv('RUNWAY_API_KEY')}"}

# 提交生成任务

payload = {

"prompt": prompt,

"duration": duration,

"webhook_url": "https://your-server.com/webhook" # 自动通知

}

response = requests.post(

f"{os.getenv('RUNWAY_API_BASE_URL')}/generate",

headers=headers,

json=payload

)

task_id = response.json()["id"]

# 轮询等待完成

while True:

status = requests.get(

f"{os.getenv('RUNWAY_API_BASE_URL')}/status/{task_id}",

headers=headers

).json()

if status["state"] == "SUCCEEDED":

video_url = status["output"]["video_url"]

# 自动下载

video_data = requests.get(video_url).content

with open(output_path, "wb") as f:

f.write(video_data)

break

elif status["state"] == "FAILED":

raise Exception("Generation failed")

time.sleep(5)

步骤3:自动剪辑与拼接

# 使用FFmpeg自动拼接多个片段

import subprocess

def auto_assemble_clips(clip_list, output_file):

# 创建文件列表

with open("file_list.txt", "w") as f:

for clip in clip_list:

f.write(f"file '{clip}'\n")

# 快速拼接(无重编码)

cmd = [

"ffmpeg", "-f", "concat", "-safe", "0",

"-i", "file_list.txt", "-c", "copy", output_file

]

subprocess.run(cmd)

步骤4:Webhook自动触发后续流程

from flask import Flask, request

app = Flask(__name__)

@app.route('/webhook', methods=['POST'])

def handle_webhook():

data = request.json

if data["state"] == "SUCCEEDED":

video_url = data["output"]["video_url"]

# 自动触发:下载→剪辑→转码→发布

process_pipeline(video_url)

return "", 204

高级功能:剧本驱动的自动分镜

import spacy

# 加载中文NER模型

nlp = spacy.load("zh_core_web_trf")

def parse_script_to_shotlist(script):

"""将剧本解析为机器可读的分镜表"""

doc = nlp(script)

shots = []

for sent in doc.sents:

shot = {

"主体": [ent.text for ent in sent.ents if ent.label_ == "PERSON"],

"动作": [token.lemma_ for token in sent if token.pos_ == "VERB"],

"场景": extract_scene_context(sent),

"情绪": infer_mood_from_adjectives(sent),

"时长": estimate_duration_by_action_count(sent)

}

shots.append(shot)

return shots

适用场景

- 影视预演(Pre-vis)快速生成

- 广告多版本快速迭代

- 短视频矩阵批量生产

- 概念验证(Proof of Concept)

3. Descript(文本驱动剪辑)

工具概述

基于AI转录技术的视频编辑工具,通过修改文字稿来剪辑视频,实现"像编辑文档一样编辑视频"的体验。

核心功能

- 自动转录:AI自动识别语音生成带时间戳的文字稿,支持区分不同说话人

- 文本剪辑:删除文字即可删除对应视频片段,调整文字顺序即调整镜头顺序

- AI语音克隆:Overdub功能可克隆声音,修改台词无需重录

- 自动字幕:一键生成精美字幕

使用教程

步骤1:导入与转录

- 将视频素材导入Descript

- 右键选择"转录"

- AI自动分析音频,生成带时间戳的文字稿

- 多人访谈可自动区分说话人

步骤2:文本剪辑

- 在转录文本中搜索关键词(如"创新"),快速定位片段

- 删除"呃"、"嗯"等口头禅,时间线自动波纹删除

- 剪切粘贴段落,视频片段自动调整顺序

- 选中文字按Delete,对应音视频同步删除

步骤3:AI增强

- Overdub:输入新文字,AI用克隆声音生成新音频

- Studio Sound:一键去除背景噪音,提升语音清晰度

- 自动字幕:基于转录稿生成字幕,支持样式自定义

适用场景

- 播客剪辑(大幅节省逐句剪辑时间)

- 访谈节目(快速定位金句)

- 课程制作(口误修正无需重录)

- 多版本预告片(快速重组内容)

4. Wisecut

工具概述

专注于将长素材提炼成片的AI视频剪辑工具,通过AI分析自动去除停顿、生成字幕、选择最佳片段。

使用流程

- 访问Wisecut官网,注册并登录

- 点击"新建项目",上传视频文件,等待云端转码

- 在"AI剪辑"面板选择:

- 语言(用于自动字幕)

- 目标时长(如从2小时压缩到15分钟)

- 风格模板(教育/营销/Vlog等)

- AI自动分析并生成初版

- 进入时间轴微调裁剪点、字幕文本或替换背景音乐

- 选择分辨率与比例(横屏/竖屏/正方形),导出成片

应用场景

- 线上教育:2小时直播回放→15分钟精华课程

- 电商运营:长讲解视频→多条30秒短视频

- 企业会议:去除停顿与敏感信息→10分钟纪要

- 自媒体:手机上传素材→云端自动剪辑→直接发布

5. Kapwing

工具概述

浏览器端的AI剪辑神器,提供完整的云端非线性编辑功能,支持团队协作和自动化处理。

核心AI功能

(1)智能去静音

- 自动检测并批量删除视频中的无声片段和尴尬停顿

- 让口播视频节奏更紧凑

(2)自动生成字幕

- 一键识别语音生成高精度字幕

- 支持翻译成多种语言

- 可自定义字体、颜色、位置

(3)内容再利用

- 一键调整视频画布比例(16:9→9:16)

- 自动聚焦画面主体

- 快速将横屏长视频转化为竖屏短视频

(4)AI降噪与增强

- 一键去除背景噪音

- 提升人声清晰度

- 确保音频达到专业录音室标准

使用流程

- 上传视频到Kapwing平台

- 选择智能剪辑功能,设置片段时长和主题

- AI自动生成多个剪辑选项

- 选择合适版本,添加字幕、转场、背景音乐

- 导出或分享至社交媒体

定价

- 免费版:基础功能,带水印

- Pro版:$16/月起,去水印+高级功能

6. Lumen5

工具概述

专注于将文章/博客一键转为视频的AI工具,自动提取关键点、匹配视觉素材、生成配音。

使用教程

步骤1:导入内容

- 粘贴文章链接,或

- 手动输入文本,或

- 上传Word/PDF文档

步骤2:AI分析与分镜

- AI自动提取标题、段落

- 智能拆分成多个镜头场景

- 为每段文字推荐匹配的画面素材

步骤3:可视化编辑

- 在"视觉效果"选项卡替换或增强图像

- 使用"布局"选项卡格式化关键教学要点

- 调整文字样式和位置

步骤4:添加配音与字幕

- 选择AI语音旁白自动朗读

- 或上传自己录制的旁白,自动同步

- 自动生成可编辑字幕

步骤5:品牌与导出

- 创建品牌工具包(Logo、字体、颜色)

- 应用模板保持视觉一致性

- 导出或分享至社交媒体

适用场景

- 内容营销:博客文章→短视频

- 教育培训:课程材料→可视化视频

- 企业培训:文档→培训视频

7. InVideo AI

工具概述

从脚本、画面、配音、音乐到字幕一条龙的AI视频工厂,支持自然语言对话式修改。

核心功能

- AI视频生成:输入提示词或脚本,自动生成完整视频

- Workflows工作流:预设模板快速启动(如"解说类视频"、“UGC广告”)

- Agents & Models:一键调用Sora、Kling、Google Veo等第三方模型

- 对话式编辑:用自然语言指挥AI微调(如"把背景音乐调小")

使用教程

步骤1:创建AI视频

- 点击"Create AI Video"

- 选择模型版本(推荐最新InVideo AI 4.0)

- 输入提示词或粘贴脚本

步骤2:使用Workflows

- 选择工作流类型(热门趋势/UGC广告/教程类/不露脸解说)

- 设置视频时长(3/5/10分钟)

- 选择发布平台(YouTube/TikTok/Instagram)

- 选择语言、配音、音乐风格

- 一键生成

步骤3:对话式精修

生成后可在对话框输入:

- “把背景音乐声音调小一点”

- “开头第一段镜头换成办公室场景”

- “字幕颜色改成黄色,字体更醒目”

AI自动重新渲染对应部分

步骤4:时间线精细调整

- 点击"Edit"进入详细编辑界面

- 时间线选中片段替换素材

- 上传本地视频/图片或从素材库搜索

- 应用更改

联动工具推荐

- ChatGPT:脚本与提示词中枢

- HeyGen:AI虚拟数字人出镜

- ElevenLabs:高级AI配音

8. Pictory

工具概述

基于AI的视频剪辑工具,支持文本转视频、PPT转视频、音频转视频,自动生成同步视觉效果。

使用流程

步骤1:选择工作流

- 文本转视频:粘贴课程文本或脚本

- PPT转视频:上传PowerPoint幻灯片

- 音频转视频:使用录制的讲座或播客

- 录制:屏幕/摄像头录制

步骤2:生成脚本(可选)

使用AI脚本生成器:

- 输入课程构想(如"项目管理原则简介")

- 选择视频类型(教程/讲解/培训)

- 点击"生成脚本"

- 使用Ask AI工具重新措辞、优化或缩短

步骤3:可视化故事板

- 点击"生成视频"创建故事板

- AI自动分割内容为场景

- 每个场景匹配媒体库图像

- 使用"视觉效果"选项卡替换图像

- 使用"布局"选项卡格式化要点

步骤4:添加旁白与字幕

- 选择AI语音旁白,或

- 上传录制旁白,自动同步

- 自动生成可编辑字幕

步骤5:品牌应用

- 创建品牌工具包(Logo、字体、颜色)

- 应用模板保持课程一致性

- 导出高清视频

9. Synthesia

工具概述

革命性的在线AI视频生成平台,通过AI虚拟人物和语音合成,15分钟创建专业级视频,无需拍摄和剪辑。

核心功能

- 125+AI虚拟人:不同种族、职业、风格

- 120+语言支持:一键切换美式英语、法语、日语等口音

- 个性化定制:上传照片生成专属数字分身,录制20分钟音频克隆声线

- 场景化模板:产品演示、企业培训、新闻播报等

使用教程

步骤1:注册与选择模板

- 访问synthesia.io注册账号

- 从"Training"、"Explainer"等分类选择场景模板

步骤2:创作内容

- 选角色:在虚拟人库选择主播形象(可筛选性别/种族)

- 写脚本:在文本框输入解说词(支持自动翻译)

- 调设置:设置语言、语速、背景音乐

步骤3:生成与导出

- 点击"Generate Video"启动AI生成(3-5分钟)

- 预览渲染效果

- 精细编辑:逐帧修改文本、替换虚拟人、调整音轨

- 导出MP4(1080P)或分享链接

API集成(开发者)

import requests

# 创建视频

response = requests.post(

"https://api.synthesia.io/v2/videos",

headers={"Authorization": "YOUR_API_KEY"},

json={

"test": True,

"title": "My first Synthetic video",

"scriptText": "Hello, World! This is my first synthetic video.",

"avatar": "anna_costume1_cameraA",

"background": "green_screen"

}

)

video_id = response.json()["id"]

适用场景

- 企业培训视频

- 产品演示

- 内部通讯

- 教学课件

三、AI自动剪辑工具综合对比

| 工具名称 | 核心能力 | 自动化程度 | 上手难度 | 最佳适用场景 | 定价 |

|---|---|---|---|---|---|

| 剪映 | 图文成片、智能剪辑、AI数字人 | ⭐⭐⭐⭐⭐ | 极低 | 短视频、自媒体、电商 | 免费/订阅 |

| Runway Gen-2 | 生成+剪辑API、风格迁移 | ⭐⭐⭐⭐ | 高 | 影视预演、创意短片 | 免费积分/订阅 |

| Descript | 文本驱动剪辑、AI语音克隆 | ⭐⭐⭐⭐ | 中 | 播客、访谈、课程 | 免费试用/订阅 |

| Wisecut | 长视频提炼、自动去停顿 | ⭐⭐⭐⭐ | 低 | 教育、会议、直播回放 | 免费试用/订阅 |

| Kapwing | 智能去静音、自动字幕 | ⭐⭐⭐ | 低 | 社交媒体、团队协作 | 免费/Pro$16/月 |

| Lumen5 | 文章转视频、自动分镜 | ⭐⭐⭐⭐ | 极低 | 内容营销、博客转视频 | 免费/订阅 |

| InVideo AI | 脚本到成片、对话式编辑 | ⭐⭐⭐⭐⭐ | 低 | YouTube、广告、教程 | 免费/订阅 |

| Pictory | 文本/PPT/音频转视频 | ⭐⭐⭐⭐ | 低 | 教育课程、培训视频 | 免费试用/订阅 |

| Synthesia | AI数字人、多语言口播 | ⭐⭐⭐⭐ | 低 | 企业培训、产品演示 | 订阅制 |

第三部分:AI音效与视频自动组合工作流

推荐工作流组合

方案一:快速短视频生产(适合自媒体)

- 文案创作:ChatGPT生成脚本

- 素材生成:剪映"图文成片"自动配图、配音、字幕

- 音效增强:ElevenLabs生成特定音效(如按钮点击、转场音效)

- 自动剪辑:剪映"智能剪辑"优化节奏

- 输出:直接发布到抖音/小红书

方案二:专业影视制作(适合独立电影人)

- 分镜生成:Runway Gen-2根据剧本生成概念视频

- 音效设计:HunyuanVideo-Foley为关键镜头生成拟音

- 音乐创作:AIVA生成主题音乐,导出STEM分轨

- 自动粗剪:Descript根据剧本文字稿自动对齐素材

- 精剪:导入Premiere Pro进行专业调色和混音

方案三:商业广告制作(适合营销团队)

- 脚本生成:InVideo AI Workflows选择"UGC广告"模板

- 素材拍摄:手机拍摄产品素材

- 自动剪辑:Wisecut自动提炼高光片段

- 音效配乐:Mubert生成免版税背景音乐

- 数字人:Synthesia生成产品解说

- 输出:多平台尺寸自动适配(Kapwing)

方案四:游戏开发(适合独立开发者)

- 环境音效:AudioLDM-S批量生成环境音(雨林、洞穴、雪地)

- 动作音效:HunyuanVideo-Foley为角色动画生成脚步声、打击声

- 背景音乐:AIVA生成循环BGM,导出MIDI在DAW中调整

- 交互音效:ElevenLabs生成UI音效

- 整合:导入Wwise或FMOD进行游戏音频中间件集成

第四部分:技术选型建议

音效生成工具选择决策树

需要生成的音效类型?

├── 特定独立音效(如按钮声、爆炸声)

│ ├── 需要开源/本地部署 → Stable Audio Open / AudioLDM-S

│ └── 云端快速生成 → ElevenLabs / MyEdit

├── 视频同步音效(拟音)

│ ├── 有视频素材需要匹配 → HunyuanVideo-Foley(开源)

│ └── 需要实时生成 → 即梦3.5 Pro(音画一体)

├── 背景音乐

│ ├── 需要人声演唱 → Suno / Udio

│ ├── 纯器乐/专业配乐 → AIVA(可导出MIDI)

│ └── 免版税/快速匹配 → Mubert / Soundraw / Beatoven.ai

└── 环境氛围音

├── 游戏开发 → AudioLDM-S(批量生成)

└── 影视后期 → 腾讯混元 / ElevenLabs

自动剪辑工具选择决策树

现有素材类型?

├── 只有文字/文章

│ ├── 需要真人出镜 → Synthesia(数字人)

│ └── 图文动画 → Lumen5 / 剪映图文成片

├── 有长视频需要提炼

│ ├── 教育/会议内容 → Wisecut

│ ├── 播客/访谈 → Descript(文本剪辑)

│ └── 社交媒体切片 → Kapwing / 剪映

├── 有分镜需要生成+剪辑

│ ├── 影视级要求 → Runway Gen-2 + API自动化

│ └── 快速出片 → InVideo AI / Pictory

└── 需要音画同步生成

└── 即梦3.5 Pro(唯一选择)

结语

AI音效生成和自动剪辑技术正在快速成熟,从2024年到2025年,我们已经看到从"玩具级"向"生产级"的质变。关键趋势包括:

- 音画一体化:即梦3.5 Pro等工具实现了生成阶段的音画同步,而非后期叠加

- 开源生态繁荣:腾讯混元、Stable Audio Open等开源模型降低了专业门槛

- 工作流整合:剪映、InVideo等工具将分散的AI能力串联成闭环

- 文本驱动:Descript等工具让视频编辑像编辑文档一样直观

建议创作者根据自身技术背景(代码能力vs纯操作)、预算(免费开源vs付费服务)、产出要求(快速批量vs精品质感)选择合适的工具组合,建立个性化的AI音视频工作流。

更多推荐

已为社区贡献180条内容

已为社区贡献180条内容

所有评论(0)