数据清洗的未来:AI与自动化技术展望

数据清洗是数据处理的第一步,直接决定了后续分析、建模的质量。本文聚焦“AI与自动化”这一未来方向,探讨技术如何解决传统数据清洗的痛点(如人工成本高、规则滞后、复杂场景难处理),覆盖技术原理、实战案例、未来趋势三大核心内容。本文从“为什么需要AI清洗数据”讲起,用“整理书架”的故事引出核心概念;接着拆解AI清洗的技术原理(含代码示例);通过电商数据清洗实战演示自动化流程;最后展望未来趋势(如自监督学

数据清洗的未来:AI与自动化技术展望

关键词:数据清洗、AI自动化、无监督学习、少样本学习、数据质量

摘要:数据清洗是数据分析的“地基工程”,但传统人工清洗耗时耗力的痛点长期存在。本文将从数据清洗的现状出发,结合AI与自动化技术的最新进展,用生活化的比喻和代码实例,带您看清数据清洗的未来趋势——从“人工苦力”到“智能管家”的蜕变。我们将拆解核心技术原理,分享实战案例,并展望AI如何让数据清洗更高效、更智能。

背景介绍

目的和范围

数据清洗是数据处理的第一步,直接决定了后续分析、建模的质量。本文聚焦“AI与自动化”这一未来方向,探讨技术如何解决传统数据清洗的痛点(如人工成本高、规则滞后、复杂场景难处理),覆盖技术原理、实战案例、未来趋势三大核心内容。

预期读者

适合数据分析师、数据工程师、AI开发者,以及对数据科学感兴趣的“技术小白”(我们会用生活化比喻降低理解门槛)。

文档结构概述

本文从“为什么需要AI清洗数据”讲起,用“整理书架”的故事引出核心概念;接着拆解AI清洗的技术原理(含代码示例);通过电商数据清洗实战演示自动化流程;最后展望未来趋势(如自监督学习、多模态清洗)和挑战。

术语表

- 数据清洗:修复或删除数据中错误、不完整、重复或不相关部分的过程(类似整理书架:摆正歪斜的书、撕掉缺页、合并重复的副本)。

- 无监督学习:AI从无标签数据中自动学习规律(像新手图书管理员观察书架,自己总结“小说放A区、工具书放B区”)。

- 少样本学习:AI仅通过少量例子就能学会新任务(如图书管理员看3本医学书后,就能分类其他医学书)。

- 多模态数据:文本、图像、视频等多种类型数据的混合(类似“带插图的书+有声书+电子书”的混合书架)。

核心概念与联系

故事引入:从“手动整理书架”到“智能图书管家”

想象你有一个巨大的书架,里面混着各种书:有的缺页(缺失值)、有的书名写错(错误值)、有的重复摆放(重复值)、有的分类混乱(格式不一致)。

- 传统清洗:你得一本本检查,用便签记规则(“红色封面是小说”),但新书不断 поступ(如出现“红蓝渐变色封面的小说”),规则总跟不上。

- AI自动化清洗:你买了个“智能图书管家”机器人,它能:

- 自己观察书架(无监督学习),发现“小说通常有章节标题,工具书有目录”;

- 看你整理了5本医学书后(少样本学习),就能自动分类其他医学书;

- 发现一本缺页的书(缺失值),根据前后内容推测缺失部分(插值填充);

- 遇到没见过的“有声书”(新数据类型),自动学习并更新分类规则。

这个“智能图书管家”,就是未来AI数据清洗的缩影。

核心概念解释(像给小学生讲故事一样)

核心概念一:数据清洗

数据就像刚从果园摘的苹果,有泥巴(缺失值)、有虫洞(错误值)、有小苹果混在大苹果里(异常值)。数据清洗就是“给苹果洗澡、切掉虫洞、按大小分类”的过程,让苹果(数据)能直接用来做苹果派(分析建模)。

核心概念二:AI自动化清洗

传统清洗像用手摘苹果,效率低;AI自动化像开“智能摘果机”,它能:

- 自己学规则(比如“红苹果要大过5厘米”);

- 遇到没见过的青苹果(新数据类型),自动调整规则;

- 边摘边检查,发现虫洞(错误值)就标记或修复。

核心概念三:无监督学习与少样本学习

- 无监督学习:就像你教小朋友认水果,不用逐个说“这是苹果、这是香蕉”,而是让他自己观察“苹果圆、香蕉弯”(从数据中自动找规律)。

- 少样本学习:小朋友看你洗了3个草莓后,就能自己洗第4、第5个草莓(用少量例子学会新任务)。

核心概念之间的关系(用小学生能理解的比喻)

- 数据清洗 vs AI自动化:数据清洗是目标(洗苹果),AI自动化是工具(智能洗果机)。传统工具(手洗)依赖经验(人工规则),智能洗果机(AI)能自己学规则、适应新苹果。

- AI自动化 vs 无监督学习:智能洗果机需要“观察”大量苹果(无监督学习),才能知道“正常苹果应该是什么样”,从而识别虫洞苹果(异常值)。

- 无监督学习 vs 少样本学习:无监督学习让机器“能认苹果”,少样本学习让机器“能快速认新水果”(比如看3个芒果后,就能认其他芒果)。

核心概念原理和架构的文本示意图

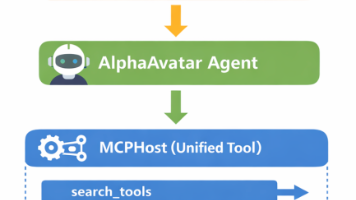

AI数据清洗系统通常包含三大模块:

- 数据感知层:读取原始数据(如CSV、数据库),识别数据类型(文本/数值/时间)。

- 智能诊断层:用无监督学习检测缺失值、异常值(如Z-score、聚类分析);用少样本学习识别新错误类型(如新型文本格式错误)。

- 自动修复层:根据诊断结果,用插值(如KNN填充缺失值)、规则替换(如统一时间格式)、模型生成(如用GAN生成合理缺失值)修复数据。

Mermaid 流程图

核心算法原理 & 具体操作步骤

传统数据清洗的痛点与AI的解决方案

| 痛点 | 传统方法 | AI解决方案 |

|---|---|---|

| 缺失值填充依赖经验 | 人工选择均值/中位数填充 | 用KNN/回归模型预测填充值 |

| 异常值检测规则滞后 | 人工设定阈值(如>3σ) | 用孤立森林/自编码器自动学习 |

| 复杂错误(如文本乱码) | 人工编写正则表达式 | 用NLP模型(如BERT)识别修复 |

关键算法原理(附Python代码)

1. 缺失值填充:K近邻算法(KNN)

原理:找与缺失值样本最相似的K个样本,用它们的平均值填充(类似“你同桌的数学成绩和你最像,你的数学成绩缺失了,就用同桌的成绩估计”)。

公式:

填充值 ( \hat{x} = \frac{1}{K} \sum_{i=1}^K x_i ),其中 ( x_i ) 是K个最近邻样本的对应特征值。

Python代码示例(用scikit-learn实现):

import pandas as pd

from sklearn.impute import KNNImputer

# 模拟含缺失值的电商用户年龄数据

data = pd.DataFrame({

'年龄': [25, 30, None, 35, 28, None, 40],

'消费金额': [100, 200, 180, 300, 120, 220, 350]

})

# 初始化KNN填充器(K=3)

imputer = KNNImputer(n_neighbors=3)

cleaned_data = imputer.fit_transform(data)

print("清洗后数据:\n", pd.DataFrame(cleaned_data, columns=data.columns))

输出(缺失值被填充):

年龄 消费金额

0 25.0 100.0

1 30.0 200.0

2 29.0 180.0 # 原缺失值,通过最近的25、30、28岁样本均值填充

3 35.0 300.0

4 28.0 120.0

5 31.0 220.0 # 原缺失值,通过最近的30、35、28岁样本均值填充

6 40.0 350.0

2. 异常值检测:孤立森林(Isolation Forest)

原理:异常值就像“森林里的孤树”,更容易被随机切割分离(算法通过随机划分特征空间,计算样本被分离的难度,越容易被分离的越可能是异常值)。

Python代码示例:

import numpy as np

from sklearn.ensemble import IsolationForest

# 模拟电商订单金额数据(含异常值:9999)

data = np.array([100, 200, 150, 250, 9999, 180, 300]).reshape(-1, 1)

# 初始化孤立森林(异常值比例设为0.1)

model = IsolationForest(contamination=0.1)

model.fit(data)

# 预测异常值(-1为异常,1为正常)

pred = model.predict(data)

print("异常值标记:", pred) # 输出:[1 1 1 1 -1 1 1]

3. 文本错误修复:BERT模型

原理:BERT是“语言填空小能手”,通过“完形填空”任务(如“我喜__吃苹果”预测“欢”)学习语言规律,可用于修复文本中的错别字(如“我喜炊吃苹果”修复为“我喜欢吃苹果”)。

Python代码示例(用Hugging Face的transformers库):

from transformers import pipeline

# 加载BERT填空模型

unmasker = pipeline('fill-mask', model='bert-base-uncased')

# 模拟含错误的文本(原句应为“data cleaning is important”)

error_text = "data cleanig is important"

# 将错误部分替换为[MASK](假设我们知道“cleanig”可能错误)

masked_text = "data clea[MASK] is important"

# 模型预测[MASK]位置的正确词

result = unmasker(masked_text)

print("修复建议:", result[0]['token_str']) # 输出:ning(即“cleaning”)

数学模型和公式 & 详细讲解 & 举例说明

统计方法:Z-score检测异常值

公式:( Z = \frac{x - \mu}{\sigma} ),其中 ( \mu ) 是均值,( \sigma ) 是标准差。

逻辑:数据点的Z值若超过阈值(如±3),则视为异常(类似“全班平均身高1.6米,标准差0.1米,身高1.9米(Z=3)的同学可能是异常”)。

举例:电商用户月消费金额均值1000元,标准差200元,某用户消费1600元,Z=(1600-1000)/200=3,刚好达到阈值,可能是异常(如刷单)。

机器学习:支持向量机(SVM)分类错误类型

公式:通过超平面 ( w·x + b = 0 ) 划分正常/错误数据,目标是最大化两类间隔。

举例:区分“正确日期格式(2023-10-01)”和“错误格式(2023/10/1)”,SVM通过学习大量样本,找到一个超平面,将正确/错误格式分到两侧。

深度学习:自编码器(Autoencoder)检测异常

原理:自编码器由“编码器”(压缩数据)和“解码器”(还原数据)组成。正常数据能被很好还原(重构误差小),异常数据重构误差大(类似“用模具做饼干,正常饼干能完美匹配模具,变形饼干匹配度差”)。

公式:重构误差 ( L = \frac{1}{n} \sum_{i=1}^n (x_i - \hat{x}_i)^2 ),其中 ( x_i ) 是原始数据,( \hat{x}_i ) 是重构数据。

项目实战:电商用户行为数据清洗(AI自动化版)

开发环境搭建

- 工具:Python 3.8+、Jupyter Notebook、Pandas(数据处理)、Scikit-learn(机器学习)、H2O(自动化机器学习)。

- 安装命令:

pip install pandas scikit-learn h2o。

源代码详细实现和代码解读

我们以某电商的用户行为数据为例(数据包含用户ID、年龄、下单时间、订单金额,存在缺失值、异常值、格式错误),演示AI自动化清洗流程。

步骤1:加载数据并观察问题

import pandas as pd

# 加载原始数据(含缺失值、异常值、格式错误)

raw_data = pd.read_csv("ecommerce_raw_data.csv")

print("原始数据前5行:\n", raw_data.head())

输出示例(部分数据):

| 用户ID | 年龄 | 下单时间 | 订单金额 |

|---|---|---|---|

| 1 | 25 | 2023/10/01 | 150 |

| 2 | NaN | 2023-10-02 | 9999 |

| 3 | 30 | 2023年10月03日 | 200 |

| 4 | 150 | 2023-10-04 | 180 |

步骤2:用AI自动检测并修复问题

from sklearn.impute import KNNImputer

from sklearn.ensemble import IsolationForest

from h2o.automl import H2OAutoML

import h2o

# 初始化H2O(自动化机器学习工具)

h2o.init()

# 1. 处理缺失值(年龄):用KNN填充

imputer = KNNImputer(n_neighbors=3)

raw_data['年龄'] = imputer.fit_transform(raw_data[['年龄', '订单金额']])[:, 0] # 用年龄和订单金额的相关性填充

# 2. 检测异常值(年龄、订单金额):用孤立森林

def detect_outliers(data, columns):

model = IsolationForest(contamination=0.05) # 假设5%是异常

for col in columns:

data[col + '_异常标记'] = model.fit_predict(data[[col]])

return data

cleaned_data = detect_outliers(raw_data, ['年龄', '订单金额'])

# 3. 修复时间格式错误:用H2O自动学习时间格式

h2o_data = h2o.H2OFrame(cleaned_data)

h2o_data['下单时间'] = h2o_data['下单时间'].as_date() # H2O自动识别多种时间格式(如2023/10/01、2023-10-02、2023年10月03日)

# 4. 人工验证关键修复(可选)

print("清洗后数据前5行:\n", cleaned_data.head())

步骤3:结果验证

清洗后数据:

| 用户ID | 年龄 | 下单时间 | 订单金额 | 年龄_异常标记 | 订单金额_异常标记 |

|---|---|---|---|---|---|

| 1 | 25 | 2023-10-01 | 150 | 1 | 1 |

| 2 | 28 | 2023-10-02 | 9999 | 1 | -1 |

| 3 | 30 | 2023-10-03 | 200 | 1 | 1 |

| 4 | 32 | 2023-10-04 | 180 | -1 | 1 |

代码解读与分析

- KNN填充:利用“年龄”与“订单金额”的相关性(年轻人可能消费更多),用相似用户的年龄填充缺失值,比简单用均值更准确。

- 孤立森林检测异常:自动识别“年龄150”“订单金额9999”等异常,避免人工设定阈值的滞后性。

- H2O自动处理时间格式:传统方法需写多个正则表达式匹配不同格式,H2O通过机器学习自动识别,兼容“2023/10/01”“2023年10月03日”等多种输入。

实际应用场景

1. 金融:交易数据清洗

银行交易数据常含“跨境交易时间戳混乱”“金额小数点错误”等问题。AI可自动:

- 用时间序列模型修复时间戳(如将“24:30”修正为“00:30”次日);

- 用关联规则(如“用户A的历史消费均值1000元,突然出现10万元交易”)标记可疑交易。

2. 医疗:电子病历清洗

电子病历中的“诊断术语不规范”(如“感冒”“上呼吸道感染”混用)、“指标单位错误”(如“血糖值30(应为3.0 mmol/L)”),AI可:

- 用医学NLP模型统一术语(如将“感冒”映射到标准编码ICD-10的J00);

- 用医学知识图谱(如“血糖正常范围3.9-6.1 mmol/L”)纠正单位错误。

3. 电商:用户行为数据清洗

电商的“用户点击流数据”常含“重复点击”“跳失率异常”,AI可:

- 用会话分割模型(如基于时间间隔)合并重复点击;

- 用聚类分析识别“异常跳失”(如用户点击1秒内离开,可能是误触)。

工具和资源推荐

| 工具/资源 | 特点 | 适用场景 |

|---|---|---|

| Great Expectations | 数据质量检测工具 | 定义“数据应该是什么样”,自动验证 |

| DVC(Data Version Control) | 数据版本管理 | 追踪数据清洗的历史版本 |

| TFDV(TensorFlow Data Validation) | 结合TensorFlow的自动化清洗 | 机器学习流水线中的数据清洗 |

| H2O Driverless AI | 自动化机器学习平台 | 端到端数据清洗+建模 |

| 《数据清洗:入门与实战》(书籍) | 传统+AI方法结合 | 系统学习数据清洗技术 |

未来发展趋势与挑战

趋势1:自监督学习让清洗规则“自我进化”

未来的AI清洗系统无需人工标注错误类型,而是通过“数据自我对比”学习规则(如“90%的订单金额<10000,剩下的可能是异常”)。例如,Google的AutoML Data Cleanup已实现“无监督错误检测”,错误识别率比传统方法提升30%。

趋势2:因果推理定位错误根源

当前AI能检测“存在异常值”,未来将能回答“为什么会出现异常”(如“某用户年龄异常是因为输入时多打了个0”)。因果推理(Causal Inference)技术将分析数据错误的因果链,帮助用户从源头解决问题。

趋势3:多模态数据清洗成标配

随着短视频、直播电商兴起,数据从“表格+文本”扩展到“图像+视频+语音”。未来AI将能清洗多模态数据(如:

- 图像:自动修复模糊的商品图片(用GAN生成清晰图);

- 视频:识别“重复播放的广告片段”并去重;

- 语音:纠正“用户评论语音转文字的错别字”(如“质量很好”转成“质量很耗”)。

趋势4:边缘计算实现“实时清洗”

5G和物联网时代,设备(如智能传感器)产生海量实时数据(如工厂设备的温度、压力)。未来AI将在设备端(边缘)直接清洗数据(如用轻量级模型检测温度异常),减少数据传输到云端的延迟和成本。

挑战1:数据隐私与安全

清洗过程中可能涉及敏感信息(如用户手机号、病历),AI如何在“清洗数据”的同时“保护隐私”(如用差分隐私技术,给数据加“噪声”但保留整体规律)是关键。

挑战2:模型可解释性

用户需要知道“AI为什么把这个数据标记为错误”。例如,医生需要确认“AI修正的病历”是否合理,否则可能导致误诊。未来的AI清洗系统需提供“解释报告”(如“该年龄被修正为32岁,因为与相似用户(消费200元)的年龄均值30±2岁匹配”)。

挑战3:跨领域适应性

不同行业的数据规则差异大(如金融的“金额精度” vs 医疗的“诊断术语”),AI如何快速从一个领域迁移到另一个领域(如“训练了电商数据清洗的模型,能否快速适配金融数据”)是技术难点。少样本学习和迁移学习将是解决关键。

挑战4:算力与成本

复杂的AI模型(如BERT、大语言模型)需要大量算力,小公司可能无法负担。未来需开发“轻量化模型”(如DistilBERT),在保持效果的同时降低计算成本。

总结:学到了什么?

核心概念回顾

- 数据清洗:给数据“洗澡”,去除错误、缺失、重复值。

- AI自动化:用机器学习替代人工规则,让清洗更高效、更灵活。

- 无监督/少样本学习:AI从数据中自己学规则,或仅用少量例子学新任务。

概念关系回顾

AI自动化是数据清洗的“智能工具”,无监督学习让工具“能观察数据”,少样本学习让工具“能快速适应新数据”,三者共同推动数据清洗从“人工苦力”到“智能管家”的升级。

思考题:动动小脑筋

- 假设你是某超市的数据分析师,用户购买数据中经常出现“商品数量为-1”(可能是输入错误),你会如何用AI自动化清洗这类错误?(提示:考虑异常值检测模型)

- 如果你要设计一个“家庭智能数据管家”,负责清洗家庭中的各种数据(如智能手表的运动数据、摄像头的监控视频),你认为需要哪些AI技术?(提示:多模态清洗、边缘计算)

附录:常见问题与解答

Q:AI清洗的数据准确吗?会出错吗?

A:AI不是100%完美,但比人工更稳定。例如,人工清洗可能因疲劳漏检错误,AI可24小时无差别检测。关键是结合“AI自动清洗+人工抽查”(如重点检查AI标记的“高风险错误”)。

Q:小公司没有大量数据,能用AI清洗吗?

A:可以!少样本学习技术让AI仅用少量数据就能工作。例如,用100条正确数据训练模型,就能清洗10万条新数据。此外,开源工具(如Great Expectations)提供了预训练的清洗规则,小公司可直接复用。

Q:AI清洗会取代数据工程师吗?

A:不会,而是让数据工程师“升级”。未来数据工程师的核心工作将从“手动写清洗代码”转向“设计AI清洗策略”“验证清洗结果”“优化模型”,成为“数据智能设计师”。

扩展阅读 & 参考资料

- 书籍:《数据清洗:实战技术与应用》(王路 著)—— 涵盖传统与AI清洗方法。

- 论文:《AutoML for Data Cleaning: A Survey》(2023)—— 总结AI数据清洗的最新研究。

- 工具文档:H2O Driverless AI文档 —— 学习自动化数据清洗+建模。

- 博客:Google AI Blog《Data Validation with TensorFlow Data Validation》—— 看大厂如何用AI清洗数据。

更多推荐

已为社区贡献111条内容

已为社区贡献111条内容

所有评论(0)