大模型记忆机制深度解析:它是如何记住你的?

本文探讨了LLM记忆系统的核心机制与实践路径。记忆系统本质上围绕"抽取"和"检索"两大模块展开:抽取层负责从对话、日志等多源输入中提炼有价值信息,通过语义压缩形成长期记忆;检索层则根据当前上下文动态召回相关记忆。关键发现包括:1)对话文本是最优记忆输入源;2)记忆需要支持动态更新与遗忘机制;3)存储形态决定系统能力边界;4)检索是迭代优化的过程。目前业界正通

即使 OpenAI 在模型能力上持续受到 Gemini 和 Claude 的追赶,User Memory 依然是 ChatGPT 最难被复制、也最容易让用户产生依赖的差异化能力。

Claude Code 允许用户维护 claude.md,自己撰写 Skill,目标是在显式地把人类意图和做事方式写入系统记忆;

Cursor 通过记录用户是否接受 Tab 补全来进行 Online RL,是在捕捉任务执行过程中的隐式反馈并用于实时迭代策略;

ChatGPT 在 Memory 之上延展出 Pluse、Atlas 等产品,其实上是在把记忆当作一种长期资产来经营。

这些尝试看起来形式各异,但背后的目标高度一致:

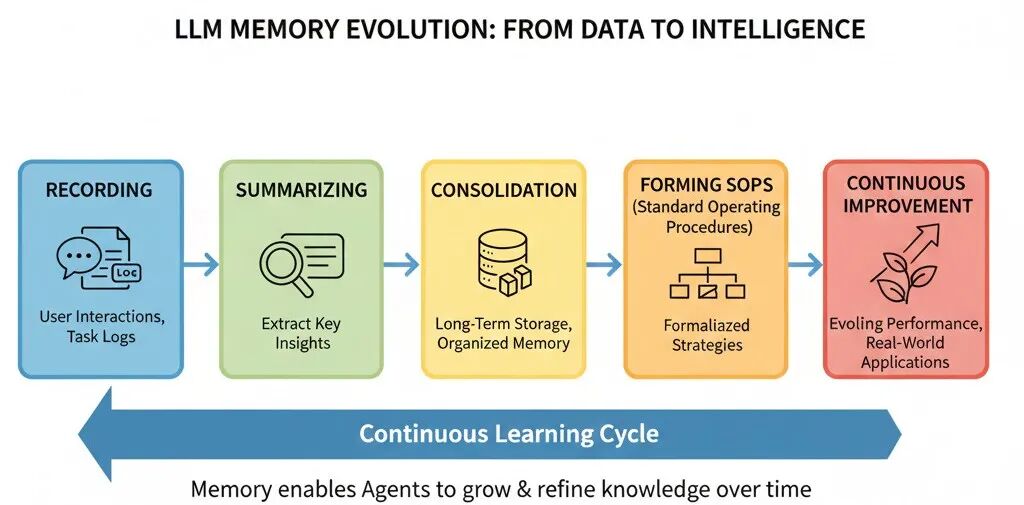

记录 → 总结 → 沉淀 → 形成 SOP→ 让 Agent 在真实环境中越跑越聪明

这正是当下 LLM Memory 模块真正承担的角色。

也正因为如此,无论是创业公司、学术研究、开源社区,还是大厂,都在密集投入这一方向。本文尝试从工程视角出发,总结目前已经被验证过的一些 Memory 实践路径。

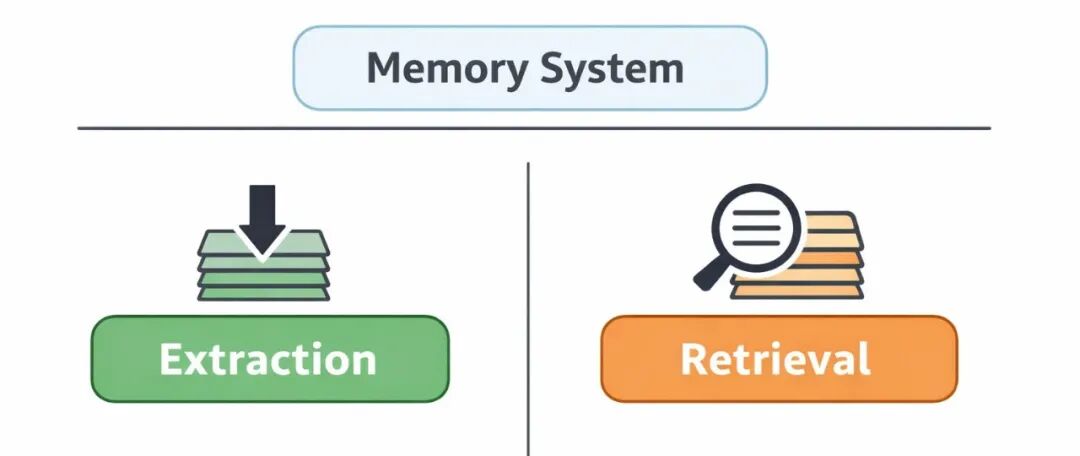

Memory 的工程本质:只有两件事

如果把 Memory 拆解到工程层面,其实并不复杂。所有系统,无论形态多么花哨,最终都绕不开两件事:

如何把信息写进记忆,以及如何在需要时把记忆取出来。

也就是:

- 记忆的抽取(Extraction)

- 记忆的检索(Retrieval)

大量看似复杂的 Memory 系统,实际上都是这两部分能力的不同组合。

一、记忆抽取模块(Extraction)

在工程上,一个完整的抽取流程通常可以理解为三段式结构:

Input→ Process →Output

不同 Memory 产品的差异,几乎都隐藏在这三个问题的答案里。

输入层:你到底在“记什么”

当前绝大多数 Memory 产品,仍然只处理文本信息,而且高度聚焦在对话消息列表这一输入形态。无论是 Mem0 还是 Memobase,基本都做出了相同的选择。这并不是能力不足,而是一个非常理性的工程判断。

对话天然具备清晰的 user / assistant 角色约束,语义边界明确,可控性强,抽取过程也更容易保持稳定。更重要的是,对话本身已经是被 LLM 深度优化过的“中间表示”,既有人类意图,又包含足够上下文信息,非常适合作为 Memory 抽取的起点。

相比之下,通用日志、工具调用轨迹、原始 COT 文本虽然信息密度更高,但往往缺乏统一结构,语义粒度不稳定,解析成本极高,也很难形成跨项目、跨团队复用的通用解法。因此,大多数做记忆系统的团队,都会优先从对话文本切入,把问题收敛在一个可控范围内。

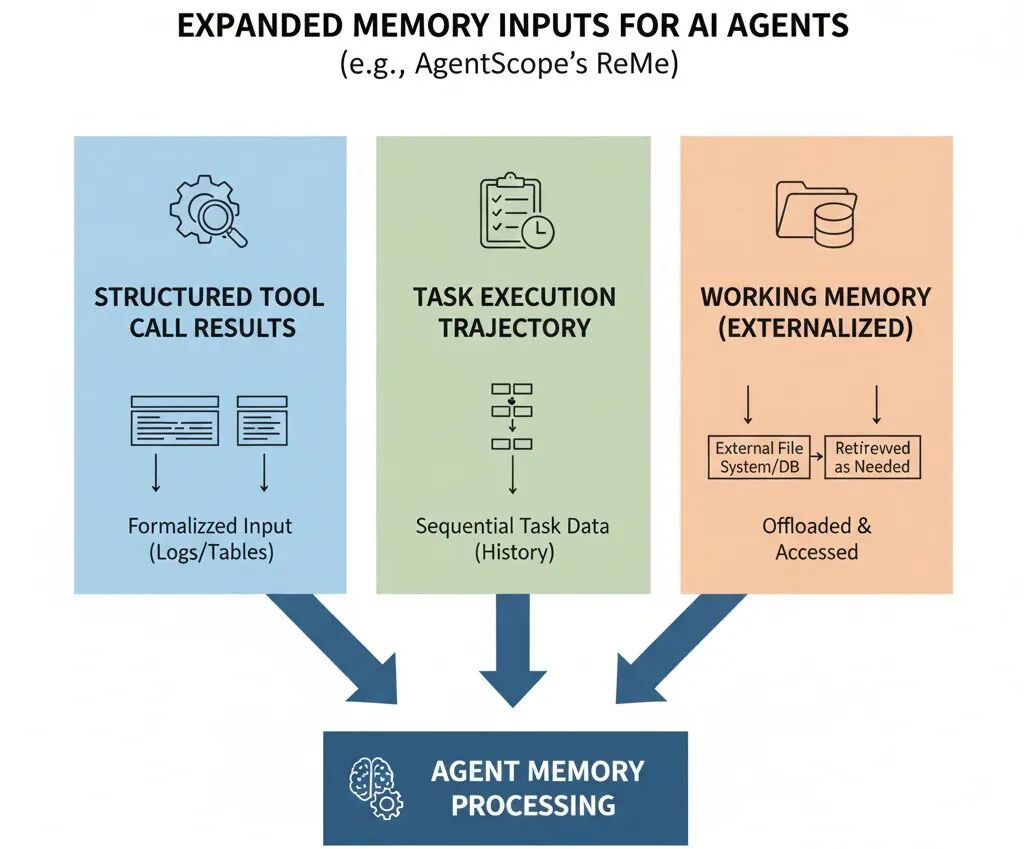

不过,这并不意味着对话列表是唯一合理的记忆输入形态。一些更偏向 Agent 框架的系统,已经开始尝试拓展 Memory 的输入边界。以阿里云的开源框架 AgentScope 中的 ReMe 为例,它在能力设计上就已经显式支持“对话之外”的记忆输入:例如结构化的工具调用结果、任务执行轨迹、以及被外置到文件系统中的 Working Memory。这类输入不再是自然语言对话,而是更接近运行时日志和行为记录的数据形态。

但值得注意的是,这类扩展目前仍然高度依赖具体框架和场景,并没有形成统一范式。很多时候,它们依然需要被二次总结、压缩成文本或半结构化表示,才能真正进入长期 memory 系统。

多模态记忆:需求仍未真正爆发

多模态记忆在当前阶段,更多是需求驱动而非能力驱动,主要集中在机器人、AI 手机、AI 眼镜、摄像头等场景中。这些系统确实需要处理图像、视频和音频,但在 Memory 层面,主流工程实践仍然高度一致。

无论输入多么复杂,最终几乎都会走向同一条 pipeline:多模态输入 → 语义压缩 → 转写为文本或结构化摘要 → 进入既有的文本 Memory 流程,此处参考 Memu。

这并不是因为多模态信息不重要,而是因为在当前阶段,文本仍然是最稳定、最通用、也最容易被检索和重排的记忆载体。真正决定多模态 Memory 是否会形成独立分支的,并不是输入类型是否丰富,而是是否出现了稳定的新交互范式(具身智能),使得非文本信息本身具备长期记忆价值。

在那之前,多模态更像是 Memory 系统的“前置感知层”,而不是记忆本体。

处理层:记住“未来还会用到的东西”

抽取模块的目标非常明确:

一方面压缩信息,降低存储和检索成本; 另一方面筛选出那些未来仍然可能影响决策分布的内容。

当前最常见的做法,是让 LLM 扮演某种“理解者”的角色,从连续对话中抽取用户画像和关键事件。画像通常描述偏好、习惯和长期约束;事件则刻画目标设立、决策变化和状态转移。

真正决定系统上限的,不是模型能力,而是抽象方式。

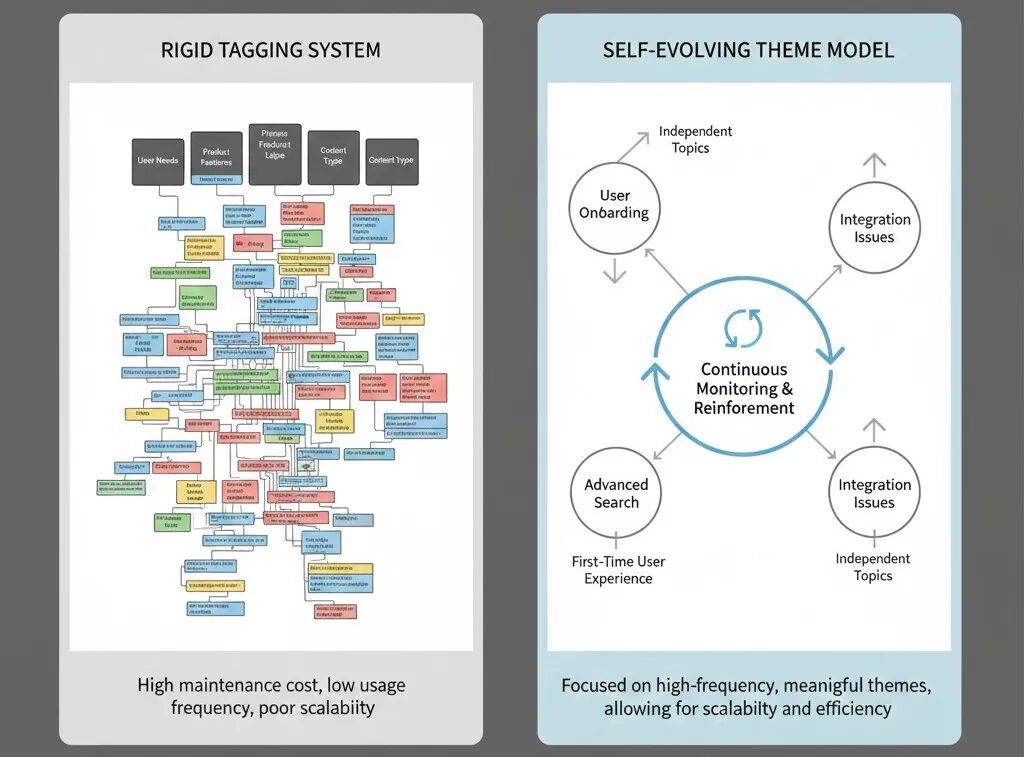

在通用 Chatbot 场景下,很多团队会尝试用庞大的标签体系覆盖世界。设计几百个一级标签、上千甚至上万个二级标签,试图穷举所有可能的话题和用户特征。但在长期运行中,这种方式维护成本极高,大量标签在真实用户身上从未被触发,更重要的是,这并不符合人类记忆的工作方式。

人类的长期记忆,对极少数高频主题异常敏感,而对大量低频信息则自然淡化。

工程上,可以把抽取过程本身做成一个持续运行的 Agent,让它不断监控新对话与历史记忆之间的重合程度。当某些话题在不同时间反复出现、被持续强化时,系统才将其提升为独立主题,并为其建立专属的 Memory 结构。这种主题自进化的方式,在长期运行中往往更稳定,也更具扩展性,Memu 的相关设计就是一个值得参考的方向。

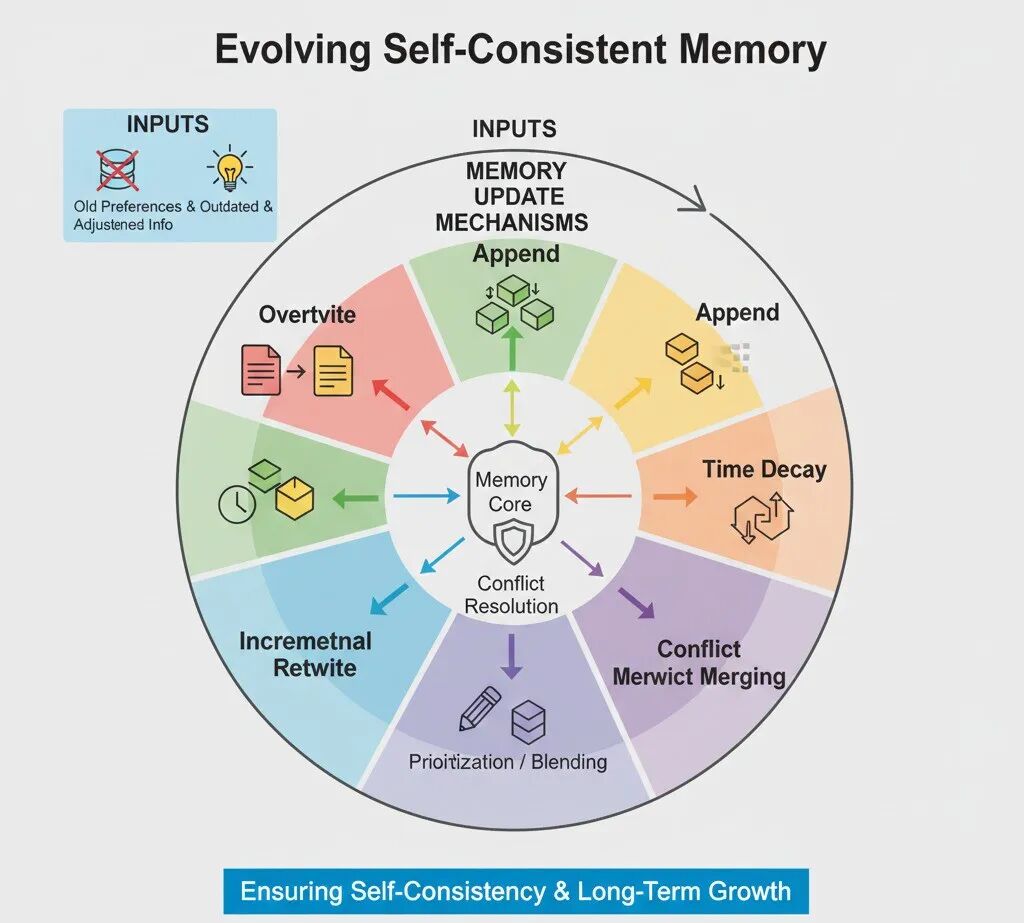

记忆管理机制:遗忘,更新和修正

需要特别强调的是,Memory 并不是只增不减的。

如果一个 Memory 系统不支持遗忘、修正和冲突处理,它迟早会走向失控。

旧的偏好、新设的目标、已经被推翻的判断,如果在系统中长期并存而不被更新,最终只会让 Agent 在不同场景下做出相互矛盾的决策。对用户而言,这种体验并不是“AI 记得很多”,而是“AI 开始前后不一”。

覆盖、追加、时间衰减、增量重写以及冲突合并,看似是不同的工程手段,但它们本质上都在回答同一个问题:当新信息出现时,旧信息是否仍然成立。Memory 系统需要做的,并不是尽可能多地保存历史,而是持续判断哪些记忆还应当参与当前的认知过程。

Memory 的更新策略,决定的不是存储效率,而是 Agent 能否在时间维度上保持自我一致,并在此基础上持续进化。

输出层:记忆的存储形态与能力边界

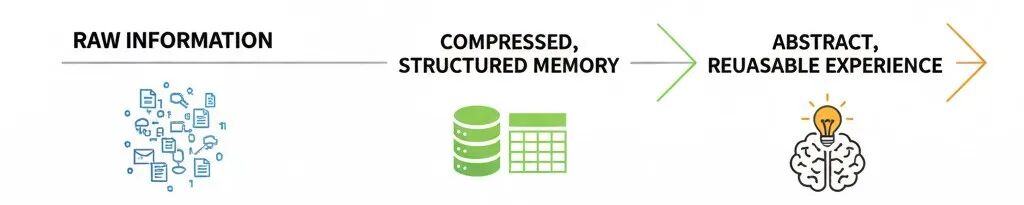

如果说前面的抽取解决的是‘记什么’,那接下来的问题是:这些记忆最终以什么形态存在,又会反过来限制系统能做什么。更准确地说,记忆本身并没有天然的形态,它的表达方式取决于你希望系统如何使用它。从工程视角看,可以把 Memory 理解为一条连续的轴:一端是几乎未经处理的原始信息,中间是被压缩、结构化后的表示,另一端则是高度抽象、可复用的经验。这些存在方式都合理,选型的决定性因素是你想怎样利用这些记忆。

落到具体系统中,这条轴对应多种并存的记忆形态。用户画像用于描述长期稳定的特征,工具调用结果和任务执行状态保存的是行为轨迹,而偏好和经验则更接近决策层面的背景条件。这些形态并不是彼此排斥的,而是共同构成了 Agent 的长期状态空间。

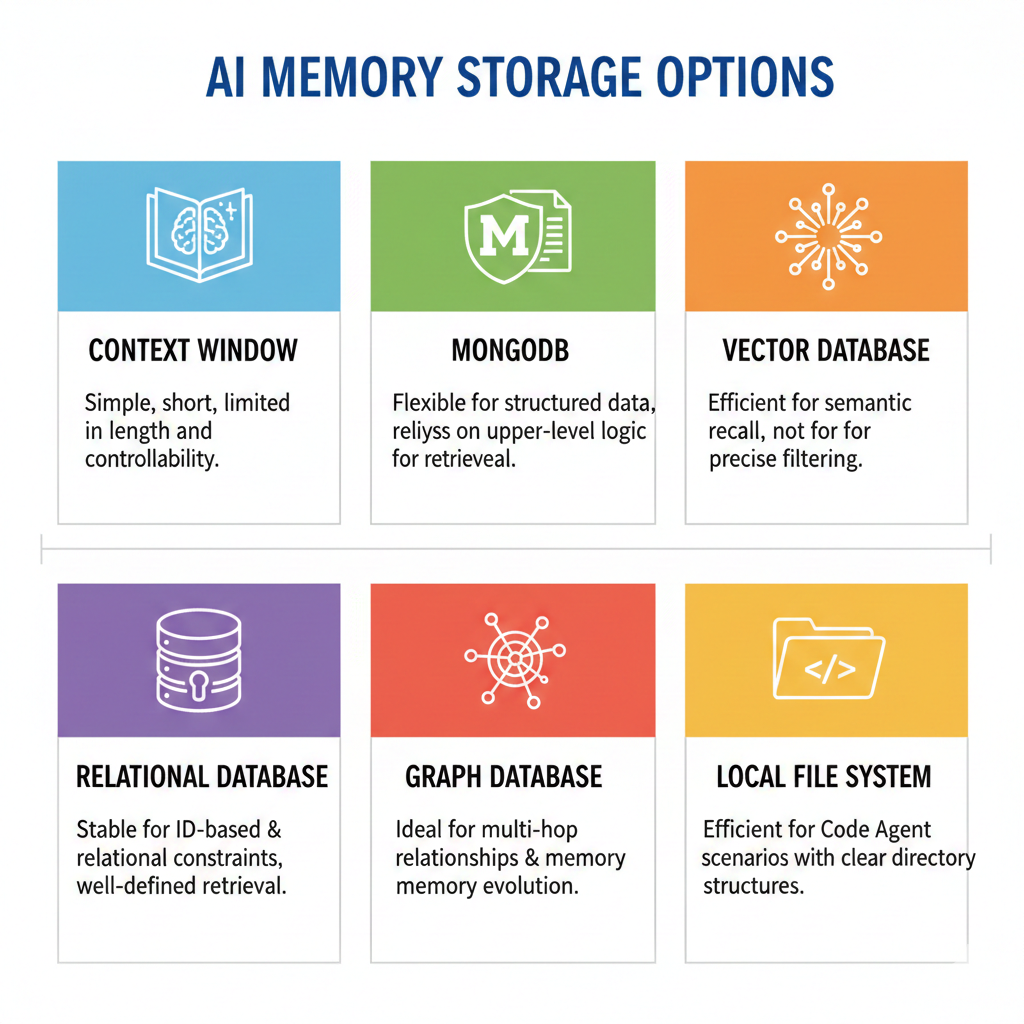

另外一个需要做取舍的是这些记忆以什么方式被存储。这里并不存在所谓的“最优解”,因为不同的存储方案,本质上是在为系统划定不同的能力边界。把记忆直接塞进上下文窗口,路径最短、实现最简单,但长度和可控性都极其有限(ChatGPT);使用 MongoDB 这样的文档数据库,可以灵活地存储结构化画像和事件,但检索能力更多依赖上层逻辑;向量数据库在语义召回上效率极高,却不擅长强约束和精确过滤(Mem0);关系型数据库在 ID 和关系约束下表现稳定,适合规则明确的检索场景(Memobase);图数据库则更适合表达多跳关系以及记忆随时间演化的结构(Zep);而在 Code Agent 等场景中,本地文件系统凭借清晰的目录层级和天然的上下文隔离,反而成为一种非常高效的选择(Claude code)。

因此,记忆的输出层设计,从来不是“选哪种数据库”的技术偏好问题,而是在回答一个更根本的问题:你希望 Memory 系统在检索、组合和演化层面具备怎样的能力边界。这个边界一旦确定,存储形态往往只是结果,而不是起点。

二、记忆检索模块(Retrieval)

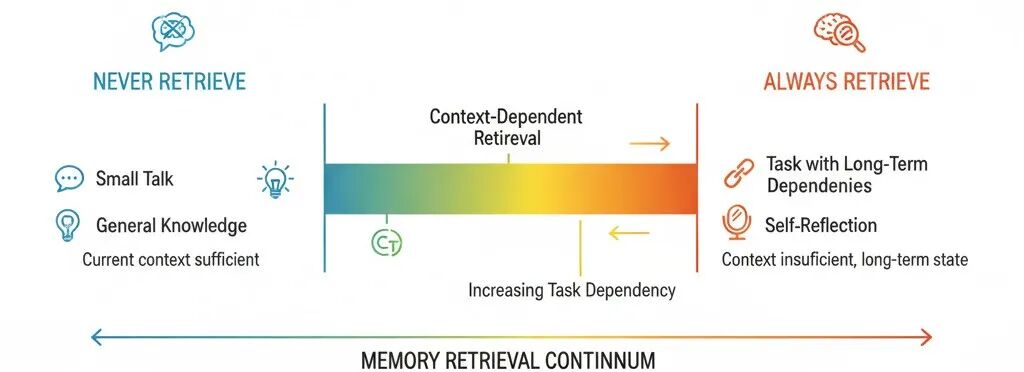

如果把检索画成一条轴,一端是永不检索,另一端是每次都检索。

首先需要明确的是并不是所有对话都需要 Memory 参与。

当用户寒暄、提问广域知识,或当前上下文已经充分时,检索反而可能干扰生成。真正需要检索的,是那些上下文不足、任务存在长期依赖,或 Agent 需要进行自我反思的场景。

检索的工程约束

记忆的检索策略,从来都不是一个独立存在的模块,而是被存储结构强约束的结果。你选择了怎样的记忆组织方式,几乎就预先决定了你能用哪些检索手段,以及这些手段的上限在哪里。

在真实系统中,记忆检索几乎从来不是一次性的动作,而更像是一条不断收缩、不断校准的路径。系统可能先对用户输入进行 query 重写,把模糊、口语化甚至带有上下文依赖的表达,转换为更稳定、更适合检索的语义形式;随后通过语义召回或关键词匹配,在大规模记忆空间中完成一次初步筛选;接着再结合规则约束或领域信息,剔除明显不相关的候选内容;最后对剩余结果进行加权打分,并通过一到多轮 rerank,逐步压缩可进入上下文的记忆规模。

在对准确性要求更高的场景中,这条链路还可能引入 LLM 参与重排,让模型在更高语义层级上判断哪些记忆在“此刻、此任务”下真正有用。而当检索结果仍然无法支撑当前问题时,复杂系统会基于新的上下文或中间判断,重新触发一次检索过程,对 query、候选空间或排序策略进行调整。

需要强调的是,这些过滤、召回与重排机制并不存在严格的先后顺序。它们更像是一组可组合、可回环的能力模块,会根据场景、成本和实时反馈被动态拼装。真正成熟的记忆检索系统,并不是执行一条固定流程,而是在不断试探中,逐步逼近“此刻最有价值的那几条记忆”。

但无论这条链路设计得多么复杂,都绕不开一个现实问题:检索不是免费午餐。

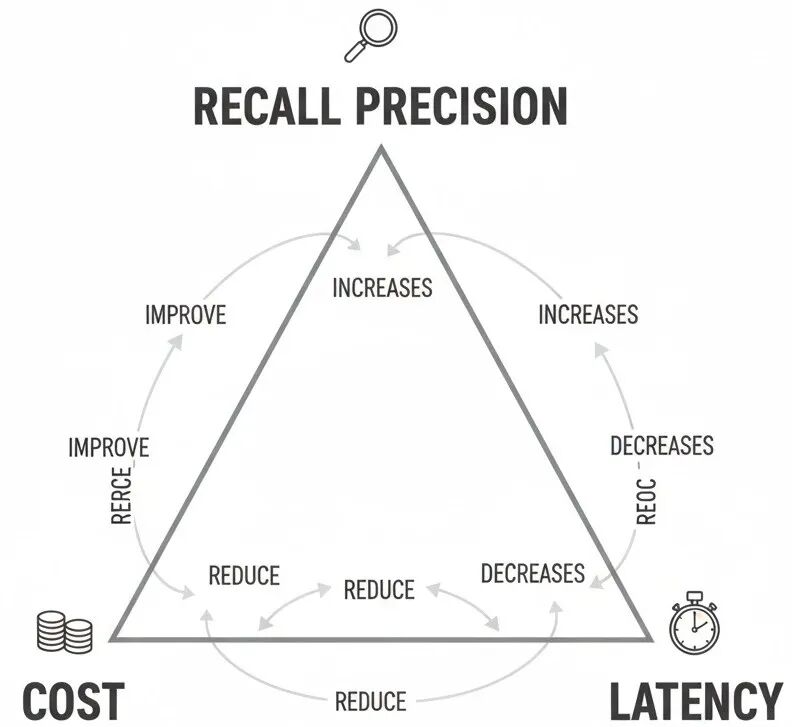

每增加一步召回或重排,都会引入额外的计算成本和时延;每降低一次过滤阈值,都会换来更高的噪声比例;而每一次试图提升召回精度,往往都意味着更慢的响应速度或更高的推理成本。这三者之间存在一个几乎无法打破的约束关系——价格、召回精度和时延构成了记忆检索中的不可能三角。

工程上的选择,从来不是“哪种方法更先进”,而是“在当前业务约束下,哪两个维度更重要”。有些系统宁愿牺牲部分精度,也要保证低延迟和可控成本;有些系统则接受更高价格和更慢响应,换取在关键任务中的确定性。记忆检索的设计,本质上是一场持续的 Tradeoff,而不是一次性做对的决策。

工程现实:Memory 不存在“即插即用”

理论讲完,落到业务中往往会非常混乱。没有人会因为要做 Memory,就随手接一个方案上线试运行。

那么我们该如何选择最佳的记忆实现策略呢?

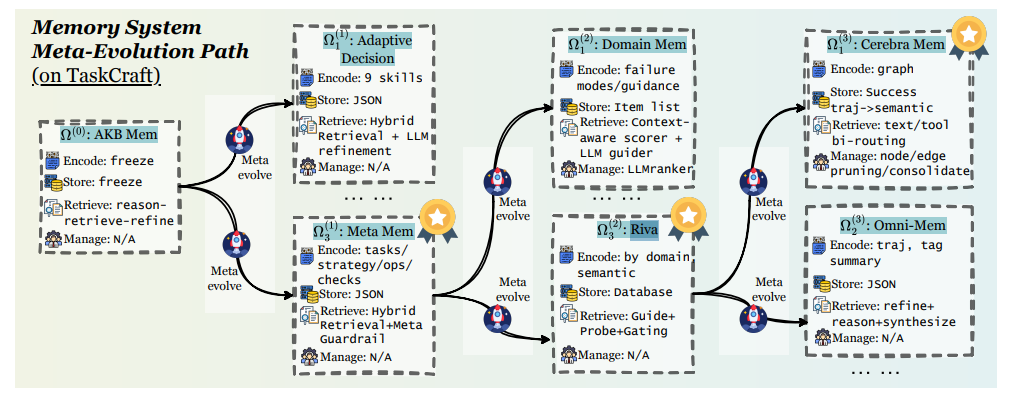

OPPO 最新发的论文 Memevolve 是一个非常值得关注的尝试。他们将 Memory 系统视为一个可优化对象,构建 AgentKB,定义 Ω 记忆策略空间,让 Memory Agent 在其中持续搜索和演化,并通过多套评测集验证策略效果。

尽管策略空间仍然是预定义集合,但方向非常清晰,强烈推荐关注。这相当于创建了一块试验田,让每个做 Memory 的人都可以在这里测试迭代其工程策略。

结语

Memory 从来不是一个附加能力,也不是为了“看起来更聪明”而堆出来的功能模块。 它本质上是一套长期状态与经验的管理系统,决定了一个 Agent 是否具备跨时间尺度积累与自我修正的能力。

没有 Memory 的 Agent,每一次交互都在重新开始;

而拥有 Memory 的 Agent,才有可能在不断修正中形成稳定的认知与行为模式。

从工程角度看,Memory 决定的从来不是某一次回答的质量,而是系统在长期运行中的一致性、可演化性以及能力上限。Memory 系统的设计,本质上是一组边界选择的组合问题——在成本、精度、延迟、抽象粒度与复杂度之间不断权衡,最终找到最适合自己业务的那一套方案。

做好这件事很难,很复杂,所以才足够迷人。

最后唠两句

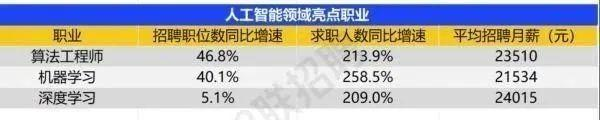

为什么AI大模型成为越来越多程序员转行就业、升职加薪的首选

很简单,这些岗位缺人且高薪

智联招聘的最新数据给出了最直观的印证:2025年2月,AI领域求职人数同比增幅突破200% ,远超其他行业平均水平;整个人工智能行业的求职增速达到33.4%,位居各行业榜首,其中人工智能工程师岗位的求职热度更是飙升69.6%。

AI产业的快速扩张,也让人才供需矛盾愈发突出。麦肯锡报告明确预测,到2030年中国AI专业人才需求将达600万人,人才缺口可能高达400万人,这一缺口不仅存在于核心技术领域,更蔓延至产业应用的各个环节。

那0基础普通人如何学习大模型 ?

深耕科技一线十二载,亲历技术浪潮变迁。我见证那些率先拥抱AI的同行,如何建立起效率与薪资的代际优势。如今,我将积累的大模型面试真题、独家资料、技术报告与实战路线系统整理,分享于此,为你扫清学习困惑,共赴AI时代新程。

我整理出这套 AI 大模型突围资料包【允许白嫖】:

-

✅从入门到精通的全套视频教程

-

✅AI大模型学习路线图(0基础到项目实战仅需90天)

-

✅大模型书籍与技术文档PDF

-

✅各大厂大模型面试题目详解

-

✅640套AI大模型报告合集

-

✅大模型入门实战训练

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

①从入门到精通的全套视频教程

包含提示词工程、RAG、Agent等技术点

② AI大模型学习路线图(0基础到项目实战仅需90天)

全过程AI大模型学习路线

③学习电子书籍和技术文档

市面上的大模型书籍确实太多了,这些是我精选出来的

④各大厂大模型面试题目详解

⑤640套AI大模型报告合集

⑥大模型入门实战训练

如果说你是以下人群中的其中一类,都可以来智泊AI学习人工智能,找到高薪工作,一次小小的“投资”换来的是终身受益!

应届毕业生:无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型:非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能 突破瓶颈:传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

👉获取方式:

有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献541条内容

已为社区贡献541条内容

所有评论(0)