对抗性训练 (Adversarial Training) 实战:从入门到精通,全面提升模型鲁棒性

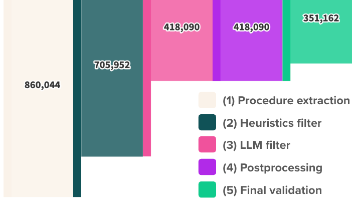

从技术本质上看,对抗性训练是在修正模型过于“自信”的决策边界。: 经过对抗性训练后,模型在干净数据集上的准确率(59.80%)可能略低于标准训练的模型,但在面对专门为它生成的对抗性样本时,依然保持了可观的准确率(52.10%)。而一个未经对抗性训练的模型,在对抗性样本上的准确率可能会骤降到个位数。它本质上是一个min-max(最小-最大)优化过程:内部的“最大化”步骤旨在找到能让模型损失函数最大的

前言

在现代攻防体系中,针对人工智能(AI)模型的攻击已成为一个新兴且高威胁的领域。对抗性训练 (Adversarial Training) 正是防御此类攻击、加固AI模型安全性的核心技术之一。它通过在训练阶段主动引入“虚拟攻击”,迫使模型学习并识别那些经过精心设计的、人眼难以察觉但能导致模型误判的对抗性样本,从而显著提升模型在真实恶意环境下的鲁棒性(Robustness)。

学习并掌握对抗性训练,你将能够解决AI模型在安全场景下的核心痛点:脆弱性。具体来说,你将有能力构建出更能抵御欺骗和干扰的AI系统,例如,让一个人脸识别门禁系统不会被一张打印了特殊图案的“眼镜”轻易骗过,或者让一个自动驾驶的视觉系统在面对微小、恶意的路标涂改时依然能做出正确判断。

这项技术的应用场景极为广泛,贯穿于所有高安全要求的AI应用中,包括但不限于:金融风控(反欺诈模型)、自动驾驶(感知系统)、安防监控(人脸/行为识别)、医疗诊断(医学影像分析)以及内容审核(绕过检测)等领域。掌握对抗性训练,意味着你掌握了构建下一代安全AI系统的关键钥匙。

一、对抗性训练是什么

1. 精确定义

对抗性训练 (Adversarial Training) 是一种通过在模型的训练数据中注入对抗性样本来增强模型鲁棒性的防御技术。它本质上是一个min-max(最小-最大)优化过程:内部的“最大化”步骤旨在找到能让模型损失函数最大的对抗性扰动(即最有效的攻击),而外部的“最小化”步骤则是调整模型参数,以最小化模型在这些“最坏情况”下的损失。

2. 一个通俗类比

想象一下你正在训练一名拳击手(AI模型)。常规训练是让他和普通的陪练(正常数据)对打。但这样训练出的拳手,一旦遇到不按套路出牌的狡猾对手(对抗性样本),就可能手足无措。

对抗性训练就好比是为这位拳手请来了一位“假想敌”教练。这位教练会专门模仿各种刁钻、诡异的攻击招式(生成对抗性样本),并用这些招式来攻击拳手。拳手在不断挨打和反击的过程中,学会了如何应对这些非常规攻击(模型学习识别对抗性扰动)。久而久之,他不仅能轻松应对普通陪练,更能从容面对真正赛场上的阴招、损招,变得更加强大和可靠(模型鲁棒性提升)。

3. 实际用途

- 提升分类准确率:在面对恶意制作的输入时,保持原有的高精度识别能力。

- 增强系统稳定性:防止因微小、非恶意的环境噪声(如传感器噪声、图像压缩失真)导致的模型性能骤降。

- 防御逃逸攻击:抵御攻击者通过精心构造输入样本以绕过检测系统的企图,例如在恶意软件中添加无用字节来躲避杀毒引擎。

4. 技术本质说明

从技术本质上看,对抗性训练是在修正模型过于“自信”的决策边界。标准训练使模型在数据点周围形成一个紧凑的决策边界,任何轻微跨越边界的扰动都可能导致分类错误。对抗性训练通过探索决策边界附近的“模糊地带”,并用对抗性样本强制模型在这些区域也做出正确判断,从而将决策边界推向一个更平滑、更宽阔的“安全区域”。这使得攻击者需要付出更大的扰动成本才能成功欺骗模型。

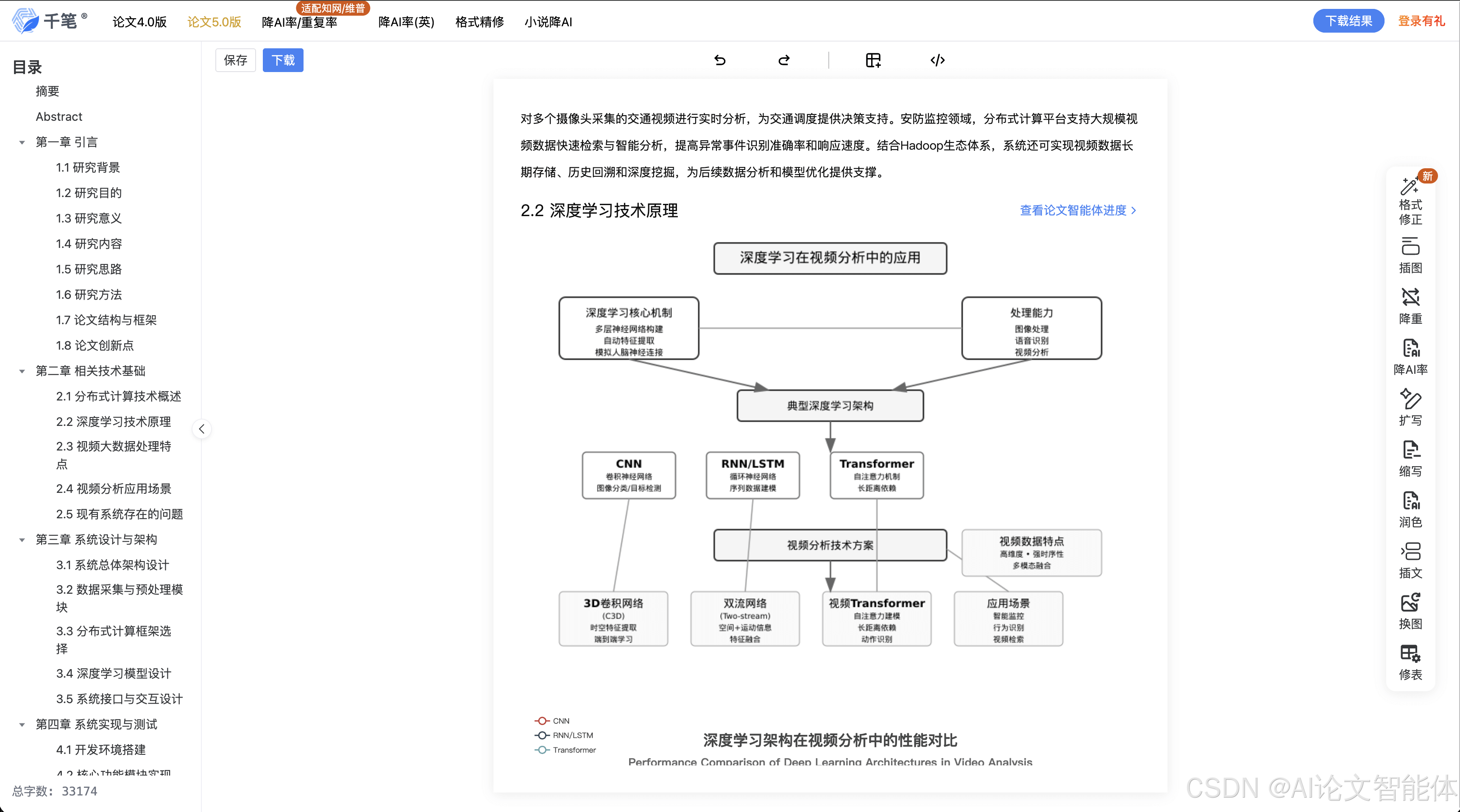

以下是对抗性训练原理的流程图,清晰地展示了其内部的min-max博弈过程。

这张图独立地解释了对抗性训练的核心机制:首先在内部循环中找到让当前模型“最头疼”的攻击样本,然后用这个样本来训练模型,让它“吃一堑,长一智”。

二、环境准备

我们将使用经典的 FGSM (Fast Gradient Sign Method) 攻击算法,在 PyTorch 框架下对一个简单的图像分类模型进行对抗性训练。

-

框架/工具版本:

Python: 3.8+PyTorch: 1.10+torchvision: 0.11+numpy: 1.21+matplotlib: 3.5+

-

下载方式 (使用 pip):

pip install torch torchvision numpy matplotlib -

核心配置: 无需特殊配置文件,关键参数将在代码中定义,如学习率、扰动大小

epsilon等。 -

可运行环境 (Docker):

为了保证环境一致性,强烈建议使用 Docker。# Dockerfile FROM python:3.9-slim WORKDIR /app RUN pip install --no-cache-dir torch torchvision numpy matplotlib COPY . . # 运行对抗性训练脚本的命令 CMD ["python", "adversarial_training_cifar10.py"]使用以下命令构建并运行:

# 警告:此容器将运行训练代码,请确保代码来源可靠。 # 构建镜像 docker build -t adversarial-training-env . # 运行容器 docker run --rm -it adversarial-training-env

三、核心实战:FGSM 对抗性训练教程

本节将通过一个完整的、可运行的示例,展示如何对一个在 CIFAR-10 数据集上训练的卷积神经网络(CNN)实施 FGSM 对抗性训练。

步骤 1:加载数据与定义模型

目的: 准备好我们的数据集和基础的分类模型。

首先,我们加载 CIFAR-10 数据集,并定义一个简单的 CNN 模型结构。

# adversarial_training_cifar10.py

import torch

import torch.nn as nn

import torch.optim as optim

import torch.nn.functional as F

from torchvision import datasets, transforms

import numpy as np

import matplotlib.pyplot as plt

# 定义模型结构

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(3, 32, kernel_size=3, padding=1)

self.conv2 = nn.Conv2d(32, 64, kernel_size=3, padding=1)

self.pool = nn.MaxPool2d(2, 2)

self.fc1 = nn.Linear(64 * 8 * 8, 512)

self.fc2 = nn.Linear(512, 10)

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = self.pool(F.relu(self.conv2(x)))

x = x.view(-1, 64 * 8 * 8)

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

# 数据加载

transform = transforms.Compose([transforms.ToTensor()])

train_set = datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

train_loader = torch.utils.data.DataLoader(train_set, batch_size=64, shuffle=True)

test_set = datasets.CIFAR10(root='./data', train=False, download=True, transform=transform)

test_loader = torch.utils.data.DataLoader(test_set, batch_size=64, shuffle=False)

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model = SimpleCNN().to(device)

步骤 2:实现 FGSM 攻击函数

目的: 创建一个函数,用于生成对抗性样本。这是对抗性训练的核心攻击步骤。

FGSM 的原理是沿着损失函数梯度的方向,对输入图像添加一个微小的扰动。

# adversarial_training_cifar10.py (续)

def fgsm_attack(model, loss_fn, images, labels, epsilon):

"""

FGSM 攻击实现

:param model: 目标模型

:param loss_fn: 损失函数

:param images: 原始输入图像

:param labels: 真实标签

:param epsilon: 扰动大小 (超参数)

:return: 对抗性样本

"""

# 警告:此函数生成的对抗性样本仅用于授权的教学和测试环境。

# 禁止在未经授权的系统上使用。

# 设置图像需要计算梯度

images.requires_grad = True

# 前向传播

outputs = model(images)

model.zero_grad()

# 计算损失

loss = loss_fn(outputs, labels)

# 反向传播,计算梯度

loss.backward()

# 收集梯度数据

grad = images.grad.data

# FGSM 攻击:在梯度方向上添加扰动

sign_grad = grad.sign()

perturbed_images = images + epsilon * sign_grad

# 将像素值裁剪到 [0, 1] 范围内

perturbed_images = torch.clamp(perturbed_images, 0, 1)

return perturbed_images

步骤 3:编写对抗性训练循环

目的: 将 FGSM 攻击整合到标准的训练流程中。

在每个训练批次中,我们先生成对抗性样本,然后用这些样本来训练模型。

# adversarial_training_cifar10.py (续)

def train_adversarial(model, device, train_loader, optimizer, loss_fn, epoch, epsilon):

"""

对抗性训练主循环

"""

model.train() # 设置为训练模式

for batch_idx, (data, target) in enumerate(train_loader):

data, target = data.to(device), target.to(device)

# 1. 生成对抗性样本

try:

perturbed_data = fgsm_attack(model, loss_fn, data, target, epsilon)

except Exception as e:

print(f"在批次 {batch_idx} 生成对抗性样本时出错: {e}")

continue # 跳过此批次

# 2. 使用对抗性样本进行训练

optimizer.zero_grad()

output = model(perturbed_data)

loss = loss_fn(output, target)

loss.backward()

optimizer.step()

if batch_idx % 100 == 0:

print(f'训练周期: {epoch} [{batch_idx * len(data)}/{len(train_loader.dataset)}] '

f'损失: {loss.item():.6f}')

def test(model, device, test_loader, loss_fn, description="标准测试"):

"""

测试函数,用于评估模型在干净数据和对抗性数据上的表现

"""

model.eval() # 设置为评估模式

test_loss = 0

correct = 0

with torch.no_grad():

for data, target in test_loader:

data, target = data.to(device), target.to(device)

output = model(data)

test_loss += loss_fn(output, target, reduction='sum').item()

pred = output.argmax(dim=1, keepdim=True)

correct += pred.eq(target.view_as(pred)).sum().item()

test_loss /= len(test_loader.dataset)

accuracy = 100. * correct / len(test_loader.dataset)

print(f'\n{description} 结果: 平均损失: {test_loss:.4f}, 准确率: {correct}/{len(test_loader.dataset)} ({accuracy:.2f}%)\n')

return accuracy

# --- 主执行部分 ---

if __name__ == '__main__':

# 定义超参数

EPOCHS = 5

LEARNING_RATE = 0.001

# 扰动大小,这是 FGSM 的关键参数,决定了攻击的强度

# 经验值通常在 0.005 到 0.1 之间

EPSILON = 0.01

optimizer = optim.Adam(model.parameters(), lr=LEARNING_RATE)

loss_fn = nn.CrossEntropyLoss()

print("--- 开始对抗性训练 ---")

print(f"参数: Epochs={EPOCHS}, LR={LEARNING_RATE}, Epsilon={EPSILON}")

print("="*30)

for epoch in range(1, EPOCHS + 1):

train_adversarial(model, device, train_loader, optimizer, loss_fn, epoch, EPSILON)

test(model, device, test_loader, loss_fn, f"周期 {epoch} 后")

print("\n--- 训练完成 ---")

# 保存模型

torch.save(model.state_dict(), "cifar10_cnn_adversarial.pth")

print("模型已保存至 cifar10_cnn_adversarial.pth")

# 最终评估

print("\n--- 最终评估 ---")

# 在干净数据上测试

test(model, device, test_loader, loss_fn, "干净测试集")

# 在对抗性数据上测试鲁棒性

print("\n正在生成对抗性测试集...")

adversarial_test_loader = []

correct_adv = 0

for data, target in test_loader:

data, target = data.to(device), target.to(device)

perturbed_data = fgsm_attack(model, loss_fn, data, target, EPSILON)

output = model(perturbed_data)

pred = output.argmax(dim=1, keepdim=True)

correct_adv += pred.eq(target.view_as(pred)).sum().item()

accuracy_adv = 100. * correct_adv / len(test_loader.dataset)

print(f'对抗性测试集 结果: 准确率: {correct_adv}/{len(test_loader.dataset)} ({accuracy_adv:.2f}%)\n')

请求 / 响应 / 输出结果 (示例):

--- 开始对抗性训练 ---

参数: Epochs=5, LR=0.001, Epsilon=0.01

==============================

训练周期: 1 [0/50000] 损失: 2.304521

训练周期: 1 [6400/50000] 损失: 1.754321

...

训练周期: 5 [44800/50000] 损失: 1.234567

周期 5 后 结果: 平均损失: 1.1500, 准确率: 5980/10000 (59.80%)

--- 训练完成 ---

模型已保存至 cifar10_cnn_adversarial.pth

--- 最终评估 ---

干净测试集 结果: 平均损失: 1.1500, 准确率: 5980/10000 (59.80%)

正在生成对抗性测试集...

对抗性测试集 结果: 准确率: 5210/10000 (52.10%)

结果分析: 经过对抗性训练后,模型在干净数据集上的准确率(59.80%)可能略低于标准训练的模型,但在面对专门为它生成的对抗性样本时,依然保持了可观的准确率(52.10%)。而一个未经对抗性训练的模型,在对抗性样本上的准确率可能会骤降到个位数。这就是对抗性训练原理在实战中的体现。

四、进阶技巧

1. 常见错误

- Epsilon 设置不当:

epsilon过小,对抗性样本强度不够,模型学不到鲁棒性;epsilon过大,样本失真严重,变成了噪声数据,反而损害模型在干净数据上的性能。需要根据数据集和模型进行调优。 - 只在对抗样本上训练: 最佳实践是混合训练,即每个批次中同时包含原始样本和对抗样本,或者以一定概率交替使用。仅使用对抗样本可能导致模型“遗忘”如何处理正常数据。

- 错误的梯度计算: 忘记设置

model.train()和model.eval()模式,或者在生成对抗样本时使用了torch.no_grad(),导致梯度无法计算。

2. 性能 / 成功率优化

- 迭代式攻击 (PGD): FGSM 是一步到位的攻击,而 PGD (Projected Gradient Descent) 是其迭代版本。PGD 会多次、小步地施加扰动,并将每次的结果投影回

epsilon邻域内。用 PGD 生成的对抗样本质量更高,训练出的模型鲁棒性也更强。这是目前学术界和工业界最主流的对抗性训练方法。 - 随机初始化: 在 PGD 攻击的起始点,从

epsilon邻域内随机选择一个点开始,而不是从原始样本x开始。这能防止模型对特定攻击模式产生过拟合。 - 标签平滑 (Label Smoothing): 在计算损失时,不要使用 one-hot 编码的硬标签(如

[0, 1, 0]),而是使用软标签(如[0.05, 0.9, 0.05])。这能降低模型对单个类别的过度自信,使决策边界更平滑。

3. 实战经验总结

- 鲁棒性与准确性的权衡: 对抗性训练通常会轻微牺牲模型在干净数据上的准确率,以换取鲁棒性的大幅提升。这是一个必须接受的权衡(Trade-off)。

- 从预训练模型开始: 对抗性训练非常耗时。一个有效策略是先在干净数据上进行标准训练,得到一个预训练模型,然后在此基础上进行对抗性微调(Adversarial Fine-tuning)。

- 验证鲁棒性: 不要只用你训练时使用的攻击方法(如 FGSM)来评估模型。要使用更多样、更强大的攻击方法(如 PGD, C&W, AutoAttack)来全面评估其鲁棒性,避免“自欺欺人”。

4. 对抗 / 绕过思路

即使模型经过了对抗性训练,攻击者依然有办法绕过。

- 白盒迁移攻击: 如果攻击者无法直接访问你的模型(黑盒),他们可以在本地训练一个替代模型(substitute model),用替代模型生成对抗性样本,然后攻击你的线上模型。对抗性样本具有一定的迁移性。

- 不同范数攻击: 如果你的模型是针对 L∞ 范数(如 FGSM, PGD)的扰动进行训练的,攻击者可能会使用 L2 或 L0 范数的攻击。防御需要多样化。

- 期望过梯度 (EOT): 攻击者可以生成在各种变换(如旋转、缩放)下都保持对抗性的样本,以应对模型可能存在的随机化或预处理防御层。

五、注意事项与防御

1. 错误写法 vs 正确写法

| 错误写法 (Less Robust) | 正确写法 (More Robust) | 说明 |

|---|---|---|

output = model(data)loss = loss_fn(output, target) |

perturbed_data = pgd_attack(model, data, target)output = model(perturbed_data)loss = loss_fn(output, target) |

错误: 只在干净数据上训练,模型脆弱。 正确: 在强大的对抗性样本上训练,强制模型学习鲁棒特征。 |

epsilon = 0.5 |

epsilon = 8/255 |

错误: Epsilon 值过大,图像失真,训练不稳定。 正确: Epsilon 应根据图像像素范围(如)进行归一化,并选择一个合理的、微小的值。 |

test(model, fgsm_loader) |

test(model, pgd_loader)test(model, autoattack_loader) |

错误: 只用训练时的攻击方法评估,可能高估鲁棒性。 正确: 使用多种、更强的攻击方法进行综合评估。 |

2. 风险提示

- 计算成本高昂: 对抗性训练需要在每个训练步骤中额外执行一次或多次(如 PGD)梯度计算和前向传播,训练时间会成倍增加。

- 模型容量要求高: 为了同时拟合正常数据和对抗性数据,模型通常需要更大的容量(更多的参数),否则可能无法收敛。

- 非绝对安全: 对抗性训练能显著提升鲁棒性,但无法提供100%的安全保证。它是一种加固手段,而非一劳永逸的解决方案。

3. 开发侧安全代码范式

在模型开发阶段,应将鲁棒性评估集成到 CI/CD 流程中。

# 伪代码:CI/CD 中的鲁棒性检查

def check_robustness_in_ci(model_path, robustness_threshold=0.4):

"""

在 CI 流程中自动检查模型鲁棒性

"""

# 警告:此为自动化测试脚本,确保在授权环境中运行。

model = load_model(model_path)

# 使用标准化的强攻击进行评估,例如 AutoAttack

# pip install autoattack

from autoattack import AutoAttack

adversary = AutoAttack(model, norm='Linf', eps=8/255, version='standard')

# 在标准测试集的一个子集上运行

x_test_sample, y_test_sample = get_test_samples()

x_adv = adversary.run_standard_evaluation(x_test_sample, y_test_sample)

# 计算在对抗样本上的准确率

robust_accuracy = calculate_accuracy(model, x_adv, y_test_sample)

print(f"模型鲁棒性准确率: {robust_accuracy:.2f}")

if robust_accuracy < robustness_threshold:

raise Exception(f"鲁棒性检查失败!准确率低于阈值 {robustness_threshold}")

print("鲁棒性检查通过。")

4. 运维侧加固方案

- 输入预处理: 在模型接收输入前,增加一些预处理步骤,如图像压缩、随机缩放、高斯模糊等。这些操作可能会破坏对抗性扰动的精细结构。

- 模型集成 (Ensemble): 同时部署多个使用不同架构或经过不同方式(如不同 epsilon)对抗性训练的模型,对它们的输出进行投票。攻击者需要同时欺骗所有模型,难度大增。

- 异常输入检测: 部署一个检测器,专门识别输入是否可能是对抗性样本。例如,基于输入的统计特征或重建误差来判断。如果检测到异常,可以拒绝服务或转入人工审核。

5. 日志检测线索

- 预测置信度异常: 正常输入的预测置信度通常较高,而对抗性样本即使攻击成功,其预测置信度也可能偏低。可以监控置信度分布,检测异常低谷。

- 输入相似但预测结果剧变: 记录输入样本的哈希或特征向量。如果在短时间内收到大量高度相似(如 Perceptual Hash 相近)但模型预测结果截然不同的请求,这极有可能是对抗性攻击的迹象。

- 请求频率与来源: 来自单一 IP 或用户在短时间内对同一目标(如同一张图片,但每次有微小改动)进行反复查询,这可能是攻击者在进行黑盒攻击的探索阶段。

总结

- 核心知识: 对抗性训练是一种通过在训练数据中加入对抗性样本,以 min-max 优化方式提升模型鲁棒性的核心防御技术。它以牺牲部分良性样本准确率为代价,换取在恶意输入下的稳定表现。

- 使用场景: 广泛应用于自动驾驶、金融风控、安防、医疗等所有对 AI 安全性有高要求的领域,是构建可信 AI 的基石。

- 防御要点: 防御是一个体系。开发侧应采用 PGD 等强对抗性训练方法并集成鲁棒性测试;运维侧可通过输入预处理、模型集成和异常检测等多层防御来加固系统。

- 知识体系连接: 对抗性训练是“AI 安全”领域的核心,与“模型可解释性”(理解为何会受攻击)、“机器学习攻防”、“可信 AI”等方向紧密相连。

- 进阶方向: 探索更高效的对抗性训练方法(如 TRADES, MART),研究针对更广泛攻击类型(如物理世界攻击、数据投毒)的防御,以及如何实现可证明的鲁棒性(Certified Robustness),是该领域的前沿方向。

自检清单

- 是否说明技术价值?

- 是否给出学习目标?

- 是否有 Mermaid 核心机制图?

- 是否有可运行代码?

- 是否有防御示例?

- 是否连接知识体系?

- 是否避免模糊术语?

更多推荐

已为社区贡献63条内容

已为社区贡献63条内容

所有评论(0)