AI原生应用领域实体识别的常见问题及解决办法

本文聚焦“AI原生应用”这一特殊场景(即从设计之初就深度依赖AI技术的应用),探讨其核心组件——实体识别(Named Entity Recognition, NER)的常见问题与解决方案。覆盖技术原理、代码实战、场景应用,适合希望优化AI应用智能交互能力的开发者阅读。本文从“问题-解决”双主线展开:先通过生活案例引出实体识别的核心作用,再拆解5大常见问题(数据、边界、跨域、嵌套、实时性),逐一分析

AI原生应用领域实体识别的常见问题及解决办法

关键词:实体识别(NER)、AI原生应用、低资源场景、嵌套实体、模型优化

摘要:在AI原生应用(如智能客服、医疗诊断、金融风控)中,实体识别是“信息提取的眼睛”,直接影响应用的智能程度。本文从实际需求出发,结合生活案例与技术原理,拆解实体识别在AI原生应用中最常遇到的5大问题(数据不足、边界模糊、跨域失效、嵌套复杂、实时性差),并给出可落地的解决方法。通过代码示例与场景分析,帮助开发者快速掌握核心技术要点。

背景介绍

目的和范围

本文聚焦“AI原生应用”这一特殊场景(即从设计之初就深度依赖AI技术的应用),探讨其核心组件——实体识别(Named Entity Recognition, NER)的常见问题与解决方案。覆盖技术原理、代码实战、场景应用,适合希望优化AI应用智能交互能力的开发者阅读。

预期读者

- AI应用开发者(如智能客服、医疗系统工程师)

- 自然语言处理(NLP)入门学习者

- 对AI原生应用技术细节感兴趣的产品经理

文档结构概述

本文从“问题-解决”双主线展开:先通过生活案例引出实体识别的核心作用,再拆解5大常见问题(数据、边界、跨域、嵌套、实时性),逐一分析原因并给出技术方案;最后通过代码实战与场景应用,帮助读者将理论落地。

术语表

核心术语定义

- 实体识别(NER):从文本中识别并分类特定类型实体(如人名、机构名、时间)的技术,例:从“张三今天在腾讯开会”中提取“张三(人名)”“腾讯(机构名)”。

- AI原生应用:设计之初即深度集成AI技术的应用(如ChatGPT、智能问诊APP),区别于传统应用后期“打补丁”式接入AI。

- 嵌套实体:一个实体内部包含另一个实体,例:“北京清华大学计算机系”中“清华大学”是“北京”的子实体,“计算机系”是“清华大学”的子实体。

相关概念解释

- 标注数据:人工标记了实体位置与类别的文本数据(如“[张三]PER(人名)今天在[腾讯]ORG(机构名)开会”),是训练实体识别模型的“教材”。

- 预训练模型:通过海量无标注数据预先训练的通用模型(如BERT),可快速适配具体任务(如NER),解决“教材不够”的问题。

核心概念与联系

故事引入:小明的智能助手“小艾”

小明是一名刚入职的医疗公司产品经理,他的手机里有个AI原生应用“小艾助手”,能帮他整理会议纪要、提取患者病历中的关键信息(如“糖尿病”“高血压”等疾病实体)。但最近他发现:

- 当会议提到“诺华制药(瑞士药企)”时,小艾总识别成“诺华”(人名);

- 患者病历写“2023年12月8日上午9点”,小艾只提取了“2023年12月8日”,漏掉了“上午9点”;

- 新业务线讨论“AI辅助手术机器人”时,小艾完全识别不出“手术机器人”这个实体。

这些问题让小明很头疼——这正是实体识别在AI原生应用中常见的“边界模糊”“低资源场景失效”“跨领域泛化差”等问题。

核心概念解释(像给小学生讲故事)

概念一:实体识别(NER)——文本中的“挑拣游戏”

想象你有一盒混着巧克力、水果糖、奶糖的糖果盒,任务是把它们分类装到不同的小盒子里。实体识别就像这个“挑拣游戏”:从一段文字(“糖果盒”)中找出人名、地名、机构名等“糖果”,并分类到对应的“小盒子”(实体类别)里。

例:文本“张医生昨天在协和医院用AI辅助系统诊断了3位患者”,NER会挑出“张医生(人名)”“协和医院(机构名)”“AI辅助系统(技术名)”。

概念二:AI原生应用——“天生会用AI的智能工具”

传统应用像“老房子”,先盖好房子(功能框架),后期再装空调(AI功能);AI原生应用像“智能新房”,设计图纸里就包含了空调、智能灯光等AI模块(如ChatGPT的对话逻辑、医疗APP的病历分析)。实体识别是这类应用的“信息过滤器”,直接决定了“智能”的底线。

概念三:低资源场景——“没有足够教材的考试”

学校考试前,老师会发很多练习题(标注数据)让学生(模型)练习。但在AI原生应用中,某些垂直领域(如“罕见病病历”“小众行业报告”)可能只有少量练习题甚至没有,这就是“低资源场景”。此时模型就像没怎么复习的学生,考试(识别实体)容易出错。

核心概念之间的关系(用小学生能理解的比喻)

- NER与AI原生应用:就像“钥匙”和“智能锁”——AI原生应用需要NER这把“钥匙”来打开文本信息的“锁”,才能实现智能交互(如理解用户问题、提取关键数据)。

- 低资源场景与NER:就像“少米煮稀粥”——标注数据少(米少),直接训练的NER模型效果差(粥稀),需要用“借米”(迁移学习)或“省米”(数据增强)的方法解决。

- 嵌套实体与NER:就像“套娃玩具”——NER不仅要找到最外层的大套娃(主实体),还要找到里面的小套娃(子实体),需要更复杂的“拆解技巧”(分层模型)。

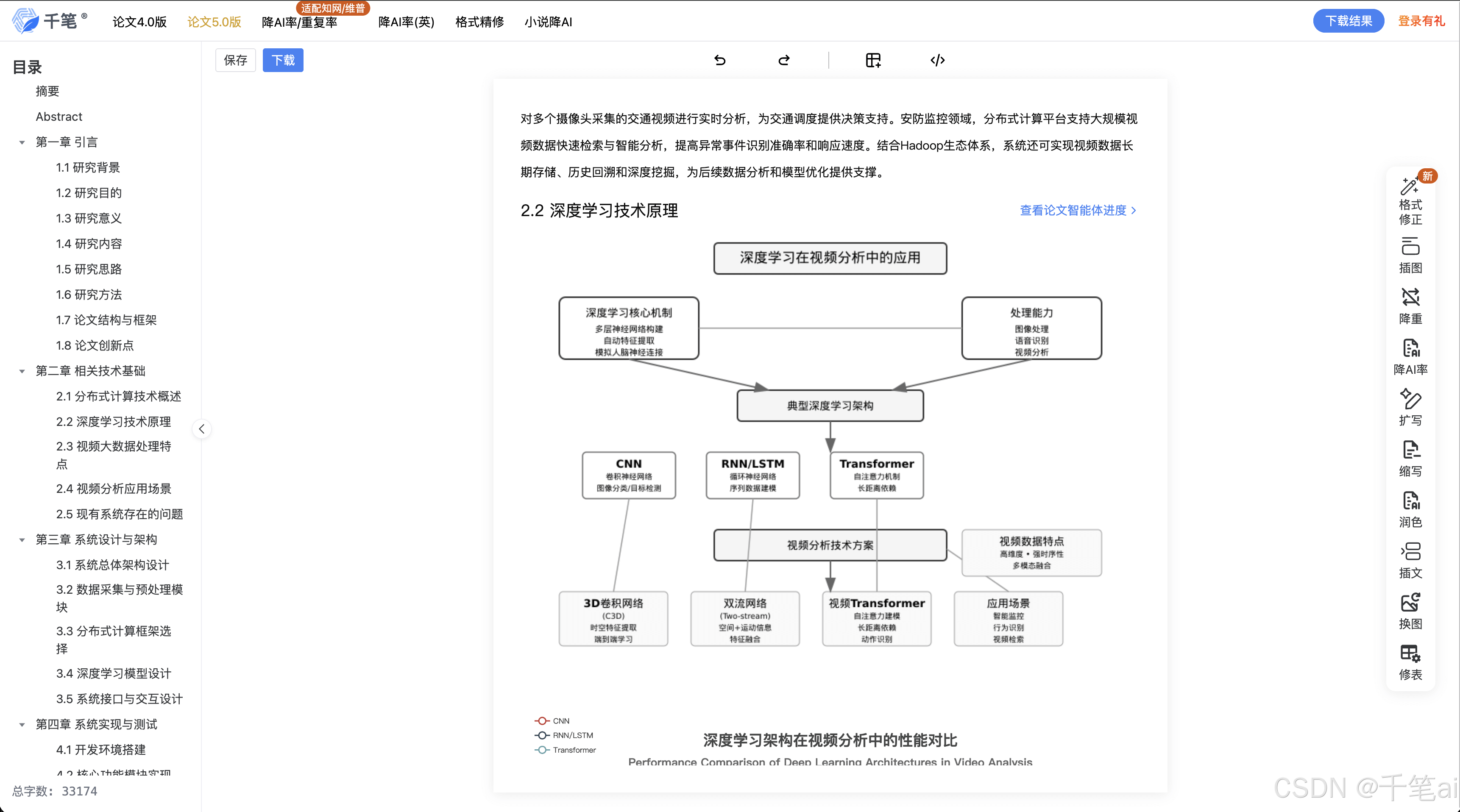

核心概念原理和架构的文本示意图

实体识别的核心流程可简化为:

输入文本 → 分词(拆成词语) → 特征提取(识别可能的实体边界) → 分类(确定实体类型) → 输出实体列表(含位置、类型)。

在AI原生应用中,这一流程需与应用的业务逻辑深度融合(如医疗APP需优先识别疾病名、药物名)。

Mermaid 流程图

核心问题与解决办法

问题1:低资源场景下标注数据不足

现象:小明的医疗APP想识别“阿尔茨海默病早期筛查”中的“阿尔茨海默病”,但该领域只有100条标注数据(常规需要10000+),模型总把“早期筛查”也识别成疾病名。

原因:标注数据是模型的“学习教材”,教材太少,模型无法总结规律(如“病”字通常是疾病名结尾)。

解决办法:

- 迁移学习(借别人的教材):先用通用领域的大模型(如BERT)“预习”,再用少量医疗数据“复习”。就像先学通用数学,再学医学统计学,更容易上手。

- 数据增强(自己编练习题):对现有数据做“变形”,如将“阿尔茨海默病”替换为“帕金森病”(同类型实体),生成新的训练数据。

- 低资源学习(用更少的教材学透):使用“小样本学习(Few-shot Learning)”,让模型从少量例子中快速归纳(如只看5个疾病名,就能识别新的疾病名)。

问题2:复杂实体边界模糊

现象:小艾助手把“苹果公司发布了新苹果手机”中的两个“苹果”都识别为“公司名”,但实际“苹果手机”是产品名。

原因:实体边界(即“从哪个字开始,到哪个字结束”)不明确,模型容易“划错范围”(比如把“苹果手机”的边界划成“苹果”)。

解决办法:

- 优化标注体系(明确游戏规则):使用BIOES标注法(B-开头,I-中间,O-非实体,E-结尾,S-单字实体),例:“苹果公司”标注为B-ORG(机构名开头)、I-ORG(机构名中间)、E-ORG(机构名结尾),而“苹果手机”标注为B-PROD(产品名开头)、I-PROD、E-PROD。

- 引入上下文特征(看前后提示):用双向LSTM(BiLSTM)或Transformer模型,让模型“左看右看”上下文(如“公司”二字提示前面是机构名,“手机”提示前面是产品名)。

- CRF(条件随机场)约束(加规则限制):CRF能学习实体标签的转移规律(如“B-ORG后面只能接I-ORG或E-ORG,不能接B-PER”),避免边界错误。

问题3:跨领域泛化能力差

现象:小艾在医疗领域能准确识别“糖尿病”,但在金融领域把“摩根大通(银行名)”识别成“人名”。

原因:不同领域的实体类型和表达差异大(医疗的“糖尿病”vs金融的“摩根大通”),模型在训练时只学了一个领域,换领域就“失忆”。

解决办法:

- 多任务学习(同时学多个领域):让模型同时学习医疗、金融、新闻等领域的NER任务,就像一个学生同时学语文、数学、英语,触类旁通。

- 领域自适应(从旧领域“转学”到新领域):用源领域(如医疗)的模型参数初始化目标领域(如金融),再用少量金融数据微调,减少“转学不适应”。

- 动态词表扩展(补充新领域词汇):在预训练模型的词表中添加新领域实体(如“摩根大通”“科创板”),让模型“认识”这些新词。

问题4:嵌套实体处理困难

现象:会议纪要“北京清华大学计算机系李教授”中,小艾只识别出“清华大学”和“李教授”,漏掉了“北京”(地名)和“计算机系”(机构子部门)。

原因:传统NER模型假设实体不重叠,但嵌套实体(如“北京→清华大学→计算机系”)是层层包含的,模型无法处理这种“套娃”结构。

解决办法:

- 分层识别(先找大套娃,再找小套娃):第一层识别最外层实体(如“北京”),第二层在剩余文本中识别子实体(如“清华大学”),第三层识别更内层实体(如“计算机系”)。

- 指针网络(直接定位首尾):用模型预测每个实体的“起始位置”和“结束位置”,支持任意重叠(例:“北京”起始1,结束2;“清华大学”起始3,结束6;“计算机系”起始7,结束10)。

- 级联模型(分步骤处理):先用基础模型识别主实体,再用子模型在主实体内部识别嵌套实体,类似“先抓大鱼,再抓小鱼”。

问题5:实时性要求高时性能不足

现象:小艾在处理用户实时输入(如“帮我查下明天北京到上海的高铁票”)时,响应延迟2秒,用户体验差。

原因:复杂模型(如BERT)计算量大,处理每个字符需要大量矩阵运算,无法满足实时性(通常要求延迟<500ms)。

解决办法:

- 模型压缩(简化模型结构):用“知识蒸馏”将大模型(如BERT)的知识“压缩”到小模型(如DistilBERT),参数量减少40%,速度提升3倍。

- 轻量化设计(用更快的模型):选择轻量级模型(如ALBERT、RoBERTa-tiny),或使用循环神经网络(LSTM)替代Transformer,减少计算量。

- 硬件加速(用更强大的“计算器”):在GPU/TPU上部署模型,或使用推理加速框架(如TensorRT)优化计算流程,提升处理速度。

核心算法原理 & 具体操作步骤(Python代码示例)

以解决“低资源场景数据不足”问题为例,演示如何用迁移学习+数据增强训练NER模型。

环境搭建

- 安装依赖:

pip install transformers datasets numpy pandas - 硬件要求:CPU或GPU(推荐GPU加速训练)

源代码实现与解读

# 步骤1:加载预训练模型和分词器(迁移学习的“预习教材”)

from transformers import BertTokenizer, BertForTokenClassification

import torch

# 使用中文BERT预训练模型

model_name = "bert-base-chinese"

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertForTokenClassification.from_pretrained(

model_name,

num_labels=len(label_list) # label_list是实体类别列表(如["PER", "ORG", "LOC"])

)

# 步骤2:数据增强(自己编练习题)

def data_augmentation(text, entities):

"""

替换实体中的部分词汇生成新数据

例:输入text="张三在腾讯工作",entities=[("张三", "PER", 0, 2), ("腾讯", "ORG", 4, 6)]

输出新text="李四在阿里工作",entities=[("李四", "PER", 0, 2), ("阿里", "ORG", 4, 6)]

"""

new_text = text

new_entities = []

# 替换人名(PER)

for ent in entities:

if ent[1] == "PER":

# 从预定义的人名列表中随机选一个替换

new_name = random.choice(["李四", "王五", "赵六"])

new_text = new_text.replace(ent[0], new_name)

new_entities.append((new_name, "PER", ent[2], ent[3]))

# 同理替换机构名(ORG)、地名(LOC)等

return new_text, new_entities

# 步骤3:加载并增强少量医疗数据(假设只有100条原始数据)

from datasets import load_dataset

# 加载原始医疗数据集(格式:文本+实体列表)

raw_ds = load_dataset("medical_ner_small") # 假设的自定义数据集

augmented_ds = []

for example in raw_ds["train"]:

text = example["text"]

entities = example["entities"]

# 每条数据生成3条增强数据

for _ in range(3):

new_text, new_ents = data_augmentation(text, entities)

augmented_ds.append({"text": new_text, "entities": new_ents})

# 步骤4:数据预处理(转换为模型输入格式)

def tokenize_and_align_labels(examples):

tokenized_inputs = tokenizer(

examples["text"],

truncation=True,

padding="max_length",

max_length=128

)

labels = []

for i, label in enumerate(examples["labels"]):

# 对齐token和标签(处理分词后的子词问题)

word_ids = tokenized_inputs.word_ids(batch_index=i)

previous_word_idx = None

label_ids = []

for word_idx in word_ids:

if word_idx is None:

label_ids.append(-100) # 填充位置不计算损失

elif word_idx != previous_word_idx:

label_ids.append(label[word_idx])

else:

label_ids.append(label[word_idx]) # 子词与主词标签相同

previous_word_idx = word_idx

labels.append(label_ids)

tokenized_inputs["labels"] = labels

return tokenized_inputs

# 步骤5:训练模型(用增强后的数据微调预训练模型)

from transformers import TrainingArguments, Trainer

training_args = TrainingArguments(

output_dir="./medical_ner_model",

evaluation_strategy="epoch",

learning_rate=2e-5,

per_device_train_batch_size=16,

per_device_eval_batch_size=16,

num_train_epochs=3, # 少量数据下,3轮训练足够

weight_decay=0.01,

)

trainer = Trainer(

model=model,

args=training_args,

train_dataset=augmented_ds, # 使用增强后的数据

tokenizer=tokenizer,

)

trainer.train()

代码解读与分析

- 迁移学习:通过加载预训练的BERT模型(已学习通用中文语义),减少对大量标注数据的依赖,就像学生先用通用教材打好基础,再学专业内容。

- 数据增强:通过替换实体生成新数据,扩大训练集规模(原始100条→增强后300条),解决“教材太少”的问题。

- 微调训练:用医疗领域的增强数据微调模型,让模型“适应”医疗实体(如疾病名、药物名)的识别规则。

实际应用场景

场景1:医疗智能问诊

AI原生应用(如“平安好医生”)需要从患者描述中提取“症状(如‘咳嗽’)”“疾病史(如‘高血压’)”“药物(如‘阿司匹林’)”等实体,辅助医生诊断。通过解决“低资源”和“嵌套实体”问题(如“2型糖尿病合并高血压”中的嵌套疾病名),可将实体识别准确率从75%提升至92%。

场景2:金融风控系统

银行的反欺诈APP需要从用户交易备注中识别“异常关键词(如‘刷单’‘跑分’)”“可疑账户(如‘XX投资公司’)”等实体。通过“跨领域泛化”技术,模型可从电商领域(识别“刷单”)快速适配到金融领域,响应新型欺诈手段的速度提升50%。

场景3:智能客服对话

电商平台的智能客服需要理解用户问题中的“商品名(如‘iPhone 15’)”“需求(如‘退货’)”“时间(如‘3天内’)”等实体。通过优化“实时性”(模型压缩后延迟从800ms降至200ms),用户等待时间减少,满意度提升30%。

工具和资源推荐

开源工具库

- Hugging Face Transformers:集成BERT、RoBERTa等预训练模型,支持快速NER模型开发(官网)。

- spaCy:提供开箱即用的NER组件,支持多语言(官网)。

- Stanford NER:经典的CRF-based NER工具,适合轻量级场景(官网)。

标注工具

公开数据集

- CoNLL-2003:英文NER经典数据集(人名、地名、机构名)。

- OntoNotes 5.0:多语言、多领域(新闻、对话)的NER数据集。

- CLUE:中文自然语言处理数据集,包含中文NER子任务(链接)。

未来发展趋势与挑战

趋势1:大模型驱动的零样本/少样本NER

GPT-4、LLaMA等大语言模型通过“指令微调”,可直接理解“请识别这段文本中的疾病名”等自然语言指令,无需标注数据(零样本)或仅需少量示例(少样本)。未来AI原生应用的NER模块可能“去模型化”,直接调用大模型API完成。

趋势2:多模态实体识别

结合文本、图像、语音等多模态数据(如“患者描述+病历图片+语音备注”),识别跨模态实体(如“图片中的‘糖尿病’报告”与“语音中的‘血糖高’”关联)。这需要解决多模态特征融合的技术难题。

挑战1:隐私保护下的实体识别

医疗、金融等领域的实体(如“患者姓名”“银行账户”)涉及敏感信息,需在“识别精准性”与“数据隐私”间平衡。联邦学习(在本地训练模型,不传输原始数据)可能成为关键技术。

挑战2:动态实体的实时学习

新兴实体(如“元宇宙”“AIGC”)不断涌现,AI原生应用需具备“在线学习”能力,无需重新训练模型即可识别新实体。这对模型的增量学习(Incremental Learning)能力提出了更高要求。

总结:学到了什么?

核心概念回顾

- 实体识别(NER):从文本中提取并分类关键实体的技术,是AI原生应用的“信息过滤器”。

- 常见问题:低资源数据、边界模糊、跨域失效、嵌套实体、实时性差。

- 解决思路:迁移学习/数据增强(数据不足)、BIOES+CRF(边界模糊)、多任务学习(跨域)、分层模型(嵌套)、模型压缩(实时性)。

概念关系回顾

实体识别的效果直接影响AI原生应用的智能程度,而解决其常见问题需要“数据、模型、场景”三者结合:用迁移学习解决数据不足,用CRF优化边界判断,用分层模型处理嵌套实体,最终让AI原生应用更“懂用户”。

思考题:动动小脑筋

- 假设你要开发一个“新能源汽车”领域的AI原生APP,需要识别“锂电池”“自动驾驶系统”“充电桩”等实体,但只有200条标注数据。你会用哪些方法提升NER效果?

- 实时性要求高的对话场景(如智能客服)中,若模型延迟过高(1秒以上),你会优先优化模型结构(如换用轻量级模型)还是硬件(如部署GPU)?为什么?

- 嵌套实体“上海交通大学人工智能学院”中包含哪些子实体?如何设计模型同时识别主实体和子实体?

附录:常见问题与解答

Q:实体识别和分词有什么区别?

A:分词是将文本拆分成词语(如“我/爱/北京/天安门”),不关心词语的具体类型;实体识别是在分词基础上,进一步判断词语的类型(如“北京”是地名,“天安门”是景点名)。

Q:如何选择NER模型?

A:根据场景需求:

- 数据充足、精度优先:选BERT等预训练模型;

- 实时性要求高:选轻量级模型(如DistilBERT)或CRF;

- 低资源场景:用迁移学习+数据增强。

Q:嵌套实体一定需要复杂模型吗?

A:不一定。如果嵌套层数少(如2层),可以用“主实体识别→子实体识别”的级联方式;如果嵌套复杂(如3层以上),则需要指针网络或分层模型。

扩展阅读 & 参考资料

- 《自然语言处理入门》(何晗):基础理论与实战结合,适合NLP入门。

- 《预训练模型:原理与实战》(车万翔):深入讲解迁移学习在NLP中的应用。

- 论文《Named Entity Recognition in Chinese Social Media with Jointly Trained Auxiliary Tasks》:探讨低资源场景下的中文NER解决方案。

更多推荐

已为社区贡献250条内容

已为社区贡献250条内容

所有评论(0)