企业知识图谱构建AI方案,AI应用架构师的未来蓝图

知识图谱(Knowledge Graph)是一种以实体为节点、关系为边的结构化语义网络,能够将分散的数据转化为“实体-关系-属性”的三元组(如“苹果公司-总部位于-库比蒂诺”),并通过图结构实现知识的关联与推理。自动化知识构建:从文本、表格、图像中自动抽取实体、关系和属性,替代70%以上的人工工作。深度知识关联:打破数据孤岛,通过图查询快速定位“隐藏关系”(如“某客户的供应商的竞争对手”)。智能决

企业知识图谱构建AI方案与AI应用架构师的未来蓝图:从技术实践到职业进化

引言:当知识成为企业核心竞争力,架构师如何绘制未来?

痛点引入:企业知识管理的“三座大山”

在数字化转型的浪潮中,企业积累了海量数据——客户资料、产品手册、研发文档、供应链信息、市场动态……这些数据本应是驱动决策的“金矿”,但现实却是:

- 知识孤岛严重:数据分散在Excel、CRM、ERP、邮件、文档系统中,格式不一(结构化表格、非结构化文本、图片、语音),部门间数据壁垒导致“数据有了,知识没了”。

- 知识抽取低效:传统方式依赖人工整理,耗时且易出错。例如,某制造企业的研发团队需要从10万份专利文档中提取“技术原理-零部件-供应商”关系,人工处理需3个月,且遗漏率超过20%。

- 决策支持乏力:当CEO询问“某产品线的核心风险点有哪些?”时,员工需跨系统汇总数据,而知识图谱可实时返回“原材料供应商稳定性(风险等级3/5)→ 生产工艺瓶颈(风险等级4/5)→ 竞品技术迭代(风险等级2/5)”的关联分析。

数据显示:Gartner调研指出,企业中80%的决策依赖非结构化数据,但仅15%的企业能有效利用这些数据;麦肯锡则发现,知识管理效率低下导致企业平均损失20-30%的年度营收。

解决方案概述:知识图谱+AI,构建企业“智慧大脑”

知识图谱(Knowledge Graph)是一种以实体为节点、关系为边的结构化语义网络,能够将分散的数据转化为“实体-关系-属性”的三元组(如“苹果公司-总部位于-库比蒂诺”),并通过图结构实现知识的关联与推理。结合AI技术(NLP、机器学习、大模型),企业知识图谱可实现:

- 自动化知识构建:从文本、表格、图像中自动抽取实体、关系和属性,替代70%以上的人工工作。

- 深度知识关联:打破数据孤岛,通过图查询快速定位“隐藏关系”(如“某客户的供应商的竞争对手”)。

- 智能决策支持:结合大模型实现知识问答、风险预警、智能推荐(如“推荐适合该客户的产品组合”)。

核心价值:IDC预测,到2025年,60%的大型企业将依赖知识图谱驱动决策,知识图谱相关市场规模将突破500亿美元。

AI应用架构师的角色:从“技术实现者”到“业务价值架构师”

在企业知识图谱构建中,AI应用架构师是“技术与业务的桥梁”,负责将知识图谱技术转化为可落地的业务方案。其核心职责包括:

- 需求解码:将业务痛点(如“风控”“研发效率”)转化为知识图谱的技术目标(实体类型、关系定义、推理规则)。

- 技术选型:在图数据库(Neo4j/JanusGraph)、抽取模型(BERT/ERNIE)、架构模式(单体/微服务)中选择最优组合。

- 全流程架构设计:设计数据层、抽取层、融合层、存储层、应用层的端到端架构,确保高可用、可扩展、低延迟。

未来趋势:随着大模型、多模态技术的发展,AI应用架构师需升级为“跨模态知识架构师”,掌握知识图谱与大模型融合(RAG、Agent)、联邦知识图谱、自动知识图谱构建(AutoKG)等技术,成为企业数字化转型的“总设计师”。

本文脉络:从技术方案到职业进化的全景指南

本文将分为三大部分,构建“技术实践-架构设计-未来展望”的完整闭环:

- 企业知识图谱构建AI方案:详解从需求分析到应用落地的全流程技术细节,包含工具选型、代码示例、案例分析。

- AI应用架构师的核心能力与职责:剖析架构师在知识图谱项目中的角色,从技术选型到性能优化的实战经验。

- 未来蓝图:技术趋势与架构师能力进化:探讨多模态知识图谱、大模型融合等前沿方向,以及架构师的能力升级路径。

第一部分:企业知识图谱构建AI方案——从0到1的技术实践

1.1 核心概念与技术栈:知识图谱的“地基”与“工具箱”

1.1.1 知识图谱的核心概念:实体、关系、属性与本体

知识图谱的本质是“结构化的语义网络”,其核心组成包括:

- 实体(Entity):现实世界中的具体事物或抽象概念,如“华为Mate 60”(产品)、“任正非”(人物)、“5G技术”(概念)。

- 关系(Relation):实体间的关联,如“华为Mate 60-搭载-5G技术”“任正非-创立-华为”。

- 属性(Attribute):实体的特征描述,如“华为Mate 60-发布时间-2023年8月”“华为-成立时间-1987年”。

- 本体(Ontology):知识图谱的“ schema”,定义实体类型、关系类型、属性类型及其约束(如“产品”类型包含“发布时间”“价格”属性,“搭载”关系的定义域为“产品”,值域为“技术”)。

示例:电商企业知识图谱的本体设计(简化版)

本体设计的重要性:本体是知识图谱的“骨架”,决定了知识的表达能力。例如,若未定义“竞品”关系,系统将无法识别“iPhone 15”与“华为Mate 60”的竞争关系,导致推荐系统失效。

1.1.2 技术栈全景图:从数据采集到知识应用的“全链条工具”

企业知识图谱构建涉及多学科技术,核心技术栈可分为6层:

| 技术层 | 核心任务 | 主流工具/框架 | 选型考量因素 |

|---|---|---|---|

| 数据采集层 | 从多源异构数据中获取原始数据 | Python爬虫(Scrapy/BeautifulSoup)、API接口(企业内部系统/公开API)、ETL工具(Talend/Kettle) | 数据源类型(结构化/非结构化)、数据规模(GB/TB级)、实时性需求(T+1/实时) |

| 数据预处理层 | 数据清洗、标准化、格式转换 | Python库(Pandas/Numpy)、文本处理(spaCy/NLTK)、图像预处理(OpenCV/PIL) | 数据质量(噪声率、缺失值)、下游模型需求(如BERT需分词、词性标注) |

| 知识抽取层 | 实体/关系/属性抽取 | NLP模型(BERT/ERNIE/RoBERTa)、规则引擎(Snorkel/Slate)、标注工具(Label Studio/Prodigy) | 抽取精度(F1值)、领域适配性(通用/垂直领域模型)、标注成本(人工/远程监督) |

| 知识融合层 | 实体对齐、冲突解决、知识补全 | 实体对齐工具(Dedupe/OpenRefine)、知识补全模型(TransE/ComplEx)、本体管理(Protégé) | 实体歧义度(如“苹果”可指公司/水果)、知识更新频率(静态/动态) |

| 知识存储层 | 存储实体、关系、属性及图结构 | 图数据库(Neo4j/JanusGraph/TigerGraph)、关系数据库(MySQL/PostgreSQL)、混合存储(图+关系库) | 查询复杂度(深度查询/路径分析)、数据规模(百万/亿级实体)、事务支持需求 |

| 知识应用层 | 知识检索、推理、可视化 | 检索引擎(Elasticsearch+图查询)、推理引擎(Drools/Jess)、可视化工具(Neo4j Bloom/Linkurious) | 应用场景(问答/推荐/风控)、响应时间(毫秒级/秒级)、用户交互方式 |

技术选型原则:没有“银弹”,需结合业务场景。例如:

- 中小规模企业/非实时场景:优先选择开源工具(如Neo4j社区版、BERT-base模型),降低成本。

- 大规模企业/实时场景:需考虑分布式图数据库(JanusGraph)、预训练大模型(ERNIE 3.0)、微服务架构。

1.2 需求分析与本体设计:知识图谱的“蓝图”设计

1.2.1 需求分析:从业务痛点到技术目标的“翻译”

需求分析的核心是“明确知识图谱的业务价值”,避免为了技术而技术。步骤如下:

-

业务场景调研:访谈业务部门(如风控、研发、销售),明确核心痛点。

- 例:银行风控部门痛点:“需从企业年报、新闻、司法文书中快速识别关联企业风险,但人工筛查耗时且漏报率高”。

- 转化为技术目标:“构建企业关联关系知识图谱,支持‘企业-股东-高管-涉诉记录’的5层以内关联查询,查询响应时间<1秒”。

-

知识范围定义:确定实体、关系、属性的类型及范围。

- 实体类型:企业、股东、高管、涉诉事件、行业分类。

- 关系类型:持股、任职、关联交易、涉诉。

- 属性类型:企业(注册资本、成立时间、行业)、高管(姓名、职位、任职时间)。

-

性能与规模需求:明确技术指标(非功能需求)。

- 数据规模:覆盖100万+企业实体,1000万+关系。

- 查询性能:单点查询<100ms,深度路径查询<1s。

- 更新频率:企业基本信息每日更新,涉诉信息实时更新。

工具推荐:使用用户故事(User Story)和用例图(Use Case Diagram)梳理需求,例如:

“作为风控分析师,我需要输入企业名称后,系统自动展示其5层以内的关联企业及风险标签(如‘被执行人’),以便快速评估信贷风险。”

1.2.2 本体设计实战:以金融风控知识图谱为例

本体设计的步骤:

-

确定核心实体类型:基于需求分析,列出核心实体(如“企业”“自然人”“涉诉事件”),并定义层级关系(如“企业”包含“上市公司”“非上市公司”)。

-

定义关系类型:明确实体间的关系及方向,如“企业-持股->企业”(持股比例属性)、“自然人-任职->企业”(职位属性)。

-

定义属性类型:为每个实体类型定义属性,如“企业”的属性包括:

- 基本属性:企业名称、统一社会信用代码、注册资本、成立日期。

- 风险属性:是否被执行人、是否失信企业、涉诉次数。

-

约束规则定义:通过本体语言(OWL/SHACL)定义规则,如“一个自然人在同一企业只能有一个最高职位”“持股比例总和不能超过100%”。

案例:金融风控知识图谱本体片段(OWL表示)

<!-- 实体类型定义 -->

<owl:Class rdf:about="#企业"/>

<owl:Class rdf:about="#自然人"/>

<owl:Class rdf:about="#涉诉事件"/>

<!-- 关系类型定义 -->

<owl:ObjectProperty rdf:about="#持股">

<rdfs:domain rdf:resource="#自然人"/>

<rdfs:range rdf:resource="#企业"/>

<rdfs:subPropertyOf rdf:resource="http://www.w3.org/2002/07/owl#topObjectProperty"/>

</owl:ObjectProperty>

<!-- 属性类型定义 -->

<owl:DatatypeProperty rdf:about="#注册资本">

<rdfs:domain rdf:resource="#企业"/>

<rdfs:range rdf:resource="http://www.w3.org/2001/XMLSchema#decimal"/>

</owl:DatatypeProperty>

<!-- 约束规则(SHACL) -->

<sh:PropertyShape sh:path="#持股比例">

<sh:datatype rdf:resource="http://www.w3.org/2001/XMLSchema#float"/>

<sh:minInclusive>0.0</sh:minInclusive>

<sh:maxInclusive>100.0</sh:maxInclusive>

</sh:PropertyShape>

本体设计工具:推荐使用Protégé(开源本体编辑工具),支持OWL/SHACL语法,可可视化本体结构并进行一致性检查。

1.3 数据采集与预处理:知识图谱的“原材料”加工

1.3.1 多源数据采集:结构化、非结构化与半结构化数据的“一网打尽”

企业数据通常分散在多种数据源中,需针对性设计采集方案:

| 数据类型 | 常见来源 | 采集工具/方法 | 挑战与解决方案 |

|---|---|---|---|

| 结构化数据 | 企业内部数据库(MySQL/Oracle)、Excel表格、CRM/ERP系统 | ETL工具(如Talend):通过JDBC连接数据库,定时抽取(T+1);API接口:调用内部系统API(如Salesforce API)获取实时数据 | 数据格式不统一(如日期格式“YYYY-MM-DD”与“MM/DD/YYYY”)→ 标准化脚本处理 |

| 非结构化数据 | 文档(Word/PDF)、邮件、网页、语音/视频 | 文本:Python爬虫(Scrapy爬取行业报告)、文档解析(PyPDF2/python-docx提取文本);语音:ASR工具(阿里云ASR/科大讯飞)转文本 | 文本噪声(如PDF扫描件需OCR→Tesseract/OCR.space)、长文档处理(分块避免内存溢出) |

| 半结构化数据 | HTML/XML文件、JSON接口返回、日志文件 | 解析库(lxml/BeautifulSoup解析HTML)、JSON解析(Python json库)、日志采集(ELK Stack) | 标签嵌套复杂(如多层HTML嵌套)→ XPath/CSS选择器精确定位数据 |

代码示例:使用Scrapy爬取行业新闻(非结构化数据采集)

# Scrapy爬虫示例:爬取某财经网站的企业新闻

import scrapy

from scrapy.crawler import CrawlerProcess

class FinanceNewsSpider(scrapy.Spider):

name = 'finance_news'

start_urls = ['https://example.com/finance/enterprise-news'] # 目标网站URL

def parse(self, response):

# 提取新闻列表页的新闻链接

news_links = response.css('div.news-list a::attr(href)').getall()

for link in news_links:

yield response.follow(link, self.parse_news)

# 翻页处理

next_page = response.css('a.next-page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)

def parse_news(self, response):

# 提取新闻详情:标题、正文、发布时间

yield {

'title': response.css('h1.news-title::text').get().strip(),

'content': '\n'.join(response.css('div.news-content p::text').getall()),

'publish_time': response.css('span.publish-time::text').get().strip(),

'url': response.url

}

# 运行爬虫并保存数据到JSON文件

process = CrawlerProcess(settings={

'FEEDS': {

'finance_news.json': {'format': 'json', 'overwrite': True},

},

})

process.crawl(FinanceNewsSpider)

process.start()

1.3.2 数据预处理:从“原始数据”到“可用数据”的关键一步

数据预处理的目标是“提升数据质量”,为下游知识抽取提供干净的输入。核心步骤包括:

1. 数据清洗:去除噪声、处理缺失值与异常值

- 文本数据:去重(基于标题/正文MD5哈希)、去除特殊字符(正则表达式

re.sub(r'[^\w\s]', '', text))、过滤低质量文本(如字数<100的短文本)。 - 结构化数据:缺失值处理(数值型用均值/中位数填充,类别型用众数填充)、异常值检测(IQR法则: Q 3 + 1.5 × I Q R Q3 + 1.5×IQR Q3+1.5×IQR或 Q 1 − 1.5 × I Q R Q1 - 1.5×IQR Q1−1.5×IQR之外的值为异常值)。

2. 文本标准化:统一格式与表达方式

- 分词(中文用Jieba/THULAC,英文用NLTK)、词性标注(spaCy的

nlp(text).ents识别命名实体)、停用词去除(加载停用词表过滤“的”“是”等无意义词)。 - 示例:“华为公司2023年发布了Mate 60手机” → 分词后:“华为公司/2023年/发布/了/Mate 60/手机”。

3. 格式转换:适配下游工具需求

- 文本转为模型输入格式(如BERT需转为token id:

tokenizer.encode(text, return_tensors='pt'))。 - 图像转为向量(如用ResNet提取图像特征:

model(image).detach().numpy())。

代码示例:文本预处理流水线(Python)

import re

import jieba

import spacy

from sklearn.feature_extraction.text import TfidfVectorizer

# 加载工具:中文分词(Jieba)、英文NLP处理(spaCy)

jieba.load_userdict('domain_dict.txt') # 加载领域词典(如“Mate 60”作为整体词)

nlp_en = spacy.load("en_core_web_sm")

def clean_text(text):

"""文本清洗:去除特殊字符、多余空格"""

text = re.sub(r'[^\w\s\u4e00-\u9fa5]', '', text) # 保留中文、英文、数字、空格

text = re.sub(r'\s+', ' ', text).strip() # 多个空格转为单个空格

return text

def chinese_tokenize(text):

"""中文分词+停用词去除"""

stopwords = set(open('stopwords.txt', 'r', encoding='utf-8').read().splitlines())

words = jieba.cut(text)

return [word for word in words if word not in stopwords and len(word) > 1]

def english_preprocess(text):

"""英文预处理:分词、词性标注、实体识别"""

doc = nlp_en(text)

tokens = [token.lemma_ for token in doc if not token.is_stop and token.is_alpha] # 词形还原、去停用词

entities = [(ent.text, ent.label_) for ent in doc.ents] # 实体识别(如ORG, PERSON)

return tokens, entities

# 示例:处理中文文本

text = "华为公司2023年8月发布了Mate 60手机,搭载了5G芯片。"

cleaned_text = clean_text(text)

tokens = chinese_tokenize(cleaned_text)

print(f"清洗后文本:{cleaned_text}")

print(f"分词结果:{tokens}") # 输出:['华为公司', '2023年', '8月', '发布', 'Mate', '60', '手机', '搭载', '5G', '芯片']

1.4 知识抽取:从文本中“挖掘”实体、关系与属性

1.4.1 实体抽取:识别“谁/什么”——从命名实体到领域实体

实体抽取是知识图谱构建的“第一步”,目标是从文本中识别出预定义类型的实体(如“企业”“产品”“人物”)。主流方法包括规则法、监督学习、远程监督和预训练模型法。

1. 规则法:基于词典与正则表达式的“快速启动”方案

- 词典匹配:构建领域实体词典(如企业名称词典、产品型号词典),使用Aho-Corasick算法快速匹配文本中的实体。

- 正则表达式:针对结构化实体(如日期、邮箱、电话号码),用正则匹配,例如:

- 日期:

r'\d{4}-\d{2}-\d{2}' - 统一社会信用代码:

r'[0-9A-HJ-NPQRTUWXY]{2}\d{6}[0-9A-HJ-NPQRTUWXY]{10}'

- 日期:

2. 预训练模型法:基于BERT的领域实体抽取(当前最优方案)

预训练语言模型(如BERT)通过微调可实现高精度实体抽取。以中文企业实体抽取为例,步骤如下:

-

数据准备:标注数据(使用Label Studio标注实体,格式为BIO标签:B-ORG(实体开始)、I-ORG(实体中间)、O(非实体))。

示例标注:华 B-ORG 为 I-ORG 公 I-ORG 司 I-ORG 发 O 布 O Mate B-PRODUCT 60 I-PRODUCT 手 I-PRODUCT 机 I-PRODUCT -

模型微调:使用Hugging Face Transformers库加载BERT-base-chinese模型,冻结底层参数,微调顶层分类头。

代码示例:基于BERT的实体抽取模型微调

from datasets import load_dataset

from transformers import BertTokenizerFast, BertForTokenClassification, TrainingArguments, Trainer

import torch

# 1. 加载数据(Label Studio导出的JSON格式)

dataset = load_dataset('json', data_files={'train': 'train.json', 'val': 'val.json'})

# 2. 定义标签与ID映射(BIO标签)

label_list = ['O', 'B-ORG', 'I-ORG', 'B-PRODUCT', 'I-PRODUCT', 'B-PERSON', 'I-PERSON']

label2id = {label: i for i, label in enumerate(label_list)}

id2label = {i: label for i, label in enumerate(label_list)}

# 3. 加载BERT分词器与模型

tokenizer = BertTokenizerFast.from_pretrained('bert-base-chinese')

model = BertForTokenClassification.from_pretrained(

'bert-base-chinese',

num_labels=len(label_list),

id2label=id2label,

label2id=label2id

)

# 4. 数据预处理函数(将文本转为模型输入格式)

def preprocess_function(examples):

tokenized_inputs = tokenizer(

examples['tokens'], truncation=True, is_split_into_words=True, max_length=512

)

labels = []

for i, label in enumerate(examples['labels']):

word_ids = tokenized_inputs.word_ids(batch_index=i) # 获取词与子词的映射

previous_word_idx = None

label_ids = []

for word_idx in word_ids:

if word_idx is None: # 子词(如“华”被分为“华”和“##为”)

label_ids.append(-100) # 忽略子词的损失计算

elif word_idx != previous_word_idx: # 词的第一个子词

label_ids.append(label2id[label[word_idx]])

else: # 词的后续子词,继承第一个子词的标签

label_ids.append(label2id[label[word_idx]] if label[word_idx].startswith('I-') else -100)

previous_word_idx = word_idx

labels.append(label_ids)

tokenized_inputs['labels'] = labels

return tokenized_inputs

tokenized_dataset = dataset.map(preprocess_function, batched=True)

# 5. 定义训练参数与Trainer

training_args = TrainingArguments(

output_dir='./bert-ner-results',

evaluation_strategy='epoch',

learning_rate=2e-5,

per_device_train_batch_size=16,

per_device_eval_batch_size=16,

num_train_epochs=5,

weight_decay=0.01,

logging_dir='./logs',

)

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_dataset['train'],

eval_dataset=tokenized_dataset['val'],

)

# 6. 开始训练

trainer.train()

# 7. 模型预测示例

text = "华为公司发布了Mate 60手机"

inputs = tokenizer(text, return_tensors="pt", truncation=True, max_length=512)

with torch.no_grad():

outputs = model(**inputs)

predictions = torch.argmax(outputs.logits, dim=2)

predicted_labels = [id2label[p.item()] for p in predictions[0]]

print(f"输入文本:{text}")

print(f"预测标签:{predicted_labels}")

# 输出:['O', 'B-ORG', 'I-ORG', 'I-ORG', 'I-ORG', 'O', 'O', 'B-PRODUCT', 'I-PRODUCT', 'I-PRODUCT', 'I-PRODUCT']

模型评估:通过F1值评估实体抽取效果,工业界目标F1值需≥0.9(通用领域)或≥0.85(垂直领域,如医疗/法律)。

1.4.2 关系抽取:识别实体间的“联系”——从“华为”和“Mate 60”到“发布”

关系抽取的目标是识别实体对之间的语义关系(如“企业-发布-产品”“人物-任职-企业”)。主流方法包括基于规则的方法、基于监督学习的方法和基于远程监督的方法。

1. 基于规则的关系抽取:适用于结构化文本(如表格、模板化文档)

- 模式匹配:定义实体对的上下文模式,例如“X公司发布了Y产品”→ 关系“发布”(X,Y)。

- 依存句法分析:通过spaCy分析句子的依存结构(主谓宾关系),提取实体对与关系词。

示例:“华为(主语)发布(谓语)Mate 60(宾语)”→ 关系“发布”(华为,Mate 60)。

2. 基于预训练模型的关系抽取:BERT+关系分类(当前主流)

将关系抽取转化为“句子分类”任务:给定包含两个实体的句子,预测实体对的关系类型。

步骤:

- 数据准备:标注数据格式为(实体1,实体2,句子,关系类型),例如:

(华为,Mate 60,“华为发布了Mate 60”,发布) - 模型微调:使用BERT模型,输入为

[CLS] + 句子 + [SEP],实体位置通过特殊标记(如[E1][/E1][E2][/E2])标注,模型输出关系类型概率。

代码示例:基于BERT的关系分类

from transformers import BertTokenizer, BertForSequenceClassification, TrainingArguments, Trainer

import torch

# 1. 定义关系类型与数据

relation_list = ['发布', '持股', '任职', '无关系']

relation2id = {r: i for i, r in enumerate(relation_list)}

id2relation = {i: r for i, r in enumerate(relation_list)}

# 示例数据(实体1,实体2,句子)

train_data = [

("华为", "Mate 60", "华为公司在2023年发布了Mate 60手机"),

("任正非", "华为", "任正非是华为公司的创始人"),

("苹果", "三星", "苹果和三星是竞争对手"), # 无关系

]

train_labels = [0, 2, 3] # 对应关系ID

# 2. 加载分词器与模型

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

model = BertForSequenceClassification.from_pretrained(

'bert-base-chinese',

num_labels=len(relation_list)

)

# 3. 数据预处理:在实体前后添加特殊标记

def preprocess(text, e1, e2):

return f"[CLS] [E1]{e1}[/E1] [E2]{e2}[/E2] {text} [SEP]"

inputs = [preprocess(text, e1, e2) for e1, e2, text in train_data]

encodings = tokenizer(inputs, padding=True, truncation=True, return_tensors="pt")

labels = torch.tensor(train_labels)

# 4. 训练模型(简化版,实际需使用Dataset和Trainer)

outputs = model(**encodings, labels=labels)

loss = outputs.loss

logits = outputs.logits

predictions = torch.argmax(logits, dim=1)

print(f"预测关系:{[id2relation[p.item()] for p in predictions]}") # 输出:['发布', '任职', '无关系']

1.4.3 属性抽取:为实体“贴标签”——从文本中提取实体属性

属性抽取是获取实体的特征信息(如“企业-注册资本-5000万”“产品-价格-5999元”)。常用方法包括:

- 规则抽取:基于属性名的模式匹配,例如“注册资本:X万元”→ 属性“注册资本”=X。

- 序列标注:将属性值视为特殊实体(如“数值型实体”),用实体抽取模型提取,再关联到属性名。

- 问答式抽取:将属性抽取转化为问答任务,例如“华为的注册资本是多少?”,用QA模型(如BERT-base-uncased)从文本中抽取答案。

1.5 知识融合与存储:构建“干净、统一”的知识网络

1.5.1 知识融合:解决“同名异义”与“异名同义”问题

知识融合的核心是“统一知识表示”,消除实体歧义与冲突。主要任务包括实体对齐、冲突解决和知识补全。

1. 实体对齐(Entity Alignment):识别不同来源中指向同一实体的记录

- 基于属性的对齐:比较实体属性相似度,如“华为技术有限公司”与“华为公司”,若名称相似度>0.8(Jaccard相似度/编辑距离)、统一社会信用代码相同,则判定为同一实体。

- 基于嵌入的对齐:将实体映射到低维向量空间(如TransE模型),通过余弦相似度判断实体是否相同:

sim ( e 1 , e 2 ) = e 1 ⋅ e 2 ∣ ∣ e 1 ∣ ∣ ⋅ ∣ ∣ e 2 ∣ ∣ \text{sim}(e1, e2) = \frac{e1 \cdot e2}{||e1|| \cdot ||e2||} sim(e1,e2)=∣∣e1∣∣⋅∣∣e2∣∣e1⋅e2

相似度>0.95则判定为同一实体。

工具推荐:Dedupe(基于监督学习的实体对齐工具)、OpenRefine(开源数据清洗与对齐工具)。

2. 冲突解决:处理同一属性的不同值

当不同数据源对同一实体的同一属性给出不同值时(如“华为成立时间”在A数据源为“1987年”,B数据源为“1988年”),需通过规则或模型解决冲突:

- 规则冲突解决:基于数据源可信度(如“官方网站数据>第三方数据”)、时间戳(“最新数据覆盖旧数据”)。

- 投票法:多个数据源中出现次数最多的值作为最终值。

1.5.2 知识存储:图数据库 vs 关系数据库的“选择之战”

知识图谱的存储需支持“图结构查询”(如路径查询、邻居查询),主流存储方案对比:

| 存储方案 | 代表产品 | 优势 | 劣势 | 适用场景 |

|---|---|---|---|---|

| 图数据库 | Neo4j、JanusGraph、TigerGraph | 原生支持图结构,查询效率高(深度路径查询毫秒级);支持图算法(PageRank/社区发现) | 写入性能较低(百万级实体以上需分片);事务支持有限(部分开源版不支持ACID) | 知识图谱核心存储,需频繁进行图查询(如风控关系分析、推荐系统) |

| 关系数据库 | MySQL、PostgreSQL | 成熟稳定,支持ACID事务;开发成本低(熟悉SQL) | 图查询需多表JOIN,效率低(深度>3时性能急剧下降) | 小规模知识图谱(实体<100万),或需与现有关系数据库系统集成 |

| 混合存储 | 图数据库+关系数据库+搜索引擎 | 图数据库存核心图结构,关系数据库存属性数据,Elasticsearch支持全文检索 | 架构复杂,维护成本高 | 大规模知识图谱(亿级实体),需兼顾图查询、事务与全文检索 |

图数据库选型建议:

- 中小规模企业/原型验证:Neo4j社区版(开源免费,支持单机部署,实体规模≤1000万)。

- 大规模企业/高并发场景:JanusGraph(分布式图数据库,支持HBase/Cassandra后端存储,实体规模亿级)。

Neo4j实战:创建实体与关系

// 创建企业实体

CREATE (c:Company {name: '华为技术有限公司', credit_code: '914403001922038216', founded: '1987-09-15'})

// 创建产品实体

CREATE (p:Product {name: 'Mate 60', type: '智能手机', price: 5999, release_date: '2023-08-29'})

// 创建关系

CREATE (c)-[r:RELEASED]->(p) SET r.timestamp = '2023-08-29'

// 查询华为发布的产品

MATCH (c:Company {name: '华为技术有限公司'})-[r:RELEASED]->(p:Product)

RETURN p.name, p.release_date

1.6 知识推理与应用:让知识图谱“活”起来

1.6.1 知识推理:从已知知识“推导”未知知识

知识推理是知识图谱的“智能核心”,通过规则或模型从现有知识中推导出新的知识。

1. 规则推理:基于预定义规则的确定性推理

- 产生式规则:

IF 条件 THEN 结论,例如:IF (X 是 Y 的母公司) AND (Y 是 Z 的母公司) THEN (X 是 Z 的母公司)(传递性规则)。

- 工具:Drools(Java规则引擎)、Pyke(Python规则引擎)。

2. 基于表示学习的推理:用机器学习模型预测未知关系

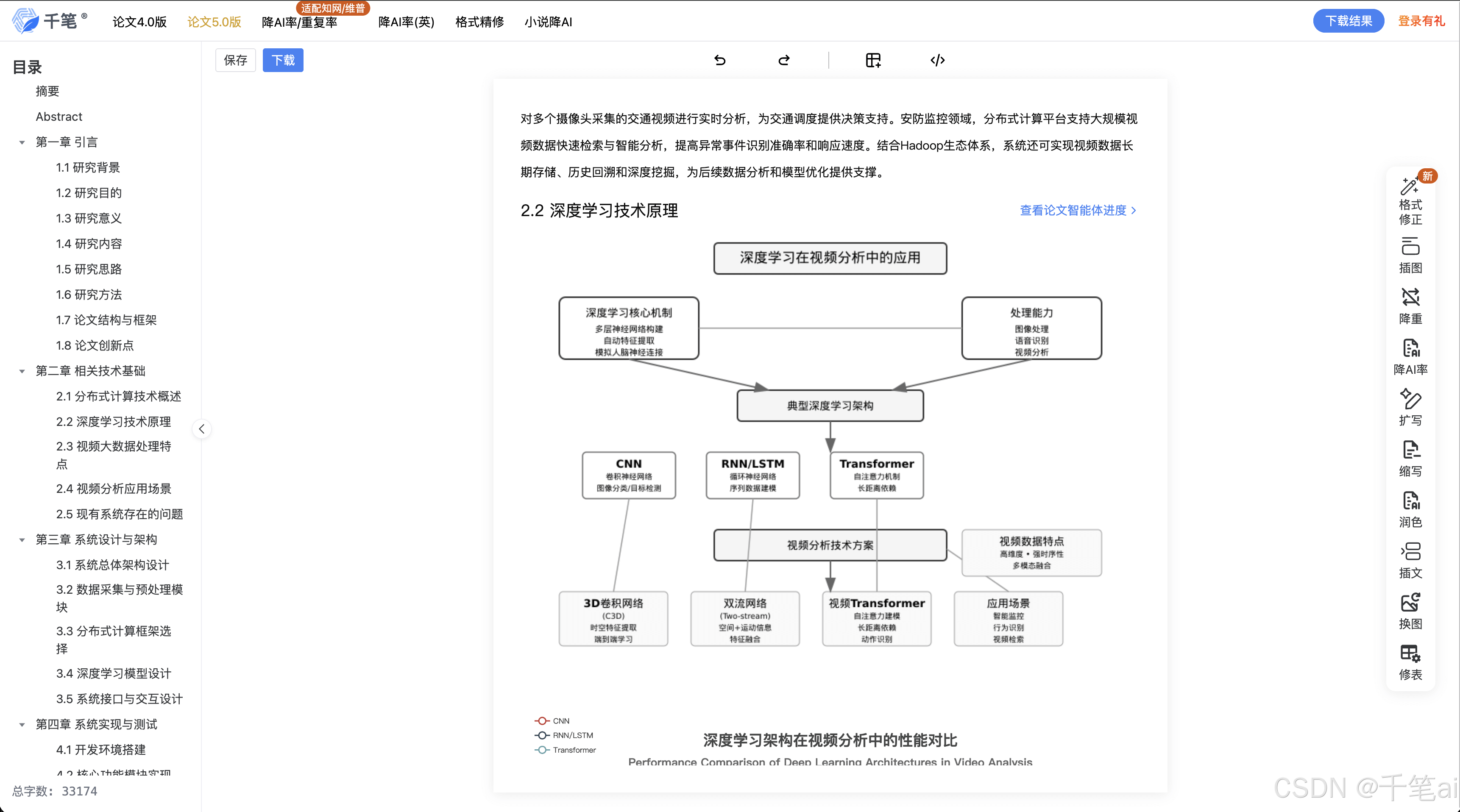

知识图谱表示学习(KG Embedding)将实体和关系映射到低维向量空间,通过向量运算预测缺失关系。主流模型包括:

-

TransE:将关系视为实体向量的平移,假设

h + r ≈ t(h:头实体,r:关系,t:尾实体),能量函数为:

E ( h , r , t ) = ∣ ∣ h + r − t ∣ ∣ 2 2 E(h,r,t) = ||h + r - t||_2^2 E(h,r,t)=∣∣h+r−t∣∣22

能量越低,三元组(h,r,t)越可能成立。 -

ComplEx:考虑实体和关系的复数表示,通过复数乘法建模关系,适用于处理对称/反对称关系。

应用:知识补全(预测缺失的关系)、链接预测(判断三元组是否成立)。

1.6.2 知识图谱的典型应用场景

知识图谱在企业中的应用已覆盖多个领域,以下为典型场景案例:

1. 智能问答与客服

- 原理:用户提问→实体识别→关系查询→答案生成。

- 案例:某银行智能客服知识图谱,包含“产品”“服务”“流程”等实体,用户提问“信用卡申请条件”→ 系统查询“信用卡-申请条件-年龄≥18岁,有稳定收入”→ 返回答案。

2. 风控与反欺诈

- 原理:构建企业关联关系网络,通过路径分析识别“隐性关联风险”。

- 案例:某互金平台知识图谱包含“借款人”“关联企业”“黑名单”等实体,当新借款人与黑名单企业存在3层以内关联(如“借款人-股东-企业A-法人-黑名单企业B”),系统自动拒绝贷款申请,欺诈识别率提升40%。

3. 研发创新与专利分析

- 原理:构建技术知识图谱,分析技术演进路径、竞争格局。

- 案例:某科技企业知识图谱包含“专利”“技术主题”“发明人”“企业”实体,通过分析“5G技术”相关专利的引用关系,发现“Massive MIMO”是核心子技术,且华为的专利数量领先,为研发投入提供决策支持。

4. 智能推荐

- 原理:基于用户-商品-属性的关联关系,推荐相似商品或个性化内容。

- 案例:电商知识图谱中,用户购买“华为Mate 60”→ 系统查询“Mate 60-搭载-5G芯片”“5G芯片-关联-快充技术”→ 推荐支持快充的华为配件。

第二部分:AI应用架构师的核心能力与职责——知识图谱项目的“总设计师”

2.1 AI应用架构师在知识图谱项目中的角色定位

AI应用架构师是知识图谱项目的“技术总负责人”,需平衡技术可行性与业务价值,核心职责包括:

- 需求分析与业务建模:将业务目标(如“提升风控效率”)转化为知识图谱的技术指标(实体类型、关系定义、查询性能)。

- 技术选型与架构设计:选择合适的工具链(图数据库、抽取模型、推理引擎),设计可扩展、高可用的系统架构。

- 项目管理与资源协调:协调数据工程师、算法工程师、前端开发等团队,确保项目按时交付。

- 性能优化与问题排查:解决知识图谱的查询延迟、存储瓶颈、模型精度等问题。

- 安全与合规:确保知识图谱数据符合隐私法规(如GDPR、个人信息保护法),实现数据脱敏、访问控制。

2.2 知识图谱系统架构设计:从“单体”到“分布式”的演进

知识图谱系统的架构设计需根据企业规模和业务需求选择合适的模式:

2.2.1 单体架构:适用于中小规模企业(实体<1000万)

架构图:

特点:各模块部署在单一服务器,开发简单,维护成本低;但扩展性差,难以应对数据量增长。

2.2.2 微服务架构:适用于中大型企业(实体1000万-1亿)

将知识图谱系统拆分为多个微服务,通过API网关通信,支持独立部署与扩展:

核心微服务:

- 数据采集服务:负责多源数据接入,独立扩展以应对高并发数据采集。

- 知识抽取服务:封装实体/关系/属性抽取模型,支持水平扩展(增加GPU节点提升抽取速度)。

- 知识融合服务:处理实体对齐与冲突解决,可独立更新融合规则。

- 图数据库服务:部署分布式图数据库(JanusGraph),支持分片存储与负载均衡。

- 知识应用服务:提供问答API、推理API、可视化API,供前端调用。

架构图:

优势:可扩展性强(按需扩展微服务实例)、容错性高(单个服务故障不影响整体)、技术栈灵活(不同服务可选用不同语言/框架)。

2.3 性能优化:让知识图谱“跑得更快”

知识图谱系统的性能瓶颈通常出现在图查询和知识抽取环节,架构师需针对性优化:

2.3.1 图查询性能优化

- 索引优化:为常用查询字段创建索引,如Neo4j中对实体名称、关系类型创建索引:

CREATE INDEX company_name_idx FOR (c:Company) ON (c.name); CREATE INDEX relation_type_idx FOR ()-[r:RELEASED]-() ON (r.type); - 查询重写:优化Cypher查询语句,避免全图扫描(如

MATCH (n) RETURN n),使用LIMIT限制返回结果,拆分复杂查询为多个简单查询。 - 缓存策略:对高频查询结果(如“热门产品信息”)缓存到Redis,减少图数据库访问次数。

- 图分区:分布式图数据库(如JanusGraph)支持按实体ID范围或属性分区,将关联紧密的实体存储在同一分区,减少跨分区查询开销。

2.3.2 知识抽取性能优化

- 模型轻量化:用小模型(如DistilBERT/ALBERT)替代BERT,推理速度提升2-3倍,精度损失<5%。

- 批处理与并行化:知识抽取服务采用批处理模式(Batch Size=32/64),利用GPU并行处理多个文本。

- 增量抽取:仅对新增/更新的文档进行抽取,避免全量重抽。

2.4 安全与合规:知识图谱的“防护盾”

知识图谱包含企业核心数据,安全与合规是架构师必须考虑的问题:

- 数据脱敏:对敏感信息(如客户身份证号、企业财务数据)进行脱敏处理(部分掩码:

110****5678)。 - 访问控制:基于RBAC(基于角色的访问控制)模型,定义不同用户角色的操作权限(如“只读用户”只能查询,“管理员”可修改知识)。

- 审计日志:记录所有操作(查询、修改、删除),便于追溯与合规检查。

- 隐私计算:在跨企业知识共享场景(如供应链知识图谱),使用联邦学习/多方安全计算(MPC),

更多推荐

已为社区贡献1011条内容

已为社区贡献1011条内容

所有评论(0)