大模型在科学理论构建推理中的辅助作用

科学理论的构建与推理是推动科学进步的核心过程。传统的科学研究方法往往依赖于科学家的个人经验、专业知识和有限的数据。然而,随着大数据时代的到来,数据量呈爆炸式增长,传统方法在处理海量数据和复杂关系时面临着巨大的挑战。大模型作为一种强大的人工智能技术,具有强大的语言理解、知识融合和推理能力,为科学理论的构建与推理提供了新的思路和方法。本文旨在探讨大模型在科学理论构建推理中的辅助作用,分析其原理、应用场

大模型在科学理论构建推理中的辅助作用

关键词:大模型、科学理论构建、推理辅助、知识融合、模型评估

摘要:本文深入探讨了大模型在科学理论构建推理中的辅助作用。详细介绍了大模型的核心概念、相关算法原理以及涉及的数学模型,通过项目实战展示了大模型在实际科学研究中的应用。同时,分析了大模型在不同科学领域的实际应用场景,推荐了相关的学习资源、开发工具和论文著作。最后总结了大模型在科学理论构建推理中的未来发展趋势与挑战,并对常见问题进行了解答。

1. 背景介绍

1.1 目的和范围

科学理论的构建与推理是推动科学进步的核心过程。传统的科学研究方法往往依赖于科学家的个人经验、专业知识和有限的数据。然而,随着大数据时代的到来,数据量呈爆炸式增长,传统方法在处理海量数据和复杂关系时面临着巨大的挑战。大模型作为一种强大的人工智能技术,具有强大的语言理解、知识融合和推理能力,为科学理论的构建与推理提供了新的思路和方法。本文旨在探讨大模型在科学理论构建推理中的辅助作用,分析其原理、应用场景和发展趋势,为科研人员提供参考。

1.2 预期读者

本文的预期读者包括科研人员、人工智能领域的从业者、对科学研究和人工智能感兴趣的学生和爱好者。对于科研人员,本文可以帮助他们了解大模型在科学理论构建中的应用,为其研究工作提供新的工具和方法;对于人工智能领域的从业者,本文可以加深他们对大模型在科学领域应用的理解,拓展其应用场景;对于学生和爱好者,本文可以激发他们对科学研究和人工智能的兴趣,为他们的学习和研究提供指导。

1.3 文档结构概述

本文将按照以下结构进行组织:首先介绍大模型的核心概念与联系,包括其原理和架构;接着详细讲解大模型在科学理论构建推理中所涉及的核心算法原理和具体操作步骤,并给出Python源代码示例;然后阐述相关的数学模型和公式,并通过举例进行说明;之后通过项目实战展示大模型在科学研究中的具体应用,包括开发环境搭建、源代码实现和代码解读;再分析大模型在不同科学领域的实际应用场景;推荐相关的学习资源、开发工具和论文著作;最后总结大模型在科学理论构建推理中的未来发展趋势与挑战,并对常见问题进行解答。

1.4 术语表

1.4.1 核心术语定义

- 大模型:指具有大量参数和强大计算能力的人工智能模型,如GPT系列、BERT等。这些模型通过在大规模数据上进行训练,能够学习到丰富的语言知识和模式,具备较强的语言理解和生成能力。

- 科学理论构建:是指科学家通过对观察到的现象进行分析、归纳和演绎,提出假设,并通过实验和验证来形成科学理论的过程。

- 推理辅助:指大模型在科学理论构建过程中,为科学家提供信息检索、知识融合、逻辑推理等方面的帮助,辅助科学家进行科学理论的构建和推理。

1.4.2 相关概念解释

- 知识图谱:是一种以图的形式表示知识的方法,其中节点表示实体,边表示实体之间的关系。知识图谱可以帮助大模型更好地理解和处理知识,提高其推理能力。

- 深度学习:是一种基于人工神经网络的机器学习方法,通过多层神经网络的训练,能够自动从数据中学习到复杂的模式和特征。大模型通常采用深度学习技术进行训练。

1.4.3 缩略词列表

- GPT:Generative Pretrained Transformer,生成式预训练变换器。

- BERT:Bidirectional Encoder Representations from Transformers,基于变换器的双向编码器表示。

- API:Application Programming Interface,应用程序编程接口。

2. 核心概念与联系

核心概念原理

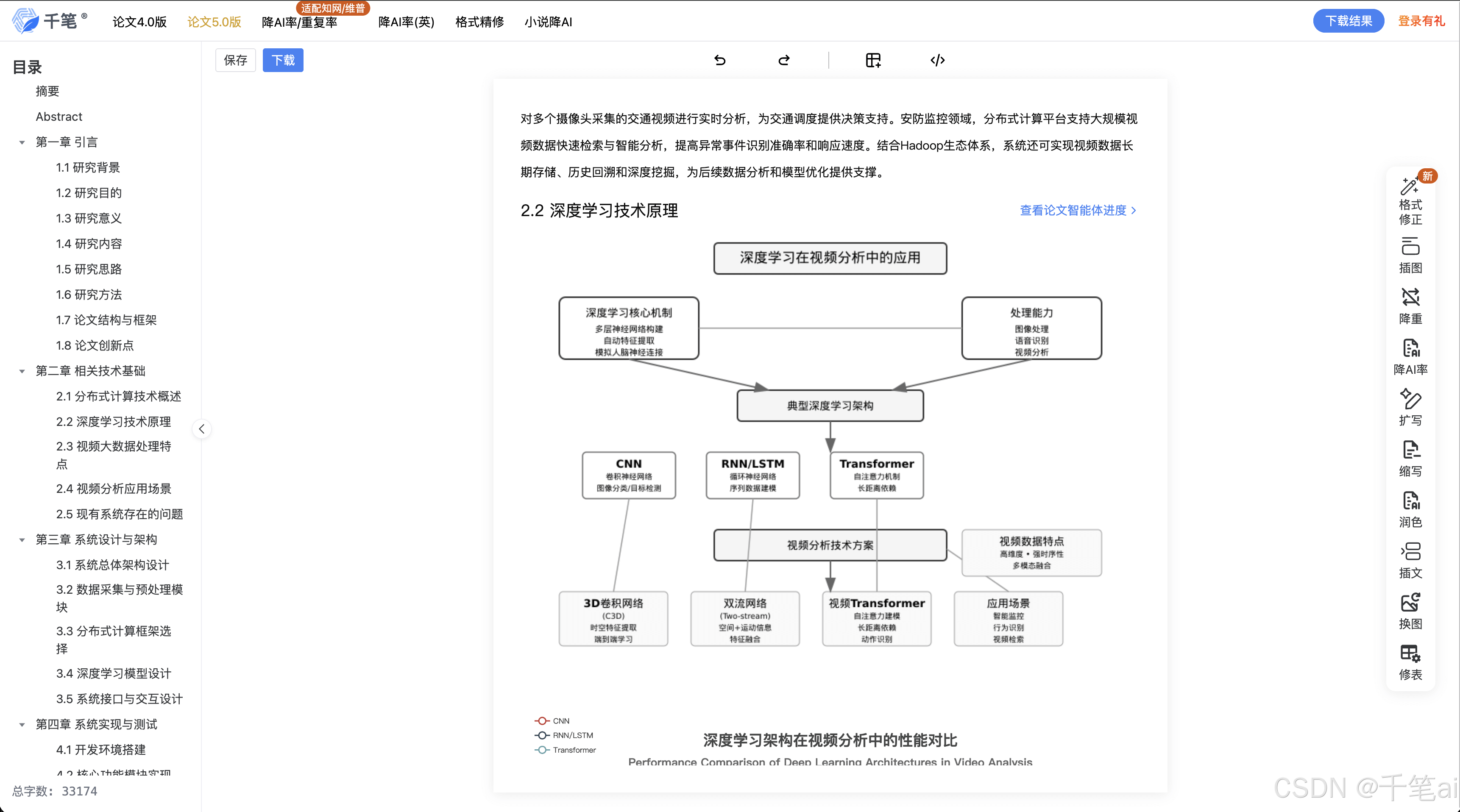

大模型的核心原理基于深度学习中的神经网络架构,特别是Transformer架构。Transformer架构由编码器和解码器组成,其中编码器负责对输入的文本进行编码,提取文本的特征表示;解码器则根据编码器的输出生成相应的文本。大模型通过在大规模文本数据上进行无监督学习,学习到语言的语法、语义和语用知识,从而具备了强大的语言理解和生成能力。

在科学理论构建推理中,大模型可以通过以下方式发挥辅助作用:

- 知识检索:大模型可以根据用户输入的问题,在其预训练的知识体系中进行检索,提供相关的科学知识和信息。

- 知识融合:大模型可以将不同来源的知识进行融合,形成更全面、更深入的知识体系,帮助科学家更好地理解和分析问题。

- 逻辑推理:大模型可以根据已知的知识和逻辑规则,进行推理和判断,为科学家提供推理建议和预测结果。

架构的文本示意图

大模型的架构可以分为输入层、隐藏层和输出层。输入层负责接收用户输入的文本信息,将其转换为模型能够处理的向量表示;隐藏层由多个Transformer块组成,每个Transformer块包含多头注意力机制和前馈神经网络,用于对输入的向量进行特征提取和变换;输出层则根据隐藏层的输出生成相应的文本。

Mermaid流程图

3. 核心算法原理 & 具体操作步骤

核心算法原理

大模型的核心算法主要基于Transformer架构中的多头注意力机制和前馈神经网络。

多头注意力机制

多头注意力机制允许模型在不同的表示子空间中并行地关注输入序列的不同部分,从而提高模型的表达能力。具体来说,多头注意力机制将输入的查询(Query)、键(Key)和值(Value)分别通过多个线性变换得到多个子查询、子键和子值,然后对每个子查询、子键和子值进行注意力计算,最后将所有注意力计算的结果拼接起来并通过一个线性变换得到最终的输出。

以下是多头注意力机制的Python代码实现:

import torch

import torch.nn as nn

class MultiHeadAttention(nn.Module):

def __init__(self, d_model, num_heads):

super(MultiHeadAttention, self).__init__()

self.d_model = d_model

self.num_heads = num_heads

self.d_k = d_model // num_heads

self.W_q = nn.Linear(d_model, d_model)

self.W_k = nn.Linear(d_model, d_model)

self.W_v = nn.Linear(d_model, d_model)

self.W_o = nn.Linear(d_model, d_model)

def scaled_dot_product_attention(self, Q, K, V, mask=None):

attn_scores = torch.matmul(Q, K.transpose(-2, -1)) / torch.sqrt(torch.tensor(self.d_k, dtype=torch.float32))

if mask is not None:

attn_scores = attn_scores.masked_fill(mask == 0, -1e9)

attn_probs = torch.softmax(attn_scores, dim=-1)

output = torch.matmul(attn_probs, V)

return output

def split_heads(self, x):

batch_size, seq_length, d_model = x.size()

return x.view(batch_size, seq_length, self.num_heads, self.d_k).transpose(1, 2)

def combine_heads(self, x):

batch_size, num_heads, seq_length, d_k = x.size()

return x.transpose(1, 2).contiguous().view(batch_size, seq_length, self.d_model)

def forward(self, Q, K, V, mask=None):

Q = self.split_heads(self.W_q(Q))

K = self.split_heads(self.W_k(K))

V = self.split_heads(self.W_v(V))

attn_output = self.scaled_dot_product_attention(Q, K, V, mask)

output = self.W_o(self.combine_heads(attn_output))

return output

前馈神经网络

前馈神经网络是大模型中的另一个重要组件,它由两个线性层和一个非线性激活函数组成。前馈神经网络的作用是对多头注意力机制的输出进行进一步的特征变换和非线性处理,提高模型的表达能力。

以下是前馈神经网络的Python代码实现:

class PositionwiseFeedForward(nn.Module):

def __init__(self, d_model, d_ff):

super(PositionwiseFeedForward, self).__init__()

self.fc1 = nn.Linear(d_model, d_ff)

self.fc2 = nn.Linear(d_ff, d_model)

self.relu = nn.ReLU()

def forward(self, x):

return self.fc2(self.relu(self.fc1(x)))

具体操作步骤

数据预处理

在使用大模型进行科学理论构建推理之前,需要对输入的数据进行预处理。数据预处理的主要步骤包括:

- 分词:将输入的文本分割成一个个单词或子词。

- 编码:将分词后的文本转换为模型能够处理的向量表示。

- 添加特殊标记:在输入的文本中添加特殊标记,如开始标记、结束标记等,以帮助模型更好地理解文本的结构。

模型训练

大模型通常采用无监督学习的方式进行训练,即在大规模文本数据上进行预训练。预训练的目标是让模型学习到语言的语法、语义和语用知识。在预训练完成后,还可以根据具体的任务需求对模型进行微调,以提高模型在特定任务上的性能。

推理过程

在推理过程中,将预处理后的输入数据输入到训练好的大模型中,模型根据输入的数据生成相应的输出。输出可以是文本、分类结果、推理建议等,具体取决于模型的任务类型。

4. 数学模型和公式 & 详细讲解 & 举例说明

多头注意力机制的数学模型和公式

缩放点积注意力

缩放点积注意力的计算公式如下:

Attention(Q,K,V)=softmax(QKTdk)V \text{Attention}(Q, K, V) = \text{softmax}(\frac{QK^T}{\sqrt{d_k}})V Attention(Q,K,V)=softmax(dkQKT)V

其中,QQQ 是查询矩阵,KKK 是键矩阵,VVV 是值矩阵,dkd_kdk 是查询和键的维度。

多头注意力

多头注意力的计算公式如下:

MultiHead(Q,K,V)=Concat(head1,⋯ ,headh)WO \text{MultiHead}(Q, K, V) = \text{Concat}(\text{head}_1, \cdots, \text{head}_h)W^O MultiHead(Q,K,V)=Concat(head1,⋯,headh)WO

其中,headi=Attention(QWiQ,KWiK,VWiV)\text{head}_i = \text{Attention}(QW_i^Q, KW_i^K, VW_i^V)headi=Attention(QWiQ,KWiK,VWiV),WiQW_i^QWiQ、WiKW_i^KWiK 和 WiVW_i^VWiV 是线性变换矩阵,WOW^OWO 是输出线性变换矩阵,hhh 是头的数量。

前馈神经网络的数学模型和公式

前馈神经网络的计算公式如下:

FFN(x)=max(0,xW1+b1)W2+b2 FFN(x) = \text{max}(0, xW_1 + b_1)W_2 + b_2 FFN(x)=max(0,xW1+b1)W2+b2

其中,W1W_1W1 和 W2W_2W2 是线性变换矩阵,b1b_1b1 和 b2b_2b2 是偏置向量。

举例说明

假设我们有一个输入序列 x=[x1,x2,x3]x = [x_1, x_2, x_3]x=[x1,x2,x3],其中每个 xix_ixi 是一个 ddd 维的向量。我们使用一个具有 h=2h = 2h=2 个头的多头注意力机制进行计算。

首先,我们将输入序列 xxx 分别通过线性变换得到查询矩阵 QQQ、键矩阵 KKK 和值矩阵 VVV:

Q=xWQ,K=xWK,V=xWV Q = xW^Q, \quad K = xW^K, \quad V = xW^V Q=xWQ,K=xWK,V=xWV

然后,我们将 QQQ、KKK 和 VVV 分别拆分成两个子查询、子键和子值:

Q1=Q[:,:,:d/2],Q2=Q[:,:,d/2:] Q_1 = Q[:, :, :d/2], \quad Q_2 = Q[:, :, d/2:] Q1=Q[:,:,:d/2],Q2=Q[:,:,d/2:]

K1=K[:,:,:d/2],K2=K[:,:,d/2:] K_1 = K[:, :, :d/2], \quad K_2 = K[:, :, d/2:] K1=K[:,:,:d/2],K2=K[:,:,d/2:]

V1=V[:,:,:d/2],V2=V[:,:,d/2:] V_1 = V[:, :, :d/2], \quad V_2 = V[:, :, d/2:] V1=V[:,:,:d/2],V2=V[:,:,d/2:]

接着,我们分别对 Q1Q_1Q1、K1K_1K1、V1V_1V1 和 Q2Q_2Q2、K2K_2K2、V2V_2V2 进行缩放点积注意力计算:

head1=Attention(Q1,K1,V1) \text{head}_1 = \text{Attention}(Q_1, K_1, V_1) head1=Attention(Q1,K1,V1)

head2=Attention(Q2,K2,V2) \text{head}_2 = \text{Attention}(Q_2, K_2, V_2) head2=Attention(Q2,K2,V2)

最后,我们将 head1\text{head}_1head1 和 head2\text{head}_2head2 拼接起来并通过一个线性变换得到最终的输出:

MultiHead(Q,K,V)=Concat(head1,head2)WO \text{MultiHead}(Q, K, V) = \text{Concat}(\text{head}_1, \text{head}_2)W^O MultiHead(Q,K,V)=Concat(head1,head2)WO

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

安装Python和相关库

首先,确保你已经安装了Python 3.7或更高版本。然后,使用以下命令安装所需的库:

pip install torch transformers numpy pandas

下载预训练模型

可以使用Hugging Face的transformers库下载预训练的大模型,例如GPT-2:

from transformers import GPT2LMHeadModel, GPT2Tokenizer

model_name = "gpt2"

tokenizer = GPT2Tokenizer.from_pretrained(model_name)

model = GPT2LMHeadModel.from_pretrained(model_name)

5.2 源代码详细实现和代码解读

以下是一个使用GPT-2模型进行文本生成的示例代码:

import torch

from transformers import GPT2LMHeadModel, GPT2Tokenizer

# 加载预训练模型和分词器

model_name = "gpt2"

tokenizer = GPT2Tokenizer.from_pretrained(model_name)

model = GPT2LMHeadModel.from_pretrained(model_name)

# 输入文本

input_text = "在物理学中,量子力学是一门重要的学科,它主要研究"

# 对输入文本进行编码

input_ids = tokenizer.encode(input_text, return_tensors="pt")

# 生成文本

output = model.generate(input_ids, max_length=100, num_beams=5, no_repeat_ngram_size=2, early_stopping=True)

# 对生成的文本进行解码

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

print(generated_text)

代码解读与分析

- 加载预训练模型和分词器:使用

transformers库的GPT2Tokenizer和GPT2LMHeadModel类加载预训练的GPT-2模型和分词器。 - 输入文本编码:使用分词器将输入文本编码为模型能够处理的输入ID。

- 文本生成:使用模型的

generate方法生成文本。max_length参数指定生成文本的最大长度,num_beams参数指定束搜索的束数,no_repeat_ngram_size参数指定不允许重复的n-gram大小,early_stopping参数指定是否在生成完成后停止搜索。 - 生成文本解码:使用分词器将生成的输入ID解码为文本。

6. 实际应用场景

物理学

在物理学中,大模型可以帮助物理学家进行理论构建和推理。例如,大模型可以根据已知的物理定律和实验数据,预测新的物理现象和理论。此外,大模型还可以帮助物理学家进行文献检索和知识融合,提高研究效率。

生物学

在生物学中,大模型可以用于基因序列分析、蛋白质结构预测等方面。例如,大模型可以根据基因序列的特征,预测基因的功能和表达调控机制。此外,大模型还可以帮助生物学家进行生物信息学数据的分析和处理,发现新的生物学规律。

化学

在化学中,大模型可以用于分子结构预测、化学反应机理研究等方面。例如,大模型可以根据分子的原子组成和化学键信息,预测分子的几何结构和物理化学性质。此外,大模型还可以帮助化学家进行化学反应的设计和优化,提高化学反应的效率和选择性。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《深度学习》(Deep Learning):由Ian Goodfellow、Yoshua Bengio和Aaron Courville撰写,是深度学习领域的经典教材。

- 《Python深度学习》(Deep Learning with Python):由Francois Chollet撰写,介绍了如何使用Python和Keras进行深度学习开发。

- 《人工智能:一种现代的方法》(Artificial Intelligence: A Modern Approach):由Stuart Russell和Peter Norvig撰写,是人工智能领域的经典教材。

7.1.2 在线课程

- Coursera上的“深度学习专项课程”(Deep Learning Specialization):由Andrew Ng教授授课,介绍了深度学习的基本概念、算法和应用。

- edX上的“人工智能导论”(Introduction to Artificial Intelligence):由麻省理工学院的Patrick Winston教授授课,介绍了人工智能的基本概念、算法和应用。

- 吴恩达老师的“机器学习”课程:在Coursera上免费开放,是机器学习领域的入门经典课程。

7.1.3 技术博客和网站

- Hugging Face的博客:提供了关于大模型和自然语言处理的最新研究成果和技术文章。

- OpenAI的博客:介绍了OpenAI在人工智能领域的最新研究成果和应用案例。

- Medium上的人工智能和机器学习相关的博客:有很多来自行业专家和研究人员的高质量文章。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:是一款专门为Python开发设计的集成开发环境,具有强大的代码编辑、调试和项目管理功能。

- Jupyter Notebook:是一个交互式的笔记本环境,适合进行数据探索、模型训练和代码演示。

- Visual Studio Code:是一款轻量级的代码编辑器,支持多种编程语言和插件扩展。

7.2.2 调试和性能分析工具

- PyTorch Profiler:是PyTorch提供的性能分析工具,可以帮助开发者分析模型的性能瓶颈和资源使用情况。

- TensorBoard:是TensorFlow提供的可视化工具,可以帮助开发者可视化模型的训练过程和性能指标。

- VS Code的调试器:可以帮助开发者调试Python代码,提高开发效率。

7.2.3 相关框架和库

- PyTorch:是一个开源的深度学习框架,具有动态图和静态图两种模式,适合进行研究和开发。

- TensorFlow:是一个开源的深度学习框架,具有强大的分布式训练和部署能力,适合进行工业级应用开发。

- Transformers:是Hugging Face开发的一个自然语言处理库,提供了多种预训练的大模型和工具,方便开发者进行自然语言处理任务的开发。

7.3 相关论文著作推荐

7.3.1 经典论文

- 《Attention Is All You Need》:介绍了Transformer架构,是大模型领域的经典论文。

- 《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》:介绍了BERT模型,是自然语言处理领域的重要突破。

- 《Generative Pretrained Transformer 3》:介绍了GPT-3模型,展示了大模型在语言生成任务上的强大能力。

7.3.2 最新研究成果

- 《Large Language Models Are Zero-Shot Reasoners》:研究了大模型在零样本推理任务上的表现。

- 《Scaling Laws for Neural Language Models》:探讨了大模型的缩放规律和性能提升方法。

- 《Training Language Models to Follow Instructions with Human Feedback》:介绍了使用人类反馈进行模型训练的方法。

7.3.3 应用案例分析

- 《Using Large Language Models for Scientific Discovery》:介绍了大模型在科学发现中的应用案例。

- 《Applying AI to Accelerate Drug Discovery》:展示了大模型在药物研发中的应用。

- 《AI in Physics: A Review》:综述了大模型在物理学中的应用现状和发展趋势。

8. 总结:未来发展趋势与挑战

未来发展趋势

- 模型规模不断扩大:随着计算能力的不断提升和数据量的不断增加,大模型的规模将不断扩大,其性能和表达能力也将不断提高。

- 多模态融合:大模型将不仅仅局限于处理文本数据,还将融合图像、音频、视频等多种模态的数据,实现更加全面和深入的信息处理。

- 科学领域的广泛应用:大模型将在物理学、生物学、化学等科学领域得到更广泛的应用,为科学研究提供更强大的工具和支持。

- 与人类智能的协同:大模型将与人类智能实现更加紧密的协同,发挥各自的优势,共同推动科学进步和社会发展。

挑战

- 计算资源需求大:大模型的训练和推理需要大量的计算资源,这对硬件设备和能源消耗提出了巨大的挑战。

- 数据质量和隐私问题:大模型的性能高度依赖于训练数据的质量和规模,同时数据隐私和安全问题也需要得到重视。

- 可解释性和可靠性:大模型的决策过程往往是黑盒的,缺乏可解释性和可靠性,这在一些关键领域的应用中可能会带来风险。

- 伦理和社会影响:大模型的广泛应用可能会带来一系列的伦理和社会问题,如就业结构变化、信息传播偏见等,需要我们进行深入的研究和探讨。

9. 附录:常见问题与解答

大模型在科学理论构建推理中的准确性如何保证?

大模型的准确性可以通过以下方式保证:

- 高质量的训练数据:使用经过筛选和标注的高质量数据进行训练,确保模型学习到准确的知识和模式。

- 模型评估和优化:使用多种评估指标对模型进行评估,并通过不断调整模型的参数和结构来优化模型的性能。

- 人工验证和修正:在实际应用中,对模型的输出结果进行人工验证和修正,确保结果的准确性和可靠性。

大模型在科学研究中的应用是否会取代科学家?

大模型在科学研究中的应用不会取代科学家,而是作为科学家的辅助工具,帮助科学家提高研究效率和发现新的科学规律。科学家仍然需要具备深厚的专业知识、创新能力和批判性思维,才能进行高质量的科学研究。

如何选择适合科学理论构建推理的大模型?

选择适合科学理论构建推理的大模型需要考虑以下因素:

- 模型的性能:选择在相关任务上表现优异的模型。

- 模型的可扩展性:选择具有良好可扩展性的模型,以便在未来能够进行进一步的优化和改进。

- 模型的易用性:选择易于使用和集成的模型,降低开发成本和难度。

- 模型的开放性:选择具有开放源代码和API的模型,方便进行二次开发和定制。

10. 扩展阅读 & 参考资料

- Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep Learning. MIT Press.

- Chollet, F. (2017). Deep Learning with Python. Manning Publications.

- Russell, S. J., & Norvig, P. (2010). Artificial Intelligence: A Modern Approach. Prentice Hall.

- Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N.,… & Polosukhin, I. (2017). Attention is all you need. In Advances in neural information processing systems (pp. 5998-6008).

- Devlin, J., Chang, M. W., Lee, K., & Toutanova, K. (2018). Bert: Pre-training of deep bidirectional transformers for language understanding. arXiv preprint arXiv:1810.04805.

- Brown, T. B., Mann, B., Ryder, N., Subbiah, M., Kaplan, J., Dhariwal, P.,… & Amodei, D. (2020). Language models are few-shot learners. arXiv preprint arXiv:2005.14165.

作者:AI天才研究院/AI Genius Institute & 禅与计算机程序设计艺术 /Zen And The Art of Computer Programming

更多推荐

已为社区贡献191条内容

已为社区贡献191条内容

所有评论(0)