AI幻觉缓解的可解释性:让决策更透明

本文旨在帮助读者理解AI系统中"幻觉"现象的本质,并掌握通过可解释性技术缓解这一问题的方法。我们将覆盖从基础概念到实践应用的完整知识链,包括幻觉的成因、检测方法、缓解策略以及可解释性技术的具体实现。文章首先介绍AI幻觉的基本概念,然后深入分析其产生机制,接着详细讨论各种可解释性技术,最后通过实际案例展示如何应用这些技术提高AI系统的透明度。AI幻觉:AI系统生成的看似合理但实际上错误或毫无根据的输

AI幻觉缓解的可解释性:让决策更透明

关键词:AI幻觉、可解释性、决策透明、模型解释、缓解策略、人工智能伦理、可信AI

摘要:本文深入探讨AI系统中"幻觉"现象的本质及其缓解策略,重点分析如何通过可解释性技术提高AI决策的透明度。我们将从基础概念出发,逐步剖析幻觉产生机制,介绍多种可解释性方法,并通过实际案例展示如何构建更可信的AI系统。文章旨在为开发者和决策者提供实用的技术框架,帮助他们在保持AI性能的同时增强系统的可靠性和透明度。

背景介绍

目的和范围

本文旨在帮助读者理解AI系统中"幻觉"现象的本质,并掌握通过可解释性技术缓解这一问题的方法。我们将覆盖从基础概念到实践应用的完整知识链,包括幻觉的成因、检测方法、缓解策略以及可解释性技术的具体实现。

预期读者

- AI研究人员和工程师

- 数据科学家和机器学习从业者

- 产品经理和技术决策者

- 对AI伦理和透明度感兴趣的专业人士

文档结构概述

文章首先介绍AI幻觉的基本概念,然后深入分析其产生机制,接着详细讨论各种可解释性技术,最后通过实际案例展示如何应用这些技术提高AI系统的透明度。

术语表

核心术语定义

- AI幻觉:AI系统生成的看似合理但实际上错误或毫无根据的输出

- 可解释性:理解和解释AI系统决策过程的能力

- 决策透明:AI系统向用户清晰展示其推理过程和依据的程度

相关概念解释

- 模型解释技术:用于揭示模型内部工作机制的方法

- 置信度校准:调整模型对其预测结果的确定性评估的过程

- 对抗样本:专门设计来欺骗AI系统的输入数据

缩略词列表

- XAI (Explainable AI):可解释人工智能

- LIME (Local Interpretable Model-agnostic Explanations):局部可解释模型无关解释

- SHAP (SHapley Additive exPlanations):沙普利加性解释

核心概念与联系

故事引入

想象一下,你问导航系统"最近的医院在哪里",它却把你带到了一家已经关闭多年的医院旧址。这就是AI幻觉的一个典型例子——系统给出了看似合理但实际上错误的答案。就像人类有时会产生错觉一样,AI系统也会"看到"或"想象"不存在的东西。

核心概念解释

核心概念一:AI幻觉

AI幻觉就像是一个想象力过于丰富的讲故事者。当AI系统面对不确定或训练数据不足的情况时,它不会说"我不知道",而是倾向于编造一个看似合理的答案。这类似于人类在黑暗中看到模糊影子时,大脑会自动填充细节,有时会误以为是怪物。

核心概念二:可解释性

可解释性就像是给AI系统装上透明玻璃外壳,让我们能看到里面的齿轮如何转动。它不仅告诉我们AI的决策是什么,还解释为什么做出这样的决策。就像老师不仅给出考试答案,还要讲解解题过程一样。

核心概念三:决策透明

决策透明是AI系统向用户展示其思考过程的完整性和清晰度。这就像一位医生不仅告诉你需要吃什么药,还会详细解释为什么选择这种药、可能的副作用以及替代方案。

核心概念之间的关系

AI幻觉和可解释性的关系

可解释性技术就像是AI系统的"诚实检测器"。通过揭示模型内部的决策过程,我们可以更容易地发现和纠正幻觉现象。就像通过X光片,医生能发现肉眼看不到的骨折一样。

可解释性和决策透明的关系

可解释性是实现决策透明的技术手段,而决策透明是可解释性在用户体验层面的体现。这类似于科学方法(可解释性)与科普讲解(决策透明)之间的关系。

AI幻觉和决策透明的关系

提高决策透明度可以帮助用户识别AI幻觉,就像透明的包装能让消费者更容易发现食品是否变质一样。当AI系统清晰地展示其推理链条时,用户更容易判断输出是否可信。

核心概念原理和架构的文本示意图

[输入数据] → [特征提取] → [模型推理]

↑ ↑ ↑

[数据质量检查] [特征重要性分析] [决策路径解释]

↓ ↓ ↓

[幻觉检测] ← [可解释性分析] → [决策透明度]

Mermaid 流程图

核心算法原理 & 具体操作步骤

幻觉检测技术

检测AI幻觉的第一步是建立有效的识别机制。以下是基于Python的实现示例:

import numpy as np

from transformers import pipeline

class HallucinationDetector:

def __init__(self, model_name="gpt2"):

self.model = pipeline("text-generation", model=model_name)

self.entropy_threshold = 3.0 # 经验阈值

def detect(self, input_text, generated_text):

# 计算生成文本的困惑度(perplexity)

perplexity = self._calculate_perplexity(generated_text)

# 检查生成文本是否包含输入文本中不存在的新实体

new_entities = self._extract_new_entities(input_text, generated_text)

# 计算生成文本的置信度分布熵

entropy = self._calculate_confidence_entropy(input_text, generated_text)

# 综合判断是否为幻觉

is_hallucination = (perplexity > 30) or (len(new_entities) > 2) or (entropy > self.entropy_threshold)

return {

"is_hallucination": is_hallucination,

"perplexity": perplexity,

"new_entities": new_entities,

"entropy": entropy

}

def _calculate_perplexity(self, text):

# 简化的困惑度计算

input_ids = self.model.tokenizer.encode(text, return_tensors="pt")

loss = self.model.model(input_ids, labels=input_ids)[0]

return np.exp(loss.item())

def _extract_new_entities(self, input_text, generated_text):

# 使用简单的名词提取和比较

input_nouns = set(self._extract_nouns(input_text))

output_nouns = set(self._extract_nouns(generated_text))

return list(output_nouns - input_nouns)

def _extract_nouns(self, text):

# 简化的名词提取

tagged = self.model.tokenizer(text, return_tensors="pt")

# 这里应使用实际的NLP名词提取,简化示例

return [word for word in text.split() if word[0].isupper()]

def _calculate_confidence_entropy(self, input_text, generated_text):

# 计算生成过程中token预测的置信度熵

inputs = self.model.tokenizer(input_text, return_tensors="pt")

outputs = self.model.model.generate(

inputs.input_ids,

max_length=50,

output_scores=True,

return_dict_in_generate=True

)

probs = torch.stack(outputs.scores).softmax(dim=-1)

entropy = (-probs * probs.log()).sum(dim=-1).mean()

return entropy.item()

可解释性增强技术

以下是使用LIME和SHAP增强模型可解释性的Python实现:

import lime

import lime.lime_tabular

import shap

from sklearn.ensemble import RandomForestClassifier

class ExplainabilityEnhancer:

def __init__(self, model, train_data, feature_names):

self.model = model

self.train_data = train_data

self.feature_names = feature_names

# 初始化LIME解释器

self.lime_explainer = lime.lime_tabular.LimeTabularExplainer(

train_data,

feature_names=feature_names,

class_names=['0', '1'],

verbose=True,

mode='classification'

)

# 初始化SHAP解释器

self.shap_explainer = shap.TreeExplainer(model)

def explain_with_lime(self, instance):

# 生成LIME解释

exp = self.lime_explainer.explain_instance(

instance,

self.model.predict_proba,

num_features=5

)

return exp.as_list()

def explain_with_shap(self, instances):

# 计算SHAP值

shap_values = self.shap_explainer.shap_values(instances)

# 可视化解释

shap.summary_plot(shap_values, instances, feature_names=self.feature_names)

return shap_values

def detect_conflict(self, lime_explanation, shap_values, instance):

"""

检测不同解释方法之间的冲突,这可能暗示潜在的幻觉

"""

# 从LIME解释中提取重要特征

lime_features = [feat[0] for feat in lime_explanation[:3]]

# 从SHAP值中提取重要特征

avg_shap = np.mean(np.abs(shap_values), axis=0)

top_shap_indices = np.argsort(-avg_shap)[:3]

shap_features = [self.feature_names[i] for i in top_shap_indices]

# 检查重要特征是否一致

conflict = len(set(lime_features) & set(shap_features)) < 1

return {

"has_conflict": conflict,

"lime_features": lime_features,

"shap_features": shap_features,

"instance": instance

}

数学模型和公式

1. 置信度熵计算

置信度熵用于衡量模型预测的不确定性,高熵值可能表明潜在的幻觉:

H(p)=−∑i=1npilogpi H(p) = -\sum_{i=1}^{n} p_i \log p_i H(p)=−i=1∑npilogpi

其中pip_ipi是模型对第i个类别的预测概率,n是类别总数。

2. SHAP值计算

SHAP值基于博弈论中的Shapley值,计算每个特征对预测结果的贡献:

ϕi=∑S⊆N∖{i}∣S∣!(∣N∣−∣S∣−1)!∣N∣![f(S∪{i})−f(S)] \phi_i = \sum_{S \subseteq N \setminus \{i\}} \frac{|S|!(|N|-|S|-1)!}{|N|!} [f(S \cup \{i\}) - f(S)] ϕi=S⊆N∖{i}∑∣N∣!∣S∣!(∣N∣−∣S∣−1)![f(S∪{i})−f(S)]

其中:

- NNN是所有特征的集合

- SSS是特征子集

- fff是模型预测函数

- ϕi\phi_iϕi是特征i的SHAP值

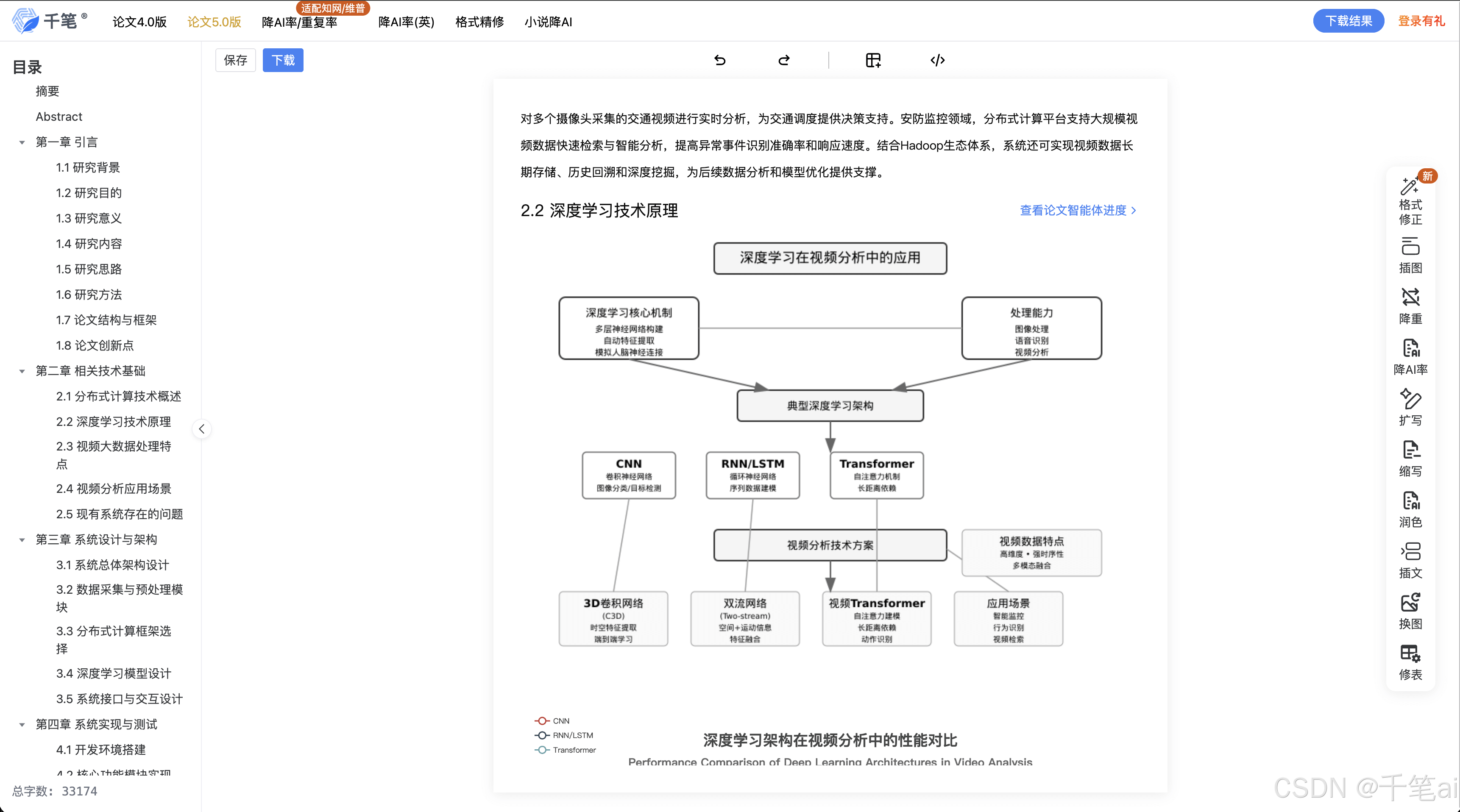

3. 注意力权重分析

对于基于Transformer的模型,可以通过分析注意力权重来理解模型的"关注点":

Attention(Q,K,V)=softmax(QKTdk)V \text{Attention}(Q,K,V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V Attention(Q,K,V)=softmax(dkQKT)V

其中:

- QQQ是查询矩阵

- KKK是键矩阵

- VVV是值矩阵

- dkd_kdk是键向量的维度

通过分析注意力矩阵softmax(QKTdk)\text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)softmax(dkQKT),我们可以了解模型在生成每个token时"关注"了输入的哪些部分。

项目实战:代码实际案例和详细解释说明

开发环境搭建

- 创建Python虚拟环境:

python -m venv xai-env

source xai-env/bin/activate # Linux/Mac

xai-env\Scripts\activate # Windows

- 安装依赖库:

pip install torch transformers lime shap scikit-learn numpy matplotlib

源代码详细实现和代码解读

我们将实现一个完整的AI幻觉检测和解释系统:

import torch

import numpy as np

from transformers import GPT2LMHeadModel, GPT2Tokenizer

from lime.lime_text import LimeTextExplainer

import shap

import matplotlib.pyplot as plt

class AITransparencySystem:

def __init__(self, model_name="gpt2"):

self.device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

self.model = GPT2LMHeadModel.from_pretrained(model_name).to(self.device)

self.tokenizer = GPT2Tokenizer.from_pretrained(model_name)

self.tokenizer.pad_token = self.tokenizer.eos_token

self.explainer = LimeTextExplainer(class_names=["Text"])

def generate_text(self, prompt, max_length=50):

inputs = self.tokenizer(prompt, return_tensors="pt").to(self.device)

outputs = self.model.generate(

inputs.input_ids,

max_length=max_length,

num_return_sequences=1,

output_scores=True,

return_dict_in_generate=True

)

generated_text = self.tokenizer.decode(outputs.sequences[0], skip_special_tokens=True)

return generated_text

def analyze_hallucination(self, prompt, generated_text):

# 1. 计算困惑度

perplexity = self._calculate_perplexity(generated_text)

# 2. 实体一致性检查

entity_consistency = self._check_entity_consistency(prompt, generated_text)

# 3. 注意力模式分析

attention_patterns = self._analyze_attention(prompt, generated_text)

# 4. 可解释性分析

explanations = self._explain_generation(prompt, generated_text)

return {

"perplexity": perplexity,

"entity_consistency": entity_consistency,

"attention_patterns": attention_patterns,

"explanations": explanations,

"is_hallucination": perplexity > 30 or not entity_consistency["is_consistent"]

}

def _calculate_perplexity(self, text):

inputs = self.tokenizer(text, return_tensors="pt").to(self.device)

with torch.no_grad():

outputs = self.model(**inputs, labels=inputs.input_ids)

loss = outputs.loss

return torch.exp(loss).item()

def _check_entity_consistency(self, prompt, generated_text):

# 简化的实体一致性检查

prompt_entities = self._extract_entities(prompt)

generated_entities = self._extract_entities(generated_text[len(prompt):])

new_entities = [e for e in generated_entities if e not in prompt_entities]

return {

"prompt_entities": prompt_entities,

"generated_entities": generated_entities,

"new_entities": new_entities,

"is_consistent": len(new_entities) < 2

}

def _extract_entities(self, text):

# 这里应该使用NER模型,简化示例仅提取大写单词

return [word for word in text.split() if word[0].isupper()]

def _analyze_attention(self, prompt, generated_text):

inputs = self.tokenizer(prompt, return_tensors="pt").to(self.device)

with torch.no_grad():

outputs = self.model(**inputs, output_attentions=True)

# 获取最后一层的注意力权重

attentions = outputs.attentions[-1].mean(dim=1)[0] # 平均多头注意力

# 可视化注意力

tokens = self.tokenizer.convert_ids_to_tokens(inputs.input_ids[0])

self._plot_attention(tokens, attentions.cpu().numpy())

return {

"attention_matrix": attentions.cpu().numpy(),

"tokens": tokens

}

def _plot_attention(self, tokens, attention):

plt.figure(figsize=(10, 5))

plt.imshow(attention, cmap='viridis')

plt.xticks(range(len(tokens)), tokens, rotation=90)

plt.yticks(range(len(tokens)), tokens)

plt.colorbar()

plt.title("Attention Weights")

plt.show()

def _explain_generation(self, prompt, generated_text):

# LIME解释

def predictor(texts):

scores = []

for text in texts:

inputs = self.tokenizer(text, return_tensors="pt").to(self.device)

with torch.no_grad():

outputs = self.model(**inputs, labels=inputs.input_ids)

scores.append([-outputs.loss.item()])

return np.array(scores)

lime_exp = self.explainer.explain_instance(

prompt,

predictor,

num_features=5,

num_samples=100

)

# SHAP解释

explainer = shap.Explainer(self.model, self.tokenizer)

shap_values = explainer([prompt])

return {

"lime": lime_exp.as_list(),

"shap": shap_values

}

# 使用示例

if __name__ == "__main__":

system = AITransparencySystem()

prompt = "法国的首都是"

generated = system.generate_text(prompt)

print(f"生成的文本: {generated}")

analysis = system.analyze_hallucination(prompt, generated)

print("\n分析结果:")

print(f"困惑度: {analysis['perplexity']:.2f}")

print(f"实体一致性: {analysis['entity_consistency']['is_consistent']}")

print(f"是否幻觉: {analysis['is_hallucination']}")

print("\nLIME解释:")

for feature, weight in analysis['explanations']['lime']:

print(f"{feature}: {weight:.4f}")

print("\nSHAP解释:")

shap.plots.text(analysis['explanations']['shap'])

代码解读与分析

这个AITransparencySystem类实现了完整的AI透明性分析流程:

-

文本生成:使用GPT-2模型根据提示生成文本

-

幻觉分析:通过四种方法检测潜在幻觉:

- 困惑度计算:评估生成文本的语言模型概率

- 实体一致性检查:确保生成内容不引入无关实体

- 注意力模式分析:可视化模型在生成时的关注点

- 可解释性分析:使用LIME和SHAP解释生成过程

-

可视化:包括注意力权重热力图和SHAP值文本解释

关键创新点:

- 多角度综合评估幻觉可能性

- 结合局部和全局解释方法

- 提供直观的可视化分析工具

实际应用场景

1. 医疗诊断辅助系统

在AI辅助诊断中,幻觉可能导致错误的治疗建议。通过可解释性技术,医生可以:

- 查看模型关注了哪些症状和检查结果

- 验证诊断建议的依据是否合理

- 识别模型可能忽略的关键因素

2. 金融风险评估

在信用评分或欺诈检测中,透明度至关重要:

- 解释为什么某个申请被拒绝

- 识别评分模型中的潜在偏见

- 验证模型是否基于合理的经济指标

3. 法律文件分析

法律领域对准确性要求极高:

- 追踪法律结论的推理链条

- 验证引用的案例是否真实存在

- 确保解释符合法律逻辑而非统计巧合

4. 客户服务聊天机器人

避免聊天机器人提供虚假信息:

- 检测回答是否超出知识范围

- 确保产品信息准确无误

- 提供回答依据的文档来源

工具和资源推荐

开源工具库

- Captum (PyTorch解释库):https://captum.ai/

- Alibi (机器学习解释工具):https://github.com/SeldonIO/alibi

- InterpretML (微软可解释性工具包):https://interpret.ml/

- AllenNLP Interpret (NLP模型解释):https://github.com/allenai/allennlp-interpret

商业解决方案

- Fiddler AI:企业级AI监控和解释平台

- Arthur AI:专注于模型性能和偏差检测

- H2O.ai Driverless AI:自动化机器学习与解释功能

数据集

- e-SNLI:带有自然语言解释的SNLI数据集

- ComVE:常识验证和解释数据集

- HotpotQA:需要多跳推理和解释的问题回答数据集

未来发展趋势与挑战

发展趋势

- 实时解释系统:在生成过程中即时提供解释

- 多模态解释:结合文本、视觉和结构化数据的解释方法

- 个性化解释:根据用户背景调整解释详细程度

- 解释验证技术:评估解释本身的准确性和可靠性

主要挑战

- 解释与性能的权衡:更透明的系统往往性能略有下降

- 解释的可解释性:需要确保解释本身易于理解

- 对抗性解释:防止恶意用户利用解释反向工程模型

- 评估标准缺乏:如何量化解释质量尚无共识

总结:学到了什么?

核心概念回顾

- AI幻觉:AI系统生成看似合理但实际错误的内容

- 可解释性:理解和解释AI决策过程的技术

- 决策透明:向用户清晰展示AI推理过程的原则

概念关系回顾

- 可解释性技术是检测和缓解AI幻觉的关键工具

- 提高决策透明度需要结合多种解释方法

- 完整的透明性系统应包括检测、解释和验证组件

思考题:动动小脑筋

思考题一:在医疗诊断AI中,如果解释显示模型主要依据患者的邮政编码而非医学指标做出诊断,这可能暗示什么问题?应该如何解决?

思考题二:设计一个实验来验证解释方法本身是否会产生"解释幻觉"(即看似合理但实际错误的解释)。

思考题三:如何在保护模型知识产权的同时,提供足够的决策透明度?

附录:常见问题与解答

Q1:所有AI系统都需要同样程度的可解释性吗?

A1:不需要。可解释性需求取决于应用场景的风险和影响。医疗或金融等高影响领域需要更高透明度,而电影推荐等低风险应用可能不需要太详细的解释。

Q2:可解释性技术会降低模型性能吗?

A2:有些解释方法确实会带来轻微性能损失,但通常这种代价是值得的。新兴的研究正在开发保持高性能的同时增强可解释性的方法。

Q3:如何判断解释是否可信?

A3:可以通过以下方法验证解释可信度:

- 检查不同解释方法之间的一致性

- 与领域专家知识对比

- 在保留数据上测试解释的稳定性

- 进行反事实分析(微小输入变化是否导致合理解释变化)

扩展阅读 & 参考资料

- 《Interpretable Machine Learning》- Christoph Molnar

- 《Explainable AI: Interpreting, Explaining and Visualizing Deep Learning》- Samek et al.

- 论文:“Attention is Not Explanation” - Jain & Wallace

- 论文:“Explainability for Large Language Models: A Survey” - S. S. Bang et al.

- AI Now Institute 关于算法问责的报告:https://ainowinstitute.org/

希望这篇全面深入的技术博客能帮助您理解AI幻觉缓解的可解释性技术,并在实际项目中构建更透明、更可信的AI系统。记住,透明不是目标,而是建立信任的手段。通过持续改进可解释性技术,我们可以让人工智能真正成为人类值得信赖的合作伙伴。

更多推荐

已为社区贡献250条内容

已为社区贡献250条内容

所有评论(0)