本地部署大模型:新手友好,数据隐私有保障

本文介绍了本地部署大模型的核心优势,如数据隐私、零成本使用、离线可用等,并详细对比了LM Studio、Ollama和Open WebUI等主流本地部署工具。推荐LM Studio因其可视化界面简单易用,适合新手快速入门。文章还提供了LM Studio的安装、模型下载、启动及对话步骤,并分享了性能优化建议和常见问题解答。最后,介绍了如何通过LM Studio调用本地模型的OpenAI兼容API接口

本文介绍了本地部署大模型的核心优势,如数据隐私、零成本使用、离线可用等,并详细对比了LM Studio、Ollama和Open WebUI等主流本地部署工具。推荐LM Studio因其可视化界面简单易用,适合新手快速入门。文章还提供了LM Studio的安装、模型下载、启动及对话步骤,并分享了性能优化建议和常见问题解答。最后,介绍了如何通过LM Studio调用本地模型的OpenAI兼容API接口,为AI应用开发奠定基础。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

为什么选择本地部署?

本地部署大模型的核心优势:

- 数据隐私:所有数据本地处理,无隐私泄露风险

- 零成本使用:无需API密钥,一次部署无限使用

- 离线可用:摆脱网络依赖

- 完全控制:自定义参数和配置

硬件要求

- 内存:16GB以上(推荐32GB)

- 显卡:NVIDIA RTX 3060+(可选,显著提升性能)

- 存储:50GB+ 可用空间

为什么选择 LM Studio?

对比主流本地部署工具:

| 工具 | 特点 | 适合场景 |

|---|---|---|

| LM Studio | 可视化界面,操作简单 | 学习入门、快速部署 |

| Ollama | 命令行工具,轻量级 | 开发者、服务器部署 |

| Open WebUI | Web界面,功能丰富 | 团队协作、高级用户 |

LM Studio 是学习的最佳选择:图形化界面、即装即用、模型管理简单。

快速安装步骤

1. 下载安装

- 访问官网:https://lmstudio.ai/

- 下载对应系统版本

- 按向导完成安装

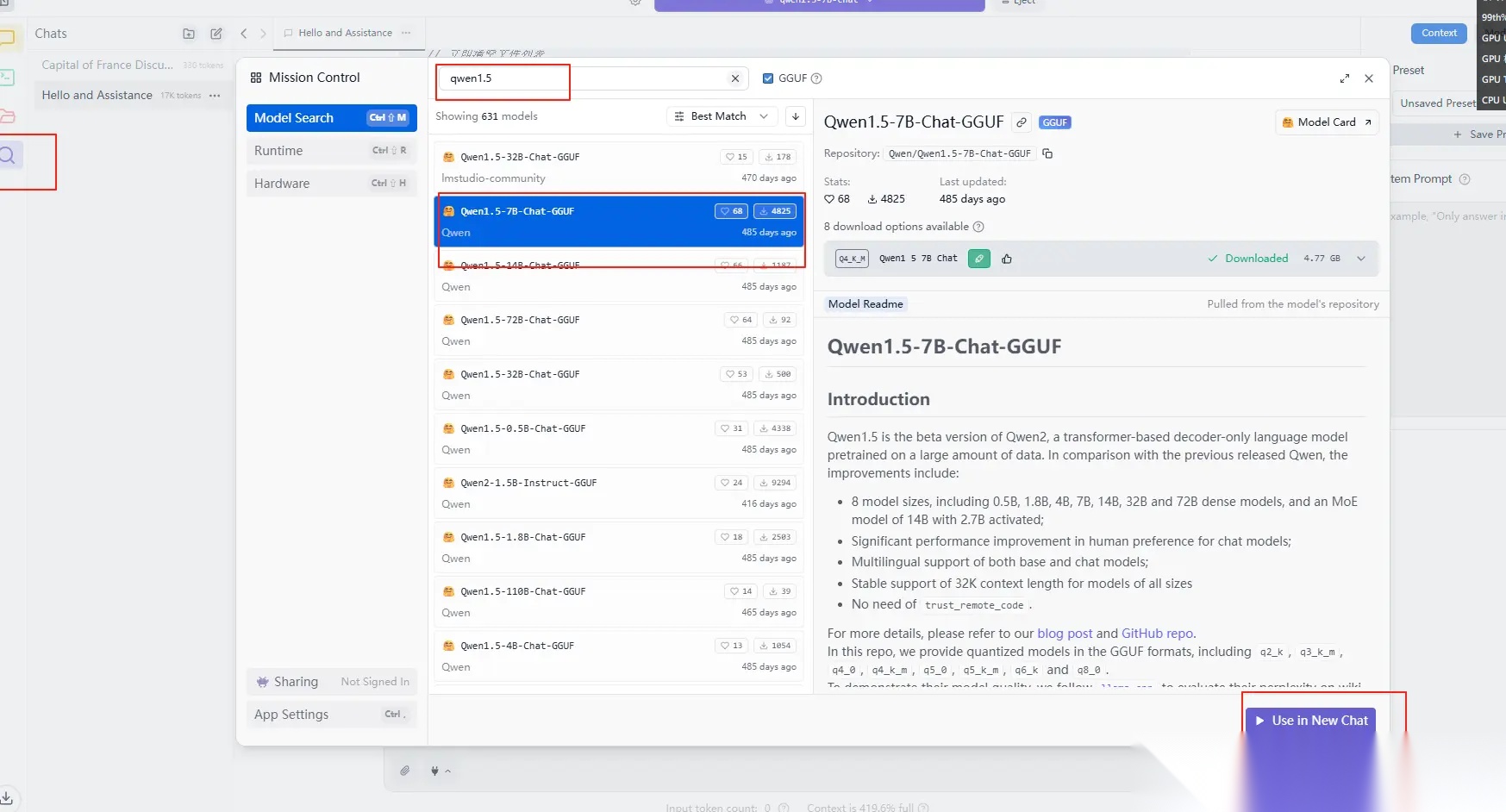

2. 下载模型

推荐入门模型:

- Qwen1.5-7B-Chat:中文能力强,适合国内用户

- Mistral 7B:性能均衡

- Phi-3-Mini:体积小巧

以 Qwen1.5-7B-Chat 为例:

- 在模型市场搜索 “qwen1.5-7b-chat”

-

点击下载(文件较大,请耐心等待)

-

下载完成后在 “Local” 标签页找到模型

3. 启动模型

- 找到下载的 Qwen1.5-7B-Chat 模型

4. 开始对话

- 切换到 “Chat” 标签页

- 确认右上角显示已加载模型

- 输入问题,开始与本地大模型对话

5 本地服务调用 图标右键,选择 “Start server 1234”

性能优化建议

- 启用GPU加速:有独显的用户务必开启

- 调整内存设置:根据系统内存合理分配

- 关闭无关程序:释放更多资源给模型

常见问题

Q: 模型启动失败? A: 检查内存是否充足,尝试选择更小的模型

Q: 响应速度慢? A: 确认GPU加速已开启,关闭后台程序释放资源

Q: 想要更好的中文效果? A: 推荐 ChatGLM、Baichuan 等中文优化模型

调用本地模型API

LM Studio 启动模型后,会在本地 1234 端口提供 OpenAI 兼容的API接口。

环境准备

install 028

注意:使用 0.28 版本的 openai 库,新版本语法有变化。

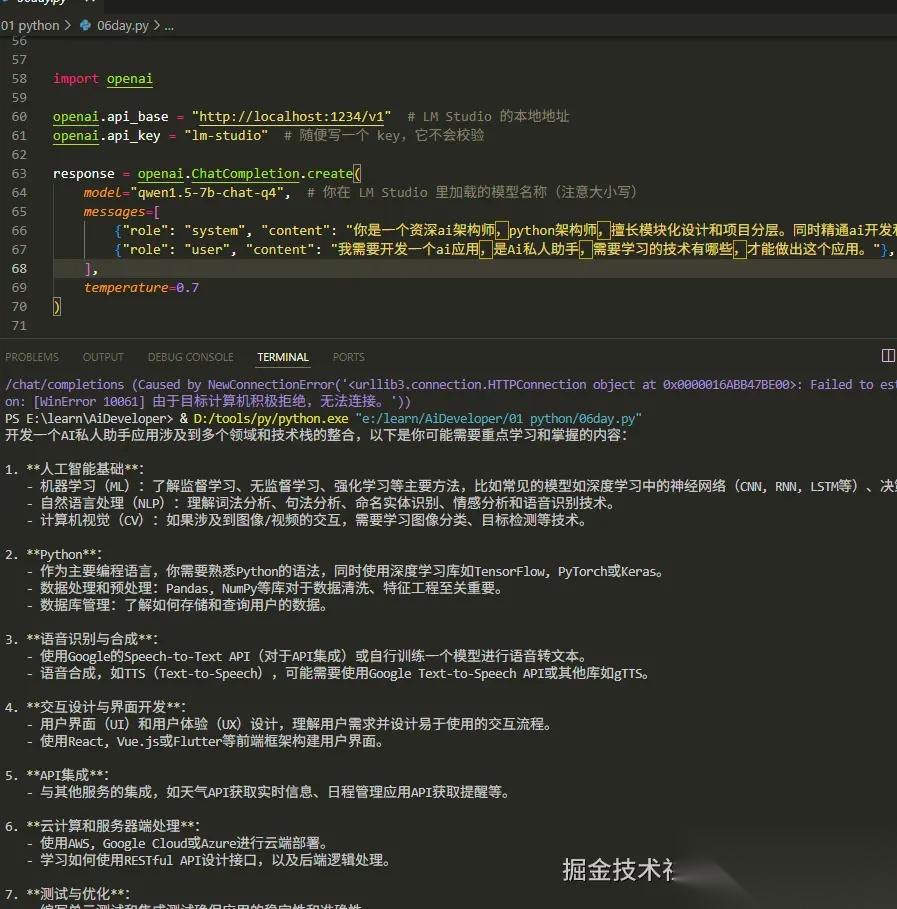

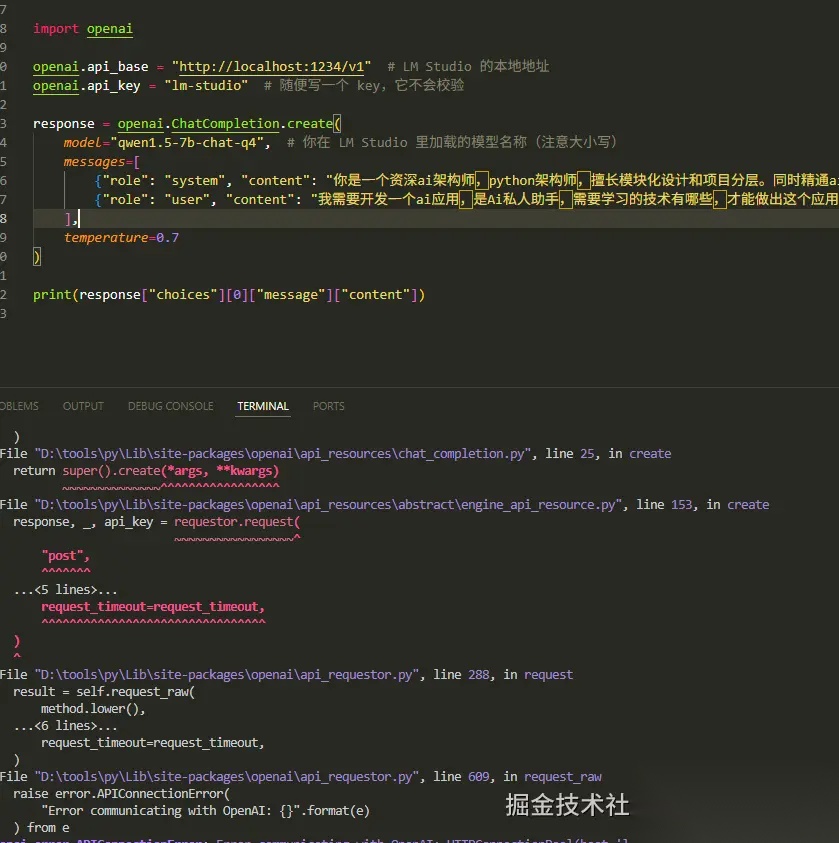

调用示例

import# 配置本地API地址"http://localhost:1234/v1"# LM Studio 默认端口"lm-studio"# 随便写,不会校验# 调用模型"qwen1.5-7b-chat-q4"# 你在 LM Studio 里加载的模型名称"role""system""content""你是一个资深ai架构师,python架构师,擅长模块化设计和项目分层。同时精通ai开发和应用。你乐于助人,回答的问题要详细且专业。会把技术每个细节都讲解清楚。""role""user""content""我需要开发一个ai应用,是Ai私人助手,需要学习的技术有哪些,才能做出这个应用。"0.7print"choices"0"message""content"

结果返回

错误分析:如果看见这个,说明服务没起来,找到图标,启动服务。

关键配置说明

- api_base:本地服务地址,默认

http://localhost:1234/v1 - api_key:可以随意填写,LM Studio 不会验证

- model:必须与 LM Studio 中加载的模型名称完全一致(注意大小写)

- 切换到 OpenAI:只需修改

api_base和api_key即可

这样就实现了从本地部署到API调用的完整流程,为AI应用开发奠定了基础。

总结

通过 LM Studio + OpenAI API 的组合,我们可以快速搭建本地AI开发环境。这种方式既保证了数据隐私,又提供了与 OpenAI 完全兼容的接口,让AI应用开发变得更加灵活和经济。

读者福利:倘若大家对大模型感兴趣,那么这套大模型学习资料一定对你有用。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献158条内容

已为社区贡献158条内容

所有评论(0)