python的scrapy框架介绍

在Scrapy项目中,爬虫是用于定义如何爬取特定网站的类。在项目的spiders目录中,可以创建一个新的Python文件来定义你的爬虫。下面是一个简单的示例:代码语言:javascriptAI代码解释# 在这里处理网页响应,提取数据等pass在上面的示例中,我们定义了一个名为MySpider的爬虫,指定了名称为example,并指定了起始URL为。在parse方法中,你可以处理网页响应,并提取你需

1.安装Scrapy:

首先,确保已在Python环境中安装了pip(Python包管理器)。然后,可以使用以下命令在命令行中安装Scrapy:

代码语言:javascript

AI代码解释

pip install scrapy2.创建Scrapy项目:

在命令行中,使用以下命令创建一个新的Scrapy项目:

代码语言:javascript

AI代码解释

scrapy startproject project_name这将在当前目录下创建一个名为project_name的文件夹,其中包含Scrapy项目的基本结构。

3.定义爬虫:

在Scrapy项目中,爬虫是用于定义如何爬取特定网站的类。在项目的spiders目录中,可以创建一个新的Python文件来定义你的爬虫。下面是一个简单的示例:

代码语言:javascript

AI代码解释

import scrapy

class MySpider(scrapy.Spider):

name = 'example'

start_urls = ['http://www.example.com']

def parse(self, response):

# 在这里处理网页响应,提取数据等

pass在上面的示例中,我们定义了一个名为MySpider的爬虫,指定了名称为example,并指定了起始URL为http://www.example.com。在parse方法中,你可以处理网页响应,并提取你需要的数据。

4.提取数据:

在parse方法中,可以使用Scrapy提供的选择器来提取网页中的数据。Scrapy支持多种选择器,如XPath和CSS选择器。下面是一个使用XPath提取数据的示例:

代码语言:javascript

AI代码解释

def parse(self, response):

titles = response.xpath('//h1/text()').getall()

for title in titles:

yield {

'title': title

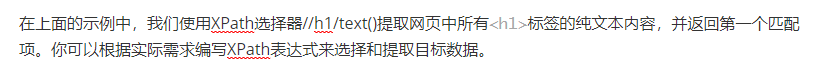

}在上面的示例中,我们使用XPath选择器提取网页中所有<h1>标签的文本内容,并将其封装为一个字典。然后使用yield语句将字典作为一个数据项返回。

5.定义数据存储:

Scrapy提供了多种数据存储的方式,如存储为JSON、CSV或数据库。你可以在项目的pipelines.py文件中定义数据存储管道。下面是一个简单的示例:

代码语言:javascript

AI代码解释

import json

class JsonWriterPipeline:

def open_spider(self, spider):

self.file = open('data.json', 'w')

def close_spider(self, spider):

self.file.close()

def process_item(self, item, spider):

line = json.dumps(dict(item)) + '\n'

self.file.write(line)

return item在上面的示例中,我们定义了一个将爬取的数据存储为JSON格式的管道。在process_item方法中,我们将数据项转换为JSON格式,并写入文件。你也可以根据需要自定义其他存储管道,如存储到数据库中。

6.运行爬虫:

如何运行爬虫取决于你的需求。在命令行中,可以使用以下命令运行爬虫:

代码语言:javascript

AI代码解释

scrapy crawl example这里的example是爬虫的名称,对应MySpider类的name属性。Scrapy将会开始运行爬虫,并根据设定的规则爬取网页并处理数据。

这些是Scrapy框架的基本使用方法。通过定义爬虫、提取数据和设置数据存储管道,你可以利用Scrapy框架快速、高效地爬取和处理网站数据。你还可以进一步研究Scrapy的高级功能,如设置请求头、处理页面间的链接、使用中间件等。官方文档为进一步学习Scrapy提供了详细的介绍和示例代码:https://docs.scrapy.org/

二丶scrapy功能学习

1.Selector数据处理

在Scrapy框架中,使用Selector类对网页进行数据提取和处理是常见的操作之一。Selector提供了强大的API,支持使用XPath选择器或CSS选择器来定位和提取网页中的数据。下面我将详细解释Selector的使用方法。

首先,你需要导入Selector类:

代码语言:javascript

AI代码解释

from scrapy import Selector然后,你可以使用Selector类来创建一个选择器对象,并将网页的内容作为参数传入:

代码语言:javascript

AI代码解释

# 以网页内容创建Selector对象

selector = Selector(text=html_content)这里的html_content是网页的内容,可以是字符串形式的HTML代码或网页响应的文本。

接下来,可以使用选择器对象来提取和处理数据。

- 使用XPath选择器提取数据:

代码语言:javascript

AI代码解释

# 使用XPath选择器提取

data = selector.xpath('//h1/text()').get()

- 使用CSS选择器提取数据:

代码语言:javascript

AI代码解释

# 使用CSS选择器提取

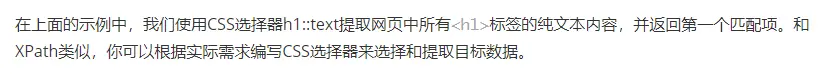

data = selector.css('h1::text').get()

提取多个数据:

代码语言:javascript

AI代码解释

# 提取多个数据

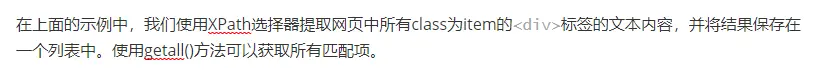

data_list = selector.xpath('//div[@class="item"]/text()').getall()

- 嵌套选择器:

代码语言:javascript

AI代码解释

# 嵌套选择器

parent_element = selector.xpath('//div[@class="parent"]')

data = parent_element.xpath('./span/text()').get()2.xpath选择器

在Scrapy框架源码中,XPath选择器被广泛用于网页数据的提取和处理。XPath是一种用于在HTML/XML文档中定位元素的查询语言,通过使用XPath选择器,可以方便地定位和提取网页中的数据。下面我将详细解释XPath选择器的用法和功能。

1.XPath基本语法:

XPath使用路径表达式来描述元素的位置,路径表达式由一系列的节点选择器和轴运算符组成。以下是XPath的一些基本语法规则:

- /: 表示从根节点开始的绝对路径,例如:/html/body/div.

- //: 表示在整个文档中搜索符合条件的元素,例如://div.

- .: 表示当前节点,例如:./span.

- ..: 表示当前节点的父节点,例如:../div.

- @: 表示获取元素的属性值,例如:@href.

2.XPath节点选择器:

XPath提供了多种节点选择器,用于选择和匹配不同类型的元素。以下是一些常用的节点选择器:

- nodename: 选择所有指定节点名称的元素,例如:div.

- : 选择所有子元素,例如:.

- @attribute: 选择指定属性的元素,例如:@href.

- [@attribute='value']: 根据属性值选择元素,例如:- [@class='container'].

3.XPath轴运算符:

轴运算符用于根据元素的相对位置选择元素。以下是一些常用的轴运算符:

- ancestor::: 选择所有祖先节点,例如:ancestor::div.

- parent::: 选择当前节点的父节点,例如:parent::div.

- preceding-sibling::: 选择当前节点之前的所有同级节点,例如:preceding-sibling::div.

4.使用XPath选择器提取数据:

在Scrapy中,可以使用Selector类的xpath()方法来执行XPath选择器。下面是一些示例:

代码语言:javascript

AI代码解释

from scrapy.selector import Selector

# 创建Selector对象

selector = Selector(text=html_content)

# 提取文本内容

data = selector.xpath('//h1/text()').get()

# 提取属性值

href = selector.xpath('//a/@href').get()

# 提取多个数据

data_list = selector.xpath('//div[@class="item"]/text()').getall()在上面的示例中,我们首先创建了一个Selector对象,其中html_content是网页的内容。然后使用xpath()方法并传入XPath表达式来选择和提取数据。get()方法用于获取第一个匹配项,而getall()方法用于获取所有匹配项的列表。

XPath选择器的功能非常强大,你可以根据具体的网页结构和需求编写自己的选择器表达式来提取和处理网页中的数据。同时,XPath还支持诸如谓语(Predicates)、逻辑运算符(and、or、not)、函数(contains、starts-with、normalize-space)等高级功能,可以进一步扩展和定制你的选择器。

3.CSS选择器

在Scrapy框架源码中,CSS选择器也是一种常用的方法来提取和处理网页数据。与XPath选择器相比,CSS选择器使用起来更简洁直观。下面我将详细讲解CSS选择器的用法和功能。

1.基本语法:

CSS选择器使用简洁的语法来选择元素。以下是一些基本的CSS选择器语法:

- tagname: 选择指定标签名的元素,例如:div.

- .#id: 选择具有指定id的元素,例如:#container.

- .class: 选择具有指定class的元素,例如:.item.

- *: 选择所有元素.

- element1, element2: 同时选择多个元素,例如:div, span.

2.层级关系和子元素选择:

CSS选择器支持选择元素的子元素和后代元素。以下是一些示例:

- parent > child: 选择父元素下的直接子元素,例如:div > span.

- ancestor descendant: 选择祖先元素下的后代元素,例如:body span.

3.属性选择器:

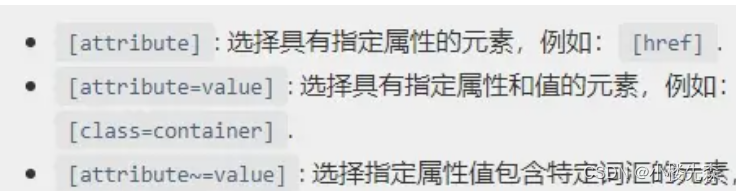

CSS选择器还支持根据元素的属性进行选择。以下是一些常见的属性选择器:

4.伪类选择器:

伪类选择器用于选择具有特殊状态或特定位置的元素。以下是一些常见的伪类选择器:

- :first-child: 选择父元素的第一个子元素.

- :last-child: 选择父元素的最后一个子元素.

- :nth-child(n): 选择父元素的第n个子元素.

- :not(selector): 选择不匹配给定选择器的元素.

5.使用CSS选择器提取数据:

在Scrapy中,可以使用Selector类的css()方法来执行CSS选择器。下面是一些示例:

代码语言:javascript

AI代码解释

from scrapy.selector import Selector

# 创建Selector对象

selector = Selector(text=html_content)

# 提取文本内容

data = selector.css('h1::text').get()

# 提取属性值

href = selector.css('a::attr(href)').get()

# 提取多个数据

data_list = selector.css('div.item::text').getall()在上面的示例中,我们首先创建了一个Selector对象,其中html_content是网页的内容。然后使用css()方法并传入CSS选择器表达式来选择和提取数据。get()方法用于获取第一个匹配项,而getall()方法用于获取所有匹配项的列表。

CSS选择器的语法简洁明了,易于理解和使用。通过灵活运用CSS选择器,你可以在Scrapy框架中方便地提取和处理网页数据。

4.scrapy对接MySQL

在Scrapy框架中,将数据存储到MySQL数据库是一种常见的需求。Scrapy提供了一个方便的方式来实现与MySQL数据库的对接。下面我将详细说明如何在Scrapy框架中对接MySQL数据库。

1.安装MySQL驱动:

首先,确保已经安装了Python的MySQL驱动程序。在Scrapy中,常用的MySQL驱动包括mysql-connector-python和pymysql。你可以使用以下命令来安装其中一个驱动程序:

代码语言:javascript

AI代码解释

pip install mysql-connector-python或

代码语言:javascript

AI代码解释

pip install pymysql2.配置数据库连接:

在Scrapy项目的settings.py文件中,可以配置MySQL数据库连接信息。例如,你需要指定数据库主机、数据库名称、用户名和密码等。以下是一个示例的配置:

代码语言:javascript

AI代码解释

# MySQL数据库连接信息

MYSQL_HOST = 'localhost'

MYSQL_PORT = 3306

MYSQL_DATABASE = 'mydatabase'

MYSQL_USER = 'myuser'

MYSQL_PASSWORD = 'mypassword'3.创建数据库连接:

在Scrapy的爬虫代码中,你可以使用以上配置信息来创建与MySQL数据库的连接。在Spider类的__init__方法中,可以使用MySQL驱动来建立数据库连接。以下是一个示例代码:

代码语言:javascript

AI代码解释

import mysql.connector

class MySpider(scrapy.Spider):

def __init__(self, *args, **kwargs):

super(MySpider, self).__init__(*args, **kwargs)

self.conn = mysql.connector.connect(

host=settings.MYSQL_HOST,

port=settings.MYSQL_PORT,

database=settings.MYSQL_DATABASE,

user=settings.MYSQL_USER,

password=settings.MYSQL_PASSWORD

)

self.cursor = self.conn.cursor()4.存储数据到数据库:

在Scrapy的爬虫代码中,当你需要将数据存储到MySQL数据库时,可以通过执行SQL语句来实现。以下是一个示例代码:

代码语言:javascript

AI代码解释

class MySpider(scrapy.Spider):

# ...

def parse(self, response):

# 解析响应数据

data = {

'title': response.xpath('//title/text()').get(),

'content': response.xpath('//div[@class="content"]/text()').get()

}

# 执行插入数据的SQL语句

sql = "INSERT INTO mytable (title, content) VALUES (%s, %s)"

values = (data['title'], data['content'])

self.cursor.execute(sql, values)

self.conn.commit()在上面的示例中,我们定义了一个parse方法,从响应中提取数据,并将其存储到MySQL数据库中。我们执行了一个插入数据的SQL语句,并使用execute()方法执行该语句,然后使用commit()方法提交事务。

需要注意的是,当爬虫关闭时,你应该在爬虫的closed方法中关闭数据库连接,以释放资源。以下是一个示例代码:

代码语言:javascript

AI代码解释

class MySpider(scrapy.Spider):

# ...

def closed(self, reason):

self.cursor.close()

self.conn.close()以上就是在Scrapy框架中对接MySQL数据库的详细步骤。通过配置数据库连接信息,创建数据库连接,然后执行SQL语句来存储数据,你可以方便地将爬取到的数据保存到MySQL数据库中。

5.Scrapy对接MongoDB

在Scrapy框架中,对接MongoDB数据库是一种常见的需求。Scrapy提供了一个方便的方式来实现与MongoDB的对接。下面我将详细说明如何在Scrapy框架中对接MongoDB数据库。

1.安装MongoDB驱动: 首先,确保已经安装了Python的MongoDB驱动程序。在Scrapy中,常用的MongoDB驱动包括pymongo和mongoengine。你可以使用以下命令来安装其中一个驱动程序:

代码语言:javascript

AI代码解释

pip install pymongo或

代码语言:javascript

AI代码解释

pip install mongoengine2.配置数据库连接:

在Scrapy项目的settings.py文件中,可以配置MongoDB数据库连接信息。例如,你需要指定数据库主机、数据库名称等。以下是一个示例的配置:

代码语言:javascript

AI代码解释

# MongoDB数据库连接信息

MONGO_URI = 'mongodb://localhost:27017/'

MONGO_DATABASE = 'mydatabase'3.创建数据库连接:

在Scrapy的爬虫代码中,你可以使用以上配置信息来创建与MongoDB数据库的连接。在Spider类的init方法中,可以使用MongoDB驱动来建立数据库连接。以下是一个示例代码:

代码语言:javascript

AI代码解释

from pymongo import MongoClient

class MySpider(scrapy.Spider):

def __init__(self, *args, **kwargs):

super(MySpider, self).__init__(*args, **kwargs)

self.client = MongoClient(settings.MONGO_URI)

self.db = self.client[settings.MONGO_DATABASE]4.存储数据到数据库:

在Scrapy的爬虫代码中,当你需要将数据存储到MongoDB数据库时,可以使用相应的MongoDB驱动提供的方法来实现。以下是一个示例代码:

代码语言:javascript

AI代码解释

class MySpider(scrapy.Spider):

# ...

def parse(self, response):

# 解析响应数据

data = {

'title': response.xpath('//title/text()').get(),

'content': response.xpath('//div[@class="content"]/text()').get()

}

# 存储数据到MongoDB集合

collection = self.db['mycollection']

collection.insert_one(data)在上面的示例中,我们定义了一个parse方法,从响应中提取数据,并将其存储到MongoDB数据库中。我们通过insert_one()方法将数据插入到指定的集合中。

需要注意的是,当爬虫关闭时,你应该在爬虫的closed方法中关闭数据库连接,以释放资源。以下是一个示例代码:

代码语言:javascript

AI代码解释

class MySpider(scrapy.Spider):

# ...

def closed(self, reason):

self.client.close()以上就是在Scrapy框架中对接MongoDB数据库的详细步骤。通过配置数据库连接信息,创建数据库连接,然后使用相应的驱动方法存储数据,你可以方便地将爬取到的数据保存到MongoDB数据库中。

6.Scrapy文件存储

在Scrapy框架中,是一个常见的需求,特别是在网络爬虫中,我们经常需要将爬取到的数据以文件的形式保存下来。Scrapy提供了多种方式来实现文件存储,包括保存为本地文件、存储到云存储服务(如Amazon S3)、存储到FTP服务器等。下面我将详细介绍Scrapy框架中文件存储的几种方式。

1.保存为本地文件:

最简单的文件存储方式是将数据保存为本地文件。在Scrapy的爬虫代码中,你可以通过在settings.py文件中配置FEED_URI和FEED_FORMAT来实现。以下是一个示例配置:

代码语言:javascript

AI代码解释

# 保存为本地文件

FEED_URI = 'result.json'

FEED_FORMAT = 'json'在以上配置中,FEED_URI指定了保存的文件路径和文件名,FEED_FORMAT指定了保存的文件格式。你可以将格式设为json、csv、xml等等。

更多推荐

已为社区贡献150条内容

已为社区贡献150条内容

所有评论(0)