你知道不,你现在给 AI 用的 Agent Skills 可能毫无作用,甚至还拖后腿?

要知道 2025 年底到 2026,在 AI 领域 Skills 自从被提出来后可以说是风头无二,大量 Skills 开始充斥社区,Skills 的低门槛也让它快速发展 ,特别是在 OpenClaw 领域,单是官方注册的 ClawHub 的 Skills 就已经有 7800+,但是它们真的有用吗?所以,如果你发现 Skill 用多了,Agent 反而傻了,不要怀疑,是你的 Skill 给你的 Ag

最近,一篇名为 《SkillsBench: Benchmarking How Well Agent Skills Work Across Diverse Tasks》 的论文提出了一个很有意思的观点:自生成的 Agnet Skills 毫无用处。

要知道 2025 年底到 2026,在 AI 领域 Skills 自从被提出来后可以说是风头无二,大量 Skills 开始充斥社区,Skills 的低门槛也让它快速发展 ,特别是在 OpenClaw 领域,单是官方注册的 ClawHub 的 Skills 就已经有 7800+ ,但是它们真的有用吗?

这篇论文(arXiv:2602.12670,SkillsBench)在一个专门为「技能是否真的有用」设计的基准上,得到了一个系统性结论:让模型自己写一套“技能/流程指南”,平均并不能提高成功率,甚至略微下降。

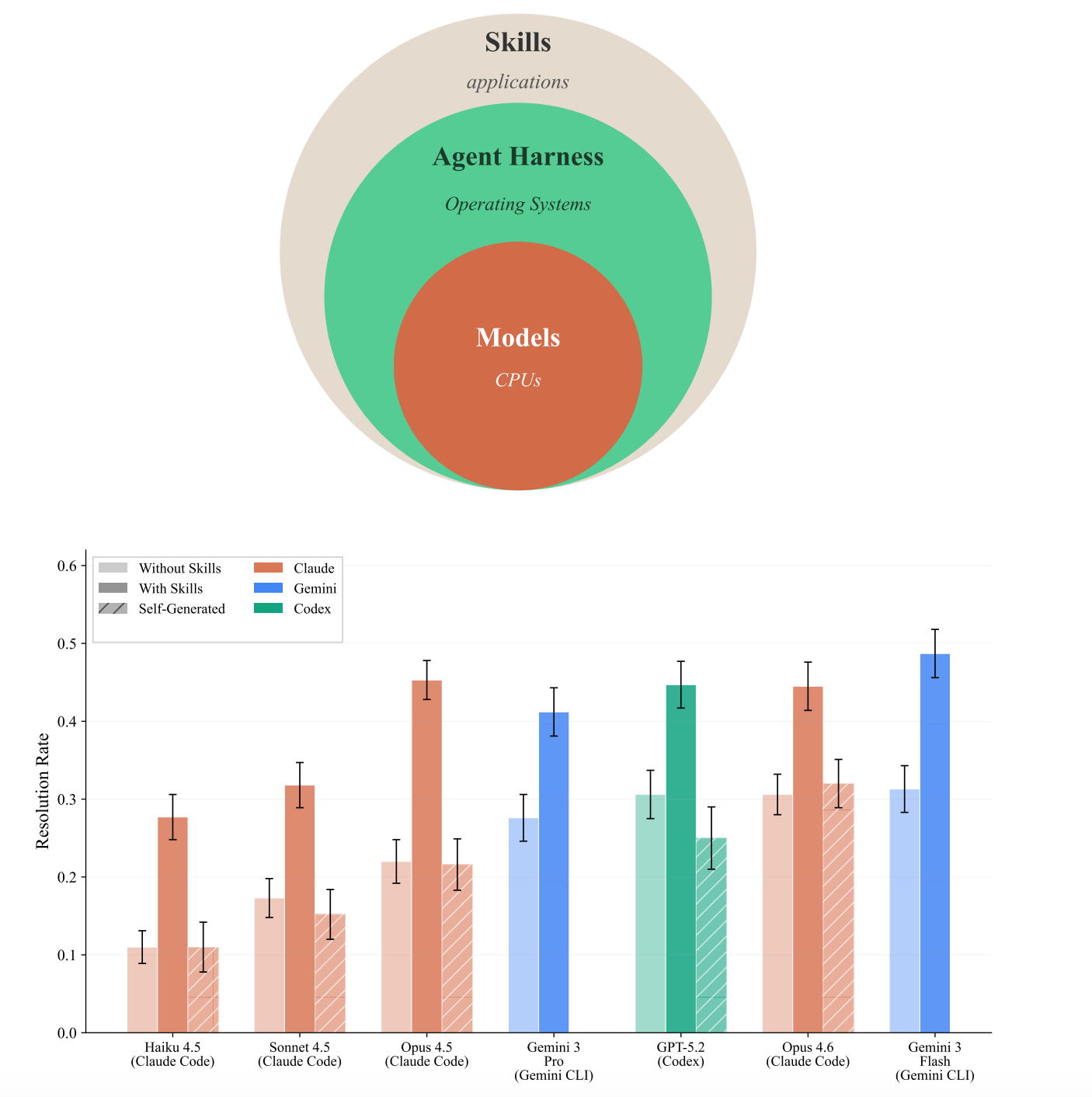

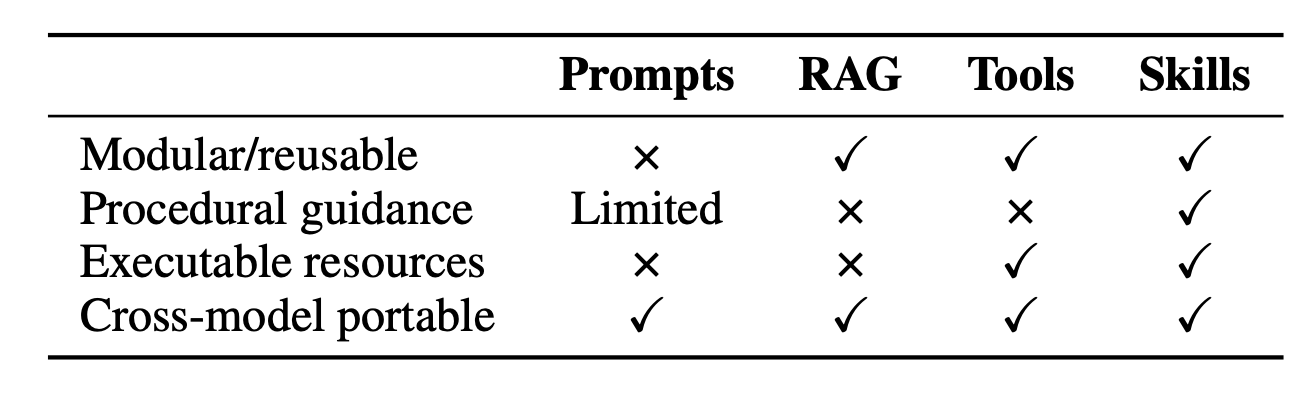

首先我们要明确一个基础点,那么就是 Agent Skill 是什么?这里他们把 Agent Skill 定义成一种结构化的“程序性知识包”,用于在推理/执行时增强 Agent:

通常是一个文件夹,里面有 SKILL.md(流程/操作步骤),以及可选的脚本、模板、参考资料、示例等,核心特征是「怎么做」,而不是「是什么」。

同时论文也明确区分:Skill 不等于普通系统提示词、不等于 few-shot、不等于 RAG 检索、不等于纯工具文档,Skill 更强调可复用的工作流/SOP + 结构化资源,而针对测试场景,论文也区分了 Curated Skills 和 Self-generated Skills:

- Curated Skills : 提前设计好的、结构化的“操作指南 + 资源包”,“能落地执行”的 SOP

- Self-generated Skills :模型自己写的技能,比如给模型一个任务,要求它先“写一个技能文件”,然后再用自己写的技能去做任务

而 SkillsBench 这个 benchmark 做了一个基准:84 个任务、11 个领域,每个任务都有确定性验证场景(跑脚本/单测,给出 pass/fail),并且同一个任务在三种条件下对比:

-

No Skills :只有任务说明

instruction.md,环境里没有 skills -

With Skills(Curated Skills) :提供专业写好的完整详细技能包(包含步骤、示例、脚本等)

-

Self-Generated Skills:不给技能包,但要求模型**先自己生成“技能文件”**再做任务,用来隔离“模型自身潜在知识”能不能替代人类技能。

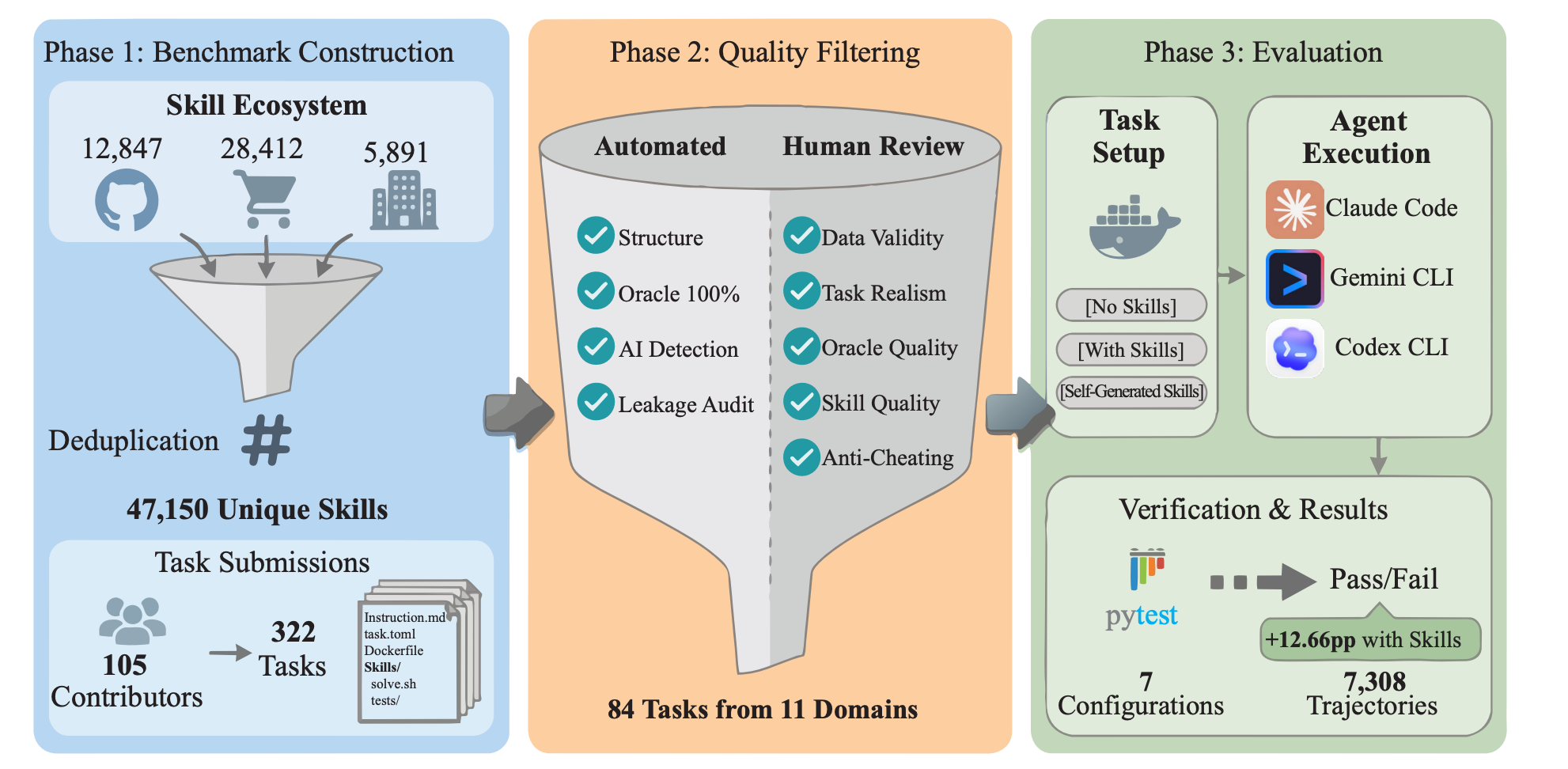

整个 Benchmark 它分成三大阶段:Benchmark Construction 、 Quality Filtering、 Evaluation。

其中 Benchmark Construction 的核心是 Skill 生态收集 ,包括:

- 开源仓库 12,847

- Claude Code 生态 28,412

- 企业伙伴 5,891

总计汇聚后,通过去重得到 47,150 unique skills,有 322 位贡献者提交 105 个候选任务

而 Quality Filtering 是把 105 个候选任务筛成最终基准任务,包括:

-

自动化检查

-

Structure(结构有效性)

-

Oracle 100%(验证器能稳定得到 100% 正确结果)

-

AI Detection(检测任务是不是 AI 生成的水任务)

-

Leakage Audit(泄漏审计:防止 skills 里直接塞答案/作弊路径)

-

-

人工审查

-

Data Validity(数据有效)

-

Task Realism(任务真实)

-

Oracle Quality(验证器质量)

-

Skill Quality(配套技能质量)

-

Anti-Cheating(防作弊)

-

最终产出:84 个任务,覆盖 11 个领域 。

在 Evaluation 阶段的同一批任务,会在三种场景下运行,同时用三套商业 harness 执行(Claude Code / Gemini CLI / Codex CLI),结果用 pytest 等确定性验证器给出 Pass/Fail :

- 总共跑了 7 个 agent-model 配置,得到 7,308 条轨迹

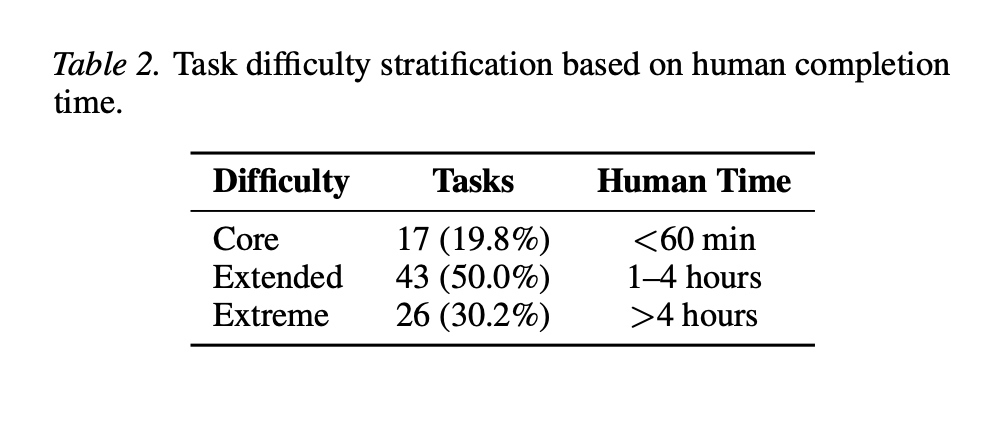

而对于任务,是用人类完成时间作为难度来变为:

- Core:17 个任务(19.8%),人类完成时间 < 60 min

- Extended:43 个任务(50.0%),人类完成时间 1–4 hours

- Extreme:26 个任务(30.2%),人类完成时间 > 4 hours

所以从整个配置可以看出来:

- 这个测试不是“手工写了几十个 demo”,而是从真实生态里抽样出一个很大的技能池 + 真实贡献者任务池

- 这个 benchmark 的难点不在「写题」,而在「确保题靠谱、可验证、不可投机取巧」

- 测的是「能不能真的做对并通过测试」,不是主观打分,也不是看起来像对

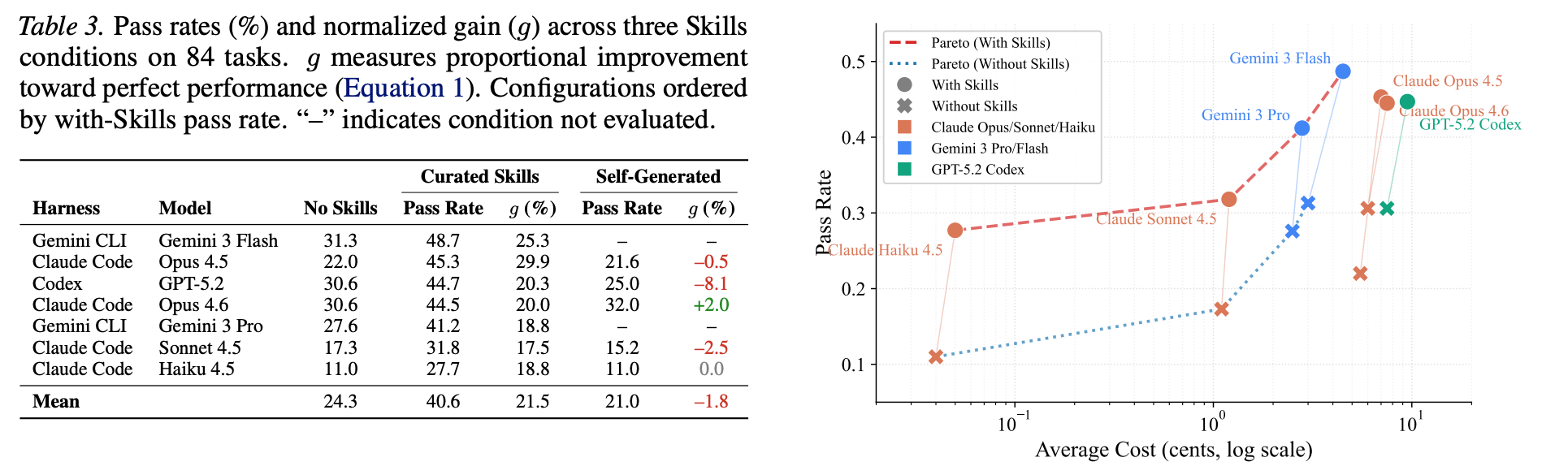

所以整个论文测试,不是只测「加一点上下文有没有用」,而是测「真实世界里那种 skill 」到底能不能稳定带来收益,根据测试结果:

-

No Skills : 平均通过率:24.3%

-

Curated Skills :平均通过率:40.6%,g 的均值 21.5

-

Self-generated Skills:平均通过率:21.0%,对应 g 的均值是 -1.8

可以看到,在 Self-generated Skills 场景,除了 Claude Code Opus 4.6 有略微作用,其他都普遍下降。

另外论文作者也总结了,对比 no-Skills :

- Self-generated Skills 的平均收益是 –1.3pp ,除了 Opus 4.6 有 +1.4pp ,Codex + GPT-5.2 甚至出现了 –5.6pp

- 而 Curated Skills 的平均收益则是 +16.2pp,但效果差异很大, 84 个任务里有 16 个任务出现负向 delta

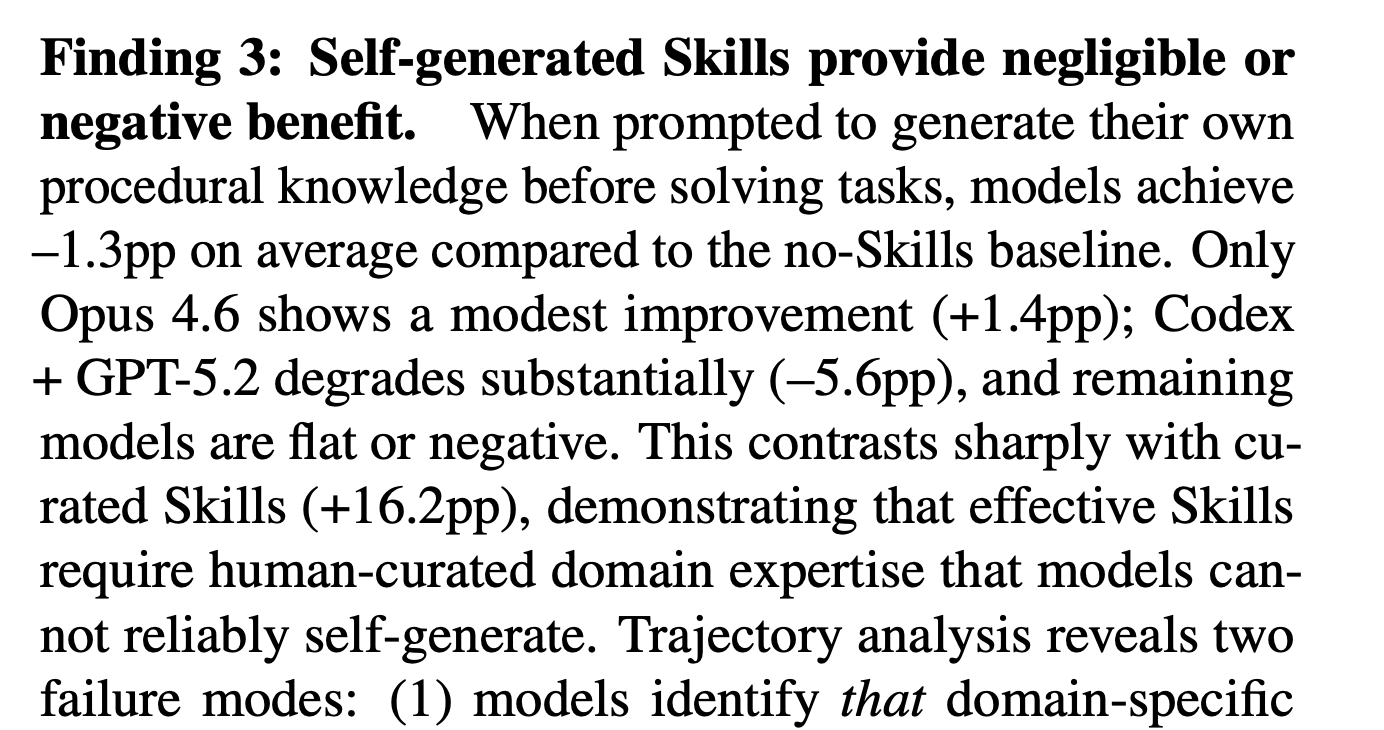

论文把 Self-generated Skills 失败总结为:模型不能可靠地“写出”自己在执行时真正会受益的程序性知识,因此“自生成”平均没有收益,这也是可以理解,目前的 AI 存在概率支持,效果和产出都看它当时的“心情”,论文把 self-generated 失败归因到一个很现实的点:

模型不能可靠地“写出”自己在执行时真正会受益的程序性知识。

说人话就是:模型「会做」但「不会写出可复用的程序性知识」,更具体,论文通过轨迹分析提了两个典型失败模式:

-

知道需要领域知识,但写出来太泛/不完整,比如只写「用 pandas 处理数据」,却不给关键 API 模式、坑点、验证方法、边界条件,导致对实际任务没有可执行指导意义。

-

高领域知识任务里,干脆没意识到需要专门技能,在制造、金融等任务上,模型常用“通用解法”硬莽,错过了需要 SOP/行业流程的关键步骤。

总结起来就是: self-gen 往往生成的是“看起来像指南的废话”,或者压根没抓住应该写什么。

到这里,可能有人会好奇,为什么会有 self-generated 这种用法?什么场景会有人让 AI 自己写 Skills ?实际上这种场景还很多,现在很多 Skills 就是懒人直接让 AI 写的,而更典型的代表,是 Claudeception 这种:

Claudeception 类似于让 Skills 自进化,它会让大模型在使用 Skills 的过程中,把你的踩坑经验自动又变成Skills ,把解决过程里真正有价值的经验,自动提炼成一条可复用的Skill 。

所以 Claudeception 的使用场景就无比贴合这个 SkillsBench ,也就是让 AI 长时间维护和迭代 Skill 是否可靠?目前这篇论文给出的结论是:并不可靠。

而对于专业人士写出来的 Curated Skills,通常包括:

- 明确步骤顺序

- 工具/命令模板

- 数据格式约束

- 验证检查点

- 常见错误与修复路径

特别是 Curated Skills 包含有领域特定知识,比如在 failure analysis 里作者就说过 Self-generated 常见问题是:

- 没意识到某些任务需要专门领域流程

- 写出的步骤过于通用

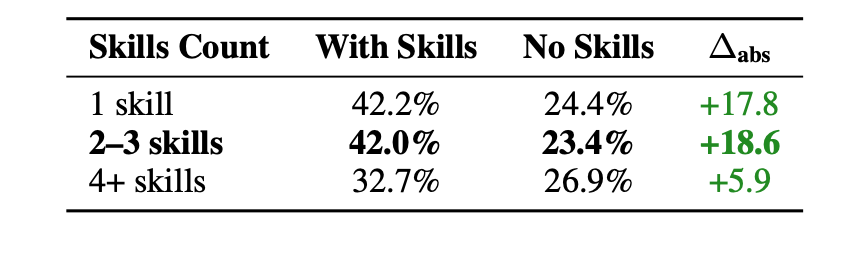

另外,除了“self-gen 不行”,论文还做了技能设计因素分析:

-

技能数量 2–3 个模块最好,太多反而拖累,按任务提供的 skill 数量分组 2–3 skills 的提升最大(+18.6pp),4 个以上提升很小,甚至可能带来认知负担/冲突

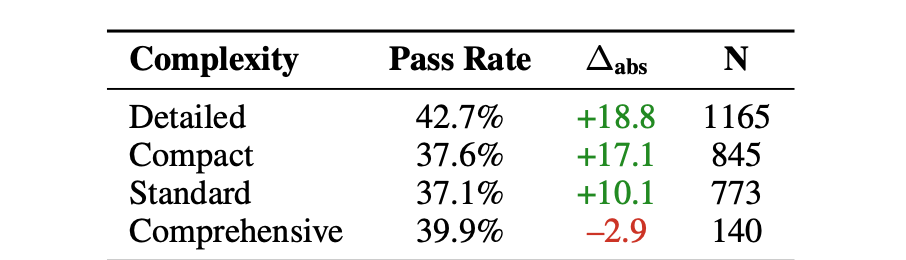

-

技能“文档复杂度”上,聚焦型胜过“大全型”,论文把把 Skills 文档分成 detailed/compact/standard/comprehensive,结果是:

-

detailed、compact 提升更大

-

comprehensive(“把所有东西都塞进去”那种)平均还降低了(-2.9pp)

所以技能不是越长越好,而是要把 agent 下一步要做什么写清楚(含检查点、命令模板、失败回滚),否则就是噪声。

所以,通过这篇论文可以总结,Agnet Skills 不是几句简单的提示词,系统的的技能包确实能增强 Agent,但是目前 AI 自己维护的 Self-generated Skills 几乎没用,甚至还会拉低效果 ,关键原因是模型很难稳定写出真正可执行、降低搜索空间的程序性知识,同时技能设计比数量也狠重要,技能不是越多越好,也不是越详细越好。

总的来就是,高质量技能 = 搜索空间压缩器,它可以限定决策路径、减少无效探索、提供验证锚点和显式化领域隐性流程,这才是 Skills 能推高 Pareto frontier 的原因,所以,你需要避免百科式技能,它可能带来的更多的噪音。

所以,如果你发现 Skill 用多了,Agent 反而傻了,不要怀疑,是你的 Skill 给你的 Agent 掺了屎

更多推荐

已为社区贡献27条内容

已为社区贡献27条内容

所有评论(0)