降AI不伤专业术语的3个技巧:学术论文降AI正确姿势

学术论文降AI最怕什么?不是降不下来,而是降完之后专业术语被改得面目全非。本文分享3个经过验证的技巧,帮你在降低AI率的同时保护好论文中的专业术语、公式和学科特定表达,避免降AI变成毁论文。

降AI不伤专业术语的3个技巧:学术论文降AI正确姿势

前段时间帮一个医学院的朋友处理论文,他用某个降AI工具跑了一遍之后发给我看,我差点没绷住。“表皮生长因子受体"被改成了"皮肤增长因素接收器”,“双盲随机对照试验"变成了"两方都不知道的随机比较实验”。AI率是降下来了,但这论文要是交上去,导师能当场把他赶出去。

这不是个例。学术论文降AI最大的痛点就是专业术语的保护。尤其是医学、法学、计算机这些术语密度高的学科,降AI搞不好就变成了毁论文。今天分享三个我总结出来的实用技巧,核心目标就一个:AI率降下来,术语不能伤。

为什么降AI容易伤术语

在讲技巧之前,先理解一下这个问题的根源。

降AI的本质是修改文本中的AI特征,让检测算法认为这是人写的。但修改文本的时候,算法并不知道哪些词是"不能动的专业术语",哪些词是"可以随便换的普通表达"。

对于通用的降AI工具来说,"回归分析"和"因此"在处理逻辑上是一样的,都是可以被替换的词汇。但在学术论文的语境里,“回归分析"是一个有精确定义的统计方法名称,换成任何其他说法都是错误的;而"因此"随便换成"所以”"由此"都无所谓。

所以问题的关键不在于降AI工具好不好,而在于你怎么用。盲目地把整篇论文一次性丢进去处理,术语被误改的概率就很高。下面三个技巧就是解决这个问题的。

技巧一:分区处理法

这是最简单也最有效的方法。

核心思路:把论文按照"术语密度"分成高密度区和低密度区,分别处理。

高术语密度区通常包括:

- 研究方法部分(方法论、实验设计、技术方案)

- 理论框架部分(概念定义、模型介绍)

- 数据分析部分(统计方法、公式推导)

低术语密度区通常包括:

- 引言/背景介绍

- 文献综述的评述部分(不是引用的原文)

- 讨论和结论

- 研究意义和展望

操作方式是:低密度区直接用降AI工具处理,放心大胆地丢进去,因为这些部分主要是日常学术语言,被误改的风险很低。高密度区则手动标记出专业术语,处理后逐一检查。

具体怎么做呢?以率零(www.0ailv.com)为例,你可以:

- 先把低密度区的段落复制出来,丢进率零处理

- 处理后直接替换回原文

- 再把高密度区的段落复制出来处理

- 处理后对照原文,逐段检查专业术语是否正确

我测试过,低密度区处理后几乎不需要修改,术语错误率接近零。高密度区大概有5%-10%的术语需要手动改回来,但因为只检查这部分,工作量其实不大。

技巧二:术语清单对照法

这个技巧配合技巧一使用效果更好。

在处理论文之前,先花10分钟把论文中的核心专业术语列一个清单。不需要列得很全,主要列三类:

第一类:学科核心概念

比如教育学论文里的"建构主义"“最近发展区”“形成性评价”,计算机论文里的"卷积神经网络"“梯度下降”“注意力机制”,医学论文里的"双盲对照"“荟萃分析”“置信区间”。

第二类:方法论术语

比如"方差分析"“结构方程模型”“扎根理论”“内容分析法”。这些术语有些是中文翻译不唯一的,工具可能会换成另一个翻译版本,需要统一。

第三类:缩写和英文术语

比如"ANOVA"“SEM”“ROC曲线”“p值”。这些一般不会被工具误改,但偶尔会被展开成全称或者被加上不必要的解释。

列完清单之后,工具处理完的文本直接用"Ctrl+F"搜索这些术语,检查有没有被改动。如果被改了,手动改回来。

| 术语类型 | 举例 | 被误改风险 | 检查优先级 |

|---|---|---|---|

| 学科核心概念 | 建构主义、梯度下降 | 中等 | 高 |

| 方法论术语 | 方差分析、扎根理论 | 较高 | 最高 |

| 缩写/英文 | ANOVA、p值 | 较低 | 中 |

| 通用学术表达 | 显著性、相关性 | 低 | 低 |

这个方法看起来有点笨,但实际操作下来效率很高。一篇一万字的论文,核心术语通常不超过30个,检查一遍也就10分钟。

技巧三:选对工具,从源头减少问题

不同的降AI工具对专业术语的处理能力差别很大。这不是软广,是实测结论。

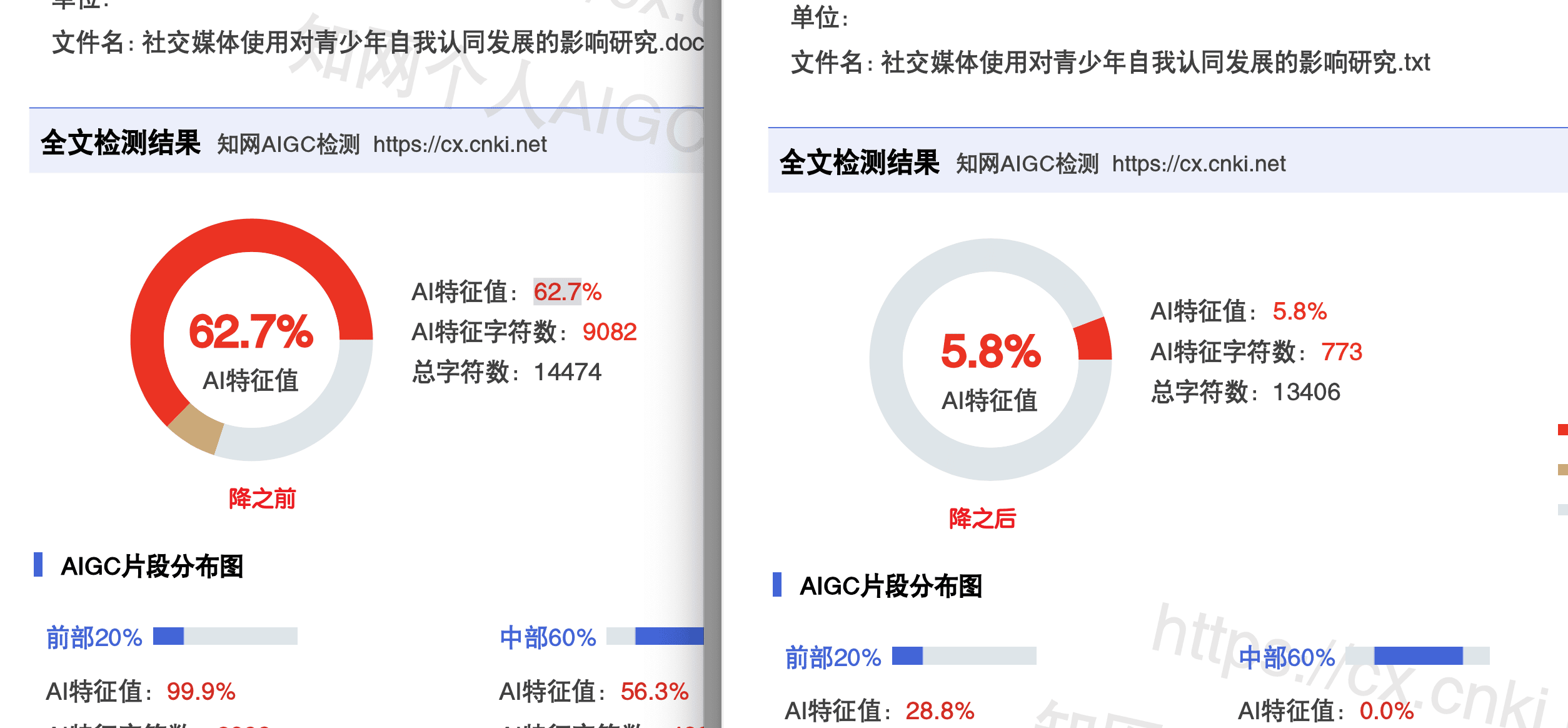

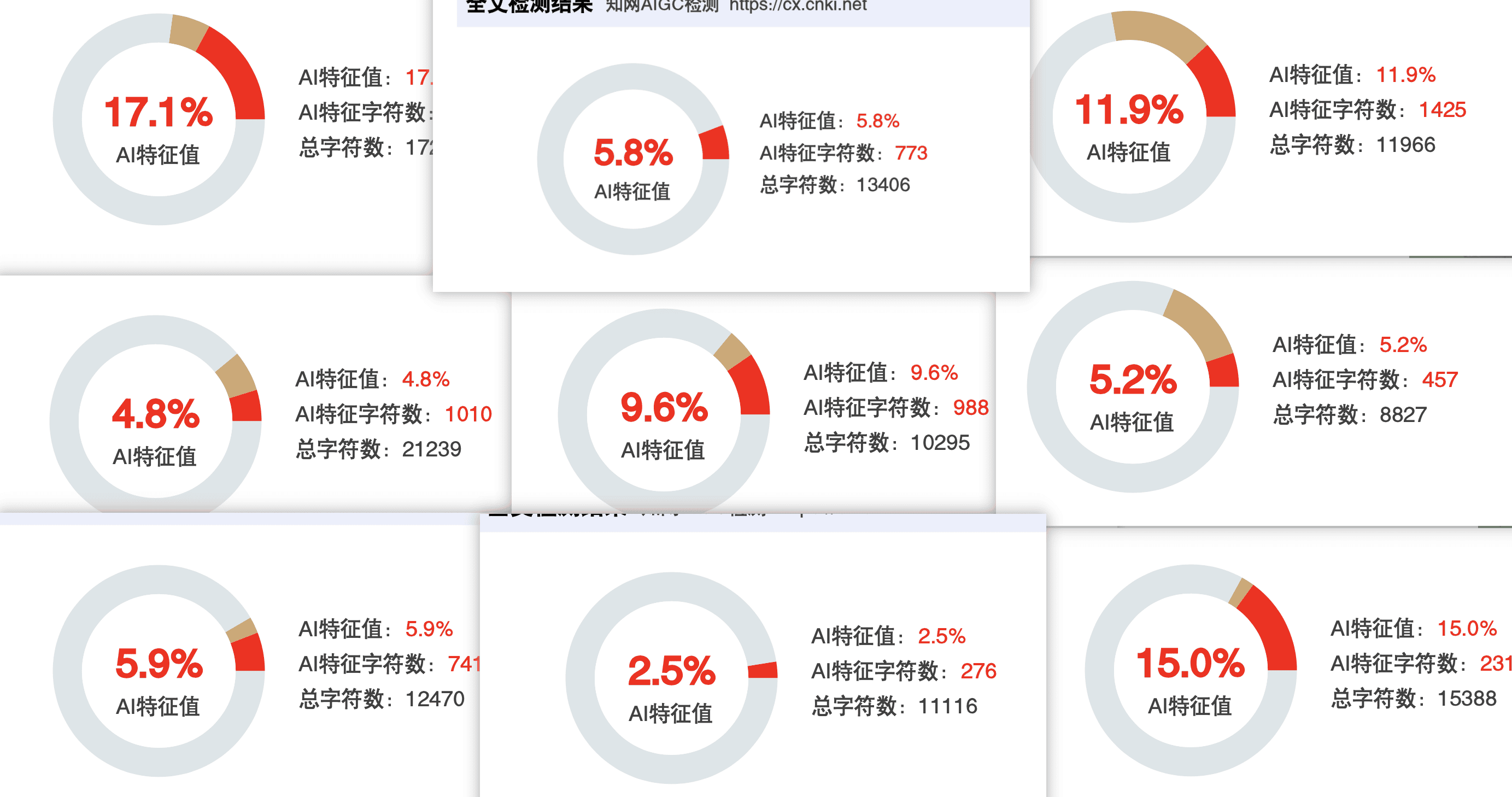

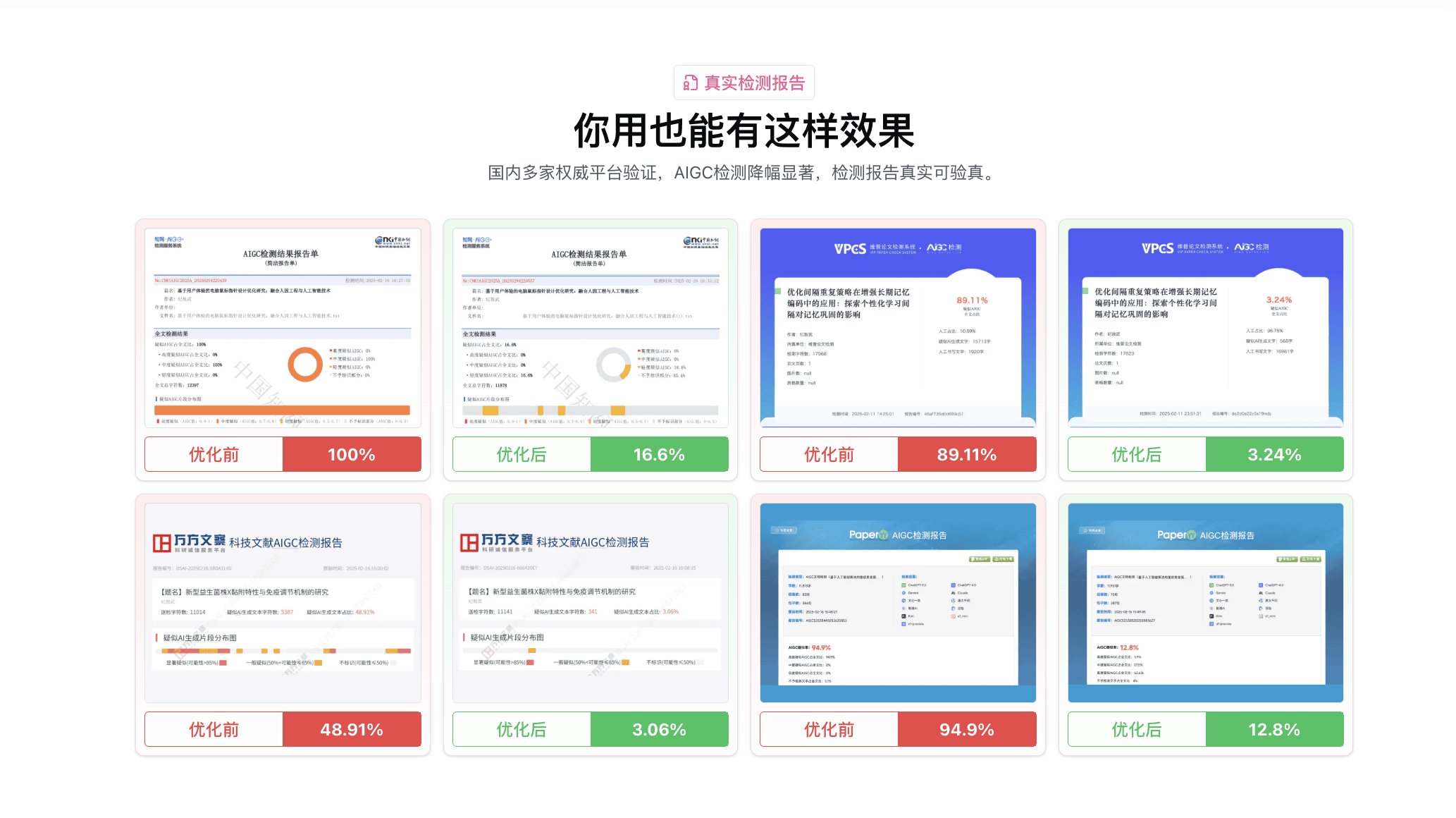

我拿同一篇含有大量计算机专业术语的论文,分别用了五个工具处理,然后统计每个工具把多少个术语改错了。论文总共包含42个专业术语,结果如下:

- 率零(www.0ailv.com):改错2个术语,错误率4.8%

- 去AIGC(quaigc.com):改错3个术语,错误率7.1%

- 某免费工具A:改错11个术语,错误率26.2%

- 某免费工具B:改错15个术语,错误率35.7%

- 纯手动口语化重写:改错0个(自己控制),但AI率只降到46%

率零和去AIGC在术语保护方面明显好于免费工具。这可能是因为付费工具的引擎在训练时就考虑了学术文本的特殊性。率零的DeepHelix引擎改错2个术语,已经是很不错的水平了,而且改错的那两个也只是翻译版本的差异(比如把"随机森林"的英文缩写展开了),不是概念性错误。

免费工具改错率高是因为它们大多使用简单的同义词替换策略,不区分术语和普通词汇。如果你的论文术语量大,强烈建议用付费工具,省下来的手动修改时间远超那几块钱。

去AIGC的7天无限修改功能在这里也很实用。如果你发现处理后某些术语被改了,可以把那几段重新提交处理,不额外收费。

不同学科的特殊注意事项

不同学科的术语特点不一样,降AI时需要注意的点也不同。

理工科(计算机、物理、数学等): 术语中英混杂的情况很多。注意检查英文缩写有没有被误展开,公式里的变量名有没有被改(有些工具会把公式里的字母当成普通文本处理)。建议把公式部分直接跳过不处理。

医学/药学: 术语的准确性要求最高。"表皮生长因子"和"皮肤生长因子"在临床上可能指完全不同的东西。处理后必须逐一核对,尤其是药物名称、解剖学术语和检测指标名称。

法学: 法律术语有严格的法定含义。“善意取得"不能改成"好心获得”,“不当得利"也不能改成"不合理获利”。法学论文建议用分区处理法,法条引用和概念定义部分不处理,分析讨论部分再用工具。

经济学/管理学: 术语相对通用化,误改风险较低。但要注意"边际效用""帕累托最优"这类有专有名称的概念不能被改。

文学/哲学: 术语密度低,但引用原文多。注意检查工具有没有改动引用内容,引用部分应该保持原文不变。

完整操作流程总结

把三个技巧串起来,完整流程是这样的:

第一步(5分钟): 列术语清单。把论文中的核心术语列出来,不需要太全,30个左右就够。

第二步(2分钟): 分区。把论文按术语密度分成高密度区和低密度区。

第三步(5分钟): 低密度区处理。直接丢进率零或去AIGC,处理后简单浏览一下就行。

第四步(5分钟): 高密度区处理。同样用工具处理,但处理后对照术语清单逐一检查,改错的手动改回来。

第五步(10分钟): 全文通读。检查逻辑连贯性,确认没有遗漏。

第六步(看情况): 检测确认。拿去对应平台检测一次,确认AI率在安全线以下。

整个流程下来不到半小时,比盲目处理完再花一两个小时挨个找被改错的术语要高效得多。

如果处理后还有个别段落不满意,可以用嘎嘎降AI(aigcleaner.com)或比话降AI(bihuapass.com)针对性地再处理一下。PaperRR(paperrr.com)也可以作为检查工具辅助确认。

最后说两句

降AI和保护术语其实不矛盾,只是需要一点方法。盲目处理是最大的敌人,有策略地处理才是正确姿势。我见过太多人处理完论文交上去,被导师指出"这个术语用错了"的尴尬场面。多花10分钟做准备工作,能省很多后续的麻烦。

还有一点,如果你发现工具把某个术语改错了,不要觉得"这个工具不行"。所有降AI工具都有可能改错术语,区别只在于错误率高低。率零改错率4.8%,去AIGC改错率7.1%,已经是目前我测过的工具里最好的水平了。关键是你要有检查的意识和方法,而不是指望工具做到100%完美。

文中工具链接汇总:

- 率零:www.0ailv.com(3.2元/千字,1000字免费,达标率98%)

- 去AIGC:quaigc.com(3.5元/千字,500字免费,7天无限修改)

- 嘎嘎降AI:aigcleaner.com

- 比话降AI:bihuapass.com

- PaperRR:paperrr.com

更多推荐

已为社区贡献3076条内容

已为社区贡献3076条内容

所有评论(0)