系列2/5-WinClaw的至暗时刻:我们差点用“硬过滤“杀死了AI的创造力

摘要:为解决WinClaw工具滥用问题,团队曾设计"硬过滤"方案——仅向AI暴露相关工具。该方案虽能大幅减少工具选择空间和token消耗,却存在致命缺陷:一旦意图识别出错,AI将彻底失去完成任务的能力。相比之下,OpenClaw采用模型驱动架构和分层权限过滤(detailKeys),实现了安全性与灵活性的平衡。本文揭示了激进优化方案背后的级联风险,为AI工具系统设计提供了重要教

WinClaw的至暗时刻:我们差点用"硬过滤"杀死了AI的创造力

本系列是AI agent中高级开发者非常受益的开发经验,新鲜火辣出台,献给开发者马年的礼物!

摘要:面对WinClaw的工具滥用危机,我们曾设计了一个"完美"方案:只让AI看到相关工具。然而这个看似高效的策略,却隐藏着致命的级联风险——一旦意图识别出错,AI将永远失去完成任务的能力。相比之下,OpenClaw的模型驱动架构为何能避免这一陷阱?本文深度剖析"硬过滤"方案从诞生到被否定的全过程。

📚 WinClaw工具优化实战专栏(共5篇)

| 篇序 | 文章标题 | 核心内容 |

|---|---|---|

| 01 | WinClaw血泪史:一次"写博客"请求如何让AI陷入工具滥用的死亡螺旋? | 问题发现:全量Schema传递导致的工具滥用灾难 |

| 02 | WinClaw的至暗时刻:我们差点用"硬过滤"杀死了AI的创造力 | 方案试错:激进方案的级联风险与失败教训 |

| 03 | WinClaw方案解剖:那些差点让我们翻车的隐藏陷阱 | 深度评估:多意图、依赖链、建议冲突等隐藏漏洞 |

| 04 | WinClaw破局之道:如何用"渐进式暴露"打赢工具优化的翻身仗? | 最终方案:平衡效率与安全的渐进式暴露策略 |

| 05 | WinClaw工程实战:从"写博客"灾难到TaskTrace追踪系统的涅槃重生 | 落地实施:TaskTrace追踪与工具纳入规范 |

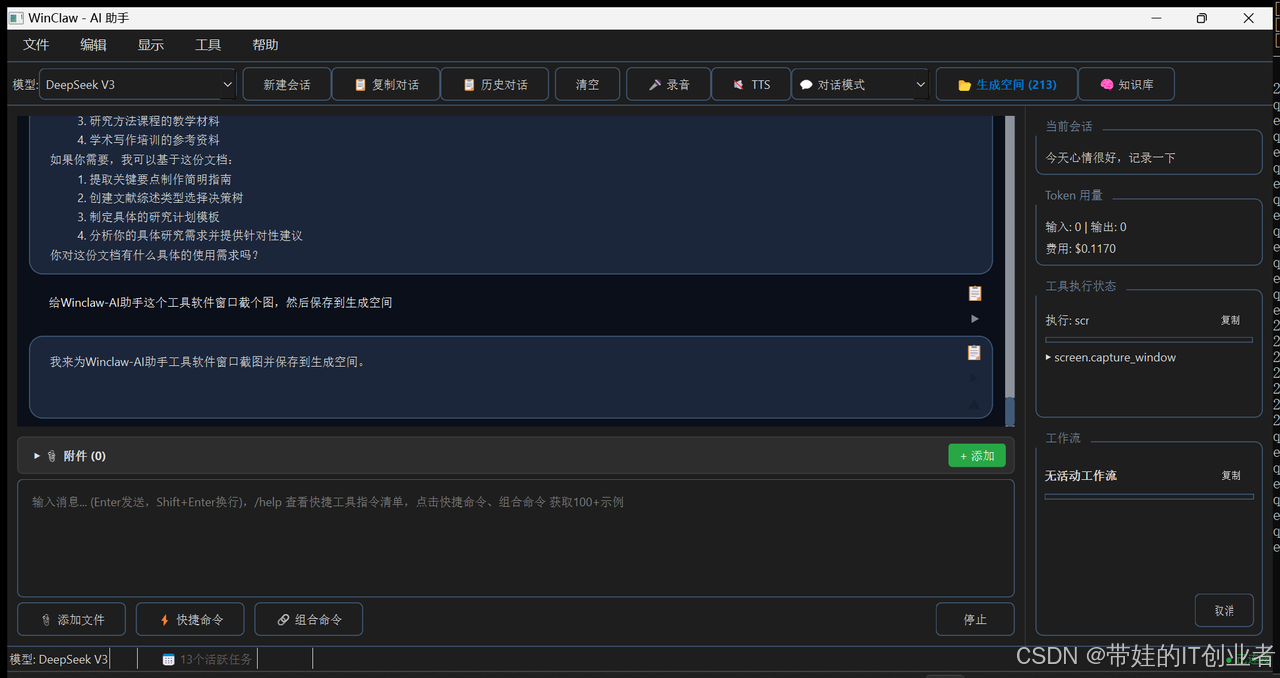

关于 WinClaw

WinClaw 是一款基于大语言模型的轻量级 Windows 桌面 AI 助手,能够通过自然语言指令帮助用户完成各种 Windows 操作任务。支持多模型接入(DeepSeek、OpenAI、Claude 等),提供 CLI 终端模式和 GUI 图形界面模式。

🔗 项目地址:https://github.com/wyg5208/WinClaw.git

为什么 OpenClaw 不会陷入这个陷阱?

| 架构特性 | WinClaw(危机中) | OpenClaw(从容应对) |

|---|---|---|

| 意图识别 | 关键词匹配,易出错 | 模型驱动 + 设备检测 |

| 工具过滤 | 考虑中的"硬过滤"方案 | 分层权限过滤(detailKeys) |

| 错误处理 | 连续失败计数器 | 状态机 + 多级降级 |

| 回退机制 | 尚未设计 | 自动权限扩展 |

关键洞察:OpenClaw 的 tool-display.json 架构天然支持"渐进式"工具暴露——通过 detailKeys 约束参数范围,而非简单粗暴地过滤工具。这种设计既保证了安全性,又保留了灵活性。WinClaw 的"硬过滤"方案恰恰缺少了这种 nuanced 的平衡。

一、问题回顾:当AI"失忆"了

在深入讨论方案之前,让我们再次回顾那个令人崩溃的真实案例:

用户:“用 mcp_browserbase-csdn 帮我在 CSDN 写一篇博客”

AI的回应:

AI: 我来帮您在 CSDN 写一篇博客...

[调用: mcp_browserbase_session_create]

[调用: browser_navigate]

[调用: browser_observe]

AI: 看起来 API 有问题。让我先截图看看...

[调用: screen_capture] ← 偏离

AI: 我来帮你创建一个包含天气、诗歌和图片的文档...

[完全偏离用户意图!]

AI: ## 第一步:分解任务

1. 查询北京今天的天气信息

2. 创作一首关于春天的诗歌

3. 生成一张春天的图片

4. 将所有内容组合成Word文档

[调用: weather_get_weather] ← 完全无关!

[调用: image_generator_generate] ← 完全无关!

[调用: doc_generator_generate] ← 完全无关!

AI不仅调用了无关工具(weather、image_generator、doc_generator),还陷入了无限循环——同样的"分解任务→并行执行"流程重复了3次!

面对这种"工具滥用+意图偏离+循环失控"的三重灾难,团队的第一个反应是:那就只传递相关的工具,让AI"看不到"那些乱七八糟的工具!

二、初稿方案:直击痛点的"硬过滤"

1.1 核心设计思路

这个方案看起来完美:

- ✅ 直接解决工具数量过多问题

- ✅ 利用已有的意图识别机制

- ✅ 大幅减少Schema tokens

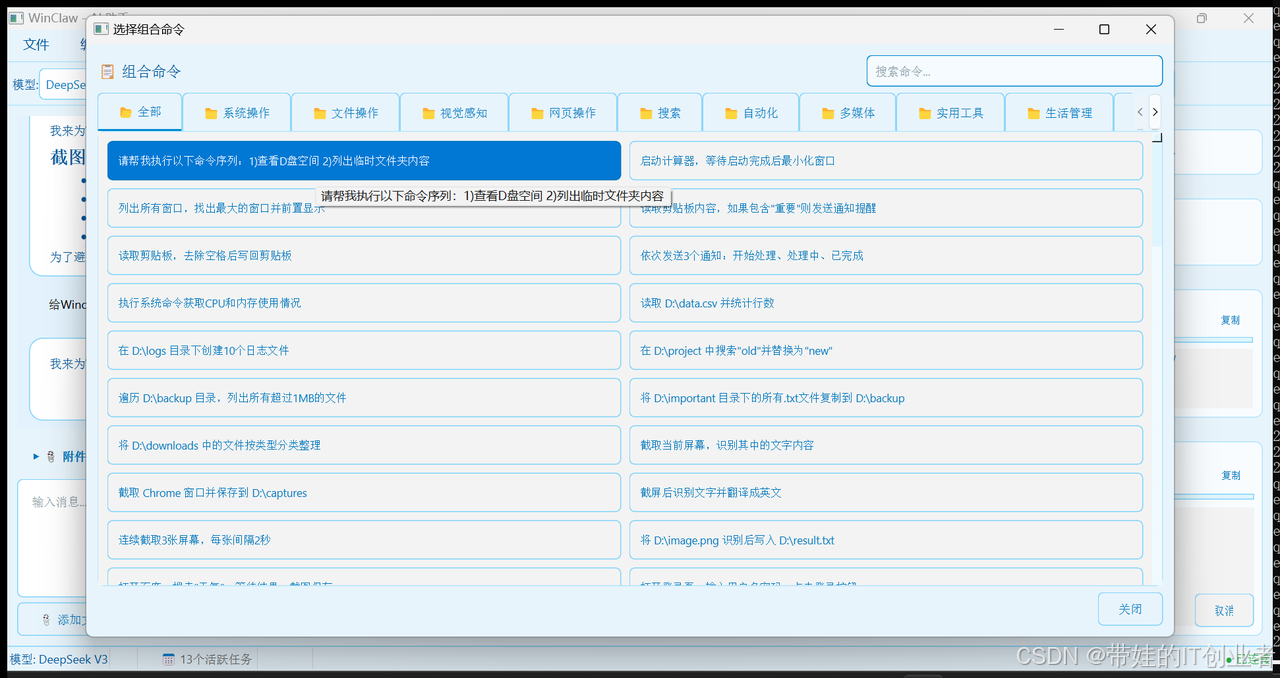

1.2 意图-工具映射表

我们设计了详细的映射关系:

INTENT_TOOL_MAPPING = {

"browser_automation": [

"browser", "browser_use",

"mcp_browserbase", "mcp_browserbase-csdn"

],

"document_assembly": [

"doc_generator", "image_generator",

"weather", "file"

],

"system_admin": [

"shell", "app_control", "screen"

],

"daily_assistant": [

"weather", "datetime_tool",

"calculator", "email"

],

}

理论上,每个意图只暴露5-15个工具,而不是60个。

1.3 预期收益测算

| 指标 | 当前(全量) | 优化后(过滤) | 改善幅度 |

|---|---|---|---|

| Schema tokens | ~15,000 | ~4,000 | -73% |

| 工具选择空间 | 60个 | 10-15个 | -75% |

| 上下文利用率 | 低 | 高 | 显著提升 |

二、配套措施:前置校验层

为了进一步保护系统,我们还设计了"工具调用前置校验层":

2.1 三重校验规则

class ToolCallValidator:

def validate(self, tool_calls: list, intent: str) -> ValidationResult:

# 规则1:相关性校验

for tc in tool_calls:

if tc.tool not in INTENT_TOOL_MAPPING.get(intent, []):

return ValidationResult(

status="REJECT",

message=f"工具 {tc.tool} 与当前任务无关"

)

# 规则2:批量限制

if len(tool_calls) > 3:

return ValidationResult(

status="REJECT",

message="单次调用工具数量超过限制(3)"

)

# 规则3:跨类别检测

categories = set()

for tc in tool_calls:

categories.add(get_tool_category(tc.tool))

if len(categories) > 2:

return ValidationResult(

status="REJECT",

message="跨类别工具调用过多"

)

return ValidationResult(status="PASS")

看似周全的设计,对吧?

三、方案评审:一针见血的质疑

当方案提交评审时,一位资深工程师提出了一个致命问题:

“如果意图识别错了怎么办?”

3.1 场景推演

因为关键词"博客"] C -->|正确识别| -----------------------^ Expecting 'SQE', 'DOUBLECIRCLEEND', 'PE', '-)', 'STADIUMEND', 'SUBROUTINEEND', 'PIPE', 'CYLINDEREND', 'DIAMOND_STOP', 'TAGEND', 'TRAPEND', 'INVTRAPEND', 'UNICODE_TEXT', 'TEXT', 'TAGSTART', got 'STR'

识别错误 → 过滤掉正确工具 → 任务必然失败

这是一个单点故障:意图识别的错误会级联传递,且无法恢复。

3.2 更多边界场景

评审中又举出了更多问题场景:

| 用户请求 | 可能的错误识别 | 后果 |

|---|---|---|

| “整理下载文件夹并生成报告” | 只识别为file_operation | 缺少doc_generator |

| “截个屏发邮件给我” | 只识别为system | 缺少email工具 |

| “查天气写文档” | 只识别为daily_assistant | 缺少doc_generator |

核心问题:用户的请求往往是多意图组合的,但简单的关键词匹配难以覆盖。

四、深入分析:级联风险的可怕之处

4.1 风险传导链

这不是概率问题,而是必然结果:

- 意图识别准确率不可能100%

- 一旦错误,后续无法补救

- 模型"看不到"被过滤的工具,即使想用也用不了

4.2 与传统过滤的区别

| 过滤类型 | 可恢复性 | 示例 |

|---|---|---|

| 搜索结果过滤 | ✅ 可翻页 | 漏掉的结果在下一页 |

| 推荐系统过滤 | ✅ 可搜索 | 找不到可以主动搜索 |

| 工具Schema过滤 | ❌ 不可恢复 | 模型根本不知道工具存在 |

工具过滤的不可逆性是其最大风险。

五、方案的另一个漏洞:工具依赖链

评审中还发现了另一个被忽略的问题:

5.1 隐藏的依赖关系

如果只返回 doc_generator 和 weather,缺少 file 工具,文档生成可能失败。

5.2 需要定义依赖关系

{

"doc_generator": {

"depends_on": ["weather", "image_generator", "file"],

"description": "文档生成器需要内容来源工具"

}

}

初稿方案完全忽略了这一点。

六、方案调整:增加兜底机制

面对质疑,我们尝试为方案增加"兜底机制":

class SafeToolManager:

def __init__(self):

self.consecutive_failures = 0

self.fallback_threshold = 2

def get_tools(self, intent: str) -> list:

# 正常模式:过滤工具

if self.consecutive_failures < self.fallback_threshold:

return filter_tools_by_intent(intent)

# 兜底模式:返回全量工具

return get_all_tools()

def report_failure(self):

self.consecutive_failures += 1

def report_success(self):

self.consecutive_failures = 0

但这又带来了新问题:

- 需要连续失败2次才能触发兜底

- 用户已经等待了很长时间

- 体验仍然受损

七、关键反思:设计原则的缺失

这次方案评审让我们意识到,我们缺少一套设计原则来指导决策。

7.1 核心矛盾

减少工具数量

↓

降低选择难度 ←→ 可能过滤掉正确工具

↓

提高决策质量 ←→ 可能导致任务失败

7.2 需要回答的问题

- 引导 vs 限制:我们应该"引导"模型选择正确工具,还是"限制"模型的选项?

- 效率 vs 安全:优化效率更重要,还是确保任务成功更重要?

- 激进 vs 渐进:一步到位解决问题,还是渐进式优化?

总结

初稿方案的失败揭示了系统设计中的一个关键教训:

当优化措施可能导致"正确路径被堵死"时,必须极其谨慎。

核心洞察:

- 硬过滤存在不可逆的单点故障风险

- 意图识别错误会级联传递

- 工具之间可能存在隐藏的依赖关系

- 需要设计可回退的兜底机制

下一篇,我们将展示二次评审如何更深入地剖析方案的漏洞,并推动我们寻找更稳妥的解决路径。

系列文章预告:

- 第3篇:《再评估:当方案暴露出隐藏漏洞》

- 第4篇:《第三次评估:渐进式暴露的艺术》

- 第5篇:《落地实战:TaskTrace追踪与工具纳入规范》

更多推荐

已为社区贡献47条内容

已为社区贡献47条内容

所有评论(0)