【RAG技术】- 什么?你不了解RAG?一文带你弄懂

摘要 RAG(检索增强生成)技术将大语言模型与外部知识库结合,通过检索相关信息辅助生成更准确的回答。其核心流程包括文档分块、向量化、检索和生成,其中文档分块策略直接影响效果。中文场景下需选择合适的Embedding模型,并采用混合检索(语义+关键词)和重排序提升精度。评估时需关注检索和生成质量,使用RAGAS框架进行全面分析。进阶方案包括Agentic RAG(具备自我优化能力)和Multimod

RAG技术全解析:从基础到高阶的三大进化之路

一、RAG核心知识点体系重构

1. RAG是什么?一个会“开卷考试”的AI考生

专业术语解释

RAG(Retrieval-Augmented Generation,检索增强生成)是一种将大语言模型(LLM)与外部知识库相结合的技术架构。它允许模型在生成回答前,先从动态更新的知识源中检索相关信息,再基于这些信息进行推理和输出 [1]。该机制有效缓解了传统LLM因训练数据固化而导致的幻觉、时效性差及私有数据不可用等问题。

大白话解读

以前的大模型像是个死记硬背的学生,考啥靠运气;而RAG呢?它是考场里唯一被允许带小抄的选手——不是作弊,是合法查资料!你说它聪明吧,其实它只是懂得“不会就翻书”这个朴素真理。

生活化类比案例

你问:“五一北京哪里好玩?”

传统AI可能答:“故宫、长城。”

RAG则像刚刷完马蜂窝攻略的本地通,告诉你:“环球影城夜场灯光秀超赞,但得提前预约,不然排队两小时起步。”

2. RAG七步走:从文档到答案的完整旅程

专业解释

RAG系统的工作流程可分为三个阶段:索引构建(Indexing)→ 检索(Retrieval)→ 生成(Generation),共包含七个标准步骤。这一过程确保了知识的高效组织与精准调用,是实现高质量问答的基础。

大白话解读

这就像一条智能工厂流水线:原料进来 → 切块贴标 → 入库 → 接单取货 → 质检打包 → 发货。每一步都井然有序,绝不让“残次品”流入下一道工序。

生活案例

类比图书馆借书流程:你想写一篇关于新能源汽车的报告 → 先去图书馆找相关书籍 → 复印重点章节 → 整理笔记 → 最终写出论文。整个过程就是一次典型的RAG式学习。

3. 文档怎么切?别让AI读“断章取义”

专业解释

文档分块(Chunking)是RAG系统的基石环节,直接影响后续检索效果。常见的策略包括固定长度切分、句子边界分割、滑动窗口、层次切片等六种方式,需根据文档类型和应用场景灵活选择。

大白话解读

切文档就像切香肠——刀法不对,一口咬下去全是肥肉或全是瘦肉,体验直接拉胯。我们追求的是每一口都有滋有味,上下文不断裂。

生活案例

切披萨 vs 切蛋糕:

- 披萨讲究均匀切,每人一块,公平分配 → 类似固定长度分块

- 蛋糕可以按口味分区切,巧克力多给小朋友,奶油少点给长辈 → 就像自适应切片,照顾不同需求

from langchain.text_splitter import RecursiveCharacterTextSplitter

splitter = RecursiveCharacterTextSplitter(

chunk_size=512,

chunk_overlap=100, # 滑动窗口重叠,防止上下文断裂

separators=["\n\n", "\n", "。", "!", "?"]

)

chunks = splitter.split_text(document)

print(f"成功切出 {len(chunks)} 个知识块 🎉")

4. Embedding选哪个?中文场景避坑指南

专业解释

Embedding模型负责将文本转换为高维向量,是语义理解的核心。主流模型如text-embedding-v4、BGE-large-zh、M3E等,在语言支持、维度、部署方式等方面各有侧重,需结合业务需求综合评估。

大白话解读

选Embedding就像挑翻译官——有的贵但准(OpenAI),有的便宜但漏译(轻量级开源),还有的专精中文(BGE)。你要做的,就是找到那个“说得清、听得懂”的靠谱伙伴。

生活案例

出国点餐时:

- 用谷歌翻译APP → 相当于API调用,方便快捷但依赖网络

- 找本地导游帮忙 → 私有化部署,安全可控但成本更高

| 模型名称 | 厂商 | 维度 | 语言支持 | 部署方式 | 适用场景 |

|---|---|---|---|---|---|

| text-embedding-v4 | 阿里通义 | 512–1024 | 中文优化 | API调用 | 中文为主,性价比高 |

| BGE-large-zh | 智源 | 1024 | 中文优秀 | 私有化部署 | 安全要求高的企业系统 |

| M3E | Moka | 768 | 开源轻量 | 私有化部署 | 资源有限的小团队 |

5. 混合检索+重排序:让AI不再“捡了芝麻丢了西瓜”

专业解释

单一向量检索对精确关键词不敏感,易遗漏关键信息。因此常采用混合检索(Hybrid Search)策略,融合语义检索与BM25关键词检索,并通过Cross-Encoder进行重排序(Rerank),显著提升最终效果。

大白话解读

光靠语感不行,还得查字典;初筛20个答案,再请专家打分选出TOP3。这就叫“广撒网 + 精筛选”,效率与精度兼得。

生活案例

招聘流程:HR用ATS系统初筛简历(关键词匹配)→ 面试官终面打分(语义理解)→ 综合评定录用。这才是真正的“人岗匹配”。

# 使用BGE-Reranker精排

reranker = Reranker(model_name="BAAI/bge-reranker-large")

top_docs = reranker.rerank(query, candidates, top_n=3)

print("🏆 最终入选的三位选手已出炉!")

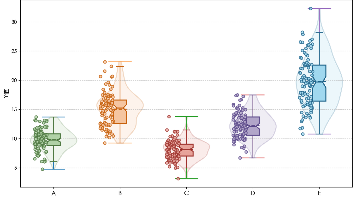

6. 如何评估你的RAG系统?

专业解释

RAG系统的评估需兼顾检索质量与生成质量。常用指标包括Recall@K、Precision@K、MRR等,同时推荐使用RAGAS框架进行端到端自动化评估,涵盖忠实度(Faithfulness)、答案相关性(Answer Relevancy)等核心维度 [1]。

大白话解读

不能只看结果对不对,还要看它是不是瞎蒙的。就像老师批卷子,不仅要看答案是否正确,还得检查解题过程有没有依据。

生活案例

老师批改作文:

- 只写“很好” → 不够客观

- 标注“此处论据不足”“引用来源缺失” → 才是真·反馈

from ragas import evaluate

result = evaluate(dataset, metrics=[faithfulness, answer_relevancy])

print("📊 评估报告已生成,请查收~")

二、三大拓展方案设计

方案一:Agentic RAG —— 让RAG学会自我进化

原理说明

Agentic RAG引入智能体(Agent)机制,使系统具备自主规划、反思与迭代能力。通过收集用户修正行为,自动分析失败模式并优化Prompt或检索策略,形成闭环学习机制。

适用场景分析

适用于需持续迭代的复杂任务,如周报模板优化、科研文献综述生成等。其优势在于能主动识别知识缺口并发起二次检索,避免“一次性作答”的局限性。

生活案例

你每次改周报,系统都在悄悄记笔记。一周后它突然说:“我发现您总把金额写成‘50000’,建议改成‘50,000.00元’。”

于是它自动更新了写作模板——这不是科幻,这是AI版职场成长日记。

class AgentFeedbackLoop:

def collect_feedback(self, output, correction):

# 存储错误样本

self.db.save({"before": output, "after": correction})

def analyze_failures(self):

# 调用LLM分析共性问题

return llm("总结这100条修改背后的规律")

方案二:Multimodal RAG —— 不止能看文字,还能“读图”

原理说明

Multimodal RAG整合CLIP、通义VL等多模态模型,实现图文联合检索。支持图像、表格、PDF等多种格式输入,突破纯文本限制,适用于医疗影像、金融图表等复杂场景。

适用场景分析

特别适合需要跨模态理解的任务,如医生上传X光片询问肺炎迹象、工程师拍照设备故障部位获取维修手册等。

生活案例

医生上传一张X光片问:“这个阴影是不是肺炎?”

系统不仅检索“肺炎影像特征”的文本资料,还比对该图与历史病例图像的相似度,综合判断风险等级。

| 模态 | 处理方式 | Embedding模型 |

|---|---|---|

| 图片 | 向量化 | CLIP, 通义VL |

| 表格 | 转Markdown/JSON | Tabular-BERT |

| OCR+图表分离 | PaddleOCR | |

| 视频 | 抽帧+语音转文字 | Whisper + CLIP |

方案三:Hybrid RAG —— 动态组合最优检索路径

原理说明

Hybrid RAG根据问题类型动态切换检索模式(向量/关键词/图谱),实现“因地制宜”的响应策略。例如,价格查询走关键词,概念推理走语义+图谱,全面提升准确率与召回率。

适用场景分析

适用于混合型知识服务系统,如企业内部知识库、智能客服平台等。能够根据不同请求自动路由至最合适的检索通道。

生活案例

你问:“iPhone 15多少钱?” → 系统启用关键词检索,精准命中价格表;

你问:“苹果公司最近有什么创新?” → 启动向量检索+图谱遍历,综合新闻、财报、专利信息生成摘要。

🔧 架构优势:

- 多路并行,降低漏检风险

- 加权融合,提升Top-1命中率

- 可插拔设计,易于扩展新策略

- 自动识别问题类型,切换模式

🚀 总结金句:没有最好的检索,只有最适合的组合。

三、结尾互动与版权声明

💬 灵魂拷问来了:

你在项目中用过哪种分块策略?踩过哪些坑?欢迎在评论区分享你的“血泪史”!

📢 郑重声明:

本文为 Java后端的Ai之路 原创,转载请注明来源。禁止任何形式的未授权转载与去水印复制。尊重原创,从你我做起。

更多推荐

已为社区贡献47条内容

已为社区贡献47条内容

所有评论(0)