基于CNN的垃圾邮件分类系统Python实现:DL00222项目剖析

最后一个全连接层则是“决策器”,给出最终的分类结果。num_classes = 2 # 假设分为垃圾邮件和正常邮件两类这一层将的输入转化为,最终输出的就是每个样本属于不同类别的概率,我们可以根据这个概率来判断邮件是否为垃圾邮件。DL00222-基于CNN的垃圾邮件分类系统python实现(1) 初始化随机词向量:将每封邮件的词id列表转化为词嵌入矩阵,(train_size, seq_length

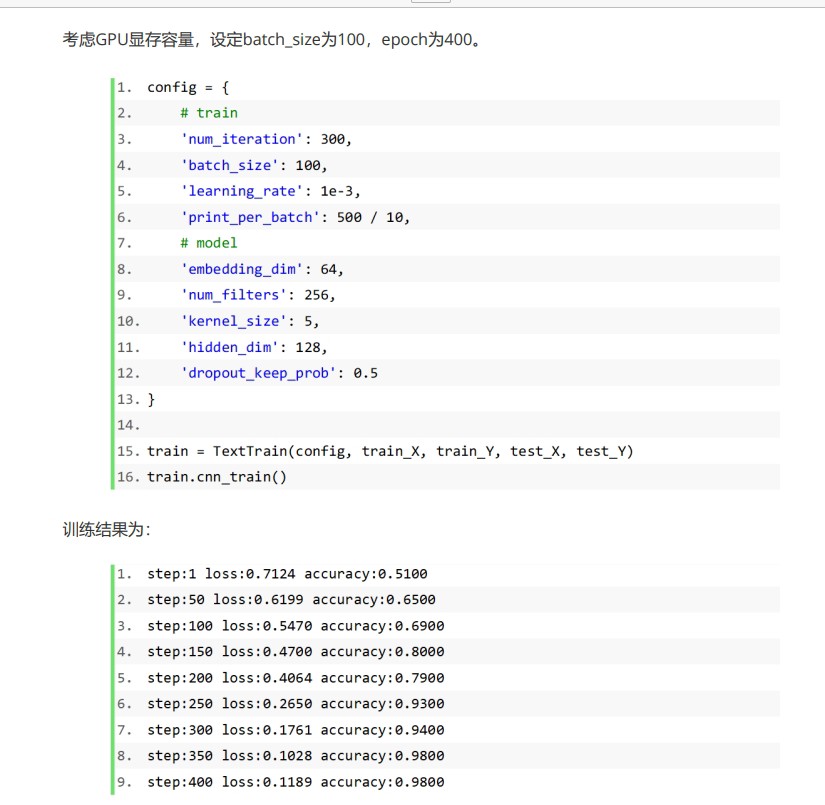

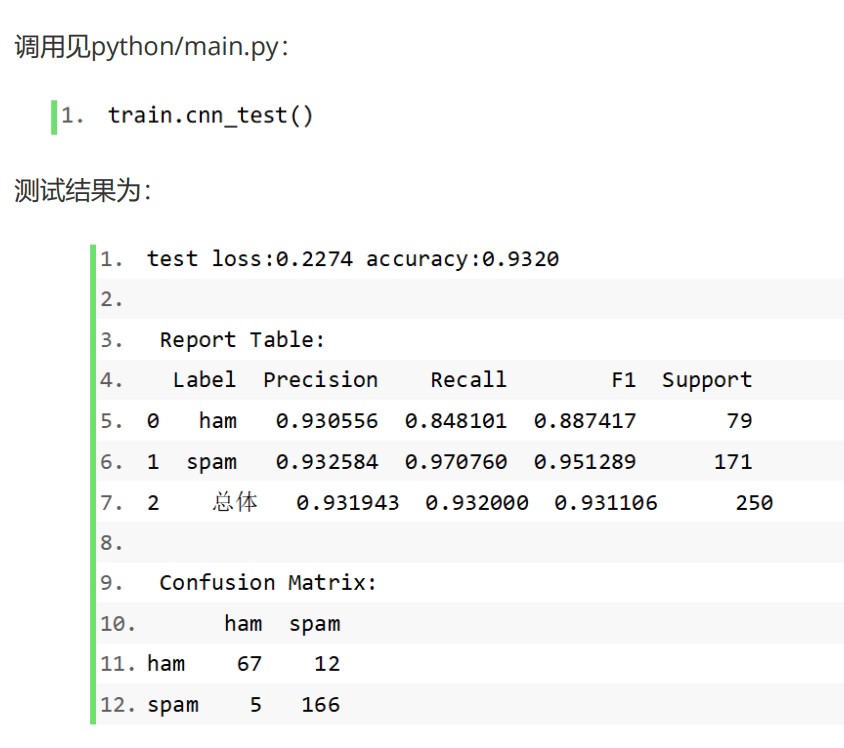

DL00222-基于CNN的垃圾邮件分类系统python实现 (1) 初始化随机词向量:将每封邮件的词id列表转化为词嵌入矩阵,(train_size, seq_length)->(train_size, seq_length, embedding_dim)。 (2) CNN卷积层:Conv1d,设定输入通道数、输出通道数和核大小,(train_size, embedding_dim, seq_length)->(train_size, num_filters, conv(seq_length))。 (3) Max Pooling最大池化层:(train_size, num_filters, conv(seq_length))->(train_size, num_filters, 1),取切片转化为(train_size, num_filters)。 (4) 全连接层:设定隐藏层维度,(train_size, num_filters)->(train_size, hidden_dim)。 (5) Dropout层:设定保留概率。 (6) relu激活函数层。 (7) 全连接层:(train_size, hidden_dim)->(train_size, num_classes)。

在当今信息爆炸的时代,垃圾邮件如同恼人的苍蝇,严重影响我们的工作和生活。基于卷积神经网络(CNN)的垃圾邮件分类系统应运而生,它能有效地帮我们识别并过滤掉这些垃圾信息。今天,咱们就一起来看看这个系统在Python中是如何实现的。

初始化随机词向量

首先,我们要把每封邮件的词id列表转化为词嵌入矩阵。这个过程就像是给每个词找一个合适的“座位”,让它们在矩阵中有自己独特的位置。

import numpy as np

# 假设这里有一个简单的词id列表,这里只为了演示,实际可能从邮件文本处理得到

word_id_list = [1, 2, 3, 4, 5]

train_size = 1

seq_length = len(word_id_list)

embedding_dim = 100

# 随机初始化词嵌入矩阵

embedding_matrix = np.random.rand(train_size, seq_length, embedding_dim)这里通过np.random.rand随机生成了一个形状为(trainsize, seqlength, embeddingdim)的矩阵,对应从(trainsize, seqlength)到(trainsize, seqlength, embeddingdim)的转换,每一个词id都被映射到了一个embedding_dim维的向量空间中。

CNN卷积层

接下来是卷积层,这里使用Conv1d。它就像是一个“扫描器”,在词嵌入矩阵上滑动,寻找其中隐藏的模式。

import torch

import torch.nn as nn

# 假设输入通道数为embedding_dim,输出通道数为num_filters,核大小为kernel_size

input_channels = embedding_dim

num_filters = 128

kernel_size = 3

conv_layer = nn.Conv1d(input_channels, num_filters, kernel_size)

# 假设这里已经把之前的numpy数组转为torch张量,并且维度调整为符合conv1d输入要求

input_tensor = torch.randn(train_size, input_channels, seq_length)

output = conv_layer(input_tensor)在这段代码中,nn.Conv1d定义了卷积层,输入通道数是embeddingdim,也就是之前词嵌入向量的维度。输出通道数numfilters可以理解为我们要找的模式的种类数。kernelsize就是扫描器的“窗口”大小。输入张量经过卷积层后,形状从(trainsize, embeddingdim, seqlength)变为(trainsize, numfilters, conv(seqlength)),这里conv(seqlength)是卷积操作后序列长度的变化结果,由核大小等因素决定。

Max Pooling最大池化层

最大池化层则像是一个“筛选器”,从卷积后的结果中选出最重要的信息。

pooling_layer = nn.MaxPool1d(kernel_size=conv(seq_length))

pooled_output = pooling_layer(output)

pooled_output = pooled_output.view(train_size, num_filters)这里nn.MaxPool1d进行最大池化操作,将(trainsize, numfilters, conv(seqlength))的张量变为(trainsize, numfilters, 1),然后通过.view方法将其转化为(trainsize, num_filters)。它只保留每个切片中的最大值,其他信息都被舍弃,这样可以减少数据量同时保留关键特征。

全连接层

第一个全连接层就像一个“信息整合器”,把之前提取到的特征进行综合。

hidden_dim = 256

fc1 = nn.Linear(num_filters, hidden_dim)

fc1_output = fc1(pooled_output)nn.Linear定义了全连接层,将(trainsize, numfilters)的输入转化为(trainsize, hiddendim),隐藏层维度hidden_dim是我们可以调整的超参数,它决定了模型对特征综合的能力。

Dropout层

Dropout层像是一个“随机偷懒器”,在训练过程中随机让一些神经元不工作,防止过拟合。

dropout_rate = 0.5

dropout_layer = nn.Dropout(dropout_rate)

dropout_output = dropout_layer(fc1_output)这里设定保留概率为0.5,意味着每次训练时,有一半的神经元会被随机“关闭”,不参与计算,这样可以让模型学习到更鲁棒的特征。

relu激活函数层

relu激活函数则给模型引入了非线性,让模型能学习更复杂的关系。

relu_layer = nn.ReLU()

relu_output = relu_layer(dropout_output)nn.ReLU实现了relu激活函数,对dropout_output进行操作,把小于0的值都变为0,大于0的值保持不变,使得模型能够学习到非线性的模式。

最后一个全连接层

最后一个全连接层则是“决策器”,给出最终的分类结果。

num_classes = 2 # 假设分为垃圾邮件和正常邮件两类

fc2 = nn.Linear(hidden_dim, num_classes)

final_output = fc2(relu_output)这一层将(trainsize, hiddendim)的输入转化为(trainsize, numclasses),最终输出的就是每个样本属于不同类别的概率,我们可以根据这个概率来判断邮件是否为垃圾邮件。

DL00222-基于CNN的垃圾邮件分类系统python实现 (1) 初始化随机词向量:将每封邮件的词id列表转化为词嵌入矩阵,(train_size, seq_length)->(train_size, seq_length, embedding_dim)。 (2) CNN卷积层:Conv1d,设定输入通道数、输出通道数和核大小,(train_size, embedding_dim, seq_length)->(train_size, num_filters, conv(seq_length))。 (3) Max Pooling最大池化层:(train_size, num_filters, conv(seq_length))->(train_size, num_filters, 1),取切片转化为(train_size, num_filters)。 (4) 全连接层:设定隐藏层维度,(train_size, num_filters)->(train_size, hidden_dim)。 (5) Dropout层:设定保留概率。 (6) relu激活函数层。 (7) 全连接层:(train_size, hidden_dim)->(train_size, num_classes)。

通过以上这些步骤,基于CNN的垃圾邮件分类系统在Python中就初步搭建完成啦。当然,实际应用中还需要更多的数据处理、模型训练和调优等步骤,但这已经为我们构建了一个基本的框架。希望这篇文章能让你对基于CNN的垃圾邮件分类系统的实现有更清晰的认识。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)