量化作业翻车实录:为什么先用Gemini打磨,再让Claude Code执行?(亲测有效)

我和 Gemini 讨论了整个 rolling beta 的正确实现方式之后,当 Claude Code 给我看它的 Plan 时,我才能看出"手写循环"这个问题。如果一个问题完全超出你的知识范围,你也看不出 AI 的错误——所以学习本身无可替代。如果直接打开 Claude Code,让它"帮我写这个数据处理程序"——结果往往是:生成了代码,跑起来了,但你完全不知道它做的对不对。如果我跳过了这一步

📌 这是「量化研究员的AI工作流实战手册」系列的第 1 篇,共 3 篇 本系列将带你完整了解 如何用多AI协作完成一个真实的量化金融项目

🗺️ 系列导航

| 篇号 | 主题 | 状态 |

|---|---|---|

| 👉 1/3 | 为什么我先用Gemini打磨,再让Claude Code执行 | 📖 本篇 |

| 2/3 | Claude Code三Agent架构:量化工程的三权分立 | 🔜 即将发布 |

| 3/3 | 数据漏洞排查实录:AI法医如何找回140万行数据 | 🔜 即将发布 |

🔥 量化作业 × 多AI协作:为什么我先用Gemini打磨,再让Claude Code执行?

💡 大多数人用AI写代码,结果越改越烂。真正的问题不是AI不够强——而是你还没搞懂让哪个AI做哪件事。

📍 背景:一个让我踩坑的量化作业

这学期的量化金融课布置了一个作业:构建一套 S&P 500 股票-期权的特征数据集。

看起来很清晰——对吧?

实际上,任务里藏着大量细节: ✅ 需要合并 CRSP 股票数据、OptionMetrics 期权数据、Fama-French 因子 ✅ 需要计算滚动 Beta、波动率曲面、Lag-1 特征 ✅ 需要处理 ID 映射(CRSP PERMNO ↔ OptionMetrics SECID) ✅ 数据量级:合并后接近 140 万行

如果直接打开 Claude Code,让它"帮我写这个数据处理程序"——结果往往是:生成了代码,跑起来了,但你完全不知道它做的对不对。

我在这个项目里用了一套双AI协作流程,最终把 140 万行数据准确率做到 99%+。这篇文章复盘这个流程的核心逻辑。

🎯 第一步:认清两个AI的核心差异

先说一个很多人忽视的事实:

🔑 Gemini 和 Claude Code 擅长的事情完全不同。不要用锤子拧螺丝。

Gemini 的优势:

- 上下文窗口超长(可以塞下完整对话+文档+代码)

- 非常适合"对话式规划"——反复打磨、不断迭代

- 适合跨文档综合理解(同时看多个数据文件的说明)

Claude Code 的优势:

- 直接在你的本地文件系统操作

- 可以真正运行代码、读文件、调试报错

- 擅长执行清晰定义好的任务

我踩过的坑:直接把模糊的任务丢给 Claude Code,让它自己去理解需求。结果: ⚠️ 它会做出"看起来合理"但金融逻辑有误的实现 ⚠️ Rolling Beta 写成了手写 for 循环(极慢,而且逻辑有误) ⚠️ 所有 .py 文件直接堆在项目根目录——维护噩梦

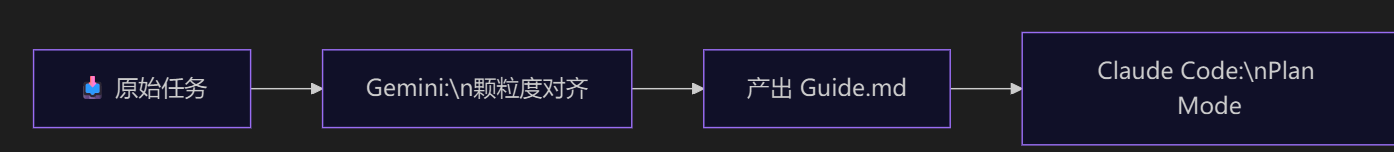

⚡ 第二步:用 Gemini 完成"认知对齐"

我把第一步叫做颗粒度对齐——在动手写任何一行代码之前,先把你和 AI 对问题的理解同步到同一层次。

整个对齐过程在 Gemini 里完成,分三轮:

❶ 第一轮:确认任务目的和教学意义

我不是让 Gemini "帮我写代码",而是先讨论:

-

为什么要做这个特征工程?金融直觉是什么? -

Lag-1 特征的意义是什么? -

Rolling Beta 的窗口为什么要 each year? -

OOS 测试能告诉我们什么?

👆 这一步很多人跳过,但它决定了后面所有代码的正确性方向。

❷ 第二轮:打磨实施方案

和 Gemini 来回讨论之后,我产出了一份 Guide.md——包含:

-

数据流程图(从原始文件到最终特征矩阵) -

关键易错点(比如:Winsorization 必须 by year,不能 global) -

ID 映射的质量控制标准(Link Score ≤ 2 才保留) -

文件结构规范( src/放代码,data/放数据)

🔑 这份 Guide 就是之后给 Claude Code 的"宪法"。它越清晰,Claude Code 出错的概率越低。

❸ 第三轮:让 Gemini 检查 Claude 的计划

Claude Code 进入 Plan Mode 之后生成了实施计划,我把计划发回给 Gemini:

"帮我审计这个计划,找出金融逻辑上的问题。"

Gemini 立刻找到了两个问题:

1️⃣ Rolling Beta:Claude 打算用手写循环,应该用 statsmodels.regression.rolling.RollingOLS

2️⃣ ID Mapping:Claude 没有严格限制 Link Score,高质量匹配率不够

这两个问题我自己当时没发现——正因为我们前期在 Gemini 里对齐了金融认知,我才有能力判断"Claude 的计划哪里有问题"。

👆 这是整个工作流的全貌。注意:Gemini 和 Claude Code 是交替出现的,不是用完一个换另一个。

📌 第三步:为什么"提升你自己的认知"才是核心

这里有一个反直觉的点:

🔑 你和 Gemini 打磨计划的过程,不只是在生产文档——你是在提升自己的认知水平。

我和 Gemini 讨论了整个 rolling beta 的正确实现方式之后,当 Claude Code 给我看它的 Plan 时,我才能看出"手写循环"这个问题。

如果我跳过了这一步,直接让 Claude Code 写代码——代码可能跑通,测试可能通过,但金融逻辑是错的,而我完全不会知道。

这就是为什么说:先和 Gemini 对齐认知,比节省那几分钟讨论时间重要得多。

⚠️ 一个警告:认知对齐的边界在于"你能力区域以内或附近的问题"。如果一个问题完全超出你的知识范围,你也看不出 AI 的错误——所以学习本身无可替代。

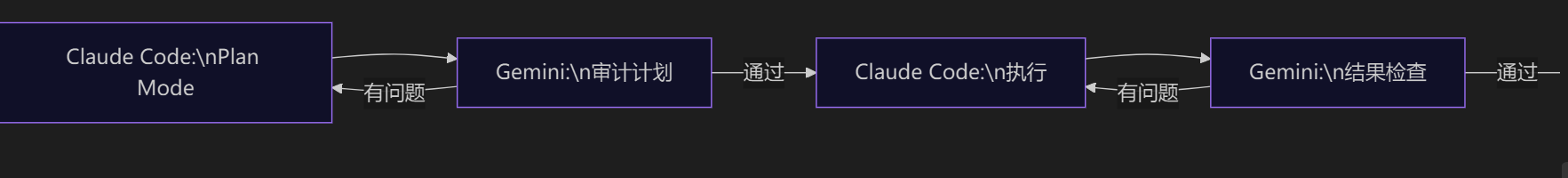

⚡ 第四步:交叉检查的复利效应

整个项目里,我用了多少次"Gemini 检查 Claude 的输出"?

6次。

-

检查 Claude 的实施计划(发现 Rolling Beta 问题) -

检查修正后的第二版计划(发现文字矛盾) -

检查 Git Release 计划 -

检查 Git Release 第二版计划 -

检查最终输出结果(发现样本量只有 10 万!) -

最终确认数据修复后的结果

每一次 Gemini 都找到了问题或提供了更好的实现思路。这不是 Claude 不够强——而是多视角交叉检查本身就能发现单一视角的盲点。

🔑 用两个不同的 AI 交叉检查,比用一个 AI 来回对话更有效——因为它们的训练方式不同,盲点也不同。

✨ 总结:关键收获

✅ 收获一:先用 Gemini 做"颗粒度对齐",产出 Guide 文档,再给 Claude Code 执行——质量远高于直接让 Claude Code 理解需求 ✅ 收获二:认知对齐不只是在生产文档,更是在提升你判断 AI 输出对错的能力 ✅ 收获三:Gemini 检查 Claude 计划,Claude 执行,Gemini 再检查结果——交叉验证的复利效应非常明显 ✅ 收获四:你和 AI 对话的质量取决于你自己的认知水平——AI 是放大器,不是替代品

💬 写在最后

这个工作流不是"用AI偷懒"——恰恰相反,它让我花了更多时间在理解问题上,而不是在调试代码上。

项目最后,数据覆盖率从最初的 6.4%(那个 76 行的测试文件)飙升到 99.1%(140 万行),不是因为我更聪明,而是因为这个流程强迫你在每一步都做对。

你现在用 AI 做项目的时候,有没有"Gemini 对齐 + Claude 执行"这样的分工?还是直接把所有事情丢给一个 AI?欢迎评论区聊聊你的工作流 💬

📌 系列进度: 1/3 ➡️ 下一篇:Claude Code 三 Agent 架构实战:量化工程的三权分立 — 架构师、测试工程师、首席开发如何分工,为什么 TDD 在量化金融里至关重要

觉得有用的话记得 ⭐收藏 + 👍点赞,方便追完整个系列~ 有问题欢迎评论区交流 💬

#干货分享 #AI工具 #量化金融 #Claude #Gemini #工作流 #学习方法 #金融工程

本文由 mdnice 多平台发布

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)