TongSIM:智能机器仿真通用平台

25年12月来自北京通研院(BIGAI)的论文“TongSIM: A General Platform For Simulating Intelligent Machines”。随着人工智能(AI)的快速发展,尤其是在多模态大语言模型(MLLM)领域,研究重点正从单模态文本处理转向更为复杂的多模态和具身人工智能领域。具身智能侧重于在逼真的模拟环境中训练智体,利用物理交互和动作反馈,而非传统的标注数

25年12月来自北京通研院(BIGAI)的论文“TongSIM: A General Platform For Simulating Intelligent Machines”。

随着人工智能(AI)的快速发展,尤其是在多模态大语言模型(MLLM)领域,研究重点正从单模态文本处理转向更为复杂的多模态和具身人工智能领域。具身智能侧重于在逼真的模拟环境中训练智体,利用物理交互和动作反馈,而非传统的标注数据集。然而,大多数现有的模拟平台设计仍然较为狭窄,各自针对特定任务量身定制。能够支持从低级具身导航到高级复合活动(例如多智体社交模拟和人机协作)等各种任务的通用训练环境仍然十分匮乏。为了弥补这一空白,推出TongSIM,一个用于训练和评估具身智体的高保真通用平台。TongSIM提供超过100个多样化的多房间室内场景以及一个开放式、交互丰富的户外城镇模拟,从而确保其能够广泛适用于各种研究需求,具有诸多实用优势。 TongSIM 的综合评估框架和基准能够精确评估智体的能力,例如感知、认知、决策、人机协作以及空间和社会推理。

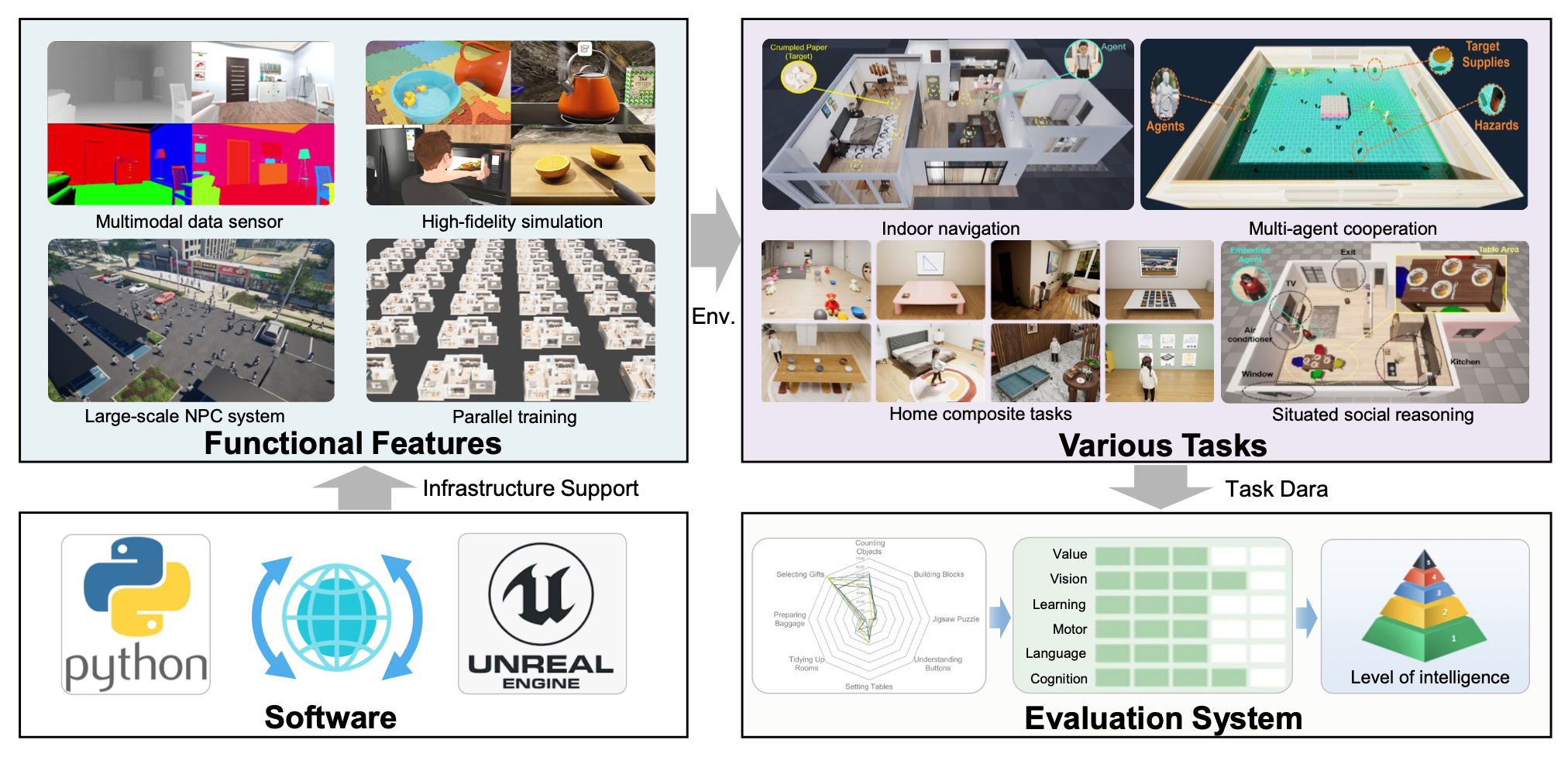

如图所示,TongSIM是一个高保真、通用的具身智能训练和测试平台,支持复杂的室内外场景仿真。在该平台上,构建多种多样的室内外场景。基于这些丰富多样的场景,提出一系列基准测试。这些基准测试涵盖智体广泛的能力,包括感知、认知、决策、人机协作、空间理解和社会理解,既包括低级任务(例如导航),也包括高级抽象任务(例如多智体游戏),从而形成一个覆盖整个智体能力谱的综合评估体系[31]。用户可以独立选择不同的基准测试来训练或测试特定智体,也可以将这些基准测试集成到通用智体中。具体而言,提出了5类基准测试任务,包括单智体任务、多智体任务、人机交互任务、初级家族复合任务和高级家族复合任务。

平台概述

TongSIM 是一个面向通用智能机器的全面且功能强大的仿真平台。该平台基于虚幻引擎 5.6 (UE5.6) 构建,并通过一系列自主开发的封装器和接口扩展引擎的原生功能。这些扩展功能支持强大的通信、调试和控制,能够有效管理高维仿真数据(包括场景语义、对象状态和智体元数据),从而简化智体的训练、测试和后续开发。

具体而言,TongSIM 平台包含 115 个不同的仿真场景,旨在支持各种任务。这些环境中填充数千个高保真对象。为了模拟逼真的拟人化行为模式,实现 28 种不同的交互功能,以满足具身智体和人类用户的交互需求。

TongSIM 提供丰富的语义标注以支持学习任务。为常用对象分配类别标签,从而实现高效的过滤和监督式训练。为了支持虚拟人和机器人的基于规则的自主导航,在室内和室外环境中都嵌入导航网格。此外,每个环境都配备场景管理器,为用户提供真实数据,包括场景元数据、分割图、生成点和导航信息。所有提供的资源均支持自定义二级标注,使研究人员能够根据特定需求定制数据。

TongSIM 的系统架构如图所示。为了便于集成各种智体和模型,TongSIM 提供一套全面的 Python 应用程序编程接口 (API)。这使得开发人员能够通过 Python 脚本对仿真环境和具身智体进行精细控制。主要功能包括:关卡管理(加载/卸载)、对象和avatar的动态实例化、角色操作、状态检索、摄像头控制、检索特定坐标附近的对象以及执行原生 UE 控制台命令。

典型的操作流程首先初始化 TongSIM UE 服务器,然后部署 TongSIM UE 客户端以建立连接。利用 Python 软件开发工具包 (SDK),用户可以操控场景、物体、NPC 和智能体,生成的视觉状态会被渲染并传输到 Web 界面,供用户和智能体查看。同时,TongSIM-Audio2Face 模块会为 NPC 和智体合成并同步面部表情和语音。此外,该平台还支持通过虚拟现实 (VR) 设备进行沉浸式交互,需要运行专用的 VR 客户端才能与服务器连接。

高保真场景

为了支持全面通用的智能体训练和测试,TongSIM平台提供了一系列丰富多样的仿真环境,涵盖不同保真度级别。具体而言,该平台包含115个室内环境,并扩展支持城市规模的室外场景。

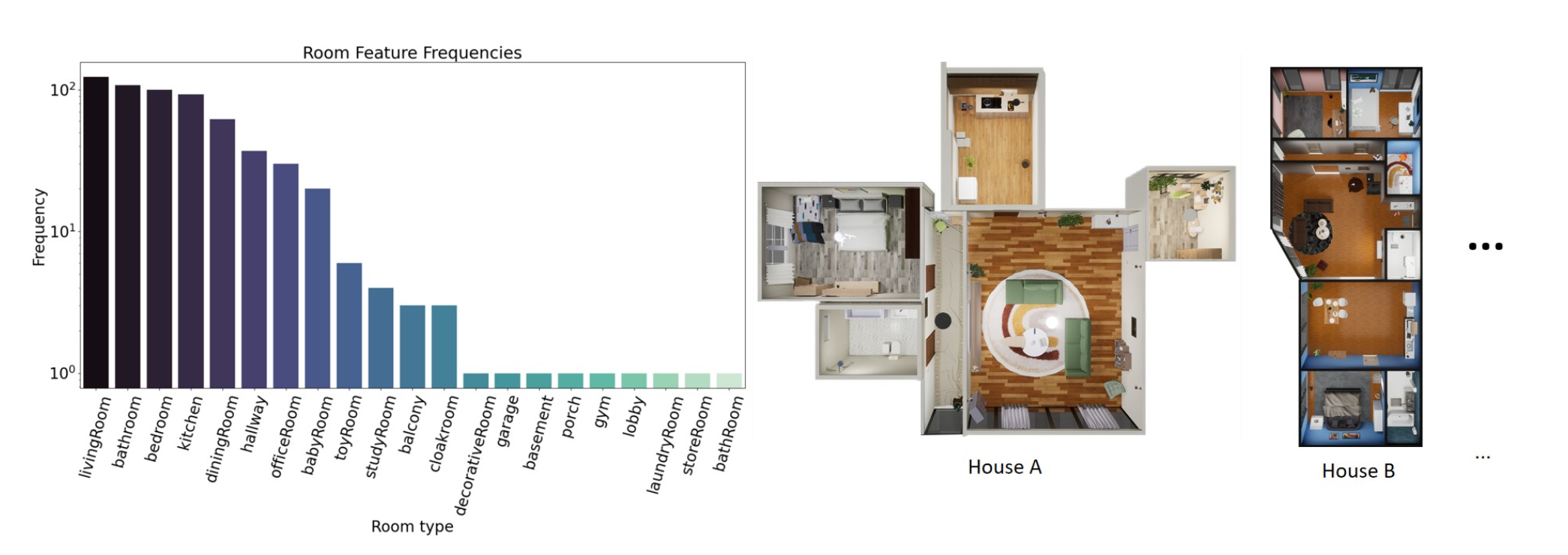

在室内场景方面,TongSIM的一大特色是能够支持复杂的混合型日常生活任务。为了确保语义真实性,聘请专业设计师手工精心设计空间布局和家具摆放,从而保证这些环境严格遵循拟人化的行为逻辑。基于这些专家设计的环境,开发一个自动化扩展流程,将场景库扩展至总共115个不同的场景。在功能上,这些环境涵盖了住宅单元、咖啡馆和零售商店等多种类别。在风格上,它们涵盖了广泛的建筑类型,从现代公寓和别墅到中世纪城堡、传统日式庭园和古典中式建筑,应有尽有。如图展示室内场景的详细统计数据。

对于室外场景,并未简单地拼接孤立的环境片段,而是构建了一个整体的虚拟都市,如图所示。这个统一的世界包含了多种功能区域,包括教育机构、住宅区、商业区和医疗设施,以及完善的道路网络和动态交通模拟系统。至关重要的是,这些功能区域在空间上是连续的。这种设计使得具身智体能够在不同的区域之间无缝导航,从而在长期训练和评估任务中保持上下文的连续性。

自定义任务和场景

为了增强 TongSIM 环境的可扩展性和多样性,开发一个自动化的程序生成流程,能够基于现有资源扩展场景库。该方法遵循由粗到精的策略。在粗粒度阶段,将现有的室内场景分解为独立的功能单元(例如,卧室、书房、厨房)。这些单元随后被随机重组,以合成新的布局配置,其中门框用作对齐锚点。在细粒度阶段,引入室内微观层面的变化。具体而言,对可移动物体的姿态施加随机扰动,并将一部分资源随机替换为从对象库中检索的同类资源。这一过程显著丰富室内装饰、空间布局和物体外观的多样性。最后,为了保证 TongSIM 平台的高保真度,采用人机协同验证步骤,由专业设计师对生成的场景进行过滤和微调,剔除任何语义不合理的实例。

除了自动化生成流程外,TongSIM 还配备一个强大的外部内容导入框架。该框架旨在与主流数字内容创作 (DCC)、计算机辅助设计 (CAD) 和 3D 扫描工作流程高度兼容,从而允许将现有资源无缝集成到平台的仿真任务和评估流程中。通过包括单元标准化、坐标系校准和光照配置在内的极简预处理流程,用户可以高效地导入自定义环境或第三方资源。目前,TongSIM 支持 glTF 2.0 (.gltf/.glb)、FBX Scene 和 Datasmith (.udatasmith) 等格式,全面覆盖行业标准的 3D 数据表示。

智体

TongSIM 提供多种智体,这些智体既可以作为 AI 模型在训练和评估过程中的具身模型,也可以作为 NPC 来辅助任务执行并增强环境逼真度。为了控制这些 NPC 的行为,TongSIM 实现了一种由基于规则的逻辑和 LLM 驱动的混合自动控制机制。

TongSIM 为这些智体配备了多功能性和多样化的视觉外观,允许外部 AI 模型通过 Python API 驱动具身模型。该平台支持的动作空间涵盖多个复杂程度,包括运动学基元(例如点头、挥手、转身)、指向特定坐标或物体的目标驱动行为(例如注视、点对点导航)以及基本的物体交互(例如拾取和放置、开关门、坐/站)。此外,该平台还支持涉及多步骤序列和高级语义的复杂复合活动,例如食用物品、倾倒液体、拖地、擦拭表面、阅读、切食物以及模拟睡眠或洗漱等日常活动。

平台特性

物理模拟

该平台利用虚幻引擎5内置的Chaos物理引擎,实现刚体动力学、流体模拟、破坏、布料等功能。这一特性使得TongSIM能够构建相对复杂的3D场景,支持对机器人等具身AI进行测试。同时,也尝试将另一个物理模拟库(NVIDIA Flex)集成到TongSIM中,该库使用统一的粒子来表示所有对象类型,从而实现不同模拟材质之间的无缝交互。

交互对象

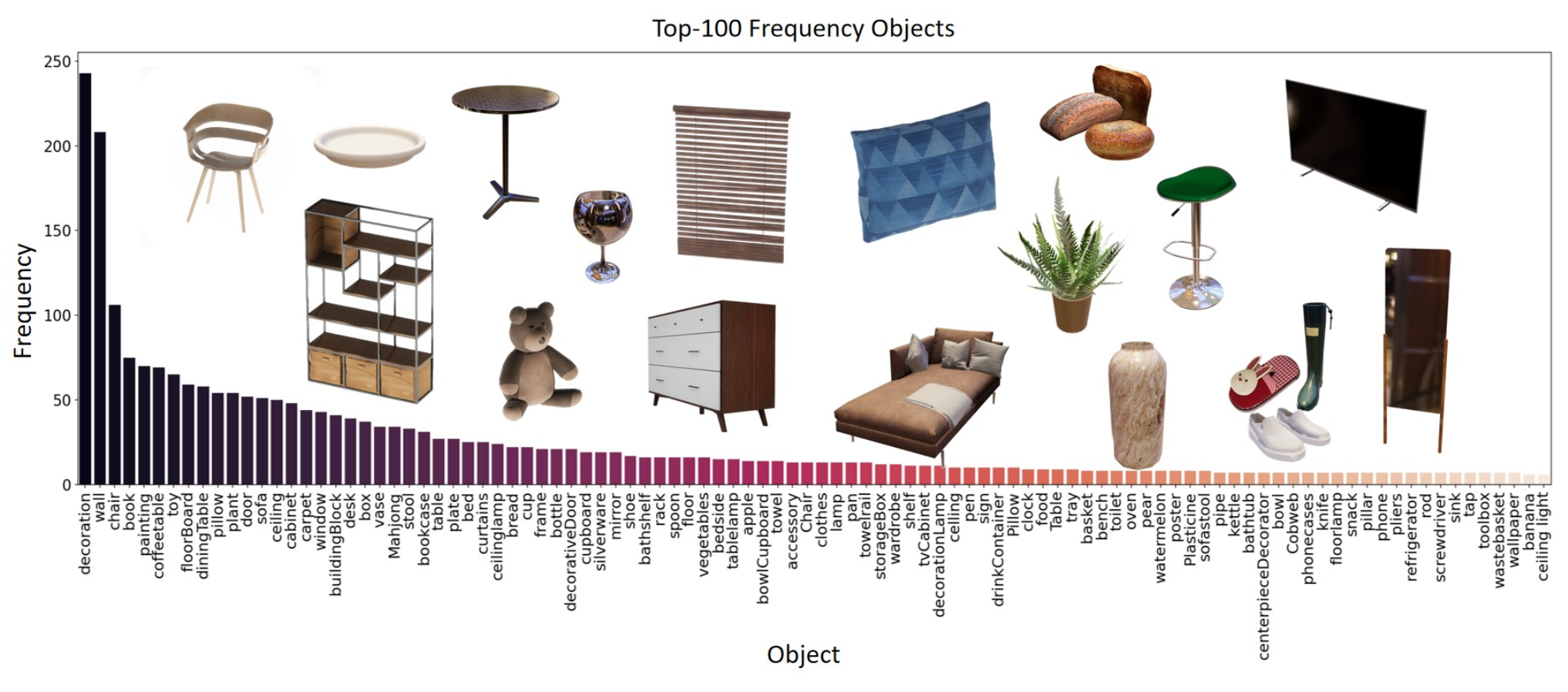

该平台构建一个基于协议的交互系统,通过交互能力等核心协议,实现了对模拟实体的精细控制。该平台支持28种不同的交互基元,并提供数千个可交互对象。如图展示 TongSIM 中部分对象的统计数据。该系统不仅涵盖实体生命周期管理(生成、销毁)和几何变换(旋转、缩放)等基本操作,还实现了机电逻辑和空间语义的深度仿真。

机电逻辑。该系统采用双层控制机制,将“通电状态”与“激活状态”解耦,从而精确模拟真实设备的操作原理。设备的最终运行状态由其物理电源和开关控制状态共同决定;因此,即使逻辑上已激活,如果实体缺少电源连接,则仍无法正常工作。这种设计忠实地再现了电气连接与设备操作之间的物理依赖关系。

空间交互锚点。为了应对复杂环境中细粒度操作的挑战,该平台定义语义标注的空间交互锚点。这些锚点引导末端执行器(例如,手、机械臂)精确定位功能区域(例如把手或按钮)的坐标,从而建立稳健的连接约束。此外,为了促进涉及多对象协同的复合交互(其中任务完成依赖于实体间特定的空间协调),系统引入了放置点的概念。这些点作为预定义的空间对接槽,可自动校准对象之间的相对位置,例如将杯子对准饮水机下方。

实验功能

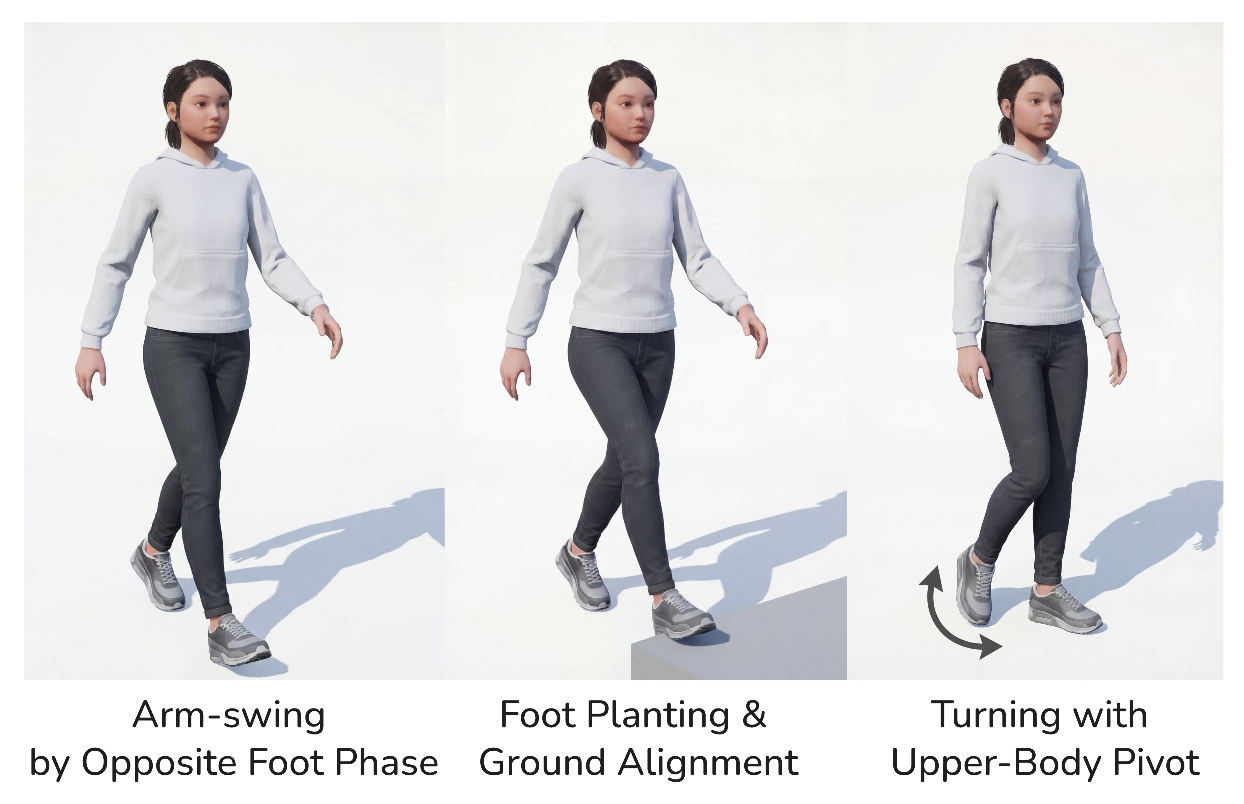

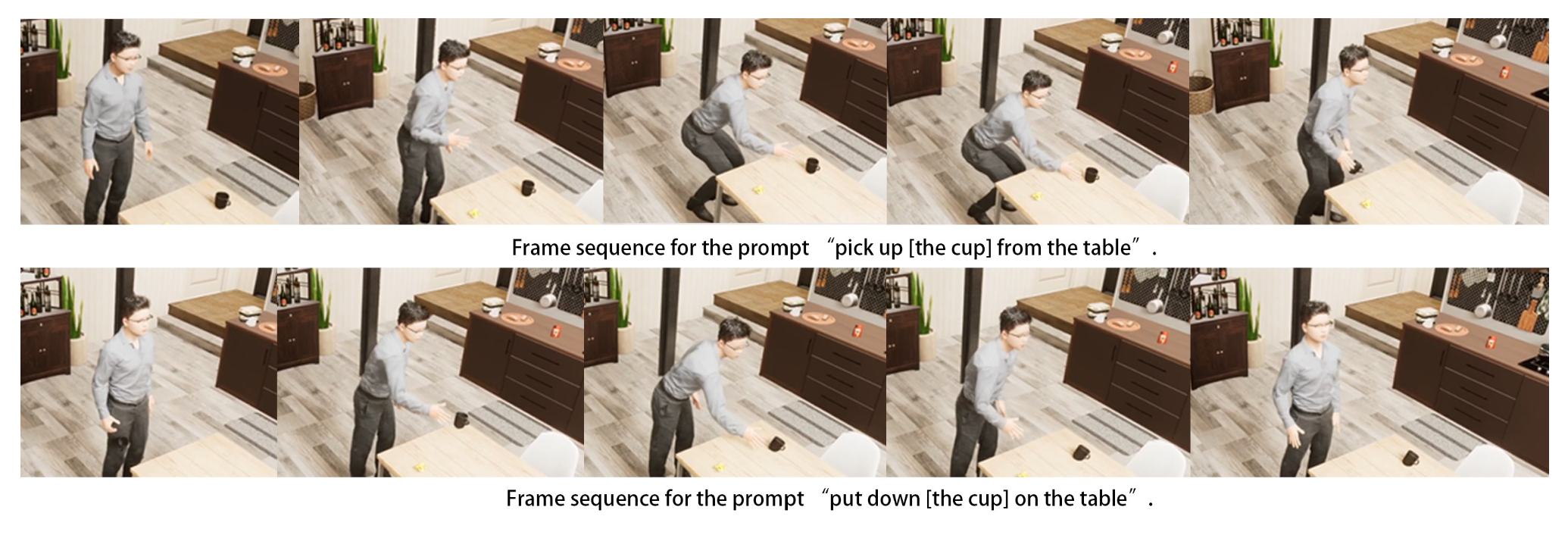

自动程序化动作。该模块为 TongSIM 平台中的人形智体提供无需动画素材的程序化运动和手臂关节功能。如图展示一个示例。利用控制装置和逆运动学 (IK),系统实时合成自然步态,并无缝适应各种骨骼结构和比例。它专为实时、大规模交互场景而设计。在 TongSIM 中,程序动画作为统一的基础运动层,与平台的任务、导航、物理和感知管线深度集成。通过支持参数化和可控随机性,该模块确保在各种场景下的稳定性,使用户能够在任意环境中快速部署智体并进行基准测试,而无需修改骨骼资源。

文本驱动运动生成。该模块实现一种基于扩散的运动生成模型,利用文本意图和环境体素图作为输入,实时合成可玩角色动画序列。如图展示一个典型的流程。该系统具有以下核心功能。(1) 文本驱动控制(自然语言 + 目标上下文):系统将自然语言表达式以及目标位置和交互对象封装在指令中。这些信息被统一并解析为模型可执行的意图和约束。 (2)环境感知(体素化几何语义):系统对角色当前位置和前两个轨迹点周围的体素网格进行实时采样。这构建表示可导航区域和障碍物的空间语义,以辅助模型规划和避障。(3)分段生成和流式播放:利用双向gRPC流式管道,系统实现“边播放边生成”机制。这确保后续序列的无缝连接和自动延续,从而实现低延迟的实时生成。(4)体素生成引擎:该组件提供全面的环境体素编码。它在前两个路径点周围构建体素体,执行几何占用并行采样,并生成随请求一起传输的位图字节流。(5)可控根运动融合:服务器控制垂直运动的节奏(例如,起伏和落脚时间),而水平位移和转向则由局部导航和控制模块动态规划。

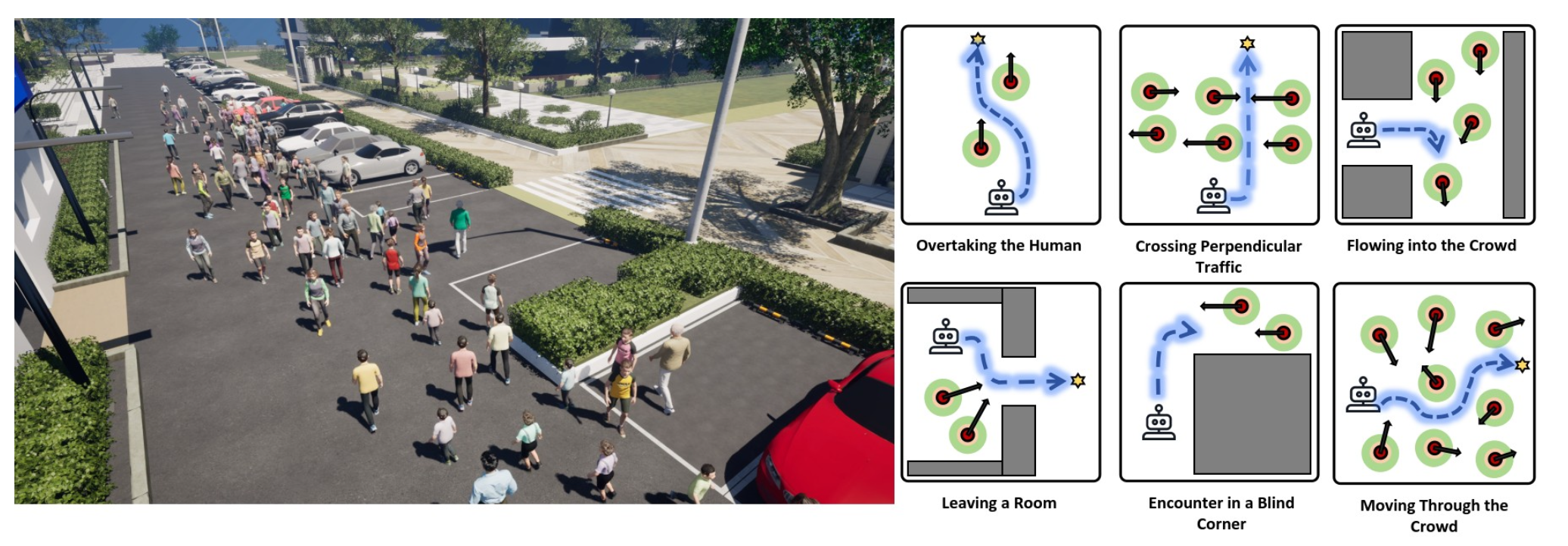

大规模人群仿真。为了支持人机混合任务(例如,社交导航、协作引导和交互式行为学习),如图所示,构建一个分层人群仿真模块,旨在同时实现个体层面的物理保真度和群体层面的行为多样性。(1)底层运动控制:社会力模型(SFM)和基于 A* 算法的可行域采样。基础层采用社会力模型,引入基于力的交互作用和环境约束,以实现局部空间中的自然避障和聚集行为。(2)高层决策和规划:在高层决策层,系统集成VLM来模拟人类智体的语义行为,并支持与机器人智体的交互和协作。该机制赋予人群模拟语义可控性和任务相关性,实现与机器人任务规划模块的语义对齐和智能协同。

从仿真到现实。为了促进逼真的机器人任务并弥合仿真到现实(Sim-to-Real)之间的差距,探索两种实验性的集成策略。第一种策略是用开源的 MuJoCo 引擎 [48] 替换 UE5 的原生物理引擎。在这种配置下,所有场景实体的物理仿真都委托给 MuJoCo,并将生成的状态更新与 UE5 的渲染管线同步,以进行视觉输出。这种方法将 MuJoCo 卓越的物理保真度和强大的机器人训练能力集成到 TongSIM 中,有效地弥补 UE5 原生动力学仿真的局限性。第二种策略引入对 Isaac Lab 的原生支持,将物理引擎和渲染引擎都迁移到 Isaac Sim。至关重要的是,这种集成保留 TongSIM 已建立的任务架构和智体接口。这种设计有助于与机器人社区无缝对接,从而实现机器人研究生态系统内大量工具链的复用。目前,这两种方法均处于实验阶段,旨在扩展 TongSIM 的兼容性,使其能够支持更广泛的智体类型,并为各种不同的实现方式构建统一的仿真框架。

并行训练

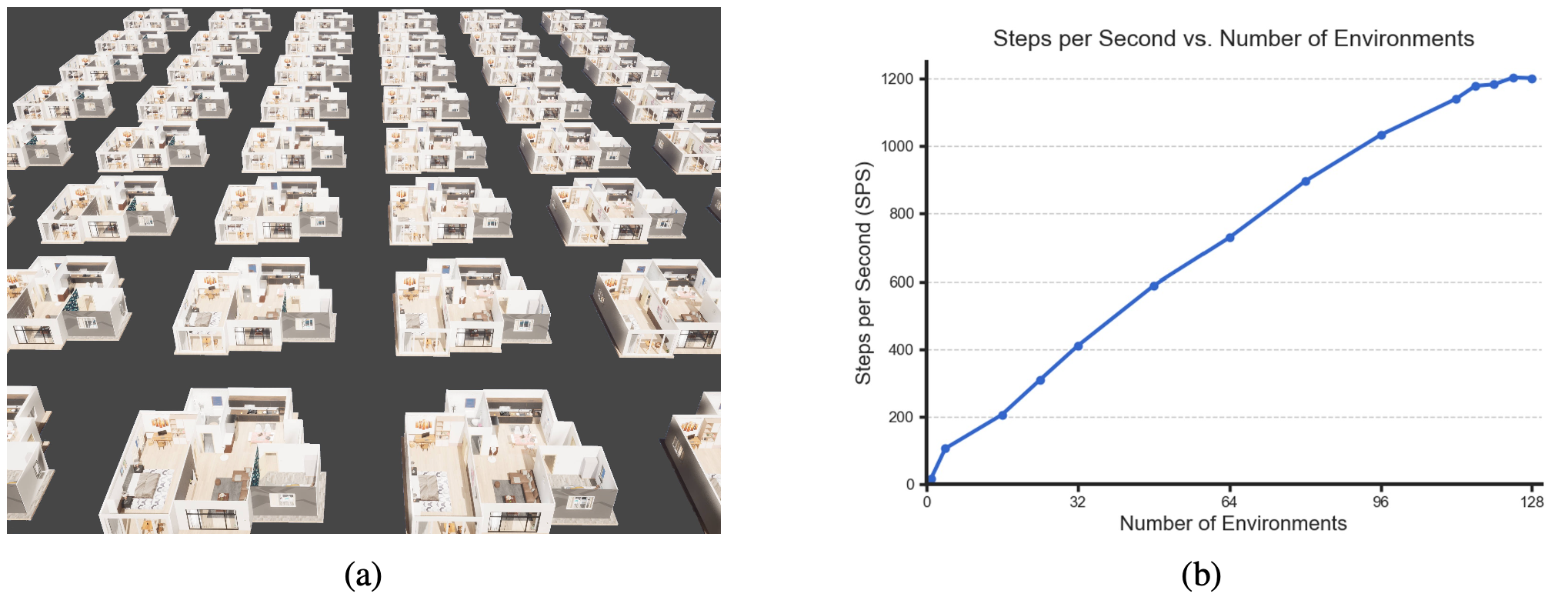

为了满足高效智体训练的需求并优化强化学习中的数据采样效率,TongSIM 引入一种多环境并行执行机制。该机制通过在单个用户设备实例中同时加载多个相互独立的子层级,使智体能够在每个时间步同时从不同的环境中获取交互数据,从而显著提高样本生成吞吐量。

为了评估该机制的性能,用“空间探索与导航”任务作为基准。实验在一台配备 Intel Core i9-13900KF CPU(24 核/32 线程,3.00 GHz)和 NVIDIA GeForce RTX 4090 GPU 的个人工作站上进行。实验结果表明,与单环境顺序执行相比,并行设置显著提高了以每秒步数衡量的交互吞吐量。具体而言,如图 (a)可视化48个并行机环境,而如图(b) 所示,采样率随着并行环境数量的增加呈现近乎线性的增长趋势。然而,在更高的并行度下,由于进程间通信和系统调度带来的开销,性能提升会逐渐趋于饱和。

TongSIM 的并行执行机制有效地提高样本采集效率,并最大限度地降低训练时间成本,为在复杂仿真环境中进行大规模强化学习奠定了坚实的基础。

更多推荐

已为社区贡献212条内容

已为社区贡献212条内容

所有评论(0)