PaddleX本地安装教程

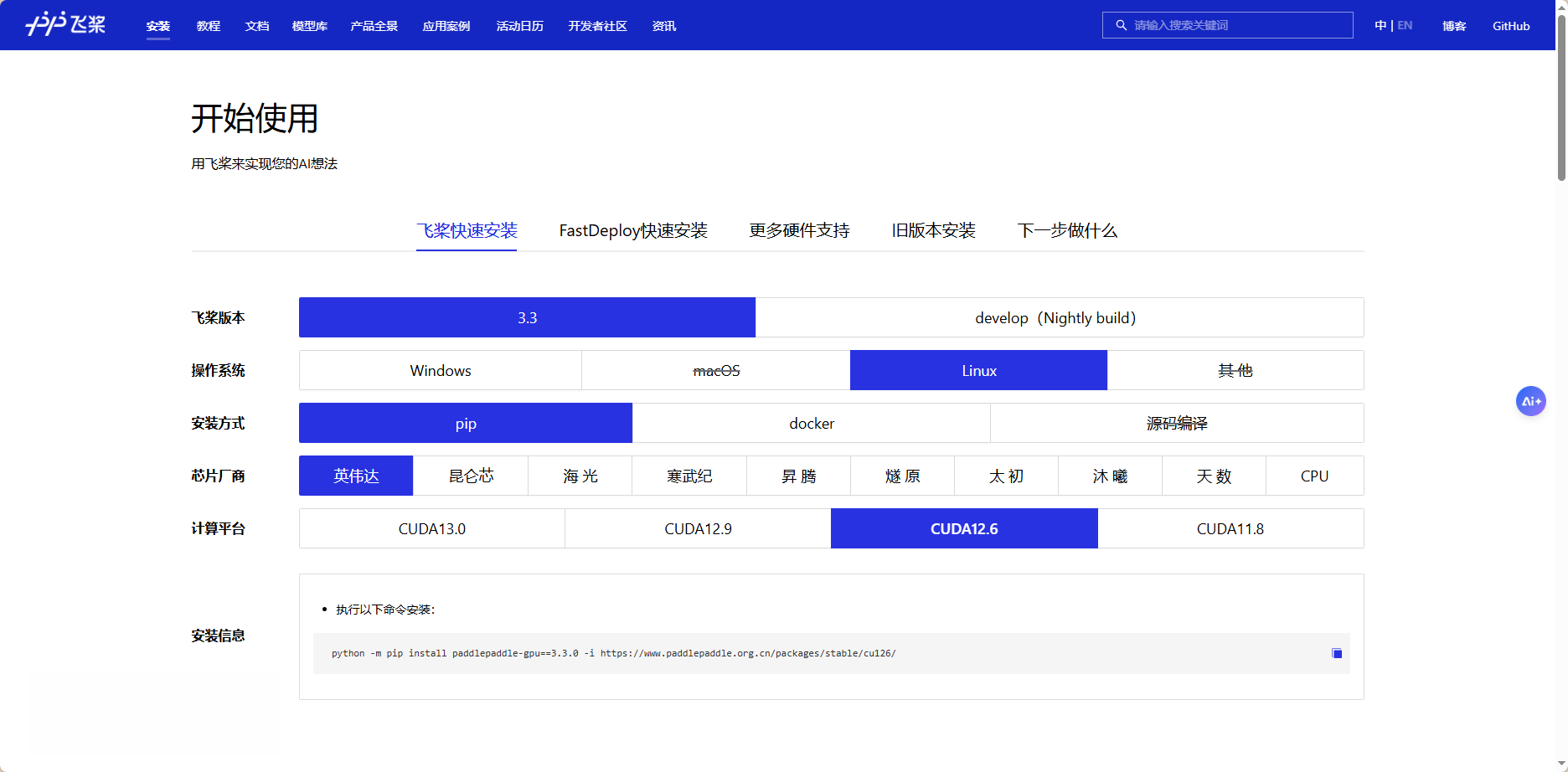

PaddleX 3.0 是基于飞桨框架构建的低代码开发工具,它集成了众多开箱即用的预训练模型,可以实现模型从训练到推理的全流程开发,支持国内外多款主流硬件,助力AI 开发者进行产业实践。下面主要是官方文档,源地址:PaddleX 文档官方文档:开始使用_飞桨-源于产业实践的开源深度学习平台PaddlePaddle3.3安装,cuda12.6二、PaddleX安装注意:若您使用PaddleX的应用场

PaddleX 3.0 是基于飞桨框架构建的低代码开发工具,它集成了众多开箱即用的预训练模型,可以实现模型从训练到推理的全流程开发,支持国内外多款主流硬件,助力AI 开发者进行产业实践。

下面主要是官方文档,源地址:PaddleX 文档

一、安装飞桨 PaddlePaddle

PaddlePaddle3.3安装,cuda12.6

python -m pip install paddlepaddle-gpu==3.3.0 -i https://www.paddlepaddle.org.cn/packages/stable/cu126/二、PaddleX安装

注意:

在安装 PaddleX 之前,请确保您已具备基本的 Python 运行环境(注:目前支持 Python 3.8 至 Python 3.12)。PaddleX 3.0-rc1 版本依赖的 PaddlePaddle 版本为 3.0.0以上版本。

2.1 插件安装模式

若您使用PaddleX的应用场景为二次开发 (例如重新训练模型、微调模型、自定义模型结构、自定义推理代码等),那么推荐您使用功能更加强大的插件安装模式。

安装您需要的PaddleX插件之后,您不仅同样能够对插件支持的模型进行推理与集成,还可以对其进行模型训练等二次开发更高级的操作。

PaddleX支持的模型训练相关插件如下,请您根据开发需求,确定所需的一个或多个插件名称:

👉 插件和产线对应关系(点击展开)

| 模型产线 | 模块 | 对应插件 |

|---|---|---|

| 通用图像分类 | 图像分类 | PaddleClas |

| 通用目标检测 | 目标检测 | PaddleDetection |

| 通用语义分割 | 语义分割 | PaddleSeg |

| 通用实例分割 | 实例分割 | PaddleDetection |

| 通用OCR | 文档图像方向分类 文本图像矫正 文本检测 文本行方向分类 文本识别 |

PaddleOCRPaddleClas |

| 通用表格识别 | 版面区域检测 表格结构识别 文本检测 文本识别 |

PaddleOCRPaddleDetection |

| 文档场景信息抽取v3 | 表格结构识别 版面区域检测 文本检测 文本识别 印章文本检测 文本图像矫正 文档图像方向分类 |

PaddleOCRPaddleDetectionPaddleClas |

| 时序预测 | 时序预测模块 | PaddleTS |

| 时序异常检测 | 时序异常检测模块 | PaddleTS |

| 时序分类 | 时序分类模块 | PaddleTS |

| 通用多标签分类 | 图像多标签分类 | PaddleClas |

| 小目标检测 | 小目标检测 | PaddleDetection |

| 图像异常检测 | 无监督异常检测 | PaddleSeg |

若您需要安装的插件为PaddleXXX,可以直接执行如下指令快速安装PaddleX的对应插件:

git clone https://github.com/PaddlePaddle/PaddleX.git

cd PaddleX

pip install -e .

paddlex --install PaddleXXX❗ 注:采用这种安装方式后,是可编辑模式安装,当前项目的代码更改,都会直接作用到已经安装的 PaddleX Wheel 包。

如果上述安装方式可以安装成功,则可以跳过接下来的步骤。

若您使用Linux操作系统,请参考2. Linux安装PaddleX详细教程。其他操作系统的安装方式,敬请期待。

2.2 自定义方式安装PaddleX

2.2.1 获取 PaddleX 源码

接下来,请使用以下命令从 GitHub 获取 PaddleX 最新源码:

git clone https://github.com/PaddlePaddle/PaddleX.git如果访问 GitHub 网速较慢,可以从 Gitee 下载,命令如下:

git clone https://gitee.com/paddlepaddle/PaddleX.git2.2.2 安装PaddleX

获取 PaddleX 最新源码之后,您可以选择Wheel包安装模式或插件安装模式。

若您选择Wheel包安装模式,请执行以下命令:

cd PaddleX

# 安装 PaddleX whl

# -e:以可编辑模式安装,当前项目的代码更改,都会直接作用到已经安装的 PaddleX Wheel

pip install -e ".[base]"若您选择插件安装模式,并且您需要的插件名称为 PaddleXXX(可以有多个),请执行以下命令:

cd PaddleX

# 安装 PaddleX whl

# -e:以可编辑模式安装,当前项目的代码更改,都会直接作用到已经安装的 PaddleX Wheel

pip install -e ".[base]"

# 安装 PaddleX 插件

paddlex --install PaddleXXX例如,您需要安装PaddleOCR、PaddleClas插件,则需要执行如下命令安装插件:

# 安装 PaddleOCR、PaddleClas 插件

paddlex --install PaddleOCR PaddleClas若您需要安装全部插件,则无需填写具体插件名称,只需执行如下命令:

# 安装 PaddleX 全部插件

paddlex --install插件的默认克隆源为 github.com,同时也支持 gitee.com 克隆源,您可以通过--platform 指定克隆源。

例如,您需要使用 gitee.com 克隆源安装全部PaddleX插件,只需执行如下命令:

# 安装 PaddleX 插件

paddlex --install --platform gitee.com安装完成后,将会有如下提示:

All packages are installed.更多硬件环境的PaddleX安装请参考PaddleX多硬件使用指南

2.3 选择性安装依赖

PaddleX 的功能丰富,而不同的功能需要的依赖也不尽相同。将 PaddleX 中不需要安装插件即可使用的功能归类为“基础功能”。PaddleX 官方 Docker 镜像预置了基础功能所需的全部依赖;使用上文介绍的 pip install "...[base]" 的安装方式也将安装基础功能需要的所有依赖。如果您只专注于 PaddleX 的某一项功能,且希望保持安装的依赖的体积尽可能小,可以通过指定“依赖组”的方式,选择性地安装依赖:

# 以仅安装 OCR 类基础功能为例

# 安装预编译的 wheel 包

pip install "paddlex[ocr]"

# 从源码安装

pip install -e ".[ocr]"

# 也可以同时指定多个依赖组

pip install -e ".[ocr,cv]"PaddleX 目前提供如下依赖组:

| 依赖组名称 | 对应的功能 |

|---|---|

base |

PaddleX 的所有基础功能。 |

cv |

CV 产线的基础功能。 |

multimodal |

多模态产线的基础功能。 |

ie |

信息抽取产线的基础功能。 |

ocr |

OCR 类产线的基础功能。 |

speech |

语音产线的基础功能。 |

ts |

时序产线的基础功能。 |

video |

视频产线的基础功能。 |

trans |

翻译产线的基础功能。 |

genai-client |

生成式 AI 客户端功能。安装此依赖组等效于安装 PaddleX 生成式 AI 客户端插件;也可以通过 PaddleX CLI 安装生成式 AI 客户端插件。 |

genai-sglang-server |

SGLang 服务器功能。安装此依赖组等效于安装 PaddleX SGLang 服务器插件;也可以通过 PaddleX CLI 安装SGLang 服务器插件。 |

genai-vllm-server |

vLLM 服务器功能。安装此依赖组等效于安装 PaddleX vLLM 服务器插件;也可以通过 PaddleX CLI 安装 vLLM 服务器插件。 |

serving |

服务化部署功能。安装此依赖组等效于安装 PaddleX 服务化部署插件;也可以通过 PaddleX CLI 安装服务化部署插件。 |

paddle2onnx |

Paddle2ONNX 功能。安装此依赖组等效于安装 PaddleX Paddle2ONNX 插件;也可以通过 PaddleX CLI 安装 Paddle2ONNX 插件。 |

每一条产线属于且仅属于一个依赖组;在各产线的使用文档中可以了解产线属于哪一依赖组。对于单功能模块,安装任意包含该模块的产线对应的依赖组后即可使用相关的基础功能。

2.4 PaddleX 对飞桨框架的依赖

PaddleX 的绝大部分功能依赖飞桨框架,因此,在大多数情况下,您需要在使用 PaddleX 前参考 飞桨PaddlePaddle本地安装教程 安装飞桨框架。不过,对于以下几种情形,不必安装飞桨框架也可以使用相应的功能:

- 使用 PaddleX

genai-vllm-server或genai-sglang-server插件提供的能力部署模型推理服务。 - 使用 PaddleX

genai-client插件调用生成式 AI 推理服务。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)