收藏备用|大模型微调全流程保姆级教程(小白/程序员必看)

微调(Fine-tuning)大模型,通俗来讲,就是给一个“博览群书”的基础大模型(预训练完成,已掌握通用语言规律和基础世界知识),做一次“针对性专业特训”。我们可以把预训练大模型理解为一个“全才”,什么都懂一点,但面对医疗、法律、企业内部业务等特定领域的专业需求时,就显得不够“精通”,甚至会出现答非所问、不懂行业黑话的情况。而微调的核心,就是用少量、高质量的领域专属数据,在基础大模型的基础上继续

本文专为小白程序员、AI入门学习者打造,详细拆解大模型微调全流程,从领域文档格式统一(转为Markdown)、Easy-dataset工具自动化构建问答数据集,到LLaMA Factory框架实操微调,再到SwanLab实时监控训练动态,每一步都附实用细节与工具指引。按照此流程实操,可轻松将通用大模型改造为特定领域专业AI助手,高效打破行业知识“孤岛”,显著提升模型在垂直领域的落地应用价值,新手也能快速上手、少走弯路。

1、什么是大模型微调?(小白秒懂版)

微调(Fine-tuning)大模型,通俗来讲,就是给一个“博览群书”的基础大模型(预训练完成,已掌握通用语言规律和基础世界知识),做一次“针对性专业特训”。我们可以把预训练大模型理解为一个“全才”,什么都懂一点,但面对医疗、法律、企业内部业务等特定领域的专业需求时,就显得不够“精通”,甚至会出现答非所问、不懂行业黑话的情况。

而微调的核心,就是用少量、高质量的领域专属数据,在基础大模型的基础上继续训练,让模型聚焦某个垂直领域深耕细作,从“样样通、样样松”的全才,蜕变为“术业有专攻”的领域专才。

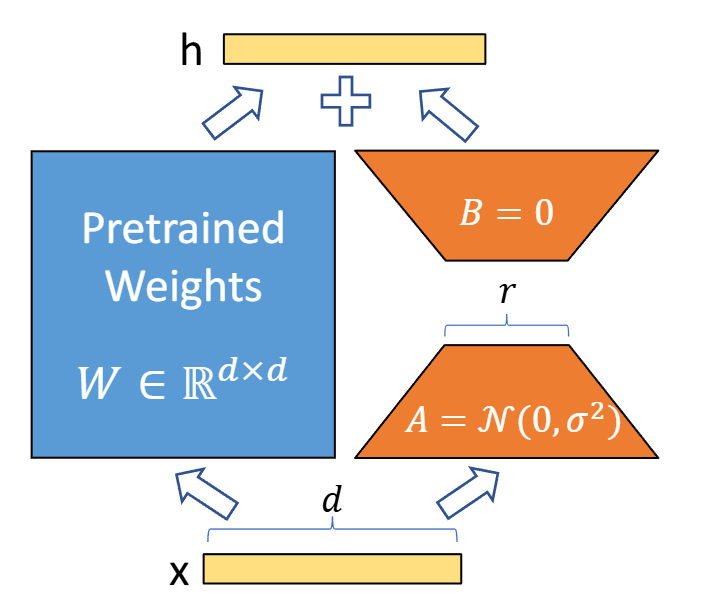

对于程序员和新手来说,最实用的就是LoRA(Low-Rank Adaptation)这类高效微调方法——无需调整模型全部参数,只需修改少量核心参数或添加少量额外层,就能达到理想的微调效果,不仅大幅降低了显卡等计算资源的要求,还能节省训练时间,真正实现“低成本、高效率、高收益”的模型定制。

补充说明:上图为LoRA微调核心原理,本质是在大模型权重文件的输出环节,额外添加一个可训练的低秩矩阵,无需改动原始模型权重,兼顾高效与便捷,小白也能快速上手。

2、为什么一定要学大模型微调?(程序员必看价值)

很多新手程序员会有疑问:预训练大模型(如Qwen、LLaMA)已经足够强大,能写代码、写文案、答问题,为什么还要费劲微调?核心原因就在于“通用≠专用”,预训练模型的短板的很明显——缺乏对特定领域的深度理解,无法适配垂直场景的实际需求。

举个直观的例子:用通用大模型查询“企业内部报销流程”,它只会给出通用的报销逻辑,却无法匹配你公司特有的报销标准、审批节点;用它解答某一行业的专业难题,它可能连基础的行业术语都无法准确解读。这也是很多企业落地AI时遇到的核心痛点——模型“不接地气”。

而微调就能完美解决这个问题:我们用自己行业、自己公司的专属数据训练模型,让模型吃透领域知识、行业黑话、业务逻辑,最终打造出一个“量身定制”的AI助手。对于程序员而言,掌握微调技术,不仅能提升自身的AI实操能力,还能助力企业实现AI落地,提升个人职业竞争力,这也是当前AI领域的核心技能之一。

3、微调前置:数据集准备(关键步骤,缺一不可)

3.1 先搞懂:领域大模型微调的核心逻辑

不管是小白还是有经验的程序员,在动手微调前,一定要先理清核心逻辑:我们身边的很多行业(比如你所在的互联网、金融、医疗),经过多年沉淀,都会积累大量宝贵的知识文档——可能是PDF格式的技术手册、Word格式的业务规范,甚至是扫描件形式的历史资料。

这些文档是领域的核心精华,但由于格式杂乱、分布零散,形成了难以利用的“知识孤岛”——想要从中找一个知识点、查一个业务规范,往往要翻几十上百页文档,耗时又费力,新手入门更是难上加难。

而领域大模型微调的核心价值,就是“激活”这些零散知识:将通用大模型的强大理解能力,与领域专属的零散文档结合,通过微调训练,让模型“记住”所有领域知识,成为一个随叫随到的领域专家,不管是新手查资料、还是老员工处理业务,都能大幅提升效率。

下面,我就从实操角度,一步步拆解数据集准备的全流程,所有工具都推荐开源、易部署的版本,小白也能轻松跟着做,程序员可直接复用流程,快速落地微调任务。

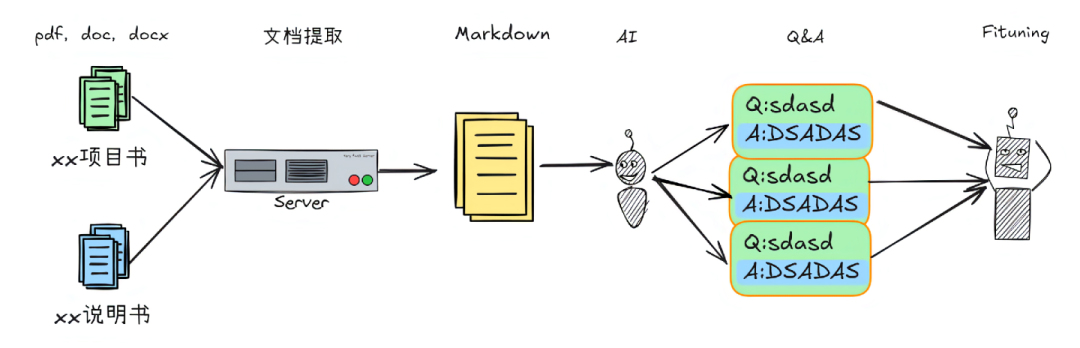

温馨提示:上图为本次微调全流程梳理,建议收藏保存,动手实操时对照查看,避免遗漏步骤——收集领域知识文档→统一转换为Markdown格式→构造微调数据集→微调大语言模型→实时监控训练过程。

3.2 第一步:文档格式统一(转为Markdown,关键前提)

由于行业知识文档的格式杂乱(PDF、Word、扫描件等),直接用来训练模型会出现“识别混乱、知识点提取不完整”的问题,因此,微调的第一步,必须将所有文档统一转换为Markdown格式。

为什么选择Markdown?因为它是轻量级标记语言,排版简洁、易读易写,既能保留文档的原始结构(标题、列表、公式等),又能被各类微调工具快速识别,而且可导出为HTML、PDF等多种格式,后续复用也很方便。(小白可参考Markdown基础语法:Markdown基本语法 | Markdown教程,10分钟就能入门)

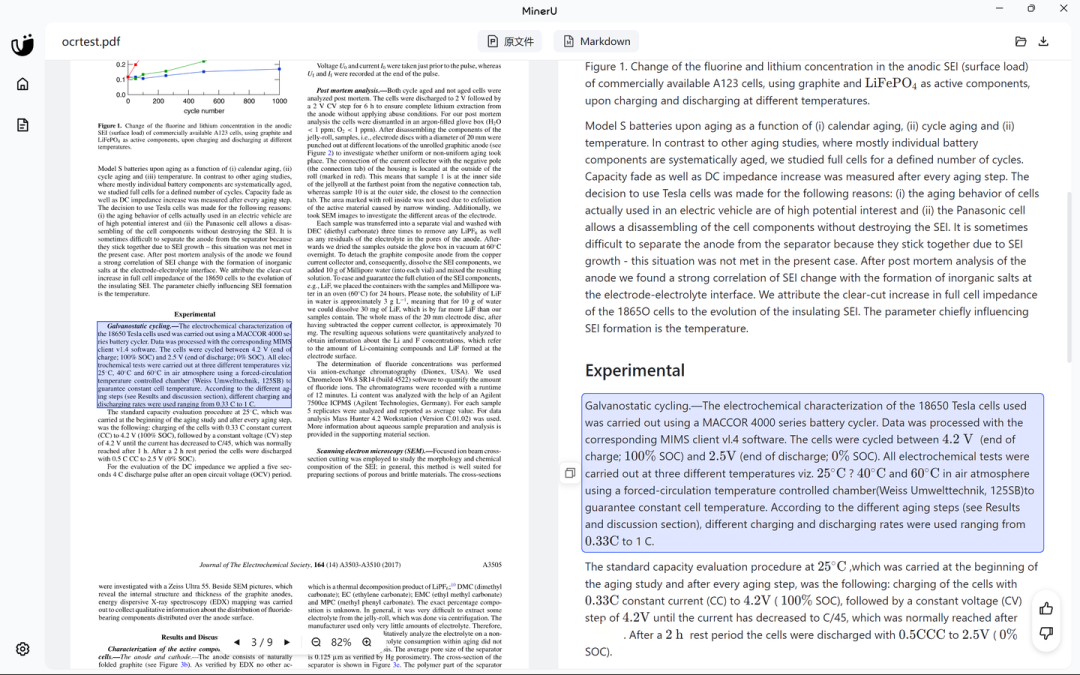

工具推荐:MinerU(国产开源,新手友好),支持本地离线部署,也可在线使用,亲测对PDF文档的识别准确率极高,不管是纯文字PDF,还是包含公式、表格的技术文档,都能精准识别转换;唯一不足的是,对Word文档的识别效果一般,建议小白和程序员先将Word文档转为PDF,再用MinerU进行转换,效率更高。

工具地址:MinerU;如果不想本地部署,可直接在魔搭社区创空间在线体验:MinerU (PDF转Markdown/JSON) · 创空间

实操演示:笔者以一篇技术论文PDF为例,用MinerU识别后,右侧可实时预览Markdown格式内容,从实际效果来看,文字、公式、表格的识别都非常准确,完全能满足后续数据集构建的需求。

补充注意:Windows客户端可在线识别,但目前仅支持导出Latex、docx、HTML格式;若想导出Markdown文件到本地,建议本地部署MinerU,操作更便捷。

3.3 第二步:构建微调数据集(自动化操作,省时省力)

拿到统一格式的Markdown文档后,还不能直接用来微调——大模型微调的核心是“问答式训练”,也就是说,我们需要将Markdown文档中的知识点,转化为“一问一答”的形式(即问答对),模型才能通过这些问答对,学习领域知识。

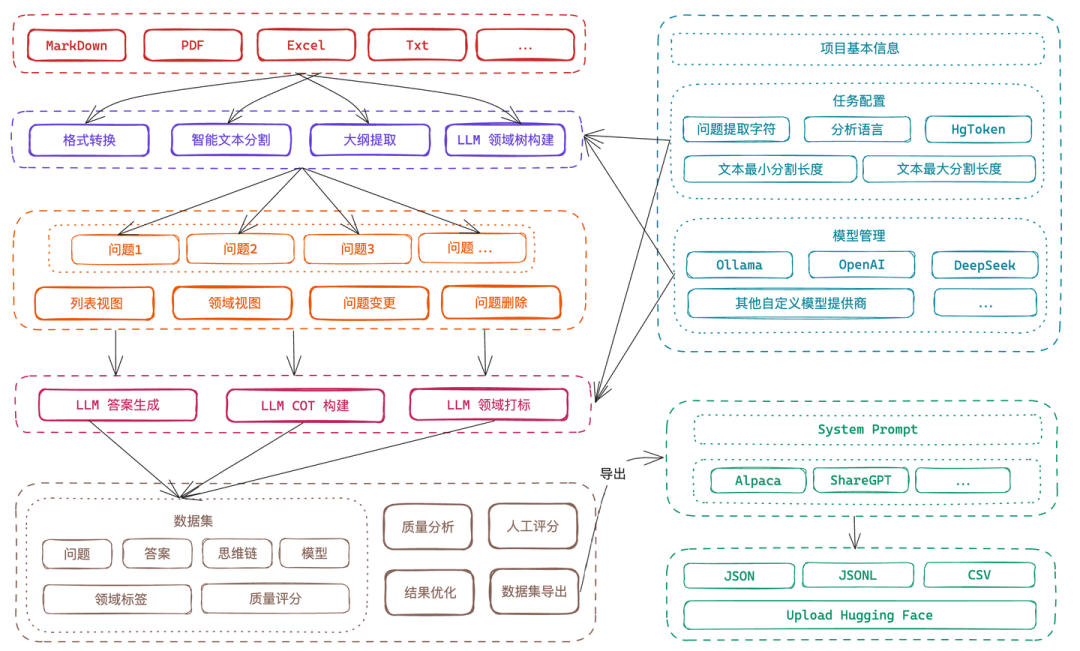

很多新手会担心:手动构造问答对,耗时又费力,还要保证知识点准确,怎么办?其实不用慌,当前AI技术已经能实现“自动化构造问答对”,我们只需借助开源工具Easy-dataset,就能快速将Markdown文档,转化为高质量的微调数据集,小白也能轻松操作,程序员可直接复用工具,提升效率。

工具地址:easy-dataset/README.zh-CN.md

工具原理:Easy-dataset的核心逻辑很简单,先将我们上传的Markdown文档进行智能分割(按知识点拆分,避免内容过长),再调用基础大模型,对每个分割后的知识点片段自动生成问题,最后结合知识点片段,让大模型自动生成对应答案,最终形成完整的问答对数据集,全程自动化,无需手动干预。

前置准备:使用Easy-dataset前,需要本地部署一个基础大模型,用于自动生成问答对。这里推荐小白和程序员使用Ollama部署Qwen2.5-7B模型——部署简单、占用资源适中,完全能满足问答对生成需求,具体部署步骤可参考:Ollama使用指南【超全版】-知乎(步骤详细,小白可跟着一步步操作)。

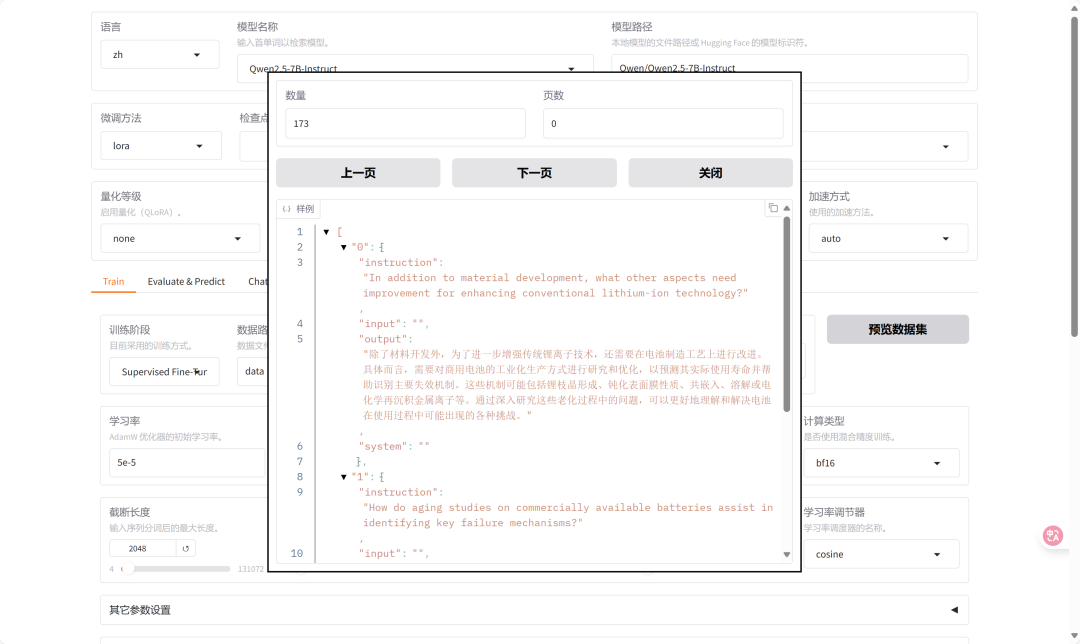

实操效果:笔者上传一篇技术类Markdown文档后,工具自动将文档分割为33个知识点切片(按逻辑拆分,每个切片聚焦一个核心知识点),最终生成173个问答对,知识点提取准确、问答匹配度高,完全能直接用于后续微调。

(文档切片效果:总共被分成了33个切片,每个切片对应一个核心知识点)

(问答对生成效果:总共生成173个问答对,数量充足,覆盖全部知识点)

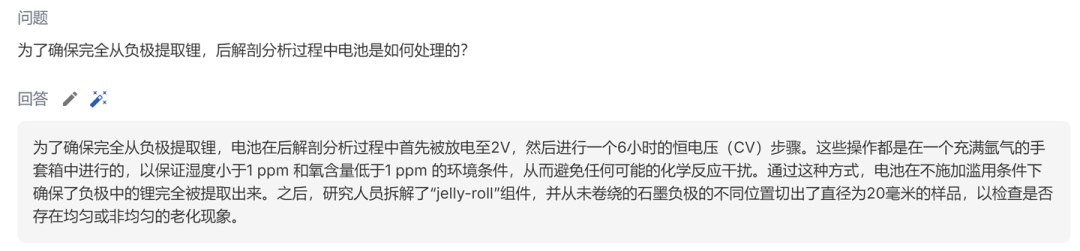

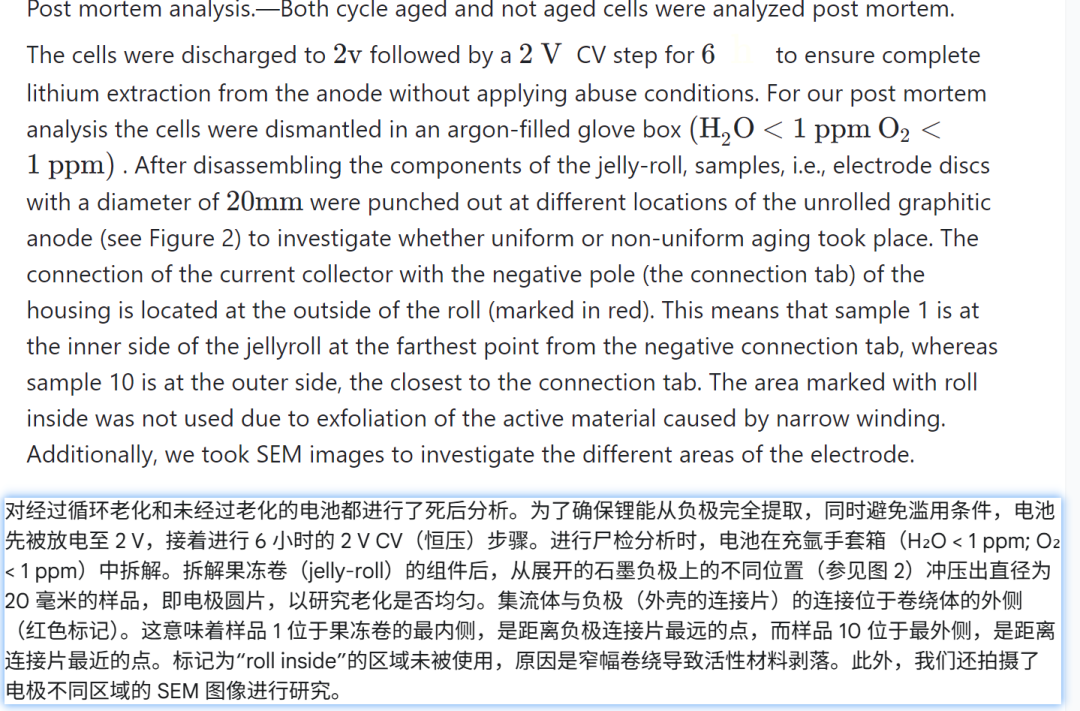

(单个问答对细节:问题贴合知识点,答案准确完整,无冗余内容)

(问答对对应原文:可清晰看到,问答对完全基于原文知识点生成,无偏离、无错误,新手可直接放心使用)

后续操作:问答对生成完成后,直接通过Easy-dataset导出微调数据集(格式适配LLaMA Factory),即可进入下一步的模型微调环节。

4、核心操作:大模型微调实操(小白可落地,程序员可复用)

4.1 先看成本:显卡显存要求(避免踩坑)

很多小白和程序员最关心的问题:微调大模型,需要什么样的显卡?会不会很耗资源?这里结合笔者实操经验,给大家一个明确的参考,避免盲目入手硬件或踩坑。

本次实操演示,笔者使用的是Qwen2.5-7B-Instruct基础模型(70亿参数),模型权重文件约15GB;在默认微调参数下,使用NVIDIA A100-PCIE-40GB显卡进行微调,实际占用显存约19.79GB。

重点提示:只要你的显卡显存≥19.79GB,就能完全复现本次微调实验,无需更高配置。对于小白和普通程序员来说,4090 24GB显卡就完全够用,性价比很高,无需追求高端显卡,降低入门成本。

4.2 微调工具部署:LLaMA Factory(开源首选,适配小白)

微调工具推荐:LLaMA Factory(开源框架,功能强大、操作简洁,自带SwanLab适配,无需额外配置复杂的监控工具,小白和程序员都能快速上手),它支持多种基础模型微调,适配各类问答数据集,而且文档完善,遇到问题可快速查阅解决方案。

部署指南:参考LLaMA Factory官方文档,步骤详细,小白可跟着一步步操作,地址:安装-LLaMA Factory

关键步骤(小白重点记):

\1. 工具安装完成后,将上一步导出的微调数据集,导入到LLaMA Factory的data文件夹下;

\2. 在data_info.json文件中,对导入的数据集进行注册(按照官方文档的格式填写,很简单,无需复杂编码);

\3. 启动LLaMA Factory,预览数据集,确认数据集导入成功、问答对格式无误,避免后续训练出错。

(数据集预览效果:选中导入的数据集文件,可直观查看问答对内容,确认无误后,即可开始微调)

4.3 训练监控:SwanLab(实时查看,避免训练失败)

微调过程中,我们需要实时监控训练状态(比如损失值、准确率等参数变化),及时发现训练中的问题(比如参数设置不合理、数据集异常等),避免白费功夫。这里推荐使用SwanLab——一款专门用于AI实验跟踪、记录、协作的平台,支持实时云端同步训练参数,操作简单,而且与LLaMA Factory自带适配,无需额外复杂配置。

实操步骤:

\1. 前往SwanLab官网注册账号,获取API密钥(免费可用,满足小白和普通程序员的微调监控需求);

\2. 将API密钥配置到LLaMA Factory中,开启SwanLab监控功能(按照官方文档操作,几步就能完成);

\3. 启动微调后,SwanLab会实时同步训练参数,可随时查看训练进度、参数曲线,及时调整优化。

SwanLab官方文档:SwanLab官方文档 | 先进的AI团队协作与模型创新引擎

(LLaMA Factory中启用SwanLab的操作界面,配置简单,小白也能快速完成)

4.4 微调效果对比(直观看到变化)

配置好所有参数后,就可以启动微调训练了。这里给大家展示一下微调前后的模型回答效果,直观感受微调的价值,也让小白和程序员更有成就感。

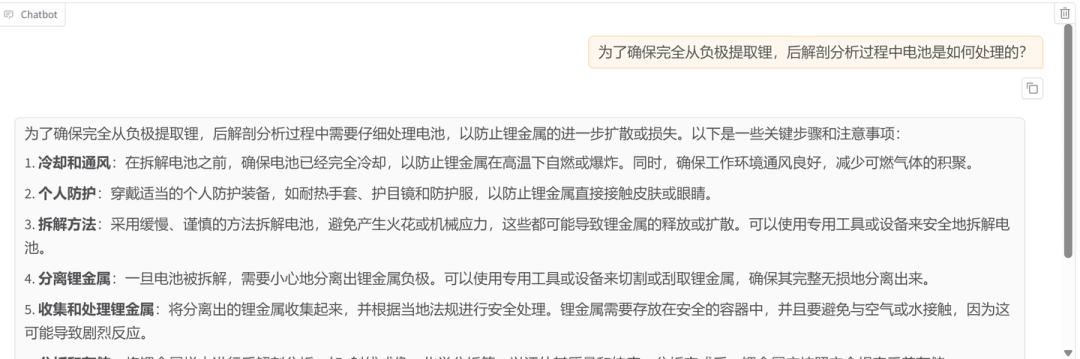

\1. 未微调模型(原始基础模型):由于未学习我们的领域专属知识,虽然能给出一些通用回答,但无法精准匹配领域需求,回答过于笼统,甚至存在偏差;

(原始模型回答效果:缺乏领域知识,回答笼统,无法满足垂直需求)

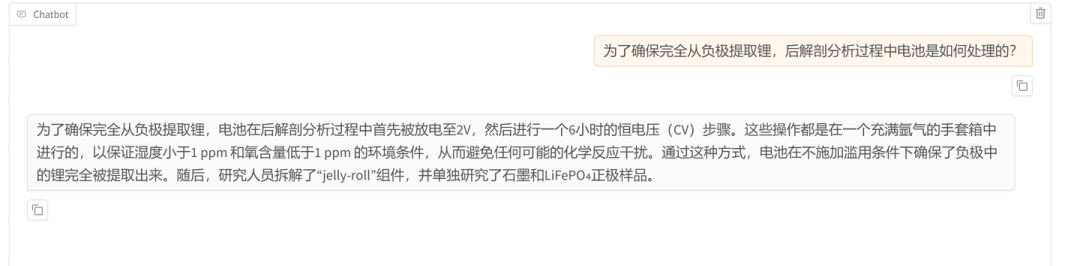

\2. 微调后模型:选择训练完成的检查点路径,调用微调后的模型,可明显看到,模型已经完全掌握了领域专属知识点,回答准确、详细,贴合实际需求,真正实现了“领域专家”的转变;

(微调后模型回答效果:精准掌握领域知识,回答详细、准确,完全适配垂直场景)

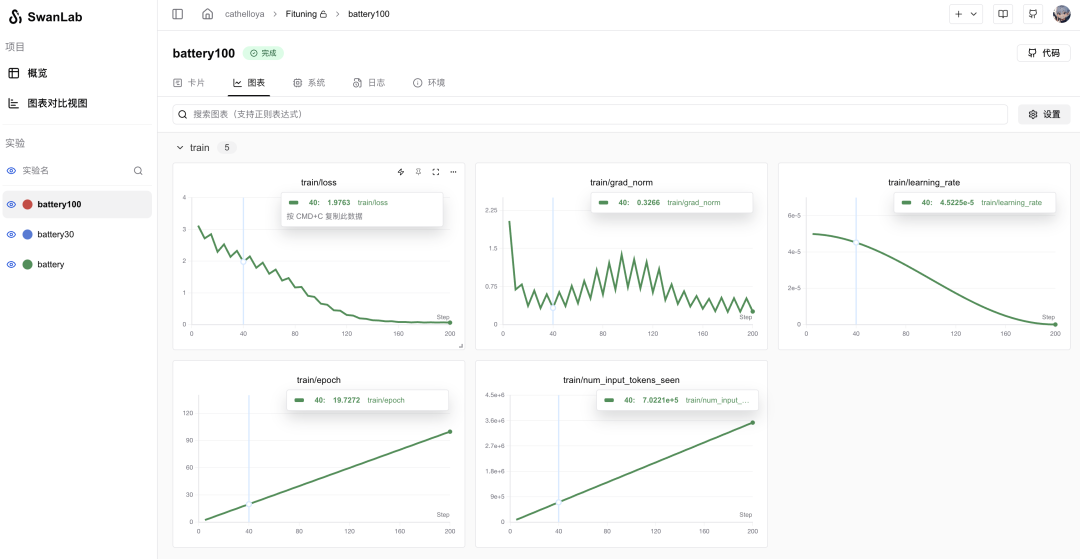

另外,在SwanLab中,我们可以查看训练过程中的各项参数曲线(如损失值曲线、学习率曲线等),通过参数变化,判断训练效果,后续可根据参数优化微调参数,提升模型性能。

(笔者本次训练的参数曲线:提示:笔者为了演示,简略设置了训练参数,实际效果可根据数据集数量、基础模型大小、训练轮次等因素优化,小白可逐步调试,程序员可直接复用优化逻辑)

补充:SwanLab基线社区可搜索作者ID cathelloya,查看笔者本次训练的完整参数配置,小白和程序员可参考复用,少走弯路。

5、小结(收藏重点,实操备查)

本文针对CSDN小白程序员、AI入门学习者,完整拆解了大模型微调的全流程,核心重点的是“实操落地”,避开了复杂的理论推导,所有步骤都附工具指引、实操细节和避坑提示,新手可跟着一步步操作,程序员可直接复用流程和工具,快速落地微调任务。

核心流程回顾(建议收藏,实操时对照查看):

\1. 文档预处理:使用MinerU工具,将PDF、Word等各类领域文档,统一转换为Markdown格式,为后续处理打下基础;

\2. 数据集构建:借助Easy-dataset工具,结合Ollama部署的基础模型,将Markdown文档自动化转为问答对数据集,省时省力;

\3. 模型微调:使用LLaMA Factory框架,导入数据集,配置参数后启动微调,借助SwanLab实时监控训练过程,及时发现问题;

\4. 效果验证:对比微调前后的模型回答效果,根据SwanLab的参数曲线,优化微调参数,最终得到适配垂直领域的专业大模型。

最后提醒:大模型微调的核心是“数据质量”,无需追求海量数据,少量高质量的领域数据,就能达到很好的微调效果。小白可从简单的小数据集、小模型入手,逐步积累经验;程序员可基于本文流程,结合实际业务需求,优化工具和参数,实现更高效的模型微调。

最后

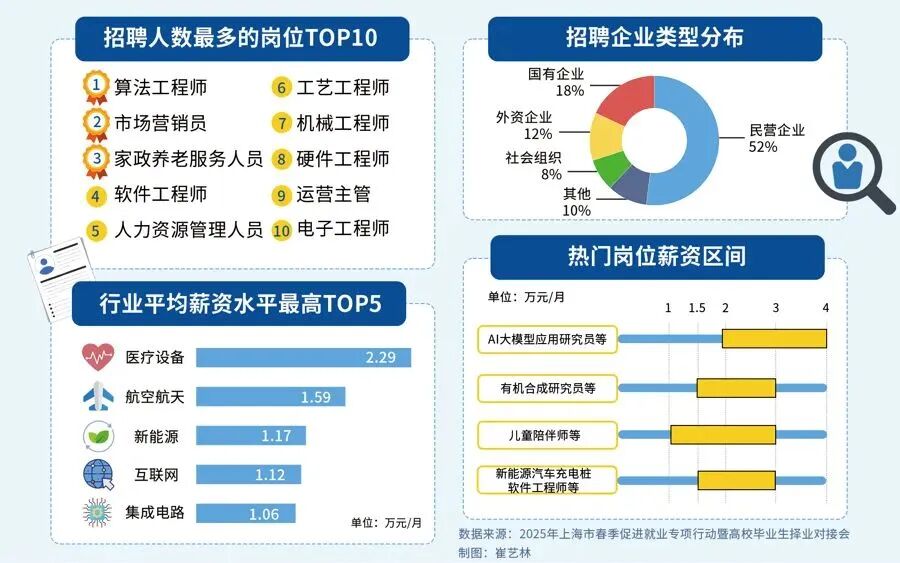

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?

答案只有一个:人工智能(尤其是大模型方向)

当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应聘者,月基础工资也能稳定在4万元左右。

再看阿里、腾讯两大互联网大厂,非“人才计划”的AI相关岗位应聘者,月基础工资也约有3万元,远超其他行业同资历岗位的薪资水平,对于程序员、小白来说,无疑是绝佳的转型和提升赛道。

对于想入局大模型、抢占未来10年行业红利的程序员和小白来说,现在正是最好的学习时机:行业缺口大、大厂需求旺、薪资天花板高,只要找准学习方向,稳步提升技能,就能轻松摆脱“低薪困境”,抓住AI时代的职业机遇。

如果你还不知道从何开始,我自己整理一套全网最全最细的大模型零基础教程,我也是一路自学走过来的,很清楚小白前期学习的痛楚,你要是没有方向还没有好的资源,根本学不到东西!

下面是我整理的大模型学习资源,希望能帮到你。

👇👇扫码免费领取全部内容👇👇

最后

1、大模型学习路线

2、从0到进阶大模型学习视频教程

从入门到进阶这里都有,跟着老师学习事半功倍。

3、 入门必看大模型学习书籍&文档.pdf(书面上的技术书籍确实太多了,这些是我精选出来的,还有很多不在图里)

4、 AI大模型最新行业报告

2026最新行业报告,针对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

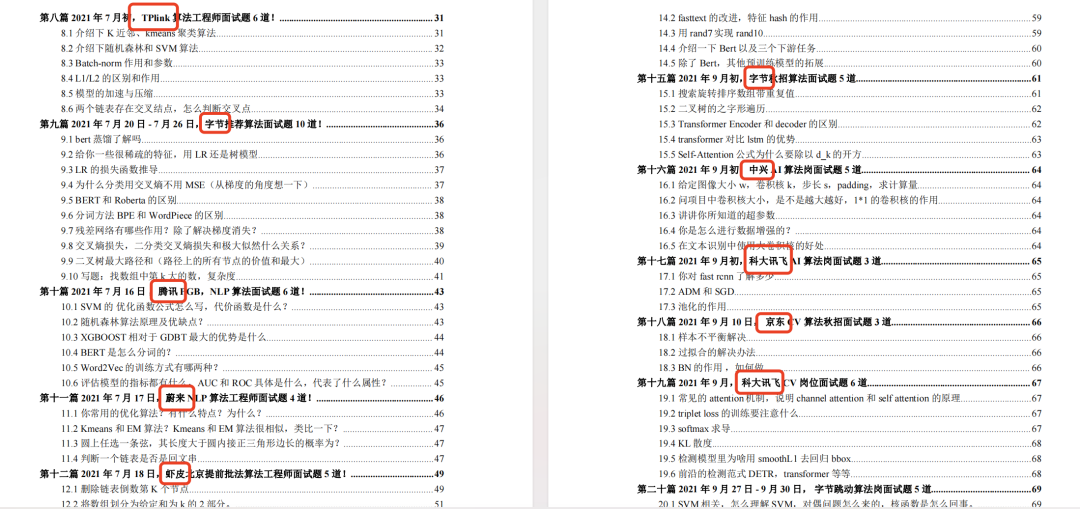

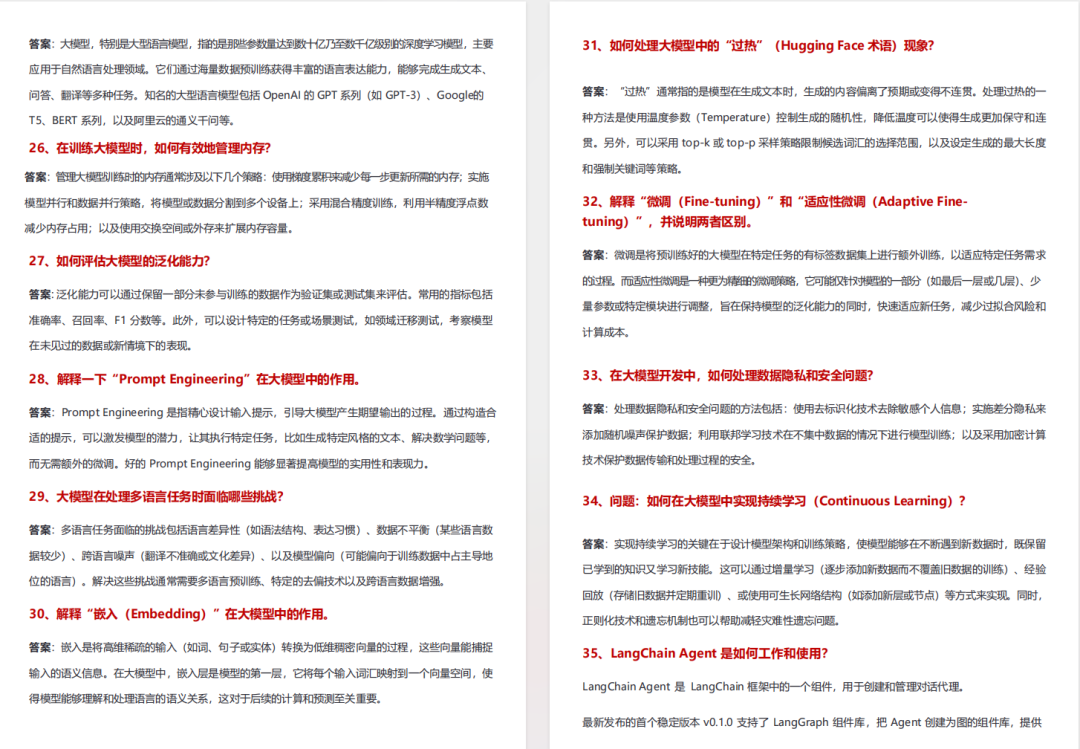

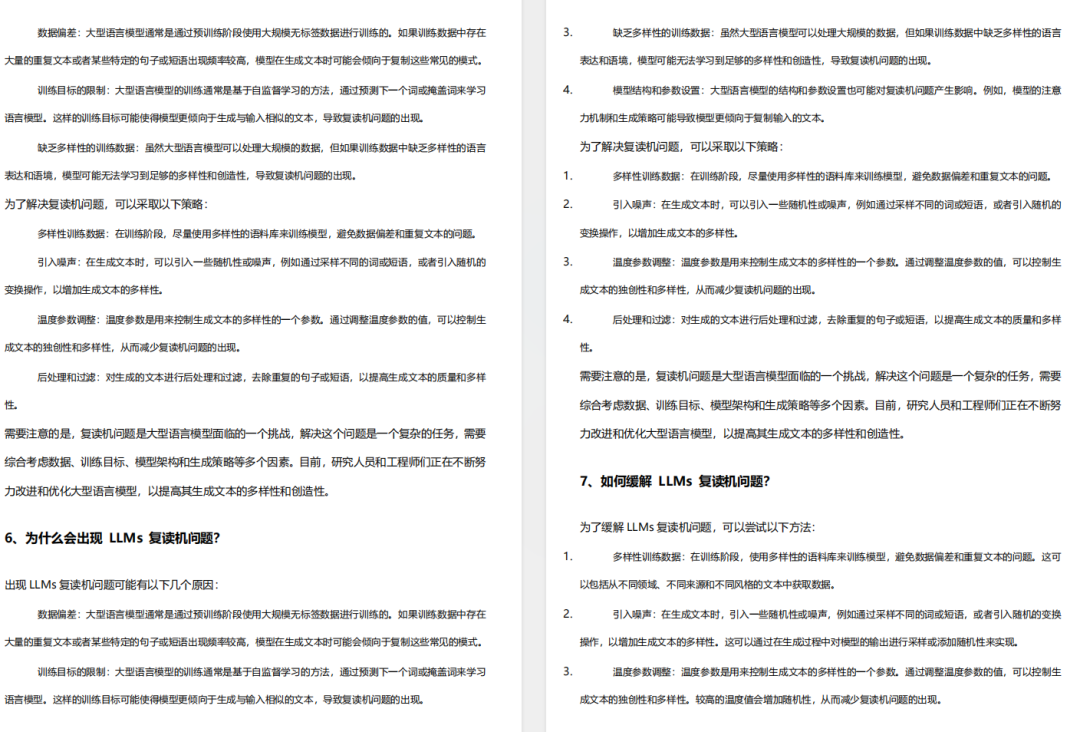

5、面试试题/经验

【大厂 AI 岗位面经分享(107 道)】

【AI 大模型面试真题(102 道)】

【LLMs 面试真题(97 道)】

6、大模型项目实战&配套源码

适用人群

四阶段学习规划(共90天,可落地执行)

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

-

硬件选型

-

带你了解全球大模型

-

使用国产大模型服务

-

搭建 OpenAI 代理

-

热身:基于阿里云 PAI 部署 Stable Diffusion

-

在本地计算机运行大模型

-

大模型的私有化部署

-

基于 vLLM 部署大模型

-

案例:如何优雅地在阿里云私有部署开源大模型

-

部署一套开源 LLM 项目

-

内容安全

-

互联网信息服务算法备案

-

…

👇👇扫码免费领取全部内容👇👇

3、这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献465条内容

已为社区贡献465条内容

所有评论(0)