Windows部署OpenClaw+对接本地vLLM大模型:超详细实操教程

Windows部署OpenClaw+对接本地vLLM大模型:超详细实操教程

OpenClaw作为本地私有化部署的AI个人助理,能实现数据本地留存、多场景自动化操作,堪称「打工人的数字分身」。相比云端AI工具,它无需担心信息泄露,还能对接本地大模型实现高性能推理。这篇教程手把手教你在Windows上通过WSL2部署OpenClaw,并成功对接Ubuntu服务器的vLLM本地大模型,全程无坑、新手也能轻松上手!

一、部署前必看:环境要求

想要流畅运行OpenClaw,基础环境必须达标,这是避免后续踩坑的关键:

-

系统:Windows 10 21H2及以上/Windows 11(需支持WSL2,官方原生推荐,兼容性拉满)

-

硬件:内存≥8GB(推荐16GB,本地操作更流畅)、硬盘剩余≥20GB、CPU开启虚拟化(BIOS默认开启,无需额外操作)

-

网络:可正常访问GitHub、npm官方源,普通网络即可,无需特殊工具

-

核心依赖:WSL2+Node.js≥22+cmake≥3.19(官方硬性要求,缺一不可)

二、基础软件安装:WSL2+Node.js+cmake

OpenClaw官方明确:Windows下优先通过WSL2运行,原生Linux环境能彻底避免Windows的依赖报错问题,这一步是整个部署的核心基础,跟着步骤来准没错!

2.1 一键安装WSL2(Ubuntu默认发行版)

-

按下

Win+R,输入cmd,右键以管理员身份运行命令提示符; -

输入命令

wsl --install,回车后自动下载安装Ubuntu,等待进度完成后重启电脑; -

重启后会弹出Ubuntu配置窗口,按提示设置用户名和密码(密码输入时不显示,正常输入即可);

-

验证安装成功:再次打开管理员cmd,输入

wsl -l -v,输出显示「Ubuntu Running Version 2」即为成功。

2.2 WSL内安装Node.js(24版本,稳定兼容)

全程在Ubuntu终端操作,通过nvm安装可灵活管理Node版本,避免版本冲突:

-

打开Ubuntu终端,输入命令安装nvm:

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.40.3/install.sh | bash -

加载nvm配置(代替重启shell):

. "$HOME/.nvm/nvm.sh" -

安装Node.js 24版本:

nvm install 24 -

验证版本:依次输入以下命令,输出对应版本即为成功:

node -v # 预期输出v24.13.1 npm -v # 预期输出11.8.0

2.3 WSL内安装cmake≥3.19(3.31.11版本为例)

cmake是编译核心依赖,需手动下载安装并配置权限:

-

终端输入命令下载安装包:

wget https://github.com/Kitware/CMake/releases/download/v3.31.11/cmake-3.31.11-linux-x86_64.sh -

赋予安装包可执行权限:

sudo chmod +x cmake-3.31.11-linux-x86_64.sh -

一键安装(跳过协议,安装到系统默认目录):

sudo ./cmake-3.31.11-linux-x86_64.sh --prefix=/usr/local --skip-license -

验证安装:输入

cmake --version,输出「cmake version 3.31.11」即为成功。

三、OpenClaw核心安装:两种方法任选,本文推荐方法二

基础环境配置完成后,即可在WSL2中安装OpenClaw,官方提供两种安装方式,更推荐方法二,更稳定,全程在Ubuntu终端执行!

方法一:脚本一键安装

# 一键执行安装脚本

curl -fsSL https://openclaw.ai/install.sh | bash

# 检查配置是否有问题

openclaw doctor

# 查看网关状态

openclaw status

# 打开Web管理界面

openclaw dashboard

方法二:手动命令安装(本教程推荐)

-

全局安装OpenClaw最新版本:

npm install -g openclaw@latest # 若安装了pnpm,可替换为:pnpm add -g openclaw@latest -

初始化配置并安装守护进程:

openclaw onboard --install-daemon -

安全配置确认:执行后会弹出安全提示,按提示点击「I understand」继续,在「Model/auth provider」中选择Qwen(通义千问,注册账号即可免费使用,无需额外付费);

-

打开Web界面:配置完成后,在浏览器输入

localhost:18789,即可看到OpenClaw的可视化管理界面,至此OpenClaw基础安装完成!

四、关键步骤:对接Ubuntu服务器vLLM本地大模型

本地Windows配置有限,且为了数据安全,将OpenClaw对接高性能服务器的vLLM本地大模型是最优选择,核心是修改配置文件+设置默认模型+重启网关,全程在WSL2终端操作!

4.1 修改openclaw.json配置文件(核心)

-

进入OpenClaw配置目录:

cd ~/.openclaw -

编辑openclaw.json文件(用vim或nano均可,新手推荐nano):

nano openclaw.json -

在文件中找到

models.providers,添加/修改vLLM配置(替换成自己的服务器信息):"vllm": { "baseUrl": "http://你的服务器IP:端口/v1", // 如http://192.168.1.100:1234/v1 "apiKey": "任意字符", // 无API_KEY则随意填写,不能为空 "api": "openai-completions", "models": [ { "reasoning": false, "id": "qwen3-32b", // 服务器vLLM的模型名称 "name": "qwen3-32b", // 与模型id一致 "input": ["text"], "cost": { "input": 0, "output": 0, "cacheRead": 0, "cacheWrite": 0 }, "contextWindow": 128000, "maxTokens": 8192 } ] } -

保存退出:nano编辑器按

Ctrl+O保存,Ctrl+X退出。

4.2 设置默认对接模型

# 将vLLM的qwen3-32b设为OpenClaw默认模型

openclaw models set vllm/qwen3-32b

# 可选:查看当前模型列表,确认默认模型是否设置成功

openclaw models list

4.3 重启网关使配置生效

# 普通重启网关

openclaw gateway

# 若配置不生效,执行强制重启(必成功)

openclaw gateway --force

4.4 验证对接成功

-

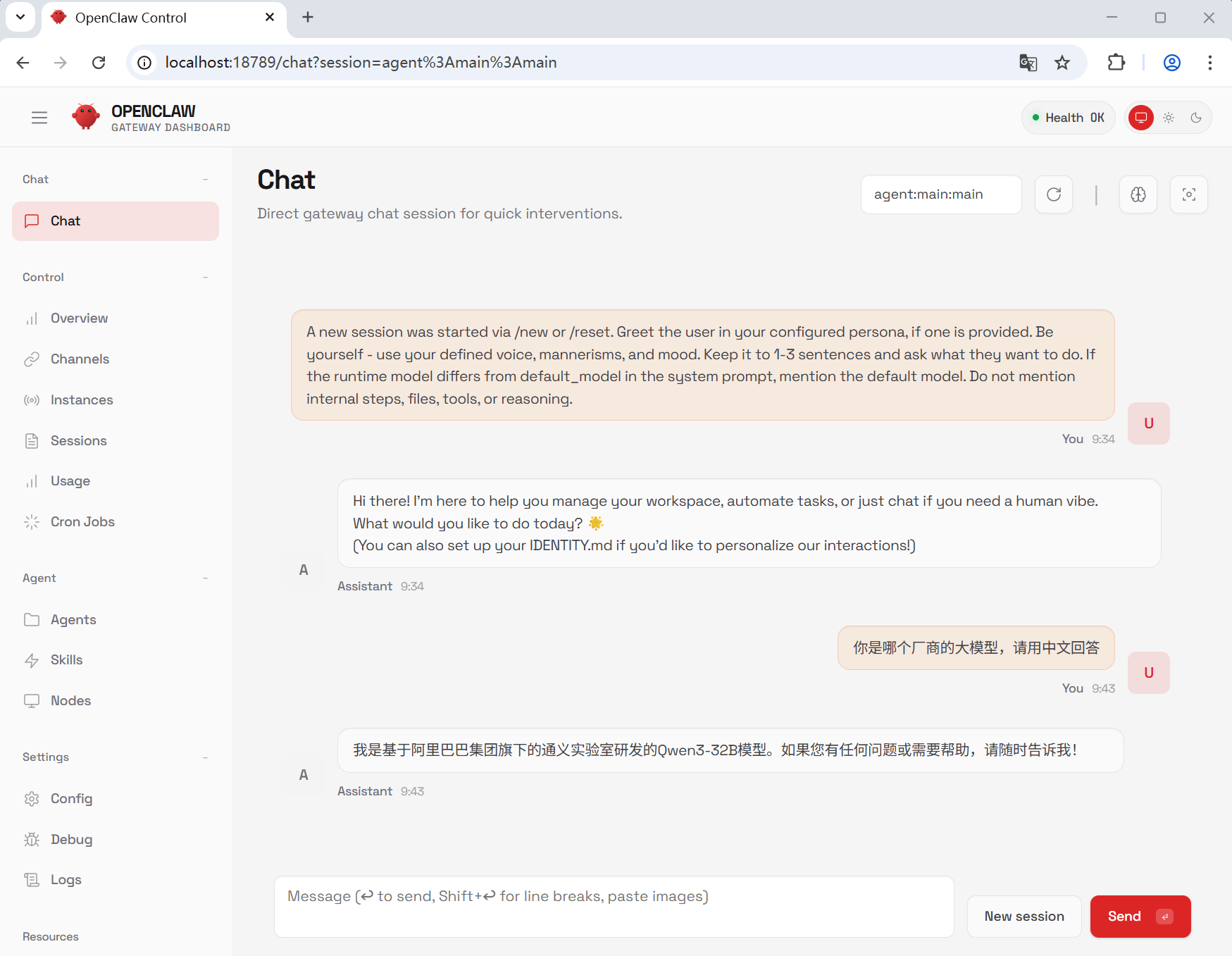

在浏览器重新打开

localhost:18789,进入OpenClaw的Chat界面; -

发送测试消息:「你是哪个厂商的大模型?」;

-

若收到回复:「我是阿里巴巴集团下的通义实验室研发的Qwen3-32b」,说明OpenClaw与本地vLLM大模型对接成功!

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)