用大白话讲解人工智能(4) Softmax回归:AI如何给选项“打分排序“

现在要选出"最佳歌手",你会怎么比?直接把分数相加?A=175分,B=175分,打平了!但直觉告诉你,A和B的风格不同,不能简单相加。这时候,你可能会想:“如果能把分数转换成’夺冠概率’就好了——谁的概率最高,谁就是最佳。,让AI能清晰地判断"哪个选项最可能是正确答案"。

Softmax回归:AI如何给选项"打分排序"?

从"选秀比赛打分"说起

假设你是《中国好声音》的评委,面前有三位选手:

- 选手A:演唱得90分,舞台表现85分

- 选手B:演唱得85分,舞台表现90分

- 选手C:演唱得80分,舞台表现80分

现在要选出"最佳歌手",你会怎么比?直接把分数相加?A=175分,B=175分,打平了!但直觉告诉你,A和B的风格不同,不能简单相加。这时候,你可能会想:“如果能把分数转换成’夺冠概率’就好了——谁的概率最高,谁就是最佳。”

这就是Softmax回归的核心作用:把一组"原始分数"转换成"概率分布",让AI能清晰地判断"哪个选项最可能是正确答案"。

为什么需要Softmax?直接比大小不行吗?

问题1:分数没有统一标准

假设另一个评委给选手打分:

- 选手A:演唱得5分(满分10分),舞台表现4分

- 选手B:演唱得4分,舞台表现5分

这组分数和前一组本质相同(A和B各有一项突出),但数值范围完全不同。如果直接比较总分(9 vs 9),依然无法区分。

问题2:分数不能反映"置信度"

假设选手A的得分是100分,选手B是1分。直接比较会认为A"绝对正确",但现实中可能只是A比B好一点,并非100倍差距。

问题3:多选项时无法分配概率

图像识别中,AI需要判断一张图是"猫"“狗"还是"鸡”。如果直接输出三个分数(比如猫=3.2,狗=1.5,鸡=-0.5),人类能看出猫分数最高,但AI需要明确的"概率"来做决策(比如"有84%的可能是猫")。

Softmax的魔法:不管原始分数是多少,都能把它们"归一化"成0~1之间的概率,且总和为1。就像把评委的打分统一换算成"夺冠概率",让比较变得公平且直观。

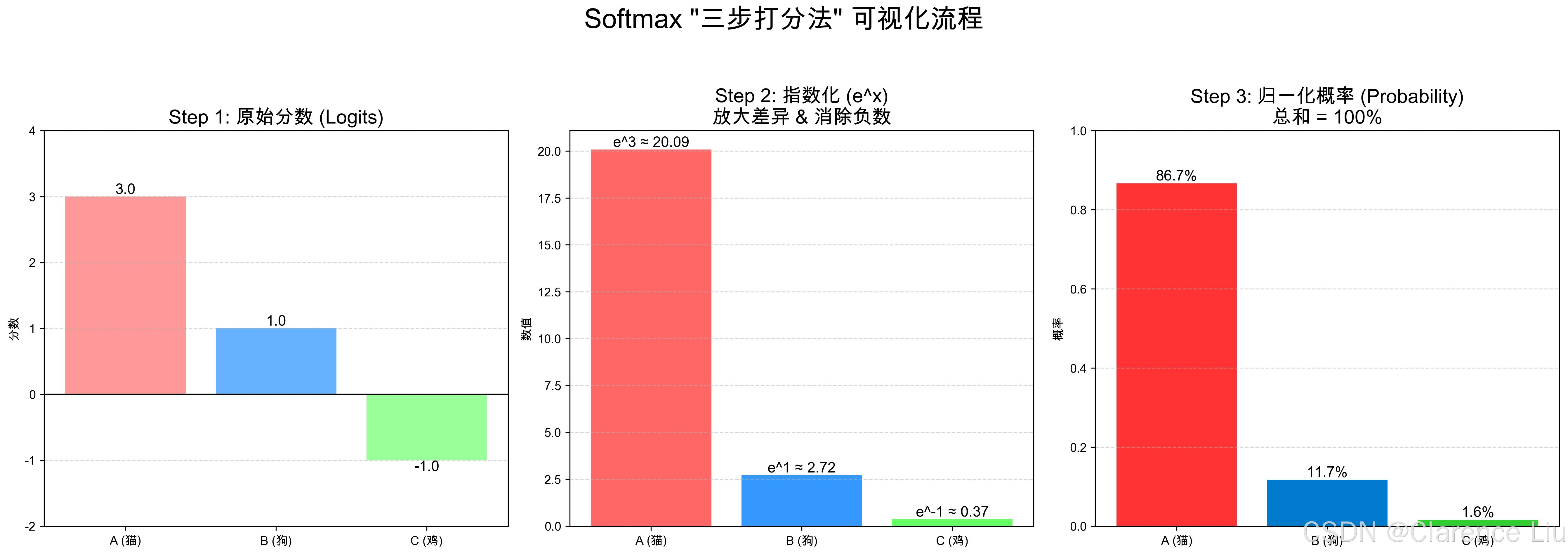

Softmax的"三步打分法"

我们用选秀比赛的例子,带大家手算一次Softmax的过程。假设有三位选手的"综合得分"(已融合演唱、舞台等因素):

- 选手A(猫):3分

- 选手B(狗):1分

- 选手C(鸡):-1分

第1步:给分数"乘火箭"——指数化(解决负数问题)

Softmax第一步是对每个分数做指数运算(e^x,e≈2.718):

- A: e³ ≈ 20.085

- B: e¹ ≈ 2.718

- C: e⁻¹ ≈ 0.368

为什么要指数化?

- 把负数变成正数(e^-1=0.368>0)

- 放大高分和低分的差距(3分和1分的差距,从2变成20.085/2.718≈7.39倍)

就像选秀中,评委可能会说:"A选手比B选手好一点?不,A是明显的冠军候选人!"指数化就是这种"放大差距"的思维。

第2步:算"占比"——归一化(让总和为1)

把三个指数化后的分数相加:

总和 = 20.085 + 2.718 + 0.368 ≈ 23.171

然后用每个选手的指数分数除以总和,得到概率:

- A的概率 = 20.085 / 23.171 ≈ 0.867(86.7%)

- B的概率 = 2.718 / 23.171 ≈ 0.117(11.7%)

- C的概率 = 0.368 / 23.171 ≈ 0.016(1.6%)

现在结果清晰了:A有86.7%的概率夺冠,B只有11.7%,C几乎不可能。

第3步:选"概率最高"的选项——Argmax

AI最后会选择概率最高的选项,这个过程叫"Argmax"(取最大值的索引):

因为A的概率最高,所以最终判断"这是猫"。

生活中的Softmax:不止"选秀打分"

案例1:手机相册分类

你的手机相册能自动把照片分成"人物"“风景”“美食”,背后就是Softmax在工作:

- 输入一张照片,AI提取特征后生成三个分数:人物=5.2,风景=2.1,美食=0.8

- Softmax转换后概率:人物=92%,风景=7%,美食=1%

- 相册把照片归类到"人物"文件夹

案例2:智能音箱唤醒词

当你说"小爱同学"时,智能音箱需要判断你说的是:

- 唤醒词(小爱同学)

- 随机噪音(比如咳嗽)

- 其他指令(比如"打开空调")

Softmax会给这三个选项打分并算概率,只有"唤醒词"的概率超过90%时,音箱才会响应。

案例3:推荐系统排序

短视频平台推荐视频时,会给每个候选视频算一个"用户喜欢分数":

- 视频A:8分(搞笑类)

- 视频B:7分(美食类)

- 视频C:6分(教育类)

Softmax把分数转换成概率后,平台会按概率高低排序,优先推荐概率最高的视频A。

Softmax的"小心机":为什么指数函数这么好用?

心机1:永远输出非负概率

指数函数e^x的值永远大于0,所以Softmax的概率永远在0~1之间,符合概率的定义。

心机2:自动突出"最高分选项"

假设有三个分数:100, 1, 0。经过Softmax后:

- e^100 ≈ 2.688×10⁴³(一个天文数字)

- e^1 ≈ 2.718,e^0=1

- 总和≈e^100,所以100分对应的概率≈100%

这意味着:只要有一个分数显著高于其他,Softmax会把几乎所有概率都分配给它,符合我们"选明显最优选项"的直觉。

心机3:对微小变化不敏感

如果分数是3.1, 3.0, 3.0,和3.0, 2.9, 2.9,Softmax算出的概率分布几乎相同。这让AI在面对微小扰动时更稳定。

Softmax回归 vs 线性回归:亲兄弟的不同分工

| 任务类型 | 输出形式 | 核心作用 | 生活类比 |

|---|---|---|---|

| 线性回归 | 一个具体数值(如房价、身高) | 预测连续值 | 用直尺量长度 |

| Softmax回归 | 一组概率(总和为1) | 多分类判断 | 给选秀选手算夺冠概率 |

关键区别:线性回归解决"多少"的问题,Softmax回归解决"哪个"的问题。但它们的底层都是"加权求和"(仿射变换),Softmax只是在输出层多了一步"概率转换"。

Softmax的"烦恼":当分数差距太大时

问题:"溢出"危机

如果某个分数特别大(比如1000),e^1000会大到电脑无法存储(数值溢出)。解决办法是"减去最大值":

- 原分数:1000, 1, 0 → 减去1000 → 0, -999, -1000

- 新指数:e⁰=1, e⁻⁹⁹⁹≈0, e⁻¹⁰⁰⁰≈0 → 概率≈100%, 0%, 0%

- 结果不变,但避免了数值溢出。

问题:“过于自信”

如果AI输出99.9%的概率是猫,但实际是狗,说明模型"过于自信"。解决办法是"温度系数":

- 温度>1(如2):让概率分布更平缓(0.8, 0.15, 0.05)

- 温度<1(如0.5):让概率分布更陡峭(0.95, 0.04, 0.01)

- 就像调节评委的"严苛程度",温度低=评委观点更极端,温度高=评委更包容。

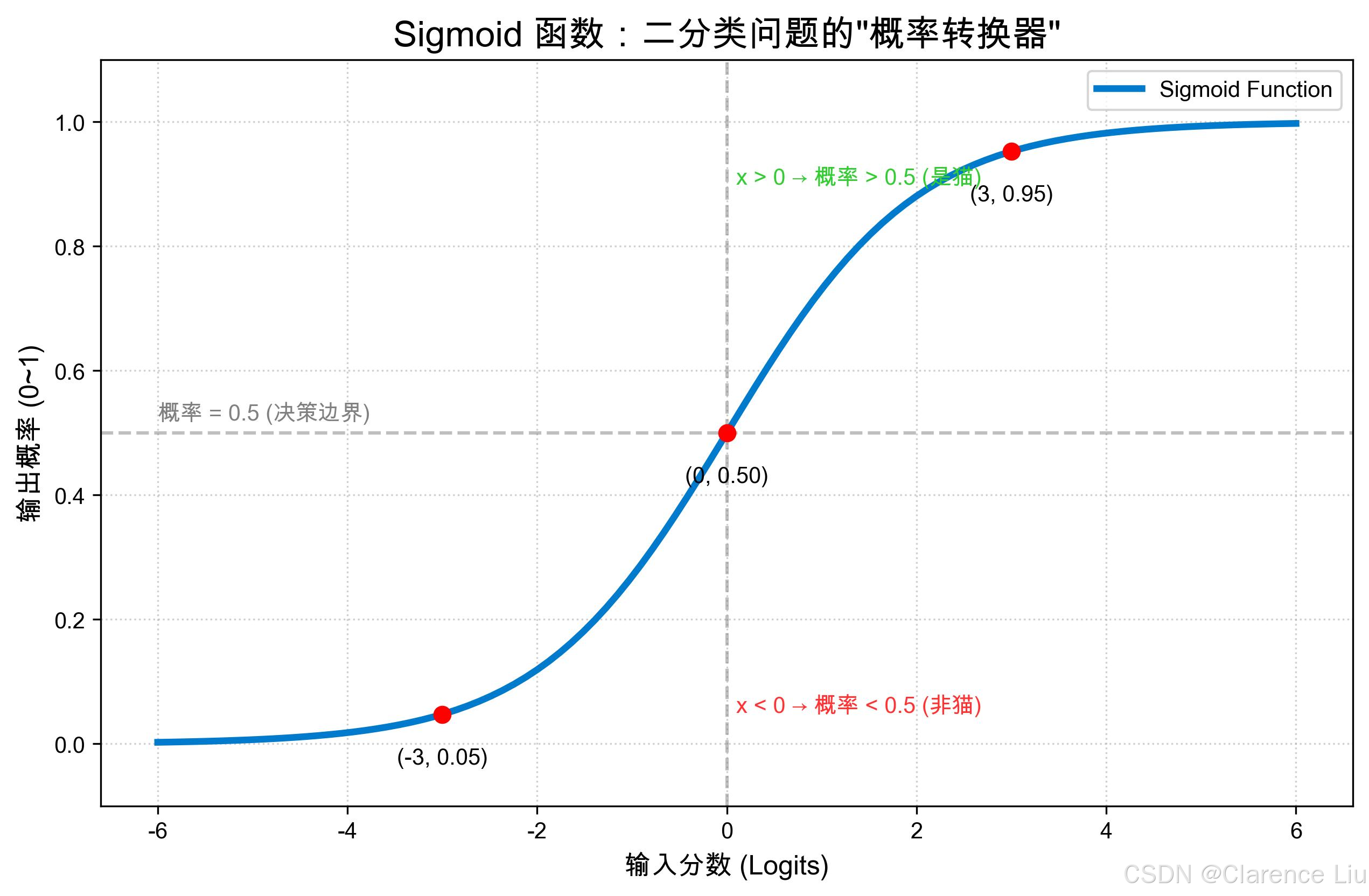

小问题:Softmax和Sigmoid是什么关系?

(提示:Sigmoid是Softmax的"双胞胎弟弟"——当只有两个选项时(二分类),Softmax的结果和Sigmoid完全一样。比如判断"是不是猫",Softmax输出(猫概率, 非猫概率),Sigmoid直接输出猫概率,本质相同。)

下一篇预告:《SVM支持向量机:找一条"最宽的分隔线"》——用"分蛋糕"的例子,讲透如何用直线完美分隔不同类别。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)