人机责任界定中的可解释AI工具:测试任务分配的变革性框架

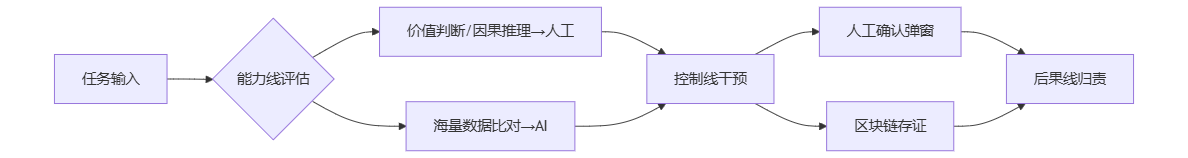

摘要: 随着AI在测试领域从辅助转向自主执行,责任界定模糊成为关键挑战。医疗误诊、金融误操作等案例凸显传统测试流程的三大断层:决策黑箱化、日志孤岛化和权责失衡。新型可解释AI工具通过“能力线-控制线-后果线”框架重构责任链:动态划分人机协作边界(如高风险操作强制人工确认)、硬性熔断机制(低置信度自动降级)及区块链溯源。以金融测试为例,XAI-Tracer工具链实现缺陷定位效率提升40%,责任纠纷处

一、测试领域人机协同的责任困境

随着AI代理从“建议者”升级为“执行者”(如自动生成测试用例、执行回归测试),责任模糊成为核心痛点。医疗测试中AI误判病理影像导致漏检,或金融系统中自动化脚本错误触发资金冻结等案例显示:当AI决策缺乏透明度时,责任链将陷入“开发者-运维方-用户”相互推诿的僵局。究其本质,传统测试流程存在三大断层:

-

决策黑箱化:神经网络的涌现特性使缺陷定位困难,如对抗样本导致图像识别测试失败时,无法追溯模型权重偏差的具体层级

-

日志孤岛化:用户操作记录、模型置信度输出、系统熔断日志分散存储,审计时难以重建完整证据链

-

权责匹配失衡:用户恶意提示词致非法输出却由开发者担责,或训练数据偏见导致歧视性测试结果时追责缺失

二、可解释AI责任链工具的架构创新

基于“能力线-控制线-后果线”三维框架(见下图),新一代工具正重塑责任分配逻辑:

-

能力线动态切分

-

人类专属域:价值判断(如伦理合规测试标准)、因果推断(缺陷根因分析)、例外处置(突发流量压测方案调整)需强制人工确认

-

AI优势域:百万级用例的兼容性矩阵验证、历史缺陷模式匹配等任务,由AI执行后生成可视化决策路径报告

-

灰域处理机制:基于ISO 29119标准构建“场景-任务清单”,如信用卡安全测试中,对涉及用户隐私的数据脱敏操作设置双人复核节点

-

-

控制线硬保障设计

-

熔断三原则:当系统置信度<85%时自动降级为建议模式;高风险操作(如生产环境数据库清理)需生物特征认证;超时未响应默认中止执行

-

全链路上链:用户指令哈希值(用户层)、模型特征归因图(模型层)、资源监控指标(系统层)实时写入联盟链,支持毫秒级溯源

-

动态预测干预:通过双向LSTM模型预判任务风险等级,如检测到模糊需求描述时,自动插入边界值测试用例生成确认环节

-

-

后果线归责模型

责任类型

归责主体

工具实现方式

数据缺陷

数据提供方+开发者连带

训练数据血缘分析+偏见检测报告

恶意指令

用户主责

操作意图识别模型+行为审计日志

系统级故障

运维方

基础设施健康度监控图谱

模型幻觉

开发者

置信度阈值校准模块

三、落地实践:金融测试场景工具链示例

某银行在信用卡风控系统测试中部署XAI-Tracer工具链,实现:

-

测试用例生成阶段

-

AI自动生成2000+压力测试用例,但对涉及征信算法公平性的12条用例触发人工确认弹窗

-

工具输出归因报告:”第7条用例因关联种族特征变量被标记,建议替换为收入区间维度“

-

-

执行监控阶段

-

当API并发测试置信度骤降至78%时,自动切换为单线程模式并告警

-

区块链存证显示:流量突增导致线程锁失效,非脚本逻辑错误

-

-

归责阶段

-

因用户强行绕过安全校验指令致测试数据泄露,操作日志溯源锁定具体账号

-

开发方因未预置隐私字段脱敏规则承担30%连带责任

成效:缺陷定位效率提升40%,责任纠纷处理周期从14天缩短至72小时

-

四、未来演进:测试责任共同体的构建

-

技术保险机制:高风险场景(自动驾驶测试)强制投保,承保方介入工具置信度校准

-

跨链审计网络:打通企业测试链、模型供应商链、监管链,实现穿透式监管

-

因果推理引擎:基于结构因果模型(SCM)构建测试失误根因图谱,替代传统日志回溯

# 示例:SCM引擎的责任节点关联分析

from causalnex.plots import plot_structure

model = StructureModel()

model.add_edges_from([

("数据偏见", "模型偏差"),

("模糊需求", "用例歧义"),

("环境配置错误", "执行超时")

])

plot_structure(model, prog="dot") # 生成责任传导可视化当测试从“人控机器”转向“人机共治”,可解释AI责任链工具将成为信任基石——它不消除风险,但让每份责任都有迹可循。

精选文章:

更多推荐

已为社区贡献338条内容

已为社区贡献338条内容

所有评论(0)